Heim >Technologie-Peripheriegeräte >KI >Ist dies der Prototyp der Meta-Version von ChatGPT? Open Source, kann auf einer einzelnen GPU ausgeführt werden, übertrifft GPT-3 mit 1/10 der Anzahl der Parameter

Ist dies der Prototyp der Meta-Version von ChatGPT? Open Source, kann auf einer einzelnen GPU ausgeführt werden, übertrifft GPT-3 mit 1/10 der Anzahl der Parameter

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 23:07:021304Durchsuche

Super große Modelle mit Hunderten Milliarden oder Billionen Parametern brauchen jemanden, der sie untersucht, ebenso wie große Modelle mit Milliarden oder Dutzenden Milliarden Parametern.

Gerade hat der Chef-KI-Wissenschaftler von Meta, Yann LeCun, bekannt gegeben, dass sie eine neue große Modellserie „Open Source“ haben – LLaMA (Large Language Model Meta AI), mit einem große Anzahl von Parametern Es reicht von 7 Milliarden bis 65 Milliarden. Die Leistung dieser Modelle ist ausgezeichnet: Das LLaMA-Modell mit 13 Milliarden Parametern kann GPT-3 (175 Milliarden Parameter) „bei den meisten Benchmarks“ übertreffen und auf einer einzelnen V100-GPU laufen, während das größte 65-Milliarden-Parameter-LLaMA-Modell vergleichbar ist zu Googles Chinchilla-70B und PaLM-540B.

Wie wir alle wissen, werden Parameter von maschinellen Lernmodellen zur Erstellung verwendet Vorhersagen basierend auf Eingabedaten oder kategorialen Variablen. Die Anzahl der Parameter in einem Sprachmodell ist ein Schlüsselfaktor für die Leistung. Größere Modelle sind normalerweise in der Lage, komplexere Aufgaben zu bewältigen und kohärentere Ergebnisse zu erzeugen, was Richard Sutton als „bittere Lektion“ bezeichnet. In den letzten Jahren haben große Technologiegiganten ein Wettrüsten um große Modelle mit Hunderten von Milliarden und Billionen Parametern gestartet und so die Leistung von KI-Modellen erheblich verbessert.

Allerdings ist diese Art von Forschungswettbewerb im Wettbewerb um „monetäre Fähigkeiten“ nicht freundlich zu gewöhnlichen Forschern, die nicht für Technologieriesen arbeiten, und hindert sie daran, groß rauszukommen Modelle. Das Studium von Prinzipien, möglichen Problemlösungen und mehr. Darüber hinaus beanspruchen in praktischen Anwendungen mehr Parameter mehr Platz und erfordern mehr Rechenressourcen für die Ausführung, was zu hohen Anwendungskosten für große Modelle führt. Wenn also ein Modell mit weniger Parametern die gleichen Ergebnisse erzielen kann wie ein anderes Modell, stellt dies eine deutliche Effizienzsteigerung dar. Dies ist für normale Forscher sehr benutzerfreundlich und es wird einfacher sein, das Modell in realen Umgebungen einzusetzen. Das ist der Sinn von Metas Forschung.

„Ich denke jetzt, dass wir innerhalb von ein oder zwei Jahren Sprachmodelle mit einem erheblichen Teil der Funktionen von ChatGPT auf unseren (Top-)Telefonen und Laptops ausführen werden“, unabhängig schrieb der Forscher für künstliche Intelligenz Simon Willison, als er die Auswirkungen des neuen KI-Modells von Meta analysierte.

Um das Modell zu trainieren und gleichzeitig die Anforderungen von Open Source und Reproduzierbarkeit zu erfüllen, verwendete Meta nur öffentlich verfügbare Datensätze, was sich von den meisten darauf basierenden Modellen unterscheidet auf nicht-großen Modellen für öffentliche Daten. Diese Modelle sind oft nicht Open Source und sind private Vermögenswerte großer Technologiegiganten. Um die Modellleistung zu verbessern, trainierte Meta mit mehr Token: LLaMA 65B und LLaMA 33B wurden mit 1,4 Billionen Token trainiert, und der kleinste LLaMA 7B verwendete ebenfalls 1 Billion Token.

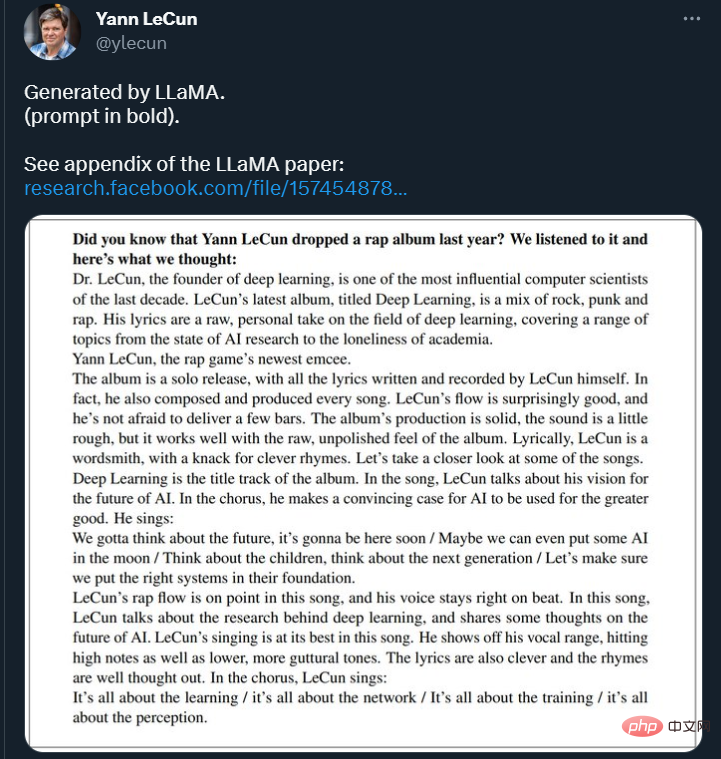

Auf Twitter zeigte LeCun auch einige Ergebnisse der LLaMA-Modellfortsetzung des Textes. Das Model wurde gebeten, fortzufahren: „Wussten Sie, dass Yann LeCun letztes Jahr ein Rap-Album veröffentlicht hat? Wir haben es uns angehört und Folgendes dachten wir: ____“

#🎜 🎜#

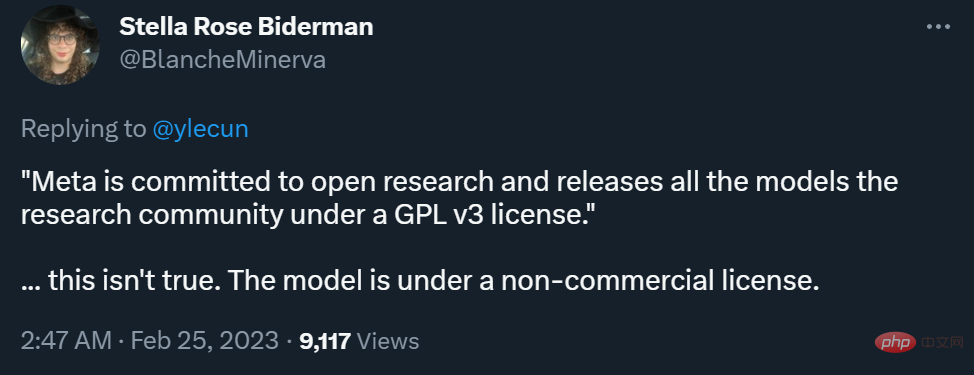

Allerdings haben die Unterschiede zwischen dem Meta-Blog und den Twitter-Aussagen von LeCun einiges verursacht, was die Frage angeht, ob es kommerzialisiert werden kann Kontroverse.

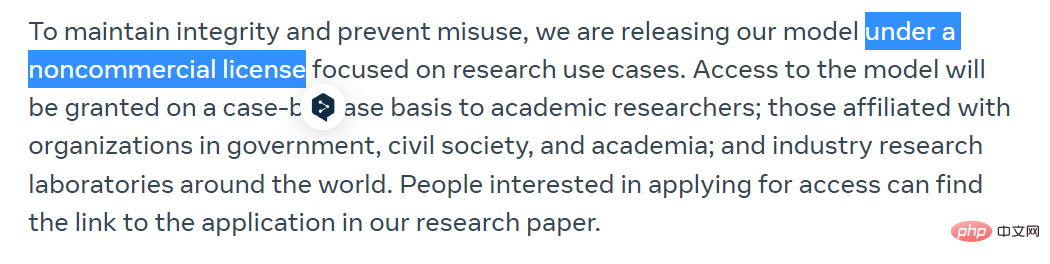

Meta erklärte im Blog, dass dies der Fall sei, um die Integrität zu wahren und Missbrauch zu verhindern Sie werden ihr Modell unter einer nichtkommerziellen Lizenz veröffentlichen, wobei der Schwerpunkt auf Forschungsanwendungsfällen liegt. Der Zugriff auf das Modell wird von Fall zu Fall akademischen Forschern, mit der Regierung, der Zivilgesellschaft und der Wissenschaft verbundenen Organisationen sowie industriellen Forschungslabors auf der ganzen Welt gewährt. Interessierte können sich unter folgendem Link bewerben:

https://docs.google.com/forms/d/e/1FAIpQLSfqNECQnMkycAp2jP4Z9TFX0cGR4uf7b_fBxjY_OjhJIL. l KGA/Ansichtsform

LeCun sagte, dass Meta sich für offene Forschung einsetzt und alle Modelle unter der GPL v3-Lizenz für die Forschungsgemeinschaft freigibt (GPL v3 erlaubt die kommerzielle Nutzung).

Diese Aussage ist ziemlich umstritten, da er nicht klargestellt hat, ob sich das „Modell“ hier auf Code oder Gewichte oder beides bezieht. Nach Meinung vieler Forscher ist das Gewicht des Modells viel wichtiger als der Code.

Als Antwort erklärte LeCun, dass der Modellcode unter der GPL v3-Lizenz offen ist.

Manche Leute glauben, dass dieses Maß an Offenheit keine echte „KI-Demokratisierung“ ist.

Derzeit hat Meta das Papier auf arXiv hochgeladen, und einige Inhalte wurden auch in das GitHub-Repository hochgeladen. Sie können es durchsuchen. 🔜 ://github.com/facebookresearch/llama Beispielaufgabe. Diese Wenig-Schuss-Eigenschaften traten erstmals bei der Skalierung von Modellen auf einen ausreichend großen Maßstab auf und brachten eine Reihe von Arbeiten hervor, die sich auf die weitere Skalierung dieser Modelle konzentrierten.

Diese Bemühungen basieren auf der Annahme, dass mehr Parameter zu einer besseren Leistung führen. Aktuelle Arbeiten von Hoffmann et al. (2022) zeigen jedoch, dass bei einem gegebenen Rechenbudget die beste Leistung nicht von den größten Modellen, sondern von kleineren Modellen erzielt wird, die auf mehr Daten trainiert werden. Das Ziel der von

- Hoffmann et al. (2022) vorgeschlagenen Skalierungsgesetze besteht darin, zu bestimmen, wie sich Datensatz- und Modellgrößen bei einem bestimmten Trainingsrechenbudget am besten skalieren lassen. Dieses Ziel ignoriert jedoch das Inferenzbudget, das bei der Bereitstellung von Sprachmodellen im großen Maßstab von entscheidender Bedeutung ist. In diesem Fall ist das bevorzugte Modell bei gegebenem Zielleistungsniveau nicht das am schnellsten zu trainierende, sondern das am schnellsten abzuleitende Modell. Während es möglicherweise günstiger ist, ein großes Modell zu trainieren, um ein bestimmtes Leistungsniveau zu erreichen, ist ein kleineres Modell, dessen Training länger dauert, letztendlich bei der Inferenz kostengünstiger. Obwohl Hoffmann et al. (2022) beispielsweise das Training eines 10B-Modells mit 200B-Tokens empfahl, stellten die Forscher fest, dass sich die Leistung des 7B-Modells auch nach 1T-Tokens weiter verbesserte.

- Der Schwerpunkt dieser Arbeit liegt darauf, eine Familie von Sprachmodellen zu trainieren, um bei einer Vielzahl von Inferenzbudgets eine optimale Leistung zu erzielen, indem mit mehr Token trainiert wird, als normalerweise verwendet werden. Das resultierende Modell namens LLaMA verfügt über Parameter im Bereich von 7B bis 65B und kann mit den besten vorhandenen LLMs mithalten. Obwohl LLaMA-13B beispielsweise zehnmal kleiner als GPT-3 ist, übertrifft es GPT-3 in den meisten Benchmarks.

- Die Forscher sagen, dass dieses Modell zur Demokratisierung der LLM-Forschung beitragen wird, da es auf einer einzigen GPU ausgeführt werden kann. In höheren Maßstäben ist das parametrische Modell LLaMA-65B auch mit den besten großen Sprachmodellen wie Chinchilla oder PaLM-540B vergleichbar. Im Gegensatz zu Chinchilla, PaLM oder GPT-3 verwendet dieses Modell nur öffentlich verfügbare Daten, wodurch diese Arbeit Open-Source-kompatibel ist, während die meisten bestehenden Modelle auf Daten basieren, die entweder nicht öffentlich verfügbar oder undokumentiert sind (z. B. Bücher-2 TB oder soziale Daten). Mediengespräche). Natürlich gibt es einige Ausnahmen, insbesondere OPT (Zhang et al., 2022), GPT-NeoX (Black et al., 2022), BLOOM (Scao et al., 2022) und GLM (Zeng et al., 2022). Aber keiner kann mit dem PaLM-62B oder Chinchilla mithalten.

Der Rest dieses Artikels beschreibt die Modifikationen der Forscher an der Transformatorarchitektur und den Trainingsmethoden. Anschließend wird die Modellleistung präsentiert und anhand einer Reihe von Standard-Benchmarks mit anderen großen Sprachmodellen verglichen. Schließlich demonstrieren wir Bias und Toxizität in Modellen anhand einiger der neuesten Benchmarks der verantwortlichen KI-Community.

Methodenübersicht

Die von den Forschern verwendete Trainingsmethode ähnelt der in früheren Arbeiten wie (Brown et al., 2020) und (Chowdhery et al., 2022) beschriebenen Methode und unterliegt der Chinchilla-Skalierung Gesetze (Hoffmann et al., 2022). Die Forscher verwendeten einen Standardoptimierer, um große Transformatoren für große Textdatenmengen zu trainieren.

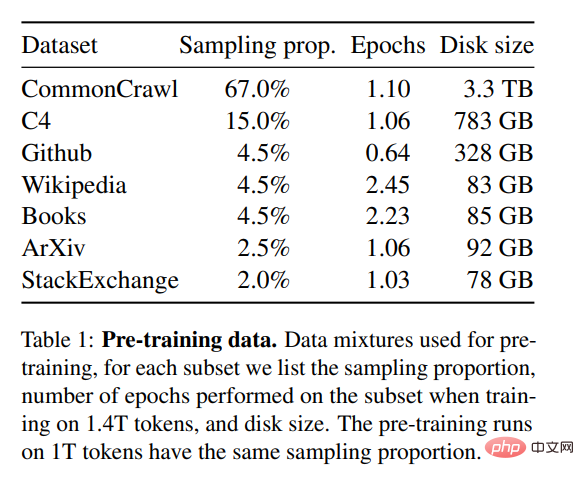

Daten vor dem Training

Wie in Tabelle 1 gezeigt, ist der Trainingsdatensatz für diese Studie eine Mischung aus mehreren Quellen, die verschiedene Bereiche abdecken. In den meisten Fällen verwenden Forscher Datenquellen wieder, die zum Trainieren anderer großer Sprachmodelle verwendet wurden. Die Einschränkung besteht hier jedoch darin, dass nur öffentlich verfügbare Daten verwendet werden können und diese mit offenen Ressourcen kompatibel sind. Die Datenmischung und deren Anteile im Trainingssatz sind wie folgt:

- Englisch CommonCrawl [67 %];

- Github [4,5 %];

- Wikipedia [4,5%];

- Gutenberg und Books3 [4,5%];

- ArXiv [2,5%];

- Stack Exchange [2%].

Der gesamte Trainingsdatensatz enthält nach der Tokenisierung ca. 1,4T Token. Für die meisten Trainingsdaten wird jedes Token während des Trainings nur einmal verwendet, mit Ausnahme der Wikipedia- und Books-Domänen, für die wir ungefähr zwei Epochen durchführen.

Der gesamte Trainingsdatensatz enthält nach der Tokenisierung ca. 1,4T Token. Für die meisten Trainingsdaten wird jedes Token während des Trainings nur einmal verwendet, mit Ausnahme der Wikipedia- und Books-Domänen, für die wir ungefähr zwei Epochen durchführen.

Architektur

Basierend auf jüngsten Arbeiten an großen Sprachmodellen verwendet diese Forschung auch die Transformatorarchitektur. Die Forscher griffen auf verschiedene Verbesserungen zurück, die anschließend vorgeschlagen und in verschiedenen Modellen wie PaLM verwendet wurden. In dem Artikel stellten die Forscher die wichtigsten Unterschiede zur ursprünglichen Architektur vor:

Vornormalisierung [GPT3]. Um die Stabilität des Trainings zu verbessern, normalisierten die Forscher den Eingang jeder Transformator-Unterschicht, anstatt den Ausgang zu normalisieren. Sie verwendeten die von Zhang und Sennrich (2019) vorgeschlagene RMSNorm-Normalisierungsfunktion.

- SwiGLU-Aktivierungsfunktion [PaLM]. Die Forscher verwendeten die von Shazeer (2020) vorgeschlagene SwiGLU-Aktivierungsfunktion, um die ReLU-Nichtlinearität zu ersetzen und die Leistung zu verbessern. Sie verwenden in PaLM die Dimensionen 2D, 3D bzw. 4D anstelle von 4D.

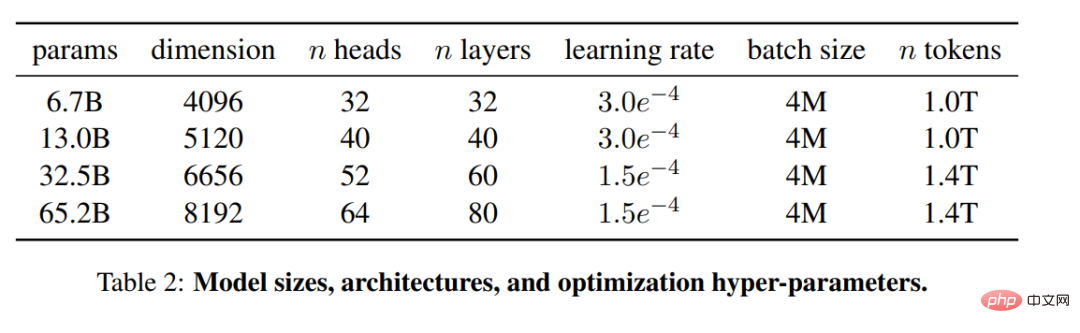

- Rotation Embed [GPTNeo]. Die Forscher entfernten die absolute Positionseinbettung und fügten die von Su et al. (2021) vorgeschlagene rotierte Positionseinbettung auf jeder Ebene des Netzwerks hinzu. Die Details der Hyperparameter verschiedener Modelle finden Sie in Tabelle 2. ... Erstens übertrifft LLaMA-65B Chinchilla-70B in allen gemeldeten Benchmarks außer BoolQ. Auch dieses Modell übertrifft den PaLM540B in jeder Hinsicht, außer bei BoolQ und WinoGrande. Auch das LLaMA-13B-Modell übertrifft GPT-3 bei den meisten Benchmarks, obwohl es zehnmal kleiner ist.

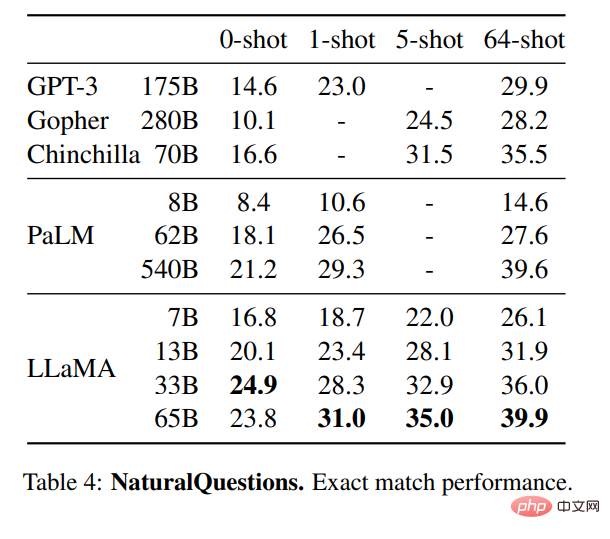

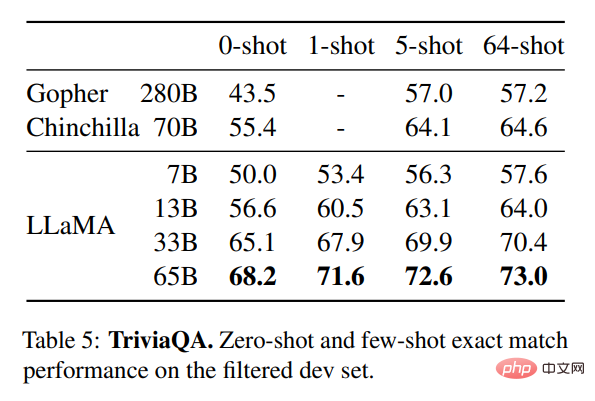

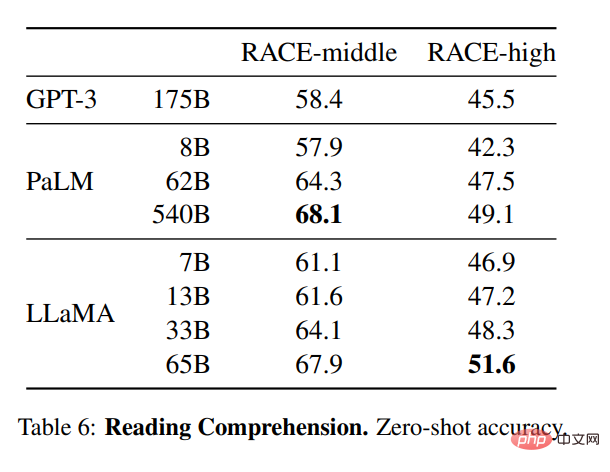

Tabelle 4 zeigt die Leistung von NaturalQuestions und Tabelle 5 zeigt die Leistung von TriviaQA. In beiden Benchmarks erreicht die LLaMA-65B sowohl im Zero- als auch im Wenig-Schuss-Modus Spitzenleistungen. Darüber hinaus ist LLaMA-13B in diesen Benchmarks gleichermaßen konkurrenzfähig, obwohl es nur ein Fünftel bis ein Zehntel so groß ist wie GPT-3 und Chinchilla. Der Inferenzprozess des Modells wird auf einer einzelnen V100-GPU ausgeführt. Die Forscher bewerteten das Modell auch anhand des RACE-Benchmarks zum Leseverständnis (Lai et al., 2017). Hier wird der Bewertungsaufbau von Brown et al. (2020) befolgt und Tabelle 6 zeigt die Bewertungsergebnisse. Bei diesen Benchmarks ist LLaMA-65B mit PaLM-540B konkurrenzfähig und LLaMA-13B übertrifft GPT-3 um mehrere Prozentpunkte.

Mathematisches Denken

Mathematisches Denken

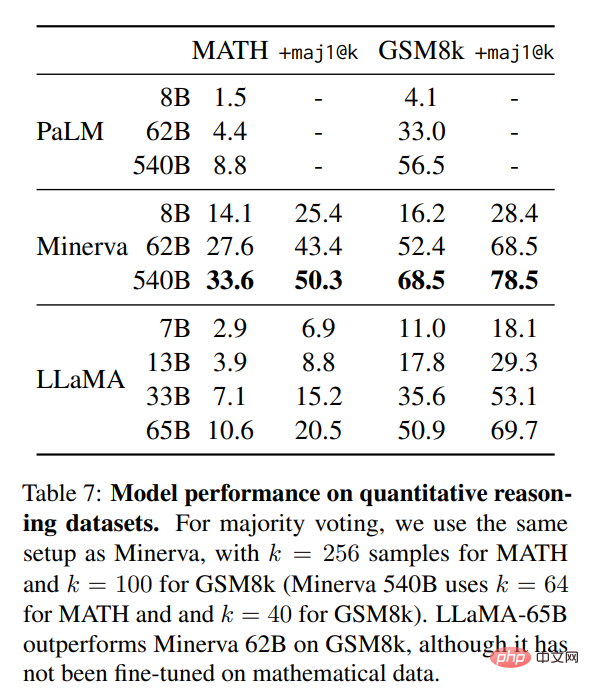

In Tabelle 7 verglichen die Forscher es mit PaLM und Minerva (Lewkowycz et al., 2022). Auf GSM8k stellten sie fest, dass LLaMA65B Minerva-62B übertraf, obwohl es nicht auf die mathematischen Daten abgestimmt war.

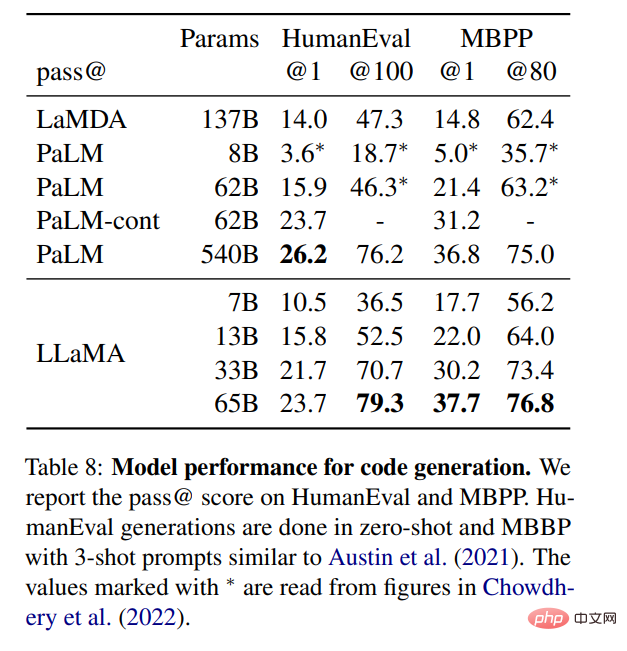

Codegenerierung

Codegenerierung

Wie in Tabelle 8 gezeigt, schneidet LLaMA bei einer ähnlichen Anzahl von Parametern besser ab als andere allgemeine Modelle wie LaMDA und PaLM, die nicht dediziert sind Code-Training oder Feinabstimmung. Bei HumanEval und MBPP übertrifft LLaMA LaMDA um 137B für Parameter über 13B. LLaMA 65B übertrifft auch PaLM 62B, auch wenn das Training länger dauert.

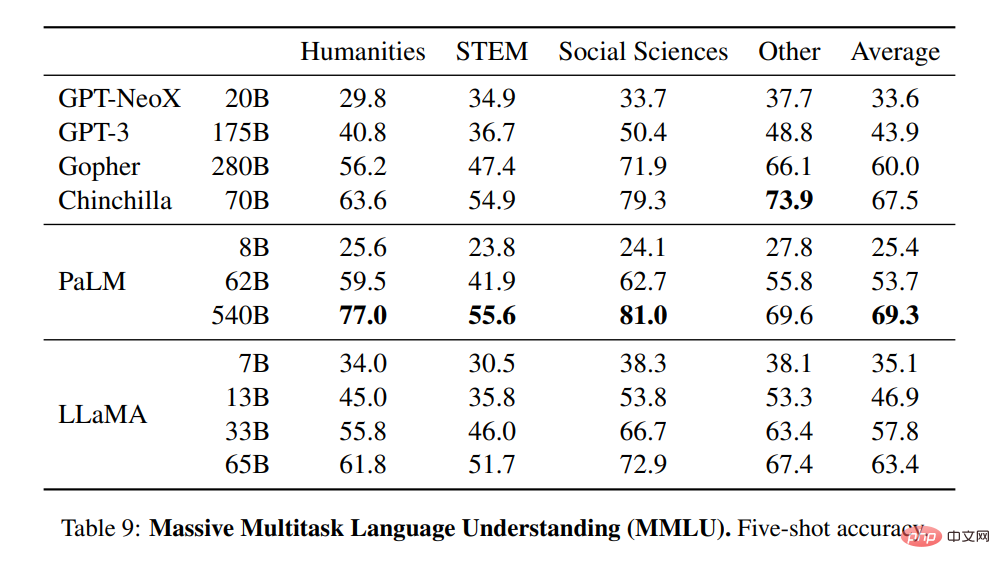

Sprachverständnis im großen Maßstab für mehrere Aufgaben

Sprachverständnis im großen Maßstab für mehrere Aufgaben

Die Forscher verwendeten die durch den Benchmark bereitgestellten Beispiele, um das Modell im 5-Schuss-Fall zu bewerten und die Ergebnisse in Tabelle 9 zu zeigen . Bei diesem Benchmark stellten sie fest, dass LLaMA-65B in den meisten Bereichen durchschnittlich einige Prozentpunkte hinter Chinchilla70B und PaLM-540B zurückblieb. Eine mögliche Erklärung ist, dass die Forscher in den Daten vor dem Training eine begrenzte Anzahl von Büchern und wissenschaftlichen Arbeiten verwendeten, nämlich ArXiv, Gutenberg und Books3, die insgesamt nur 177 GB umfassten, während die Modelle mit bis zu 2 TB an Büchern trainiert wurden. Die umfangreichen Bücher, die von Gopher, Chinchilla und PaLM verwendet werden, erklären möglicherweise auch, warum Gopher GPT-3 in diesem Benchmark übertrifft, in anderen Benchmarks jedoch gleichauf ist.

Leistungsänderungen während des Trainings

Leistungsänderungen während des Trainings

Während des Trainingszeitraums verfolgten die Forscher die Leistung des LLaMA-Modells anhand einiger Fragebeantwortungs- und Common-Sense-Benchmarks. Die Ergebnisse sind in Abbildung dargestellt 2. Die Leistung verbessert sich bei den meisten Benchmarks stetig und korreliert positiv mit der Trainingsstörung des Modells (siehe Abbildung 1).

Das obige ist der detaillierte Inhalt vonIst dies der Prototyp der Meta-Version von ChatGPT? Open Source, kann auf einer einzelnen GPU ausgeführt werden, übertrifft GPT-3 mit 1/10 der Anzahl der Parameter. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr