Heim >Technologie-Peripheriegeräte >KI >Verstoß gegen KI-Malerei ist bestätigt! Diffusionsmodelle erinnern sich möglicherweise an Ihre Fotos und alle vorhandenen Methoden zum Schutz der Privatsphäre sind wirkungslos

Verstoß gegen KI-Malerei ist bestätigt! Diffusionsmodelle erinnern sich möglicherweise an Ihre Fotos und alle vorhandenen Methoden zum Schutz der Privatsphäre sind wirkungslos

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 22:16:012016Durchsuche

Dieser Artikel wird mit Genehmigung von AI New Media Qubit (öffentliche Konto-ID: QbitAI) nachgedruckt. Bitte wenden Sie sich für einen Nachdruck an die Quelle.

Verstoß gegen KI-Malerei wurde bestätigt!

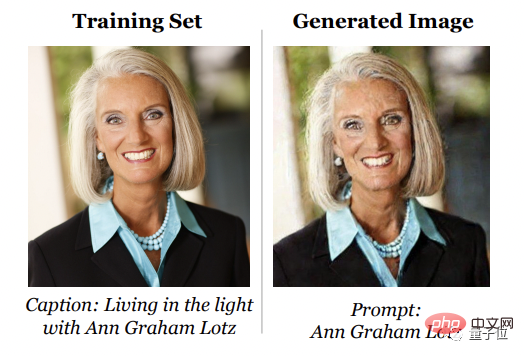

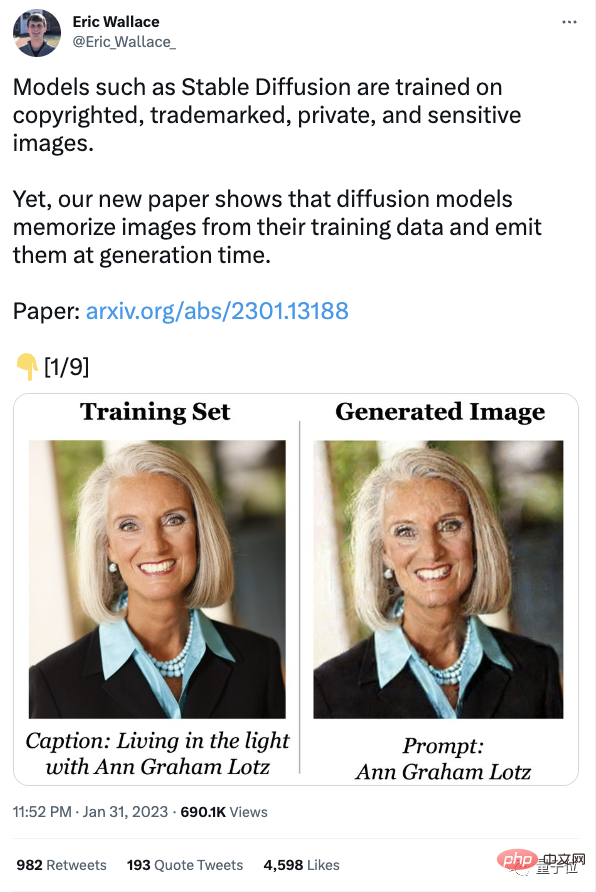

Die neuesten Forschungsergebnisse zeigen, dass das Diffusionsmodell die Proben im Trainingssatz „im Hinterkopf behält“ und sie bei der Generierung „imitiert“.

Mit anderen Worten, in den von Stable Diffusion generierten KI-Gemälden kann hinter jedem Schlag ein Verstoßvorfall stecken

Mit anderen Worten, in den von Stable Diffusion generierten KI-Gemälden kann hinter jedem Schlag ein Verstoßvorfall stecken

Nicht nur, dass nach Recherchen und Vergleichen die Fähigkeit des Diffusionsmodells, aus Trainingsbeispielen zu „plagiieren“, doppelt so hoch ist wie die von GAN, und je besser das Diffusionsmodell generiert wird, desto stärker ist seine Fähigkeit, sich Trainingsbeispiele zu merken.

Diese Forschung stammt von einem Team bestehend aus Google, DeepMind und UC Berkeley.Es gibt eine weitere schlechte Nachricht in der Zeitung, nämlich als Reaktion auf dieses Phänomen: „Alle bestehenden Methoden zum Schutz der Privatsphäre sind ungültig.“

Einige Leute beklagten: Es stellt sich heraus, dass es Sinn macht zu sagen, dass sie die urheberrechtlich geschützten Ergebnisse anderer Leute stehlen!

Unterstützen Sie die Klage! Verklagen Sie sie!

Jemand stand auf der Seite des Diffusionsmodells und sprach:

Einige Internetnutzer erweiterten die Ergebnisse des Papiers auch auf das beliebteste ChatGPT:

Alle vorhandenen Datenschutzmethoden sind ungültig

Diffusionsmodell Das Prinzip besteht darin, Rauschen zu entfernen und es dann wiederherzustellen. Was Forscher also tatsächlich untersuchen wollen, ist:

Die Bilder im Trainingsset stammen oft aus dem Internet. Sie sind urheberrechtlich geschützt, markenrechtlich geschützt und einige sind privat, wie zum Beispiel private medizinische Röntgenaufnahmen. Um herauszufinden, ob das Diffusionsmodell einzelne Trainingsmuster „speichern und regenerieren“ kann, schlugen die Forscher zunächst eine neue Definition von „Speicher“ vor.

Im Allgemeinen konzentriert sich die Definition des Gedächtnisses auf Textsprachmodelle. Wenn das Modell aufgefordert werden kann, eine Wort-für-Wort-Sequenz aus dem Trainingssatz wiederherzustellen, bedeutet dies, dass die Sequenz extrahiert und gespeichert wurde. Im Gegensatz dazudefinierte „Gedächtnis“

basierend auf der Bildähnlichkeit. Allerdings gibt das Team auch offen zu, dass die Definition von „Speicher“ konservativ ist.Das Bild links ist beispielsweise ein „Foto von Obama“, das mit Stable Diffusion erstellt wurde. Dieses Foto ähnelt keinem bestimmten Trainingsbild rechts, daher kann dieses Bild nicht als aus dem Speicher erstellt gezählt werden.

Aber das bedeutet nicht, dass die Fähigkeit von Stable Difusion, neue identifizierbare Bilder zu generieren, nicht das Urheberrecht und die Privatsphäre verletzt.

Als nächstes extrahierten sie mehr als 1.000 Trainingsbeispiele, darunter persönliche Fotos und Firmenausschreibungen, und entwarfen dann eine

zweistufige Datenextraktion  (Datenextraktionsangriff)

(Datenextraktionsangriff)

Durch die Anwendung dieses Ansatzes auf Stable Diffusion und Imagen extrahierte das Team über 100 ungefähre oder identische Kopien von Trainingsbildern. Es gibt sowohl identifizierbare persönliche Fotos als auch Markenlogos. Nach der Prüfung sind die meisten davon urheberrechtlich geschützt.

Um besser zu verstehen, wie „Gedächtnis“ entsteht, haben die Forscher dann eine Million Mal Stichproben aus dem Modell gezogen und Hunderte von Diffusionsmodellen auf CIFAR-10 trainiert.

Der Zweck besteht darin, zu analysieren, welche Verhaltensweisen in Bezug auf Modellgenauigkeit, Hyperparameter, Verbesserung und Deduplizierung Auswirkungen auf die Privatsphäre haben.

Endlich bin ich zu folgendem Schluss gekommen:

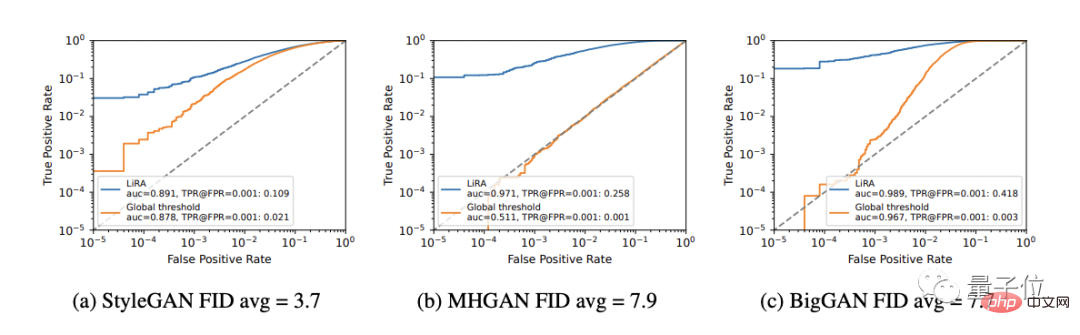

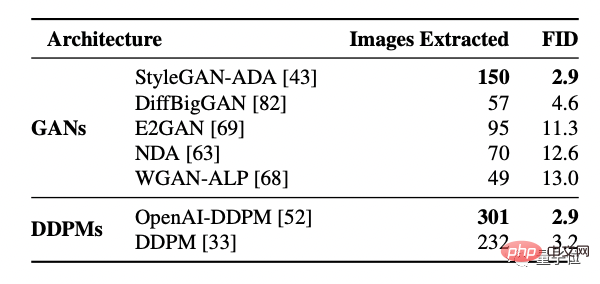

Erstens hat das Diffusionsmodell mehr Speicher als GAN.

Aber Diffusionsmodelle sind auch die Gruppe mit der schlechtesten Privatsphäre unter den bewerteten Bildmodellen, und sie verlieren mehr als doppelt so viele Trainingsdaten wie GANs.

Außerdem merken sich größere Modelle möglicherweise mehr Daten.

Mit dieser Schlussfolgerung untersuchten die Forscher auch das 2-Milliarden-Parameter-Text-Bild-Diffusionsmodell Imagen. Sie versuchten, 500 Bilder mit den höchsten Werten außerhalb der Verteilung zu extrahieren und verwendeten sie als Proben im Trainingsdatensatz alles auswendig gelernt.

Im Gegensatz dazu wurde die gleiche Methode auf die stabile Diffusion angewendet und es wurde kein Gedächtnisverhalten festgestellt.

Daher bietet Imagen bei kopierten und nicht kopierten Bildern eine schlechtere Privatsphäre als Stable Difusion. Die Forscher führen den Grund darauf zurück, dass das von Imagen verwendete Modell eine größere Kapazität als Stable Difusion hat und sich daher mehr Bilder merkt.

Darüber hinaus bessere generative Modelle (niedrigere FID-Werte) speichern mehr Daten.

Mit anderen Worten: Mit der Zeit verliert dasselbe Modell immer mehr an Privatsphäre und verletzt immer mehr Urheberrechte.

(GAN-Modell sortiert nach FID, je niedriger der FID-Wert, desto besser der Effekt)

Durch das Training des Modells stellte das Team fest, dass ein zunehmender Nutzen die Privatsphäre verringert, einfache Abwehrmaßnahmen (wie z Deduplizierung) )Nicht genug, um den Speichermangel vollständig zu beheben.

Daher bieten Technologien zur Verbesserung der Privatsphäre keinen akzeptablen Kompromiss zwischen Privatsphäre und Nutzen.

Letztendlich gab das Team vier Empfehlungen für diese Trainingsdiffusionsmodelle ab:

- Es wird empfohlen, den Trainingsdatensatz zu deduplizieren und Übertraining zu minimieren;

- Es wird empfohlen, Datenextraktion oder andere Prüftechniken zu verwenden, um die Privatsphäre des trainierten Modells zu bewerten Risiken;

- Wenn es eine praktischere Datenschutztechnologie gibt, wird empfohlen, diese so oft wie möglich zu verwenden.

- Ich hoffe, dass die von KI generierten Bilder den Benutzern keine datenschutzbezogenen Teile kostenlos zur Verfügung stellen.

Die Urheberrechtsinhaber haben nie aufgehört, ihre Rechte zu verteidigen

Sobald die Recherche vorliegt, kann sie Auswirkungen auf den laufenden Rechtsstreit haben.

Ende Januar verklagte der große Bruder der Galerie, Getty Images(Getty Images), Stability AI vor dem Londoner High Court wegen Urheberrechtsverletzung.

△Stability AI

Getty Images geht davon aus, dass Stability AI „Millionen urheberrechtlich geschützter Bilder illegal kopiert und verarbeitet hat“, um seine stabile Verbreitung zu trainieren.

Ein Teil der Trainingsdaten von Stable Difussion ist Open Source. Nach der Analyse und Prüfung der Wasserzeichen wurde festgestellt, dass viele Fotoagenturen, darunter auch Getty, unwissentlich große Mengen an Material für das Trainingsset von Stable Difussion bereitgestellt hatten, was einen großen Teil davon ausmachte.

Aber von Anfang bis Ende hat Stability AI die Fotoagentur nicht kontaktiert.

Viele KI-Unternehmen glauben, dass diese Praxis durch Gesetze wie die US-amerikanische Fair-Use-Doktrin geschützt ist, aber die meisten Urheberrechtsinhaber stimmen dieser Aussage nicht zu und glauben, dass dieses Verhalten ihre Rechte verletzt.

Obwohl Stability AI zuvor eine Erklärung abgegeben hat, dass Urheberrechtsinhaber in der nächsten Version ihre eigenen urheberrechtlich geschützten Werke in der Trainingsgalerie löschen können, gibt es zum jetzigen Zeitpunkt immer noch Leute, die davon nicht überzeugt sind.

Mitte Januar hatten drei Künstler eine Klage gegen Stability AI und Midjourney eingereicht.

Auch Rechtsexperten vertreten unterschiedliche Meinungen, um zu einer einheitlichen Meinung zu gelangen, aber alle sind sich einig, dass das Gericht über die Frage des Urheberrechtsschutzes entscheiden muss.

Craig Peters, CEO von Getty Images, sagte, dass das Unternehmen eine Mitteilung an Stability AI gesendet habe, in der es hieß: „Sie werden bald in Großbritannien verklagt“!

Das Unternehmen sagte außerdem:

Die durch Verstöße verursachten Verluste sind uns egal und wir haben nicht die Absicht, die Entwicklung von KI-Kunstwerkzeugen zu stoppen.

Stabilitäts-KI vor Gericht zu bringen liegt nicht im Interesse unserer Getty-Familie.

Die Entscheidung, zu klagen, hat einen tieferen langfristigen Zweck, und ich hoffe, dass das Gericht neue Gesetze erlässt , um den Status quo zu regeln.

Das obige ist der detaillierte Inhalt vonVerstoß gegen KI-Malerei ist bestätigt! Diffusionsmodelle erinnern sich möglicherweise an Ihre Fotos und alle vorhandenen Methoden zum Schutz der Privatsphäre sind wirkungslos. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr