Heim >Technologie-Peripheriegeräte >KI >Was passiert beim Lernen von ChatGPT, wenn menschliches Feedback in die KI-Malerei eingeführt wird?

Was passiert beim Lernen von ChatGPT, wenn menschliches Feedback in die KI-Malerei eingeführt wird?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 21:04:011903Durchsuche

In jüngster Zeit haben tiefe generative Modelle bemerkenswerte Erfolge bei der Generierung hochwertiger Bilder aus Textaufforderungen erzielt, was teilweise auf die Skalierung tiefer generativer Modelle auf große Webdatensätze wie LAION zurückzuführen ist. Es bleiben jedoch einige erhebliche Herausforderungen bestehen, die verhindern, dass groß angelegte Text-zu-Bild-Modelle Bilder erzeugen, die perfekt auf Textaufforderungen abgestimmt sind. Beispielsweise können aktuelle Text-zu-Bild-Modelle häufig keinen zuverlässigen visuellen Text generieren und haben Schwierigkeiten bei der kombinierten Bildgenerierung.

Zurück im Bereich der Sprachmodellierung ist das Lernen aus menschlichem Feedback zu einer leistungsstarken Lösung geworden, um „Modellverhalten mit menschlichen Absichten in Einklang zu bringen“. Diese Art von Methode lernt zunächst durch menschliches Feedback zur Modellausgabe eine Belohnungsfunktion, die das widerspiegeln soll, was den Menschen bei der Aufgabe wichtig ist, und verwendet dann die gelernte Belohnungsfunktion durch einen verstärkenden Lernalgorithmus (z. B. PPO für die proximale Richtlinienoptimierung), um die Sprache zu optimieren Modelle. Dieses Reinforcement Learning with Human Feedback Framework (RLHF) hat erfolgreich groß angelegte Sprachmodelle (wie GPT-3) mit einer anspruchsvollen menschlichen Qualitätsbewertung kombiniert.

Inspiriert durch den Erfolg von RLHF im Sprachbereich schlugen Forscher von Google Research und Berkeley, Kalifornien, kürzlich eine Feinabstimmungsmethode zur Ausrichtung von Text an Bildmodellen unter Verwendung menschlichen Feedbacks vor.

Papieradresse: https://arxiv.org/pdf/2302.12192v1.pdf

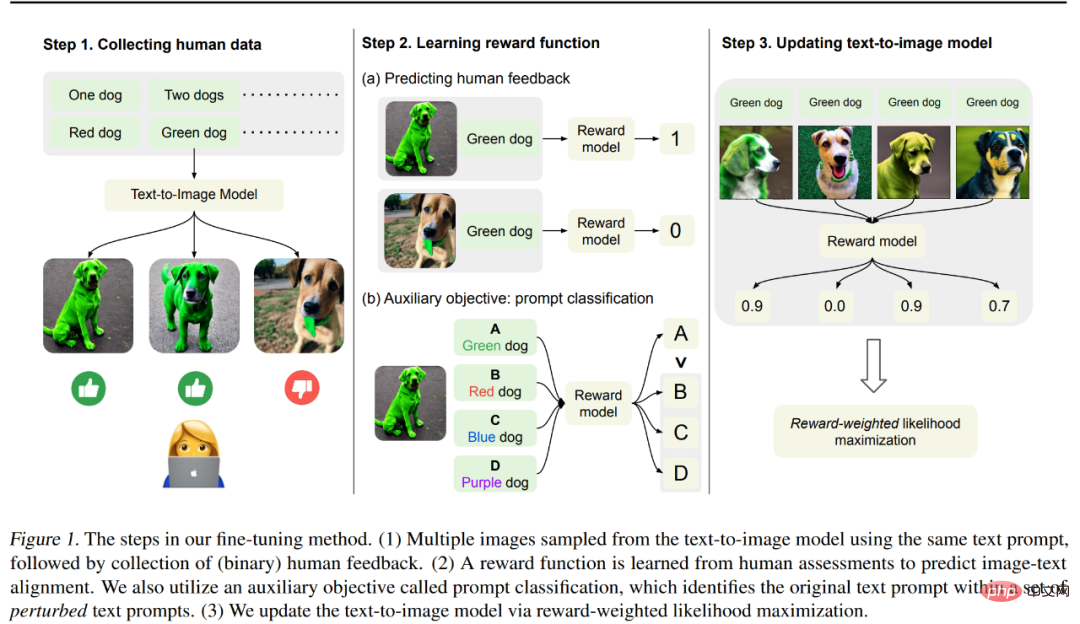

Die Methode dieses Artikels ist in Abbildung 1 unten dargestellt, die hauptsächlich in 3 unterteilt ist Schritte.

Schritt 1: Generieren Sie zunächst verschiedene Bilder aus einer Reihe von Textaufforderungen, „die dazu dienen, die Ausrichtung von Text an der Bildmodellausgabe zu testen“. Untersuchen Sie insbesondere die fehleranfälligeren Eingabeaufforderungen des vorab trainierten Modells – das Generieren von Objekten mit einer bestimmten Farbe, Nummer und einem bestimmten Hintergrund und das anschließende Sammeln binären menschlichen Feedbacks, das zur Bewertung der Modellausgabe verwendet wird.

Schritt 2: Trainieren Sie mithilfe eines von Menschen gekennzeichneten Datensatzes eine Belohnungsfunktion, um menschliches Feedback anhand von Bild- und Textaufforderungen vorherzusagen. Wir schlagen eine Hilfsaufgabe vor, um ursprüngliche Textaufforderungen aus einer Reihe gestörter Textaufforderungen zu identifizieren, um menschliches Feedback effektiver für das Belohnungslernen zu nutzen. Diese Technik verbessert die Verallgemeinerung der Belohnungsfunktion auf unsichtbare Bilder und Textaufforderungen.

Schritt 3: Aktualisieren Sie das Text-zu-Bild-Modell durch belohnungsgewichtete Wahrscheinlichkeitsmaximierung, um es besser an menschliches Feedback anzupassen. Im Gegensatz zu früheren Arbeiten, bei denen Reinforcement Learning zur Optimierung eingesetzt wurde, verwendeten die Forscher halbüberwachtes Lernen, um das Modell zu aktualisieren und die Qualität der Modellausgabe, also die erlernte Belohnungsfunktion, zu messen.

Die Forscher verwendeten 27.000 Bild-Text-Paare mit menschlichem Feedback, um das Stable Diffusion-Modell zu verfeinern. Die Ergebnisse zeigten, dass das fein abgestimmte Modell erhebliche Verbesserungen bei der Generierung von Objekten mit bestimmten Farben, Mengen usw. erzielte. und Hintergründe. Es wurde eine Verbesserung der Bild-Text-Ausrichtung um bis zu 47 % bei leichtem Verlust der Bildtreue erreicht.

Darüber hinaus wurden die kombinierten Generierungsergebnisse verbessert, um unsichtbare Objekte anhand einer Kombination aus unsichtbaren Farben, Mengen und Hintergrundaufforderungen besser zu generieren. Sie stellten außerdem fest, dass die erlernte Belohnungsfunktion besser mit den menschlichen Einschätzungen der Ausrichtung übereinstimmte als die CLIP-Werte bei Testtextaufforderungen.

Kimin Lee, der Erstautor des Papiers, sagte jedoch auch, dass die Ergebnisse dieses Papiers nicht alle Fehlermodelle im bestehenden Text-zu-Bild-Modell lösen und es noch viele Herausforderungen gebe. Sie hoffen, dass diese Arbeit das Potenzial des Lernens aus menschlichem Feedback bei der Ausrichtung von Vincent-Graphmodellen hervorheben wird.

Methodeneinführung

Um das generierte Bild an der Textaufforderung auszurichten, führte diese Studie eine Reihe von Feinabstimmungen am vorab trainierten Modell durch, und der Prozess ist siehe Abbildung 1 oben. Zuerst wurden entsprechende Bilder aus einer Reihe von Textaufforderungen generiert, ein Prozess, der darauf ausgelegt war, verschiedene Leistungen des vinzentinischen Graphenmodells zu testen. Anschließend gaben menschliche Bewerter binäres Feedback zu diesen generierten Bildern. Anschließend trainierte die Studie ein Belohnungsmodell, um menschliches Feedback vorherzusagen Textaufforderungen und Bilder als Eingabe; schließlich nutzt die Studie die belohnungsgewichtete Log-Likelihood, um das Vincent-Diagrammmodell zu verfeinern, um die Text-Bild-Ausrichtung zu verbessern.

Erhebung menschlicher Daten

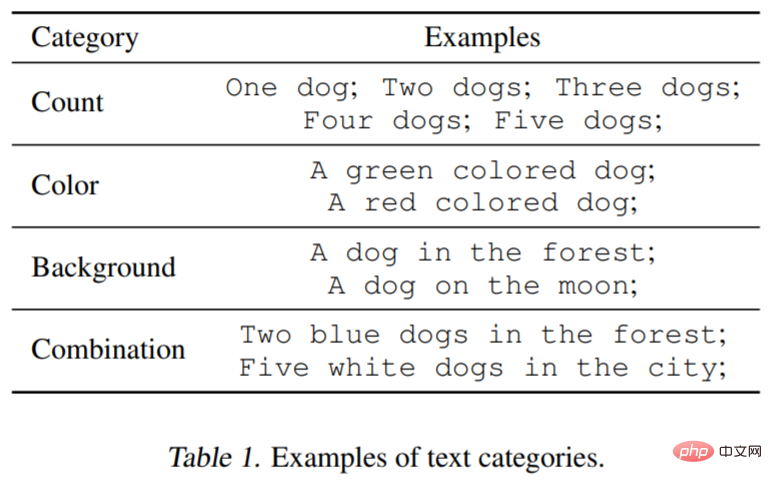

Um die Funktionalität von zu testen Basierend auf dem Vincent-Graphenmodell wurden in dieser Studie drei Arten von Textaufforderungen berücksichtigt: angegebene Anzahl, Farbe und Hintergrund. Für jede Kategorie generierte die Studie Eingabeaufforderungen, indem jedes Wort oder jede Phrase, die das Objekt beschrieb, wie z. B. Grün (Farbe) und ein Hund (Menge), gepaart wurden. Darüber hinaus berücksichtigte die Studie Kombinationen aus drei Kategorien (z. B. zwei grün gefärbte Hunde in einer Stadt). Tabelle 1 unten veranschaulicht die Datensatzklassifizierung besser. Jede Eingabeaufforderung wird zum Generieren von 60 Bildern verwendet, und das Modell ist hauptsächlich Stable Diffusion v1.5.

Menschlich. Feedback#🎜🎜 #

Als nächstes folgt menschliches Feedback zum generierten Bild. Drei von derselben Eingabeaufforderung generierte Bilder werden den Etikettierern vorgelegt und sie werden gebeten, zu bewerten, ob jedes generierte Bild mit der Eingabeaufforderung übereinstimmt, und die Bewertungskriterien werden gut oder schlecht sein. Da diese Aufgabe relativ einfach ist, reicht eine binäre Rückmeldung aus.

Belohnungslernen

Für die bessere Bewertung Die Bild-Text-Ausrichtung misst die Studie mithilfe einer Belohnungsfunktion  , die die CLIP-Einbettung von Bild x und Textaufforderung z auf Skalarwerte abbildet. Es wird dann verwendet, um menschliches Feedback k_y ∈ {0, 1} (1 = gut, 0 = schlecht) vorherzusagen.

, die die CLIP-Einbettung von Bild x und Textaufforderung z auf Skalarwerte abbildet. Es wird dann verwendet, um menschliches Feedback k_y ∈ {0, 1} (1 = gut, 0 = schlecht) vorherzusagen.

Formal gesehen ist die Belohnungsfunktion angesichts des menschlichen Feedback-Datensatzes D^human = {(x, z, y)} wird durch Minimierung des mittleren quadratischen Fehlers (MSE) trainiert:  Studien haben gezeigt, dass Datenerweiterungsmethoden die Dateneffizienz und Modelllernleistung erheblich verbessern können Um den Feedback-Datensatz effektiv zu nutzen, entwarf diese Studie ein einfaches Datenerweiterungsschema und Hilfsverluste für Belohnungslernen. Diese Studie verwendet erweiterte Eingabeaufforderungen in einer Hilfsaufgabe, d. h. das Klassifizierungsbelohnungslernen wird anhand der ursprünglichen Eingabeaufforderungen durchgeführt. Der Prompt-Klassifikator verwendet eine Belohnungsfunktion wie unten gezeigt: Aktualisieren Sie das Wensheng-Diagrammmodell. Da die Vielfalt des vom Modell generierten Datensatzes begrenzt ist, kann es zu einer Überanpassung kommen. Um dies abzumildern, minimierte die Studie auch den Verlust vor dem Training wie folgt:

Studien haben gezeigt, dass Datenerweiterungsmethoden die Dateneffizienz und Modelllernleistung erheblich verbessern können Um den Feedback-Datensatz effektiv zu nutzen, entwarf diese Studie ein einfaches Datenerweiterungsschema und Hilfsverluste für Belohnungslernen. Diese Studie verwendet erweiterte Eingabeaufforderungen in einer Hilfsaufgabe, d. h. das Klassifizierungsbelohnungslernen wird anhand der ursprünglichen Eingabeaufforderungen durchgeführt. Der Prompt-Klassifikator verwendet eine Belohnungsfunktion wie unten gezeigt: Aktualisieren Sie das Wensheng-Diagrammmodell. Da die Vielfalt des vom Modell generierten Datensatzes begrenzt ist, kann es zu einer Überanpassung kommen. Um dies abzumildern, minimierte die Studie auch den Verlust vor dem Training wie folgt:

Experimentelle Ergebnisse

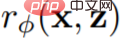

Der experimentelle Teil dient dazu, die Wirksamkeit des menschlichen Feedbacks zu testen, das an der Feinabstimmung des Modells beteiligt ist. Das im Experiment verwendete Modell ist Stable Diffusion v1.5; die Datensatzinformationen sind in Tabelle 1 (siehe oben) und Tabelle 2 aufgeführt. Tabelle 2 zeigt die Verteilung des Feedbacks, das von mehreren menschlichen Etikettierern bereitgestellt wird.

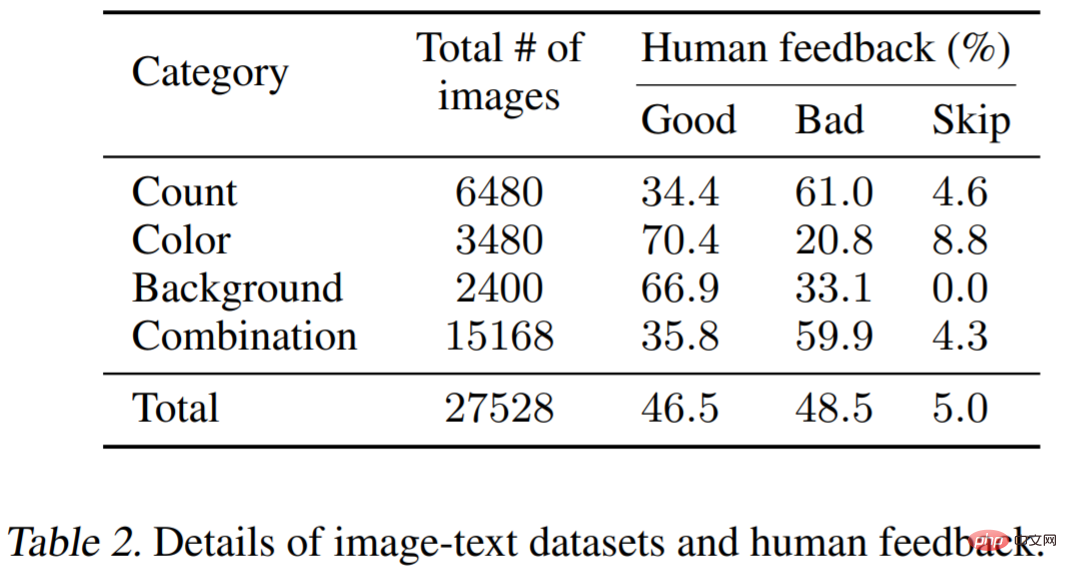

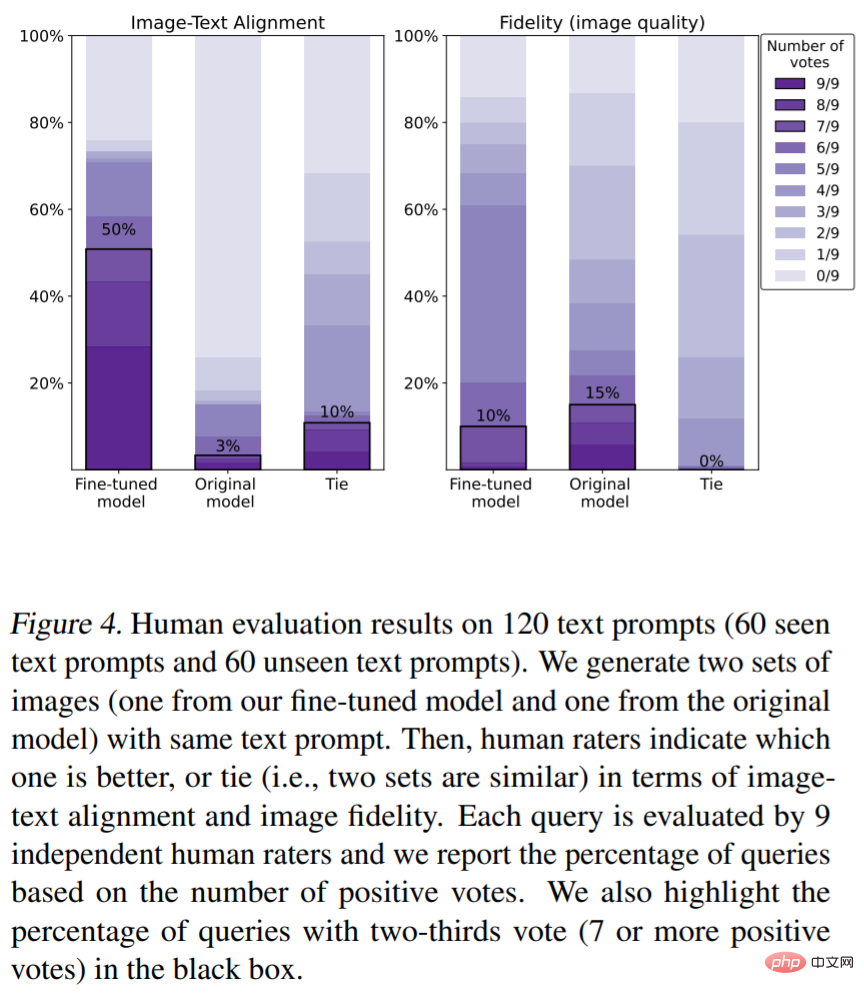

Menschliche Bewertungen der Text-Bild-Ausrichtung (Bewertungsmetriken sind Farbe, Anzahl). von Objekten). Wie in Abbildung 4 dargestellt, verbessert unsere Methode die Bild-Text-Ausrichtung erheblich. Insbesondere erhielten 50 % der vom Modell generierten Bilder mindestens zwei Drittel der Stimmen (die Anzahl der Stimmen betrug 7 oder mehr). Die Feinabstimmung verringert jedoch leicht die Bildtreue (15 % gegenüber 10 %). Abbildung 2 zeigt das entsprechende Modell des Originalmodells und die verfeinerte Version dieses Papierbildbeispiels. Es ist ersichtlich, dass das ursprüngliche Modell Bilder erzeugte, denen Details (wie Farbe, Hintergrund oder Anzahl) fehlten (Abbildung 2 (a)), und dass das von unserem Modell generierte Bild der durch die Eingabeaufforderung angegebenen Farbe, Anzahl und Hintergrund entspricht . Es ist erwähnenswert, dass unser Modell auch unsichtbare Textaufforderungsbilder mit sehr hoher Qualität erzeugen kann (Abbildung 2 (b)).

Belohnen Sie die Ergebnisse des Lernens. Abbildung 3(a) zeigt die Bewertungen des Modells für gesehene Textaufforderungen und unsichtbare Textaufforderungen. Belohnungen (grün) entsprechen eher typischen menschlichen Absichten als CLIP-Werte (rot).

Das obige ist der detaillierte Inhalt vonWas passiert beim Lernen von ChatGPT, wenn menschliches Feedback in die KI-Malerei eingeführt wird?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr