Heim >Technologie-Peripheriegeräte >KI >Wie viel Potenzial haben Festparametermodelle? Hong Kong Chinese, Shanghai AI Lab und andere schlugen ein effizientes Videoverständnis-Framework EVL vor

Wie viel Potenzial haben Festparametermodelle? Hong Kong Chinese, Shanghai AI Lab und andere schlugen ein effizientes Videoverständnis-Framework EVL vor

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 20:58:041162Durchsuche

Visuelle Basismodelle haben in den letzten zwei Jahren eine bemerkenswerte Entwicklung erzielt. Einerseits hat das auf großen Internetdaten basierende Vortraining eine große Anzahl semantischer Konzepte für das Modell voreingestellt und somit eine gute Generalisierungsleistung erzielt, andererseits aber auch die volle Nutzung der Modellgröße ermöglicht Durch das Wachstum großer Datensätze stehen verwandte Modelle bei der Migration zu nachgelagerten Aufgaben vor Ineffizienzproblemen, insbesondere bei Videoverständnismodellen, die mehrere Frames verarbeiten müssen.

- Papierlink: https://arxiv.org/abs/2208.03550

- Codelink: https://github.com/OpenGVLab/efficient-video-recognition

Basierend auf den beiden oben genannten Merkmalen schlugen Forscher der Chinesischen Universität Hongkong, des Shanghai Artificial Intelligence Laboratory und anderer Institutionen ein effizientes EVL-Framework für das Videoverständnis-Transferlernen vor, das Trainingsberechnungen und Speicher spart, indem es das Gewicht des Grundgerüsts festlegt Modellverbrauch; gleichzeitig bleibt durch die Verwendung mehrstufiger, feinkörniger Zwischenfunktionen die Flexibilität der traditionellen End-to-End-Feinabstimmung weitestgehend erhalten.

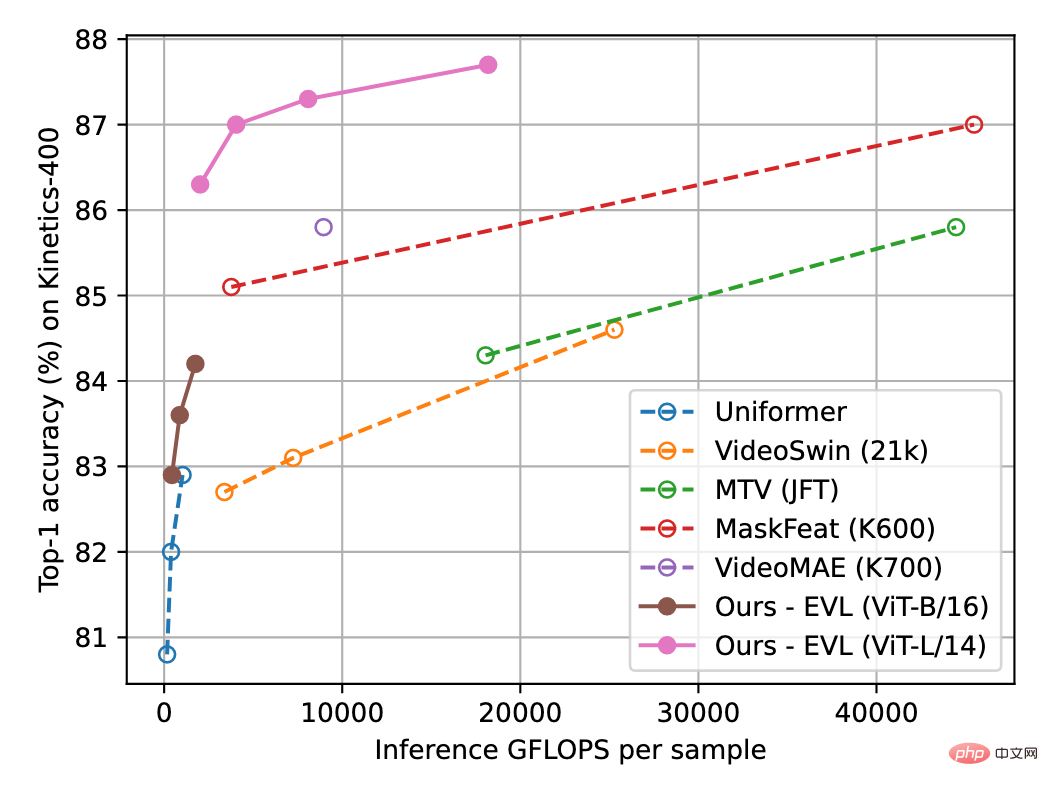

Abbildung 1 unten zeigt die Ergebnisse der EVL-Methode für den Videoverständnisdatensatz Kinetics-400. Experimente zeigen, dass diese Methode zwar Trainingsaufwand spart, aber dennoch das Potenzial des grundlegenden visuellen Modells bei Videoverständnisaufgaben vollständig ausschöpft.

Abbildung 1: Vergleich der Erkennungsgenauigkeit von Kinetics-400. Die horizontale Achse ist der Umfang der Inferenzberechnung und die vertikale Achse ist die Genauigkeit. Das gesamte schematische Diagramm des Algorithmus

Methode

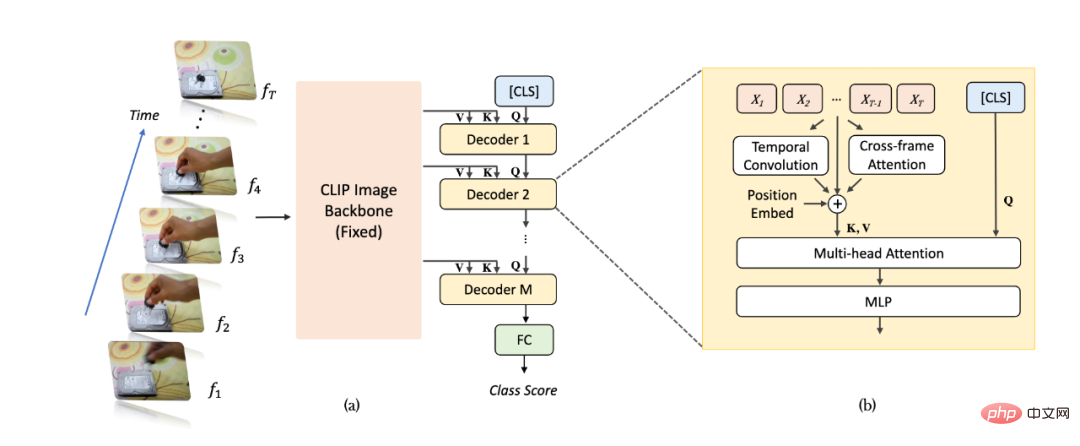

ist in Abbildung 2(a) dargestellt. Für ein Videobeispiel nehmen wir T-Frames, geben sie in ein Bilderkennungsnetzwerk ein (am Beispiel von CLIP) und extrahieren Merkmale. Im Vergleich zu herkömmlichen Methoden extrahieren wir mehrschichtige, nicht gepoolte Merkmale aus den letzten Schichten des Bilderkennungsnetzwerks, um reichhaltigere und feinkörnigere Bildinformationen zu erhalten, und die Parametergewichte des Bilderkennungsnetzwerks bleiben beim Videolernen immer konsistent behoben. Anschließend werden die mehrschichtigen Feature-Maps nacheinander in einen Transformer-Decoder zur Informationsaggregation auf Videoebene eingegeben. Die mehrschichtig dekodierten [CLS]-Merkmale werden verwendet, um die endgültige Klassifizierungsvorhersage zu generieren.

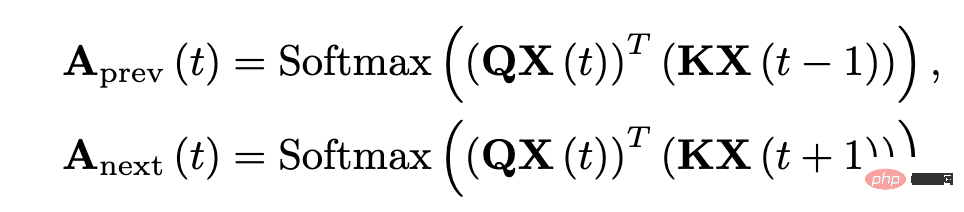

Wie in Abbildung 2(b) dargestellt, haben wir aufgrund der Störung bei der Aggregation von Funktionen des Transformer-Decoders ein zusätzliches Timing-Informationsmodellierungsmodul im Netzwerk hinzugefügt, um positionsbezogene feinkörnige Timing-Informationen besser zu extrahieren. Insbesondere fügen wir drei zusätzliche Arten von positionsbezogenen Zeitinformationen hinzu: Die erste ist die zeitliche Positionseinbettung (Position Embeddings), die zweite ist die tiefentrennbare Faltung der zeitlichen Dimension (Depthwise Convolution) und die dritte ist die Aufmerksamkeit zwischen benachbarten Frames Informationen erzwingen. Für interframe-Aufmerksamkeitsinformationen extrahieren wir die Abfrage- und Schlüsselmerkmale der entsprechenden Ebene aus dem Bilderkennungsnetzwerk und berechnen die Aufmerksamkeitskarte zwischen benachbarten Frames (im Gegensatz zum Bilderkennungsnetzwerk besteht die Aufmerksamkeitskarte aus der Abfrage aus dem der gleiche Rahmen und die gleichen Hauptmerkmale werden erhalten). Die resultierende Aufmerksamkeitskarte kann die Positionsänderungen von Objekten zwischen benachbarten Frames explizit widerspiegeln. Nach der linearen Projektion erhält die Aufmerksamkeitskarte eine Vektorgruppe, die die Verschiebungseigenschaften des Objekts widerspiegelt und in Form einer Element-für-Element-Addition in die Bildmerkmale integriert wird.

Abbildung 2: Strukturdiagramm des EVL-Algorithmus. (a) Gesamtstruktur, (b) Sequentielles Informationsmodellierungsmodul.

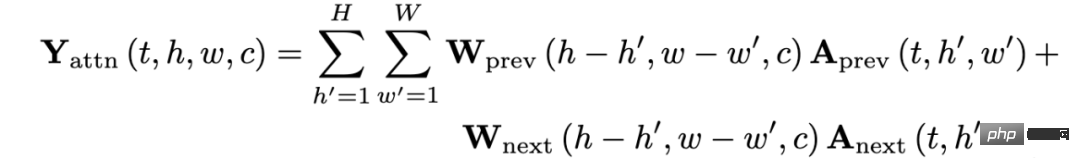

Abbildung 3: Mathematischer Ausdruck von Inter-Frame-Aufmerksamkeitsmerkmalen.

Experiment

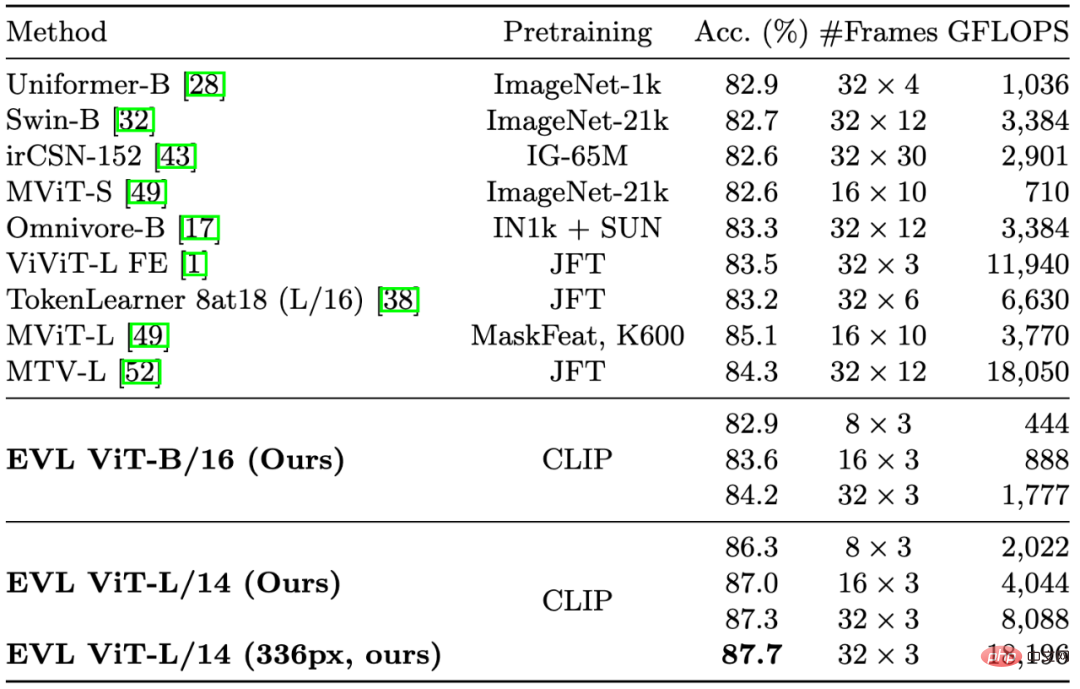

In Abbildung 1 und Tabelle 1 haben wir einige wichtige Methoden des vorherigen Videoverständnisses zitiert. Obwohl wir uns auf die Reduzierung des Trainingsaufwands konzentrieren, übertrifft unsere Methode immer noch bestehende Methoden in Bezug auf Genauigkeit (bei gleichem Rechenaufwand).

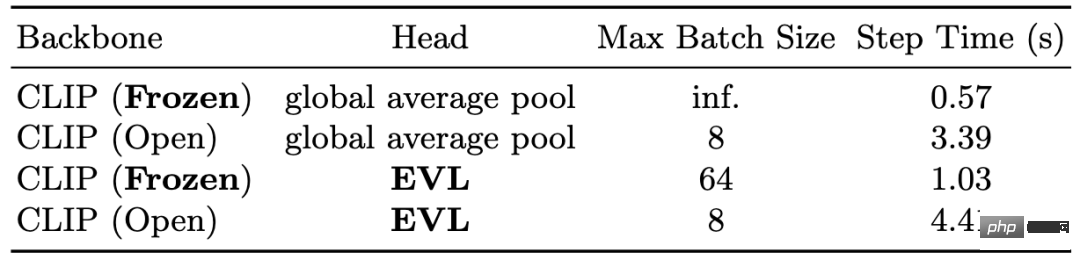

In Tabelle 2 zeigen wir die Reduzierung des Trainingsaufwands, die das feste Backbone-Netzwerk mit sich bringt. In Bezug auf den Speicher kann das feste Backbone-Netzwerk auf der V100-GPU eine maximale Stapelgröße von 64 erreichen, während das End-to-End-Training zeitlich nur 8 erreichen kann Netzwerk kann das Drei- bis Vierfache der Trainingszeit einsparen.

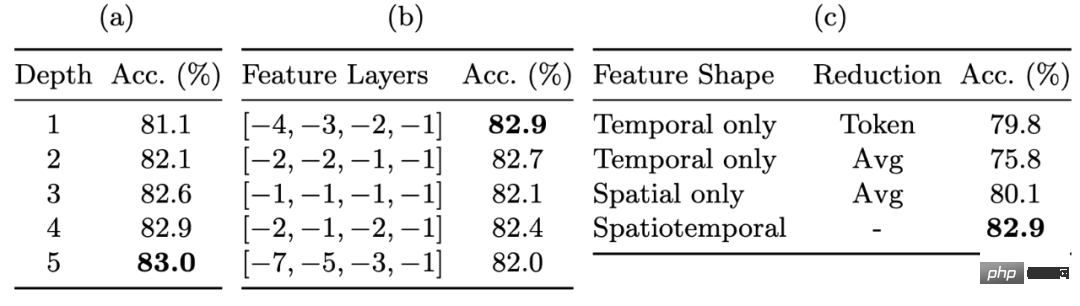

In Tabelle 3 zeigen wir die Verbesserung der Erkennungsleistung durch feinkörnige Feature-Maps. Die mehrschichtigen Unpooled-Funktionen ermöglichen es uns, ein erhebliches Maß an Flexibilität bei der Festlegung der Gewichte des Backbone-Netzwerks aufrechtzuerhalten. Die Verwendung nicht gepoolter Features bringt die deutlichste Verbesserung (ca. 3 %), gefolgt von der Verwendung von Multi-Layer-Decodern und Mid-Layer-Features, die ebenfalls jeweils etwa 1 % Leistungsverbesserung bringen.

Abschließend zeigen wir die Wirkung des feinkörnigen Timing-Informationsmoduls in Tabelle 4. Obwohl feinkörnige Timing-Informationen einen begrenzten Einfluss auf die Leistung von Kinetics-400 haben, sind sie für die Leistung von Something-Something-v2 sehr wichtig: Die drei Arten von feinkörnigen Timing-Informationsmodulen bringen insgesamt etwa 0,5 % und ca. 14 % Leistungsverbesserung. Tabelle 1: Vergleichsergebnisse mit vorhandenen Methoden für Kinetics-400

Tabelle 3: Die Auswirkung feinkörniger Feature-Maps auf die Genauigkeit

Tabelle 4: Die Auswirkung feinkörniger zeitlicher Informationsmodellierung auf verschiedene Datensätze

Zusammenfassung

Zusammenfassung

In diesem Artikel wird das EVL-Videoverständnis-Lernframework vorgeschlagen, das zum ersten Mal das große Potenzial eines Festbild-Backbone-Netzwerks bei Videoverständnisproblemen demonstriert und außerdem leistungsstarkes Videoverständnis für Forschungsgruppen mit begrenzter Rechenleistung benutzerfreundlicher macht Ressourcen. Wir glauben auch, dass unsere Methode mit der Verbesserung der Qualität und des Maßstabs grundlegender visueller Modelle eine Referenz für nachfolgende Forschungen zu leichtgewichtigen Transferlernalgorithmen sein kann.

Das obige ist der detaillierte Inhalt vonWie viel Potenzial haben Festparametermodelle? Hong Kong Chinese, Shanghai AI Lab und andere schlugen ein effizientes Videoverständnis-Framework EVL vor. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr