Heim >Technologie-Peripheriegeräte >KI >Die beiden Auszubildenden von Li Feifei leiten gemeinsam: Ein Roboter, der „multimodale Eingabeaufforderungen' verstehen kann, kann die Nullschussleistung um das 2,9-fache verbessern

Die beiden Auszubildenden von Li Feifei leiten gemeinsam: Ein Roboter, der „multimodale Eingabeaufforderungen' verstehen kann, kann die Nullschussleistung um das 2,9-fache verbessern

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 20:37:081472Durchsuche

Die nächste Entwicklungschance im Bereich der künstlichen Intelligenz könnte darin bestehen, das KI-Modell mit einem „Körper“ auszustatten und mit der realen Welt zu interagieren, um zu lernen.

Verglichen mit vorhandener natürlicher Sprachverarbeitung, Computer Vision und anderen Aufgaben, die in bestimmten Umgebungen ausgeführt werden, Offenfeldroboter-Technologie #🎜🎜 # ist offensichtlich schwieriger.

Promptbasiertes Lernen kann es beispielsweise ermöglichen, dass ein einzelnes Sprachmodell beliebige Verarbeitungsaufgaben in natürlicher Sprache ausführt, z B. beim Schreiben von Code. Um Zusammenfassungen und Fragen und Antworten zu erstellen, müssen Sie nur die Eingabeaufforderung ändern.

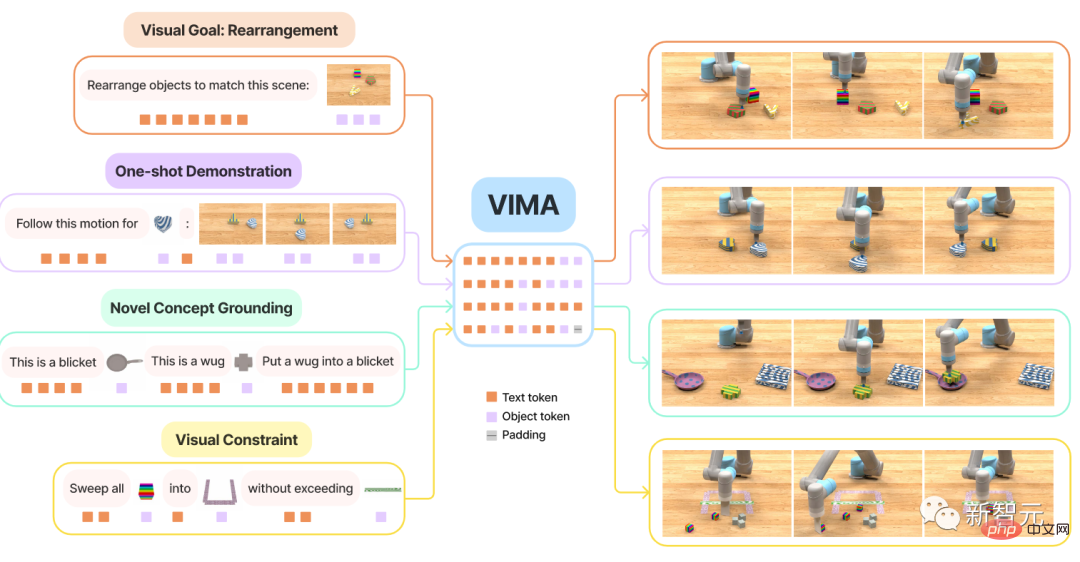

Aber Es gibt noch mehr Arten von Aufgabenspezifikationen in der Robotik , wie zum Beispiel die Nachahmung einer einzelnen Beispieldemonstration, das Befolgen mündlicher Anweisungen oder das Erreichen einer bestimmte visuelle Ziel, diese werden in der Regel als unterschiedliche Aufgaben angesehen, die von speziell ausgebildeten Modellen erledigt werden.

Forscher von NVIDIA, der Stanford University, dem Macalester College, Caltech, der Tsinghua University und der University of Texas in Austin haben gemeinsam ein VIMA vorgeschlagen, Ein universeller Roboteragent, der auf Transformer basiert, nutzt multimodale Eingabeaufforderung, um eine extrem hohe Generalisierungsleistung zu erreichen und kann eine große Anzahl von Roboteroperationsaufgaben bewältigen.

Papierlink: https://arxiv.org/abs/2210.03094

Projektlink: https://vimalabs.github.io/

# 🎜🎜#Code-Link: https://github.com/vimalabs/VIMA

Eingabeaufforderung fürgestaffelte Verwendung Der Text und die visuellen Symbole von .

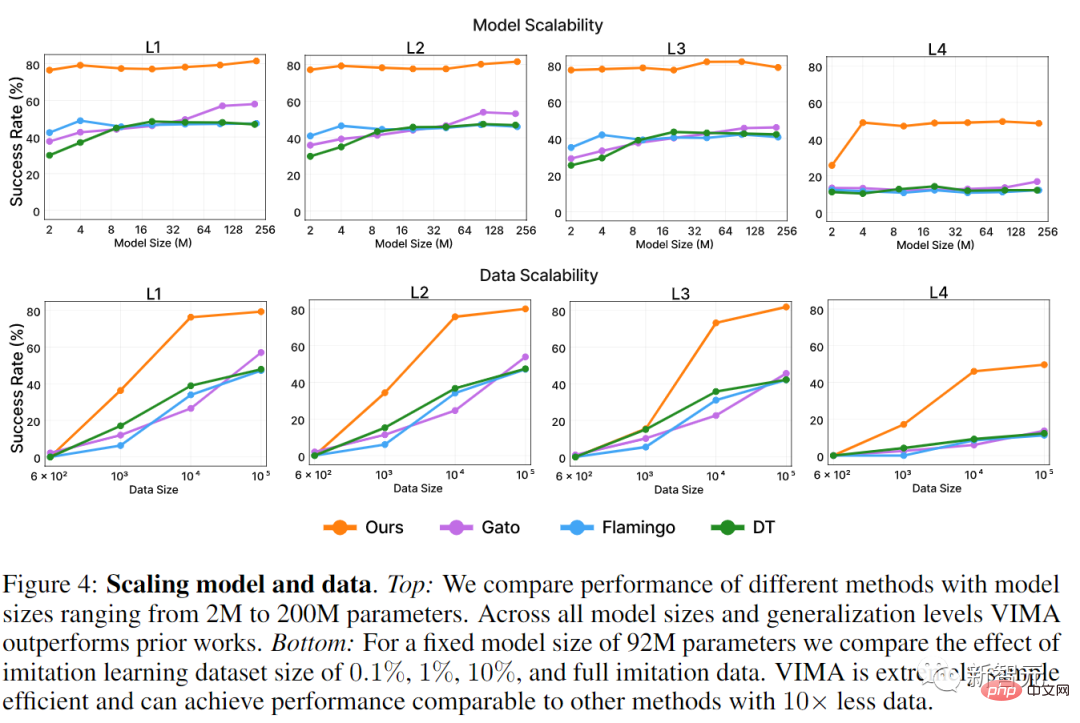

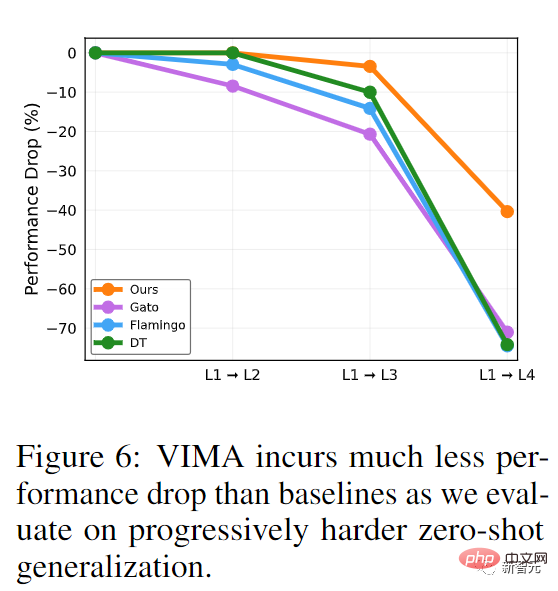

Um VIMA zu trainieren und zu bewerten, schlugen die Forscher einenneuen Simulations-Benchmark-Datensatz vor, der Tausende von programmgesteuert generierten Desktop-Aufgaben mit multimodalen Eingabeaufforderungen enthält und mehr als 600.000 Expertentrajektorien werden für Nachahmungslernen verwendet, um die Generalisierungsleistung des Modells in vier Ebenen zu bewerten. Unter der Bedingung eines Modells gleicher Größe und derselben Menge an Trainingsdaten werden VIMA-Aufgaben unter der schwierigsten Null-Schuss-Generalisierungseinstellung durchgeführt

Erfolgsquote Es ist das 2,9-facheder aktuellen Sota-Methode. Mit 10-mal weniger Trainingsdaten ist VIMA immer noch 2,7-mal besser als andere Methoden.

Derzeit sind alle Codes, vorab trainierten Modelle, Datensätze und Simulationsbenchmarks

vollständig Open Source. Der Erstautor des Artikels ist

Yunfan Jiang, ein Masterstudent im zweiten Jahr an der Stanford University, der derzeit Praktikant bei NVIDIA ist Forschungsinstitut. Abschluss an der University of Edinburgh im Jahr 2020. Sein Forschungsschwerpunkt ist verkörperte künstliche Intelligenz (verkörperte KI), die durch Interaktion mit der Umwelt lernt. Der spezifische Forschungsinhalt ist die Verwendung groß angelegter Basismodelle zur Implementierung offener verkörperter Agenten 🎜🎜#Der Artikel enthält zwei Tutoren, die beide ehemalige Schüler von Li Feifei waren.

Zhu Yuke

Zhu Yuke

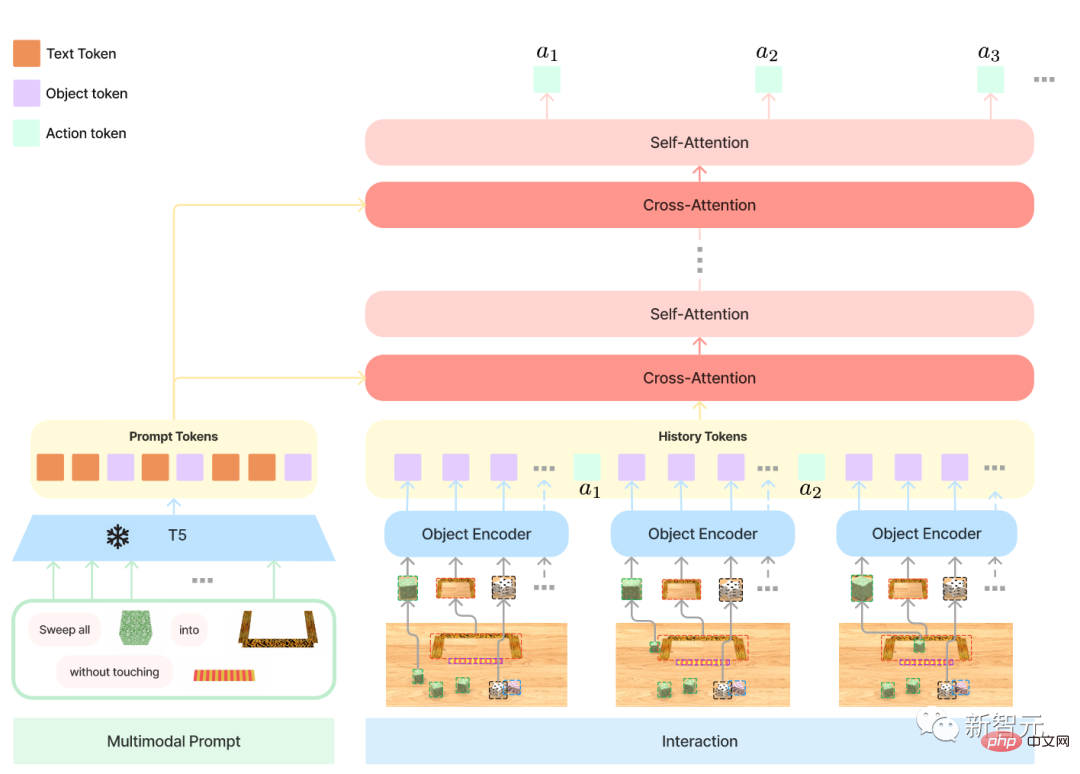

Fan Linxi, hat an der Stanford University promoviert, bei Li Feifei studiert und ist derzeit wissenschaftlicher Mitarbeiter bei NVIDIA AI. Die Hauptforschungsrichtung ist die Entwicklung allgemein fähiger autonomer Agenten. Spezifische Forschungsarbeiten umfassen grundlegende Modelle, politisches Lernen, Robotik, multimodales Lernen und Großsysteme. Transformer hat im Bereich NLP eine sehr hohe Leistung beim Multitasking erzielt. Nur ein Modell kann gleichzeitig Fragen und Antworten, maschinelle Übersetzung, Textzusammenfassung usw. durchführen. Die Schnittstelle zur Umsetzung verschiedener Aufgaben liegt in den Eingabetext-Prompts, wodurch spezifische Aufgabenanforderungen an das allgemeine Großmodell übergeben werden. Kann diese Eingabeaufforderungsschnittstelle auf einem allgemeinen Roboteragenten verwendet werden? Für einen Hausarbeitsroboter müssen Sie im Idealfall nur Bring es zu mir eintreten und der Roboter kann den Becher gemäß dem Bild holen. Wenn der Roboter neue Fähigkeiten erlernen muss, ist es am besten, diese durch die Eingabe von Videodemonstrationen zu erlernen. Wenn der Roboter mit unbekannten Objekten interagieren muss, kann dies einfach anhand einer Illustration erklärt werden. Um eine sichere Bereitstellung zu gewährleisten, können Benutzer gleichzeitig visuelle Einschränkungen festlegen, z Enthält hauptsächlich drei Teile: 1, Formale multimodale Eingabeaufforderung, die die Robotermanipulationsaufgabe in ein Sequenzmodellierungsproblem umwandelt; 3. Ein neues Roboter-Agentenmodell mit verschiedenen der Aufgabe zur systematischen Bewertung der Skalierbarkeit und Allgemeingültigkeit von Agenten Erstens ermöglicht die Flexibilität, die multimodale Eingabeaufforderungen bieten, Entwicklern die Spezifizierung und Erstellung eines einzelnen Modell zur Unterstützung einer großen Anzahl von Aufgabenspezifikationen. In diesem Artikel werden hauptsächlich sechs Arten von Aufgaben berücksichtigt: 1, Einfache Objektmanipulation (Einfache Objektmanipulation) , die Aufgabenaufforderung erfolgt in Form von in 4; Einzelbeispiel-One-Shot-Videoimitation 6. Visuelles Denken (Visuelles Denken) in einen Container legen“ oder visuelles Denken erfordern Erinnerung, wie zum Beispiel „Legen Sie in den Behälter und stellen Sie ihn dann wieder an seinen Platz“ Es ist zu beachten, dass sich diese sechs Arten von Aufgaben nicht gegenseitig ausschließen, zum Beispiel einige Aufgaben Ein Verb (Romankonzept ), die noch nie zuvor gesehen wurde, kann durch das Demonstrationsvideo (Nachahmung) vorgestellt werden. Neuer Benchmark VIM-BENCH Es ist für eine kluge Frau schwierig, ohne Reis zu kochen, um das Modell zu trainieren einige unterstützende Daten als Multimodaler Roboter-Lern-Benchmark VIMA-BENCH vorbereitet. In der Simulationsumgebung zielen bestehende Benchmarks im Allgemeinen auf bestimmte Aufgabenspezifikationen ab. Derzeit gibt es keinen Benchmark, der eine umfangreiche multimodale Aufgabensuite und eine umfassende Testplattform zur gezielten Erkennung von Agentenfunktionen bereitstellen kann. Zu diesem Zweck bauten die Forscher VIMA-BENCH, indem sie den Ravens-Robotersimulator erweiterten, um eine erweiterbare Sammlung von Objekten und Texturen zu unterstützen, um multimodale Hinweise zu erstellen und eine große Anzahl von Aufgaben prozedural zu generieren. Konkret stellt VIMA-BENCH 17 Metaaufgaben mit multimodalen Eingabeaufforderungsvorlagen bereit, die in 1000 unabhängige Aufgaben instanziiert werden können. Jede Metaaufgabe gehört zu einer oder mehreren der oben genannten sechs Aufgabenspezifikationsmethoden. VIMA-BENCH kann durch geskriptete Oracle-Agenten eine große Menge an Nachahmungslerndaten generieren. Unter Beobachtung und Aktionen umfasst der Beobachtungsraum des Simulators RGB-Bilder, die aus Vorder- und Draufsichten gerendert wurden, und der Benchmark bietet außerdem realistische Objektsegmentierung und Begrenzungsrahmen für objektzentrierte Train-Modelle. VIM-BENCH erbt den erweiterten Aktionsraum aus früheren Arbeiten, der aus den grundlegendsten Bewegungsfertigkeiten wie „Pick and Place“, „Wischen“ usw. besteht, die durch die Haltung des Endeffekts bestimmt werden . Der Simulator verfügt außerdem über ein Skript-Orakelprogramm, das Expertendemonstrationen generieren kann, indem es privilegierte Simulatorzustandsinformationen verwendet, wie z. B. die genaue Position aller Objekte und die zugrunde liegende Interpretation multimodaler Anweisungen. Schließlich generierten die Forscher einen großen Offline-Datensatz von Expertenverläufen für Nachahmungslernen durch vorprogrammierte Orakel. Der Datensatz umfasst 50.000 Trajektorien für jede Metaaufgabe, also insgesamt 650.000 erfolgreiche Trajektorien. Behalten Sie außerdem eine Teilmenge von Objektmodellen und Texturen zur einfachen Auswertung bei und verwenden Sie 4 der 17 Metaaufgaben für Zero-Shot-Generalisierungstests. VIMA-BENCHs Standard für jede Aufgabe hat nur Erfolg und Misserfolg, und es gibt kein Belohnungssignal für Zwischenzustände. Zur Testzeit führten die Forscher die Agentenstrategie in einem Physiksimulator aus, um die Erfolgsquote zu berechnen, und die durchschnittliche Erfolgsquote über alle bewerteten Metaaufgaben hinweg war die endgültige gemeldete Metrik. Das Bewertungsprotokoll enthält vier Ebenen, um systematisch die Generalisierungsfähigkeit des Agenten zu prüfen. Jede Ebene weicht stärker von der Trainingsverteilung ab, sodass streng genommen eine Ebene schwieriger ist als die nächste. 1. Platzierungsverallgemeinerung: Während des Trainings sind alle Eingabeaufforderungen wörtlich, aber während des Tests ist die Platzierung von Objekten auf dem Desktop zufällig. 2, Kombinatorische Verallgemeinerung: Alle Materialien (Adjektive) und dreidimensionale Objekte (Substantive) können im Training gesehen werden, aber einige neue Kombinationsformen werden im Test auftauchen. 3. Neuartige Objektverallgemeinerung: Testaufforderungen und simulierte Arbeitsbereiche enthalten neue Adjektive und Objekte. 4, Neuartige Aufgabenverallgemeinerung: Eine neue Metaaufgabe mit einer neuen Eingabeaufforderungsvorlage während des Tests In der multimodalen Eingabeaufforderung sind insgesamt drei Formate enthalten: 1, Text, verwenden Sie das vorab trainierte T5-Modell, um Wörter zu segmentieren und Wortvektoren zu erhalten 2, Die gesamte Desktop-Szene, verwenden Sie zunächst Mask R-CNN, um alle unabhängigen Objekte zu identifizieren dargestellt durch einen Begrenzungsrahmen und ein zugeschnittenes Bild und dann mit einem Begrenzungsbo-Encoder bzw. ViT codiert. 3, Bild eines einzelnen Objekts, verwenden Sie auch ViT, um Token zu erhalten, und geben Sie dann die Ergebnissequenz in das vorab trainierte T5-Encodermodell ein. Robotersteuerung, das heißt, die Eingabe des Decoders ist die Darstellungs- und Trajektorienverlaufssequenz nach mehreren Queraufmerksamkeitsebenen in der Eingabeaufforderungssequenz. Ein solches Design kann die Verbindung zu Eingabeaufforderungen verbessern; die ursprünglichen Eingabeaufforderungs-Tokens besser behalten und verarbeiten und die Recheneffizienz steigern. Das experimentelle Design in der Testphase dient hauptsächlich der Beantwortung von drei Fragen: 1, Vergleich der Leistung von VIMA und früheren SOTA Transformer-basierten Agenten bei verschiedenen Aufgaben mit multimodalen Eingabeaufforderungen ; 2, VIMAs Skalierungseigenschaften in Bezug auf Modellkapazität und Datenvolumen; 3, Ob unterschiedliche visuelle Wortsegmentierer, bedingte Hinweise und bedingte Kodierung die endgültige Entscheidungsfindung beeinflussen. Die im Vergleich zu Basismodellen umfassen gato, flamingo und decision Transformator (DT). Wird für das Training verwendet und die Größe des Encoders wird immer beibehalten, da VIMA auf T5-Basis definitiv besser ist als andere Werke bei der Zero-Shot-Generalisierungsbewertung auf allen Ebenen. Obwohl Gato und Flamingo bei größeren Modellen eine verbesserte Leistung aufweisen, ist VIMA immer noch besser als alle Modelle. Bei der Datenskalierung Im Leistungsvergleich Progressive Generalisierung Referenz: https://arxiv.org/abs/2210.03094Roboter und multimodale Eingabeaufforderungen

VIMA-Modell

Das obige ist der detaillierte Inhalt vonDie beiden Auszubildenden von Li Feifei leiten gemeinsam: Ein Roboter, der „multimodale Eingabeaufforderungen' verstehen kann, kann die Nullschussleistung um das 2,9-fache verbessern. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr