Heim >Technologie-Peripheriegeräte >KI >Ein Artikel über die drei Kernelemente des autonomen Fahrens

Ein Artikel über die drei Kernelemente des autonomen Fahrens

- 王林nach vorne

- 2023-04-12 20:19:061317Durchsuche

Sensoren: Unterschiedliche Positionierung und Funktionen, komplementäre Vorteile

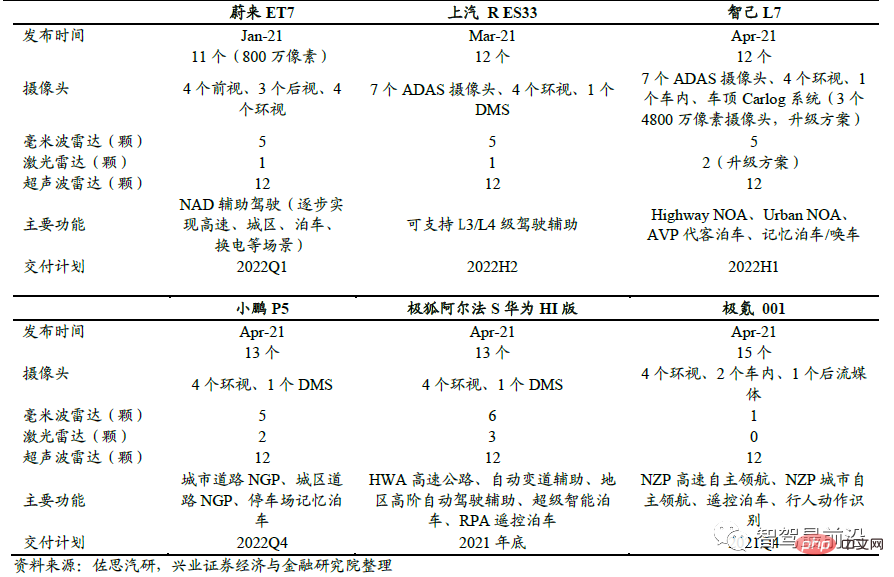

Autonome Fahrzeuge sind häufig mit einer Vielzahl von Sensoren ausgestattet, darunter Kameras und Millimeterwellenradar , LiDAR. Diese Sensoren haben jeweils unterschiedliche Funktionen und Positionierungen und ergänzen sich in ihren Vorteilen gegenseitig; sie werden zum Auge autonomer Fahrzeuge. Neue Autos nach 2021 werden mit einer großen Anzahl von Sensoren ausgestattet, um redundante Hardware für die Implementierung autonomerer Fahrfunktionen durch OTA zu reservieren.

Neue Inlandsveröffentlichungen von Januar bis Mai 2021 Auto Modellsensorkonfiguration und Kernfunktionen

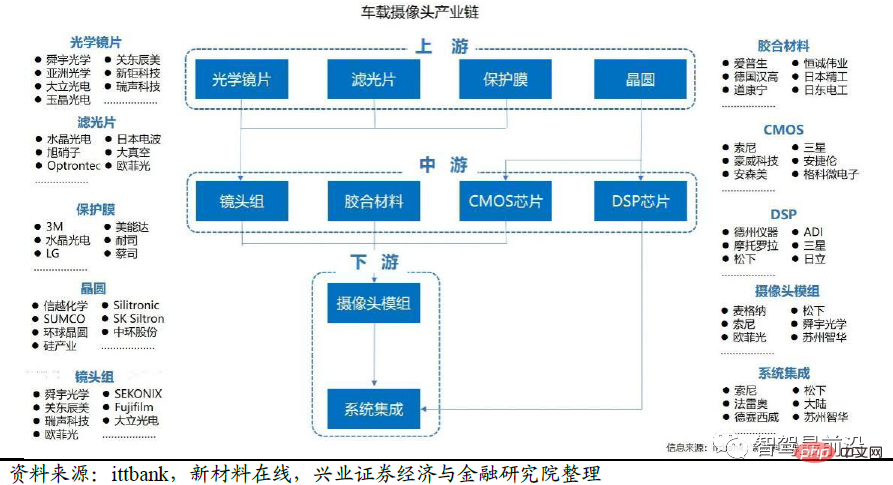

Funktion der Kamera: Wird hauptsächlich für Fahrspurlinien, Verkehrszeichen, Ampeln, Fahrzeug- und Fußgängererkennung und -erkennung verwendet Informationen Umfassende, kostengünstige Funktionen, jedoch beeinträchtigt durch Regen, Schnee, Wetter und Licht. Moderne Kameras bestehen aus Objektiven, Objektivmodulen, Filtern, CMOS/CCD, ISP und Datenübertragungsteilen. Das Licht wird auf den Sensor fokussiert, nachdem es die optische Linse und den Filter passiert hat. Das optische Signal wird über einen integrierten CMOS- oder CCD-Schaltkreis in ein elektrisches Signal umgewandelt und dann von dem in ein standardmäßiges digitales Bild im RAW-, RGB- oder YUV-Format umgewandelt Bildprozessor (ISP) Das Signal wird über die Datenübertragungsschnittstelle an den Computer übertragen. Kameras können eine Fülle von Informationen liefern. Allerdings ist die Kamera auf natürliche Lichtquellen angewiesen. Der aktuelle Dynamikbereich des visuellen Sensors ist nicht besonders groß. Wenn das Licht nicht ausreicht oder sich das Licht drastisch ändert, kann das visuelle Bild vorübergehend verloren gehen und die Funktion wird stark eingeschränkt Regen- und Verschmutzungsbedingungen In der Industrie wird Computer Vision normalerweise verwendet, um verschiedene Mängel von Kameras zu beheben.

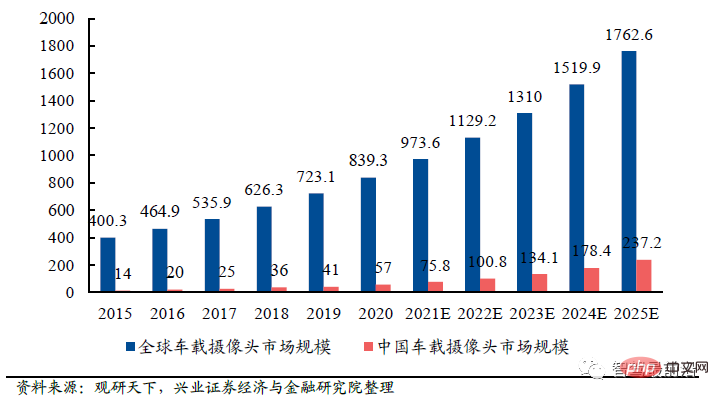

Autokameras sind ein wachstumsstarker Markt. Mit der kontinuierlichen Weiterentwicklung autonomer Fahrfunktionen nimmt der Einsatz von Kameras im Fahrzeug zu. Beispielsweise sind für die Vorwärtssicht im Allgemeinen 1–3 Kameras und für die Rundumsicht 4–8 Kameras erforderlich. Es wird erwartet, dass der globale Markt für Autokameras bis 2025 176,26 Milliarden Yuan erreichen wird, wovon der chinesische Markt 23,72 Milliarden Yuan erreichen wird.

Globaler und chinesischer Markt für Autokameras 2015–2025 Größe (100 Millionen Yuan) Chiplieferanten sowie Midstream-Modullieferanten und Systemintegratoren, nachgelagerte Unternehmen der Unterhaltungselektronik, autonomes Fahren Tier 1 usw. Wertmäßig entfallen 50 % der Gesamtkosten auf den Bildsensor (CMOS Image Sensor), gefolgt von der Modulverpackung mit 25 % und den optischen Linsen mit 14 %.

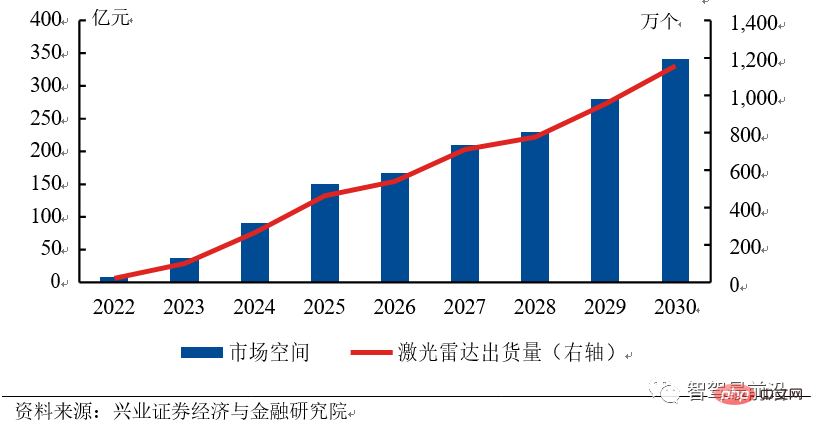

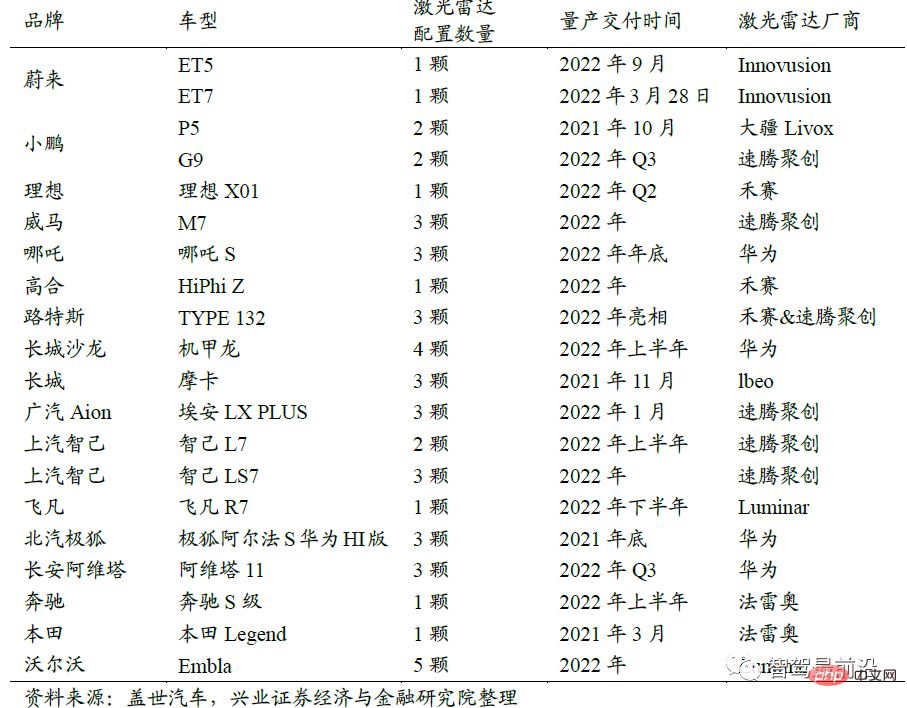

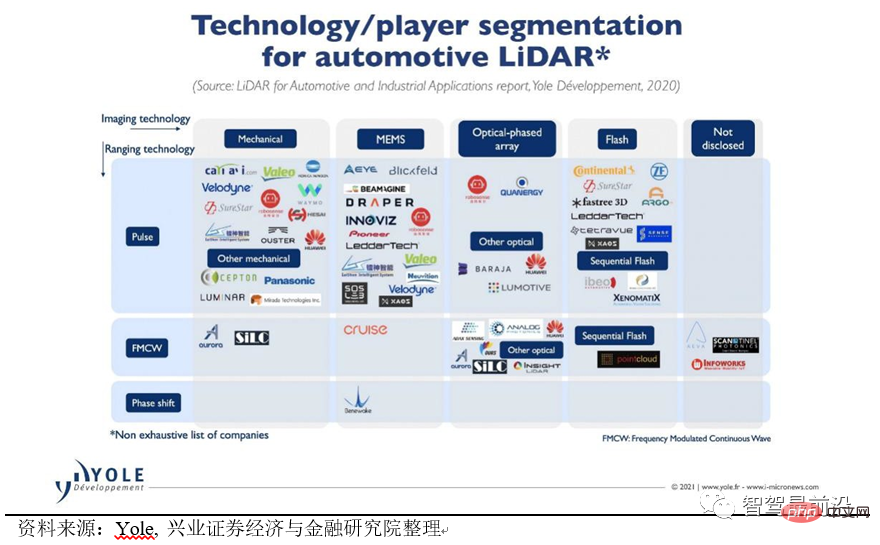

#🎜 🎜#Die Rolle von Lidar (Lidar): Wird hauptsächlich zur Erkennung der Entfernung und Geschwindigkeit umgebender Objekte verwendet. Am Sendeende des Lidars wird von einem Laserhalbleiter ein hochenergetischer Laserstrahl erzeugt. Nachdem der Laser mit den umliegenden Zielen kollidiert, wird er vom Empfangsende des Lidars erfasst und berechnet, um die Entfernung zu ermitteln Geschwindigkeit des Ziels. LiDAR verfügt über eine höhere Erkennungsgenauigkeit als Millimeterwellen und Kameras und kann große Entfernungen erfassen, die oft mehr als 200 Meter erreichen. LiDAR wird nach seinem Scanprinzip in mechanisches, rotierendes Spiegel-, MEMS- und Festkörper-LiDAR unterteilt. Nach dem Ranging-Prinzip kann es in Time-of-Flight Ranging (ToF) und Frequency Modulated Continuous Wave (FMCW) unterteilt werden. Die Branche befindet sich derzeit in der Erkundungsphase der Lidar-Anwendung, es gibt noch keine klare Richtung und es ist unklar, welcher technische Weg in Zukunft zum Mainstream werden wird. Der Laserradarmarkt ist riesig und chinesische Unternehmen werden in den Vereinigten Staaten führend sein. Der Lidar-Markt hat weitreichende Aussichten. Wir gehen davon aus, dass der chinesische Lidar-Markt bis 2025 fast 15 Milliarden Yuan groß sein wird und dass der Weltmarkt bis 2030 fast 35 Milliarden Yuan groß sein wird Yuan, und der Weltmarkt wird fast 65 Milliarden Yuan betragen. Die jährliche Wachstumsrate des Marktes erreichte 48,3 %. Tesla, das größte selbstfahrende Unternehmen in den Vereinigten Staaten, führt eine reine Vision-Lösung ein. Andere Automobilhersteller haben keine konkreten Pläne, Lidar in Autos einzubauen. Daher ist China zum größten potenziellen Markt für Automobil-Lidar geworden. Im Jahr 2022 werden zahlreiche inländische Fahrzeughersteller mit Lidar ausgestattete Produkte auf den Markt bringen, und es wird erwartet, dass die Auslieferungen von Lidar-Produkten für die Automobilindustrie im Jahr 2022 200.000 Einheiten erreichen werden. Chinesische Unternehmen haben eine höhere Gewinnwahrscheinlichkeit, weil sie näher am Markt sind, ein hohes Maß an Zusammenarbeit mit chinesischen OEMs haben und einfacher Marktaufträge erhalten können, sodass sie die Kosten schneller senken können und so einen positiven Kreislauf bilden. Chinas riesiger Markt wird chinesischen Lidar-Unternehmen dabei helfen, die Technologielücke zu ausländischen Unternehmen zu schließen. China LiDAR-Marktausblick von 2022 bis 2030 # 🎜🎜# Lidar-Modellliste#🎜 🎜# Die FMCW-Technologie existiert parallel zur TOF-Technologie: Die TOF-Technologie ist relativ ausgereift und bietet die Vorteile einer schnellen Reaktionsgeschwindigkeit und einer hohen Erkennungsgenauigkeit, kann die FMCW jedoch nicht direkt messen kann mehrere direkt passieren. Das Puller-Prinzip verfügt über eine hohe Messgeschwindigkeit und eine hohe Empfindlichkeit (mehr als zehnmal höher als ToF), eine starke Entstörungsfähigkeit, eine Erkennung über große Entfernungen und einen geringen Stromverbrauch. In Zukunft könnten High-End-Produkte FMCW und Low-End-Produkte TOF verwenden. 1550 nm ist besser als 905 nm: 905 nm ist ein Nahinfrarotlaser, der leicht von der menschlichen Netzhaut absorbiert wird und Netzhautschäden verursacht, daher kann die 905 nm-Lösung nur sein auf niedriger Leistung gehalten. Das Prinzip des 1550-nm-Lasers ist das sichtbare Spektrum. Der Laser verursacht bei gleicher Leistung weniger Schäden am menschlichen Auge und hat einen größeren Erfassungsbereich. Der Nachteil besteht jedoch darin, dass er InGaAs als Generator benötigt und keine Silizium-basierten Detektoren verwenden kann. Überspringen Sie den halbfesten Zustand und springen Sie direkt zum vollständigen festen Zustand: Zu den bestehenden Lösungen im halbfesten Zustand gehören rotierende Spiegeltypen, Winkeltypen und MEMS, die alle über solche verfügen Es enthält nur wenige mechanische Komponenten und wird in Fahrzeugumgebungen verwendet. Es hat eine kurze Lebensdauer und ist schwierig, die Fahrzeugzertifizierung zu bestehen. Die VCSEL+SPAD-Lösung für Solid-State-Lidar nutzt Chip-Level-Technologie, hat eine einfache Struktur und kann problemlos Fahrzeugvorschriften erfüllen. Sie ist derzeit die gängigste technische Lösung für reine Solid-State-Lidar. Der Lidar hinter dem iPhone12 Pro nutzt die VCSEL + SPAD-Lösung.

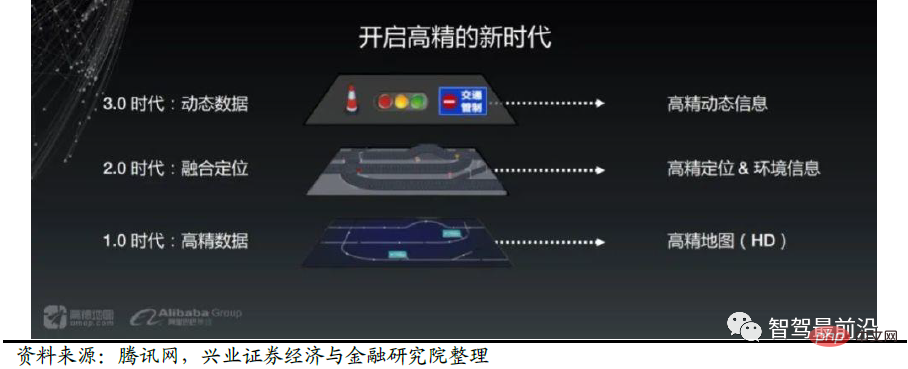

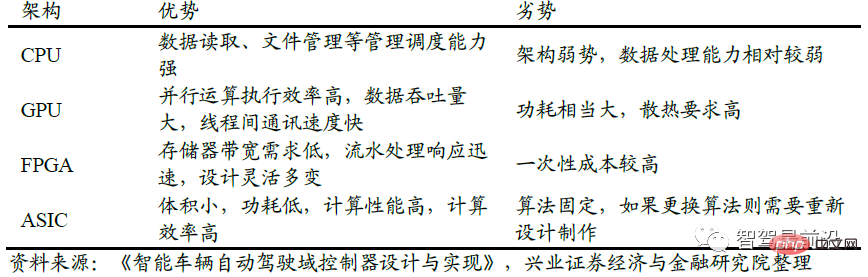

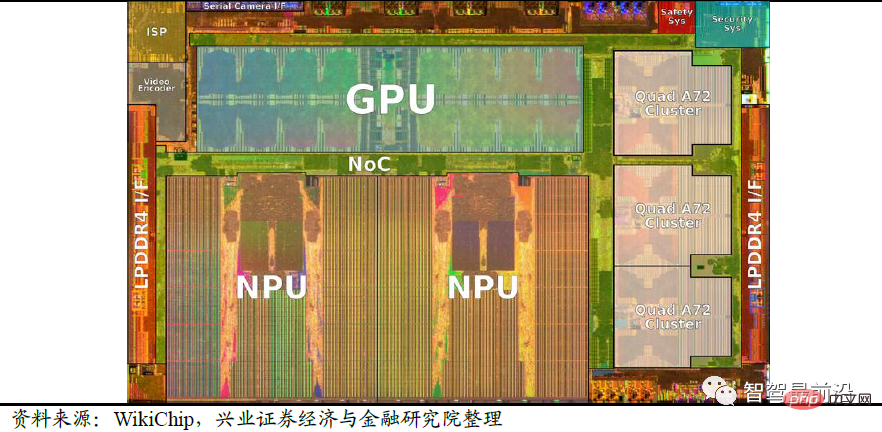

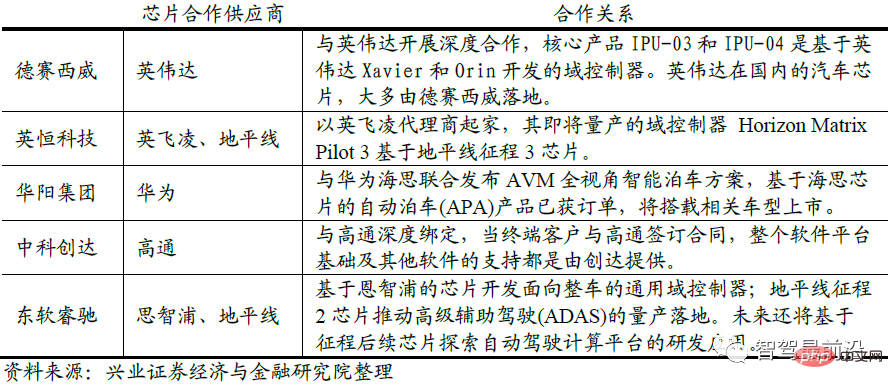

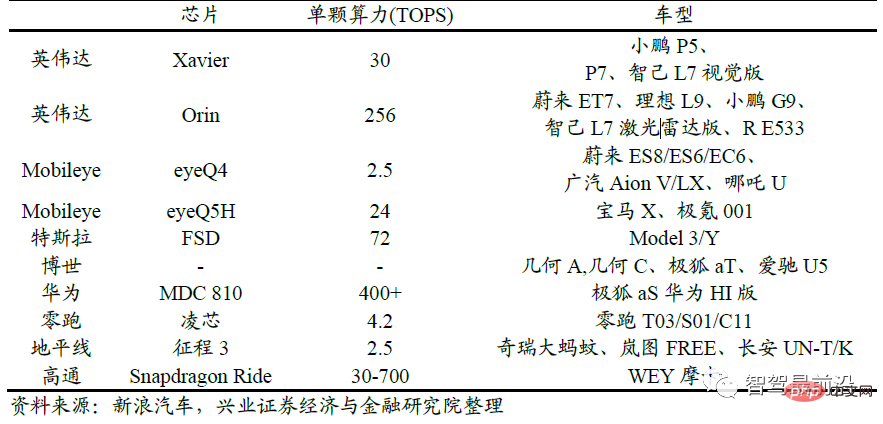

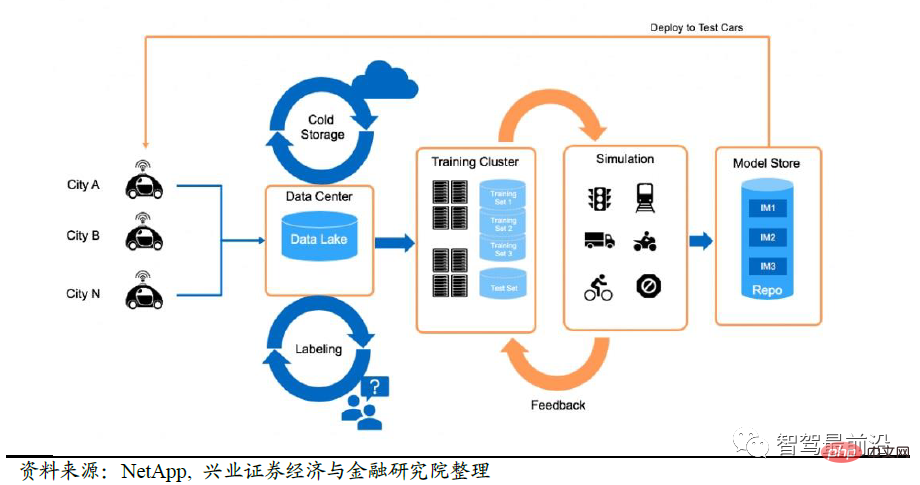

Die technische Route und repräsentative Unternehmen von Lidar # 🎜🎜# Es besteht die Möglichkeit, dass die hochauflösende Karte untergraben wird. Der Kampf um Routen geht im Bereich der fortschrittlichen Karten weiter. Tesla hat eine hochpräzise Karte vorgeschlagen, die keine vorherige Kartierung erfordert. Basierend auf den von Kameras gesammelten Daten wird die Technologie der künstlichen Intelligenz verwendet, um einen dreidimensionalen Raum der Umgebung zu erstellen Es übernimmt Crowdsourcing-Denken und besteht aus: Jedes Fahrzeug stellt Straßeninformationen bereit und wird in der Cloud vereinheitlicht und aggregiert. Daher müssen wir auf die durch technologische Innovationen verursachte Untergrabung hochpräziser Karten achten. Einige Praktiker glauben, dass hochpräzise Karten für intelligentes Fahren unverzichtbar sind, hochpräzise Karten sind nicht blockiert und haben keine Distanz und visuelle Mängel können hochpräzise Karten immer noch eine Rolle in Bezug auf Fehler spielen, hochpräzise Karten können einige Sensorfehler effektiv beseitigen und bestehende Sensorsysteme unter bestimmten Straßenbedingungen effektiv ergänzen und korrigieren. Darüber hinaus können hochpräzise Karten auch eine Fahrerlebnisdatenbank aufbauen, gefährliche Bereiche durch mehrdimensionales räumlich-zeitliches Data Mining analysieren und Fahrern neue Fahrerlebnisdatensätze zur Verfügung stellen. Lidar + Vision-Technologie, Sammelfahrzeug + Crowdsourcing-Modell sind die Mainstream-Lösungen für hochpräzise Karten in der Zukunft. HD-Karten müssen Genauigkeit und Geschwindigkeit in Einklang bringen. Eine zu geringe Erfassungsgenauigkeit und eine zu geringe Aktualisierungshäufigkeit können den Anforderungen des autonomen Fahrens an hochpräzise Karten nicht gerecht werden. Um dieses Problem zu lösen, haben hochpräzise Kartenunternehmen einige neue Methoden eingeführt, beispielsweise das Crowdsourcing-Modell. Jedes selbstfahrende Auto dient als hochpräzises Kartenerfassungsgerät, um hochpräzise dynamische Informationen bereitzustellen, die aggregiert und verarbeitet werden zur Nutzung an andere Autos verteilt. Mit diesem Modell können führende Unternehmen für hochpräzise Karten aufgrund der großen Anzahl von Automodellen, die am Crowdsourcing teilnehmen können, genauere und schnellere hochpräzise Karten sammeln und so eine Situation aufrechterhalten, in der die Starken immer stark sind. AMAP-Fusionslösung Die Computerplattform wird auch als autonome Fahrdomäne bezeichnet Regler. Mit zunehmender Durchdringungsrate des autonomen Fahrens über L3 steigen auch die Anforderungen an die Rechenleistung. Obwohl die aktuellen L3-Vorschriften und -Algorithmen noch nicht eingeführt wurden, haben Fahrzeughersteller Rechenleistungsredundanzlösungen eingeführt, um Platz für nachfolgende Software-Iterationen zu reservieren. Die Computerplattform wird in Zukunft zwei Entwicklungsmerkmale aufweisen: Heterogenität und verteilte Elastizität. Heterogen: Für autonome High-End-Fahrzeuge muss die Computerplattform mit mehreren Typen und Multidatensensoren kompatibel sein und über hohe Sicherheit und Leistung verfügen. Der vorhandene Einzelchip kann viele Schnittstellen- und Rechenleistungsanforderungen nicht erfüllen, und es ist eine heterogene Chip-Hardwarelösung erforderlich. Heterogenität kann sich in einer einzigen Platine widerspiegeln, die mehrere Architekturchips integriert, wie z. B. Audi zFAS integrierte MCU (Mikrocontroller), FPGA (Programmable Gate Array), CPU (Zentraleinheit) usw.; sie kann sich auch in einem leistungsstarken Einzelchip widerspiegeln (SoC, System-on-Chip) integriert mehrere Architektureinheiten gleichzeitig, z. B. die integrierte GPU (Grafikprozessor) von NVIDIA Xavier und zwei heterogene CPU-Einheiten. Verteilungsflexibilität: Die aktuelle Automobilelektronikarchitektur besteht aus vielen Einzelfunktionschips, die nach und nach in Domänencontroller integriert werden. Autonomes High-End-Fahren erfordert integrierte intelligente Computerplattformen mit Funktionen wie Systemredundanz und reibungsloser Erweiterung. Einerseits werden unter Berücksichtigung der heterogenen Architektur und Systemredundanz mehrere Karten verwendet, um eine Systementkopplung und -sicherung zu erreichen, andererseits wird eine verteilte Erweiterung mit mehreren Karten verwendet, um die Anforderungen an Rechenleistung und Schnittstellen im High-End-Bereich zu erfüllen autonomes Fahren. Unter der einheitlichen Verwaltung und Anpassung desselben autonomen Fahrbetriebssystems implementiert das Gesamtsystem gemeinsam autonome Fahrfunktionen und passt verschiedene Chips durch Änderung von Hardwaretreibern, Kommunikationsdiensten usw. an. Mit zunehmendem Niveau des autonomen Fahrens wird der Bedarf des Systems an Rechenleistung, Schnittstellen usw. von Tag zu Tag steigen. Neben der Erhöhung der Rechenleistung eines einzelnen Chips können Hardwarekomponenten auch mehrfach gestapelt werden, um eine flexible Anpassung und reibungslose Erweiterung von Hardwarekomponenten zu erreichen und so die Rechenleistung des gesamten Systems zu verbessern, Schnittstellen zu erhöhen und Funktionen zu verbessern. Die heterogene verteilte Hardwarearchitektur besteht hauptsächlich aus drei Teilen: KI-Einheit, Recheneinheit und Steuereinheit. KI-Einheit: Verwendet einen KI-Chip mit paralleler Computerarchitektur und verwendet eine Multi-Core-CPU, um den KI-Chip und die erforderlichen Prozessoren zu konfigurieren. Derzeit werden KI-Chips hauptsächlich für die effiziente Fusion und Verarbeitung von Multisensordaten verwendet und geben Schlüsselinformationen für die Ausführung auf der Ausführungsebene aus. Die KI-Einheit ist der anspruchsvollste Teil der heterogenen Architektur und muss die Engpässe in Bezug auf Kosten, Stromverbrauch und Leistung überwinden, um den Anforderungen der Industrialisierung gerecht zu werden. KI-Chips können zwischen GPU, FPGA, ASIC (anwendungsspezifischer integrierter Schaltkreis) usw. wählen. Vergleich verschiedener Chiptypen Rechnereinheit: Die Recheneinheit besteht aus mehreren CPUs. Es zeichnet sich durch eine hohe Single-Core-Frequenz und eine starke Rechenleistung aus und erfüllt die entsprechenden Anforderungen an die funktionale Sicherheit. Loading Hypervisor, das Kernel-Verwaltungssystem von Linux, verwaltet Softwareressourcen, führt die Aufgabenplanung durch und wird zur Ausführung der meisten Kernalgorithmen im Zusammenhang mit autonomem Fahren und zur Integration mehrdimensionaler Daten verwendet, um eine Pfadplanung und Entscheidungskontrolle zu erreichen. Steuereinheit: Basiert hauptsächlich auf einem herkömmlichen Fahrzeugcontroller (MCU). Das Steuergerät lädt die Basissoftware der ClassicAUTOSAR-Plattform, und die MCU ist über die Kommunikationsschnittstelle mit dem Steuergerät verbunden, um eine horizontale und longitudinale Steuerung der Fahrzeugdynamik zu erreichen und die Anforderungen der funktionalen Sicherheit auf ASIL-D-Ebene zu erfüllen. Nehmen Sie als Beispiel den Tesla FSD-Chip. Der FSD-Chip verwendet eine CPU+GPU+ASIC-Architektur. Enthält 3 Quad-Core-Cortex-A72-Cluster für insgesamt 12 CPUs mit 2,2 GHz; eine Mali G71 MP12 GPU mit 1 GHz, 2 Neural Processing Units (NPUs) und verschiedene andere Hardwarebeschleuniger. Es gibt eine klare Arbeitsteilung zwischen den drei Sensortypen. Die Cortex-A72-Kern-CPU wird für die allgemeine Rechenverarbeitung verwendet, die Mali-Kern-GPU wird für die leichte Nachbearbeitung verwendet und die NPU wird für neuronale Netzwerkberechnungen verwendet. Die GPU-Rechenleistung erreicht 600 GFLOPS und die NPU-Rechenleistung erreicht 73,73 Tops. Tesla FSD-Chiparchitektur Die Kerntechnologie des Domänencontrollers für autonomes Fahren ist der Chip, gefolgt von der Software und dem Betriebssystem Fähigkeiten. Der Chip bestimmt die Rechenleistung der autonomen Fahrcomputerplattform. Er ist schwierig zu entwerfen und herzustellen und kann leicht zu einem steckengebliebenen Glied werden. Der High-End-Markt wird von den internationalen Halbleitergiganten NVIDIA, Mobileye, Texas Instruments, NXP usw. dominiert. In den L2- und darunter liegenden Märkten gewinnen inländische Unternehmen, die von Horizon vertreten werden, allmählich an Anerkennung bei den Kunden. Chinesische Hersteller von Domänencontrollern arbeiten in der Regel eng mit einem Chiphersteller zusammen, um Chips zu kaufen und diese mit eigenen Hardware-Fertigungs- und Software-Integrationskapazitäten an den OEM zu liefern. Die Zusammenarbeit mit Chipfirmen ist grundsätzlich exklusiv. Aus Sicht der Chip-Kooperation hat Desay SV durch die Verbindung mit Nvidia und Thunderstar mit Qualcomm die offensichtlichsten Vorteile. Die Huayang Group, ein weiteres inländisches Unternehmen für Domänencontroller für autonomes Fahren, hat sich mit Huawei HiSilicon und Neusoft Reach zusammengetan, um Kooperationsbeziehungen mit NXP und Horizon aufzubauen. Die kooperative Beziehung zwischen inländischen Domänencontroller-Unternehmen und Chip-Unternehmen Reihe von Lösungen, die vom Unternehmen bereitgestellt werden. Beispielsweise kaufen die High-End-Modelle von Weilai, Ideal und Xpeng NVIDIA Orin-Chips und NVIDIA-Software für autonomes Fahren; BMW kauft Lösungen von der Chipfirma Mobileye und Great Wall kauft die L2-Lösung von Horizon; Wir sollten weiterhin auf die Zusammenarbeit zwischen Chip- und Domänencontroller-Unternehmen achten. Zusammenarbeit zwischen Chipherstellern und Automobilherstellern 3. Daten und Algorithmen helfen bei der Iteration von Algorithmen, und die Qualität von Algorithmen ist die zentrale Wettbewerbsfähigkeit von Unternehmen für autonomes Fahren. Für diese Art von Problemen gibt es nur eine Lösung: Automobilunternehmen müssen die Führung bei der Erfassung realer Daten übernehmen und gleichzeitig ähnlichere Umgebungen auf der Computerplattform für autonomes Fahren simulieren, damit das System dies kann Lerne beim nächsten Mal besser damit umzugehen. Ein typisches Beispiel ist der Schattenmodus von Tesla: Er identifiziert potenzielle Eckfälle durch den Vergleich mit dem menschlichen Fahrerverhalten. Diese Szenen werden dann mit Anmerkungen versehen und dem Trainingssatz hinzugefügt. Dementsprechend müssen Automobilhersteller einen Datenverarbeitungsprozess einrichten, damit die erfassten realen Daten für die Modelliteration verwendet werden können und das iterierte Modell in realen Serienfahrzeugen installiert werden kann. Damit die Maschine Eckfälle in großem Maßstab lernen kann, wird gleichzeitig nach Erhalt eines Eckfalls eine groß angelegte Simulation der in diesem Eckfall auftretenden Probleme durchgeführt und weitere Eckfälle für das Systemlernen abgeleitet. Nvidia DriveSim, eine von NVIDIA unter Verwendung der Metaverse-Technologie entwickelte Simulationsplattform, ist eines der Simulationssysteme. Datenführende Unternehmen bauen Datengräben. 1) Bestimmen Sie, ob das autonome Fahrzeug auf einen Eckfall stößt, und laden Sie ihn hoch 2) Kommentieren Sie die hochgeladenen Daten 3) Verwenden Sie Simulationssoftware, um zusätzliche Trainingsdaten zu simulieren und zu erstellen 4) Iterativ aktualisieren das neuronale Netzwerkmodell mit Daten 5) Stellen Sie das Modell über OTA in realen Fahrzeugen bereit Datenverarbeitungsprozess Hinter den Daten steckt eine enorme Rechenleistung Laut der Rede von NVIDIA auf der 2022CES benötigen Unternehmen, die in L2-Fahrassistenzsysteme investieren, nur 1-2.000 GPUs, während Unternehmen, die komplette L4-Fahrsysteme entwickeln, 25.000 GPUs für den Aufbau von Rechenzentren benötigen. 1. Tesla verfügt derzeit über 3 große Rechenzentren mit insgesamt 11.544 GPUs: Das automatische Markierungsrechenzentrum verfügt über 1.752 A100-GPUs und die anderen beiden für das Training genutzten Rechenzentren verfügen über 4.032 bzw. 5.760 A100-GPUs Das von AI DAY veröffentlichte, selbst entwickelte DOJO-Supercomputersystem verfügt über 3.000 D1-Chips und eine Rechenleistung von bis zu 1,1 EFLOPS. 2. Das von SenseTime im Bau befindliche Shanghai Supercomputing Center sieht vor, dass die maximale Rechenleistung 3,65 EFLPOS (BF16/CFP8) erreichen wird.

Computerplattform: Die Anforderungen an Chips steigen ständig und die Halbleitertechnologie ist ein Graben

Benutzerdaten sind für die Transformation autonomer Fahrsysteme äußerst wichtig. Beim autonomen Fahren gibt es ein seltenes Szenario, das wahrscheinlich nicht eintritt. Diese Art von Szenario wird als Eckfall bezeichnet. Wenn das Sensorsystem auf einen Eckfall stößt, führt dies zu ernsthaften Sicherheitsrisiken. Was in den letzten Jahren beispielsweise passierte, war, dass der Autopilot von Tesla einen großen weißen Lastwagen, der kreuzte, nicht erkannte und ihn von der Seite traf, was zum Tod des Besitzers führte. Im April 2022 stürzte Xiaopeng ab und überschlug sich beim Einschalten Autonomes Fahren. Fahrzeuge mitten auf der Straße.

Benutzerdaten sind für die Transformation autonomer Fahrsysteme äußerst wichtig. Beim autonomen Fahren gibt es ein seltenes Szenario, das wahrscheinlich nicht eintritt. Diese Art von Szenario wird als Eckfall bezeichnet. Wenn das Sensorsystem auf einen Eckfall stößt, führt dies zu ernsthaften Sicherheitsrisiken. Was in den letzten Jahren beispielsweise passierte, war, dass der Autopilot von Tesla einen großen weißen Lastwagen, der kreuzte, nicht erkannte und ihn von der Seite traf, was zum Tod des Besitzers führte. Im April 2022 stürzte Xiaopeng ab und überschlug sich beim Einschalten Autonomes Fahren. Fahrzeuge mitten auf der Straße.

Übliche Datenverarbeitungsvorgänge sind:

Das obige ist der detaillierte Inhalt vonEin Artikel über die drei Kernelemente des autonomen Fahrens. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr