Heim >Technologie-Peripheriegeräte >KI >Google ist der erste Anbieter von AIGC zur Videogenerierung, Internetnutzer: Sie können Filme anpassen

Google ist der erste Anbieter von AIGC zur Videogenerierung, Internetnutzer: Sie können Filme anpassen

- PHPznach vorne

- 2023-04-12 20:10:121628Durchsuche

Wir wissen, dass Fortschritte bei generativen Modellen und multimodalen visuellen Sprachmodellen den Weg für groß angelegte Text-zu-Bild-Modelle mit beispiellosem generativen Realismus und Vielfalt geebnet haben. Diese Modelle bieten neue kreative Prozesse, beschränken sich jedoch auf die Zusammenstellung neuer Bilder und nicht auf die Bearbeitung vorhandener Bilder. Um diese Lücke zu schließen, ermöglichen intuitive textbasierte Bearbeitungsmethoden die textbasierte Bearbeitung generierter und realer Bilder und bewahren einige der ursprünglichen Eigenschaften dieser Bilder. Ähnlich wie bei Bildern wurden kürzlich viele Text-zu-Video-Modelle vorgeschlagen, es gibt jedoch nur wenige Methoden, die diese Modelle für die Videobearbeitung verwenden.

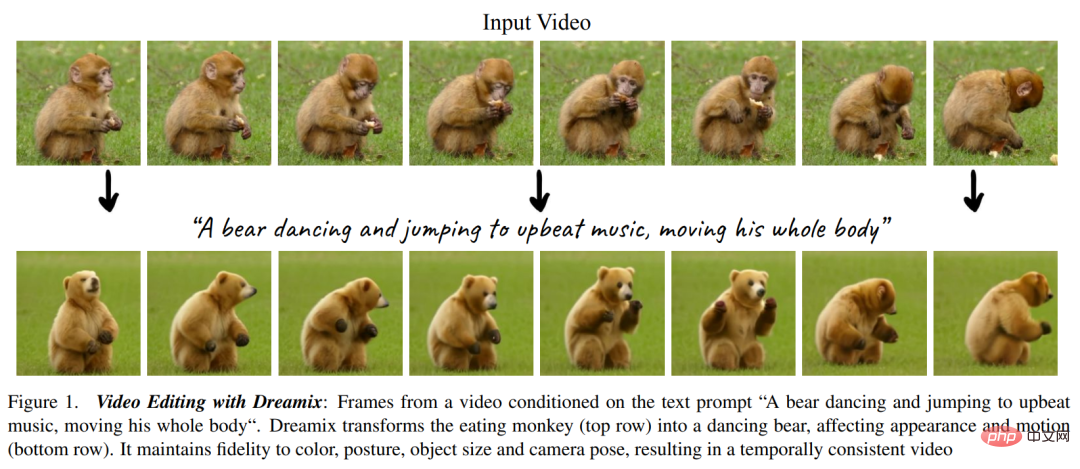

Bei der textgesteuerten Videobearbeitung stellt der Benutzer ein Eingabevideo zusammen mit einer Textaufforderung bereit, die die erwarteten Eigenschaften des generierten Videos beschreibt, wie in Abbildung 1 unten dargestellt. Die Ziele umfassen die folgenden drei Aspekte: 1) Ausrichtung: Das bearbeitete Video sollte der Eingabeaufforderung entsprechen. 2) Wiedergabetreue: Das bearbeitete Video sollte den Inhalt des Originalvideos beibehalten. 3) Qualität: Das bearbeitete Video sollte eine hohe Qualität aufweisen .

Wie Sie sehen, Videobearbeitung ist anspruchsvoller als Bildbearbeitung, es erfordert die Synthese neuer Aktionen, anstatt nur das visuelle Erscheinungsbild zu verändern. Auch die zeitliche Konsistenz muss gewahrt bleiben. Daher reicht die Anwendung von Bearbeitungsmethoden auf Bildebene wie SDEdit und Prompt-to-Prompt auf Videobilder nicht aus, um gute Ergebnisse zu erzielen.

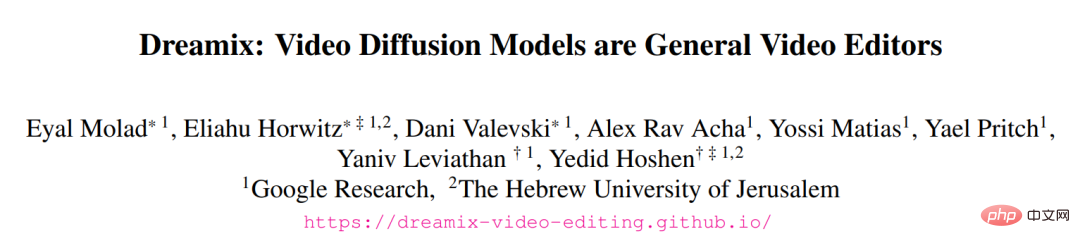

In einem kürzlich von Google Research und anderen auf arXiv veröffentlichten Artikel Forscher schlugen eine neue Methode Dreamix vor, die von UniTune inspiriert wurde, um textbedingte Videos zu verbreiten Modell (Videodiffusionsmodell, VDM) wird auf die Videobearbeitung angewendet. ?? io/

- Der Kern der Methode in diesem Artikel besteht darin, den textbedingten VDM durch die folgenden zwei Hauptideen dazu zu bringen, eine hohe Wiedergabetreue zum Eingabevideo beizubehalten

- . Zum einen wird kein reines Rauschen als Modellinitialisierung verwendet, sondern eine herabgestufte Version des Originalvideos, um durch Reduzierung der Größe und Hinzufügen von Rauschen nur geringe räumlich-zeitliche Informationen beizubehalten. Zum anderen soll die Wiedergabetreue des Originalvideos durch Feinabstimmung weiter verbessert werden Generatives Modell auf dem Originalvideo Spend. Durch die Feinabstimmung wird sichergestellt, dass das Modell die hochauflösenden Eigenschaften des Originalvideos versteht. Eine einfache Feinabstimmung des Eingabevideos trägt zu einer relativ geringen Bewegungsbearbeitbarkeit bei, da das Modell lernt, Rohbewegungen zu bevorzugen, anstatt Textaufforderungen zu folgen. Wir schlagen eine neuartige hybride Feinabstimmungsmethode vor, bei der der VDM auch auf eine Reihe einzelner Frames des Eingabevideos feinabgestimmt wird und deren Timing verwirft. Die Feinabstimmung der Mischung verbessert die Qualität der Bewegungsbearbeitung erheblich.

- Die Forscher nutzten ihr Videobearbeitungsmodell außerdem, um ein neues Bildanimations-Framework vorzuschlagen, wie in Abbildung 2 unten dargestellt. Das Framework besteht aus mehreren Schritten, wie zum Beispiel dem Animieren von Objekten und Hintergründen in Bildern, dem Erstellen dynamischer Kamerabewegungen und mehr. Sie tun dies durch einfache Bildverarbeitungsvorgänge wie das Kopieren von Bildern oder geometrische Bildtransformationen und erstellen so grobe Videos. Verwenden Sie dann den Dreamix-Videoeditor, um das Video zu bearbeiten. Darüber hinaus nutzten die Forscher auch ihre Feinabstimmungsmethode für die zielgerichtete Videogenerierung, die Videoversion von Dreambooth.

Im experimentellen Anzeigeteil führten die Forscher umfangreiche qualitative Untersuchungen und manuelle Bewertungen durch, um die leistungsstarken Fähigkeiten ihrer Methode zu demonstrieren. Einzelheiten finden Sie in der folgenden Animation.

Für Google In dieser Studie sagen einige, dass 3D+-Bewegungs- und Bearbeitungstools ein heißes Thema für die nächste Welle von Artikeln sein könnten.

Methodenübersicht

#🎜🎜 #Dieser Artikel schlägt eine vor Neue Methode zur Videobearbeitung, insbesondere:

Textgesteuerte Videobearbeitung durch Umkehren beschädigter Videos#🎜 🎜#  # 🎜🎜#

# 🎜🎜#

Beim Zerstören des Eingabevideos müssen Sie zunächst einen Downsampling-Vorgang durchführen, um das Grundmodell (16 Bilder 24 × 40) zu erhalten. , und fügen Sie dann Gaußsches Rauschen mit einer Varianz von

hinzu, um das Eingabevideo weiter zu zerstören. Für das oben verarbeitete Video besteht der nächste Vorgang darin, kaskadiertes VDM zu verwenden, um das beschädigte Video mit niedriger Auflösung so abzubilden, dass es mit dem Text mit hoher Auflösung übereinstimmt Video. Der Kerngedanke hierbei ist, dass es angesichts eines verrauschten Videos mit sehr geringer zeitlicher und räumlicher Auflösung viele durchaus realisierbare entsprechende Videos mit hoher Auflösung gibt. Das Grundmodell in diesem Artikel geht von einem beschädigten Video aus, das das gleiche Rauschen aufweist wie der Diffusionsprozess zum Zeitpunkt s. Die Studie verwendete dann VDM, um den Diffusionsprozess bis zum Zeitpunkt 0 umzukehren. Schließlich wird das Video durch das Super-Resolution-Modell aufgewertet.

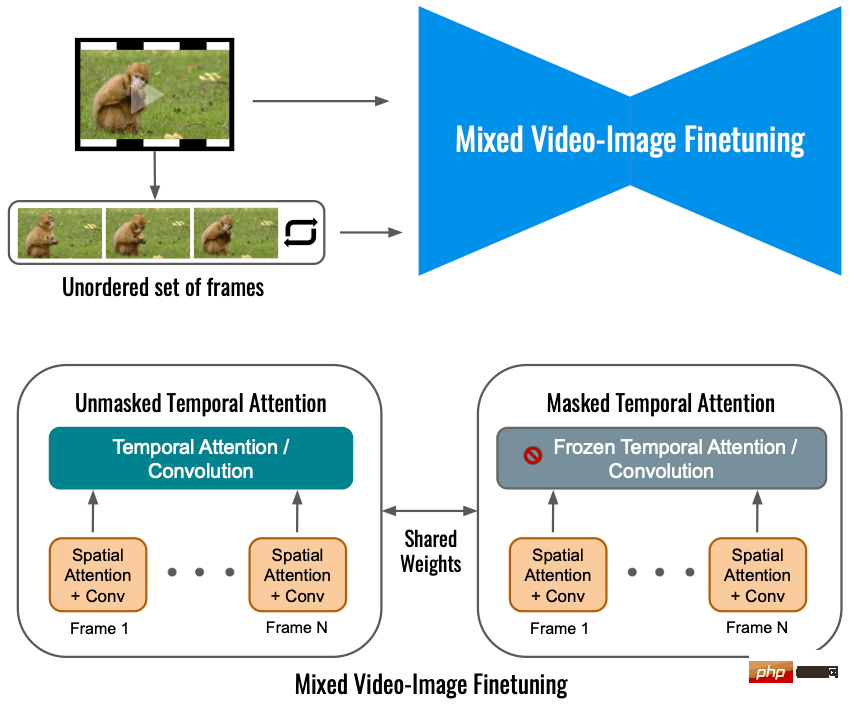

Feinabstimmung gemischter Videobilder

Nur Eingangsvideo verwenden Für das Video wird durch die Feinabstimmung des Diffusionsmodells die Änderung der Objektbewegung begrenzt. Stattdessen wird in dieser Studie ein Hybridziel verwendet, d. h. zusätzlich zum ursprünglichen Ziel (untere linke Ecke) wird in diesem Artikel auch ein ungeordneter Rahmen optimiert Dies wird durch „maskierte zeitliche Aufmerksamkeit“ erreicht, um eine Feinabstimmung der zeitlichen Aufmerksamkeit und Faltung zu verhindern (unten rechts). Dieser Vorgang ermöglicht das Hinzufügen von Bewegung zu statischen Videos.

Nur Eingangsvideo verwenden Für das Video wird durch die Feinabstimmung des Diffusionsmodells die Änderung der Objektbewegung begrenzt. Stattdessen wird in dieser Studie ein Hybridziel verwendet, d. h. zusätzlich zum ursprünglichen Ziel (untere linke Ecke) wird in diesem Artikel auch ein ungeordneter Rahmen optimiert Dies wird durch „maskierte zeitliche Aufmerksamkeit“ erreicht, um eine Feinabstimmung der zeitlichen Aufmerksamkeit und Faltung zu verhindern (unten rechts). Dieser Vorgang ermöglicht das Hinzufügen von Bewegung zu statischen Videos.

Begründung#🎜 🎜#

Basierend auf der Anwendungsvorverarbeitung (anwendungsabhängige Vorverarbeitung, links in der Abbildung unten) unterstützt diese Forschung mehrere Anwendungen und kann Eingabeinhalte in ein einheitliches Videoformat konvertieren. Bei der Bild-zu-Video-Umwandlung wird das Eingabebild kopiert und transformiert, wodurch ein grobes Video mit etwas Kamerabewegung synthetisiert wird. Für die objektgesteuerte Videogenerierung wird die Eingabe weggelassen und separat feinabgestimmt, um die Wiedergabetreue aufrechtzuerhalten. Dieses Rohvideo wurde dann mit dem Dreamix Video Editor (rechts) bearbeitet: Wie bereits erwähnt, wurde das Video zunächst durch Downsampling zerstört, wodurch Rauschen hinzugefügt wurde. Anschließend wird ein fein abgestimmtes textgesteuertes Videodiffusionsmodell angewendet, um das Video auf seine endgültige zeitliche und räumliche Auflösung hochzuskalieren.

Experimentelle Ergebnisse

Bild zu Video: Wenn der Eingabe ist ein Bild. Dreamix kann seine Videoprioritäten verwenden, um neue bewegliche Objekte hinzuzufügen, wie das Bild unten, in dem ein Einhorn in einem nebligen Wald erscheint und heranzoomt.

Pinguine erscheinen neben der Hütte:

Zielgerichtete Videogenerierung: Dreamix kann auch eine Sammlung von Bildern mit demselben Thema erstellen und daraus ein neues Video erstellen bewegliches Objekt mit diesem Thema. Das Bild unten zeigt eine Raupe, die sich auf einem Blatt windet:

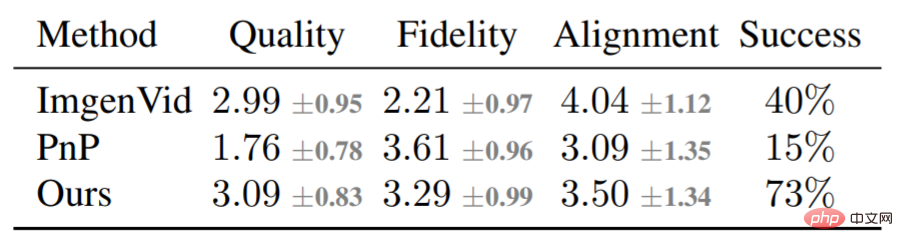

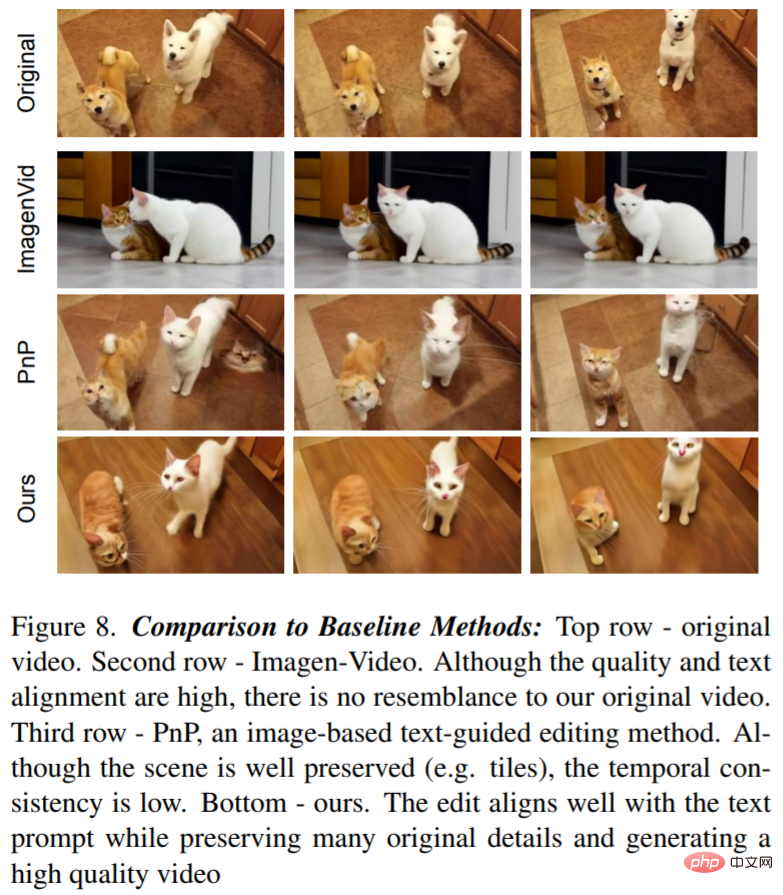

Zusätzlich zur qualitativen Analyse führte die Studie auch einen Basisvergleich durch, wobei hauptsächlich Dreamix mit Imagen-Video und Plug-and-Play (PnP) verglichen wurde Methode zum Vergleich. Die folgende Tabelle zeigt die Bewertungsergebnisse:

Abbildung 8 zeigt ein von Dreamix bearbeitetes Video und zwei Basisbeispiele: Das Text-zu-Video-Modell erreicht eine Bearbeitung mit niedriger Wiedergabetreue, da es nicht das Originalvideo verwendet als Bedingung. PnP behält die Szene bei, aber es mangelt an Konsistenz von Bild zu Bild; Dreamix schneidet bei allen drei Zielen gut ab.

Weitere technische Details finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonGoogle ist der erste Anbieter von AIGC zur Videogenerierung, Internetnutzer: Sie können Filme anpassen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr