Heim >Technologie-Peripheriegeräte >KI >Zusammenfassung der Open-Source-Datensatzressourcen für autonomes Fahren

Zusammenfassung der Open-Source-Datensatzressourcen für autonomes Fahren

- 王林nach vorne

- 2023-04-12 20:07:041804Durchsuche

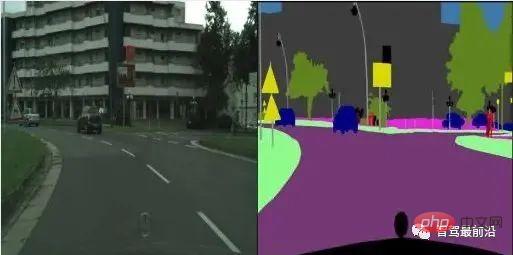

Datensatz für Stadtlandschaftsbildpaare

Download-Adresse des Datensatzes: http://m6z.cn/6qBe8e

Stadtlandschaftsdaten (Datensatz-Homepage) enthalten Tag-Video entnommen aus einem in Deutschland gefahrenen Fahrzeug. Bei dieser Version handelt es sich um eine verarbeitete Teilstichprobe, die im Rahmen des Pix2Pix-Artikels erstellt wurde. Der Datensatz enthält Standbilder aus den Originalvideos und semantische Segmentierungsbezeichnungen werden zusammen mit den Originalbildern angezeigt. Dies ist einer der besten Datensätze für semantische Segmentierungsaufgaben.

Semantischer Segmentierungsdatensatz für selbstfahrende Autos

Download-Adresse des Datensatzes: http://m6z.cn/5zYdv9 # 🎜🎜#

Dieser Datensatz bietet Bild- und beschriftete semantische Segmentierung von Daten, die mit dem autonomen Fahrzeugsimulator CARLA erfasst wurden. Mit diesem Datensatz können ML-Algorithmen trainiert werden, um semantische Segmentierungen von Autos, Straßen usw. in Bildern zu identifizieren.

UCBs groß angelegter Allwetter-Datensatz mit voller Beleuchtung, einschließlich 1.100 Stunden HD-Video, GPS/IMU, Zeitstempelinformationen, 2D-Begrenzungsrahmenanmerkung von 100.000 Bildern, semantischer Segmentierung und Beispielen für die Segmentierung von 10.000 Bildern Anmerkungen, Anmerkungen zu Fahrentscheidungen und Anmerkungen zum Straßenzustand. Zehn autonome Fahraufgaben, die offiziell zur Verwendung in diesem Datensatz empfohlen werden: Bildanmerkung, Straßenerkennung, Segmentierung befahrbarer Bereiche, Erkennung von Verkehrsteilnehmern, semantische Segmentierung, Instanzsegmentierung, Erkennung und Verfolgung mehrerer Objekte, Segmentierung und Verfolgung mehrerer Objekte, Domäne Anpassungs- und Nachahmungslernen.

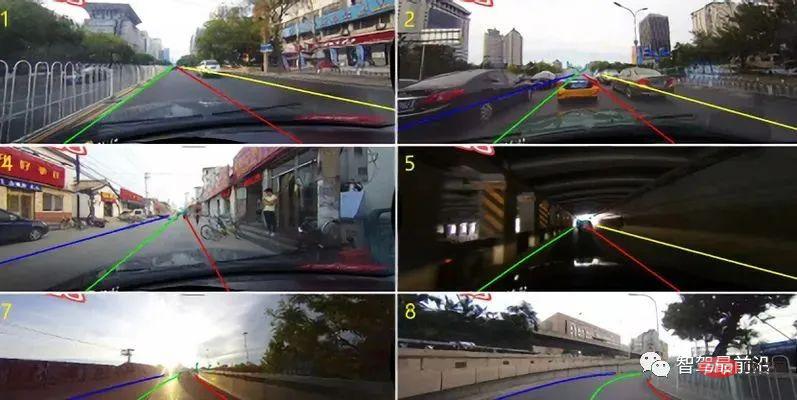

CULane-Datensatz

CULane-Datensatz

Download-Adresse des Datensatzes: http://m6z.cn/643fxb

# 🎜🎜 #CULane ist ein umfangreicher anspruchsvoller Datensatz, der für die akademische Forschung zur Fahrspurerkennung verwendet wird. Die Daten wurden von Kameras erfasst, die in sechs verschiedenen Fahrzeugen installiert waren, die von unterschiedlichen Fahrern in Peking gefahren wurden. Es wurden über 55 Stunden Videomaterial gesammelt und 133.235 Bilder extrahiert. In jedem Frame werden die Fahrspuren manuell mit kubischen Splines beschriftet. In Situationen, in denen Fahrspurmarkierungen durch Fahrzeuge verdeckt oder unsichtbar sind, wird die Fahrspurannotation weiterhin kontextbezogen durchgeführt. Der Fahrstreifen auf der anderen Seite der Schranke ist nicht beschriftet. In diesem Datensatz liegt der Schwerpunkt auf der Erkennung von Vierspurmarkierungen, die in der Praxis von größter Bedeutung sind. Andere Fahrbahnmarkierungen haben keine Anmerkungen.Afrikanischer Verkehrszeichendatensatz

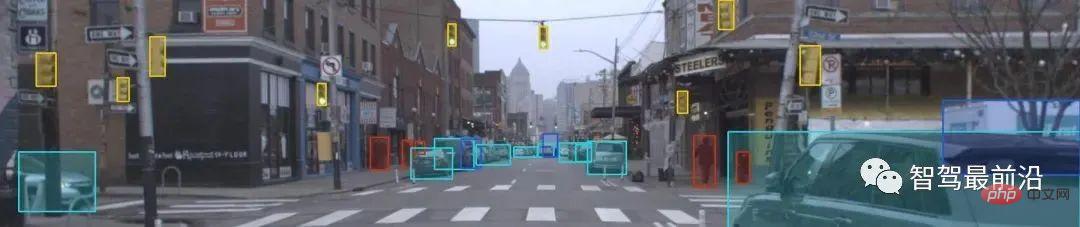

Argoverse-Datensatz

Download-Adresse des Datensatzes: http://m6z.cn/5P0b9B # 🎜🎜 #Argoverse zielt auf Aufgaben ab: 3D-Verfolgung und Bewegungsvorhersage. Die den beiden Aufgaben entsprechenden Datensätze sind tatsächlich unabhängig, aber die Erfassungsausrüstung und der Erfassungsort sind gleich. Es liefert 360-Grad-Videos und Punktwolkeninformationen und rekonstruiert die Karte basierend auf der Punktwolke, bei voller Beleuchtung den ganzen Tag über. 3D-Begrenzungsrahmen in Videos und Punktwolken werden mit Anmerkungen versehen. Der 3D-Tracking-Datensatz enthält 113 Videos von 15–30 Sekunden und die Aktionsvorhersage enthält 323.557 Videos von 5 Sekunden (insgesamt 320 Stunden). Das besondere Highlight des Datensatzes ist die Verknüpfung zwischen Originaldaten und Karten.

# 🎜🎜 #Argoverse zielt auf Aufgaben ab: 3D-Verfolgung und Bewegungsvorhersage. Die den beiden Aufgaben entsprechenden Datensätze sind tatsächlich unabhängig, aber die Erfassungsausrüstung und der Erfassungsort sind gleich. Es liefert 360-Grad-Videos und Punktwolkeninformationen und rekonstruiert die Karte basierend auf der Punktwolke, bei voller Beleuchtung den ganzen Tag über. 3D-Begrenzungsrahmen in Videos und Punktwolken werden mit Anmerkungen versehen. Der 3D-Tracking-Datensatz enthält 113 Videos von 15–30 Sekunden und die Aktionsvorhersage enthält 323.557 Videos von 5 Sekunden (insgesamt 320 Stunden). Das besondere Highlight des Datensatzes ist die Verknüpfung zwischen Originaldaten und Karten.

Dieser Datensatz besteht aus Bildern, die vom Carla-Fahrsimulator generiert wurden. Trainingsbilder sind Bilder, die von einer Dashcam aufgenommen wurden, die in einem simulierten Fahrzeug installiert ist. Etikettenbilder sind Segmentierungsmasken. Das Beschriftungsbild klassifiziert jedes Pixel als: linke Spurgrenze und rechte Spurgrenze. Die mit diesem Datensatz verbundene Herausforderung besteht darin, ein Modell zu trainieren, das die Segmentierungsmasken des Validierungsdatensatzes genau vorhersagen kann.

Datensatz „Autonom fahrende Fahrzeuge auf der Straße“

Download-Adresse des Datensatzes: http://m6z.cn/5ss0xe

Dieser Datensatz bietet benutzerfreundliche Trainingsdaten für autonome Fahrzeuge. Stellt den Lenkwinkel, die Beschleunigung, das Bremsen und die Gangposition für jedes Bild im Fahrvideo bereit. Das Video wurde mit einer Kamera aufgenommen, die an der Windschutzscheibe eines Autos montiert war, das eine Straße im indischen Bundesstaat Kerala entlangfuhr.

Caltech Pedestrian Dataset

Download-Adresse des Datensatzes: http://m6z.cn/5P0bdX

Der Caltech Pedestrian Dataset besteht aus etwa 10 Stunden 640x480 30Hz Video, das von einem Fahrzeug aufgenommen wurde, das durch normalen Verkehr fährt in einer städtischen Umgebung. Ungefähr 250.000 Frames (in 137 etwa einminütigen Segmenten) wurden mit Anmerkungen versehen, mit insgesamt 350.000 Begrenzungsrahmen und 2300 Fußgängern.

CamSeq 2007-Datensatz

Download-Adresse des Datensatzes: http://m6z.cn/5ss0Ho

CamSeq ist ein Bodendatensatz, der für Forschungsarbeiten zur Videozielerkennung frei verwendet werden kann. Der Datensatz enthält 101 Bildpaare mit 960 x 720 Pixeln. Jede Maske wird durch „_L“ außerhalb des Dateinamens angegeben. Alle Bilder (original und echt) liegen im unkomprimierten 24-Bit-Farb-PNG-Format vor.

Dieser Datensatz wurde ursprünglich für das Problem selbstfahrender Autos entwickelt. Diese Sequenz zeigt eine dynamische Fahrszene in der Stadt Cambridge, gefilmt aus einem dynamischen Auto. Dies ist ein anspruchsvoller Datensatz, da neben der Eigenbewegung des Autos auch andere Autos, Fahrräder und Fußgänger ihre eigene Bewegung haben und sich oft gegenseitig blockieren.

Echte Industrieszenen-Datensätze

Einige Medien haben eine große Anzahl realer Szenendatensätze aus Industrie und Industrie mit insgesamt 1473 GB hochwertigen internen Datensatzressourcen gesammelt. Die Datensätze stammen aus realen Geschäftsszenarien und werden von Industriepartnern und Medien gesammelt und bereitgestellt.

Im Rahmen des Ranking-Moduls können Entwickler kostenlos interne Datensätze für die Algorithmenentwicklung nutzen. Wir bieten außerdem jedem kostenlosen Support für die Rechenleistung und zugehörige technische Fragen und Antworten.

Sobald die Punktzahl des Algorithmusmodells den Standard erreicht, erhalten Entwickler mit dem höchsten Rang auch die Möglichkeit, mit der Plattform zusammenzuarbeiten, um weiterhin eine langfristige Umsatzbeteiligung aus den Bestellungen des Algorithmus zu erhalten!

Die Plattform hat die tatsächlichen Bedürfnisse von Smart Cities, Gewerbeimmobilien, hellen Küchen und anderen Branchen erfüllt, einschließlich, aber nicht beschränkt auf, Zielerkennung, Verhaltenserkennung, Bildsegmentierung, Videoverständnis, Zielverfolgung, OCR und andere visuelle Algorithmusrichtungen.

Das neueste Zielerkennungsprojekt: Mobiltelefonidentifikationsprojekt: http://m6z.cn/6qBdJS

Weitere Ranking-Projekte: http://m6z.cn/6xrthf

Das obige ist der detaillierte Inhalt vonZusammenfassung der Open-Source-Datensatzressourcen für autonomes Fahren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr