Heim >Technologie-Peripheriegeräte >KI >Warum nutzt die Robotikforschung im Vergleich zu generativen Modellen immer noch die gleichen alten Methoden von vor ein paar Jahren?

Warum nutzt die Robotikforschung im Vergleich zu generativen Modellen immer noch die gleichen alten Methoden von vor ein paar Jahren?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 19:04:22988Durchsuche

Auf dem Gebiet der Robotik wurden bemerkenswerte Fortschritte erzielt, und diese Fortschritte deuten darauf hin, dass Roboter in Zukunft noch mehr tun können. Aber es gibt auch besorgniserregende Dinge, denn im Vergleich zu generativen Modellen hinkt der Fortschritt von Robotern immer noch etwas hinterher, insbesondere mit dem Aufkommen von Modellen wie GPT-3 wird diese Lücke noch deutlicher.

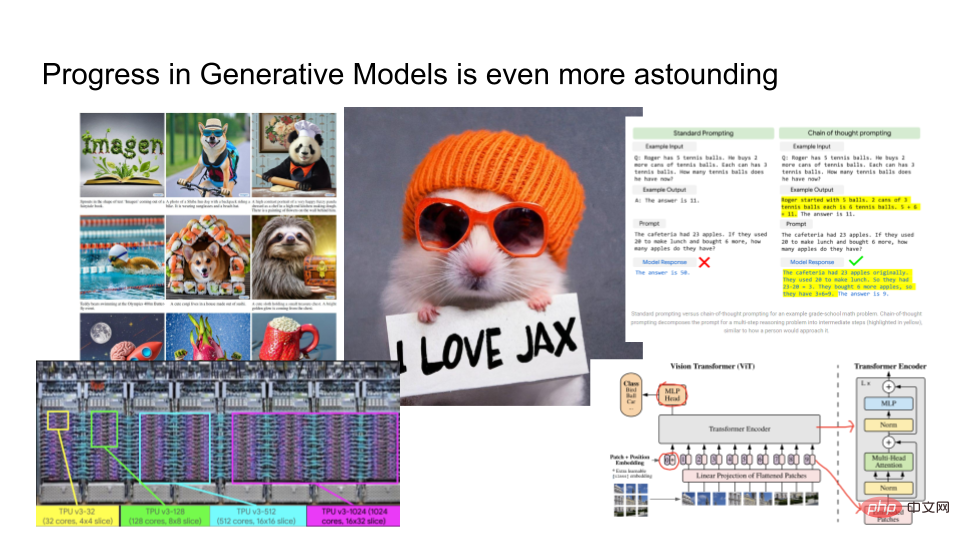

Die Ergebnisse des generativen Modells sind erschreckend gut. Die linke Seite des Bildes oben ist das Ausgabeergebnis von Imagen, das von Google gestartet wurde. Sie können ihm einen Text hinzufügen, z. B. „Ein Hamster trägt einen orangefarbenen Hut und hält ein Blatt Papier mit der Aufschrift „Ich liebe JAX“ in der Hand.“ Basierend auf dem angegebenen Text rendert Imagen ein angemessenes Bild. Darüber hinaus hat Google auch ein großes Sprachmodell PaLM trainiert, mit dem erklärt werden kann, warum Witze lustig sind und so weiter. Sie trainieren Modelle mit fortschrittlicher Hardware wie TPUv4 und im Bereich Computer Vision entwickeln Forscher einige sehr komplexe Architekturen wie Vision Transformers.

Generative Modelle entwickeln sich im Vergleich zur Robotik so schnell. Welche Verbindung besteht zwischen beiden?

In diesem Artikel stellt Eric Jang, Vizepräsident für KI des norwegischen Robotikunternehmens „Halodi Robotics“, vor: „Wie machen wir Roboter eher zu generativen Modellen?“ 》. Das Folgende ist der Hauptinhalt des Artikels.

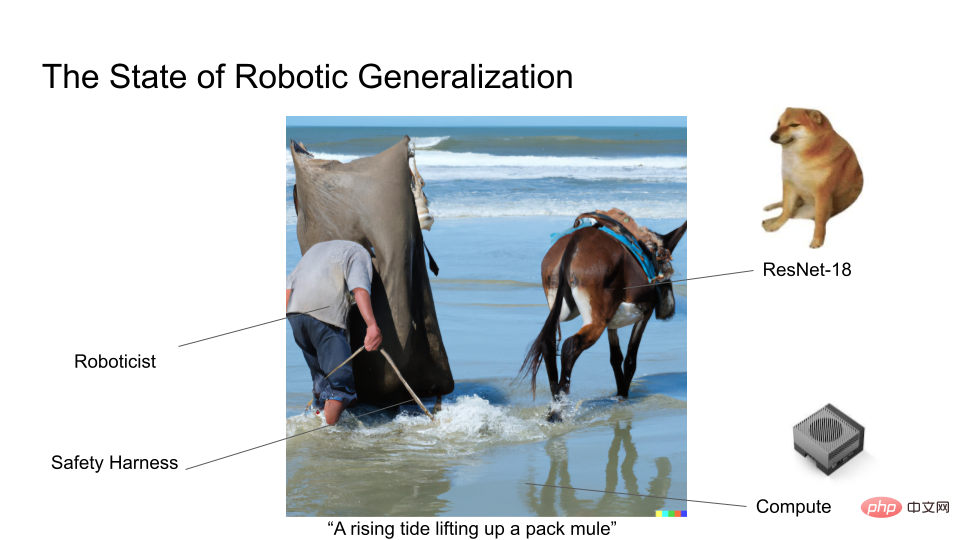

Als Experte auf dem Gebiet der Robotik sind die Fortschritte im Bereich der generativen Modelle etwas beneidenswert. Denn im Bereich der Robotik verwenden die meisten Forscher wahrscheinlich immer noch ResNet18, eine 7 Jahre alte Deep-Learning-Architektur. Wir trainieren sicherlich keine Modelle anhand riesiger Datensätze, wie dies bei generativen Modellen der Fall ist, sodass nur sehr wenige Forschungsanstrengungen im Bereich Robotik Schlagzeilen machen.

Wir kennen das Moravec-Paradoxon: Im Vergleich zu kognitiven Aufgaben ist es schwierig, Roboter intuitiv zu manipulieren und zu transportieren. Worte lassen sich offenbar nicht so eindrucksvoll erklären.

Zuerst definieren wir das generative Modell. Bei generativen Modellen geht es um mehr als nur das Rendern von Bildern oder das Generieren von Unmengen an Text. Es ist auch ein Framework, das wir verwenden können, um das gesamte probabilistische maschinelle Lernen zu verstehen. Bei generativen Modellen gibt es zwei Kernfragen:

1. Wie viele Bits gibt es in der Datenkategorie, die Sie modellieren möchten?

2. Wie gut kannst du das Modell bauen?

Im Jahr 2012 erzielte AlexNet einen Durchbruch. Es kann 1000 Kategorien vorhersagen, und Log2 (1000 Klassen) umfasst etwa 10 Klassenbits. Sie können sich AlexNet als ein bildbasiertes generatives Modell vorstellen, das 10 Informationsbits enthält. Wenn Sie den Schwierigkeitsgrad der Modellierungsaufgabe auf die MS-CoCo-Untertitelaufgabe erhöhen, enthält das Modell etwa 100 Informationsbits. Wenn Sie eine Bildgenerierung durchführen, beispielsweise von Text zu Bild mit DALLE oder Imagen, enthält diese etwa 1000 Bit an Informationen.

Je mehr Kategorien modelliert werden, desto mehr Rechenleistung ist erforderlich, um die darin enthaltenen bedingten Wahrscheinlichkeiten zu berechnen. Aus diesem Grund wird das Modell mit zunehmender Anzahl der Kategorien riesig. Wenn wir immer größere Modelle trainieren, wird es möglich, Merkmale in den Daten auszunutzen, um umfassendere Strukturen zu erlernen. Aus diesem Grund sind generative Modelle und selbstüberwachtes Lernen zu beliebten Methoden geworden, um Deep Learning mit großen Eingabemengen durchzuführen, ohne dass eine umfassende menschliche Kennzeichnung erforderlich ist.

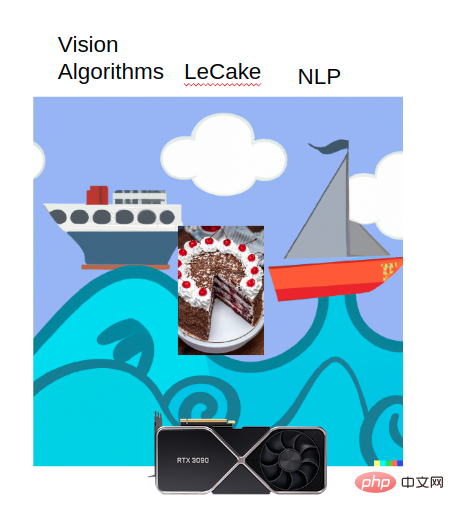

Rich Sutton wies in seinem Artikel „The Bitter Lesson“ darauf hin: Die meisten Fortschritte in der künstlichen Intelligenz scheinen in diesem Computerboom erzielt worden zu sein, während es in anderen Aspekten kaum Fortschritte gab. Der Vision-Algorithmus, NLP und Yann LeCuns LeCake profitieren alle von diesem Computerboom.

Welche Inspiration gibt uns dieser Trend? Wenn Sie über ein überparametrisiertes Modell verfügen, das mehr Daten verarbeiten kann, und das Modell alle Funktionen im Netzwerk erfassen kann, gepaart mit starker Rechenleistung und Trainingszielen, ist Deep Learning fast immer machbar.

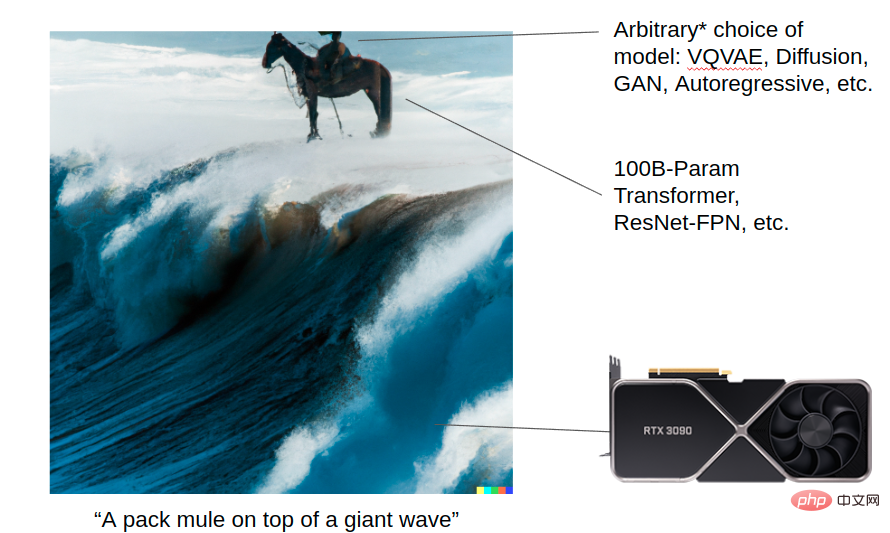

Lassen Sie DALL-E 2 ein Bild generieren: ein Maultier, das auf einer riesigen Welle reitet. Dieses Bild zeigt, wie generative Modelle mithilfe des Computerbooms außergewöhnliche Ergebnisse erzielen können. Sie verfügen über eine leistungsstarke Rechenleistung (Transformer, Resnet usw.) und können für die Modellierung zwischen VQVAE, Diffusion, GAN, Autoregressive und anderen Algorithmen wählen. Die Details jedes Algorithmus sind heute wichtig, aber in Zukunft werden sie möglicherweise keine Rolle mehr spielen, sobald Computer leistungsfähig genug sind. Aber auf lange Sicht sind Modellmaßstab und gute Architektur die Grundlage für all diese Fortschritte.

Die folgende Abbildung zeigt dagegen den aktuellen Stand der Generalisierungsforschung im Bereich der Robotik. Derzeit trainieren viele Robotikforscher noch kleine Modelle und haben Vision Transformer noch nicht verwendet!

Alle, die sich mit Roboterforschung befassen, hoffen alle, dass Roboter in der realen Welt häufiger eingesetzt werden und eine größere Rolle spielen können. Im Bereich generativer Modelle stehen Forscher vor relativ wenigen Problemen, während sie im Bereich der Robotikforschung häufig auf Probleme wie Schwierigkeiten beim Einsatz von Robotern und verrauschte Daten stoßen, mit denen Forscher, die an generativen Modellen arbeiten, nicht konfrontiert werden.

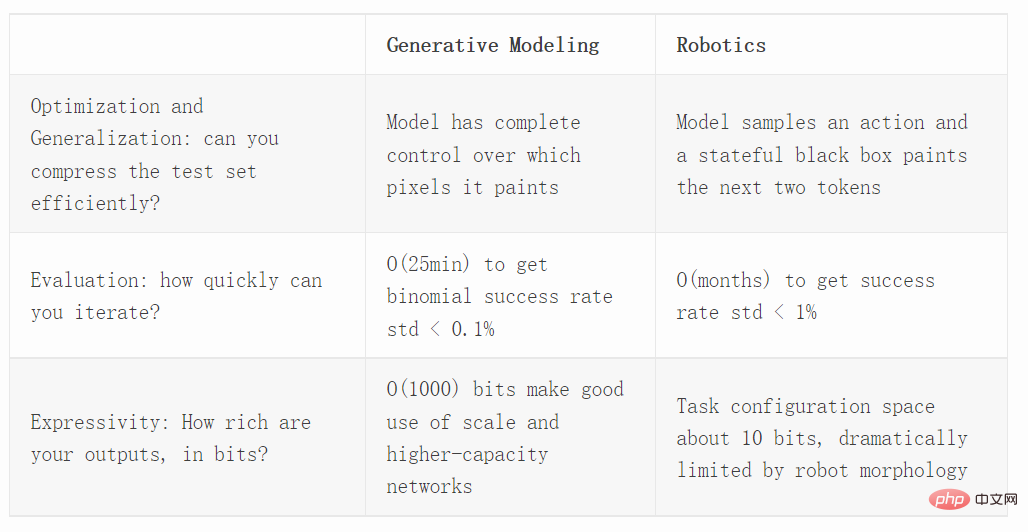

Als nächstes vergleichen wir generative Modelle und Robotik aus drei verschiedenen Dimensionen, einschließlich Optimierungs-, Bewertungs- und Ausdrucksfähigkeiten.

Optimierung

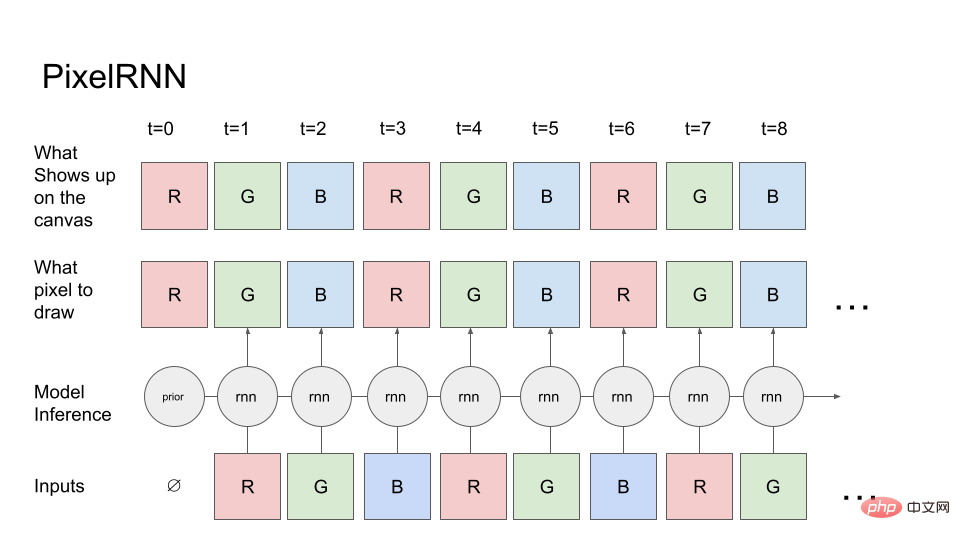

Schauen wir uns zunächst ein einfaches generatives Modell an: PixelRNN.

Ausgehend vom Rotkanal des ersten Pixels (die A-priori-Wahrscheinlichkeit des Rotkanals ist bekannt) teilt das Modell der Leinwand (obere Reihe) mit, welches Pixel es zeichnen möchte. Die Leinwand zeichnet genau nach Anweisung, kopiert also die Pixelwerte auf die Leinwand und liest die Leinwand dann wieder in das Modell ein, um den nächsten Kanal vorherzusagen, bei dem es sich um den grünen Kanal handelt. Dann werden die Werte auf der R- und G-Leinwand an das RNN zurückgemeldet und so weiter, um schließlich die RGBRGBRGB...-Sequenz zu generieren.

Bei tatsächlichen Bilderzeugungsaufgaben können Diffusion oder Transformator verwendet werden. Der Einfachheit halber verwenden wir jedoch nur vorwärtsausführende RNNs.

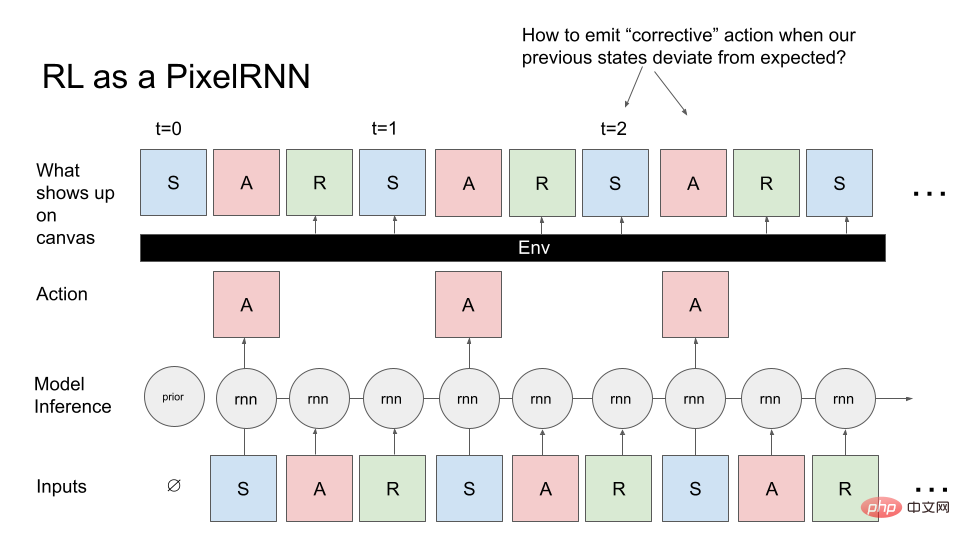

Lassen Sie uns nun das allgemeine Steuerungsproblem in PixelRNN umwandeln. Anstatt Bilder zu generieren, wollen wir MDPs (Markov Decision Processes) generieren: Sequenzen von Zuständen, Aktionen und Belohnungen. Wir möchten einen MDP generieren, der einem Agenten (z. B. einem Roboter) entspricht, der eine Aufgabe ausführt. Auch hier gehen wir von Vorwissen aus und das Modell tastet den Anfangszustand der Reinforcement Learning (RL)-Umgebung ab. Dies ist die erste Eingabe in das Modell, das RNN tastet das erste Pixel (A) ab und die Leinwand generiert A genau wie angewiesen. Im Gegensatz zum Generieren von Bildern gibt Canvas jedoch immer die vorherige RNN-Ausgabe zurück, und die aktuelle Operation besteht darin, dass die nächsten zwei Pixel (R, S) durch die aktuelle Umgebung bestimmt werden: Das heißt, es akzeptiert die Aktion und alle vorherigen Zustände und berechnet R. S irgendwie.

Wir können uns die RL-Umgebung als ein Malerobjekt vorstellen, das RNN-Aktionen ausführt, anstatt den gewünschten Inhalt direkt auf der Leinwand zu zeichnen, sondern beliebig komplexe Funktionen zum Zeichnen von Pixeln verwendet.

Wenn wir es mit dem PixelRNN vergleichen, das das Bild zuvor gezeichnet hat, ist diese Aufgabe offensichtlich anspruchsvoller, denn wenn Sie versuchen, das gewünschte Bild abzutasten, wird eine Blackbox angezeigt, und diese Blackbox wirkt sich auf das Bild aus Sie möchten zeichnen.

Ein typisches Problem, das während des Zeichenvorgangs auftritt: Wenn die Umgebung einen unerwarteten Zustand anzeigt, liegt ein Problem vor, nämlich wie Korrekturanweisungen ausgegeben werden, damit wir zu dem Bild zurückkehren können, das wir zeichnen möchten. Darüber hinaus müssen wir MDP-Bilder im Gegensatz zur Bildgenerierung tatsächlich sequentiell generieren und können nicht zur Bearbeitung zurückkehren, was ebenfalls Herausforderungen bei der Optimierung mit sich bringt.

Wenn wir verstehen wollen, wie RL-Methoden wie PPO verallgemeinert werden, sollten wir sie in einer nicht kontrollierten Umgebung vergleichen, sie auf Bilderzeugungstechniken anwenden und sie mit modernen generativen Modellen vergleichen. In der Arbeit von Hinton und Nair aus dem Jahr 2006 verwendeten sie das Federsystem, um die digitale MNIST-Synthese zu modellieren. DeepMind repliziert einen Teil dieser Bildsynthesearbeit mit RL-Methoden.

Die Bildgenerierung ist ein großartiger Maßstab für die Untersuchung von Optimierung und Steuerung, da sie die Notwendigkeit einer Verallgemeinerung über Tausende verschiedener Szenarien hinweg deutlich hervorhebt.

Neueste Projekte wie Decision Transformer, Trajectory Transformer und Multi-Game Decision Transformer haben gezeigt, dass die Upside-Down-RL-Technologie bei der Verallgemeinerung gute Arbeit leistet. Wie vergleichen sich Upside-Down-RL-Techniken mit Online- (PPO) oder Offline-RL-Algorithmen (CQL)? Es ist auch einfach auszuwerten, wir können die Dichte (Wahrscheinlichkeitsmodell der vollständigen Beobachtung des Experten) auswerten und überprüfen, ob sich ein ausgewählter RL-Algorithmus bei der Messung der Testwahrscheinlichkeit auf eine große Anzahl von Bildern verallgemeinern lässt.

Bewertung

Wenn wir die Erfolgsquote eines Roboters bei bestimmten Aufgaben abschätzen möchten, können wir die Binomialverteilung verwenden.

Die Varianz der Binomialverteilung beträgt p(1−p)/N, p ist der Stichprobenmittelwert (geschätzte Erfolgsquote); N ist die Anzahl der Versuche. Im schlimmsten Fall, wenn p = 50 % (maximale Varianz), sind 3000 Stichproben erforderlich, um die Standardabweichung auf weniger als 1 % zu bringen!

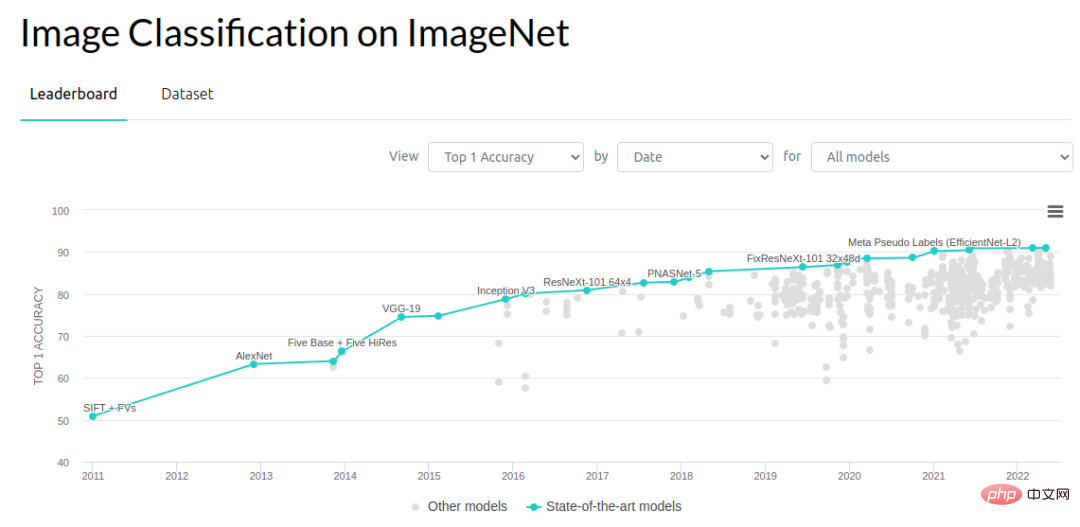

Wenn wir es aus der Perspektive des Computer Vision betrachten, sind Verbesserungen im Bereich von 0,1–1 % ein wichtiger Fortschrittstreiber. Das ImageNet-Objekterkennungsproblem hat seit 2012 große Fortschritte gemacht. Die Fehlerquote ist von 2012 bis 2014 um 3 % und dann um etwa 1 % pro Jahr gesunken. Es gibt viele Leute, die daran arbeiten, dies zum Laufen zu bringen. Vielleicht ist in diesem Jahr (2022) ein Engpass bei der Benchmark-Verbesserung erreicht, aber in den sieben Jahren von 2012 bis 2018 haben Forscher viele Fortschritte und Ergebnisse erzielt.

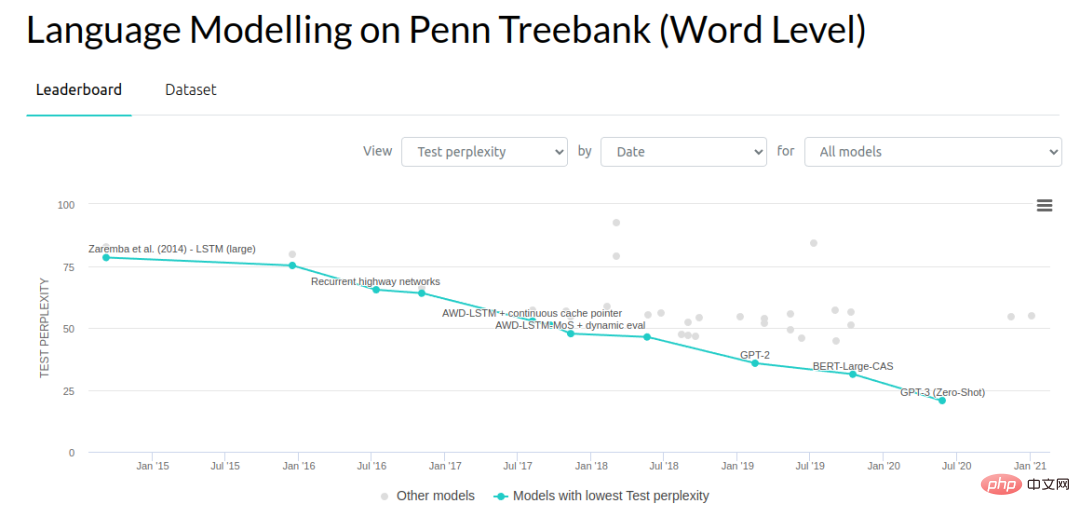

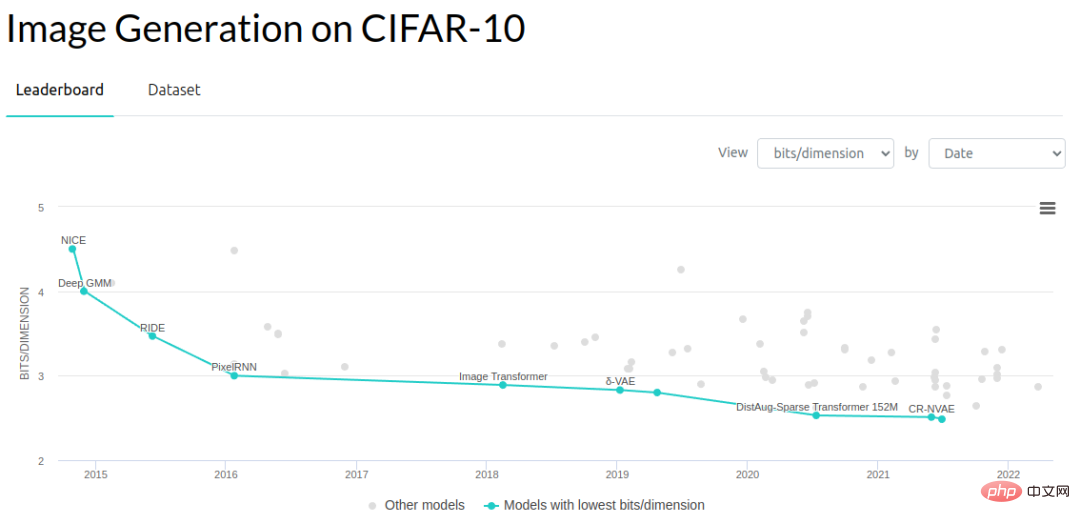

In anderen Bereichen der generativen Modellierung haben Forscher die Komplexität von Sprachmodellen und die Bits pro Dimension generativer Modelle auf Bildern reduziert.

Im Folgenden finden Sie einen groben Vergleich der Auswertegeschwindigkeit gängiger Benchmarks. Der ImageNet-Objekterkennungstestsatz 2012 umfasst 150.000 Bilder. Geht man von einer Inferenzgeschwindigkeit von 10 ms pro Bild aus und wertet jedes Bild nacheinander aus, würde die Auswertung jedes Testbeispiels etwa 25 Minuten dauern (tatsächlich ist die Auswertung viel schneller, da eine Stapelverarbeitung möglich ist). Hier gehen wir jedoch davon aus, dass nur ein einziger Roboter die Auswertung durchführt und die Bilder kontinuierlich verarbeitet werden müssen.

Da es sich um riesige Bilder handelt, können wir eine Standardfehlerschätzung innerhalb von 0,1 % erhalten. Eigentlich brauchen wir keinen Standardfehler von 0,1 %, um in diesem Bereich voranzukommen, vielleicht reicht 1 %.

Im Hinblick auf die Bewertung der Komplexität ist auch die End-to-End-Performance ein wichtiger Faktor. Werfen wir einen Blick darauf, wie eine End-to-End-Leistungsbewertung neuronaler Netze in simulierten Aufgaben durchgeführt wird. Habitat Sim ist einer der schnellsten verfügbaren Simulatoren und wurde entwickelt, um den Overhead zwischen neuronalen Netzwerkinferenzen und Umgebungsschritten zu minimieren. Der Simulator kann 10.000 Schritte pro Sekunde ausführen, aber da der Vorwärtsdurchlauf des neuronalen Netzwerks etwa 10 ms beträgt, führt dieser Engpass zu einer Auswertungszeit von 2 Sekunden pro Episode (unter der Annahme einer typischen Navigationsepisode mit 200 Schritten). Dies ist viel schneller als das Betreiben eines echten Roboters, aber viel langsamer als die Auswertung einer einzelnen Computer-Vision-Probe.

Wenn man ein End-to-End-Robotersystem mit einem Grad an Diversität evaluieren würde, der dem ähnelt, was wir mit ImageNet gemacht haben, würde eine typische Evaluierung eine Woche dauern, um Hunderttausende Evaluierungsszenarien zu verarbeiten. Dies ist kein ganz sinnvoller Vergleich, da jede Episode tatsächlich etwa 200 Inferenzdurchläufe hat, wir die Bilder innerhalb einer einzelnen Episode jedoch nicht als unabhängige Validierungssätze behandeln können. Ohne eine andere Episodenmetrik wissen wir nur, ob die Aufgabe erfolgreich war, sodass alle Rückschlüsse innerhalb der Episode nur zu einer einzigen Stichprobe der Binomialschätzung beitragen. Wir müssen die Erfolgsraten anhand von Zehntausenden Episoden und nicht anhand von Bildern schätzen. Natürlich könnten wir versuchen, andere Richtlinienbewertungsmethoden zu verwenden, aber diese Algorithmen sind nicht zuverlässig genug, um sofort zu funktionieren.

Im nächsten Schritt führen wir eine Vor-Ort-Bewertung des realen Roboters durch. In der realen Welt dauert die Auswertung jeder Episode etwa 30 Sekunden. Wenn also ein Team aus 10 Bedienern die Auswertung durchführt und jeder Bediener 300 Episoden pro Tag fertigstellen kann, können etwa 3000 Auswertungen pro Tag durchgeführt werden.

Wenn die Bewertung eines Modells einen ganzen Tag dauert, stellt dies eine große Grenze für die Produktivität dar, da Sie nur eine Idee pro Tag ausprobieren können. Daher können wir nicht mehr an kleinen Ideen arbeiten, die die Leistung schrittweise um 0,1 % verbessern, oder an sehr extremen Ideen. Wir mussten einen Weg finden, einen großen Leistungssprung zu machen. Das sieht zwar gut aus, ist aber in der Praxis schwierig umzusetzen.

Wenn Sie einen iterativen Prozess des Roboterlernens in Betracht ziehen, kann es leicht passieren, dass die Anzahl der Evaluierungsversuche Ihre Trainingsdaten bei weitem übersteigt! Die monatelange kontinuierliche Auswertung führte zu etwa Zehntausenden Episoden, was bereits mehr ist als die meisten Demonstrationsdatensätze für robotergestütztes Deep-Learning.

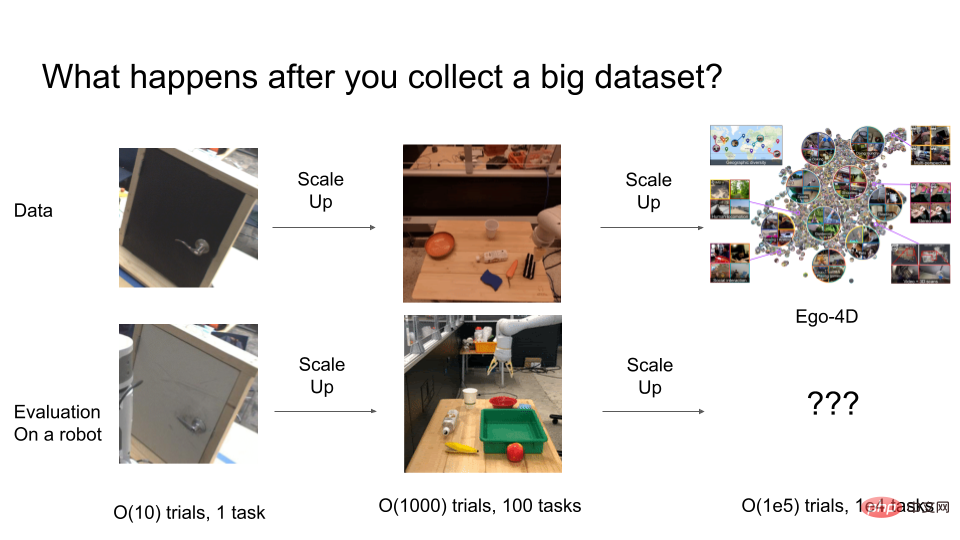

Vor ein paar Jahren lösten Forscher noch Probleme wie Roboterarme, um Türen zu öffnen, aber diese Strategien ließen sich nicht gut verallgemeinern. Normalerweise führen Forscher die Auswertungen in einer Abfolge von etwa 10 Episoden durch. Aber 10–50 Versuche reichen eigentlich nicht aus, um statistische Robustheit zu gewährleisten. Um gute Ergebnisse zu erzielen, können tatsächlich mehr als 1000 Versuche zur endgültigen Bewertung durchgeführt werden.

Aber was passiert, wenn die Testversion weiter ausgeweitet wird? Angenommen, wir müssen irgendwann ein extrem allgemeines Robotersystem mit O(100.000) Verhaltensweisen trainieren. Wie viele Versuche benötigen wir, um ein solches allgemeines System zu bewerten? Hier werden die Kosten für die Wertermittlung extrem hoch.

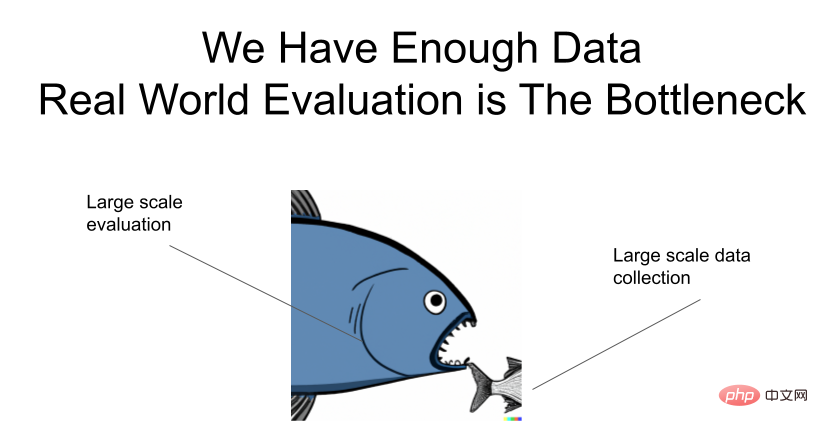

Ich betone es noch einmal: Die Datenlage ist ausreichend, aber es gibt einen Engpass bei der Auswertung!

Wie beschleunigt man die Auswertung?

Hier finden Sie einige Ideen, wie Sie die Bewertung universeller Robotersysteme beschleunigen können.

Eine Möglichkeit besteht darin, das Generalisierungsproblem und den Roboter getrennt zu untersuchen. Tatsächlich hat die Deep-Learning-Community dies bereits erreicht. Die meisten Forscher im Bereich Computer Vision und generative Modellierung testen ihre Ideen nicht direkt an echten Robotern, sondern gehen davon aus, dass ihre Modelle, sobald sie starke Generalisierungsfähigkeiten erreichen, schnell auf Roboter übertragen werden. ResNets, die im Bereich Computer Vision entwickelt wurden, vereinfachen viele Optionen zur visuellen Bewegungsmodellierung von Robotern erheblich. Stellen Sie sich vor, ein Forscher müsste seine Idee jedes Mal an einem echten Roboter testen, wenn er eine andere neuronale Netzwerkarchitektur ausprobieren möchte! Eine weitere Erfolgsgeschichte ist CLIPort, das die leistungsstarken multimodalen Generalisierungsfähigkeiten von Bild-Text-Modellen von der zugrunde liegenden geometrischen Argumentation für die Griffplanung entkoppelt.

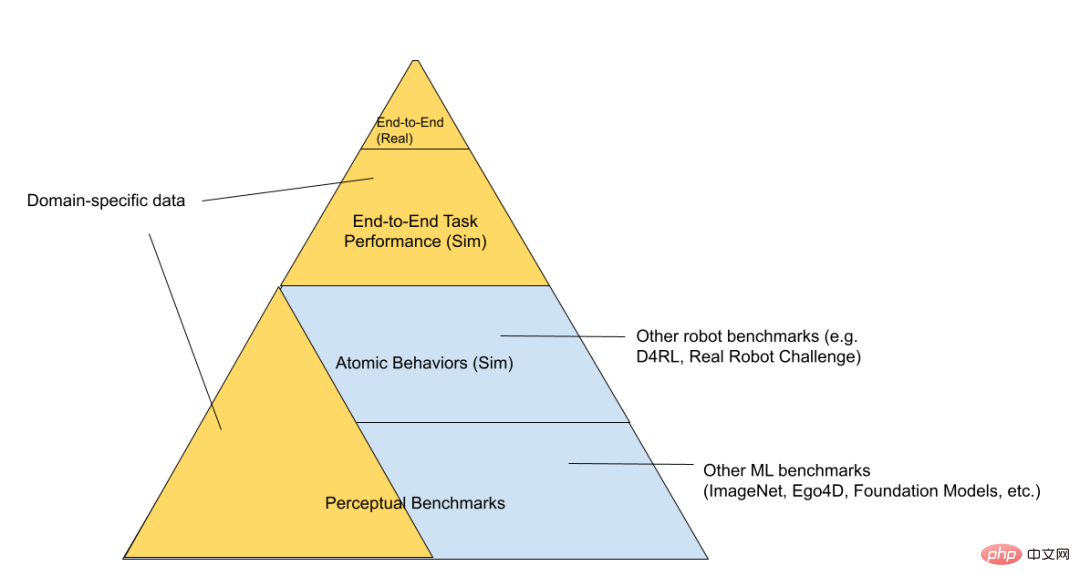

Wir können den RL-Technologiestapel weiter in drei Schichten unterteilen: „simulierte Spielzeugumgebung“, „simulierter Roboter“ und „echter Roboter“ (in der Reihenfolge der zunehmenden Bewertungsschwierigkeit geordnet).

Am unteren Ende der Pyramide gibt es allgemeine Benchmarks, wie zum Beispiel die Benchmarks von Kaggle-Wettbewerben. Im weiteren Verlauf gibt es eine Reihe von „Spielzeugkontrollproblemen“, die das Problem auf „Bare-Metal“-Art untersuchen. Es laufen nur der Simulator und das neuronale Netzwerk sowie der gesamte Code für reale Roboter, wie z. B. das Batteriemanagement , existiert nicht. Wenn Sie in der Pyramide weiter nach oben gehen, gelangen Sie zu spezifischeren Bereichen, die für das Problem, das Sie lösen möchten, relevanter sind. Beispielsweise können ein „simulierter Roboter“ und ein „echter Roboter“ für dieselbe Aufgabe verwendet werden und denselben zugrunde liegenden Robotercode wiederverwenden. Simulierte Spielzeugumgebungen können zur Untersuchung allgemeiner Algorithmen verwendet werden, haben jedoch weniger Überschneidungen mit dem Bereich der endgültigen Robotik. An der Spitze der „Bewertungspyramide“ stehen die realen Roboteraufgaben, die wir zu lösen versuchen. Die direkte Iteration dieses Prozesses ist sehr langsam, daher möchten wir alle hier so wenig Zeit wie möglich aufwenden. Wir hoffen, dass Basismodelle, die auf niedrigeren Ebenen trainiert und bewertet werden, dabei helfen zu verstehen, welche Ideen funktionieren, ohne dass jede Bewertung auf der obersten Ebene durchgeführt werden muss.

In ähnlicher Weise funktioniert das Feld bereits auf diese entkoppelte Weise. Die meisten Menschen, die daran interessiert sind, einen Beitrag zu Robotern zu leisten, werden nicht unbedingt Roboter bedienen. Sie können visuelle Darstellungen und Architekturen trainieren, die schließlich für Roboter nützlich sein könnten. Der Nachteil der Entkopplung besteht natürlich darin, dass Verbesserungen der Wahrnehmungsbasislinien nicht immer mit Verbesserungen der Roboterfähigkeiten einhergehen. Während beispielsweise die mAP-Metrik die semantische Segmentierung oder die Videoklassifizierungsgenauigkeit oder sogar verlustfreie Komprimierungs-Benchmarks verbessert (was theoretisch letztendlich dazu beitragen sollte), wissen wir nicht, wie sich Verbesserungen bei den Darstellungszielen tatsächlich auf Verbesserungen bei nachgelagerten Aufgaben auswirken. Letztendlich müssen Sie also das End-to-End-System testen, um zu verstehen, wo die tatsächlichen Engpässe liegen.

Google hat einmal einen coolen Artikel mit dem Titel „Challenging Common Assumptions in Unsupervised Learning of Disentangled Representations“ veröffentlicht, in dem sie gezeigt haben, dass viele völlig unüberwachte Repräsentationslernmethoden nicht zu nennenswerter Leistung führen Verbesserungen bei nachgelagerten Aufgaben, es sei denn, wir führen die Bewertung und Auswahl von Modellen anhand der endgültigen nachgelagerten Kriterien durch, die uns wichtig sind.

Papieradresse: https://arxiv.org/pdf/1811.12359.pdf

# 🎜🎜#Eine weitere Möglichkeit, die Kosten der Auswertung zu senken, besteht darin, sicherzustellen, dass der Datenerfassungs- und Auswertungsprozess konsistent ist. Wir können gleichzeitig Bewertungsdaten und Expertenbetriebsdaten erfassen. Durch bestimmte Eingriffe können wir HG-Dolch-Daten sammeln, sodass nützliche Trainingsdaten gesammelt werden können. Gleichzeitig kann uns die durchschnittliche Anzahl der Interventionen pro Episode grob sagen, ob die Strategie gut genug ist. Wir können auch Skalarmetriken anstelle von Binomialmetriken beobachten, da jede Episode dieser Metriken mehr Informationen liefert als ein einzelner Erfolg/Misserfolg.

Die Verwendung von RL-Algorithmen für die autonome Datenerfassung ist eine weitere Möglichkeit, Auswertung und Datenerfassung zu kombinieren. Diese Methode erfordert jedoch, dass wir Episoden manuell bewerten oder eine gut gestaltete Methode verwenden Belohnungsfunktion. Alle diese Ansätze erfordern den Einsatz einer großen Anzahl von Robotern in der realen Welt, die in der realen Welt immer noch in ständiger Iteration stecken bleiben.

Die Möglichkeit, den Bewertungsalgorithmus schneller zu machen, besteht darin, den Sim-to-Real-Migrationsalgorithmus zu verbessern. Wir können viele Roboter parallel simulieren, sodass es keine Einschränkungen gibt. Mohi Khansari, Daniel Ho, Yuqing Du und andere haben eine Technik namens „Task Consistency Loss“ entwickelt, die die Darstellung von sim und real in Invarianten reguliert, sodass die Strategie in sim Das Verhalten sollte dem realen ähnlich sein. Wenn wir in der Simulation evaluierte Strategien auf reale übertragen, möchten wir sicherstellen, dass höhere Leistungsmetriken in der Simulation auch tatsächlich höheren Leistungsmetriken in der Realität entsprechen. Je kleiner die sim2real-Lücke ist, desto vertrauenswürdiger sind die Indikatoren im Simulationsexperiment. Mal sehen, wie viele Bits ein modernes generatives Modell ausgeben kann. Ein 64x64x3 RGB-Bild mit 8 Bit pro Kanal ist 36864 Bit. Das Sprachmodell kann eine beliebige Anzahl von Token generieren, aber wenn wir das Ausgabefenster auf 2048 Token festlegen, hat jedes Token 17 Bits, also insgesamt 36793 Bits. Daher können sowohl Bild- als auch Textgenerierungsmodelle etwa 37 KBit synthetisieren. Je ausdrucksstärker die Modelle werden, desto höher wird auch die Wahrnehmung dieser Modelle durch die Menschen sein. Manche denken sogar, dass Sprachmodelle teilweise bewusst sind, weil sie so ausdrucksstark sind!

Wie ausdrucksstark sind aktuelle Roboter im Vergleich dazu? Hier entwerfen wir eine vereinfachte reale Umgebung. Auf dem Tisch liegen 6 Gegenstände. Die Aufgabe des Roboters besteht darin, einen Gegenstand auf einen anderen Gegenstand zu verschieben oder bestimmte Gegenstände zu transportieren. log2(100) beträgt etwa 7 Bits, was bedeutet: „Angesichts des Zustands der Welt kann der Roboter Atome in einen von N Zuständen bewegen, wobei N mit 7 Bits beschrieben werden kann.“ Der SayCan-Algorithmus von Google kann etwa 550 Operationen mit einem neuronalen Netzwerk durchführen, was im Vergleich zu aktuellen Standards des Deep Learning für die Robotik ziemlich beeindruckend ist, und zwar in insgesamt nur etwa 10 Bits.

Dieser Vergleich ist nicht völlig sinnvoll, da die Definition von Informationen zwischen beiden unterschiedlich ist. Er wird hier nur bereitgestellt, um eine grobe Vorstellung davon zu vermitteln, wann man die relative Komplexität einer Reihe von Aufgaben mit einer anderen vergleichen muss heraus, was wichtig ist.

Eine der Herausforderungen, denen wir begegnet sind, besteht darin, dass die Funktionalität des Roboters immer noch eingeschränkt ist. Wenn Sie sich den Ego4D-Datensatz ansehen, erfordern viele Aufgaben zwei Hände, aber die meisten Roboter verwenden heutzutage immer noch einen einarmigen mobilen Manipulator mit Radbasis. Sie können sich nicht bewegen oder irgendwohin gehen, und natürlich haben wir nur einen „Roboterarm“, was viele interessante Aufgaben ausschließt.

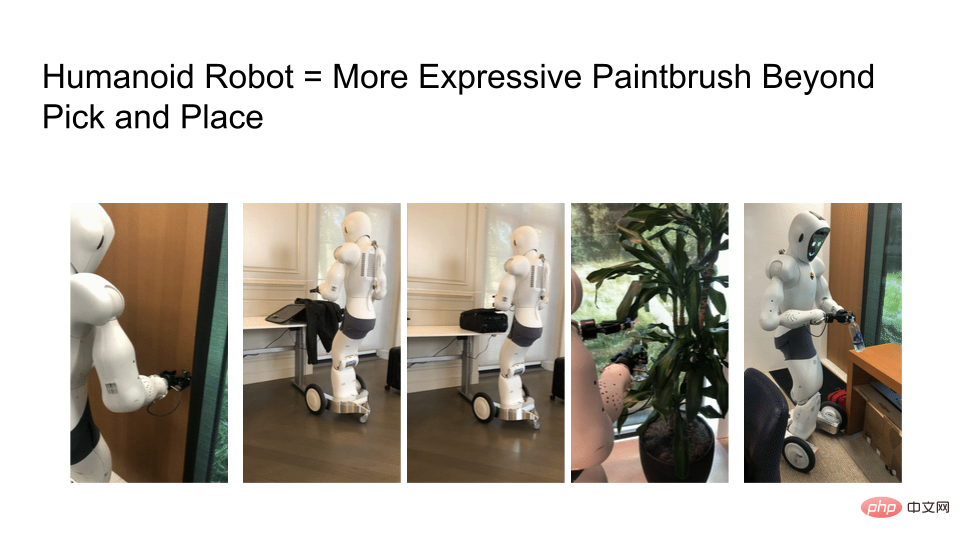

Wir müssen ausdrucksstärkere Roboter untersuchen, aber die Ausdruckskraft von Roboterlernalgorithmen ist durch die Hardware begrenzt. Unten sehen Sie ein Bild des Roboters, der Türen öffnet, Koffer packt, Reißverschlüsse schließt, Pflanzen gießt und Wasserflaschenverschlüsse umdreht. Je näher Roboterhardware an reale Menschen heranrückt, desto mehr Dinge können Sie in einer menschenzentrierten Welt tun.

Da Roboter immer ausdrucksvoller werden, benötigen wir nicht nur Trainingsdaten im Internetmaßstab, sondern auch Bewertungsprozesse im Internetmaßstab. Wenn man sich den Fortschritt großer Sprachmodelle (LLMs) anschaut, gibt es mittlerweile viele Artikel, die sich mit der Optimierung befassen und was bestehende Modelle leisten können und was nicht.

Zum Beispiel stellt der Benchmark von BigBench eine Reihe von Aufgaben zusammen und fragt, was wir aus diesen Modellen gewinnen können. OpenAI ermöglicht Internetnutzern die Evaluierung ihrer DALLE-2- und GPT-3-Modelle. Ihre Entwicklungs- und Produktteams können aus benutzerbezogenen KI-Experimenten lernen, da die Details der LLM-Modelle für einen einzelnen Forscher schwer zu beherrschen sind.

Abschließend noch eine Frage an die Leser: Welche Technologie entspricht der GPT-3- oder DALLE-2-API im Bereich der Robotik? Können Forscher in der Internet-Community mithilfe dieser gleichwertigen Technologie die Roboterforschung in Frage stellen und verstehen, was sie tatsächlich leisten kann?

Zum Abschluss fassen Sie den Vergleich zwischen Optimierung, Bewertung und Ausdruckskraft in einer Tabelle zusammen:

Das obige ist der detaillierte Inhalt vonWarum nutzt die Robotikforschung im Vergleich zu generativen Modellen immer noch die gleichen alten Methoden von vor ein paar Jahren?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr