Heim >Technologie-Peripheriegeräte >KI >Yann LeCun spricht über Google Research: Zielgerichtete Kommunikation gibt es schon lange, wo ist Ihre Innovation?

Yann LeCun spricht über Google Research: Zielgerichtete Kommunikation gibt es schon lange, wo ist Ihre Innovation?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 18:52:131530Durchsuche

Vor ein paar Tagen stellte der akademische Turing-Award-Gewinner Yann LeCun eine Google-Studie in Frage.

Vor einiger Zeit schlug Google AI in seiner neuen Forschung „LocoProp: Enhancing BackProp via Local Loss Optimization“ ein allgemeines hierarchisches Verlustkonstruktions-Framework LocoProp für mehrschichtige neuronale Netze vor, das nur Optimierer erster Ordnung verwendet und gleichzeitig Leistung erzielt nahe an dem von Methoden zweiter Ordnung.

Genauer gesagt stellt sich das Framework ein neuronales Netzwerk als eine modulare Zusammensetzung aus mehreren Schichten vor, wobei jede Schicht ihre eigene Gewichtsregulierungs-, Zielausgabe- und Verlustfunktion verwendet, wodurch letztendlich sowohl Leistung als auch Effizienz erreicht werden.

Google hat die Wirksamkeit seiner Methode experimentell anhand von Benchmark-Modellen und Datensätzen überprüft und so die Lücke zwischen Optimierern erster und zweiter Ordnung verringert. Darüber hinaus gaben Google-Forscher an, dass ihre Methode zur Konstruktion lokaler Verluste das erste Mal ist, dass quadratische Verluste als lokale Verluste verwendet werden.

Bildquelle: @Google AI

Zu dieser Recherche von Google haben einige Leute kommentiert, dass sie großartig und interessant ist. Einige Leute äußerten jedoch unterschiedliche Ansichten, darunter der Turing-Preisträger Yann LeCun.

Er glaubt, dass es viele Versionen dessen gibt, was wir heute als Zielobjekte bezeichnen, einige davon stammen aus dem Jahr 1986. Was ist also der Unterschied zwischen Googles LocoProp und ihnen?

Bildquelle: @Yann LeCun

In Bezug auf LeCuns Frage stimmte Haohan Wang, der im Begriff ist, Assistenzprofessor an der UIUC zu werden, zu. Er sagte, es sei manchmal überraschend, warum einige Autoren dachten, eine so einfache Idee sei die erste ihrer Art. Vielleicht haben sie etwas anderes gemacht, aber das Werbeteam konnte es kaum erwarten, herauszukommen und alles zu behaupten ...

Fotoquelle: @HaohanWang

Einige Leute sind jedoch „nicht kalt“ gegenüber LeCun und denken, dass er Aus Wettbewerbsüberlegungen werfe man Fragen auf und provoziere sogar „Krieg“. LeCun antwortete und behauptete, dass seine Frage nichts mit Konkurrenz zu tun habe, und nannte als Beispiel ehemalige Mitglieder seines Labors wie Marc'Aurelio Ranzato, Karol Gregor, Koray Kavukcuoglu usw., die alle einige Versionen der Zielausbreitung verwendet hätten. und jetzt arbeiten sie alle bei Google DeepMind. Fotoquelle: @Gabriel Jimenez @Yann LeCun Werfen wir zunächst einen Blick darauf, worum es in dieser Google-Studie geht. Gibt es eine herausragende Innovation?

Google LocoProp: Verbesserte Backpropagation mit lokaler Verlustoptimierung

Papieradresse: https://proceedings.mlr.press/v151/amid22a/amid22a.pdf

Es gibt auch fortgeschrittenere Optimierungsmethoden wie Shampoo, K-FAC usw., die nachweislich die Konvergenz verbessern und die Anzahl der Iterationen reduzieren. Diese Methoden können Änderungen in Gradienten erfassen. Mithilfe dieser zusätzlichen Informationen können Optimierer höherer Ordnung effizientere Aktualisierungsrichtungen für das trainierte Modell ermitteln, indem sie Korrelationen zwischen verschiedenen Parametergruppen berücksichtigen. Der Nachteil besteht darin, dass die Berechnung von Aktualisierungsrichtungen höherer Ordnung rechenintensiver ist als Aktualisierungen erster Ordnung.

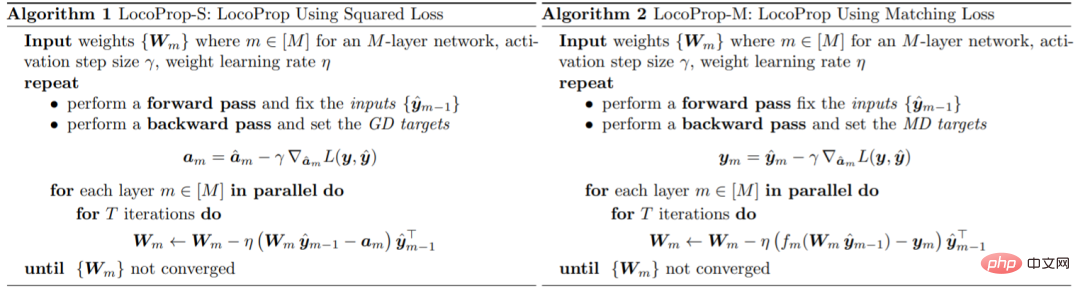

Google stellte in dem Artikel ein Framework zum Training von DNN-Modellen vor: LocoProp, das neuronale Netze als modulare Kombinationen von Schichten betrachtet. Im Allgemeinen führt jede Schicht eines neuronalen Netzwerks eine lineare Transformation der Eingabe durch, gefolgt von einer nichtlinearen Aktivierungsfunktion. In dieser Studie wurde jeder Schicht des Netzwerks ein eigener Gewichtsregulator, ein eigenes Ausgabeziel und eine eigene Verlustfunktion zugewiesen. Die Verlustfunktion jeder Schicht ist so konzipiert, dass sie mit der Aktivierungsfunktion dieser Schicht übereinstimmt. Mit dieser Form kann das Training einer bestimmten kleinen Menge lokaler Verluste minimiert werden, indem parallel zwischen Schichten iteriert wird.

Google verwendet diesen Optimierer erster Ordnung für Parameteraktualisierungen und vermeidet so den Rechenaufwand, der für Optimierer höherer Ordnung erforderlich ist.

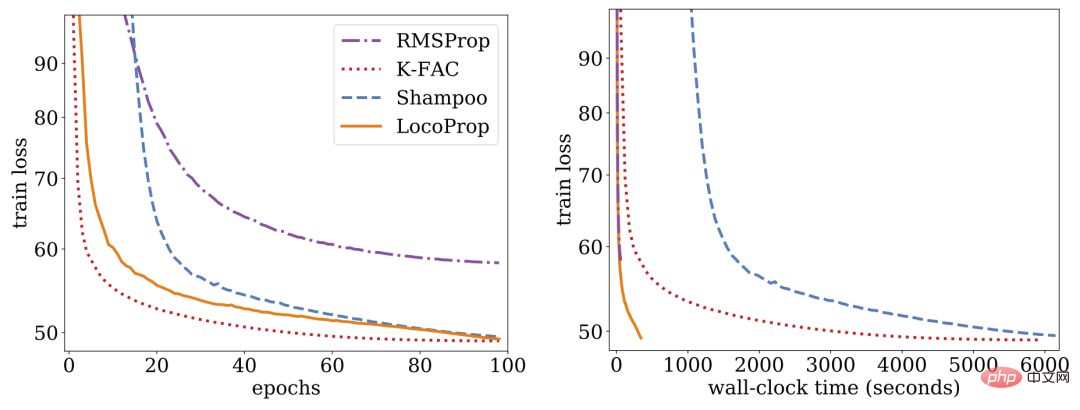

Untersuchungen zeigen, dass LocoProp Methoden erster Ordnung bei Deep-Autoencoder-Benchmarks übertrifft und eine vergleichbare Leistung wie Optimierer höherer Ordnung wie Shampoo und K-FAC ohne hohen Speicher- und Rechenaufwand erbringt.

LocoProp: Verbesserte Backpropagation mit lokaler Verlustoptimierung

Typischerweise werden neuronale Netze als zusammengesetzte Funktionen betrachtet, die die Eingabe jeder Schicht in eine Ausgabedarstellung umwandeln. LocoProp übernimmt diese Perspektive bei der Zerlegung des Netzwerks in Schichten. Anstatt die Gewichtungen einer Schicht zu aktualisieren, um eine Verlustfunktion auf die Ausgabe zu minimieren, wendet LocoProp insbesondere eine vordefinierte lokale Verlustfunktion an, die für jede Schicht spezifisch ist. Für eine bestimmte Schicht wird die Verlustfunktion so gewählt, dass sie mit der Aktivierungsfunktion übereinstimmt. Beispielsweise würde ein Tanh-Verlust für eine Schicht mit Tanh-Aktivierung gewählt. Darüber hinaus stellt der Regularisierungsterm sicher, dass die aktualisierten Gewichte nicht zu weit von ihren aktuellen Werten abweichen.

Ähnlich wie bei der Backpropagation wendet LocoProp einen Vorwärtsdurchlauf an, um Aktivierungen zu berechnen. Beim Rückwärtsdurchlauf legt LocoProp Ziele für Neuronen in jeder Schicht fest. Schließlich zerlegt LocoProp das Modelltraining in unabhängige Probleme über Schichten hinweg, wobei mehrere lokale Aktualisierungen parallel auf die Gewichte jeder Schicht angewendet werden können.

Google hat Experimente mit Deep-Autoencoder-Modellen durchgeführt, einem gängigen Maßstab für die Bewertung der Leistung von Optimierungsalgorithmen. Sie führten umfangreiche Optimierungen an mehreren häufig verwendeten Optimierern erster Ordnung durch, darunter SGD, SGD mit Momentum, AdaGrad, RMSProp, Adam und Optimierern höherer Ordnung, einschließlich Shampoo, K-FAC, und verglichen die Ergebnisse mit LocoProp. Die Ergebnisse zeigen, dass die LocoProp-Methode eine deutlich bessere Leistung als Optimierer erster Ordnung erbringt und mit Optimierern höherer Ordnung vergleichbar ist, während sie bei der Ausführung auf einer einzelnen GPU deutlich schneller ist.

Das obige ist der detaillierte Inhalt vonYann LeCun spricht über Google Research: Zielgerichtete Kommunikation gibt es schon lange, wo ist Ihre Innovation?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr