Heim >Technologie-Peripheriegeräte >KI >Mit einer einzigen Karte können KI-Malmodelle ausgeführt werden, die auch für Anfänger verständlich sind. Kostenlose NPU-Rechenleistung ist mit 1 Million Karten verfügbar.

Mit einer einzigen Karte können KI-Malmodelle ausgeführt werden, die auch für Anfänger verständlich sind. Kostenlose NPU-Rechenleistung ist mit 1 Million Karten verfügbar.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 18:16:081493Durchsuche

Ich glaube, jeder kennt die jüngste Beliebtheit des KI-Zeichnens.

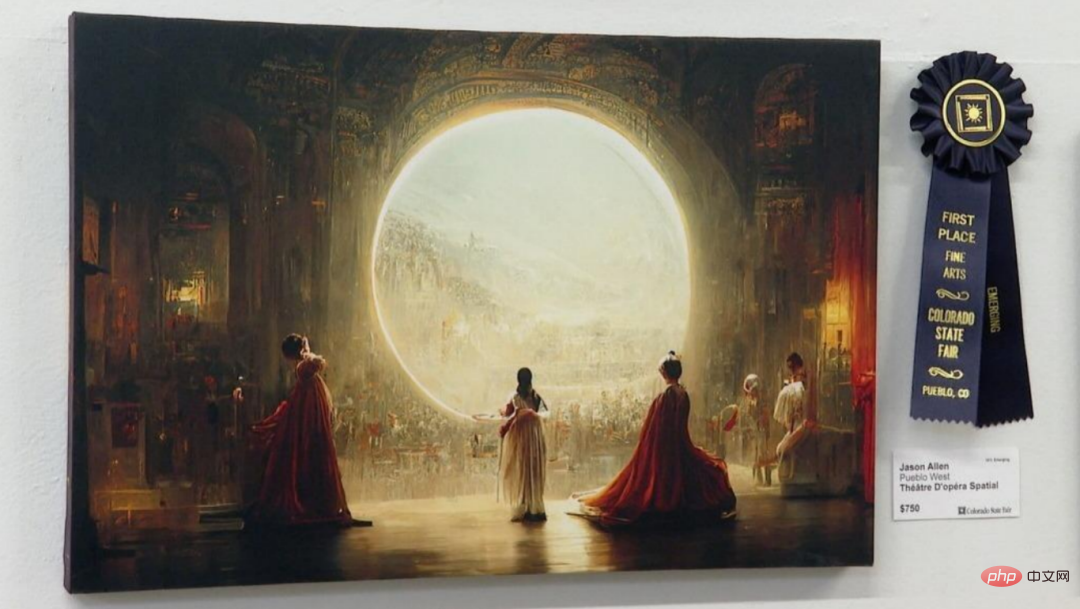

Von den von KI-Zeichensoftware generierten Werken über den Sieg über viele menschliche Künstler bis hin zum Gewinn der digitalen Kunstmeisterschaft haben sich in- und ausländische Plattformen wie DALL.E, Imagen und Novelai bis heute floriert.

Vielleicht haben Sie auch auf verwandte Websites geklickt und versucht, die Szenerie in Ihrem Kopf von der KI beschreiben zu lassen, oder Sie haben ein hübsches/schönes Foto von sich hochgeladen und dann über den rauen Kerl gelacht, der schließlich entstanden ist.

Also, während Sie den Charme des KI-Zeichnens spüren, haben Sie jemals darüber nachgedacht (nein, das müssen Sie getan haben), was ist das Geheimnis dahinter?

△Die Arbeit, die die Kategorie „Digitale Kunst“ auf der Colorado Technology Expo gewann – „Space Opera“

Alles beginnt mit einem Modell namens DDPM...

Was ist DDPM?

DDPM-Modell, der vollständige Name lautet Denoising Diffusion Probabilistic Model, kann als Urheber des aktuellen Diffusionsmodells bezeichnet werden.

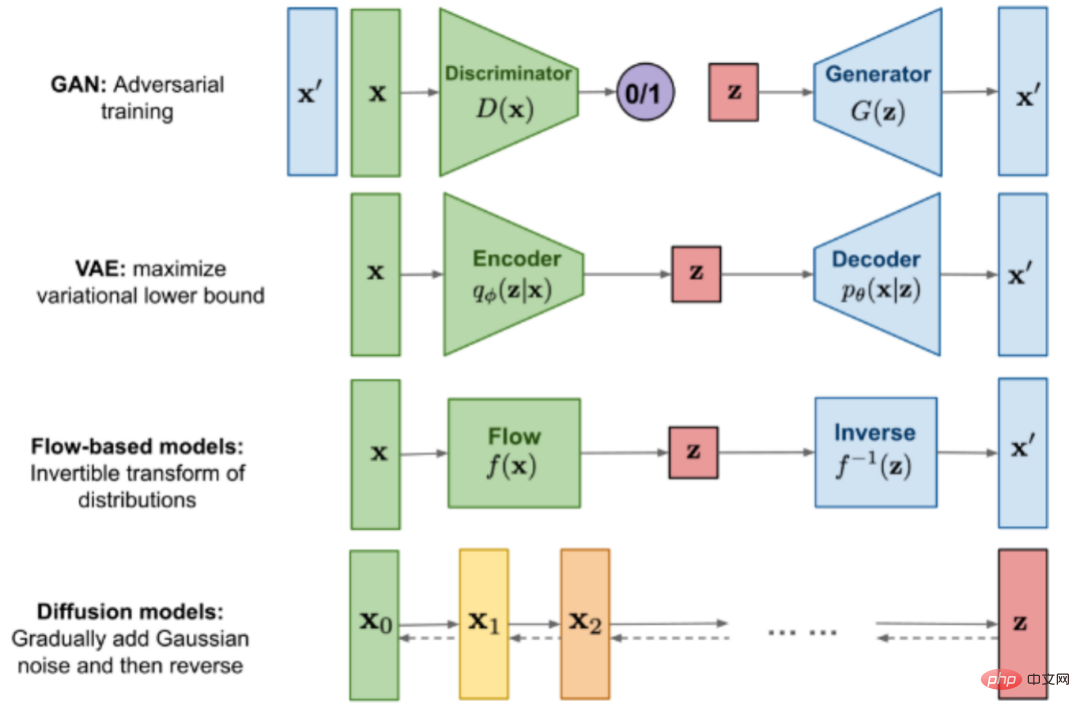

Im Gegensatz zu Vorgängermodellen wie GAN, VAE und Strömungsmodellen besteht die Gesamtidee des Diffusionsmodells darin, durch einen optimierungsorientierten Ansatz schrittweise Bilder aus einem reinen Rauschbild zu generieren.

△Jetzt gibt es einen Vergleich der generierten Bildmodelle

Einige Freunde fragen sich vielleicht: Was ist ein reines Rauschbild?

Es ist ganz einfach. Wenn der alte Fernseher kein Signal hat, sind die Schneeflockenbilder, die zusammen mit dem „Kribbelgeräusch“ erscheinen, reine Rauschbilder.

Was DDPM in der Generierungsphase tut, ist, diese „Schneeflocken“ Stück für Stück zu entfernen, bis das klare Bild sein wahres Aussehen offenbart. Wir nennen diese Phase „Entrauschen“.

△Reines Rauschbild: Schneeflockenbildschirm eines alten Fernsehers

Anhand der Beschreibung kann man spüren, dass die Rauschunterdrückung tatsächlich ein recht komplizierter Prozess ist.

Es gibt keine bestimmte Regel für das Entrauschen. Vielleicht warst du schon lange beschäftigt, aber am Ende möchtest du trotzdem vor den seltsamen Bildern weinen.

Natürlich haben verschiedene Arten von Bildern auch unterschiedliche Entrauschungsregeln. Jemand hatte eine Idee und eine wunderbare Methode, wie man die Maschine diese Regel lernen lässt:

Da die Entrauschungsregeln schwer zu erlernen sind, dann I Warum nicht zuerst ein Bild durch Hinzufügen von Rauschen in ein reines Rauschbild umwandeln und dann den gesamten Vorgang in umgekehrter Reihenfolge durchführen?

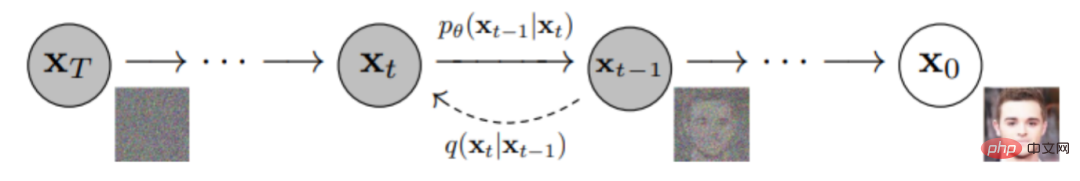

Dies legt den gesamten Trainings-Inferenzprozess des Diffusionsmodells fest: Zuerst wird das Bild in ein reines Rauschbild umgewandelt, das sich einer Gaußschen Verteilung annähert, indem im Vorwärtsprozess schrittweise Rauschen hinzugefügt wird durch schrittweises Entrauschen und Generieren von Bildern im umgekehrten Prozess;

Abschließend wird das Modell mit dem Ziel, die Ähnlichkeit zwischen dem Originalbild und dem generierten Bild zu erhöhen, optimiert, bis der gewünschte Effekt erreicht ist.

△DDPM-Training-Inferenzprozess

△DDPM-Training-Inferenzprozess

An diesem Punkt frage ich mich, wie jeder das akzeptiert? Wenn Sie das Gefühl haben, dass es kein Problem gibt und es einfach ist, machen Sie sich bereit, ich werde mit der ultimativen Bewegung (ausführliche Theorie) beginnen.

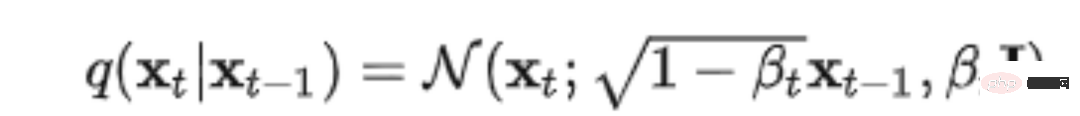

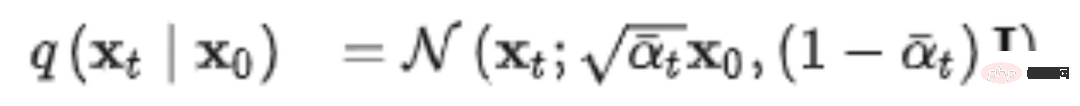

1.1.1 VorwärtsprozessDer Vorwärtsprozess wird auch Diffusionsprozess genannt und das Ganze ist eine parametrisierte Markov-Kette. Ausgehend von der anfänglichen Datenverteilung x0~q(x) wird bei jedem Schritt für T-Zeiten Gaußsches Rauschen zur Datenverteilung hinzugefügt. Der Prozess von Schritt t-1 xt-1 bis Schritt t xt kann durch Gaußsche Verteilung wie folgt ausgedrückt werden:

Mit geeigneten Einstellungen verlieren die ursprünglichen Daten x0 mit zunehmendem t allmählich ihre Eigenschaften. Wir können verstehen, dass nach einer unendlichen Anzahl von Rauschadditionsschritten die endgültigen Daten xT zu einem Bild ohne Merkmale und völlig zufälligem Rauschen werden, was wir zuerst als „Schneeflockenbildschirm“ bezeichnet haben.

Mit geeigneten Einstellungen verlieren die ursprünglichen Daten x0 mit zunehmendem t allmählich ihre Eigenschaften. Wir können verstehen, dass nach einer unendlichen Anzahl von Rauschadditionsschritten die endgültigen Daten xT zu einem Bild ohne Merkmale und völlig zufälligem Rauschen werden, was wir zuerst als „Schneeflockenbildschirm“ bezeichnet haben.

In diesem Prozess können die Änderungen bei jedem Schritt durch Festlegen des Hyperparameters βt gesteuert werden. Unter der Voraussetzung, dass wir das ursprüngliche Bild kennen, kann man sagen, dass der gesamte Prozess der Vorwärtsrauschaddition bekannt und kontrollierbar ist kann bei jedem Schritt vollständig wissen, wie die generierten Daten aussehen.

Aber das Problem besteht darin, dass jede Berechnung vom Ausgangspunkt aus beginnen, den Prozess jedes Schritts kombinieren und ihn langsam auf die gewünschten Schrittdaten xt ableiten muss, was zu mühsam ist. Glücklicherweise können wir aufgrund einiger Merkmale der Gaußschen Verteilung xt in einem Schritt direkt von x0 erhalten.

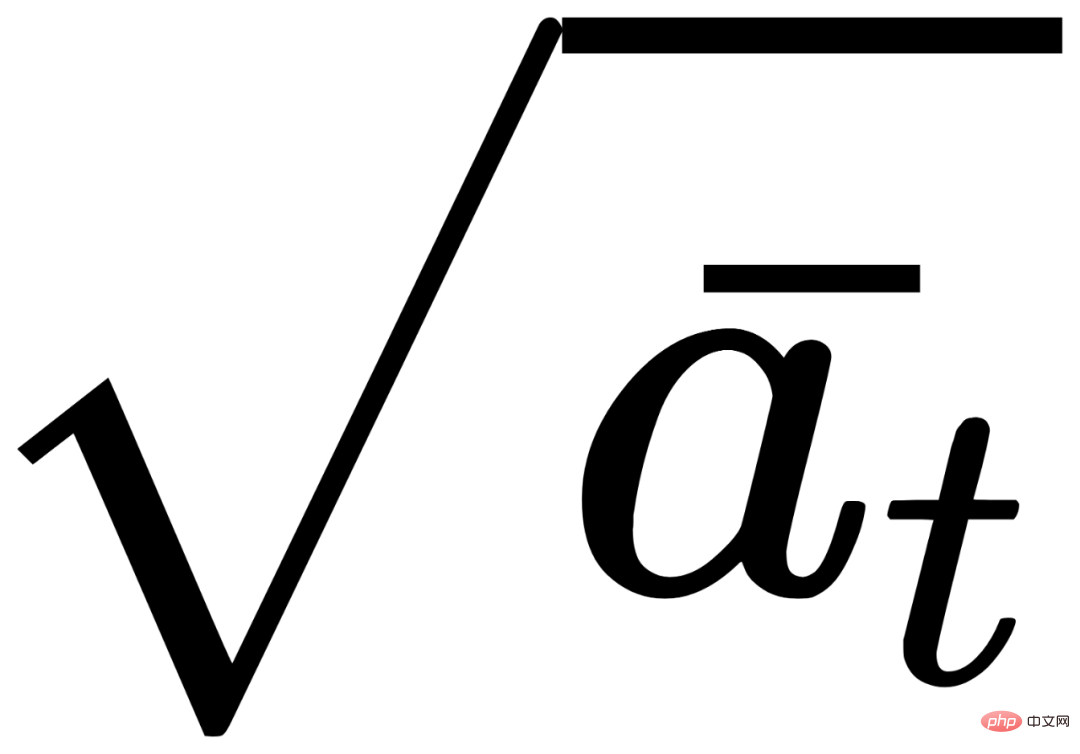

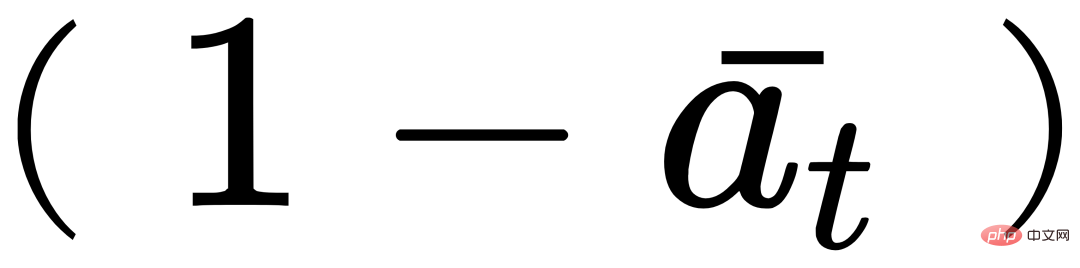

Achtung, das

hier

und  sind Kombinationskoeffizienten, die im Wesentlichen βt-Ausdrücke von Hyperparametern sind.

sind Kombinationskoeffizienten, die im Wesentlichen βt-Ausdrücke von Hyperparametern sind.

1.1.2 Rückwärtsvorgang

und Vorwärtsvorgang Auf die gleiche Weise erfolgt der Der umgekehrte Prozess ist ebenfalls eine Markov-Kette, aber die hier verwendeten Parameter sind unterschiedlich. Was die spezifischen Parameter betrifft, muss die Maschine diese lernen.

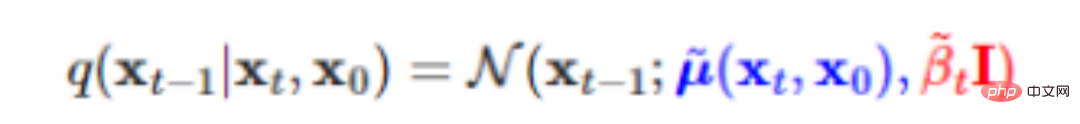

Bevor wir verstehen, wie die Maschine lernt, überlegen wir uns zunächst, wie der Prozess aussehen sollte, basierend auf bestimmten Originaldaten x0, vom t-Schritt xt bis zum t-1-Schritt xt-1 genau . ?

Die Antwort ist, dass dies immer noch durch die Gaußsche Verteilung ausgedrückt werden kann:

Beachten Sie, dass hier x0 berücksichtigt werden muss bedeutet umgekehrt Das dabei erzeugte endgültige Bild hängt immer noch von den Originaldaten ab. Wenn Sie ein Bild einer Katze eingeben, sollte das vom Modell generierte Bild eine Katze sein. Wenn Sie ein Bild eines Hundes eingeben, sollte sich das vom Modell generierte Bild auch auf einen Hund beziehen. Wenn x0 entfernt wird, sind die durch die Diffusion erzeugten endgültigen Bilder unabhängig von der Art des eingegebenen Bildtrainings dieselben, „Katzen und Hunde werden nicht unterschieden“.

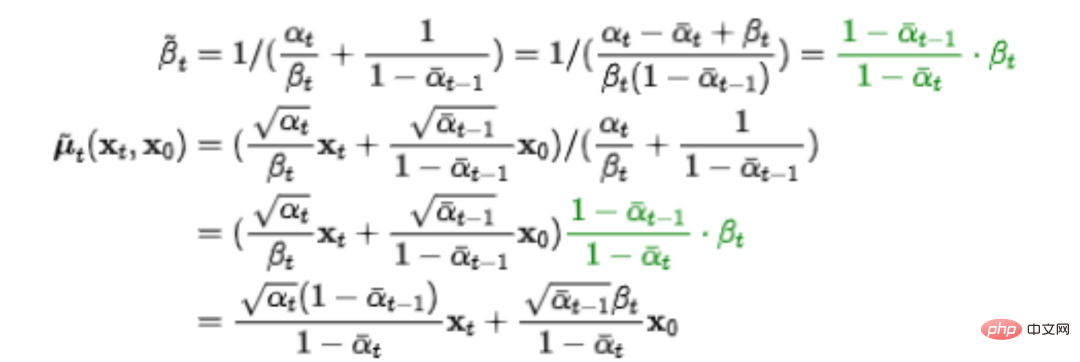

Nach einer Reihe von Ableitungen haben wir festgestellt, dass die Parameter

und

#🎜 im umgekehrten Prozess vorliegen 🎜#

, ist das nicht erstaunlich~

Natürlich kennt die Maschine den tatsächlichen Inversionsprozess nicht im Voraus. Sie kann ihn lediglich mit einer ungefähren geschätzten Verteilung simulieren, ausgedrückt als p0(xt-1|xt).

Natürlich kennt die Maschine den tatsächlichen Inversionsprozess nicht im Voraus. Sie kann ihn lediglich mit einer ungefähren geschätzten Verteilung simulieren, ausgedrückt als p0(xt-1|xt).

Wir haben zu Beginn erwähnt, dass die Daten schließlich durch Vergrößerung der Originaldaten generiert werden müssen und umgekehrt Prozessähnlichkeit zur Optimierung des Modells. Beim maschinellen Lernen berechnen wir diese Ähnlichkeit basierend auf der Kreuzentropie.

In Bezug auf Kreuzentropie wird die akademische Definition „zur Messung der Differenzinformationen zwischen zwei Wahrscheinlichkeitsverteilungen“ verwendet. Mit anderen Worten: Je kleiner die Kreuzentropie, desto näher ist das vom Modell erzeugte Bild dem Originalbild. In den meisten Fällen ist die Berechnung der Kreuzentropie jedoch schwierig oder unmöglich, sodass wir im Allgemeinen den gleichen Effekt erzielen, indem wir einen einfacheren Ausdruck optimieren.

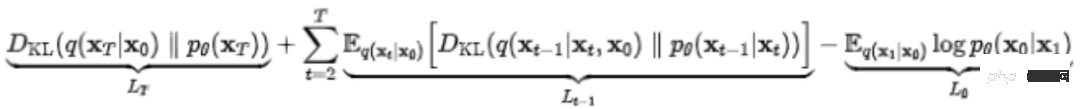

Das Diffusionsmodell basiert auf den Optimierungsideen des VAE-Modells und ersetzt Kreuzentropie durch Variationsuntergrenze (VLB, auch bekannt als ELBO) als maximales Optimierungsziel. Nach unzähligen Zerlegungsschritten kamen wir schließlich zu:

Angesichts einer so komplizierten Formel müssen viele Freunde einen großen Kopf haben. Aber keine Panik, worauf Sie hier achten müssen, ist nur Lt-1 in der Mitte. Es stellt die geschätzte Verteilung p0(xt-1|xt) und die tatsächliche Verteilung q(xt-1|xt,x0) dazwischen dar xt und xt-1 ) Lücke. Je kleiner die Lücke, desto besser ist das vom Modell erzeugte Endbild.

Angesichts einer so komplizierten Formel müssen viele Freunde einen großen Kopf haben. Aber keine Panik, worauf Sie hier achten müssen, ist nur Lt-1 in der Mitte. Es stellt die geschätzte Verteilung p0(xt-1|xt) und die tatsächliche Verteilung q(xt-1|xt,x0) dazwischen dar xt und xt-1 ) Lücke. Je kleiner die Lücke, desto besser ist das vom Modell erzeugte Endbild.

Nachdem wir die Prinzipien hinter DDPM verstanden haben, sehen wir uns an, wie das DDPM-Modell implementiert wird …

Das ist seltsam. Ich glaube, wenn Sie dies lesen, möchten Sie sich auf keinen Fall von Hunderten oder Tausenden von Codezeilen taufen lassen.

Glücklicherweise hat MindSpore Ihnen ein vollständig entwickeltes DDPM-Modell zur Verfügung gestellt. Die Bedienung ist einfach und kann mit einer einzigen Karte durchgeführt werden Der Effekt muss nur ausgeführt werden

Einige Analyse wichtiger Parameter:

GaussianDiffusion

- image_size: Bildgröße

- timesteps: Anzahl der Rauschschritte

- sampling_timesteps: Anzahl der Sampling-Schritte Um die Inferenzleistung zu verbessern, muss sie kleiner als die Anzahl sein Rauschschritte

Trainer

- folder_or_dataset: Entsprechend dem Pfad im Bild kann es sich um den Pfad des heruntergeladenen Datensatzes (str) handeln, oder es kann VisionBaseDataset, GeneratorDataset oder MindDataset sein, das die Datenverarbeitung durchgeführt hat

- train_batch_size : Batch-Größe

- train_lr: Lernrate

- train_num_steps: Anzahl der Trainingsschritte

„Erweiterte Version“ DDPM-Modell MindDiffusion

DDPM ist nur der Anfang der Geschichte der Diffusion. Derzeit sind unzählige Forscher von der großartigen Welt dahinter angezogen und haben sich ihr gewidmet.

Während der kontinuierlichen Optimierung des Modells haben sie auch schrittweise die Anwendung der Diffusion in verschiedenen Bereichen weiterentwickelt.

Dazu gehören Bildoptimierung, Inpainting, 3D-Vision im Bereich Computer Vision, Text-to-Speech in der Verarbeitung natürlicher Sprache, molekulare Konformationsgenerierung, Materialdesign im Bereich AI for Science usw.

Eric Zelikman, ein Doktorand am Fachbereich Informatik der Stanford University, nutzte seine Fantasie, um zu versuchen, DALLE-2 mit ChatGPT, einem weiteren kürzlich beliebten Konversationsmodell, zu kombinieren, um eine herzerwärmende Bilderbuchgeschichte zu erstellen.

△DALLE-2 + ChatGPT, eine Geschichte über einen kleinen Roboter namens „Robbie“

Am bekanntesten sind jedoch wahrscheinlich seine Text-zu-Bild-Anwendungen. Geben Sie ein paar Schlüsselwörter oder eine kurze Beschreibung ein und das Model kann das entsprechende Bild für Sie generieren.

Geben Sie zum Beispiel „City Night Scene Cyberpunk Greg Lutkowsky“ ein und das Endergebnis wird ein farbenfrohes Werk im futuristischen Science-Fiction-Stil sein.

Wenn Sie beispielsweise „Monets Frau mit Sonnenschirm im Mondtraum“ eingeben, erhalten Sie ein sehr verschwommenes Porträt einer Frau. Erinnert Sie der Farbanpassungsstil an Monets „Seerosen“?

Möchten Sie ein realistisches Landschaftsfoto als Bildschirmschoner? Kein Problem!

△Country Field Screensaver

Möchten Sie etwas mit mehr zweidimensionaler Konzentration? Das ist auch ok!

△Aus dem realistischen Stil der Abgrundlandschaftsmalerei

Die oben genannten Bilder wurden alle von Wukong Huahua unter der MindDiffusion-Plattform produziert, einem großen Modell chinesischen Textes, das auf dem Diffusionsmodell basiert und vom Noah-Team von Huawei erstellt wurde arbeitete mit dem ChinaSoft Distributed Parallel Laboratory und der Produktabteilung von Ascend Computing zusammen, um gemeinsam zu entwickeln.

Das Modell wird auf der Grundlage des Wukong-Datensatzes trainiert und mithilfe der Software- und Hardwarelösungen MindSpore + Ascend implementiert.

Freunde, die es unbedingt ausprobieren möchten, keine Sorge, um jedem ein besseres Erlebnis und mehr Raum für die Selbstentwicklung zu bieten, planen wir, dass die Modelle in MindDiffusion auch die Eigenschaften Trainierbarkeit und Schlussfolgerung haben. Es wird voraussichtlich nächstes Jahr verfügbar sein. Wir sehen uns alle, bleiben Sie dran.

Wir heißen alle herzlich willkommen, ein Brainstorming durchzuführen und verschiedene einzigartige Arbeitsstile zu entwickeln ~

(Laut Kollegen, die sich nach internen Informationen erkundigt haben, haben einige Leute bereits damit begonnen, „Zhang Fei-Stickerei“, „Liu Huaqiang Melonen schneiden“ auszuprobieren. „Alte griechische Götter“ „Godzilla vs. Godzilla“. Ähm, was soll ich tun? Ich freue mich plötzlich auf das fertige Produkt fragte, warum es so populär werden kann, dass es sogar populärer wird als das GAN-Netzwerk?

Diffusion hat herausragende Vorteile und offensichtliche Nachteile; viele ihrer Bereiche sind noch leer und ihre Zukunft ist noch unbekannt.

Warum arbeiten so viele Menschen unermüdlich daran?

Vielleicht können uns die Worte von Professor Ma Yi eine Antwort geben.

Aber die Wirksamkeit des Diffusionsprozesses und sein schneller Ersatz von GAN verdeutlichen auch eine einfache Wahrheit: Ein paar Zeilen einfacher und korrekter mathematischer Ableitung können viel effektiver sein als das groß angelegte Debuggen von Hyperparametern und Netzwerkstrukturen im letzten Jahrzehnt. Vielleicht ist das der Reiz des Diffusion-Modells.参考链接(可滑动查看):

[1]https://medium.com/mlearning-ai/ai-art-wins-fine-arts-competition-and-sparks-controversy-882f9b4df98c

[2] Jonathan Ho, Ajay Jain und Pieter Abbeel. Entrauschende Diffusions-Wahrscheinlichkeitsmodelle. arXiv:2006.11239, 2020.

[3]Ling Yang, Zhilong Zhang, Shenda Hong, Runsheng Xu, Yue Zhao, Yingxia Shao, Wentao Zhang, Ming-Hsuan Yang und Bin Cui. Diffusionsmodelle: Ein umfassender Überblick über Methoden und Anwendungen. arXiv-Vorabdruck arXiv:2209.00796, 2022.

[4]https://lilianweng.github.io/posts/2021-07-11-diffusion-models

[5]https://github.com/lvyufeng/denoising -diffusion-mindspore

[6]https://zhuanlan.zhihu.com/p/525106459

[7]https://zhuanlan.zhihu.com/p/500532271

[8]https://www .zhihu.com/question/536012286

[9]https://mp.weixin.qq.com/s/XTNk1saGcgPO-PxzkrBnIg

[10]https://m.weibo.cn/3235040884/4804448864177745

Das obige ist der detaillierte Inhalt vonMit einer einzigen Karte können KI-Malmodelle ausgeführt werden, die auch für Anfänger verständlich sind. Kostenlose NPU-Rechenleistung ist mit 1 Million Karten verfügbar.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr