Heim >Technologie-Peripheriegeräte >KI >Das LLaMA-Modell wurde durchgesickert und die Meta-Version von ChatGPT wurde gezwungen, „Open Source' zu sein! GitHub erhält 8.000 Sterne und es werden zahlreiche Rezensionen veröffentlicht

Das LLaMA-Modell wurde durchgesickert und die Meta-Version von ChatGPT wurde gezwungen, „Open Source' zu sein! GitHub erhält 8.000 Sterne und es werden zahlreiche Rezensionen veröffentlicht

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 17:49:031537Durchsuche

Der Kampf um ChatGPT wird immer intensiver.

Vor einigen Wochen veröffentlichte Meta sein eigenes groß angelegtes Sprachmodell LLaMA mit Parametern zwischen 7 und 65 Milliarden.

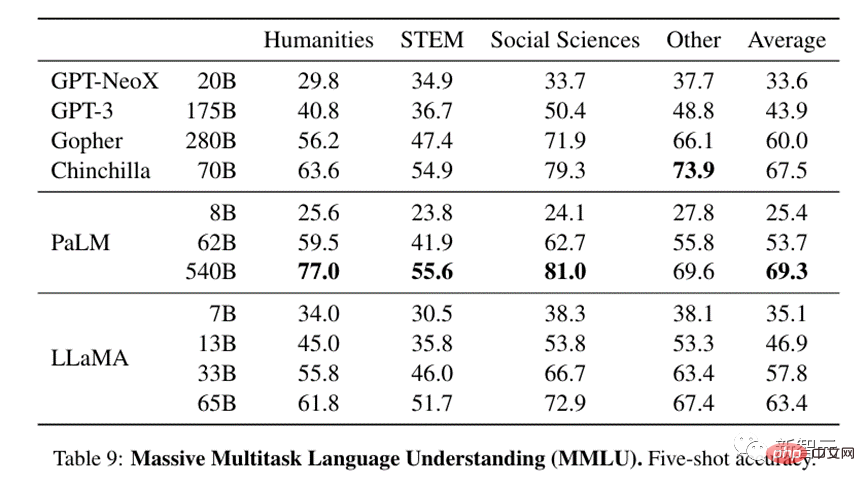

In der Studie übertraf LLaMA (13 Milliarden) mit nur 1/10 Parametern GPT-3 bei den meisten Benchmarks.

Für LLaMA mit 65 Milliarden Parametern ist es vergleichbar mit DeepMinds Chinchilla (70 Milliarden Parameter) und Googles PaLM (540 Milliarden Parameter).

Obwohl Meta behauptet, dass LLaMA Open Source ist, müssen Forscher es dennoch anwenden und überprüfen.

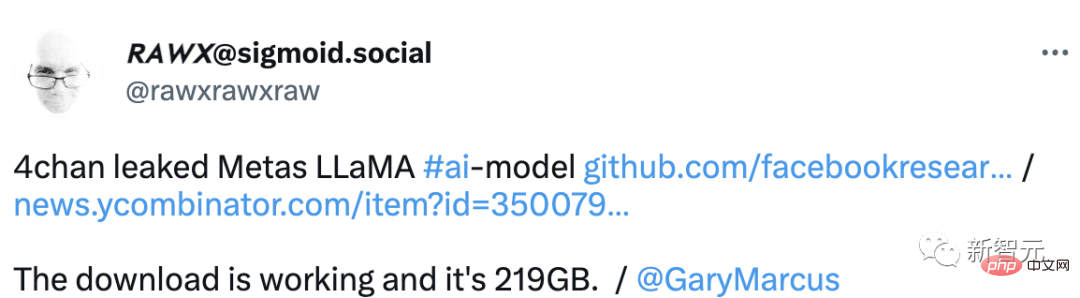

Was ich jedoch nie erwartet hätte, war, dass nur wenige Tage nach der Veröffentlichung die Modelldateien von LLaMA im Voraus durchgesickert waren.

Die Frage ist also, ist das Absicht oder Zufall? LLaMA war „Open Source“?

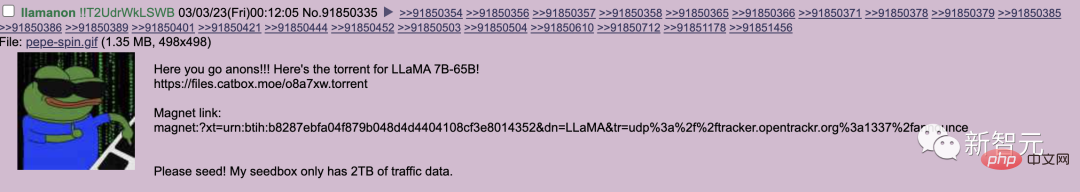

Kürzlich wurde die fertige Produktbibliothek von LLaMA im ausländischen Forum 4chan durchgesickert.

Er reichte außerdem eine zweite Pull-Anfrage an das Projekt ein, die einen Seed-Link zu einem anderen Satz Gewichte für das Modell bereitstellte.

Aktuell hat das Projekt 8.000 Sterne auf GitHub erhalten.

Einer der größten Fehler, den Leaker machen, besteht jedoch darin, ihren eindeutigen Identifikationscode in das durchgesickerte Modell aufzunehmen.

Dieser Code wurde speziell entwickelt, um Leaker aufzuspüren und die persönlichen Daten des Benutzers llamanon zu gefährden.

Wie das Sprichwort sagt, ist LLaMAs Open Source nicht sehr anständig, aber die Internetnutzer tragen dazu bei, dass es anständig ist.

Darüber hinaus haben Benutzer von 4chan eine praktische Ressource für diejenigen erstellt, die das Modell auf ihren eigenen Workstations bereitstellen möchten.

und bietet eine Anleitung zu einem Verteilungs-Tutorial, in dem erläutert wird, wie man ein Modell erhält und ihm für eine effizientere Inferenz modifizierte Gewichte hinzufügt.

Darüber hinaus bietet diese Ressource sogar eine Möglichkeit, LLaMA in die Online-Schreibplattform KoboldAI zu integrieren.

Ein Internetnutzer machte eine klare Analyse: „Vielleicht wurde dies von Meta absichtlich durchgesickert, um gegen OpenAI zu kämpfen.“

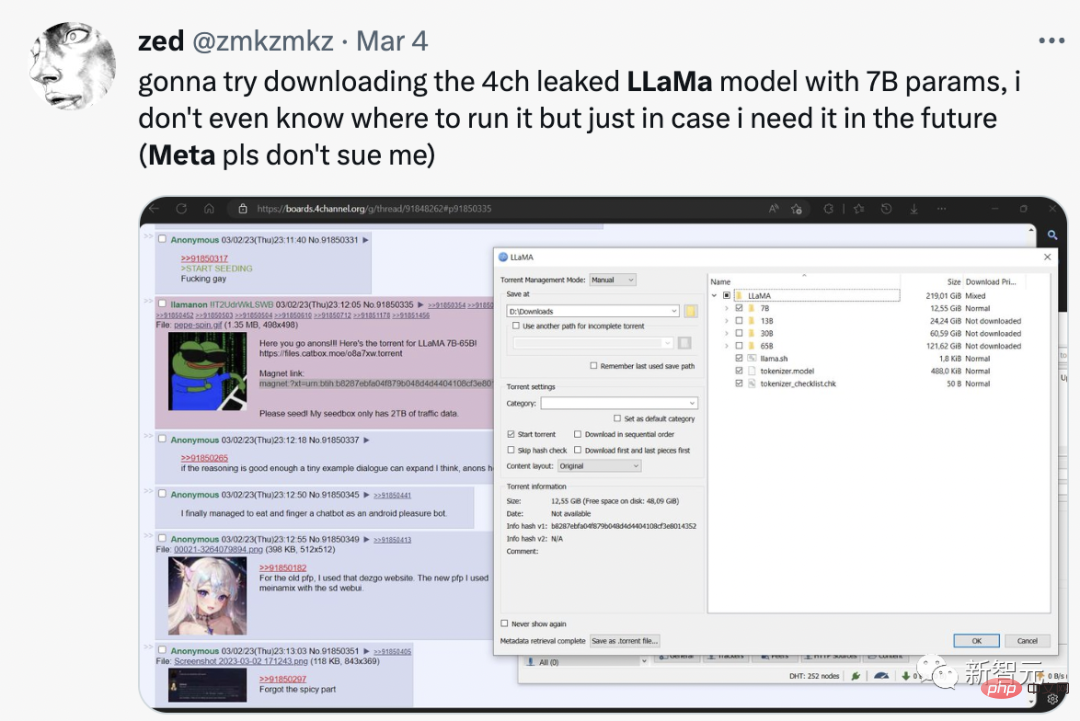

Einige Kunden denken, dass dies ein besseres Modell ist und es genau den Kern ihres Geschäftsplans trifft, den Zugang für 250.000 US-Dollar pro Jahr zu verkaufen. Für einen Monat Zugang zu ihrem Dienst kauft man eine Maschine, auf der dieses geleakte Modell laufen kann. Meta unterbietet einen potenziellen neuen Konkurrenten, um das derzeitige große Technologiekartell stabil zu halten. Vielleicht ist das eine Art Verschwörungstheorie, aber wir leben im Zeitalter großer Technologie und großer Verschwörungen. Am Montag sagte Meta, dass es seine Tools für künstliche Intelligenz weiterhin akkreditierten Forschern zur Verfügung stellen werde, auch wenn LLaMA an nicht autorisierte Benutzer weitergegeben wurde. Einige Internetnutzer sagten direkt, dass sie LLaMA mit 7 Milliarden Parametern heruntergeladen haben. Obwohl sie nicht wissen, wie man es ausführt, können sie es für den Fall, dass sie es in Zukunft benötigen, herunterladen.

Das Leck und Open Source von LLaMA ist ein großes Ereignis:

Stable Diffusion ist Open Source. Acht Monate später können wir nun die Gedanken anderer Menschen lesen und alles entschlüsseln, was sie sehen.

Mit der Eröffnung der LLMs werden wir einige wirklich verrückte Sachen bekommen.

Vorläufige Modellbewertung

Nicht lange nach der Veröffentlichung von LLaMA entdeckten Internetnutzer, dass dieses Modell mit den kleinsten Parametern auch fast 30 GB GPU zum Betrieb benötigt.

Mit der Gleitkommaoptimierung über Bits- und Bytes-Bibliotheken konnten sie das Modell jedoch auf einer einzigen NVIDIA RTX 3060 zum Laufen bringen.

Darüber hinaus konnte ein Forscher auf GitHub sogar einige Wörter pro Sekunde ableiten, wenn er die 7B-Version von LLM auf einer Ryzen 7900X-CPU ausführte.

Was genau ist also das LLaMA-Modell? Ausländische Leute haben es rezensiert.

LLaMA hat in vielen Tests gut abgeschnitten.

In Bezug auf das Verständnis groß angelegter Multitasking-Sprachen liegt selbst das relativ kleine 13B-Modell auf Augenhöhe mit GPT-3, das 13-mal größer ist.

Die 33B-Version ist GPT-3 weit überlegen, und die 65B-Version kann mit dem leistungsstärksten vorhandenen LLM-Modell konkurrieren – dem 540B-Parameter-PaLM von Google.

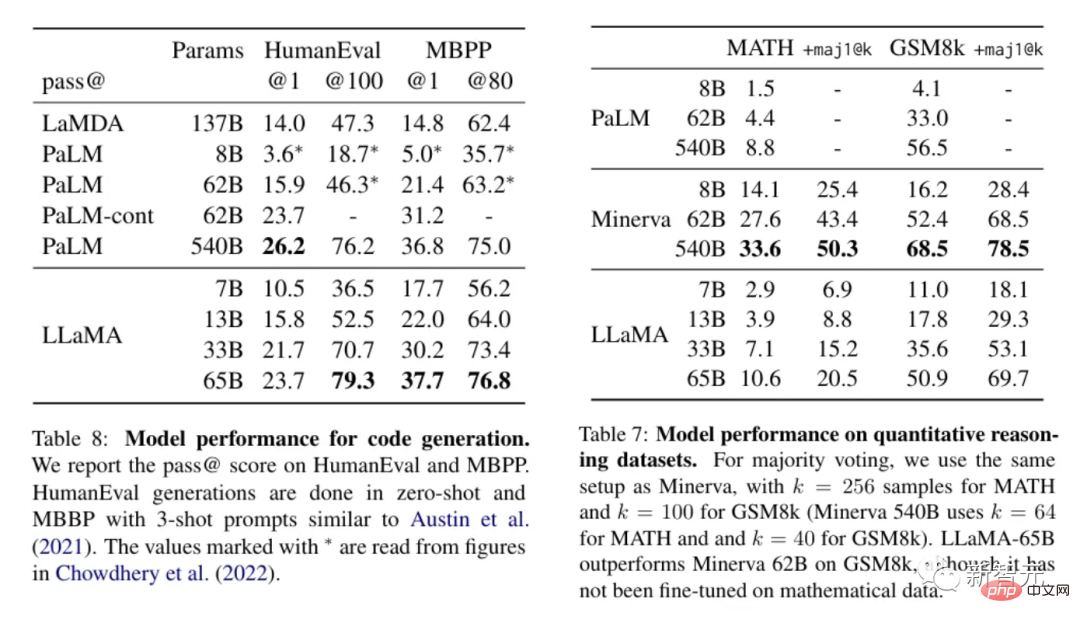

Bei Texten, die die Anwendung von Logik oder Berechnungen zur Verarbeitung erfordern, schneidet LLaMA gut ab und ist hinsichtlich des quantitativen Denkens mit PaLM vergleichbar und verfügt sogar über bessere Fähigkeiten zur Codegenerierung als letzteres.

Angesichts dieser Ergebnisse scheint LLaMA eines der fortschrittlichsten Modelle zu sein, die derzeit verfügbar sind, und darüber hinaus ist es klein genug, dass es nicht viele Ressourcen zum Betrieb benötigt. Das macht LLaMA für Leute sehr verlockend, damit zu spielen und zu sehen, was es kann.

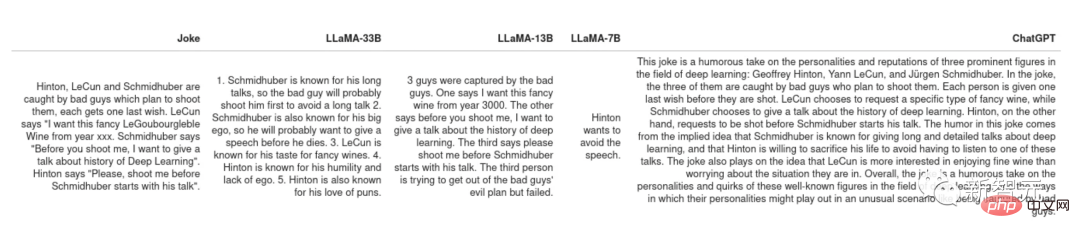

Witze erklären

PaLMs Originalpapier zeigt einen sehr coolen Anwendungsfall: Lassen Sie das Modell anhand eines Witzes erklären, warum er lustig ist. Diese Aufgabe erfordert eine Kombination aus Experimentieren und Logik, die alle bisherigen PaLM-Modelle nicht bewältigen konnten.

Lassen Sie sich einige der Witze von LLaMA und ChatGPT erklären, wie zum Beispiel Schimidhubers lange und langweilige Rede.

Aber insgesamt haben sowohl LLaMA als auch ChatGPT keinen Sinn für Humor.

Allerdings haben die beiden unterschiedliche Strategien, mit Witzen umzugehen, die sie nicht verstehen. ChatGPT wird eine „Textwand“ erzeugen, in der Hoffnung, dass zumindest einige der Sätze richtige Antworten sind Wie ein Schüler, der die Antwort nicht kennt, hoffe ich, dass der Lehrer aus seinem Unsinn die Antwort finden kann.

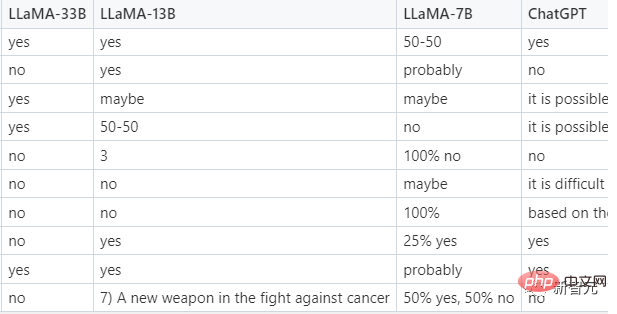

Zero-Shot-Klassifizierung

Dies ist eine sehr praktische Funktion, die es Benutzern ermöglicht, LLM anstelle von Bewertern zu verwenden, um Trainingssätze zu generieren und dann kleinere wartungsfähige Modelle auf diesen Trainingssätzen zu trainieren.

Eine anspruchsvollere Aufgabe besteht darin, angeklickte Anzeigen zu klassifizieren. Da sich selbst Menschen nicht darauf einigen können, was angeklickte Anzeigen sind, werden dem Modell in der Eingabeaufforderung einige Beispiele bereitgestellt, sodass es sich tatsächlich um ein weniger Beispiel und einen Wert ungleich Null handelt Probenklassifizierung. Hier sind Tipps von LLaMA.

Im Test gelang es nur LLaMA-33B, dem erforderlichen Format zu folgen, um Antworten zu geben, und seine Vorhersagen schnitten an zweiter Stelle ab und konnten vernünftigere Antworten geben, antworteten jedoch oft nicht im vorgeschriebenen Format . Die kleineren Modelle 7B und 13B sind für diese Aufgabe weniger geeignet.

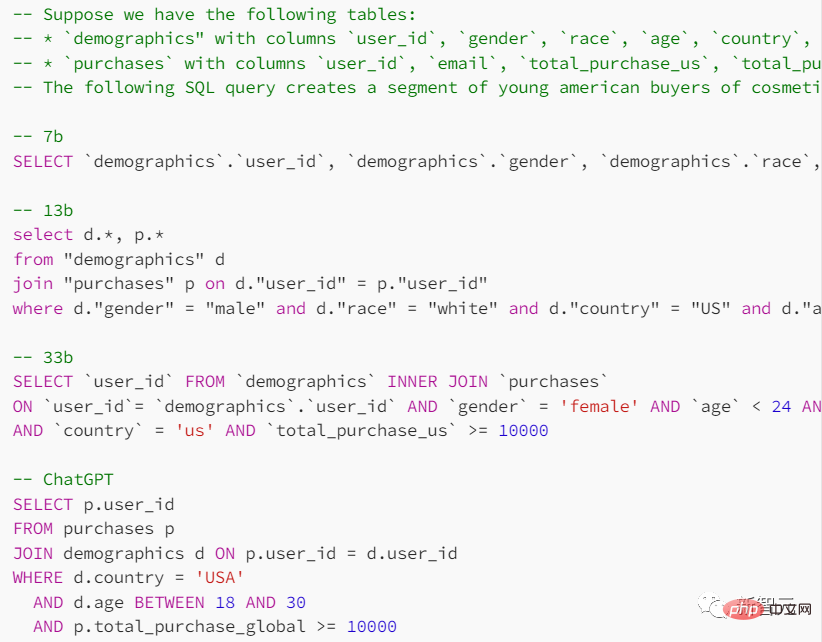

Codegenerierung

Obwohl das französische LLM in Geisteswissenschaften gut abschneidet, ist es in MINT-Fächern nicht gut. Wie schneidet LLaMA in dieser Hinsicht ab?

Geben Sie in der Eingabeaufforderung die Form der Suchtabelle und den Zweck an, den Sie erreichen möchten, und bitten Sie das Modell, SQL-Abfrageanweisungen bereitzustellen.

ChatGPT schneidet bei dieser Aufgabe besser ab, aber die vom Sprachmodell gelieferten Ergebnisse sind im Allgemeinen unzuverlässig.

In verschiedenen Tests im Vergleich zu ChatGPT hat LLaMA nicht so viel gewonnen wie erwartet. Wenn die Lücke nur durch RLHF (Reinforcement Learning mit menschlichem Feedback) verursacht wird, könnte die Zukunft kleiner Modelle natürlich rosiger sein.

Das obige ist der detaillierte Inhalt vonDas LLaMA-Modell wurde durchgesickert und die Meta-Version von ChatGPT wurde gezwungen, „Open Source' zu sein! GitHub erhält 8.000 Sterne und es werden zahlreiche Rezensionen veröffentlicht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr