Heim >Technologie-Peripheriegeräte >KI >ImageNet-Labelfehler entfernt, Modellranking erheblich geändert

ImageNet-Labelfehler entfernt, Modellranking erheblich geändert

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 17:46:111229Durchsuche

Früher wurde ImageNet aufgrund des Problems der Etikettenfehler zu einem heißen Thema. Sie werden überrascht sein, diese Zahl zu hören. Es gibt mindestens 100.000 Etiketten mit Problemen. Studien, die auf falschen Etiketten basieren, müssen möglicherweise annulliert und wiederholt werden.

Aus dieser Sicht ist die Verwaltung der Qualität des Datensatzes immer noch sehr wichtig.

Viele Menschen verwenden den ImageNet-Datensatz als Benchmark, aber basierend auf vorab trainierten ImageNet-Modellen können die Endergebnisse aufgrund der Datenqualität variieren.

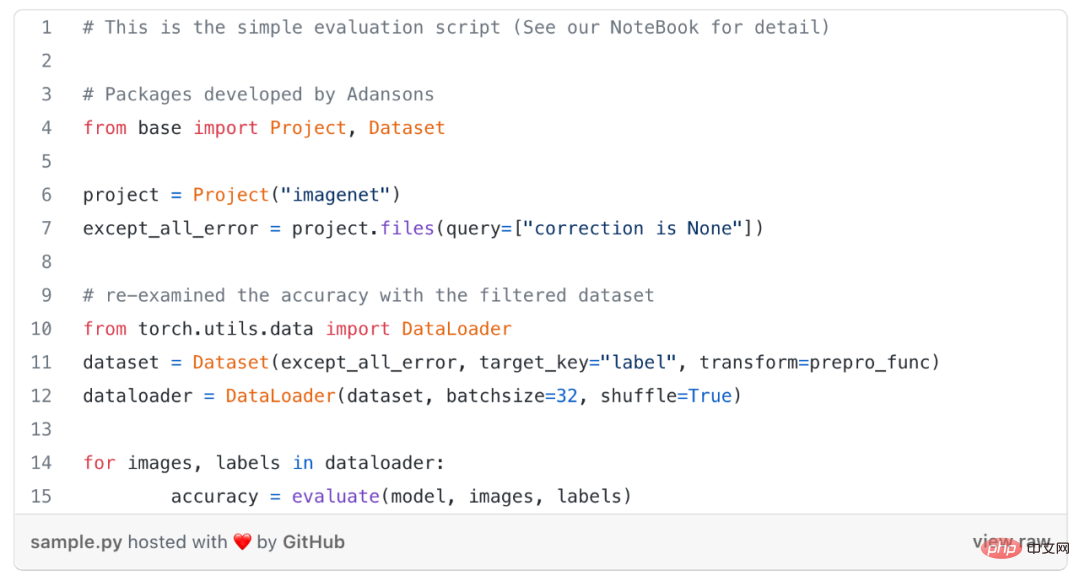

In diesem Artikel untersucht Kenichi Higuchi, ein Ingenieur von Adansons Company, den ImageNet-Datensatz im Artikel „Sind wir mit ImageNet fertig?“ erneut und bewertet ihn nach dem Entfernen erneut Die falschen Etikettendaten. Das Modell wurde auf Torchvision veröffentlicht.

Fehlerhafte Daten aus ImageNet entfernen und das Modell neu bewerten

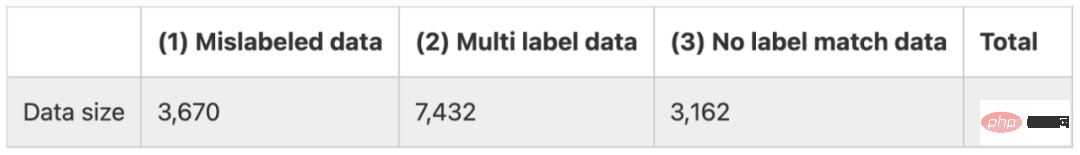

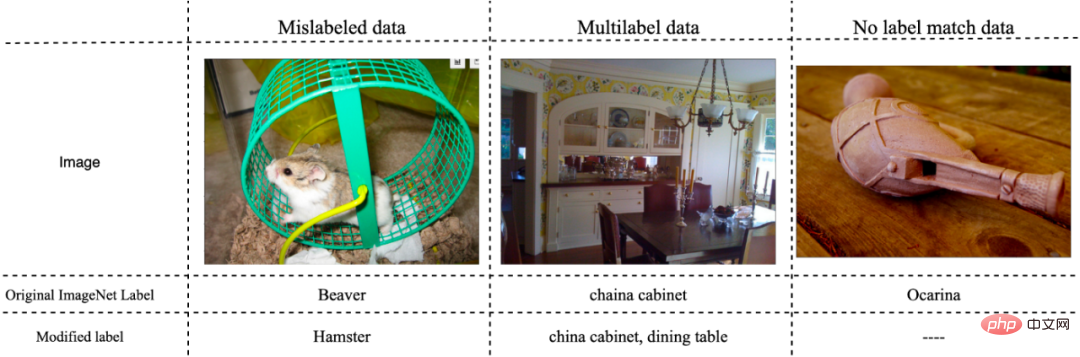

Dieses Dokument unterteilt Beschriftungsfehler in ImageNet in drei Kategorien, wie unten gezeigt.

(1) Daten mit falscher Beschriftung

(2) Daten, die mehreren Beschriftungen entsprechen

(3) Gehört nicht zu beliebige Etikettendaten

Methode

Ohne Umschulung des Modells wurde diese Studie untersucht die Genauigkeit des Modells, indem nur falsch gekennzeichnete Daten, d. h. die oben genannten Fehlerdaten vom Typ (1), und alle falschen Daten aus den Bewertungsdaten, d. h. (1)–(3) Fehlerdaten, ausgeschlossen werden.

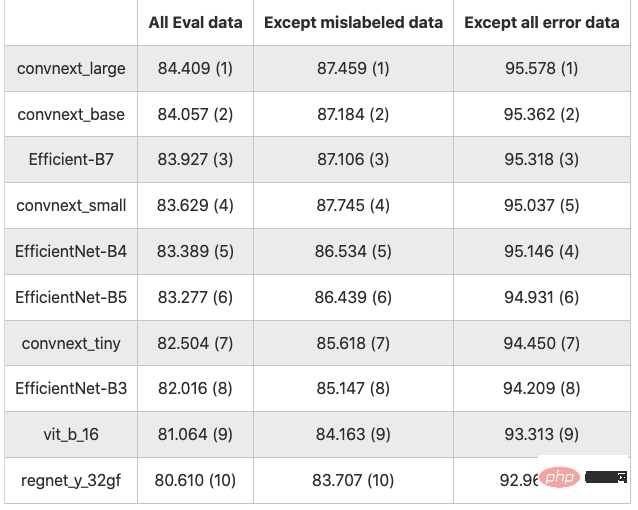

#🎜🎜 #Die Ergebnisse sind in der folgenden Tabelle aufgeführt (Werte sind Genauigkeit in %, Zahlen in Klammern sind Rangfolgen)

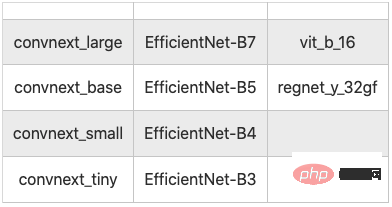

Die Ergebnisse von 10 Klassifizierungsmodellen

Nimmt man alle Eval-Daten als Basis, mit Ausnahme falscher Datentypen (1), erhöht sich die Genauigkeit um durchschnittlich 3,122 Punkte, ohne alle falschen Daten (1)~ (3) stieg die Genauigkeit um durchschnittlich 11.743 Punkte.

Wie erwartet ist die Genauigkeitsrate durchweg verbessert, wenn man fehlerhafte Daten ausschließt. Es besteht kein Zweifel daran, dass fehlerhafte Daten im Vergleich zu sauberen Daten fehleranfällig sind.

Wie erwartet ist die Genauigkeitsrate durchweg verbessert, wenn man fehlerhafte Daten ausschließt. Es besteht kein Zweifel daran, dass fehlerhafte Daten im Vergleich zu sauberen Daten fehleranfällig sind.

Bei der Auswertung ohne Ausschluss fehlerhafter Daten und wenn alle fehlerhaften Daten (1) bis (3) ausgeschlossen werden, ändert sich die Genauigkeitsbewertung des Modells.

In diesem Artikel gibt es 3.670 fehlerhafte Daten (1), was 7,34 % der insgesamt 50.000 Daten ausmacht. Nach dem Entfernen stieg die Genauigkeitsrate im Durchschnitt um etwa 3,22 Punkte . Wenn fehlerhafte Daten entfernt werden, ändert sich der Datenmaßstab und ein einfacher Vergleich der Genauigkeitsraten kann verzerrt sein.

Fazit

Obwohl dies nicht ausdrücklich betont wird, ist es wichtig, bei der Durchführung des Bewertungstrainings genau gekennzeichnete Daten zu verwenden.

Frühere Studien haben beim Vergleich der Genauigkeit zwischen Modellen möglicherweise falsche Schlussfolgerungen gezogen. Die Daten sollten also zunächst ausgewertet werden, aber lässt sich damit wirklich die Leistung des Modells bewerten?

Viele Modelle, die Deep Learning verwenden, scheuen es oft, über die Daten nachzudenken, sind aber bestrebt, die Genauigkeit und andere Bewertungsmetriken durch die Leistung des Modells zu verbessern, selbst wenn die Bewertungsdaten Fehler enthalten Daten werden nicht korrekt verarbeitet.

Bei der Erstellung eigener Datensätze, beispielsweise bei der Anwendung von KI in Unternehmen, steht die Erstellung hochwertiger Datensätze in direktem Zusammenhang mit der Verbesserung der Genauigkeit und Zuverlässigkeit der KI. Die experimentellen Ergebnisse dieser Arbeit zeigen, dass eine einfache Verbesserung der Datenqualität die Genauigkeit um etwa 10 Prozentpunkte verbessern kann, was zeigt, wie wichtig es ist, bei der Entwicklung von KI-Systemen nicht nur das Modell, sondern auch den Datensatz zu verbessern.

Allerdings ist es nicht einfach, die Qualität des Datensatzes sicherzustellen. Während die Erhöhung der Metadatenmenge wichtig ist, um die Qualität von KI-Modellen und -Daten richtig einzuschätzen, kann die Verwaltung insbesondere bei unstrukturierten Daten umständlich sein.

Das obige ist der detaillierte Inhalt vonImageNet-Labelfehler entfernt, Modellranking erheblich geändert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr