Heim >Technologie-Peripheriegeräte >KI >Ray, das Open-Source-KI-Framework hinter ChatGPT, ist jetzt 1 Milliarde US-Dollar wert

Ray, das Open-Source-KI-Framework hinter ChatGPT, ist jetzt 1 Milliarde US-Dollar wert

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 15:07:031684Durchsuche

Textgenerierende künstliche Intelligenz hat in letzter Zeit das Internet im Sturm erobert: ChatGPT ist bekannt für seine Fähigkeit, sehr detaillierte, nahezu lebensechte Antworten auf fast jede Frage zu liefern, die man sich vorstellen kann. Das Aufkommen großer Modellanwendungen hat das Vertrauen der Menschen in die Durchbrüche der KI-Technologie geweckt, aber nur wenige Menschen wissen, dass dahinter ein verteiltes maschinelles Lernframework steckt, das diese generative KI-Revolution vorantreibt.

Das Distributed-Computing-Framework Ray des von A16z unterstützten Startups Anyscale ist der Schlüssel dazu, dass OpenAI das Training von Modellen wie ChatGPT beschleunigen kann. Ray steht hinter allen jüngsten groß angelegten Sprachmodellen von OpenAI – und es könnte auch das Framework hinter dem mit Spannung erwarteten GPT-4 von OpenAI sein. Brancheninsider gehen davon aus, dass mit der kontinuierlichen Implementierung groß angelegter Modelltechnologie durch die Generierung menschennaher Inhalte eine milliardenschwere Branche entsteht.

In diesem Bereich ist Ray der einflussreichste Rahmen. Vor seiner Einführung nutzte OpenAI eine benutzerdefinierte Sammlung von Tools zur Entwicklung großer Modelle. Aber OpenAI-Präsident Greg Brockman sagte auf dem Ray Summit Anfang des Jahres, dass sich das Unternehmen an Ray gewandt habe, als die Herausforderungen, denen es gegenüberstand, zunahmen.

Lukas Biewald, CEO des Softwareunternehmens Weights & Biases, glaubt, dass Ray bereits ein heißer aufstrebender Stern in der KI-Welt ist. „Dank neuer Tools können Sie denselben Code auf einem Laptop und auf einem großen verteilten Server ausführen. Das ist eine große Veränderung, und sie wird an Bedeutung gewinnen, je größer die Modelle werden“, sagte Biewald.

Milliarden-Dollar-Wette

Mit zunehmender Reife der Technologie hat Ray die Aufmerksamkeit des Kapitalmarkts auf sich gezogen. Das Eigenkapital von Anyscale ist zu einem knappen Gut geworden. Business Insider berichtete, dass die jüngste Finanzierungsrunde, eine Erweiterung der Serie C, nach Angaben von mit der Angelegenheit vertrauten Personen innerhalb weniger Tage mit einem Wert von mehr als 1 Milliarde US-Dollar abgeschlossen wurde.

Einige Investoren haben Anyscale als hoffnungsvolles „nächstes Databricks“ von Horowitz beschrieben – eine Beschreibung, die Sinn macht, wenn man bedenkt, dass der Mitbegründer des Startups, Ion Stoica, ein 31-Milliarden-Dollar-Datenriese ist.

„Künstliche Intelligenz entwickelt sich in einem unglaublichen Tempo und die Menschen probieren ständig neue Ansätze aus“, sagte Robert Nishihara, CEO von Anyscale. „ChatGPT vereint viele frühere Arbeiten an großen Sprachmodellen. Darüber hinaus benötigen Sie eine Infrastruktur, die Flexibilität, schnelle Innovation und die Erweiterung verschiedener Algorithmen und Methoden ermöglicht.“ Hinter den neuen Tools stehen immer größere Modelle und Technologieunternehmen müssen die Art und Weise, wie sie KI entwickeln, von Grund auf überdenken. Ray wurde entwickelt, um das Trainieren dieser riesigen Modelle zu erleichtern. Ray kann Hunderte Milliarden Datenpunkte enthalten und jeder Antwort ein quasi lebensechtes Gefühl verleihen.

Wie Ray zum Werkzeug der Wahl für maschinelles Lernen wurde

Ray ist ein verteiltes Computer-Framework, das auf Speicherfreigabe basiert und für feinkörniges paralleles Rechnen und heterogenes Computing geeignet ist und eine zugrunde liegende Infrastruktur für die Verwaltung der Zuordnung bereitstellt. Die komplexe Aufgabe von Trainieren von Modellen für maschinelles Lernen.Im Jahr 2017 reichten Forscher der UC Berkeley Rays Artikel „Ray: A Distributed Framework for Emerging AI Applications“ zum ersten Mal ein:

- Papierlink: https://arxiv.org/abs/1712.05889

- GitHub: https://github.com/ray-project/ray

In dieser Arbeit, Forscher Vorhersagen, wie die nächste Generation von KI-Anwendungen aussehen wird: eine, die kontinuierlich mit der Umgebung interagiert und aus interaktiven Aktionen lernt. Diese Anwendungen müssen zunehmend Aufgaben in dynamischen Umgebungen erledigen, auf Veränderungen in der Umgebung reagieren und eine Reihe von Aktionen ausführen, um langfristige Ziele zu erreichen. Diese Funktionen haben neue und anspruchsvolle Systemanforderungen in Bezug auf Leistung und Flexibilität der Betriebsumgebung gestellt, weshalb Forscher ein verteiltes Ray-Framework vorgeschlagen haben.

Ray implementiert eine einheitliche Schnittstelle, die Aufgabenparallelität und akteurbasierte Berechnungen ausdrücken kann, unterstützt von einer einzigen dynamischen Ausführungs-Engine. Um den Leistungsanforderungen gerecht zu werden, verwendet Ray einen verteilten Scheduler und einen verteilten fehlertoleranten Speicher, um den Steuerungsstatus des Systems zu verwalten. Es ist das erste verteilte Computing-Framework, das Training, Simulation und Dienste vereint. Es vereint rollenparallele (Akteur) und aufgabenparallele (Aufgaben-)Berechnungen auf der Grundlage einer dynamischen Task-Ausführungs-Engine und gewährleistet die hohe Skalierbarkeit und hohe Leistung des Frameworks Toleranz.

Rays Architektur.

Aufbauend auf dieser Arbeit gründeten Robert Nishihara, Philipp Moritz und Ion Stoica von der UC Berkeley sowie der Berkeley-Professor Michael I. Jordan im Dezember 2019 Anyscale, das bisher 260 Millionen US-Dollar eingesammelt hat.

Praktiker des maschinellen Lernens können häufig kleine Modelle mit begrenzten Datensätzen auf ihren Laptops ausführen, beispielsweise einfache Modelle, die vorhersagen, welche Produkte Benutzer kaufen werden. Allerdings sind Laptops für sehr große Modelle wie ChatGPT nicht geeignet, da für deren Training riesige Server erforderlich sind.

Das Training eines Modells mit einer großen Anzahl von Geräten steht vor einer großen Herausforderung – der Koordination des Trainings auf unterschiedlicher Hardware. Ray löst einfach dieses Problem. Es stellt Praktikern einen Mechanismus zur Verfügung, mit dem sie unterschiedliche Hardware als Einheit verwalten können, um zu bestimmen, welche Daten wohin gehen, Fehler zu behandeln usw. Die Hardwaretypen umfassen Google Cloud, AWS und andere. Ein Portfolio von Produkten, die das gleiche Problem lösen . Darüber hinaus erweiterte Ray auch „Actor“, ein wichtiges Programmierkonzept in anderen Sprachen, auf Python, das bekanntermaßen die Sprache der Wahl für Programme für maschinelles Lernen ist.

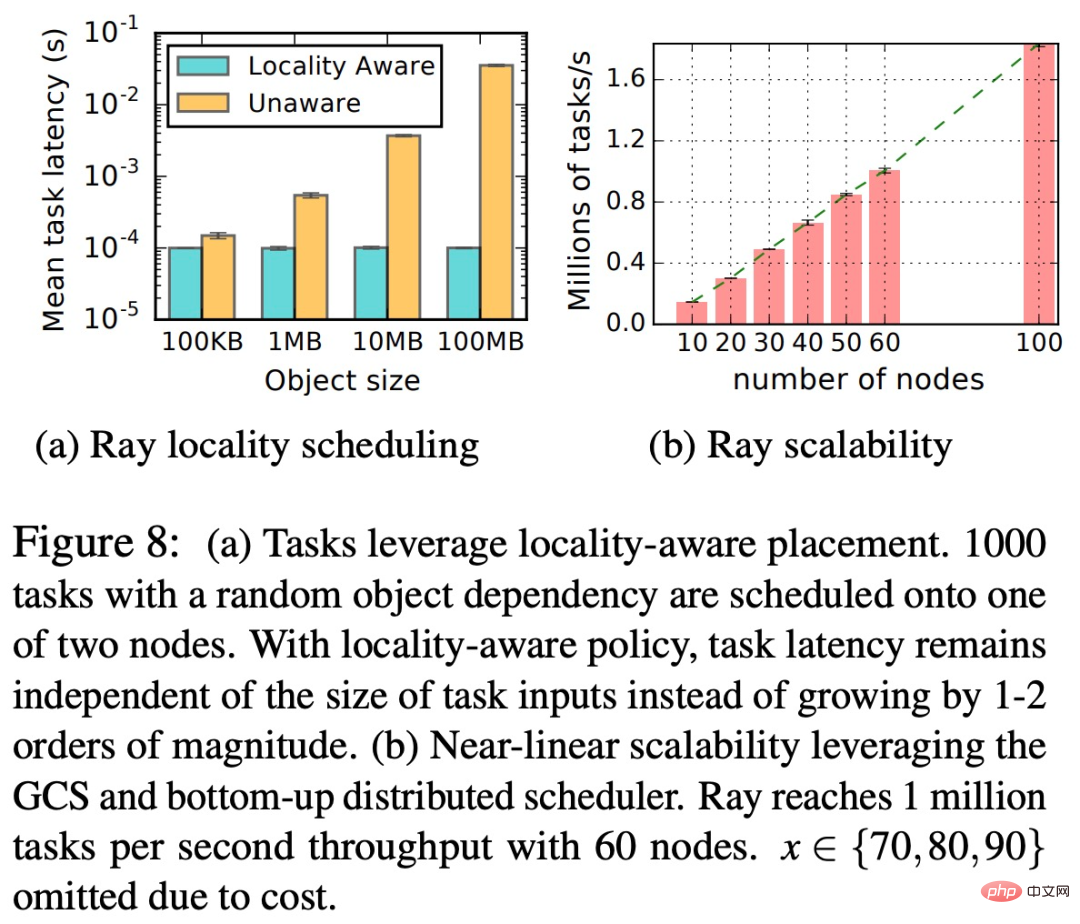

Als verteiltes Computer-Framework bietet Ray zwei wesentliche Vorteile: Standorterkennung (Locality-Aware) und Aufgabenplatzierung (Aufgabenplatzierung). Wie in der folgenden Abbildung dargestellt, ist Ray in der Lage, das System zu skalieren, um feinkörnige Aufgaben mit hohem Durchsatz zu unterstützen und gleichzeitig Fehlertoleranz und Aufgabenplanung mit geringer Latenz aufrechtzuerhalten.

Ray verringert die Komplexität beim Training großer Modelle für OpenAI erheblich und gibt dem Unternehmen mehr Zeit, sich auf die entscheidenden Funktionen des Modells zu konzentrieren.

Eine neue Generation von KI erfordert neue Entwicklungstools, und Ray ist nur eines von vielen schnell wachsenden Werkzeugen für maschinelles Lernen der nächsten Generation, die die Art und Weise, wie KI entwickelt wird, schnell verändern. Beispielsweise hat das JAX-Framework von Google ebenfalls große Aufmerksamkeit erhalten, und es wird erwartet, dass es das Rückgrat der wichtigsten maschinellen Lerntools von Google wird, und es wurde weithin in DeepMind und Google Brain übernommen.

In ähnlicher Weise hat Coiled, ein von FirstMark Capital und Bessemer Venture Partners unterstütztes Startup, ein Parallel-Computing-Framework namens Dask entwickelt.

Groß angelegte Sprachmodelle erschließen heutzutage mehr Potenzial, und diese neuen Tools für maschinelles Lernen werden leistungsfähigere Sprachmodelle für Technologiegiganten und Start-ups in der Branche erstellen.

Das obige ist der detaillierte Inhalt vonRay, das Open-Source-KI-Framework hinter ChatGPT, ist jetzt 1 Milliarde US-Dollar wert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr