Heim >Technologie-Peripheriegeräte >KI >Werden KI-Tools zu einem begehrten Gut für Cyberkriminelle? Studie zeigt, dass russische Hacker OpenAI-Beschränkungen umgehen, um auf ChatGPT zuzugreifen

Werden KI-Tools zu einem begehrten Gut für Cyberkriminelle? Studie zeigt, dass russische Hacker OpenAI-Beschränkungen umgehen, um auf ChatGPT zuzugreifen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 13:19:051222Durchsuche

Branchenberichten zufolge hat OpenAI die Anwendung von ChatGPT, einem leistungsstarken Chatbot, in einigen Ländern und Regionen eingeschränkt, da befürchtet wird, dass er für kriminelle Aktivitäten genutzt werden könnte. Die Studie ergab jedoch, dass einige Cyberkriminelle aus Russland versucht haben, neue Wege zur Umgehung bestehender Beschränkungen zu finden, um ChatGPT einzuführen, und fanden Fälle, darunter die Umgehung von IP-, Zahlungskarten- und Telefonnummernbeschränkungen.

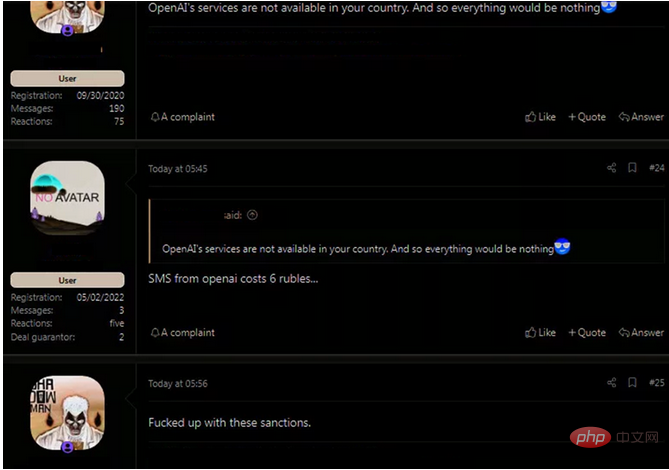

Forscher fanden in einem Hacker-Forum Beweise dafür, dass russische Hacker versuchten, Beschränkungen für den Zugriff auf ChatGPT zu umgehen.

Seit seiner Einführung im November 2022 hat sich ChatGPT zu einem wichtigen Workflow-Tool für Entwickler, Autoren und Studenten entwickelt hat sich auch zu einer mächtigen Waffe entwickelt, die von Cyberkriminellen ausgenutzt werden kann. Es gibt Hinweise darauf, dass Hacker damit bösartigen Code schreiben und Phishing-E-Mails verbessern.

ChatGPT kann für böswillige Zwecke verwendet werden, was bedeutet, dass OpenAI die Bereitstellung des Tools einschränken muss, da Hacker, die ChatGPT verwenden, böswillige Angriffe schneller durchführen können. OpenAI nutzt Geolocation-Blockierungsmaßnahmen, um zu verhindern, dass russische Benutzer auf das System zugreifen.

Die Forscher von Check Point Software fanden jedoch mehrere Fälle, in denen Hacker aus Russland in Untergrund-Hacking-Foren darüber sprachen, wie diese Beschränkungen umgangen werden können. Beispielsweise stellte eine Hackergruppe aus Russland im Forum eine Frage: Wenn sie ChatGPT nicht normal betreten können, wie können sie dann mit einer gestohlenen Zahlungskarte ein OpenAI-Konto bezahlen und über die API auf das System zugreifen? Das System befindet sich derzeit in einer kostenlosen Vorschauversion, während die API die Text- und Codegenerierung mithilfe von Token für die Zahlung während der Sitzungen umfasst.

Sergey Shykevich, Manager der Threat Intelligence-Abteilung von Check Point, sagte, dass die Umgehung der OpenAI-Beschränkungen nicht besonders schwierig sei: „Wir sehen jetzt, dass einige Hacker in Russland bereits darüber diskutieren und prüfen, wie sie Geofences umgehen und ChatGPT für ihre böswilligen Zwecke nutzen können „Wir glauben, dass diese Hacker wahrscheinlich versuchen, ChatGPT in ihren Cyberkriminalitätsaktivitäten zu testen, weil die dahinterstehende künstliche Intelligenz ihre Cyberangriffe effizienter machen kann.“ Sprachtutorials zu halblegitimen Online-SMS-Diensten und deren Verwendung zur Registrierung für ChatGPT, was den Anschein erweckt, dass ChatGPT in anderen Ländern verwendet wird, die nicht blockiert sind.

Hacker erfahren aus diesen Foren, dass sie für eine virtuelle Nummer nur 2 Cent bezahlen müssen und diese Nummer dann nutzen können, um Codes von OpenAI zu erhalten. Diese temporären Telefonnummern können von überall auf der Welt stammen und bei Bedarf können neue Nummern generiert werden.

Böswillige Nutzung von Infostealer und ChatGPTFrühere Untersuchungen haben Beispiele von Cyberkriminellen aufgedeckt, die in diesen Hacking-Foren posten, wie man ChatGPT für illegale Aktivitäten ausnutzt. Dazu gehört die Erstellung eines sehr einfachen Infostealers. Mit zunehmender Verbreitung von Tools der künstlichen Intelligenz werden diese Infostealer immer fortschrittlicher.

Infostealer ist ein Beispiel für die Einführung dieser „einfachen Tools“ und erschien in einem Hacker-Forum in einem Beitrag mit dem Titel „ChatGPT – Die Vorteile von Malware“. Der Autor des Beitrags weist darauf hin, dass Hacker ChatGPT verwenden können, um die Malware neu zu erstellen, indem sie Beschreibungen und Berichte in ein Tool für künstliche Intelligenz einspeisen und dann Python-basierten Diebstahlcode weitergeben, der nach gängigen Dateitypen sucht und diese in zufällige Ordner kopiert und hochlädt sie an einen fest codierten FTP-Server.

Shykevich sagte. „Cyberkriminelle finden ChatGPT attraktiv. In den letzten Wochen haben wir Beweise dafür entdeckt, dass Hacker damit begonnen haben, ChatGPT zum Schreiben von bösartigem Code zu verwenden. ChatGPT hat das Potenzial, einen guten Ausgangspunkt für Hacker zu bieten und den Fortschritt von Cyberangriffen zu beschleunigen. So wie ChatGPT es kann.“ So wie es Entwicklern beim Schreiben von Code hilft, kann es auch für böswillige Zwecke verwendet werden.“

OpenAI sagte, es habe Schritte unternommen, um die Verwendung von ChatGPT einzuschränken, einschließlich der Einschränkung der Arten von Anfragen, die gestellt werden können, aber einige Anfragen könnten möglicherweise verwendet werden vermisst werden. Es gibt auch Hinweise darauf, dass seine Tipps dazu verwendet werden, ChatGPT zu „fälschen“, indem potenziell schädliche Codebeispiele unter dem Deckmantel der Recherche oder als fiktive Beispiele bereitgestellt werden.

ChatGPT und potenzielle FehlinformationenIn der Zwischenzeit arbeitet OpenAI mit dem Center for Security and Emerging Technologies der Georgetown University und dem Stanford Internet Observatory zusammen, um zu untersuchen, wie große Sprachmodelle (wie GPT-3, die Grundlage von ChatGPT) funktionieren könnten Es werden Möglichkeiten genutzt, Falschinformationen zu verbreiten.

Dieses Modell kann verwendet werden, um die Kosten für operative Einflussnahmeoperationen zu senken und sie so unter der Kontrolle neuer Arten von Cyberkriminellen zu halten, während zuvor nur große Akteure Zugriff auf diese Art von Inhalten hatten. Ebenso können Personalvermittler, die die Textproduktion automatisieren können, neue Wettbewerbsvorteile erlangen.

Die Verwendung von ChatGPT durch Hacker kann auch zu unterschiedlichen Verhaltensweisen führen, das Ausmaß von Cyberangriffen erhöhen und die Erstellung personalisierterer und zielgerichteterer Inhalte im Vergleich zur manuellen Erstellung ermöglichen. Letztendlich stellten sie fest, dass Textgenerierungstools im Vergleich zu den meisten von Menschen erstellten Propagandadokumenten in der Lage waren, wirkungsvollere und überzeugendere Nachrichten zu generieren, was darauf hindeutet, dass Hackern möglicherweise nicht die erforderlichen Kenntnisse der Sprache oder Kultur ihrer Ziele fehlen.

Forscher von OpenAI erklären: „Unser grundlegendes Urteil ist, dass Sprachmodelle für Markenverfechter nützlich sind und Online-Influencer-Operationen verändern können. Selbst die fortschrittlichsten Modelle sind verschlüsselt oder über Anwendungsprogrammierschnittstellen (API) zugänglich, Befürworter könnten ebenfalls versucht sein Open-Source-Alternativen übernehmen.“

Das obige ist der detaillierte Inhalt vonWerden KI-Tools zu einem begehrten Gut für Cyberkriminelle? Studie zeigt, dass russische Hacker OpenAI-Beschränkungen umgehen, um auf ChatGPT zuzugreifen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr