Heim >Technologie-Peripheriegeräte >KI >Ist das KI-Spiel nach dem Aufkommen supergroßer Modelle vorbei? Gary Marcus: Der Weg ist schmal

Ist das KI-Spiel nach dem Aufkommen supergroßer Modelle vorbei? Gary Marcus: Der Weg ist schmal

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 11:46:061523Durchsuche

In jüngster Zeit hat die von Google gestern vorgeschlagene Technologie der künstlichen Intelligenz in großen Modellen Durchbrüche erzielt, die erneut Diskussionen über KI-Funktionen ausgelöst haben. Durch das Lernen vor dem Training aus großen Datenmengen verfügt der Algorithmus über beispiellose Fähigkeiten beim Erstellen realistischer Bilder und beim Verstehen von Sprache.

Viele Menschen sind der Meinung, dass wir der allgemeinen künstlichen Intelligenz nahe stehen, aber Gary Marcus, ein bekannter Wissenschaftler und Professor an der New York University, glaubt nicht daran.

Kürzlich widerlegte sein Artikel „The New Science of Alt Intelligence“ die Ansicht von DeepMind Research Director Nando de Freitas vom „Gewinnen in großem Maßstab“.

Das Folgende ist der Originaltext von Gary Marcus:

Seit Jahrzehnten gibt es im Bereich der KI die Annahme, dass künstliche Intelligenz von natürlicher Intelligenz inspiriert werden sollte. John McCarthy schrieb eine bahnbrechende Arbeit darüber, warum KI gesunden Menschenverstand braucht – „Programme mit gesundem Menschenverstand“; Marvin Minsky schrieb das berühmte Buch „Society of Mind“ und versuchte, sich von der Verhaltensökonomie inspirieren zu lassen Nobelpreisträger für Wirtschaftswissenschaften für seine Beiträge, schrieb die berühmten „Modelle des Denkens“, die darauf abzielten zu erklären, „wie neu entwickelte Computersprachen Theorien psychologischer Prozesse ausdrücken, damit Computer vorhergesagtes menschliches Verhalten simulieren können.“ Wissen Sie, einem großen Teil der aktuellen KI-Forscher (zumindest den einflussreicheren) ist das überhaupt egal. Stattdessen konzentrieren sie sich mehr auf das, was ich „Alt Intelligence“ nenne (danke an Naveen Rao für seinen Beitrag zu diesem Begriff).

Alt Intelligence bedeutet nicht, Maschinen zu bauen, die Probleme auf die gleiche Weise lösen können wie menschliche Intelligenz, sondern vielmehr die Nutzung großer Datenmengen, die aus menschlichem Verhalten gewonnen werden, um Intelligenz zu ersetzen. Derzeit liegt der Schwerpunkt von Alt Intelligence auf der Skalierung. Befürworter solcher Systeme argumentieren, dass wir der wahren Intelligenz und sogar dem Bewusstsein umso näher kommen, je größer das System ist.

Das Studium der Alt-Intelligenz selbst ist nichts Neues, wohl aber die damit verbundene Arroganz.

Seit einiger Zeit sehe ich einige Anzeichen dafür, dass die aktuellen Superstars der künstlichen Intelligenz und sogar die meisten Menschen auf dem gesamten Gebiet der künstlichen Intelligenz die menschliche Erkenntnis ablehnen und Linguistik, kognitive Psychologie, Anthropologie und Wissenschaftler ignorieren oder sich sogar darüber lustig machen Bereiche wie Philosophie.

Aber heute Morgen habe ich einen neuen Tweet über Alt Intelligence entdeckt. Nando de Freitas, der Autor des Tweets und Forschungsdirektor bei DeepMind, erklärte, dass es bei der KI „jetzt nur noch um Skalierung geht“. Tatsächlich sind seiner Ansicht nach (vielleicht absichtlich provozierend mit feuriger Rhetorik) die schwierigeren Herausforderungen in der KI bereits gelöst. „Spiel vorbei!“ sagte er.

Im Wesentlichen ist es nichts Falsches daran, Alt Intelligence zu verfolgen.

Im Wesentlichen ist es nichts Falsches daran, Alt Intelligence zu verfolgen.

Alt Intelligence repräsentiert eine Intuition (oder eine Reihe von Intuitionen) darüber, wie man intelligente Systeme baut. Da noch niemand weiß, wie man Systeme baut, die mit der Flexibilität und Intelligenz der menschlichen Intelligenz mithalten können, ist es ein faires Spiel für die Menschen, viele verschiedene Hypothesen darüber zu verfolgen, wie dies erreicht werden kann. Nando de Freitas verteidigt diese Hypothese so unverblümt wie möglich, und ich nenne sie Scaling-Uber-Alles.

Natürlich wird der Name dem nicht ganz gerecht. De Freitas macht deutlich, dass man das Modell nicht einfach vergrößern und Erfolg erwarten kann. Die Leute haben in letzter Zeit viel skaliert und einige große Erfolge erzielt, sind aber auch auf einige Hindernisse gestoßen. Bevor wir näher darauf eingehen, wie De Freitas mit dem Status Quo umgeht, werfen wir einen Blick darauf, wie der Status Quo aussieht.

StatusSysteme wie DALL-E 2, GPT-3, Flamingo und

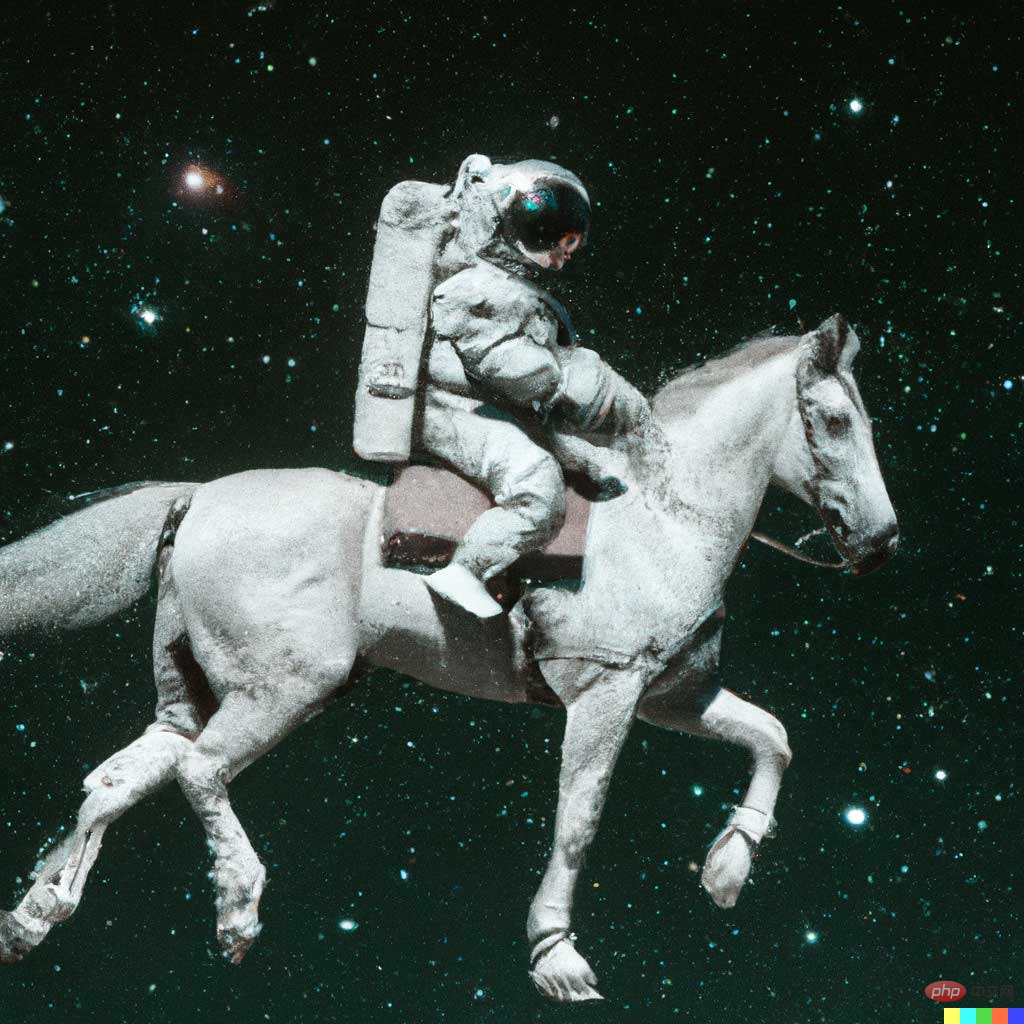

Gato mögen aufregend erscheinen, aber niemand, der diese Modelle sorgfältig studiert hat, würde sie mit menschlicher Intelligenz verwechseln. Zum Beispiel kann DALL-E 2 realistische Kunstwerke basierend auf Textbeschreibungen erstellen, wie zum Beispiel „Ein Astronaut auf einem Pferd“:

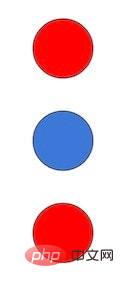

Aber es ist auch anfällig für überraschende Fehler, etwa beim Text ist „ein rotes Quadrat auf einem blauen Quadrat“. Die von DALL-E generierten Ergebnisse sind wie im linken Bild dargestellt, und das rechte Bild ist das vom vorherigen Modell generierte Ergebnis. Die Generierungsergebnisse von DALL-E sind eindeutig schlechter als bei früheren Modellen.

Aber es ist auch anfällig für überraschende Fehler, etwa beim Text ist „ein rotes Quadrat auf einem blauen Quadrat“. Die von DALL-E generierten Ergebnisse sind wie im linken Bild dargestellt, und das rechte Bild ist das vom vorherigen Modell generierte Ergebnis. Die Generierungsergebnisse von DALL-E sind eindeutig schlechter als bei früheren Modellen.

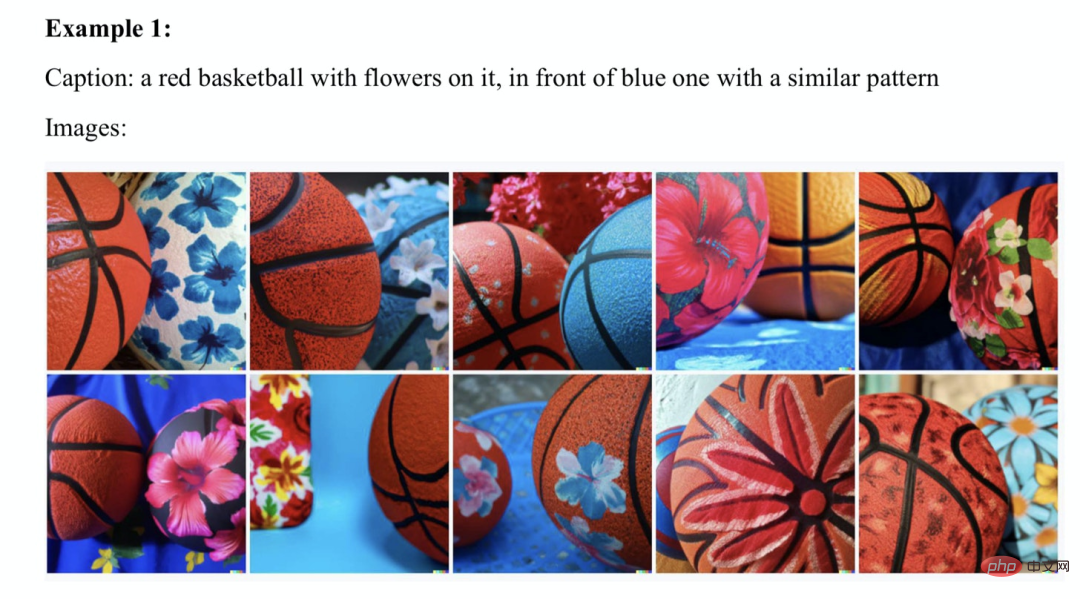

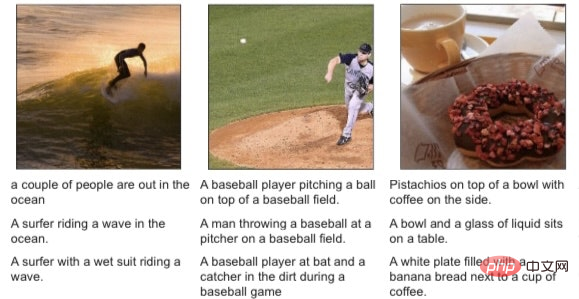

Als Ernest Davis, Scott Aaronson und ich uns mit diesem Thema befassten, fanden wir viele ähnliche Beispiele:

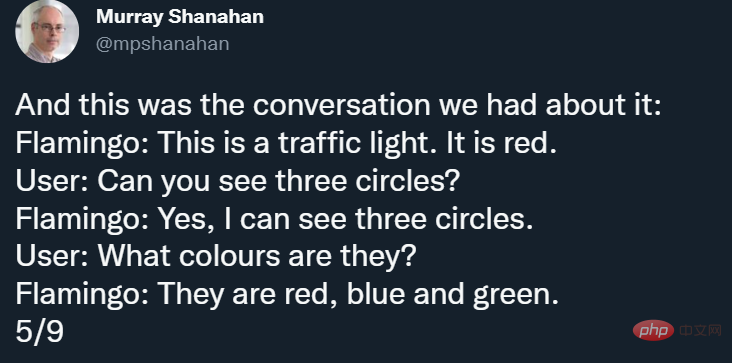

Außerdem hat der scheinbar atemberaubende Flamingo als DeepMind-Senior auch seinen eigenen Fehler Der Forscher Murray Shanahan wies in einem Tweet darauf hin, und Flamingos Hauptautor Jean-Baptiste Alayrac fügte später einige Beispiele hinzu. Shanahan zeigte Flamingo beispielsweise ein Bild wie dieses:

und führte die folgende fehlerhafte Konversation rund um das Bild:

# 🎜🎜## 🎜🎜# scheint „aus dem Nichts gemacht“ zu sein.

scheint „aus dem Nichts gemacht“ zu sein.

Vor einiger Zeit hat DeepMind auch den multimodalen, multitaskingfähigen und vielgestaltigen „Generalisten“-Agenten Gato herausgebracht, aber wenn man sich das Kleingedruckte ansieht, kann man immer noch Unzuverlässigkeit feststellen. Natürlich werden Befürworter des Deep Learning darauf hinweisen, dass Menschen Fehler machen.

Aber jeder ehrliche Mensch wird erkennen, dass diese Fehler darauf hinweisen, dass derzeit etwas defekt ist. Man kann ohne Übertreibung sagen: Wenn meine Kinder regelmäßig solche Fehler machen würden, würde ich alles, was ich tue, aufgeben und sie sofort zum Neurologen bringen.

Seien wir mal ehrlich: Skalierung funktioniert noch nicht, aber möglich ist es zumindest, so zumindest die Theorie von de Freitas – ein klarer Ausdruck des Zeitgeists. Wie bringt de Freitas also Realität und Ehrgeiz in Einklang? Tatsächlich wurden mittlerweile Milliarden von Dollar in Transformer und viele andere verwandte Bereiche investiert, Trainingsdatensätze wurden von Megabyte auf Gigabyte erweitert und Parametergrößen wurden von Millionen auf Billionen erweitert. Allerdings bleiben rätselhafte Irrtümer bestehen, die seit 1988 in zahlreichen Werken ausführlich dokumentiert wurden.

Dies bestätigte erneut, dass er „größer ist“. als alles andere“ und gab ein Ziel an: Sein Ziel ist nicht nur eine bessere KI, sondern auch AGI.

AGI steht für Artificial General Intelligence, die mindestens so gut, so einfallsreich und breit anwendbar ist wie die menschliche Intelligenz. Der enge Sinn von künstlicher Intelligenz, den wir derzeit erkennen, ist eigentlich alternative Intelligenz (Alt-Intelligenz), und ihre ikonischen Erfolge sind Spiele wie Schach (Deep Blue hat nichts mit menschlicher Intelligenz zu tun) und Go (AlphaGo hat wenig mit menschlicher Intelligenz zu tun). . De Freitas hat ehrgeizigere Ziele und man muss ihm zugute halten, dass er diese sehr offen anspricht. Wie erreicht er also sein Ziel? Um es noch einmal zu wiederholen: de Freitas konzentriert sich auf technische Tools zur Aufnahme größerer Datensätze. Andere Ideen, etwa aus der Philosophie oder der Kognitionswissenschaft, mögen wichtig sein, werden aber ausgeschlossen.

Er sagte: „Die Philosophie der Symbole ist nicht notwendig.“ Vielleicht ist dies eine Widerlegung meiner langjährigen Bewegung, symbolische Manipulation in die Kognitionswissenschaft und künstliche Intelligenz zu integrieren. Die Idee tauchte kürzlich im Nautilus-Magazin wieder auf, obwohl sie noch nicht vollständig ausgearbeitet wurde. Hier ist meine kurze Antwort: Was er sagte: „[neuronale] Netze haben kein Problem damit, [Symbole] zu erstellen und sie zu manipulieren“, ignoriert sowohl die Geschichte als auch die Realität. Was er ignoriert, ist die Geschichte, dass sich viele Enthusiasten neuronaler Netze seit Jahrzehnten gegen Symbole gewehrt haben; er ignoriert die Realität, dass symbolische Beschreibungen wie der oben erwähnte „rote Würfel auf einem blauen Würfel“ immer noch den Verstand des SOTA-Modells 2022 verblüffen können.

Am Ende des Tweets drückte De Freitas seine Zustimmung zu Rich Suttons berühmtem Artikel „Bitter Lessons“ aus:

Suttons Argument ist, dass das Einzige, was zu Fortschritten in der KI führen wird, mehr Daten und effizientere Berechnungen sind. Meiner Meinung nach hat Sutton nur halb recht, seine Beschreibung der Vergangenheit ist fast richtig, aber seine induktiven Vorhersagen für die Zukunft sind nicht überzeugend.

Bisher hat Big Data in den meisten Bereichen (sicherlich nicht in allen Bereichen) (vorübergehend) den Sieg über gut konzipiertes Knowledge Engineering verdrängt.

Aber fast alle Software auf der Welt, von Webbrowsern über Tabellenkalkulationen bis hin zu Textverarbeitungsprogrammen, basiert immer noch auf Knowledge Engineering, und Sutton ignoriert dies. Beispielsweise ist die hervorragende Flash Fill-Funktion von Sumit Gulwani ein sehr nützliches System zum einmaligen Lernen, das überhaupt nicht auf der Prämisse von Big Data, sondern auf klassischen Programmiertechniken basiert.

Ich glaube nicht, dass ein reines Deep-Learning-/Big-Data-System damit mithalten kann.

Tatsächlich sind die Hauptprobleme der künstlichen Intelligenz, auf die Kognitionswissenschaftler wie Steve Pinker, Judea Pearl, Jerry Fodor und ich seit Jahrzehnten hinweisen, tatsächlich noch nicht gelöst. Ja, Maschinen können sehr gut Spiele spielen, und Deep Learning hat in Bereichen wie der Spracherkennung große Fortschritte gemacht. Aber keine künstliche Intelligenz verfügt derzeit über genügend Verständnis, um Texte zu erkennen und ein Modell zu erstellen, das normal sprechen und Aufgaben erledigen kann, noch kann sie wie die Computer in den „Star Trek“-Filmen argumentieren und eine zusammenhängende Reaktion hervorrufen.

Wir befinden uns noch im Anfangsstadium der künstlichen Intelligenz.

Bei einigen Problemen mit bestimmten Strategien erfolgreich zu sein, garantiert nicht, dass wir alle Probleme auf ähnliche Weise lösen. Es wäre einfach dumm, dies nicht zu erkennen, insbesondere wenn einige der Fehlermodi (Unzuverlässigkeit, seltsame Fehler, kombinatorische Fehler und Unverständnis) unverändert geblieben sind, seit Fodor und Pinker sie 1988 aufgezeigt haben. Fazit Bringen Sie uns zur Verallgemeinerung auf menschlicher Ebene. Lasst uns einen Bereich fördern, der so aufgeschlossen ist, dass Menschen ihre eigene Arbeit in viele Richtungen entwickeln können, ohne Ideen, die zufällig noch nicht vollständig entwickelt sind, vorzeitig zu verwerfen. Schließlich ist Alt Intelligence möglicherweise nicht der beste Weg zur (allgemeinen) künstlichen Intelligenz.

Wie bereits erwähnt, würde ich mir Gato gerne als „alternative Intelligenz“ vorstellen – eine interessante Erkundung alternativer Wege zum Aufbau von Intelligenz, aber wir müssen es ins rechte Licht rücken: Es wird nicht wie ein Gehirn funktionieren, es wird nicht wie ein Kind funktionieren. Auf diese Weise gelernt, versteht es die Sprache nicht, steht im Widerspruch zu menschlichen Werten und kann nicht darauf vertrauen, dass es wichtige Aufgaben erledigt.

Es ist vielleicht besser als alles andere, was wir derzeit haben, aber es funktioniert immer noch nicht wirklich, und selbst nachdem wir viel investiert haben, ist es für uns an der Zeit, eine Pause einzulegen.

Das obige ist der detaillierte Inhalt vonIst das KI-Spiel nach dem Aufkommen supergroßer Modelle vorbei? Gary Marcus: Der Weg ist schmal. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr