Heim >Technologie-Peripheriegeräte >KI >Ein Artikel, der die Multisensorfusion für autonomes Fahren kurz analysiert

Ein Artikel, der die Multisensorfusion für autonomes Fahren kurz analysiert

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 11:19:081167Durchsuche

Was haben intelligente vernetzte Autos mit autonomem Fahren zu tun?

Der Kern des autonomen Fahrens liegt im Auto. Was ist also das intelligente Netzwerkverbindungssystem? Der Träger der intelligenten Netzwerkverbindung ist auch das Auto, aber der Kern ist das Netzwerk, das verbunden werden muss. Das eine ist ein Netzwerk aus Sensoren und intelligenten Steuerungssystemen im Auto, das andere ist ein Netzwerk, das alle Autos verbindet und gemeinsam nutzt. Bei der Netzwerkverbindung geht es darum, ein Auto in ein großes Netzwerk einzubinden, um wichtige Informationen wie Standort, Route, Geschwindigkeit und andere Informationen auszutauschen. Das Entwicklungsziel des intelligenten Netzwerksystems besteht darin, die Sicherheit und den Komfort des Autos durch das Design und die Optimierung der internen Sensoren und Steuerungssysteme des Autos zu verbessern und das Auto menschlicher zu machen. Das ultimative Ziel ist natürlich, fahrerlos zu werden Fahren.

Die drei Kernhilfssysteme autonomer Fahrzeuge: Umgebungswahrnehmungssystem, Entscheidungs- und Planungssystem sowie Steuerungs- und Ausführungssystem, die auch die intelligenten vernetzten Fahrzeuge sind Sie müssen selbst drei wichtige technische Probleme lösen.

Welche Rolle spielt das Umweltbewusstseinssystem im intelligenten Netzwerkverbindungssystem?

Was ist Umweltsensorik und was umfasst sie hauptsächlich?

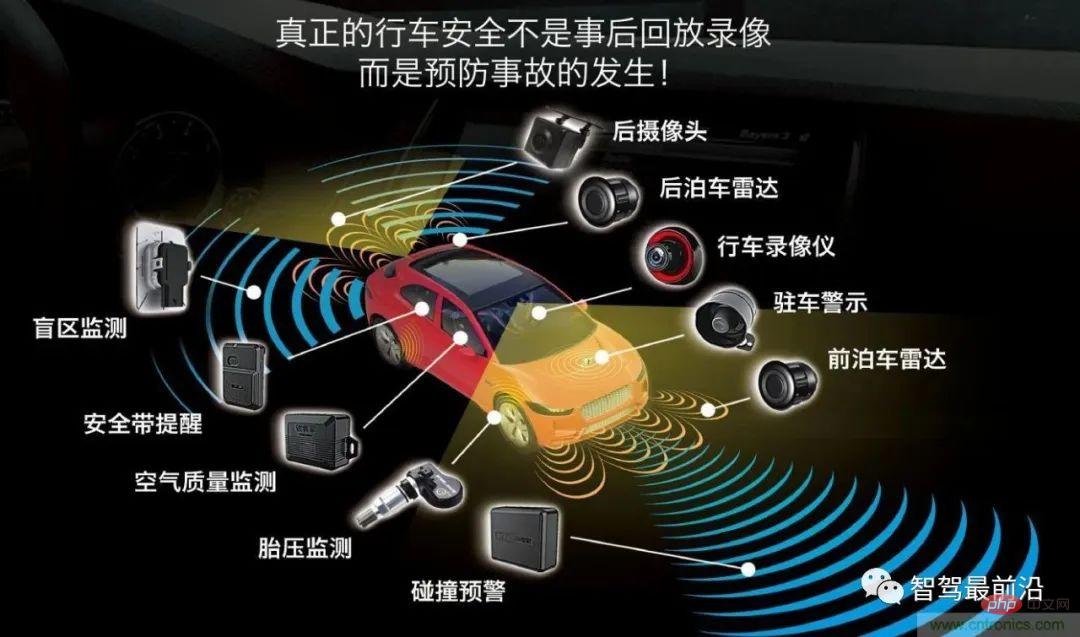

Die Umgebungswahrnehmung umfasst hauptsächlich drei Aspekte: Sensorik, Wahrnehmung und Positionierung. Zu den Sensoren gehören Kameras, Millimeterwellenradar, Lidar und Ultraschallwellen, die am Fahrzeug angebracht sind, um Daten zu sammeln, Farben zu identifizieren und Entfernungen zu messen.

Wenn ein intelligentes Auto die vom Sensor erhaltenen Daten nutzen möchte, um intelligentes Fahren zu erreichen, werden die durch den Sensor erhaltenen Daten verwendet Der Sensor muss eine (Wahrnehmungs-)Algorithmusverarbeitung durchlaufen, die in Datenergebnisse zusammengestellt wird, um den Austausch von Informationen über Fahrzeuge, Straßen, Personen usw. zu realisieren, damit Fahrzeuge automatisch analysieren können, ob das Fahrzeug sicher oder gefährlich fährt, sodass Fahrzeuge kann intelligentes Fahren nach den Wünschen der Menschen realisieren und letztendlich die Entscheidungsfindung und die Ziele des autonomen Fahrens ersetzen.

Dann wird es hier ein zentrales technisches Problem geben. Wie können die von mehreren Sensoren gescannten Daten zu vollständigen Objektbilddaten werden?

Multisensor-Fusionstechnologie

Die Hauptfunktion des Die Kamera erkennt die Objektfarbe, wird jedoch durch Regenwetter beeinträchtigt. Millimeterwellenradar kann die Nachteile von Kameras ausgleichen, die durch Regenwetter beeinträchtigt werden, und entfernte Hindernisse wie Fußgänger, Straßensperren usw. erkennen, kann dies jedoch nicht Identifizieren Sie die spezifische Form von Hindernissen. Laserradar kann den Mangel des Millimeterwellenradars ausgleichen, das die spezifische Form von Hindernissen nicht identifizieren kann . Um die von verschiedenen Sensoren gesammelten externen Daten zu fusionieren und dem Controller eine Entscheidungsgrundlage zu geben, ist es notwendig, den Multisensor-Fusionsalgorithmus zu einer Panoramawahrnehmung zu verarbeiten.

Was ist Multisensorfusion (Fusionsalgorithmusverarbeitung) und was sind die wichtigsten Fusionsalgorithmen?

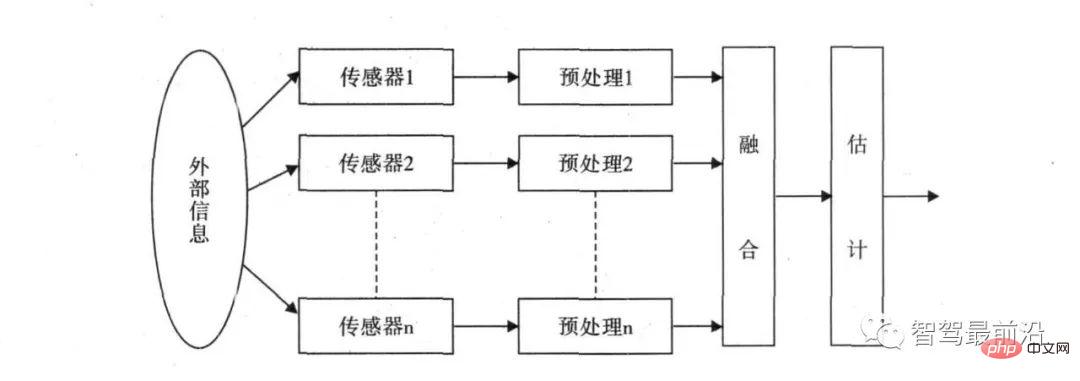

Das Grundprinzip der Multi-Sensor-Fusion ähnelt dem Prozess der umfassenden Informationsverarbeitung durch das menschliche Gehirn. Es nutzt verschiedene Sensoren, um mehrstufige und... Multi-Space-Informationsergänzung und optimierte Kombinationsverarbeitung. Das Ergebnis ist eine konsistente Interpretation der beobachteten Umgebung. In diesem Prozess müssen Daten aus mehreren Quellen für eine angemessene Kontrolle und Nutzung vollständig genutzt werden. Das ultimative Ziel der Informationsfusion besteht darin, durch Kombinationen von Informationen auf mehreren Ebenen und mit mehreren Aspekten auf der Grundlage der erhaltenen getrennten Beobachtungsinformationen nützlichere Informationen abzuleiten jeden Sensor. Dabei wird nicht nur der kooperative Betrieb mehrerer Sensoren genutzt, sondern auch Daten aus anderen Informationsquellen umfassend verarbeitet, um die Intelligenz des gesamten Sensorsystems zu verbessern.

Das Konzept der Multisensor-Datenfusion wurde erstmals im militärischen Bereich eingesetzt Bei der Entwicklung des autonomen Fahrens werden verschiedene Radargeräte zur Fahrzeugzielerkennung eingesetzt. Da verschiedene Sensoren Probleme mit der Datengenauigkeit haben, stellt sich die Frage, wie die endgültigen zusammengeführten Daten ermittelt werden können. Beispielsweise meldet das Lidar, dass der Abstand zum vorausfahrenden Fahrzeug 5 m beträgt, das Millimeterwellenradar meldet, dass der Abstand zum vorausfahrenden Fahrzeug 5,5 m beträgt, und die Kamera ermittelt, dass der Abstand zum vorausfahrenden Fahrzeug 4 m beträgt. Wie soll der Zentralprozessor das endgültige Urteil fällen? Dann ist eine Reihe von Multi-Data-Fusion-Algorithmen erforderlich, um dieses Problem zu lösen.

Häufig verwendete Methoden der Multisensorfusion werden in zwei Kategorien unterteilt: zufällige und künstliche Intelligenz. Die KI-Kategorie umfasst hauptsächlich Fuzzy-Logik-Methoden und künstliche neuronale Netzwerkmethoden. Zu den stochastischen Methoden gehören hauptsächlich Algorithmen wie Bayes-Filterung und Kalman-Filterung. Derzeit werden bei der Automobilfusionserkennung hauptsächlich Zufallsfusionsalgorithmen verwendet.

Der Fusionswahrnehmungsalgorithmus autonomer Fahrzeuge verwendet hauptsächlich den Kalman-Filteralgorithmus, der den Systemzustand mithilfe von Systemeingangs- und -ausgangsbeobachtungsdaten optimal abschätzt. Dies ist derzeit der beste Algorithmus zur Lösung der meisten Probleme effiziente Methode.

Mehrere Sensoren müssen von Fusionsalgorithmen verarbeitet werden, um das Problem der Multisensorfusion zu lösen. Die meisten Jobanforderungen in der Kategorie Fusionssensorik erfordern die Fähigkeit, mehrere zu beherrschen Das Funktionsprinzip und die Dateneigenschaften des Signals sowie die Fähigkeit, Fusionsalgorithmen für die Softwareentwicklung und Sensorkalibrierungsalgorithmen sowie Punktwolkendatenverarbeitung, Deep-Learning-Erkennungsalgorithmen usw. zu beherrschen.

Der dritte Teil der Umgebungswahrnehmung – Positionierung (Slam)

Slam wird als gleichzeitige Positionierung und Zuordnung bezeichnet. Dabei wird davon ausgegangen, dass die Szene statisch ist und die Bewegung der Kamera verwendet wird, um die Bildsequenz zu erhalten und die 3 zu erhalten -D-Szene. Strukturelles Design ist eine wichtige Aufgabe der Computer Vision. Die von der Kamera erhaltenen Daten werden von einem Algorithmus verarbeitet, der visuell ist.

Neben dem visuellen Slam umfassen die Methoden zur Positionierung des Umgebungsbewusstseins auch Lidar-Slam, GPS/IMU und hochpräzise Karten. Die von diesen Sensoren gewonnenen Daten müssen von Algorithmen verarbeitet werden, um Datenergebnisse zu erzeugen, die eine Standortinformationsgrundlage für autonome Fahrentscheidungen liefern. Wenn Sie daher im Bereich der Umweltwahrnehmung arbeiten möchten, können Sie nicht nur die Position des Fusion-Sensing-Algorithmus, sondern auch das Slam-Feld auswählen.

Das obige ist der detaillierte Inhalt vonEin Artikel, der die Multisensorfusion für autonomes Fahren kurz analysiert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr