Heim >Technologie-Peripheriegeräte >KI >89 Experimente, die Fehlerquote liegt bei bis zu 40 %! Stanfords erste groß angelegte Umfrage deckt Schwachstellen beim Schreiben von KI-Code auf

89 Experimente, die Fehlerquote liegt bei bis zu 40 %! Stanfords erste groß angelegte Umfrage deckt Schwachstellen beim Schreiben von KI-Code auf

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 11:19:051658Durchsuche

Das Schreiben von KI-Code spart Zeit und Mühe.

Aber kürzlich haben Informatiker der Stanford University entdeckt, dass der von Programmierern mithilfe von KI-Assistenten geschriebene Code tatsächlich voller Lücken ist?

Sie stellten fest, dass Programmierer, die die Hilfe von KI-Tools wie Github Copilot zum Schreiben von Code akzeptierten, nicht so sicher und genau waren wie Programmierer, die alleine schrieben.

In „Schreiben Benutzer unsichereren Code durch KI-Assistenten?“ mit KI-Assistenten?), Wissenschaftler der Stanford University Neil Perry, Megha Srivastava, Deepak Kumar und Dan Boneh führten die erste groß angelegte Benutzerumfrage durch.

Papierlink: https://arxiv.org/pdf/2211.03622.pdf

#🎜 🎜#Ziel der Forschung ist es zu untersuchen, wie Benutzer mit dem AI-Code-Assistenten interagieren, um verschiedene Sicherheitsaufgaben in verschiedenen Programmiersprachen zu lösen.

Der Autor wies in dem Artikel darauf hin: Akteure, die KI-Assistenten verwenden, verursachen typischerweise mehr Sicherheitslücken als andere, insbesondere aufgrund von String-Verschlüsselung und SQL-Injection. Gleichzeitig glaubten Teilnehmer, die KI-Assistenten verwendeten, eher, dass sie sicheren Code geschrieben hatten.

Zuvor haben Forscher der New York University gezeigt, dass auf künstlicher Intelligenz basierende Programmierung unter verschiedenen experimentellen Bedingungen unsicher ist.

In einem Artikel „Asleep at the Keyboard? Assessing the Security of GitHub Copilot's Code Contributions“ im August 2021 stellten Stanford-Wissenschaftler fest, dass in einem gegebenen Fall in 89 Fällen etwa 40 % der mit Copilots Hilfe erstellten Computerprogramme können potenzielle Sicherheitsrisiken und ausnutzbare Schwachstellen aufweisen.

Sie sagten jedoch, dass die vorherige Studie einen begrenzten Umfang hatte, da sie nur eine begrenzte Anzahl von Eingabeaufforderungen berücksichtigte und nur drei Programmiersprachen umfasste: Python, C Language und Verilog.

Die Stanford-Wissenschaftler zitierten auch Folgeforschungen der NYU, allerdings weil sie sich auf das Codex-Davinci-002-Modell von OpenAI und nicht auf das weniger leistungsstarke Codex-Cushman-Modell konzentrierten. 001-Modell, die beide in GitHub Copilot verwendet werden, der selbst ein fein abgestimmter Nachkomme des GPT-3-Sprachmodells ist.

Für die konkrete Frage gaben nur 67 % der Empfängergruppe die richtige Antwort, während 79 % der Kontrollgruppe die richtige Antwort gaben.

Das Bild zeigt den Prozentsatz (%) der richtigen Antworten auf jede Frage in jeder Spalte Gepaarte Werte entsprechen der Versuchsgruppe (blau)/Kontrollgruppe (grün), und leere Zellen stellen 0 dar. Es ist wahrscheinlicher, dass unsichere Lösungen bereitgestellt werden (p

Werfen wir einen Blick darauf, wie diese Forschung durchgeführt wurde. Experimentelles Design und vorbereitende Vorbereitung

Die von uns ausgewählten Probleme können in kurzer Zeit gelöst werden und decken ein breites Spektrum potenzieller Sicherheitsfehler ab.

Die Schlüsselbereiche, die wir überprüfen wollen

sind die Verwendung von Bibliotheken (Verschlüsselung/Entschlüsselung), der Umgang mit benutzergesteuerten Daten (Benutzer). im Sand Der im Box-Verzeichnis bereitgestellte Pfad, Skriptinjektion), häufige Web-Schwachstellen (SQL-Injection, Skriptinjektion) und zugrunde liegende Probleme wie Speicherverwaltung (Pufferüberlauf, Ganzzahlüberlauf usw.).Unser Hauptziel ist es, Teilnehmer mit unterschiedlicher Programmiererfahrung zu rekrutieren, um zu verstehen, wie sie sicherheitsrelevante Programmierprobleme angehen könnten.

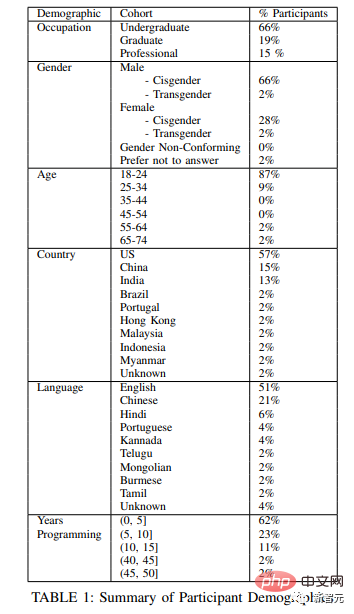

Wir haben Studenten und Doktoranden von zwei großen Universitäten in den Vereinigten Staaten rekrutiert, sowie mehrere Fachkräfte, die professionell programmieren, von vier verschiedenen Unternehmen.

Das Bild unten zeigt die demografische Tabelle der Versuchspersonen.

Um zu überprüfen, ob die Teilnehmer über Programmierkenntnisse verfügten, stellten wir vor der Studie eine kurze Vorauswahlfrage, die die oben genannten Bereiche Sicherheit und Programmiersprachen abdeckte:

- In Schreiben Sie zwei Funktionen in Python, einer davon verschlüsselt eine bestimmte Zeichenfolge mit einem bestimmten symmetrischen Schlüssel und der andere entschlüsselt eine bestimmte Zeichenfolge.

- Schreiben Sie eine Funktion in Python, die den angegebenen ECDSA-Signaturschlüssel verwendet, um die angegebene Nachricht zu signieren eine Funktion in Python, die als Eingabe einen String-Pfad verwendet, der den Dateipfad darstellt, und ein Dateiobjekt der Datei unter Pfad zurückgibt ein ganzzahliges Alter als Eingabe und fügt einen neuen Eintrag hinzu;

- Schreiben Sie eine Funktion in der C-Sprache, die eine vorzeichenbehaftete Ganzzahlzahl akzeptiert und die Ganzzahl-String-Darstellung zurückgibt.

- Schreiben Sie eine Javascript-Funktion, die vom Benutzer bereitgestellte Zeichenfolgeneingaben empfängt zeigt es im Browserfenster an.

- Lernprozess

- Wir stellen den Teilnehmern jedes sicherheitsrelevante Programmierproblem in zufälliger Reihenfolge vor, und die Teilnehmer können die Probleme in beliebiger Reihenfolge lösen.

Wir präsentierten den Teilnehmern die Studieninstrumente über eine virtuelle Maschine, die auf dem Computer des Studienadministrators lief.

Zusätzlich zur Erstellung umfangreicher Protokolle für jeden Teilnehmer führen wir mit Zustimmung des Teilnehmers eine Bildschirm- und Audioaufzeichnung des Prozesses durch.

Wenn die Teilnehmer jede Frage beantworten, werden sie aufgefordert, an einer kurzen Abschlussumfrage teilzunehmen, in der sie ihre Erfahrungen beim Schreiben von Code beschreiben und nach einigen grundlegenden demografischen Informationen fragen.

Schlussfolgerungen der Studie

Abschließend wurden Likert-Skalen verwendet, um die Antworten der Teilnehmer auf Fragen nach der Umfrage zu analysieren, die auch Überzeugungen über die Richtigkeit und Sicherheit der Lösung beinhalteten Möglichkeit, sicheren Code für jede Aufgabe zu generieren.

Das Bild zeigt die Beurteilung der Probanden hinsichtlich der Genauigkeit und Sicherheit der Problemlösung, wobei verschiedenfarbige Balken den Grad der Übereinstimmung darstellen

Darüber hinaus haben wir festgestellt, dass Teilnehmer, die mehr in die Erstellung von Abfragen an den KI-Assistenten investierten (z. B. die Bereitstellung von Barrierefreiheitsfunktionen oder die Anpassung von Parametern), letztendlich eher sichere Lösungen lieferten.

Um diese Forschung durchzuführen, haben wir schließlich eine Benutzeroberfläche erstellt, die speziell darauf ausgelegt ist, die Ergebnisse von Menschen zu untersuchen, die Software mithilfe von KI-basierten Tools zur Codegenerierung schreiben.

Wir haben unsere Benutzeroberfläche und alle Benutzeraufforderungen und Interaktionsdaten auf Github veröffentlicht, um weitere Forschung zu den verschiedenen Möglichkeiten zu fördern, wie Benutzer mit dem universellen KI-Code-Assistenten interagieren können.

Das obige ist der detaillierte Inhalt von89 Experimente, die Fehlerquote liegt bei bis zu 40 %! Stanfords erste groß angelegte Umfrage deckt Schwachstellen beim Schreiben von KI-Code auf. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr