Heim >Technologie-Peripheriegeräte >KI >Benutze Magie, um Magie zu besiegen! Eine Go-KI, die es mit den besten menschlichen Spielern aufnehmen konnte, verlor gegen ihre Mitbewerber

Benutze Magie, um Magie zu besiegen! Eine Go-KI, die es mit den besten menschlichen Spielern aufnehmen konnte, verlor gegen ihre Mitbewerber

- 王林nach vorne

- 2023-04-12 08:40:031519Durchsuche

In den letzten Jahren hat das verstärkende Lernen im Selbstspiel in einer Reihe von Spielen wie Go und Schach übermenschliche Leistungen erbracht. Darüber hinaus konvergiert auch die idealisierte Version des Selbstspiels einem Nash-Gleichgewicht. Das Nash-Gleichgewicht ist in der Spieltheorie sehr bekannt. Diese Theorie wurde von John Nash, dem Begründer der Spieltheorie und Nobelpreisträger, vorgeschlagen. Das heißt, in einem Spielprozess wird eine Partei unabhängig von der Strategiewahl der anderen Partei eine bestimmte Strategie wählen . Strategie, die Strategie wird als dominante Strategie bezeichnet. Wenn ein Spieler die optimale Strategie wählt, wenn die Strategien aller anderen Spieler bestimmt sind, dann wird diese Kombination als Nash-Gleichgewicht definiert.

Frühere Untersuchungen haben gezeigt, dass die scheinbar effektiven kontinuierlichen Kontrollstrategien im Selbstspiel auch von gegnerischen Strategien ausgenutzt werden können, was darauf hindeutet, dass Selbstspiel möglicherweise nicht so mächtig ist wie bisher angenommen. Dies führt zu der Frage: Ist die Konfrontationsstrategie eine Möglichkeit, das Selbstspiel zu überwinden, oder reicht die Selbstspielstrategie selbst nicht aus?

Um diese Frage zu beantworten, haben Forscher vom MIT, der UC Berkeley und anderen Institutionen einige Untersuchungen durchgeführt. Sie haben sich für ein Gebiet entschieden, das sich gut für Selbstspiele eignet, nämlich Go. Konkret führten sie einen Angriff auf KataGo durch, das stärkste öffentlich verfügbare Go-KI-System. Für ein Festnetz (Einfrieren von KataGo) trainierten sie eine durchgängige gegnerische Strategie. Beim Training von KataGo erhielten sie eine gegnerische Strategie und nutzten diese Strategie, um KataGo anzugreifen erreichte eine Gewinnquote von 99 % gegen KataGo, was mit den 100 besten europäischen Go-Spielern vergleichbar ist. Und als KataGo genügend Suchanfragen nutzte, um übermenschliche Level zu erreichen, erreichte die Gewinnrate 50 %. Entscheidend ist, dass der Angreifer (in diesem Artikel wird auf die in dieser Studie erlernte Strategie Bezug genommen) nicht durch das Erlernen einer allgemeinen Go-Strategie gewinnen kann.

Hier müssen wir über KataGo sprechen. Wie es in diesem Artikel heißt, war KataGo zum Zeitpunkt des Schreibens dieses Artikels immer noch das leistungsstärkste öffentliche Go-KI-System. Mit der Unterstützung der Suche kann man sagen, dass KataGo sehr mächtig ist und ELF OpenGo und Leela Zero besiegt, die selbst übermenschlich sind. Jetzt hat der Angreifer in dieser Studie KataGo besiegt, das als sehr mächtig gilt.

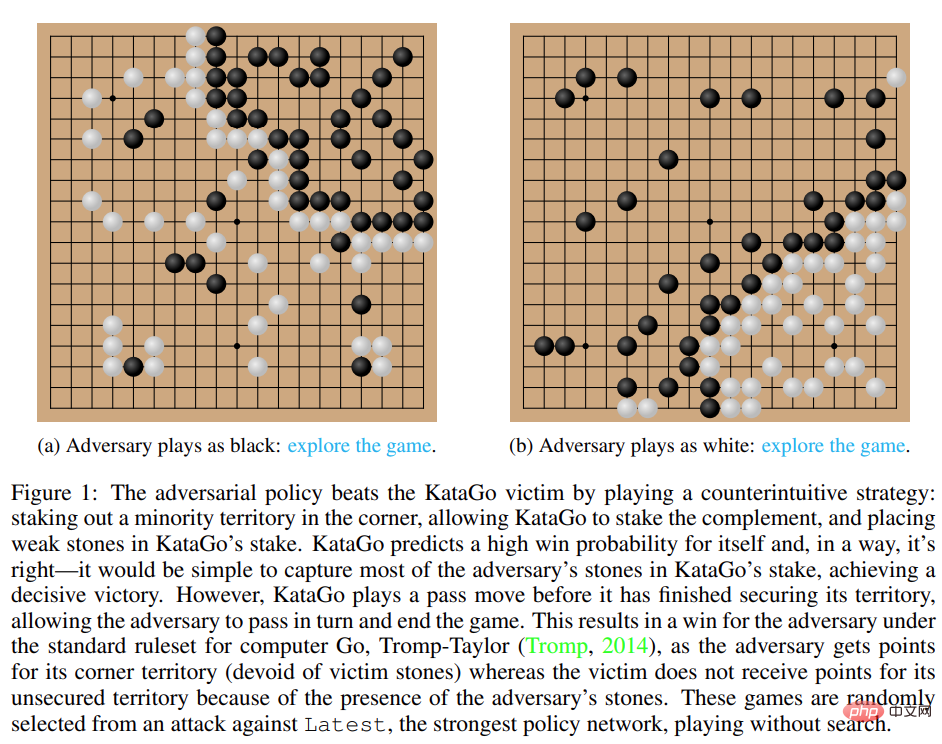

Abbildung 1: Gegnerische Strategie besiegt KataGo-Opfer. 🔜 katago?row=0#no_search-board

Interessanterweise kann die in dieser Studie vorgeschlagene gegnerische Strategie menschliche Spieler nicht besiegen, und selbst Amateurspieler können das vorgeschlagene Modell deutlich übertreffen.

Interessanterweise kann die in dieser Studie vorgeschlagene gegnerische Strategie menschliche Spieler nicht besiegen, und selbst Amateurspieler können das vorgeschlagene Modell deutlich übertreffen.

- AngriffsmethodeFrühere Methoden wie KataGo und AlphaZero trainieren den Agenten normalerweise, Spiele selbst zu spielen, und der Spielgegner ist der Agent selbst. In dieser Forschung des MIT, der UC Berkeley und anderer Institutionen wird ein Spiel zwischen dem Angreifer (Gegner) und den Agenten des festen Opfers (Opfer) gespielt und der Angreifer auf diese Weise trainiert. Die Forschung hofft, Angreifer darin zu schulen, Spielinteraktionen mit Opferagenten auszunutzen, anstatt nur Spielgegner zu imitieren. Dieser Vorgang wird „Victim-Play“ genannt.

- Beim herkömmlichen Selbstspiel modelliert der Agent die Aktionen des Gegners, indem er Stichproben aus seinem eigenen Richtliniennetzwerk macht. Diese Methode eignet sich tatsächlich für das Selbstspiel. Beim Opferspiel ist es jedoch der falsche Ansatz, das Opfer anhand des Richtliniennetzwerks des Angreifers zu modellieren. Um dieses Problem zu lösen, schlägt diese Studie zwei Arten von kontradiktorischen MCTS (A-MCTS) vor, darunter:

- A-MCTS-S: In A-MCTS-S legt der Forscher den Suchprozess des Angreifers wie folgt fest: Wenn das Opfer die Schachfigur bewegt, wird eine Probe aus dem Richtliniennetzwerk des Opfers entnommen Schachfigur Wenn , Probe aus dem Richtliniennetzwerk des Angreifers.

- A-MCTS-R: Da A-MCTS-S die Fähigkeiten des Opfers unterschätzt, schlägt diese Studie A-MCTS-R vor, und zwar auf jedem Opferknoten im A-MCTS-R-Baum. Das Opfer führt MCTS aus. Diese Änderung erhöht jedoch die rechnerische Komplexität des Trainings und der Schlussfolgerung für den Angreifer.

Während des Trainingsprozesses trainierte die Studie gegnerische Strategien gegen Spiele, die gegen eingefrorene KataGo-Opfer gespielt wurden. Ohne Suche kann der Angreifer eine Siegesquote von >99 % gegen KataGo-Opfer erzielen, was mit der der 100 besten europäischen Go-Spieler vergleichbar ist. Darüber hinaus erzielte der trainierte Angreifer in 64 gespielten Runden gegen den Agenten des Opfers eine Siegesquote von über 80 %, was nach Einschätzung der Forscher mit der der besten menschlichen Go-Spieler vergleichbar war.

Es ist erwähnenswert, dass diese Spiele zeigen, dass die in dieser Studie vorgeschlagene gegnerische Strategie kein reines Glücksspiel ist, sondern das Spiel vorzeitig beendet, indem KataGo dazu gebracht wird, einen Zug in einer für den Angreifer günstigen Position zu platzieren. Tatsächlich war der Angreifer zwar in der Lage, Spielstrategien auszunutzen, die mit denen der besten menschlichen Go-Spieler vergleichbar waren, von menschlichen Amateuren konnte er jedoch leicht besiegt werden.

Um die Fähigkeit des Angreifers zu testen, gegen Menschen zu spielen, ermöglichte diese Studie Tony Tong Wang, dem Erstautor der Arbeit, tatsächlich gegen das Angreifermodell zu spielen. Wang hatte das Go-Spiel vor diesem Forschungsprojekt noch nie gelernt, aber er schlug das Angreifermodell dennoch mit großem Abstand. Dies zeigt, dass die in dieser Studie vorgeschlagene gegnerische Strategie zwar ein KI-Modell besiegen kann, das menschliche Spitzenspieler besiegen kann, menschliche Spieler jedoch nicht. Dies kann darauf hindeuten, dass einige AI Go-Modelle Fehler aufweisen.

Bewertungsergebnisse

Angriffsopfer-Richtliniennetzwerk

Zunächst bewerteten die Forscher die Leistung ihrer eigenen Angriffsmethoden auf KataGo (Wu, 2019) und stellten fest, dass der A-MCTS-S-Algorithmus geeignet war Search-free Latest (KataGos neuestes Netzwerk) erreicht eine Gewinnrate von über 99 %.

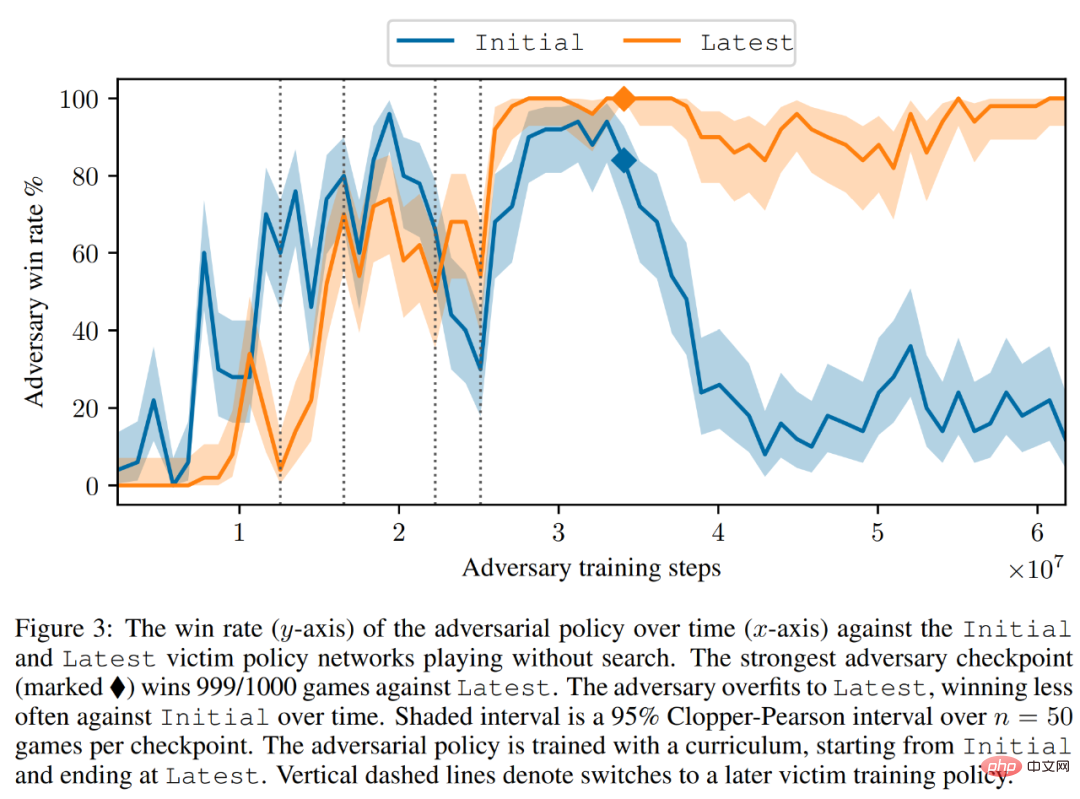

Wie in Abbildung 3 unten dargestellt, bewertete der Forscher die Leistung der Selbstkonfrontationsstrategie in den Netzwerken „Initial“ und „Laute Policy“. Sie fanden heraus, dass der Selbstangreifer während des größten Teils des Trainings eine hohe Siegesquote (über 90 %) gegen beide Opfer erzielte. Mit der Zeit übersteigt der Angreifer jedoch „Latest“ und die Gewinnquote gegenüber „Initial“ sinkt auf etwa 20 %.

Die Forscher bewerteten auch die besten Gegenstrategie-Checkpoints mit Latest und erzielten eine Erfolgsquote von über 99 %. Darüber hinaus wird eine so hohe Gewinnrate erreicht, während die gegnerische Strategie nur für 3,4 × 10^7 Zeitschritte trainiert wird, was 0,3 % der Zeitschritte des Opfers entspricht.

Mit der Suche zu Opfern migrieren

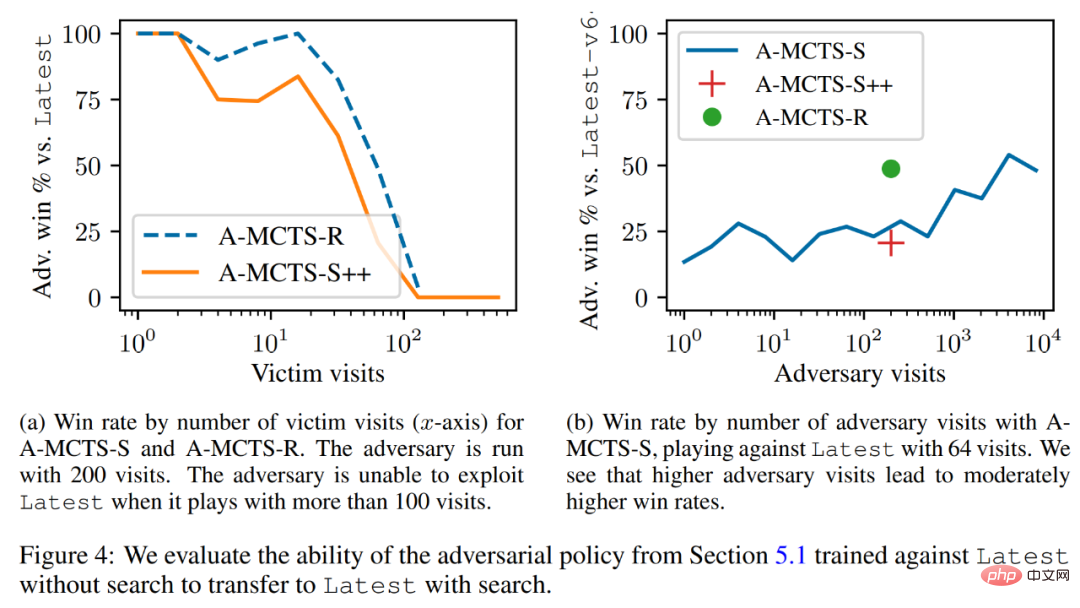

Die Forscher haben die gegnerische Strategie erfolgreich auf den niedrigen Suchmechanismus migriert und die im vorherigen Abschnitt trainierte gegnerische Strategie anhand der neuesten Fähigkeit der Suche bewertet. Wie in Abbildung 4a unten dargestellt, stellten sie fest, dass die Siegquote von A-MCTS-S gegen Opfer nach 32 Opferrunden auf 80 % sank. Aber hier sucht das Opfer nicht während des Trainings und der Schlussfolgerung.

Darüber hinaus testeten die Forscher auch A-MCTS-R und stellten fest, dass es eine bessere Leistung erzielte und bei 32 Opferrunden eine Siegesquote von mehr als 99 % gegenüber Latest erreichte, bei 128 Runden fiel die Siegesquote jedoch unter 10 %.

In Abbildung 4b zeigen die Forscher, dass A-MCTS-S eine maximale Gewinnquote von 54 % gegenüber Latest erreicht, wenn der Angreifer 4096 Runden erreicht. Dies ist der Leistung von A-MCTS-R bei 200 Epochen sehr ähnlich, das eine Gewinnrate von 49 % erreichte.

Andere Bewertungen

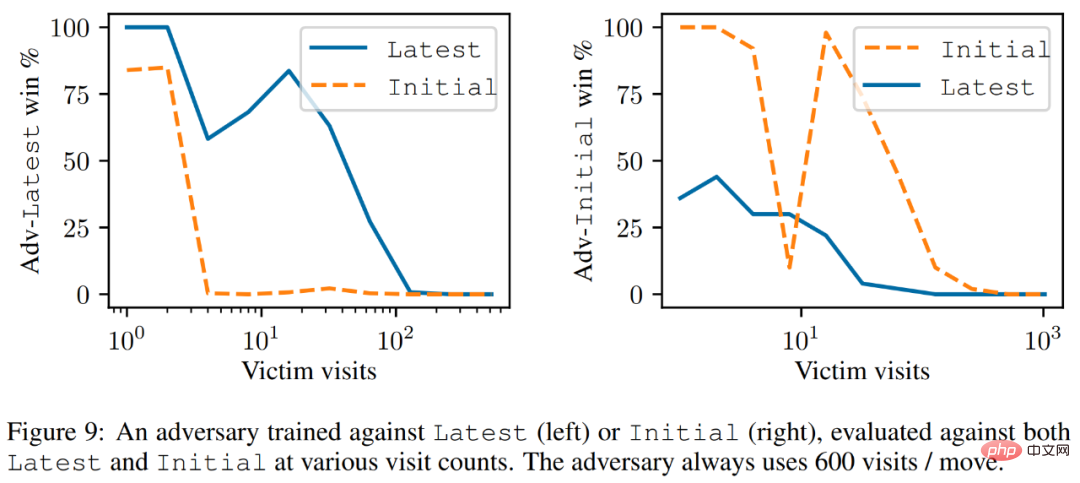

Wie in Abbildung 9 unten dargestellt, stellten die Forscher fest, dass Latest zwar ein leistungsfähigerer Agent ist, der gegen Latest trainierte Angreifer jedoch gegen Latest eine bessere Leistung erbrachte als Initial.

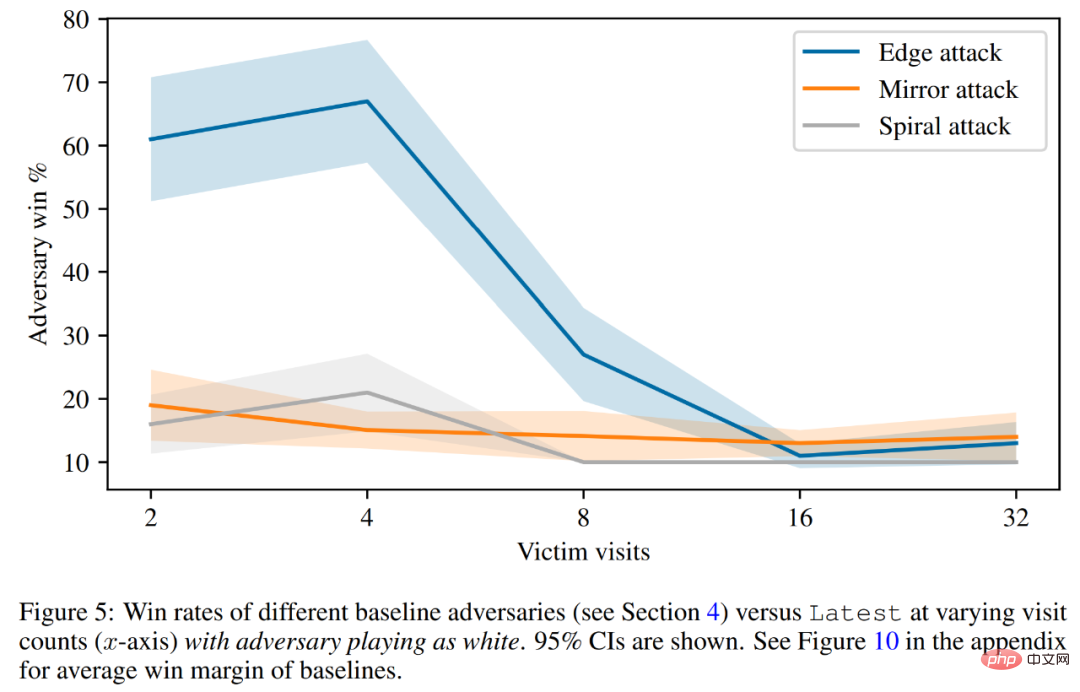

Abschließend diskutierte der Forscher das Angriffsprinzip, einschließlich der Vorhersage des Opferwerts und der hartcodierten Verteidigungsbewertung. Wie in Abbildung 5 unten dargestellt, schneiden alle Basisangriffe deutlich schlechter ab als die gegnerischen Strategien, auf die sie trainiert wurden.

Weitere technische Details finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonBenutze Magie, um Magie zu besiegen! Eine Go-KI, die es mit den besten menschlichen Spielern aufnehmen konnte, verlor gegen ihre Mitbewerber. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr