Heim >Technologie-Peripheriegeräte >KI >Metas groß angelegte Studie zur Sprachübersetzung, die Ergebnisse sind alle „Routine'

Metas groß angelegte Studie zur Sprachübersetzung, die Ergebnisse sind alle „Routine'

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 23:46:042053Durchsuche

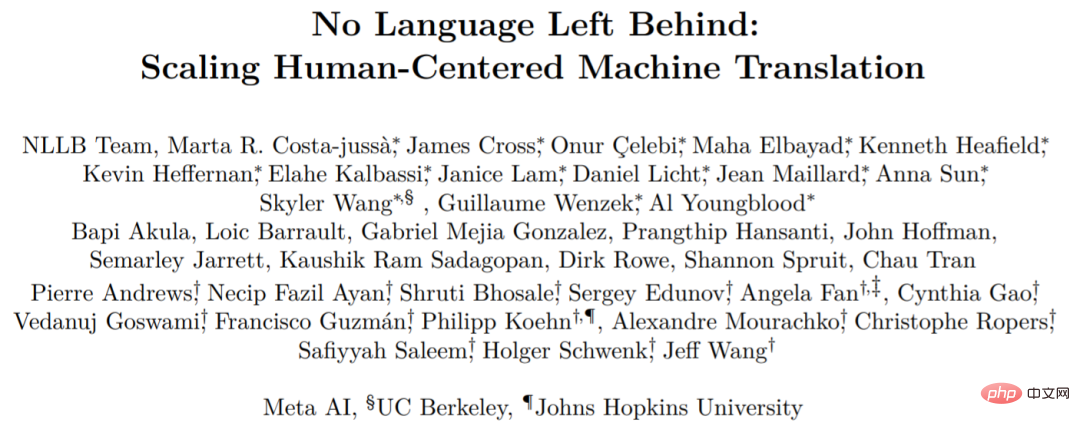

Anfang Juli dieses Jahres veröffentlichte Meta AI ein neues Übersetzungsmodell namens No Language Left Behind (NLLB), das wir wörtlich mit „Keine Sprache zurückgelassen“ übersetzen können.

Wie der Name schon sagt, kann NLLB jede Übersetzung zwischen mehr als 200 Sprachen unterstützen, und Meta AI hat es auch als Open Source bereitgestellt. Es kann Sprachen übersetzen, die Sie noch nie zuvor gesehen haben, wie z. B. Luganda, Urdu usw. ?? com /facebookresearch/fairseq/tree/nllb

Diese Forschung wurde jedoch kürzlich in Frage gestellt. Einige Leute glauben, dass viele der Behauptungen von Meta AI im NLLB unbegründet und irreführend sind und die Bewertungsergebnisse schwerwiegend sind Folgen. Darüber hinaus sagen Skeptiker, dass es aufgrund der Bewertungsmethodik von Meta AI leicht wäre, höhere Zahlen zu erhalten, als sie angeben.

Diese Forschung wurde jedoch kürzlich in Frage gestellt. Einige Leute glauben, dass viele der Behauptungen von Meta AI im NLLB unbegründet und irreführend sind und die Bewertungsergebnisse schwerwiegend sind Folgen. Darüber hinaus sagen Skeptiker, dass es aufgrund der Bewertungsmethodik von Meta AI leicht wäre, höhere Zahlen zu erhalten, als sie angeben.

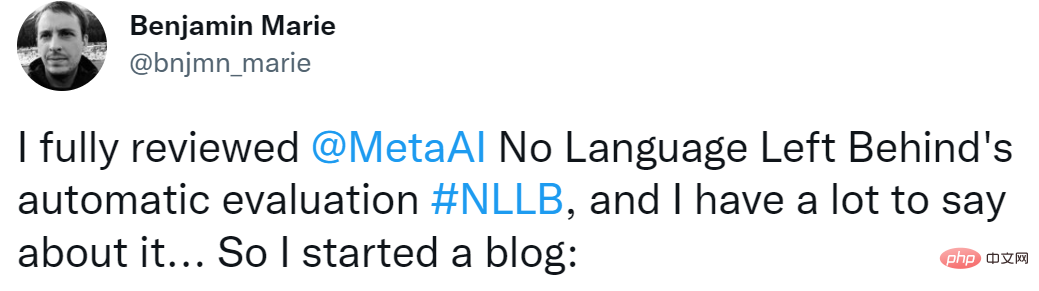

- Der Skeptiker ist Benjamin Marie, ein Forscher in der Verarbeitung natürlicher Sprache, der sich mit Übersetzungstechnologie auskennt. Was er in Frage stellte, kann als Meta-KI zusammengefasst werden, die spBLEU und BLEU nebeneinander vergleicht.

- Zu dieser Frage sagten einige Forscher: spBLEU ist eine vernünftige Metrik, vorausgesetzt, der Text enthält keine Leerzeichen (Thai usw.). Aber der Vergleich von spBLEU und BLEU ist definitiv falsch.

Netizen Arle Lommel antwortete auf Benjamin Marie: Das ist ein großartiger Punkt. Dies hat mich auch gelehrt, dass wir bei der Forschung zum maschinellen Lernen sehr vorsichtig sein sollten, wenn es um Forschungsergebnisse geht, denen es an Bestätigung mangelt. Was Sie hier finden, deutet darauf hin, dass das Problem komplizierter wird, wenn sich Menschen nur auf Brüche beziehen, ohne zu kontrollieren, wie sie erzeugt werden.

Vedanuj Goswami, einer der Autoren des Papiers, sagte: „Wir stimmen zu 100 % mit dem Autor überein, dass man BLEU-Scores nicht mit verschiedenen Tokenizern vergleichen kann. Aber das Hauptargument des Autors ist, dass das große Problem.“ In unserer Arbeit ist es nicht wahr, dass die meisten Ergebnisse nicht vergleichbar sind

In unserer Arbeit verwenden Tabelle 30 und Tabelle 31 denselben Tokenizer für die spBLEU-Bewertung (FLORES-101 spm tokenizer), wir verwenden nicht speziell FLORES -200 spm tokenizer. Wir beschreiben dies ausführlich im Titel von Tabelle 30 und in Abschnitt 8.3.1. In ähnlicher Weise verwenden die Tabellen 35, 36, 37, 38 alle vergleichbare Metriken/Tokenizer für unseren Artikel Die derzeitige Bewertungsmethode für maschinelle Übersetzungen ist nicht perfekt und verschiedene Arbeiten verwenden unterschiedliche Methoden. „

In unserer Arbeit verwenden Tabelle 30 und Tabelle 31 denselben Tokenizer für die spBLEU-Bewertung (FLORES-101 spm tokenizer), wir verwenden nicht speziell FLORES -200 spm tokenizer. Wir beschreiben dies ausführlich im Titel von Tabelle 30 und in Abschnitt 8.3.1. In ähnlicher Weise verwenden die Tabellen 35, 36, 37, 38 alle vergleichbare Metriken/Tokenizer für unseren Artikel Die derzeitige Bewertungsmethode für maschinelle Übersetzungen ist nicht perfekt und verschiedene Arbeiten verwenden unterschiedliche Methoden. „

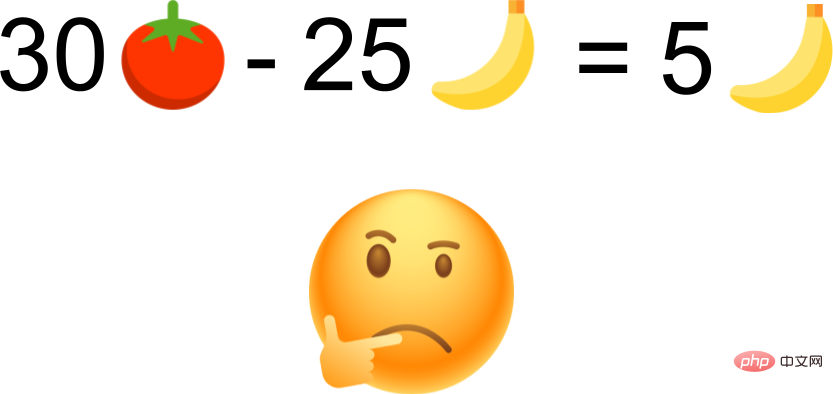

Nachfolgend stellen wir den spezifischen Inhalt von Benjamin Maries Zweifeln vor Lassen Sie uns eine einfache Analogie ziehen:

Nachfolgend stellen wir den spezifischen Inhalt von Benjamin Maries Zweifeln vor Lassen Sie uns eine einfache Analogie ziehen:

Paul hat 25 Bananen und Bill hat 30 Tomaten. Würden Sie sagen, dass Bill fünf Bananen mehr hat als Paul?

BLEU ist wie eine Banane, spBLEU ist wie eine Tomate. Ersetzen Sie Paul durch „Vorherige Arbeit“ und Bill durch „NLLB“. Wir können jetzt etwa Folgendes schreiben:

Die vorherige Arbeit wurde bei 25 BLEU und NLLB bei 30 spBLEU durchgeführt. Würden Sie sagen, dass NLLB 5 BLEU-Punkte besser ist als frühere Arbeiten?

Mit der obigen Analogie ist der unten eingeführte Inhalt möglicherweise leichter zu verstehen.

Zuvor veröffentlichte Meta AI einen Artikel, der NLLB umfassend erläuterte und bewertete. In der Zusammenfassung des Papiers behaupten sie, dass das Modell eine BLEU-Verbesserung von 44 % im Vergleich zu früheren SOTA-Methoden erzielt. Mit anderen Worten: NLLB wird bessere Ergebnisse liefern als frühere Studien.

In Bezug auf BLEU ist es in der Geschichte der maschinellen Übersetzungsforschung selten, dass sich BLEU im Vergleich zur vorherigen SOTA-Technologie um 44 % verbessert. Dieser einfache Satz in der Arbeit repräsentiert also den wissenschaftlichen Fortschritt. Einige Medien berichteten direkt über diese Aussage und positionierten Meta AI ohne weitere Überprüfung an der Spitze der maschinellen Sprachübersetzung.

Wenn sich Meta AI dafür entscheidet, eine so große technische Studie zu veröffentlichen, sollten sie sehr zuverlässige wissenschaftliche Beweise liefern. Andernfalls wird die Behauptung von Meta AI, dass sie besser abschneidet als andere, ohne jegliche Beweise, nur die sehr harte Arbeit untergraben, die andere Forschungseinrichtungen geleistet haben und leisten.

Marie Um das NLLB-Fehlerproblem zu erklären, versucht er zu zeigen, wie Meta-KI durch ihre eigenen Ergebnisse in die Irre geführt werden kann. Anhand einfacher Beispiele aus dem NLLB und ähnlichen Beispielen, die sie selbst gefunden hat, zeigt Marie, wie einfach es ist, über SOTA hinauszugehen, wenn man die fehlerhaften Bewertungsmethoden des NLLB verwendet. Abschließend identifiziert und konkretisiert Marie die wesentlichen Fehler ihrer Einschätzung.

Meta AI verglich sein Modell mit Daten aus mehr als 20 früheren Studien und kam zu dem Schluss, dass NLLB frühere Studien deutlich übertraf. Um eine so große Anzahl von Vergleichen zu ermöglichen, stützen sie sich auf automatisierte Bewertungsmetriken für die maschinelle Übersetzungsbewertung, hauptsächlich BLEU und spBLEU.

BLEU ist trotz seiner Mängel in der maschinellen Übersetzung äußerst beliebt.

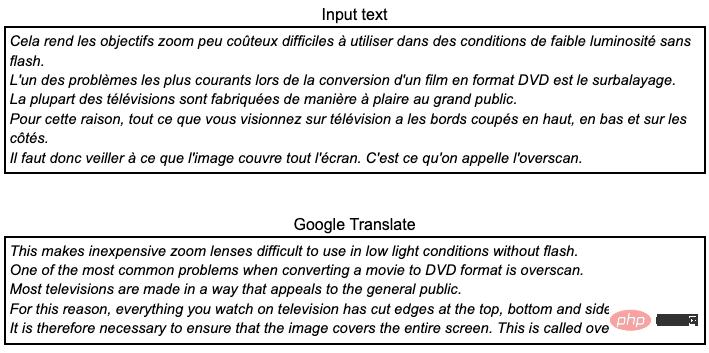

Zum Beispiel möchten wir den folgenden französischen Text aus dem FLORES101-Datensatz mit Google Translate ins Englische übersetzen. Wenn Sie Französisch sprechen, werden Sie feststellen, dass es sich um eine Übersetzung von sehr schlechter Qualität handelt: Grammatikfehler, inkonsistente Terminologie und eine unnatürliche Lesbarkeit. Da der Datensatz aus dem Englischen erstellt wurde, wertet Meta AI die maschinelle Übersetzung nur bei der Übersetzung ins Englische aus.

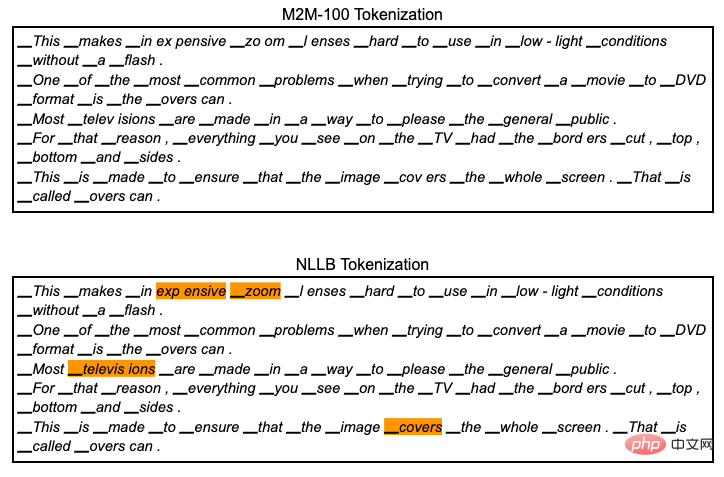

Wir können es mit der Referenzübersetzung vergleichen, indem wir zählen, wie viele Tokens in Google Translate auch in dieser Referenzübersetzung enthalten sind. Ein Token wird hier als eine durch ein Leerzeichen getrennte Folge von Zeichen definiert. Orange hebt alle Token-Sequenzen im Google Translate oben hervor, die in der Referenzübersetzung unten erscheinen.

Unter Berücksichtigung nur aller übereinstimmenden Token kann der BLEU-Score auf 50,8 BLEU berechnet werden. Dieser Wert allein bedeutet nichts, er macht nur Sinn, wenn er mit einem anderen BLEU-Wert verglichen wird.

Der wichtigste Punkt, den es hier zu verstehen gilt, ist, dass die Punktzahl auf der Grundlage von Token berechnet wird, was in den meisten maschinellen Übersetzungsforschungen ignoriert wird. Der BLEU-Score wird mit SacreBLEU berechnet, das seine eigene interne Tokenisierung durchführt und im Grunde nur Leerzeichen vor Satzzeichen hinzufügt. Dies ist eine der zuverlässigsten und wiederholbarsten Methoden zur Berechnung des BLEU-Scores. Meta AI verwendet spBLEU.

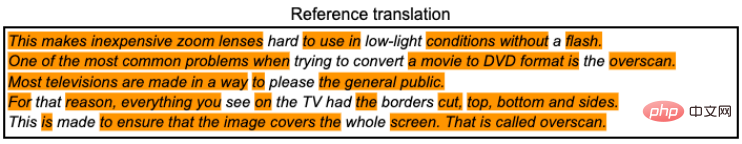

Was ist also spBLEU? Es ist BLEU, verwendet jedoch eine andere Tokenisierung. Es tokenisiert Google Translate und Referenzübersetzungen wie folgt.

Der mit spBLEU verbundene Token generiert den Token, indem er das Wort in kleinere Teile zerlegt (das an den Token angehängte Wort ist hier nicht wichtig, versuchen Sie es zu ignorieren). Eine direkte Folge der Verwendung der spBLEU-Tokenisierung ist, dass wir am Ende mehr Token sowohl für Übersetzungen als auch für Referenzen haben. Da mehr Token vorhanden sind, können wir davon ausgehen, dass Google Translate mehr Token aus der Referenz abgleicht. Dann wird die Punktzahl steigen. Tatsächlich beträgt der spBLEU-Score hier 54,8.

Wir können nicht umhin, 4 Punkte mehr zu verlangen als der oben mithilfe der internen SacreBLEU-Tokenisierung berechnete BLEU-Score? Wird die Übersetzung also immer besser?

Anscheinend nicht, die Übersetzung bleibt dieselbe. Ein Vergleich von BLEU und spBLEU macht überhaupt keinen Sinn. BLEU und spBLEU handhaben Google Translate und Referenzübersetzungen unterschiedlich und werden nur zu Bewertungszwecken verwendet. Es handelt sich tatsächlich um unterschiedliche Indikatoren. Wären sie derselbe Indikator, müssten wir sie nicht anders benennen. Wie wir in der Community der maschinellen Übersetzungsforschung oft lesen und hören, ist es nicht fair oder sogar unfair, die Übersetzungsqualität anhand von BLEU-Scores zu vergleichen, die für verschiedene oder sogar fast ähnliche Token berechnet wurden. Wenn Sie möchten, dass Ihre Forschung wissenschaftlich glaubwürdig ist, müssen Sie lediglich Ihren BLEU-Score konsistent und mit genau derselben Tokenisierung berechnen.

Meta AI behauptet, dass NLLB viel besser ist als frühere Studien, weil sie immer bessere spBLEU-Werte erzielen können als zuvor veröffentlichte BLEU-Werte, das Gegenteil ist der Fall. Denn es ist eine äußerst schwierige Aufgabe, den spBLEU-Score für eine bestimmte Übersetzung unter den BLEU-Score zu bringen. Was noch verwirrender ist: Wenn es ihr Ziel ist, die höchste Punktzahl zu erreichen, warum nicht einfach die chrBLEU-Metrik verwenden?

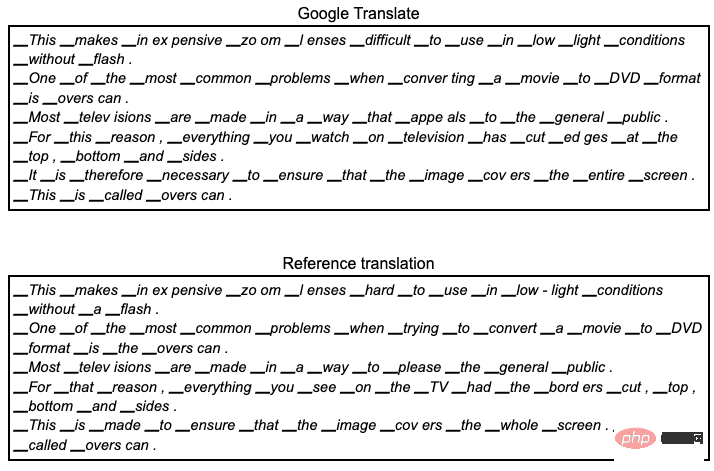

Zum Beispiel wird in Google Translate und Reference Translation jedes Zeichen zu einem Token (d. h. zwischen den Zeichen werden Leerzeichen eingefügt).

Dann berechnen wir den chrBLEU-Wert mit 75,5, was 20,7 Punkte höher ist als der spBLEU. Nach Einschätzung des NLLB wird dies eine deutliche Verbesserung sein, die einen neuen Höhepunkt für die maschinelle Übersetzung darstellen wird, während das ursprüngliche Google Translate unverändert bleibt.

Beispiele für Fehler in Arbeiten

Schauen wir uns nun ein konkretes Beispiel einer NLLB-Bewertung an.

Meta AI behauptet, frühere Arbeiten übertroffen zu haben, indem es seine Zahlen mit zuvor veröffentlichten Zahlen vergleicht. In diesem Artikel werden Schlussfolgerungen aus den Tabellen 30, 31, 32, 35, 36, 37 und 38 gezogen und mit früheren Arbeiten verglichen.

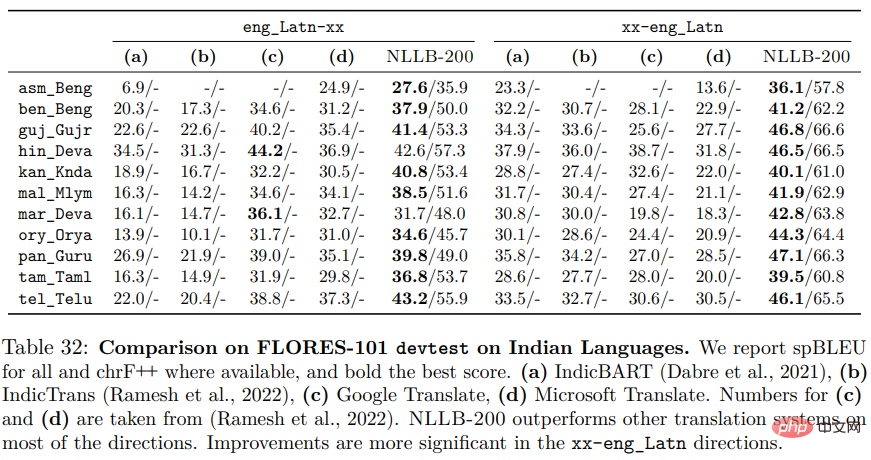

startet von Tisch 32. Dies ist eines der anschaulichsten Beispiele, da dabei verschiedene Arten von Fehlern auftreten können.

In der Tabelle sind alle Zahlen mit Ausnahme der NLLB-200-Spalte direkt aus den zuvor veröffentlichten Artikeln IndicBART und IndicTrans kopiert. Aus Gründen der Lesbarkeit markiert Meta AI die höchste Punktzahl für jede Sprache fett, wobei die fett gedruckte Spalte angibt, dass das entsprechende System das beste ist.

Die Tabelle zeigt spBLEU für alle, was irreführend ist. Eigentlich bedeutet „all“ nur NLLB-200, da IndicBART und IndicTrans nicht spBLEU, sondern BLEU verwenden. Beim Vergleich zeigt sich jedoch, dass der spBLEU-Score von NLLB höher ist als der BLEU-Score früherer Arbeiten. Aber bedeutet das, dass NLLB besser ist? Sind 30 Tomaten besser als 25 Bananen?

Im Text, der die Ergebnisse erklärt, können wir sehen:

Zum Beispiel (c) Google Translate, (d) Microsoft Translate. NLLB-200 übertrifft alle Modelle in den meisten Richtungen deutlich. Der Trainingsdatensatz für NLLB-200 umfasst 25 indische Sprachen, fast doppelt so viele wie die von (a) und (b) abgedeckten. Die Leistungsverbesserungen sind auf mehr mehrsprachige Übertragungen sowie eine verbesserte Datenqualität für das indische Sprach-Mining und die Rückübersetzung zurückzuführen.

Mit anderen Worten, NLLB hat mehr Tomaten als die vorherige Studie Bananen. NLLB hat also mehr Bananen.

spBLEU-Scores sind höher als BLEU-Scores, da sie auf kleineren und unterschiedlichen Token berechnet werden. Lässt sich NLLB jedoch besser übersetzen? Wir können einfach nicht antworten. Erschwerend kommt hinzu, dass IndicBART und IndicTrans nicht vergleichbar sind, da beide zwei unterschiedliche Token-Methoden verwenden.

Die meisten der oben aufgeführten Tabellen haben ähnliche Probleme und weisen mehr oder weniger Fehler auf.

Wenn Sie sich die von IndicBART und IndicTrans veröffentlichten Papiere ansehen, um die Zahlen zu überprüfen, werden Sie feststellen, dass es noch andere Probleme gibt. Die Spalten (a, b) in Tabelle 32 sind alle vertauscht, die IndicBART-Zahlen sind die Zahlen in Indicatrans und umgekehrt.

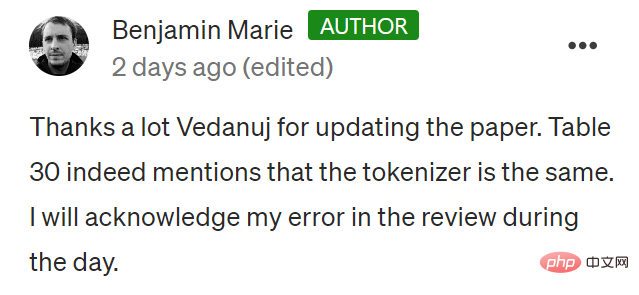

Wenn man sich Tabelle 30 ansieht, ist das Problem noch größer.  Allerdings wurde Tabelle 30 in der Zeitung aktualisiert und Benjamin Marie bedankte sich bei Vedanuj für die Aktualisierung des Artikels. Tabelle 30 erwähnt, dass der Tokenizer derselbe ist. Ich gebe meinen Fehler zu.

Allerdings wurde Tabelle 30 in der Zeitung aktualisiert und Benjamin Marie bedankte sich bei Vedanuj für die Aktualisierung des Artikels. Tabelle 30 erwähnt, dass der Tokenizer derselbe ist. Ich gebe meinen Fehler zu.

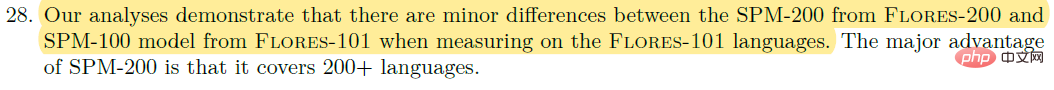

Wie in Tabelle 32 gezeigt, behauptet Meta AI, dass NLLB frühere DeltaLM und Deepnet übertrifft, während die BLEU-Scores mit verschiedenen Berechnungsmethoden verglichen werden. Neu ist hier, dass sie NLLB auch mit ihrer vorherigen Arbeit, M2M-100, verglichen haben, die ebenfalls mit spBLEU bewertet wurde. Ist dieser Vergleich also sinnvoll? NEIN. Obwohl beide spBLEU verwenden, verwenden sie tatsächlich unterschiedliche Tokenizer, was einen Vergleich unmöglich macht. In Fußnote 28 machen sie folgende Aussage:

„Unsere Analyse zeigt, dass bei Messung an der FLORES-101-Sprache der SPM-200 von FLORES-200 und der SPM-100 von FLORES-101 vorhanden sind.“ Es gibt kleine Unterschiede zwischen den Modellen. Der Hauptvorteil von SPM-200 besteht darin, dass es mehr als 200 Sprachen abdeckt.

Kleine Unterschiede sind auch Unterschiede. In diesem Fall sind diese Unterschiede wichtig, weil wir wissenschaftliche Forschung betreiben.

Ein Fortschritt für NLLB im Vergleich zu ihrer Arbeit an M2M-100 ist die Hinzufügung weiterer Sprachen zum Modell und Datensatz. Es beinhaltet das Tokenisierungsmodell. Wenn Sie diesem Tokenizer weitere Sprachen mit unterschiedlichen Schriftsystemen hinzufügen und dabei die Vokabulargröße konstant halten, erhalten Sie technisch gesehen automatisch ein Vokabular mit kleineren Token. Wie oben gezeigt, können Sie durch die Verwendung kleinerer Token bessere Ergebnisse erzielen. Lassen Sie uns dies überprüfen.

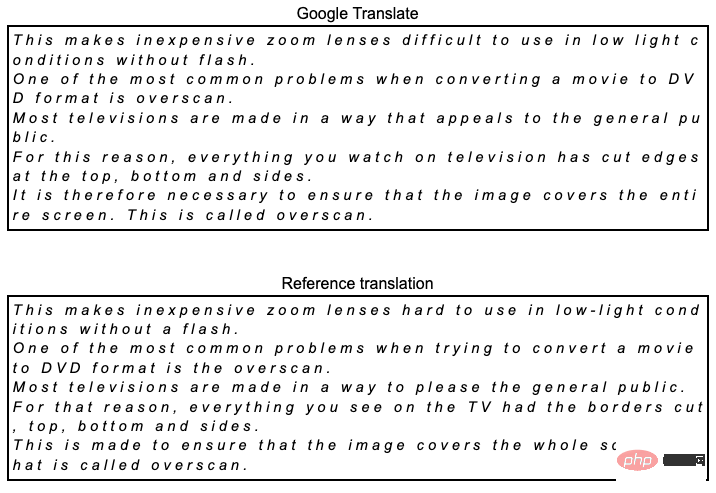

Wie in der Abbildung unten gezeigt:

Diese Tokenisierung generiert 95 Token, während NLLB 97 Token generiert. Dies ist nur ein subtiler Unterschied. Wenn spBLEU mithilfe der M2M-100-Tokenisierung berechnet wird, beträgt der Wert 53,8, was 1 Punkt niedriger ist als bei der NLLB-Tokenisierung. Laut der Forschungsliteratur zur maschinellen Übersetzung reicht in der Regel ein Unterschied von 1 Punkt aus, um zu behaupten, dass ein System deutlich besser ist. Wie erwartet wird NLLB höhere Ergebnisse erzielen als M2M-100.

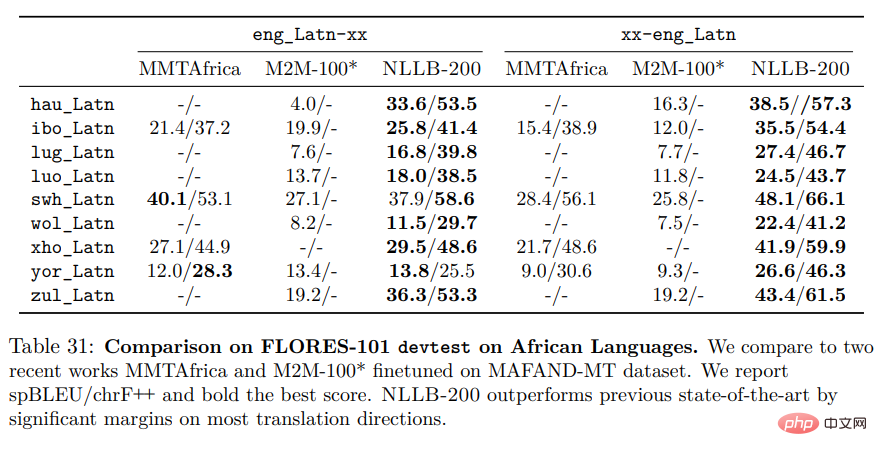

Die nächste Tabelle ist die letzte Tabelle in diesem Artikel: Tabelle 31.

Auch hier haben wir die gleichen oben genannten Probleme:

1. M2M-100 und NLLB verwenden zwei unterschiedliche Tokenisierungen für die Bewertung, daher ist kein Vergleich möglich. 2. MMTAfrica scheint in seinem Papier die M2M-100-Tokenisierung zu verwenden. Es ist vergleichbar mit dem M2M-100, aber nicht mit dem NLLB.

Der Artikel enthält noch einige Fragen, daher werde ich sie hier nicht einzeln vorstellen. Der Hauptfehler, den Meta AI in NLLB macht, ist ein sehr häufiger Fehler bei der Bewertung maschineller Übersetzungen, obwohl wir zugeben sollten, dass diese Arbeit wirklich erstaunlich ist und für viele Sprachen eine höhere Übersetzungsqualität liefern kann.

Das obige ist der detaillierte Inhalt vonMetas groß angelegte Studie zur Sprachübersetzung, die Ergebnisse sind alle „Routine'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr