Heim >Technologie-Peripheriegeräte >KI >ConvNeXt V2 verwendet hier nur die einfachste Faltungsarchitektur und ist hinsichtlich der Leistung Transformer nicht unterlegen

ConvNeXt V2 verwendet hier nur die einfachste Faltungsarchitektur und ist hinsichtlich der Leistung Transformer nicht unterlegen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 23:19:011681Durchsuche

Nach Jahrzehnten der Grundlagenforschung hat das Gebiet der visuellen Erkennung eine neue Ära des groß angelegten Lernens visueller Darstellungen eingeläutet. Vorab trainierte großformatige Vision-Modelle sind zu einem unverzichtbaren Werkzeug für Feature-Learning und Vision-Anwendungen geworden. Die Leistung eines Lernsystems für visuelle Darstellung wird stark von drei Hauptfaktoren beeinflusst: der neuronalen Netzwerkarchitektur des Modells, der zum Trainieren des Netzwerks verwendeten Methode und den Trainingsdaten. Verbesserungen bei jedem Faktor tragen zu einer verbesserten Gesamtleistung des Modells bei.

Innovationen im Design neuronaler Netzwerkarchitekturen haben im Bereich des Repräsentationslernens schon immer eine wichtige Rolle gespielt. Die Convolutional Neural Network Architecture (ConvNet) hatte einen erheblichen Einfluss auf die Computer-Vision-Forschung und ermöglichte den Einsatz universeller Feature-Learning-Methoden bei verschiedenen visuellen Erkennungsaufgaben, ohne auf manuell implementiertes Feature-Engineering angewiesen zu sein. In den letzten Jahren hat die ursprünglich für die Verarbeitung natürlicher Sprache entwickelte Transformer-Architektur aufgrund ihrer Eignung für Modelle und Datensätze unterschiedlicher Größe auch in anderen Deep-Learning-Bereichen breite Anwendung gefunden.

Das Aufkommen der ConvNeXt-Architektur modernisiert das traditionelle ConvNet und beweist, dass sich reine Faltungsmodelle auch an Änderungen in der Modell- und Datensatzgröße anpassen können. Die gebräuchlichste Methode zur Erkundung des Designraums neuronaler Netzwerkarchitekturen besteht jedoch nach wie vor darin, die Leistung des überwachten Lernens auf ImageNet zu bewerten.

Eine weitere Idee besteht darin, den Schwerpunkt des visuellen Repräsentationslernens vom beschrifteten überwachten Lernen auf selbstüberwachtes Vortraining zu verlagern. Selbstüberwachte Algorithmen führten die maskierte Sprachmodellierung in das Sichtfeld ein und wurden schnell zu einer beliebten Methode zum Erlernen visueller Darstellungen. Beim selbstüberwachten Lernen wird jedoch typischerweise eine Architektur verwendet, die für überwachtes Lernen konzipiert ist, und es wird davon ausgegangen, dass die Architektur festgelegt ist. Beispielsweise verwendet Masked Autoencoder (MAE) eine visuelle Transformatorarchitektur.

Eine Möglichkeit besteht darin, diese Architekturen mit selbstüberwachten Lernrahmen zu kombinieren, aber dabei treten einige spezifische Probleme auf. Beispielsweise entsteht bei der Kombination von ConvNeXt mit MAE das folgende Problem: MAE verfügt über ein spezielles Encoder-Decoder-Design, das für die Sequenzverarbeitungsfähigkeiten des Transformators optimiert ist, wodurch sich der rechenintensive Encoder auf diese sichtbaren Patches konzentriert und dadurch das Vortraining reduziert wird Kosten. Dieses Design ist jedoch möglicherweise nicht mit dem Standard-ConvNet kompatibel, das dichte Schiebefenster verwendet. Ohne Berücksichtigung der Beziehung zwischen Architektur und Trainingszielen ist außerdem unklar, ob eine optimale Leistung erreicht werden kann. Tatsächlich zeigen bestehende Untersuchungen, dass es schwierig ist, ConvNet mit maskenbasiertem selbstüberwachtem Lernen zu trainieren, und experimentelle Beweise zeigen, dass Transformer und ConvNet beim Feature-Lernen unterschiedlich sein können, was sich auf die Qualität der endgültigen Darstellung auswirkt.

Zu diesem Zweck schlugen Forscher von KAIST, Meta und der New York University (darunter Liu Zhuang, Erstautor von ConvNeXt, und Xie Saining, Erstautor von ResNeXt) vor, gemeinsam die Netzwerkarchitektur und den maskierten Autoencoder darunter zu entwerfen Der Zweck dieses Frameworks besteht darin, maskenbasiertes selbstüberwachtes Lernen auf ConvNeXt-Modelle anzuwenden und Ergebnisse zu erzielen, die mit denen von Transformatoren vergleichbar sind.

Papieradresse: https://arxiv.org/pdf/2301.00808v1.pdf

Beim Entwerfen eines maskierten Autoencoders behandelt diese Studie die Eingabe mit einer Maske als einen Satz spärlicher Patches , und spärliche Faltung wird verwendet, um die sichtbaren Teile zu verarbeiten. Die Idee wurde durch die Verwendung spärlicher Windungen bei der Verarbeitung großräumiger 3D-Punktwolken inspiriert. Konkret schlägt diese Forschung vor, ConvNeXt mit spärlichen Faltungen zu implementieren und dann während der Feinabstimmung die Gewichte ohne spezielle Verarbeitung wieder in standardmäßige dichte Netzwerkschichten umzuwandeln. Um die Effizienz vor dem Training weiter zu verbessern, ersetzt diese Studie den Transformatordecoder durch einen einzelnen ConvNeXt, wodurch das gesamte Design vollständig faltungsfähig wird. Die Forscher stellten fest, dass nach dem Hinzufügen dieser Änderungen die erlernten Funktionen nützlich waren und die Basisergebnisse verbesserten, die fein abgestimmte Leistung jedoch immer noch schlechter war als das transformatorbasierte Modell.

Dann analysierte die Studie den Funktionsraum von ConvNeXt mit verschiedenen Trainingskonfigurationen. Beim direkten Training von ConvNeXt auf maskierten Eingaben stellten die Forscher mögliche Probleme beim Zusammenbruch von Merkmalen in der MLP-Ebene fest. Um dieses Problem zu lösen, schlägt diese Studie vor, eine globale Antwortnormalisierungsschicht (Global Response Normalization Layer) hinzuzufügen, um den Funktionswettbewerb zwischen Kanälen zu verbessern. Diese Verbesserung ist am effektivsten, wenn das Modell mit maskierten Autoencodern vorab trainiert wird, was darauf hindeutet, dass die Wiederverwendung fester Architekturentwürfe aus überwachtem Lernen möglicherweise nicht der beste Ansatz ist.

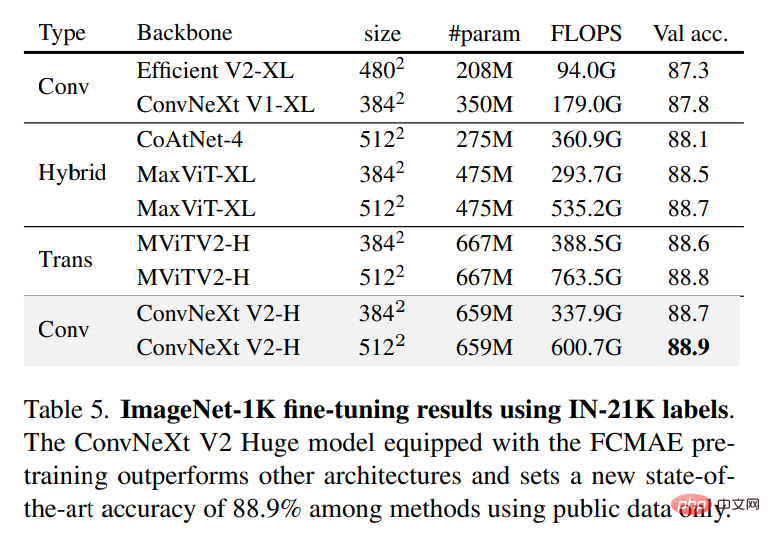

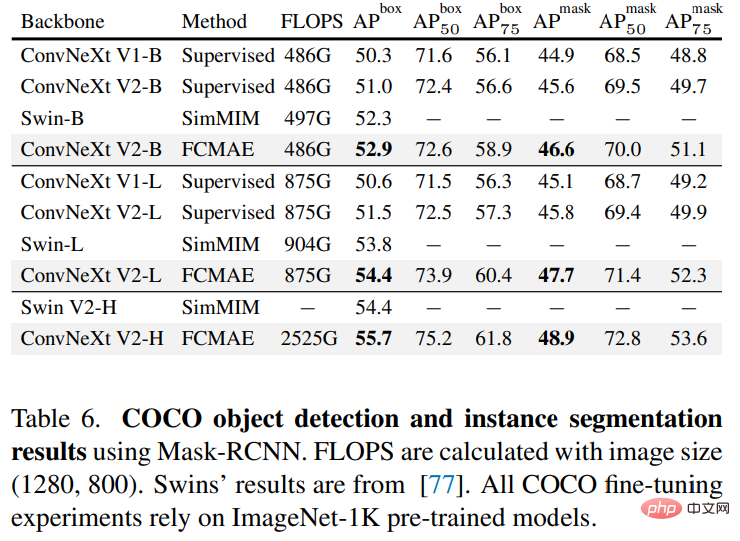

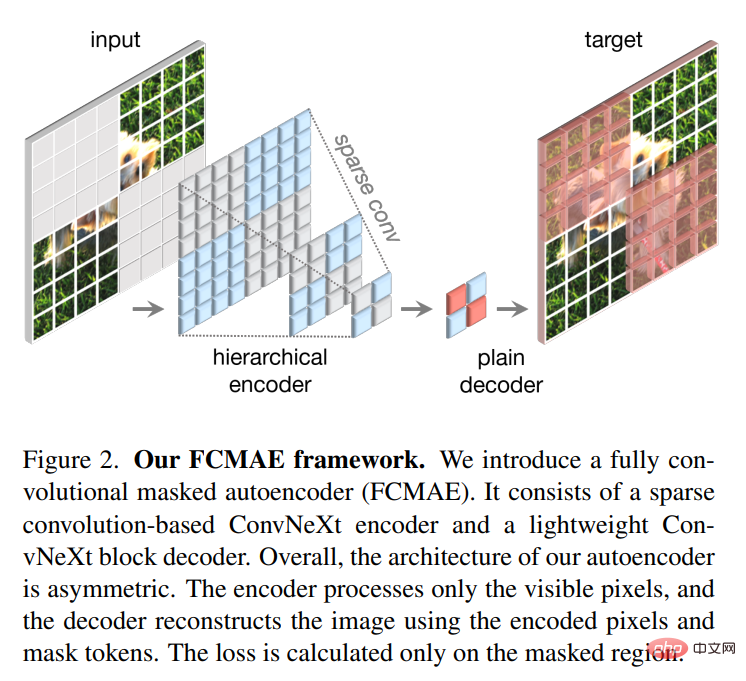

Basierend auf den oben genannten Verbesserungen schlägt diese Studie ConvNeXt V2 vor, das in Kombination mit maskierten Autoencodern eine bessere Leistung zeigt. Gleichzeitig stellten die Forscher fest, dass ConvNeXt V2 gegenüber reinem ConvNet bei verschiedenen Downstream-Aufgaben erhebliche Leistungsverbesserungen aufweist, darunter Klassifizierungsaufgaben auf ImageNet, Zielerkennung auf COCO und semantische Segmentierung auf ADE20K. Die in dieser Studie vorgeschlagene Methode ist konzeptionell einfach und basiert auf der vollständigen Faltungsmethode. Das Lernsignal wird generiert, indem die ursprüngliche visuelle Eingabe zufällig mit einem hohen Maskierungsverhältnis maskiert wird und das Modell dann die fehlenden Teile basierend auf dem verbleibenden Kontext vorhersagen lässt. Der Gesamtrahmen ist in der folgenden Abbildung dargestellt. Das

-Framework besteht aus einem auf spärlicher Faltung basierenden ConvNeXt-Encoder und einem leichtgewichtigen ConvNeXt-Decoder, wobei die Struktur des Autoencoders asymmetrisch ist. Der Encoder verarbeitet nur sichtbare Pixel, während der Decoder codierte Pixel und Maskentokens verwendet, um das Bild zu rekonstruieren. Gleichzeitig wird der Verlust nur im maskierten Bereich berechnet.

-Framework besteht aus einem auf spärlicher Faltung basierenden ConvNeXt-Encoder und einem leichtgewichtigen ConvNeXt-Decoder, wobei die Struktur des Autoencoders asymmetrisch ist. Der Encoder verarbeitet nur sichtbare Pixel, während der Decoder codierte Pixel und Maskentokens verwendet, um das Bild zu rekonstruieren. Gleichzeitig wird der Verlust nur im maskierten Bereich berechnet.

Globale Reaktionsnormalisierung

Es gibt viele Mechanismen im Gehirn, die die neuronale Diversität fördern. Beispielsweise kann die laterale Hemmung dazu beitragen, die Reaktion aktivierter Neuronen zu verbessern, indem sie den Kontrast und die Selektivität einzelner Neuronen gegenüber Reizen erhöht und gleichzeitig die Reaktionsvielfalt ganzer Neuronenpopulationen erhöht. Beim Deep Learning kann diese Form der lateralen Hemmung durch Antwortnormalisierung erreicht werden. In dieser Studie wird eine neue Antwortnormalisierungsschicht namens Global Response Normalization (GRN) eingeführt, die darauf abzielt, den Kontrast und die Selektivität zwischen Kanälen zu erhöhen. Die GRN-Einheit besteht aus drei Schritten: 1) globale Feature-Aggregation, 2) Feature-Normalisierung und 3) Feature-Kalibrierung. Wie in der Abbildung unten gezeigt, können GRN-Ebenen in den ursprünglichen ConvNeXt-Block zusammengeführt werden.

Die Forscher fanden anhand von Experimenten heraus, dass LayerScale bei der Anwendung von GRN nicht erforderlich ist und gelöscht werden kann. Unter Nutzung dieses neuen Blockdesigns erstellte die Studie eine Vielzahl von Modellen mit unterschiedlichen Effizienzen und Kapazitäten, die als ConvNeXt V2-Modellfamilie bezeichnet werden und von leichtgewichtig (Atto) bis rechenintensiv (Huge) reichen.

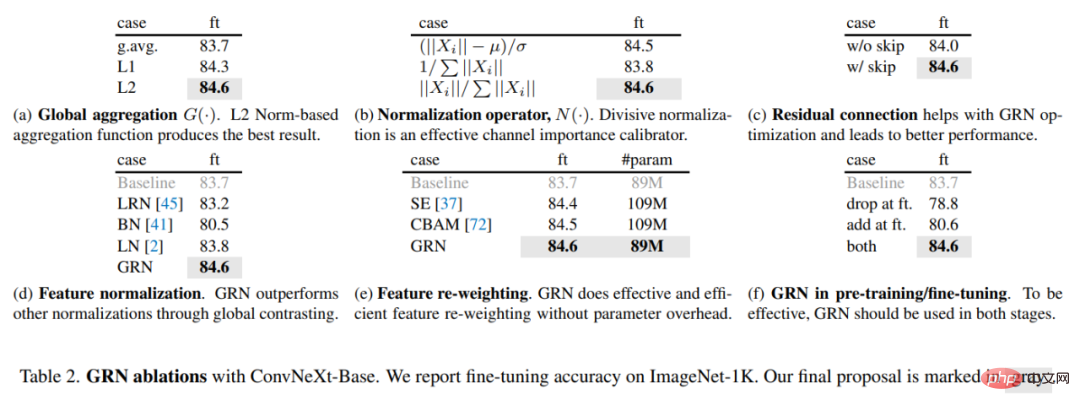

Um die Rolle von GRN zu bewerten, nutzte diese Studie das FCMAE-Framework, um ConvNeXt V2 vorab zu trainieren. Aus der visuellen Darstellung in Abbildung 3 unten und der Kosinus-Abstandsanalyse in Abbildung 4 lässt sich erkennen, dass ConvNeXt V2 das Problem des Merkmalkollapses effektiv lindert. Die Kosinus-Abstandswerte sind konstant hoch, was darauf hinweist, dass die Merkmalsvielfalt während der Übertragung von Netzwerkschichten erhalten bleiben kann. Dies ähnelt dem mit MAE vorab trainierten ViT-Modell. Dies zeigt, dass das Lernverhalten von ConvNeXt V2 dem von ViT unter einem ähnlichen Pre-Training-Framework für Maskenbilder ähnelt.

Um die Rolle von GRN zu bewerten, nutzte diese Studie das FCMAE-Framework, um ConvNeXt V2 vorab zu trainieren. Aus der visuellen Darstellung in Abbildung 3 unten und der Kosinus-Abstandsanalyse in Abbildung 4 lässt sich erkennen, dass ConvNeXt V2 das Problem des Merkmalkollapses effektiv lindert. Die Kosinus-Abstandswerte sind konstant hoch, was darauf hinweist, dass die Merkmalsvielfalt während der Übertragung von Netzwerkschichten erhalten bleiben kann. Dies ähnelt dem mit MAE vorab trainierten ViT-Modell. Dies zeigt, dass das Lernverhalten von ConvNeXt V2 dem von ViT unter einem ähnlichen Pre-Training-Framework für Maskenbilder ähnelt.

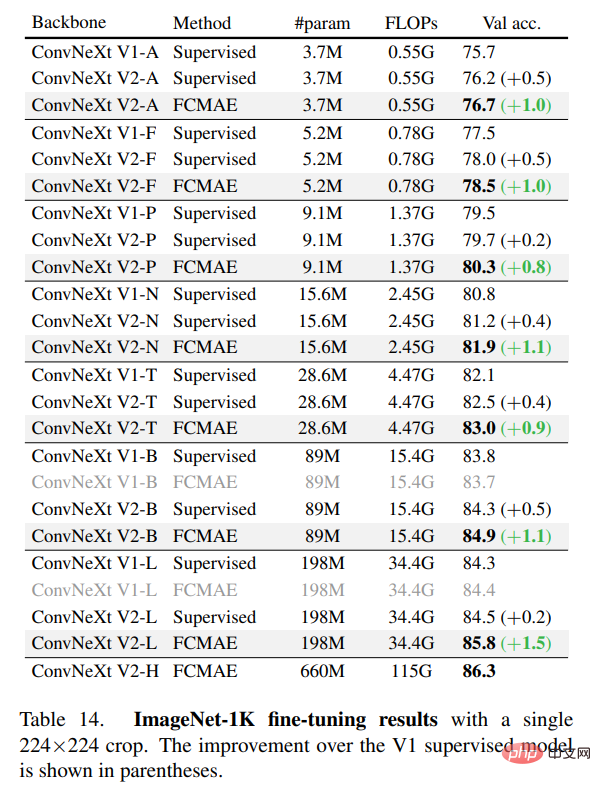

In der Studie wurde die Feinabstimmungsleistung weiter bewertet. Die Ergebnisse sind in der folgenden Tabelle aufgeführt.

Wenn es mit GRN ausgestattet ist, kann das vorab trainierte FCMAE-Modell das überwachte Modell, das mit 300 Epochen trainiert wurde, deutlich übertreffen. GRN verbessert die Darstellungsqualität durch die Verbesserung der Funktionsvielfalt, die für das maskenbasierte Vortraining von entscheidender Bedeutung ist und im ConvNeXt V1-Modell nicht vorhanden ist. Es ist erwähnenswert, dass diese Verbesserung ohne zusätzlichen Parameter-Overhead und ohne Erhöhung der FLOPS erreicht wird.

Abschließend untersuchte die Studie auch die Bedeutung von GRN für das Vortraining und die Feinabstimmung. Wie in Tabelle 2(f) unten gezeigt, sinkt die Leistung erheblich, unabhängig davon, ob GRN aus der Feinabstimmung entfernt wird oder neu initialisierte GRN während der Feinabstimmung hinzugefügt wird. Dies zeigt, dass GRN sowohl beim Vortraining als auch bei der Feinabstimmung wichtig ist.

Interessierte Leser können den Originaltext des Artikels lesen, um weitere Forschungsdetails zu erfahren.

Das obige ist der detaillierte Inhalt vonConvNeXt V2 verwendet hier nur die einfachste Faltungsarchitektur und ist hinsichtlich der Leistung Transformer nicht unterlegen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr