Heim >Technologie-Peripheriegeräte >KI >Die Parameter werden leicht verbessert und der Leistungsindex explodiert! Google: Große Sprachmodelle verbergen „mysteriöse Fähigkeiten'

Die Parameter werden leicht verbessert und der Leistungsindex explodiert! Google: Große Sprachmodelle verbergen „mysteriöse Fähigkeiten'

- 王林nach vorne

- 2023-04-11 23:16:101669Durchsuche

Da große Sprachmodelle Dinge tun können, auf die sie nicht trainiert wurden, scheinen sie eine Art Magie zu besitzen und sind daher in den Mittelpunkt des Hypes und der Aufmerksamkeit von Medien und Forschern geraten.

Beim Erweitern eines großen Sprachmodells treten gelegentlich einige neue Fähigkeiten auf, die in kleineren Modellen nicht verfügbar sind. Dieses der „Kreativität“ ähnliche Attribut wird als „emergente“ Fähigkeit bezeichnet und stellt einen Schritt in Richtung allgemeiner künstlicher Intelligenz dar.

Jetzt erforschen Forscher von Google, Stanford, Deepmind und der University of North Carolina die „emergente“ Fähigkeit in großen Sprachmodellen.

Decoder fordert DALL-E auf

Die magische „emergente“ Fähigkeit

Die Verarbeitung natürlicher Sprache (NLP) wurde durch Sprachmodelle revolutioniert, die auf großen Textdatenmengen trainiert wurden. Durch die Skalierung von Sprachmodellen werden häufig die Leistung und die Stichprobeneffizienz bei einer Reihe nachgelagerter NLP-Aufgaben verbessert.

In vielen Fällen können wir die Leistung eines großen Sprachmodells vorhersagen, indem wir auf Leistungstrends kleinerer Modelle schließen. Beispielsweise wurde der Effekt der Skalierung auf die Ratlosigkeit von Sprachmodellen über mehr als sieben Größenordnungen hinweg nachgewiesen.

Allerdings verbesserte sich die Leistung bei einigen anderen Aufgaben nicht in vorhersehbarer Weise.

Zum Beispiel zeigt das GPT-3-Papier, dass die Fähigkeit des Sprachmodells, mehrstellige Additionen durchzuführen, eine flache Skalierungskurve für Modelle mit 100M- bis 13B-Parametern aufweist, was ungefähr zufällig ist, aber einen Leistungssprung bei a verursacht Knoten.

Angesichts der zunehmenden Verwendung von Sprachmodellen in der NLP-Forschung ist es wichtig, diese Fähigkeiten, die unerwartet auftreten können, besser zu verstehen.

In einem kürzlich in Machine Learning Research (TMLR) veröffentlichten Artikel „Emergent Power of Large Language Models“ zeigten Forscher Dutzende Beispiele für „emergent“ Power, die durch erweiterte Sprachmodelle erzeugt werden.

Die Existenz dieser „emergenten“ Fähigkeit wirft die Frage auf, ob eine zusätzliche Skalierung das Spektrum der Sprachmodellfähigkeiten weiter erweitern kann.

Bestimmte Hinweis- und Feinabstimmungsmethoden führen nur bei größeren Modellen zu Verbesserungen

„Notfall“-Eingabeaufforderungen

Zuerst besprechen wir die „Entstehung“, die bei Eingabeaufforderungsaufgaben auftreten kann.

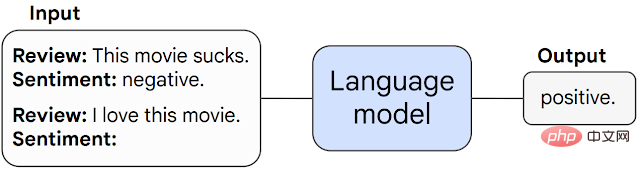

Bei dieser Art von Aufgabe wird ein vorab trainiertes Sprachmodell aufgefordert, die Aufgabe der Vorhersage des nächsten Wortes auszuführen und führt die Aufgabe aus, indem es die Antwort vervollständigt.

Ohne weitere Feinabstimmung können Sprachmodelle häufig Aufgaben ausführen, die während des Trainings nicht gesehen wurden.

Wenn eine Aufgabe bei einem bestimmten Skalierungsschwellenwert unvorhersehbar von einer zufälligen zu einer überzufälligen Leistung ansteigt, nennen wir sie eine „aufkommende“ Aufgabe.

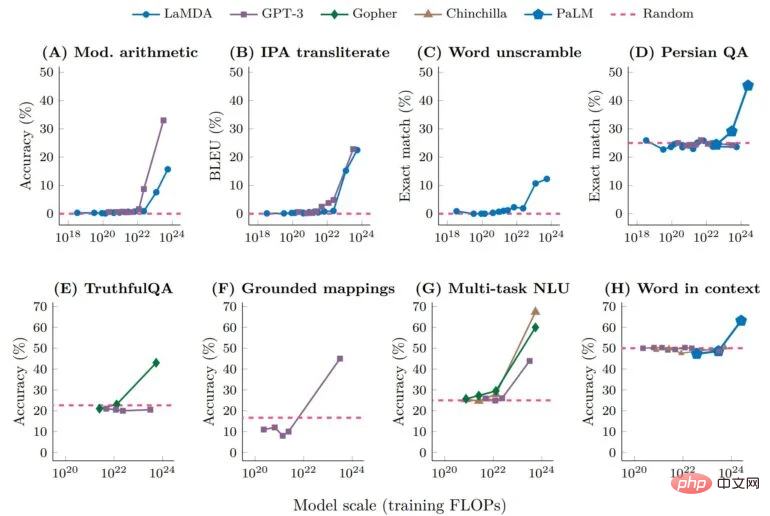

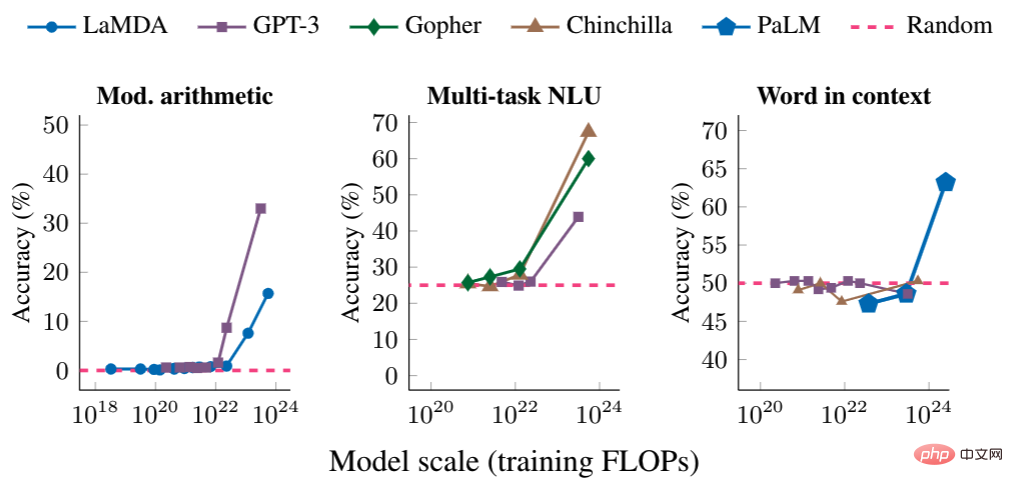

Im Folgenden zeigen wir drei Beispiele für schnelle Aufgaben mit „emergenter“ Leistung: mehrstufiges Rechnen, das Ablegen einer Prüfung auf Hochschulniveau und das Ermitteln der beabsichtigten Bedeutung eines Wortes.

In jedem Fall ist die Leistung von Sprachmodellen schlecht und hängt kaum von der Modellgröße ab, bis ein bestimmter Schwellenwert erreicht wird – wo ihre Leistung ansteigt.

Bei Modellen mit ausreichendem Maßstab wird die Leistung dieser Aufgaben nur nicht zufällig – beispielsweise werden arithmetische und Multitasking-NLU-Aufgaben pro Sekunde trainiert Die Anzahl der Gleitkommaoperationen (FLOP) übersteigt 10 hoch 22, und die Trainings-FLOP der Wörter in der Kontextaufgabe übersteigt 10 hoch 24.

„Emergente“ Prompt-Strategie

Die zweite Kategorie der „emergenten“ Fähigkeiten umfasst Prompt-Strategien, die die Fähigkeiten von Sprachmodellen verbessern.

Prompt-Strategie ist ein umfassendes Paradigma für Prompts, das auf eine Reihe unterschiedlicher Aufgaben angewendet werden kann. Sie gelten als „emergent“, wenn sie bei kleinen Modellen versagen und nur von ausreichend großen Modellen verwendet werden können.

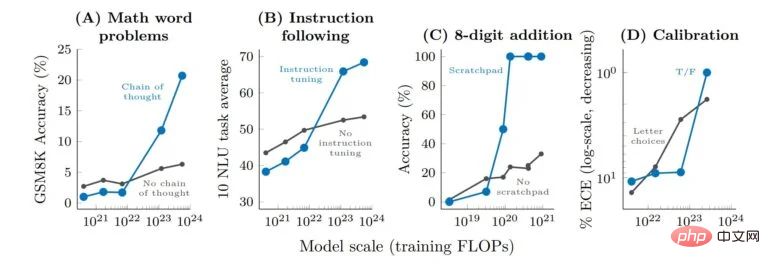

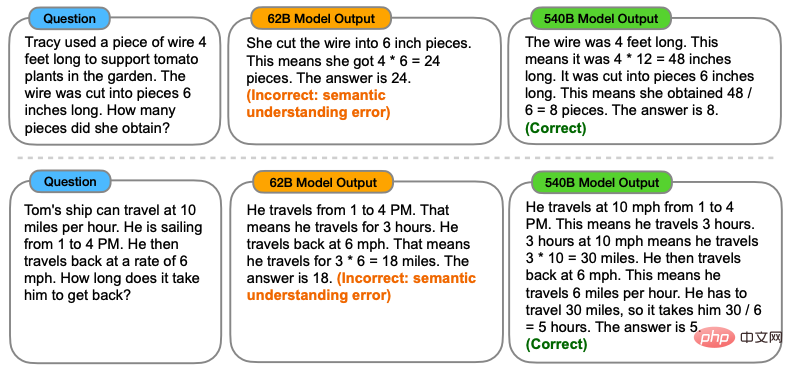

Gedankenketten-Prompts sind ein typisches Beispiel für die „emergente“ Prompt-Strategie und veranlassen das Modell, eine Reihe von Zwischenschritten zu generieren, bevor es die endgültige Antwort gibt.

Gedankenketten-Eingabeaufforderungen ermöglichen es Sprachmodellen, Aufgaben auszuführen, die komplexes Denken erfordern, wie beispielsweise mehrstufige mathematische Wortaufgaben.

Es ist erwähnenswert, dass das Modell die Fähigkeit zum Gedankenkettendenken ohne explizites Training erwerben kann. Die folgende Abbildung zeigt ein Beispiel für eine Gedankenkettenaufforderung.

Die empirischen Ergebnisse der Denkkettenaufforderung sind wie folgt.

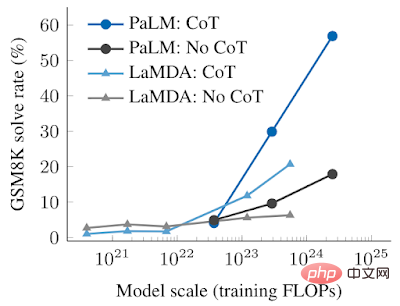

Bei kleineren Modellen übertrifft die Anwendung der Thought Chain-Eingabeaufforderung die Standardaufforderung nicht, z. B. bei GSM8K. ein anspruchsvoller mathematischer Textaufgaben-Benchmark.

Bei großen Modellen erreichten Thought Chain-Eingabeaufforderungen jedoch eine Lösungsrate von 57 % auf GSM8K, was die Leistung in unseren Tests erheblich verbesserte.

Die Bedeutung des Studiums „aufkommender“ Fähigkeiten

Was ist also die Bedeutung des Studiums „aufkommender“ Fähigkeiten?

Die Identifizierung „aufkommender“ Fähigkeiten in großen Sprachmodellen ist der erste Schritt zum Verständnis dieses Phänomens und seiner möglichen Auswirkungen auf zukünftige Modellfähigkeiten.

Da beispielsweise die „aufkommenden“ Fähigkeiten und Strategien zur Eingabeaufforderung bei kleinen Stichproben nicht explizit im Vortraining kodiert sind, kennen Forscher die Fähigkeiten zur Eingabeaufforderung bei kleinen Stichproben möglicherweise nicht der aktuellen Sprachmodelle.

Darüber hinaus ist auch die Frage sehr wichtig, ob eine weitere Erweiterung größeren Modellen möglicherweise „aufkommende“ Fähigkeiten verleihen wird.

- Warum erscheint die Fähigkeit „emergent“?

- Werden neue reale Anwendungen von Sprachmodellen freigeschaltet, wenn bestimmte Fähigkeiten auftauchen?

- Können neue Fähigkeiten durch andere Methoden (z. B. bessere Modellarchitektur oder Trainingstechniken) freigeschaltet werden, ohne die Skalierbarkeit zu erhöhen, da Rechenressourcen teuer sind?

Forscher sagen, dass diese Probleme noch nicht bekannt sind.

Da sich das NLP-Gebiet jedoch weiterentwickelt, ist es sehr wichtig, das Verhalten von Sprachmodellen zu analysieren und zu verstehen, einschließlich der „aufkommenden“ Fähigkeiten, die durch Skalierung entstehen .

Das obige ist der detaillierte Inhalt vonDie Parameter werden leicht verbessert und der Leistungsindex explodiert! Google: Große Sprachmodelle verbergen „mysteriöse Fähigkeiten'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr