Heim >Technologie-Peripheriegeräte >KI >Warten Sie, ChatGPT wird nicht fallen!

Warten Sie, ChatGPT wird nicht fallen!

- PHPznach vorne

- 2023-04-11 21:01:081867Durchsuche

Geschrieben von Yan Zheng

So lebhaft war es schon lange nicht mehr! Ein Produkt, das bei Menschen auf der ganzen Welt große Diskussionen hervorrufen kann, ist so wertvoll, dass ich darüber nachgedacht habe, während mein Gehirn auf Hochtouren lief, und es scheint, dass die einzige Möglichkeit, es zu beschreiben, darin besteht, den „iPhone-Moment“ von Nvidia-CEO Jensen Huang zu nutzen. um es zu beschreiben.

Fünf Tage nach dem Start überstieg die Zahl der Nutzer eine Million. Zwei Monate, monatliche Lebensdauer von 100 Millionen.

Wie hoch ist also der ROI der Teilnahme an ChatGPT? Der Herausgeber hat das Kosten- und Ertragsmodell von ChatGPT geklärt und kurz das Layout und die damit verbundenen Richtlinien inländischer Giganten sowie die Art und Weise besprochen, wie Entwickler darin investieren sollten. Ich hoffe, es kann allen helfen.

1. Wie viel kostet es, ein ChatGPT zu erstellen? Die Einführung von ChatGPT ist zwar der „iPhone-Moment“, die Kosten sind jedoch unverschämt. Hier finden Sie eine Zusammenstellung von Berechnungsdaten relevanter Institutionen, unterteilt in drei Aspekte: anfängliche Investitionskosten, Schulungskosten und Betriebskosten.

1. Anfängliche Investitionskosten

Guosheng Securities, ein bekanntes inländisches Wertpapierunternehmen, hat die von OpenAI zu diesem Zeitpunkt erforderlichen Rechenleistungskosten berechnet. Wenn man davon ausgeht, dass im Januar dieses Jahres durchschnittlich etwa 13 Millionen einzelne Besucher täglich ChatGPT nutzen, beträgt der entsprechende Chipbedarf mehr als 30.000 NVIDIA A100-GPUs, die anfänglichen Investitionskosten liegen bei etwa 800 Millionen US-Dollar und die tägliche Stromrechnung wird ebenfalls bei etwa 800 Millionen US-Dollar liegen 50.000 US-Dollar.

2. Schulungskosten

Mit dem Chip und der Rechenleistungsgrundlage sind auch die Schulungskosten des Modells eine große Schwelle. Guosheng Securities schätzt auf der Grundlage der Anzahl der Parameter und Token, dass die Kosten für das einmalige Training von GPT-3 etwa 1,4 Millionen US-Dollar betragen. Bei Verwendung derselben Berechnungsformel liegen die Trainingskosten für einige größere LLM-Modelle zwischen 2 und 12 Millionen US-Dollar. .

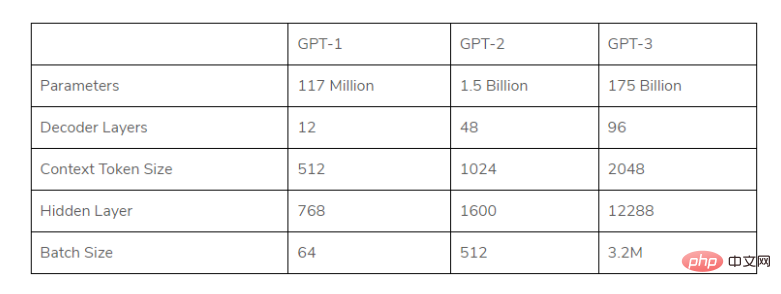

Bild: Übersicht über die GPT-Parameter jeder Generation (Im Rahmen des großen Modells hat das von ChatGPT verwendete GPT-Modell die Anzahl der Parameter in jeder Generation sowie die Anforderungen an das Datenvolumen schnell erweitert Die Kosten für die Vorschulung sind ebenfalls rapide gestiegen.

(Im Rahmen des großen Modells hat das von ChatGPT verwendete GPT-Modell die Anzahl der Parameter in jeder Generation sowie die Anforderungen an das Datenvolumen schnell erweitert Die Kosten für die Vorschulung sind ebenfalls rapide gestiegen.

3. Die Betriebskosten sind die Kosten für die Antwort: Musk fragte ChatGPT einmal auf der Twitter-Plattform: „Wie hoch sind die durchschnittlichen Kosten für jeden Chat?“ Altmann, CEO von OpenAI, erwartete eine leichte Verbitterung: Die durchschnittlichen Chat-Kosten von ChatGPT liegen bei „einstelligen Cent“ und sagte, dass Anstrengungen unternommen werden müssten, um die Kosten zu optimieren.

Was ist also diese „einstellige Zahl“? Der Autor erhielt die Antwort basierend auf den folgenden Daten.

· Im Januar 2023 hieß es in einem Analysebericht der Investmentbank Morgan Stanley, dass die Kosten für eine Antwort auf ChatGPT etwa das 6- bis 28-fache der durchschnittlichen Kosten einer Google-Suchanfrage betragen.

· Laut der neuesten Analyse von Morgan Stanley betrugen die durchschnittlichen Kosten für die 3,3 Billionen Google-Suchen im letzten Jahr jeweils etwa 0,2 Cent.

Daher ist ersichtlich, dass die ChatGPT-Chat-Antwortkosten 1,2 bis 5,6 Cent betragen.

Also, wie viele Beratungen gibt es jeden Tag? Nach Angaben von Similarweb zog die Website chat.openai.com (die offizielle Website von ChatGPT) Ende Januar 2023 in der Woche vom 27. Januar bis 3. Februar täglich bis zu 25 Millionen Besucher an.

Geht man davon aus, dass jeder Nutzer täglich etwa 10 Fragen stellt, ergeben sich täglich etwa 250 Millionen Beratungen. Daraus lässt sich schließen, dass allein zur Deckung der Chatkosten die täglichen Ausgaben zwischen 0,3 und 140 Millionen US-Dollar betragen. (Natürlich werden die Kosten langsam sinken.)

Dutzende Millionen Dollar sind nur die Eintrittsgebühr, und Operationen von mehreren zehn Millionen oder sogar über 100 Millionen Dollar pro Tag sind unerträglich!

Li Di, CEO der Xiaobing Company, hat eine Rechnung aufgestellt: „Wenn wir die Kosten von ChatGPT berücksichtigen, werde ich jeden Tag 300 Millionen Yuan und mehr als 100 Milliarden Yuan pro Jahr verbrennen.“

Kürzlich Google-Mutter Auch John Hennessy, Vorstandsvorsitzender des Unternehmens Alphabet, äußerte Bedenken hinsichtlich der Kosten: Die Kosten für die Suche auf Basis großer Sprachmodelle könnten zehnmal so hoch sein wie für die Standard-Schlüsselwortsuche Auswirkungen auf die Alphabet-Gruppe. Die Rentabilität wird sich auswirken

Die Schwelle ist also zu hoch, um einen echten „ChatGPT“ aufzubauen (der „Graben“ großer Unternehmen wird sehr tief sein), selbst für internationale Giganten wie Google. Denken Sie noch einmal darüber nach.

Zweitens: Können die enormen Investitionen und Ausgaben die erwarteten Einnahmen bringen? Der Nettoverlust belief sich offensichtlich auf 545 Millionen ChatGPT zweifelt nicht an seiner Monetarisierungsfähigkeit. Vor nicht allzu langer Zeit gab OpenAI bekannt, dass es in diesem Jahr einen Umsatz von 200 Millionen US-Dollar und im nächsten Jahr von 1 Milliarde US-Dollar erwartet. Derzeit ist das Gewinnmodell von OpenAI rund um ChatGPT grob geteilt in zwei Typen unterteilt:

1) Bereitstellung einer API-Datenschnittstelle, Durchführung von Verarbeitungsaufgaben in natürlicher Sprache und Abrechnung basierend auf der Anzahl der Zeichen;

2) ChatGPTPlus bietet Priorität für Antwort- und andere Privilegien in Zeiten hoher Serverauslastung und berechnet ein Abonnement Servicegebühr von 20 US-Dollar/Monat.

Wenn wir außerdem das neue Bing mit ChatGPT integrieren, wird diese konversationsbasierte intelligente Suche auch viele Werbeeinnahmen generieren

Allerdings scheint Altman, der Leiter von OpenAI, nicht viele Vorstellungen von der Kommerzialisierung zu haben. Er sagte zuvor zu diesem Thema: „Ich weiß es nicht.“ Geld anzuziehen übertrifft bei weitem unsere Vorstellung.

Zurück in China machen sich Unternehmen möglicherweise mehr Gedanken über Geschäftsszenarien, die Entscheidung, ob zuerst die B-Seite oder die C-Seite zuerst erstellt werden soll.

3. Der Elefant kämpft darum, der Erste zu sein, der einsatzbereit ist.

In einer Zeit, in der der Internetverkehr seinen Höhepunkt erreicht, sind Giganten damit beschäftigt, durchzubrechen. Im Bereich AIGC scheint es, dass große Technologieunternehmen einen Lichtblick gesehen und mit der aktiven Umsetzung begonnen haben, in der Hoffnung, diesen aufkommenden Technologietrend effektiv in Wettbewerbsvorteile auf dem Markt umzuwandeln.

KI-Forschungs- und Entwicklungsabteilungen wie Baidu Feipiao, Tencent Youtu, Alibaba Damo Academy, Byte und NetEase haben eine neue Wettbewerbsrunde für ChatGPT-ähnliche Produkte gestartet.

Tatsächlich ist die Entwicklung großer Modelle nicht neu. Viele inländische Unternehmen haben ihre eigenen Akkumulations- und Feldvorteile.

Aber derzeit ist Baidu derjenige, der in naher Zukunft herausragt.

Am Donnerstag betonte Baidu-Gründer Robin Li während der Telefonkonferenz zum vierten Quartal und zum Finanzbericht für das gesamte Jahr seine Begeisterung und Erwartungen für das bevorstehende „Wen Xin Yi Yan“ und sagte sogar: „Wir glauben, dass es die Cloud verändern wird.“ Die Regeln des Computerspiels.“ Autonomes Fahren, Xiaodu-Smart-Geräte usw. werden darin integriert. Unter anderem wird Wen Xinyiyan externe Dienste über die Baidu Smart Cloud bereitstellen. Der März naht und „Wen Xin Yi Yan“, das sich in der „Sprint-Phase“ befindet, steht kurz davor, aus seinem Kokon auszubrechen.

Mehr als 10 Jahre hohe Investitionen in Forschung und Entwicklung warten auf den Bruchpunkt. Die Suche ist auf das C-Ende ausgerichtet und die Smart Cloud auf das B-Ende, ein Elefant, der einst die Ära des mobilen Internets verpasst hat, läutet eine neue und umfassende „Tanz“-Möglichkeit ein.

4. Warum bleiben neue Begriffe bestehen?

Technische Konzepte tauchen endlos auf und weitere „Schlagworte“ können der Werbung nicht standhalten.

Als die Menschen das Metaversum das letzte Mal erwähnten, beschränkten sie sich auf die Vorstellung, „was ist das Metaversum“. Als die Menschen dann wiederholt über die „VUCA-Ära“ nachdachten, verschwanden die Stimmen allmählich.

Wenn ein möglicher Technologietrend in der Gesellschaft Fuß fassen will, muss er letzten Endes einen echten Mehrwert bieten. Die von ChatGPT repräsentierte AIGC-Technologie muss auch die Schwachstellen der „Schwierigkeiten bei der Implementierung von KI“ in der Vergangenheit überwinden und es der KI ermöglichen, sorgfältig zu denken und Innovationen einzuführen, um die Benutzererfahrung zu verbessern, neue Benutzererfahrungen zu schaffen und sozialen Wert zu schaffen. Und dieser Punkt ist auch der Kernpunkt.

Die gute Nachricht ist, dass wir seinen Wert erkennen. Textbasierte Aufgaben wie das Schreiben von E-Mails, Brainstorming, das Umschreiben von Code und das Schreiben von Zusammenfassungen können Praktikern tatsächlich viel Zeit und Kosten ersparen. Ich glaube, dass AIGC in Zukunft in verschiedenen Inhaltsszenarien wie Sprache, Bildern usw. zu sehen sein wird Videos. Keine schlechte Leistung.

Natürlich ist es neben den Grundwerten auch untrennbar mit dem Boden verbunden, der Innovationen fördert. Das Ministerium für Wissenschaft und Technologie antwortete gestern auch auf Fragen zu ChatGPT: „Unser Land hat entsprechende ethische Maßnahmen für jede neue Technologie, einschließlich der KI-Technologie, ergriffen, um Vorteile bei der Entwicklung von Wissenschaft und Technologie zu erzielen und Nachteile zu vermeiden.“ „Vorteile“ zu verbessern. Geben Sie die ungestüme Mentalität auf, dem Trend zu folgen, und entwickeln Sie ein solides Verständnis für die zu lösenden Probleme. Es ist pragmatischer, als nur der Aufregung zuzusehen, wie „die Aktien steigen und fallen“. OpenAI-Entwickler arbeiten beispielsweise an praktischen Möglichkeiten, die Kosten für das Modelltraining zu senken.

Am 25. sagte Wang Jian, Akademiker der Chinesischen Akademie für Ingenieurwissenschaften und Gründer von Alibaba Cloud, auf der Global Artificial Intelligence Pioneer Conference 2023: „Rechenleistung ist kein Engpass oder eine Entschuldigung mehr für Entwickler.“ Entwickler müssen ein umfassendes Verständnis der gesamten Branche haben und die Fähigkeiten und Grenzen des Algorithmus verstehen.

Wang Jian sagte, dass Entwickler, die wirklich künstliche Intelligenz auf höchstem Niveau entwickeln, der Idee folgen, Probleme zu finden und vorhandene Technologien zu ihrer Lösung zu nutzen, was tatsächlich ein Durchbruch ist.

„Es ist wichtig, dass man das Richtige zur richtigen Zeit tut.“

Das obige ist der detaillierte Inhalt vonWarten Sie, ChatGPT wird nicht fallen!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr