Heim >Technologie-Peripheriegeräte >KI >Das Diffusionsmodell generiert Bilder mit chinesischen Schriftzeichen und gibt Emoticons mit einem Klick aus: OPPO und andere schlugen GlyphDraw vor

Das Diffusionsmodell generiert Bilder mit chinesischen Schriftzeichen und gibt Emoticons mit einem Klick aus: OPPO und andere schlugen GlyphDraw vor

- 王林nach vorne

- 2023-04-11 20:13:141341Durchsuche

In letzter Zeit wurden im Bereich der textgenerierten Bilder viele unerwartete Durchbrüche erzielt, und viele Modelle können die Funktion erfüllen, auf der Grundlage von Textanweisungen hochwertige und vielfältige Bilder zu erstellen. Obwohl die erzeugten Bilder bereits sehr realistisch sind, sind aktuelle Modelle oft gut in der Lage, Bilder von physischen Objekten wie Landschaften und Objekten zu erzeugen, haben jedoch Schwierigkeiten, Bilder mit einem hohen Maß an kohärenten Details zu erzeugen, wie beispielsweise Bilder mit komplexem Glyphentext wie chinesischen Schriftzeichen .

Um dieses Problem zu lösen, haben Forscher von OPPO und anderen Institutionen ein allgemeines Lernframework GlyphDraw vorgeschlagen, das es dem Modell ermöglichen soll, Bilder mit eingebettetem kohärentem Text zu generieren. Dies ist die erste Arbeit auf dem Gebiet der Bilder Synthese zur Lösung des Problems der chinesischen Schriftzeichengenerierung.

- Papieradresse: https://arxiv.org/abs/2303.17870

- Projekthomepage: https://1073521013.github.io/glyph-draw.github.io/

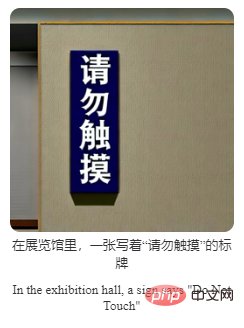

Schauen wir uns zunächst den Generierungseffekt an. Generieren Sie beispielsweise einen Warnslogan für die Messehalle:

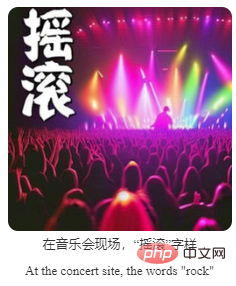

Erstellen Sie eine Werbetafel:

Fügen Sie einen kurzen Text hinzu Beschreibung zum Bild, Text Die Stile können auch variiert werden:

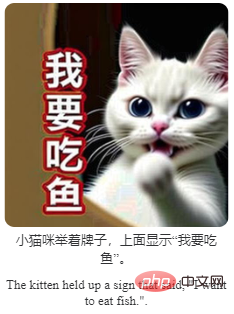

Das interessanteste und praktischste Beispiel ist auch die Generierung von Emoticons:

Obwohl die Ergebnisse einige Mängel aufweisen Der Gesamtgenerierungseffekt war sehr gut. Insgesamt gehören zu den Hauptbeiträgen dieser Forschung:

- Diese Forschung schlägt das erste Framework zur Generierung von Bildern chinesischer Schriftzeichen, GlyphDraw, vor, das einige Hilfsinformationen, einschließlich Glyphen und Positionen chinesischer Schriftzeichen, verwendet, um während der gesamten Generierung eine feinkörnige Bereitstellung bereitzustellen Prozessführung, wodurch Bilder mit chinesischen Schriftzeichen nahtlos in Bilder mit hoher Qualität eingebettet werden;

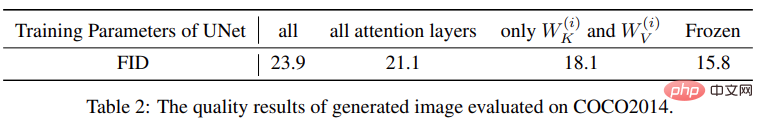

- Diese Studie schlägt eine effektive Trainingsstrategie vor, die die Anzahl der trainierbaren Parameter im vorab trainierten Modell begrenzt, um eine Überanpassung und katastrophales Vergessen zu verhindern Die leistungsstarke Open-Domain-Generierungsleistung des Modells ermöglicht gleichzeitig eine präzise Bildgenerierung chinesischer Schriftzeichen.

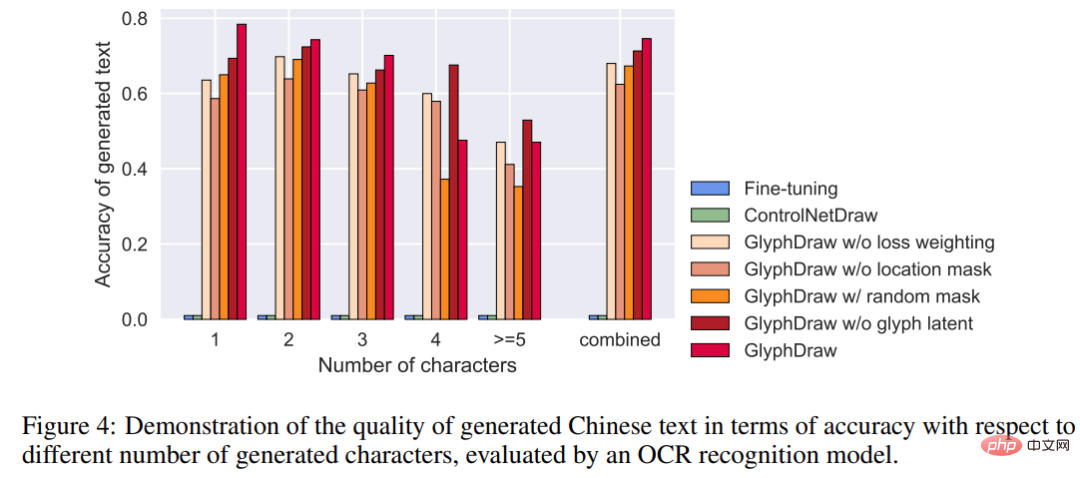

- Diese Studie stellt den Konstruktionsprozess des Trainingsdatensatzes vor und schlägt einen neuen Benchmark zur Bewertung der Qualität der Bildgenerierung chinesischer Schriftzeichen mithilfe von OCR-Modellen vor. Unter anderem erreichte GlyphDraw eine Generierungsgenauigkeit von 75 %, was deutlich besser ist als frühere Bildsynthesemethoden.

Modelleinführung

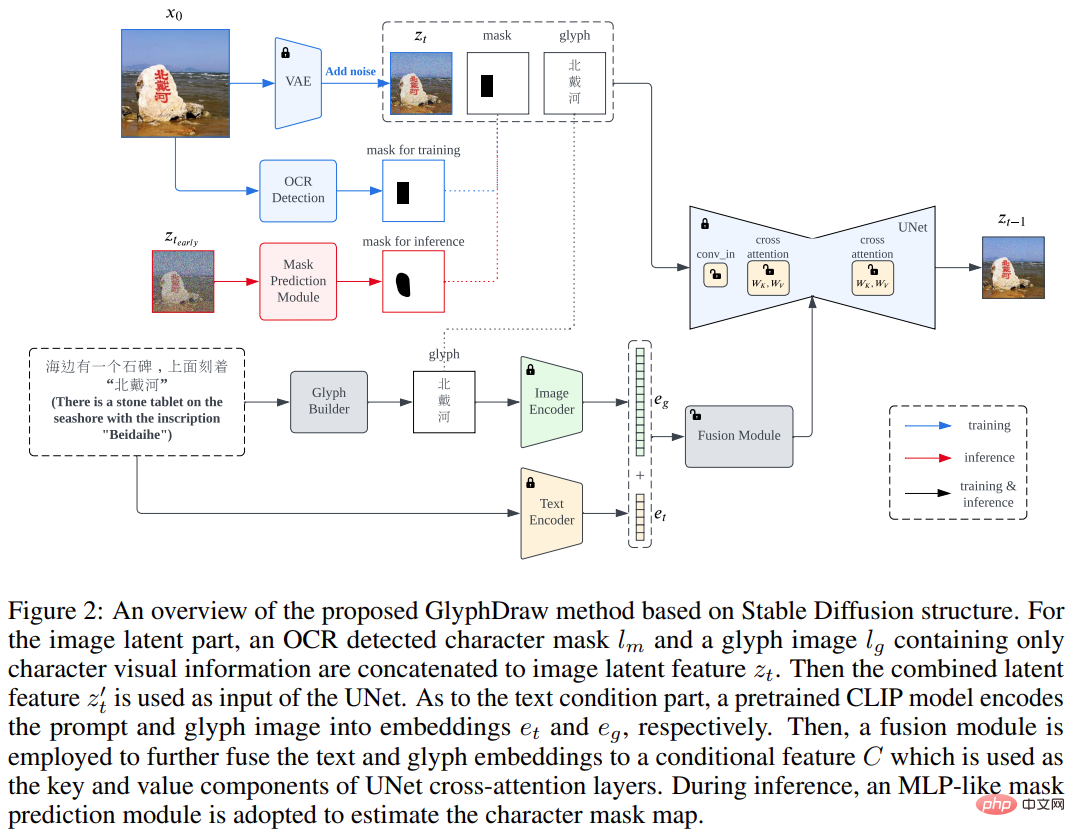

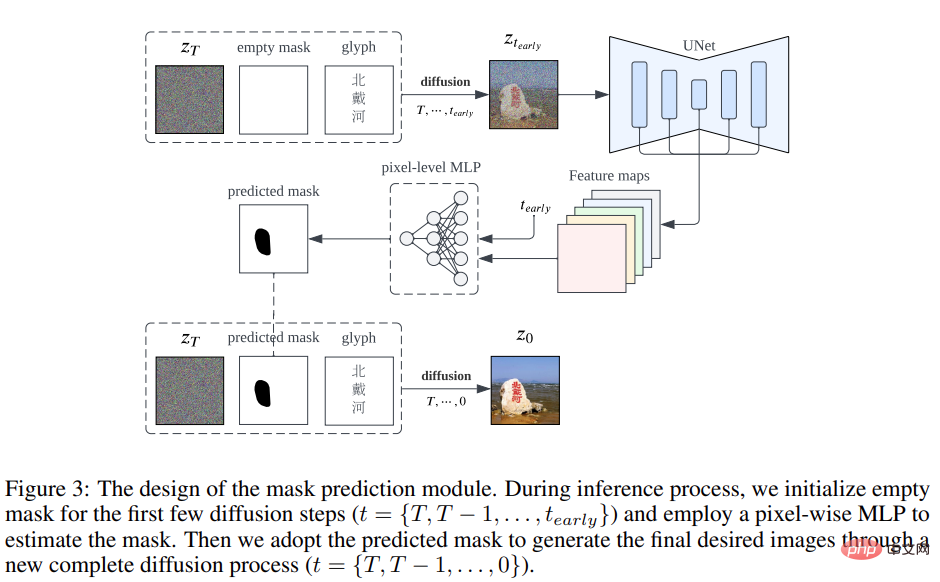

Diese Studie entwarf zunächst eine komplexe Strategie zur Konstruktion von Bild-Text-Datensätzen und schlug dann ein allgemeines Lernframework GlyphDraw vor, das auf dem Open-Source-Bildsynthesealgorithmus Stable Diffusion basiert, wie in gezeigt Abbildung 2 unten.

Das allgemeine Trainingsziel der stabilen Diffusion kann als folgende Formel ausgedrückt werden:

GlyphDraw basiert auf dem Kreuzaufmerksamkeitsmechanismus in Stable Diffusion, bei dem der ursprüngliche latente Eingabevektor z_t durch eine Verkettung des latenten Bildvektors z_t, der Textmaske l_m und des Glyphenbilds l_g ersetzt wird.

Darüber hinaus ist Bedingung C durch den Einsatz domänenspezifischer Fusionsmodule mit hybriden Glyphen- und Textfunktionen ausgestattet. Durch die Einführung von Textmasken- und Glypheninformationen kann im gesamten Trainingsprozess eine feinkörnige Diffusionskontrolle erreicht werden, die eine Schlüsselkomponente zur Verbesserung der Modellleistung darstellt und letztendlich Bilder mit chinesischem Schriftzeichentext generiert.

Insbesondere die Pixeldarstellung von Textinformationen, insbesondere komplexer Textformen wie piktografische chinesische Schriftzeichen, unterscheidet sich erheblich von natürlichen Objekten. Beispielsweise besteht das chinesische Wort „Himmel“ aus mehreren Strichen in einer zweidimensionalen Struktur, und sein entsprechendes natürliches Bild ist „blauer Himmel mit weißen Wolken übersät“. Im Gegensatz dazu haben chinesische Schriftzeichen sehr feinkörnige Eigenschaften und selbst kleine Bewegungen oder Verformungen können zu einer fehlerhaften Textwiedergabe führen, wodurch die Bilderzeugung unmöglich wird.

Beim Einbetten von Zeichen in natürliche Bildhintergründe ist außerdem ein wichtiges Problem zu berücksichtigen: Die Erzeugung von Textpixeln genau zu steuern und gleichzeitig zu vermeiden, dass benachbarte natürliche Bildpixel beeinträchtigt werden. Um perfekte chinesische Schriftzeichen auf natürlichen Bildern wiederzugeben, haben die Autoren sorgfältig zwei Schlüsselkomponenten entworfen, die in das Diffusionssynthesemodell integriert sind, nämlich Positionskontrolle und Glyphenkontrolle.

Im Gegensatz zur globalen bedingten Eingabe anderer Modelle muss bei der Zeichengenerierung bestimmten lokalen Bereichen des Bildes mehr Aufmerksamkeit geschenkt werden, da sich die latente Merkmalsverteilung von Zeichenpixeln stark von der natürlicher Bildpixel unterscheidet. Um zu verhindern, dass das Modelllernen zusammenbricht, schlägt diese Studie innovativ eine feinkörnige Standortbereichskontrolle vor, um die Verteilung zwischen verschiedenen Bereichen zu entkoppeln.

Neben der Positionskontrolle ist ein weiteres wichtiges Thema die Feinsteuerung der Strichsynthese chinesischer Schriftzeichen. Angesichts der Komplexität und Vielfalt chinesischer Schriftzeichen ist es äußerst schwierig, ohne explizite Vorkenntnisse einfach aus großen Bild-Text-Datensätzen zu lernen. Um chinesische Schriftzeichen genau zu generieren, bezieht diese Studie explizite Glyphenbilder als zusätzliche bedingte Informationen in den Modelldiffusionsprozess ein.

Experimente und Ergebnisse

Da es keinen vorherigen Datensatz speziell für die Generierung chinesischer Schriftzeichenbilder gibt, wurde in dieser Studie zunächst ein Benchmark-Datensatz ChineseDrawText für die qualitative und quantitative Bewertung erstellt und dann auf die Genauigkeit der ChineseDrawText-Generierung getestet und verglichen mehrerer Methoden (ausgewertet durch OCR-Erkennungsmodell).

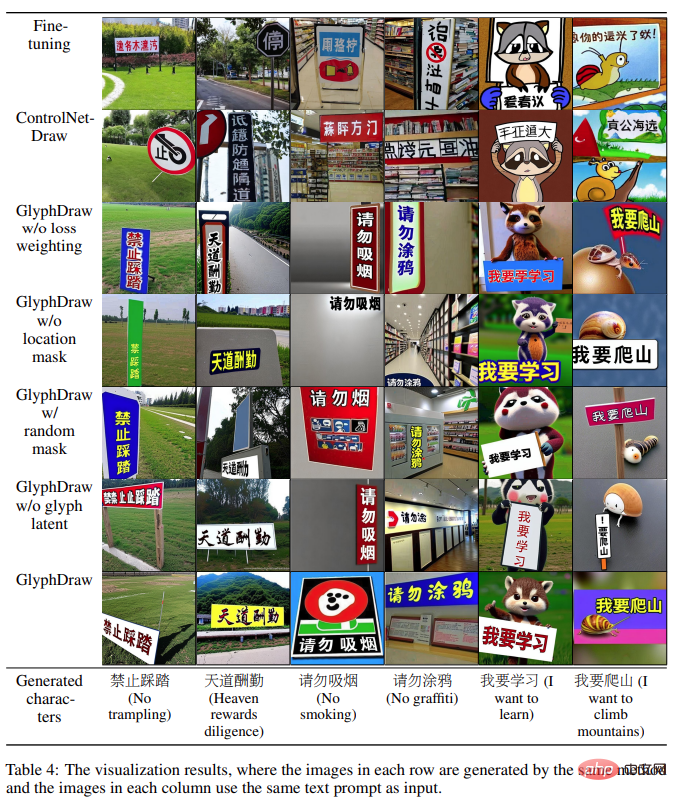

Das in dieser Studie vorgeschlagene GlyphDraw-Modell erreichte durch die effektive Nutzung von Hilfsglyphen- und Positionsinformationen eine durchschnittliche Genauigkeit von 75 % und demonstrierte damit die hervorragenden Fähigkeiten des Modells zur Zeichenbildgenerierung. Die visuellen Vergleichsergebnisse mehrerer Methoden sind in der folgenden Abbildung dargestellt:

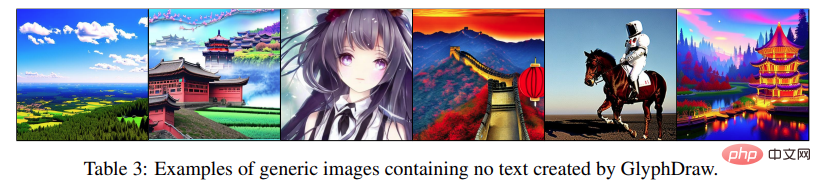

Darüber hinaus kann GlyphDraw auch die Leistung der Bildsynthese im offenen Bereich aufrechterhalten, indem die Trainingsparameter begrenzt werden. Der FID der allgemeinen Bildsynthese auf MS-COCO FID. 10.000 werden nur um 2,3 gesenkt.

Interessierte Leser können den Originaltext des Artikels lesen, um weitere Forschungsdetails zu erfahren.

Das obige ist der detaillierte Inhalt vonDas Diffusionsmodell generiert Bilder mit chinesischen Schriftzeichen und gibt Emoticons mit einem Klick aus: OPPO und andere schlugen GlyphDraw vor. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr