Heim >Technologie-Peripheriegeräte >KI >Zwei Gerüchte und aktuelle Vorhersagen für GPT-4!

Zwei Gerüchte und aktuelle Vorhersagen für GPT-4!

- 王林nach vorne

- 2023-04-11 18:07:031188Durchsuche

Autor |. Yun Zhao

Am 9. März brachte Andreas Braun, CTO von Microsoft Deutschland, auf der KI-Auftaktkonferenz eine lang erwartete Neuigkeit: „Wir werden nächste Woche GPT-4 starten, wenn wir Multimodal starten.“ Modi, die völlig unterschiedliche Möglichkeiten bieten – wie Videos Dinge, die bisher nur von Menschen gelesen und verstanden werden konnten. Gleichzeitig hat sich die Technologie dahingehend weiterentwickelt, dass sie „für alle Sprachen verfügbar“ ist: Sie können Fragen auf Deutsch stellen und auf Italienisch antworten. Mit Multimodalität wird Microsoft (-OpenAI) „Modelle umfassend machen“.

Es scheint grundsätzlich sicher zu sein, dass GPT-4 ein großes multimodales Modell sein wird. Wenn Sie jedoch die wahre Identität von GPT-4 im Voraus wissen möchten, ist es nicht unmöglich, sie zu finden.

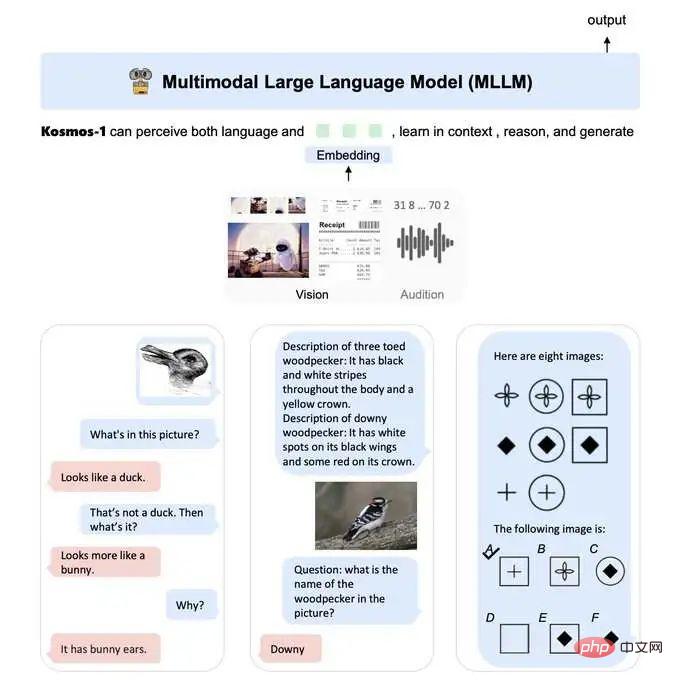

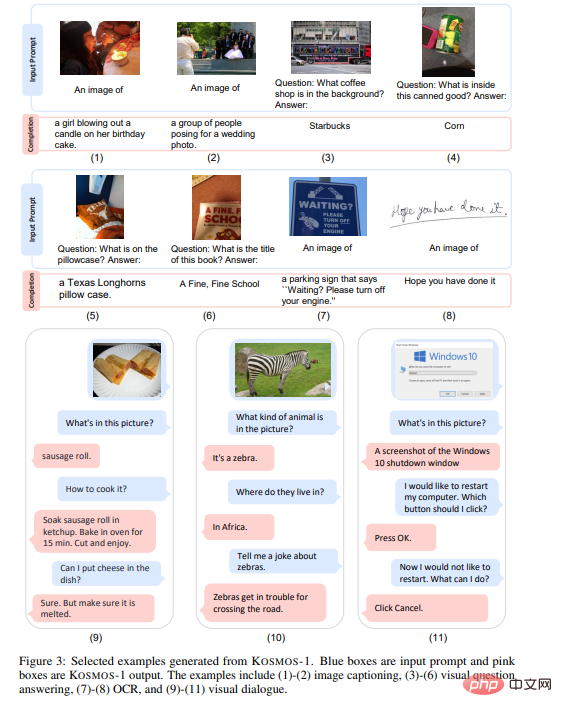

KOSMOS-1 ist ein multimodales großes Sprachmodell (MLLM), das in der Lage ist, multimodale Eingaben wahrzunehmen, Anweisungen zu befolgen und Kontextlernaufgaben durchzuführen, bei denen es sich auch um multimodale Aufgaben handeln kann. In dieser Arbeit richten wir unsere Vision an großen Sprachmodellen (LLMs) aus und treiben so die Entwicklung von LLMs zu MLLMs voran.

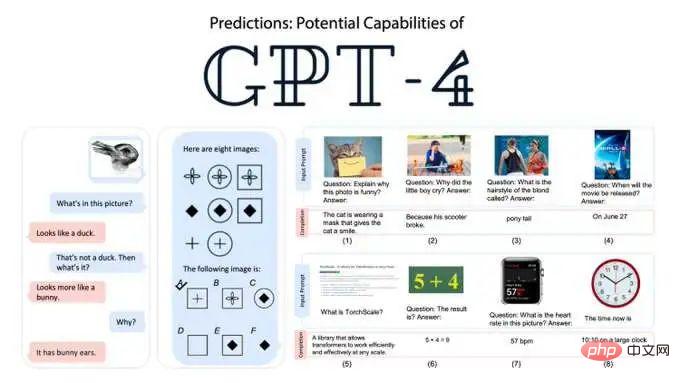

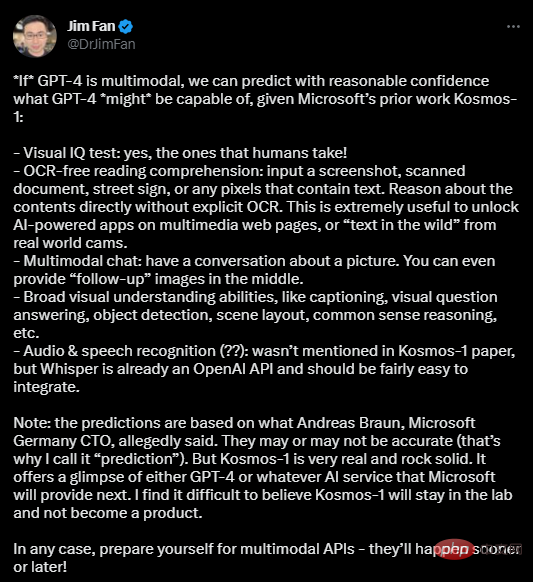

Der Stanford Ph.D. und der NVIDIA-KI-Wissenschaftler Jim Fan haben auf dieser Grundlage 5 konkrete Vorhersagen getroffen:

(1) Visueller IQ-Test: Ja, ein Test für Menschen! (2) Kein OCR-Leseverständnis: Eingabe-Screenshots, gescannte Dokumente, Straßenschilder oder Pixel mit Text. Argumentieren Sie direkt über Inhalte ohne explizite OCR. Dies ist nützlich, um KI-gesteuerte Anwendungen auf Multimedia-Webseiten oder „Text in freier Wildbahn“ von realen Kameras freizuschalten. (3) Multimodaler Chat: Unterhalten Sie sich über Bilder. Sie können sogar nach der Hälfte der Bearbeitung ein „Folgebild“ bereitstellen. (4) Umfangreiche visuelle Verständnisfunktionen wie Untertitel, visuelle Fragen und Antworten, Objekterkennung, Szenenlayout, logisches Denken usw. (5) Audio- und Spracherkennung: Im Kosmos-1-Papier nicht erwähnt, aber Whisper ist bereits eine OpenAI-API und sollte einfach zu integrieren sein. Jim glaubt, dass es aufgrund der jüngsten Ankündigung von Andreas einige Abweichungen bei den Vorhersagen geben könnte. Aber Kosmos-1 hat dies bereits getan. Es gibt Grund zu der Annahme, dass es Funktionen für GPT-4 oder jeden KI-Dienst bereitstellt, den Microsoft als nächstes anbieten wird. „Es ist kaum zu glauben, dass Kosmos-1 im Labor bleibt und kein Produkt wird.“

Beispiele für multimodale Großmodellanwendungen: Bilderfassung, Bildfrage und -antwort, OCR, visueller Dialog

Jim rät Praktikern: „Bitte seien Sie auf multimodale APIs vorbereitet – sie werden früher oder später kommen Wird erscheinen! „

Zweitens gibt es nicht genügend Daten. Obwohl der multimodale GPT-4 im Begriff ist, leistungsstarke Seh-, Hör-, Leseverständnis- und Denkfähigkeiten zu demonstrieren, ist dies nur die Spitze des Eisbergs von AGI. Am Beispiel humanoider Roboter ist es schwierig, die Steuerungsdaten zu vereinheitlichen der Roboter und „Diese Steuerdaten hängen mit der Roboterhardware zusammen und variieren stark.“ Daher können Trainingsdaten verschiedener realer Roboter nicht einfach kombiniert werden, was sich qualitativ von Daten wie Text, Video, Bild, Audio usw. unterscheidet.

3. Zwei Gerüchte über GPT-4

1. Gefälscht!

GPT-4 ist ein neues Sprachmodell, das von OpenAI entwickelt wird und Text erzeugen kann, der der menschlichen Sprache ähnelt. Es wird die von ChatGPT verwendete Technologie weiterentwickeln, die auf GPT-3.5 basiert.

Bereits im August 2021 spekulierten Branchenexperten, dass GPT-4 100 Billionen Parameter haben würde, aber einige Leute sagten damals: Der Aufbau einer KI mit mehr Parametern garantiert nicht unbedingt eine bessere Leistung und kann sich auf die Reaktionsfähigkeit auswirken.

Aber Altman, der Vater von ChatGPT, widerlegte schnell die Gerüchte: Die nächste Version von ChatGPT wird weder AGI sein noch 100 Billionen Parameter haben. Diese Gerüchte sind unwahr.

2.Verwendet der Bing-Chat GPT-4?

Microsoft hat gesagt, dass das neue Bing oder Bing Chat leistungsfähiger ist als ChatGPT. Da der Chat von OpenAI GPT-3.5 verwendet, spekulieren einige, dass der Bing-Chat möglicherweise GPT-4 verwendet. Dies wurde nicht bestätigt.

Offensichtlich wurde Bing Chat aktualisiert, um Zugriff auf aktuelle Informationen über das Internet zu ermöglichen, was eine enorme Verbesserung gegenüber ChatGPT darstellt, das bisher nur von Trainingsdaten profitieren konnte, die vor 2021 eingegangen sind.

Neben dem Internetzugang sind die für den Bing-Chat verwendeten KI-Modelle viel schneller, was sehr wichtig ist, wenn sie aus dem Labor genommen und der Suchmaschine hinzugefügt werden.

Aber es scheint unwahrscheinlich, dass dies mit dem GPT-4-Modell von OpenAI gleichwertig ist. Wenn GPT-4 bereits öffentlich verfügbar ist, besteht keine Notwendigkeit mehr, es geheim zu halten.

4. GPT-4: Eine Evolution, keine Revolution

Es besteht kein Zweifel, dass das kommende GPT-4 die Leute definitiv beeindrucken wird, aber OpenAI-CEO Sam Altman wurde von StrictlyVC interviewt: „Die Leute ‚betteln‘ darum.“ „Wir sind enttäuscht, und sie werden enttäuscht sein“, sagte Altman. Altman twitterte zuvor auch über das Potenzial von AGI, der Weltwirtschaft großen Schaden zuzufügen, und sagte, dass ein paar kleine Änderungen schnell umgesetzt würden. , ist besser als alarmierende Fortschritte, die wenig Chancen bieten damit sich die Welt an Veränderungen anpassen kann.

Zufälligerweise hat der Weltklasse-Meister der künstlichen Intelligenz, Ben Goertzel, auch viel kaltes Wasser auf GPT-3/GPT-4 gegossen:

Natürlich sollten die Leute jetzt bemerken, dass in diese „Wissensumordnungs“-Systeme investiert wird (z. B. Der Betrag an Geld und Arbeitskraft, der in ChatGPT investiert wird, ist weitaus größer als der Betrag, der in alternative KI-Ansätze investiert wird, die die Komplexität fundierter, selbstkorrigierender Kognition stärker berücksichtigen.

Die umfassende Skepsis gegenüber mehrschichtigen neuronalen Netzen und der Einführung von Expertensystemen in den späten 1970er und frühen 1990er Jahren schien naiv, archaisch und dumm, ähnlich wie heute.

? Sie sind weder cool noch nützlich – es handelt sich lediglich um eine trendige neue, schmale KI-Technologie, die nicht so stark mit AGI verbunden ist, wie es scheint oder wie einige Kommentatoren behaupten. Kurz gesagt: GPT-4 wird eine Weiterentwicklung sein, keine Revolution. 5. Am Ende geschrieben Natürlich wird ChatGPT 4 wahrscheinlich nicht der Name des nächsten Produkts von OpenAI sein, aber es wird sehr wahrscheinlich etwas kreative Fantasie mit sich bringen Modell, das die Verbesserung von GPT-4 vorantreibt. KI-Praktiker und -Manager müssen sich auf den aktuellen Arbeitsfortschritt von GPT-4 und ChatGPT konzentrieren und darauf, wann OpenAI möglicherweise das nächste große Upgrade veröffentlicht. Abschließend möchte ich allen sagen, dass es keine Rolle spielt, ob die Veröffentlichung von GPT-4 nächste Woche mit den Vorhersagen dieses Artikels übereinstimmt, einschließlich des großen inländischen Modells „Wen Xinyiyan“, auf das wir uns freuen . Entscheidend ist, ob Entwickler oder ihre Unternehmen bereit sind, multimodale APIs für große Modelle zu nutzen. Welch ein Glück, dass all dies hoffentlich noch vor 2024 geschehen wird! Referenzlink: https://arxiv.org/abs/2302.14045https://www.heise.de/news/GPT-4-is-coming-next-week-and-it- will-be-multimodal-says-Microsoft-Germany-7540972.htmlhttps://t.co/JbtQvjoJ3WDas obige ist der detaillierte Inhalt vonZwei Gerüchte und aktuelle Vorhersagen für GPT-4!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr