Heim >Technologie-Peripheriegeräte >KI >OpenAI hat offiziell eine KI-generierte Inhaltskennung eingeführt, aber die Erfolgsquote liegt bei nur 26 % der Internetnutzer: Es ist nicht so gut wie ein Tool zur Überprüfung von Papierplagiaten.

OpenAI hat offiziell eine KI-generierte Inhaltskennung eingeführt, aber die Erfolgsquote liegt bei nur 26 % der Internetnutzer: Es ist nicht so gut wie ein Tool zur Überprüfung von Papierplagiaten.

- PHPznach vorne

- 2023-04-11 15:19:031374Durchsuche

Viele Leute haben vielleicht vergessen, dass ChatGPT Ende November letzten Jahres offiziell veröffentlicht wurde, und das sind jetzt erst zwei Monate her, aber der Hype, den es auslöste, hat dazu geführt, dass Technologieunternehmen nacheinander nachzogen Ein weiterer Grund war die Geburt von Einhörnern. Das Startup-Unternehmen forderte außerdem die akademische Gemeinschaft auf, die Anforderungen für die Papierakzeptanz zu ändern.

Nachdem ChatGPT im KI-Bereich eine große Diskussion darüber ausgelöst hat, „ob es verboten werden soll“, ist das Authentizitätsidentifizierungstool von OpenAI endlich da.

Am 31. Januar kündigte OpenAI offiziell die Einführung eines Erkennungstools zur Unterscheidung zwischen menschlichen Werken und KI-generiertem Text an. Diese Technologie soll seinen eigenen ChatGPT identifizieren. GPT-3 usw. Vom Modell generierter Inhalt. Allerdings scheint die Genauigkeit des Klassifikators derzeit besorgniserregend zu sein: OpenAI wies im Blog darauf hin, dass die Genauigkeitsrate der AI-Identifizierung mit hoher Konfidenz bei etwa 26 % liegt. Die Agentur ist jedoch davon überzeugt, dass es in Verbindung mit anderen Methoden dazu beitragen kann, den Missbrauch von KI-Textgeneratoren zu verhindern.

„Der Zweck unseres vorgeschlagenen Klassifikators besteht darin, die Verwirrung zu reduzieren, die durch durch künstliche Intelligenz generierten Text verursacht wird. Allerdings weist er noch einige Einschränkungen auf, daher sollte er als verwendet werden „anders als Ergänzung zu Methoden zur Bestimmung der Textquelle und nicht als primäres Entscheidungsinstrument“, sagte ein OpenAI-Sprecher den Medien per E-Mail. „Wir verwenden diesen ersten Klassifikator, um Rückmeldungen darüber zu erhalten, ob solche Tools nützlich sind, und hoffen, Möglichkeiten zur künftigen Verbesserung zu teilen.“ Die Begeisterung für generative KI, insbesondere für textgenerierende KI, wächst, aber ihr stehen Bedenken gegenüber Missbrauch, wobei Kritiker die Entwickler dieser Tools auffordern, Maßnahmen zu ergreifen, um ihre potenziell schädlichen Auswirkungen abzuschwächen.

Angesichts der riesigen Menge an KI-generierten Inhalten haben einige Branchen sofort Beschränkungen verhängt. Einige der größten Schulbezirke in den Vereinigten Staaten haben die Verwendung von ChatGPT verboten ihre Netzwerke und Geräte, aus Angst vor den Auswirkungen des Lernens der Schüler und der Genauigkeit der vom Tool generierten Inhalte. Websites wie Stack Overflow haben Benutzern außerdem verboten, von ChatGPT generierte Inhalte zu teilen, mit der Begründung, dass künstliche Intelligenz dazu führen wird, dass Benutzer in normalen Diskussionen mit nutzlosen Inhalten überschwemmt werden. Diese Situationen verdeutlichen den Bedarf an KI-Erkennungstools. Obwohl der Effekt nicht zufriedenstellend ist, erreicht der OpenAI AI Text Classifier ein Architektur-Benchmarking mit der GPT-Serie. Wie ChatGPT handelt es sich um ein Sprachmodell, das anhand vieler öffentlicher Textbeispiele aus dem Web trainiert wird. Im Gegensatz zu ChatGPT ist es darauf abgestimmt, die Wahrscheinlichkeit vorherzusagen, dass ein Text von KI generiert wurde – nicht nur von ChatGPT, sondern von jedem textgenerierenden KI-Modell.

Konkret trainierte OpenAI seinen KI-Textklassifizierer auf Text aus 34 Textgenerierungssystemen von fünf verschiedenen Organisationen, darunter OpenAI selbst. Diese wurden mit ähnlichen (aber nicht identischen) künstlichen Texten aus Wikipedia, Websites, die aus auf Reddit geteilten Links entnommen wurden, und einer Reihe „menschlicher Demos“, die für das OpenAI-Textgenerierungssystem gesammelt wurden, gepaart.

Es ist zu beachten, dass der OpenAI-Textklassifizierer nicht mit allen Texttypen funktioniert. Der erkannte Inhalt muss mindestens 1000 Zeichen oder etwa 150 bis 250 Wörter umfassen. Es verfügt nicht über die Plagiatsprüfungsfunktionen von Papiererkennungsplattformen – eine sehr unangenehme Einschränkung, wenn man bedenkt, dass textgenerierende KI nachweislich „richtige Antworten“ aus Trainingssätzen kopiert. OpenAI sagte, dass aufgrund seines englischsprachigen Datensatzes die Wahrscheinlichkeit größer sei, Fehler bei Texten zu machen, die von Kindern oder in anderen Sprachen als Englisch geschrieben wurden.

Es ist zu beachten, dass der OpenAI-Textklassifizierer nicht mit allen Texttypen funktioniert. Der erkannte Inhalt muss mindestens 1000 Zeichen oder etwa 150 bis 250 Wörter umfassen. Es verfügt nicht über die Plagiatsprüfungsfunktionen von Papiererkennungsplattformen – eine sehr unangenehme Einschränkung, wenn man bedenkt, dass textgenerierende KI nachweislich „richtige Antworten“ aus Trainingssätzen kopiert. OpenAI sagte, dass aufgrund seines englischsprachigen Datensatzes die Wahrscheinlichkeit größer sei, Fehler bei Texten zu machen, die von Kindern oder in anderen Sprachen als Englisch geschrieben wurden.

Bei der Bewertung, ob ein bestimmter Text von KI generiert wurde, gibt der Detektor keine positive Ja- oder Nein-Antwort. Je nach Konfidenzniveau markiert es den Text als „sehr unwahrscheinlich“, dass er von KI generiert wird (weniger als 10 % Wahrscheinlichkeit), „unwahrscheinlich“, dass er von KI generiert wird (zwischen 10 % und 45 % Wahrscheinlichkeit), „Unklar, ob.“ es war „KI-generiert (45 % bis 90 % Wahrscheinlichkeit), „möglicherweise“ KI-generiert (90 % bis 98 % Chance) oder „sehr wahrscheinlich“ KI-generiert (mehr als 98 % Chance).

sieht der Bilderkennungs-KI sehr ähnlich, abgesehen von der Genauigkeit. Laut OpenAI etikettiert der Klassifikator in 9 % der Fälle von Menschen geschriebenen Text fälschlicherweise als KI-geschriebenen Text.

Nach einigen Versuchen ist der Effekt tatsächlich nicht sehr gut

OpenAI gibt an, dass die Erfolgsquote seines KI-Textklassifikators bei etwa 26 % liegt. Nachdem einige Internetnutzer es ausprobiert hatten, stellten sie fest, dass der Erkennungseffekt tatsächlich nicht gut war.

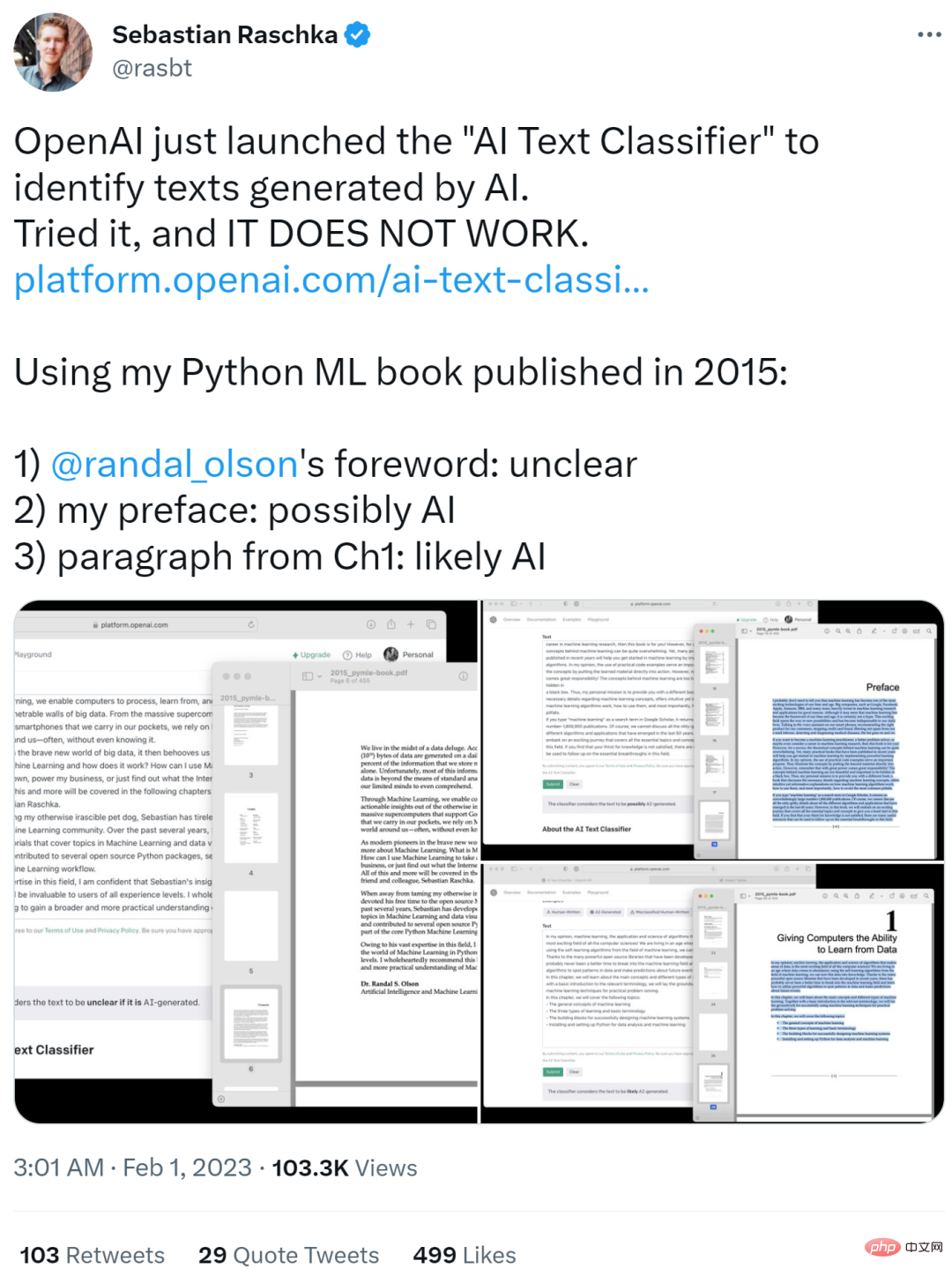

Nach dem Ausprobieren kommentierte Sebastian Raschka, ein bekannter ML- und KI-Forscher: „Es funktioniert nicht.“ Als Eingabetext verwendete er sein Python ML-Buch aus der Originalausgabe von 2015 und die Ergebnisse sind unten dargestellt.

- Randy Olsons Vorwortteil wurde als Unklar

- Sein eigener Vorwortteil wurde als möglicherweise KI) identifiziert

- Der Absatzteil des ersten Kapitels wurde identifiziert wie wahrscheinlich durch KI erzeugt (wahrscheinlich KI)

Sebastian Raschka sagte, dies sei ein interessantes Beispiel, hatte aber bereits Mitleid mit den Studenten, die für unverschämte Aufsatzerkennungsergebnisse bestraft werden könnten die Zukunft.

Also schlug er vor, dass Sie, wenn Sie ein solches Modell einsetzen möchten, bitte eine Verwirrungsmatrix teilen. Andernfalls könnte die Übernahme dieses Modells für die Benotung durch Lehrkräfte in der Praxis zu Schäden führen. Es sollte auch eine gewisse Transparenz hinsichtlich falsch positiver und falsch negativer Ergebnisse herrschen.

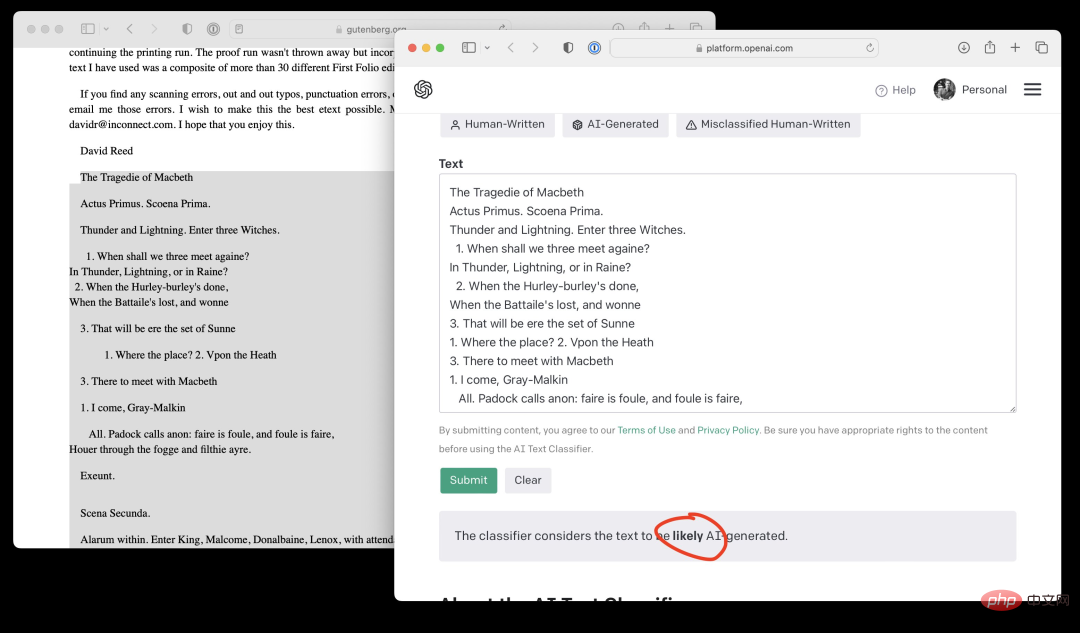

Darüber hinaus gab Sebastian Raschka den Inhalt der ersten Seite von Shakespeares „Macbeth“ ein und der OpenAI AI-Textklassifikator lieferte Ergebnisse, die wahrscheinlich von KI generiert wurden. Einfach unverschämt!

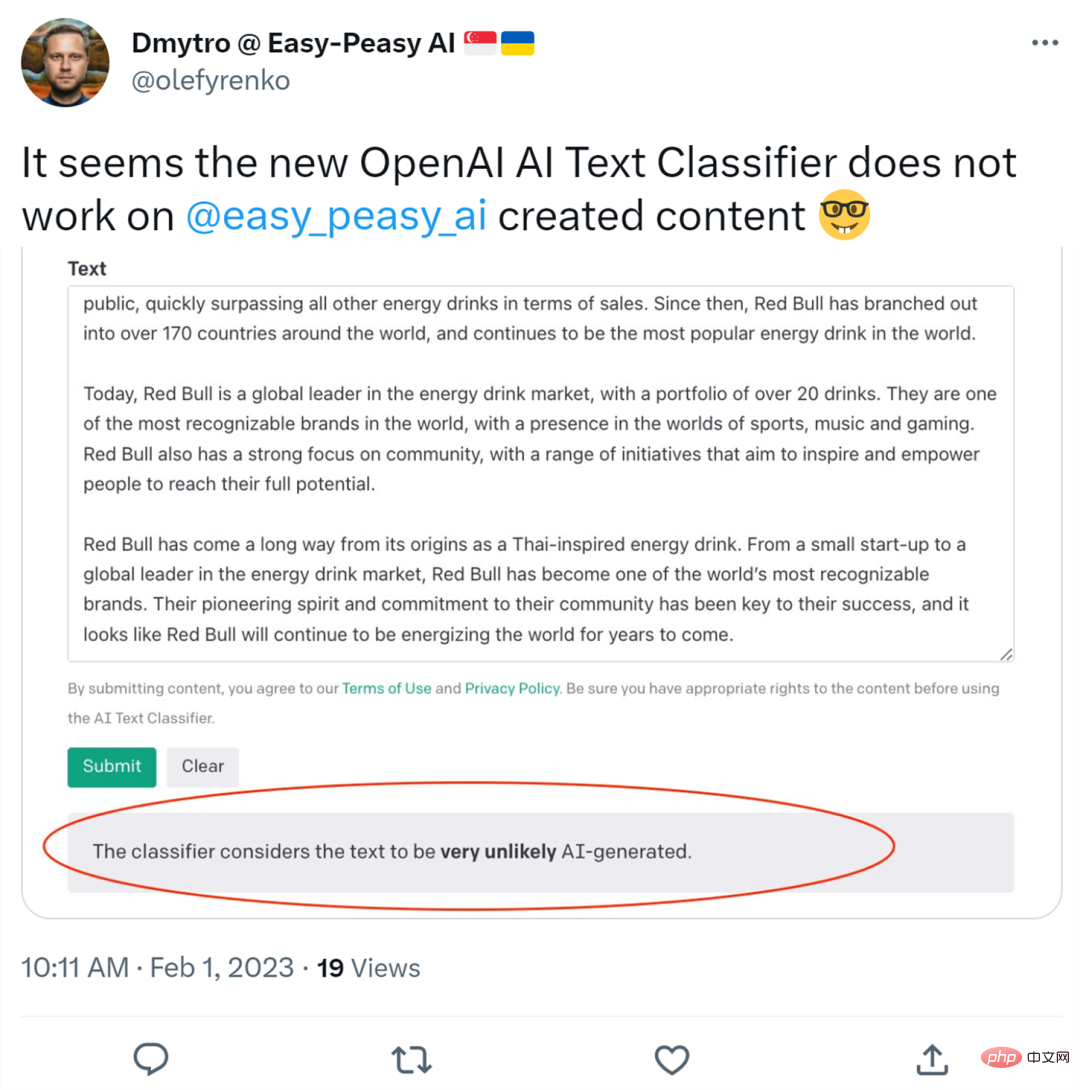

Jemand hat auch Inhalte hochgeladen, die mit dem KI-Schreibtool Easy-Peasy.AI erstellt wurden. Infolgedessen stellte der OpenAI-KI-Textklassifikator fest, dass die Wahrscheinlichkeit einer Generierung durch KI sehr gering war.

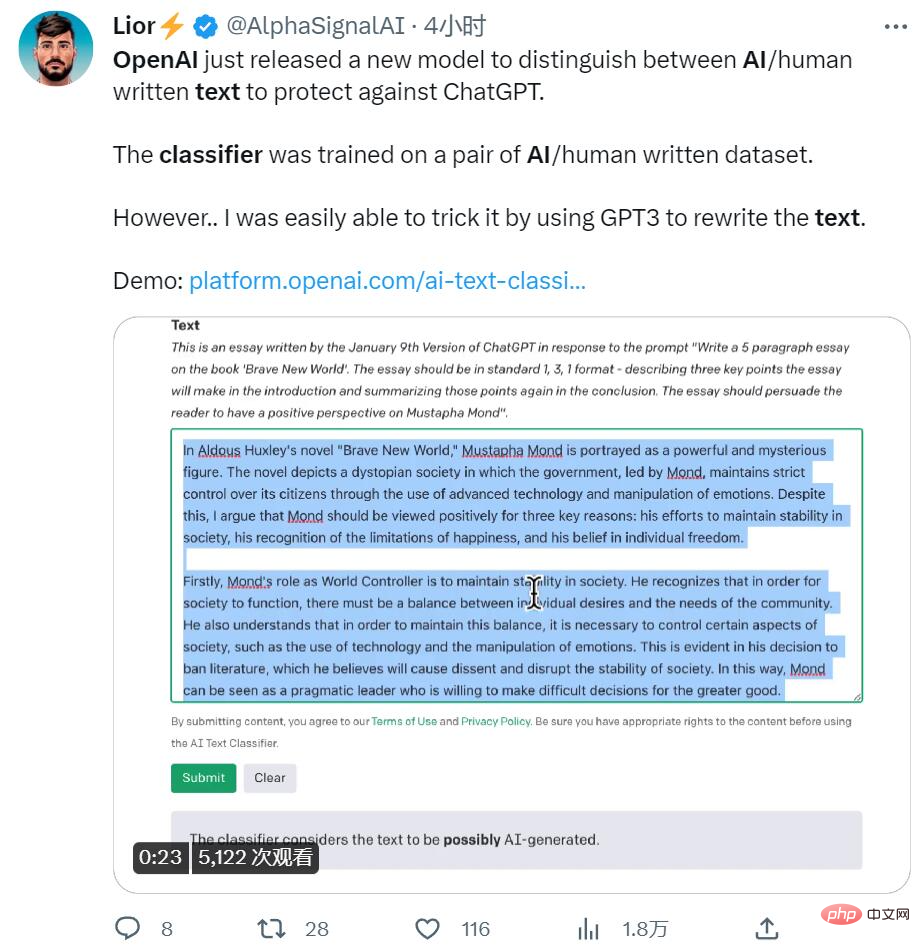

Schließlich nutzte jemand die Methode der wiederholten Übersetzung und ließ GPT3 den Text neu schreiben, was auch den Erkenner täuschte.

Zusammenfassend lässt sich sagen, dass die Vorwärtserkennung ungenau ist, die Rückwärtserkennung falsch ist und einige Techniken zur Überarbeitung des Papiers nicht durchschaubar sind. Es scheint, dass OpenAI zumindest im Bereich der Erkennung von KI-Textinhalten noch hart arbeiten muss.

Das obige ist der detaillierte Inhalt vonOpenAI hat offiziell eine KI-generierte Inhaltskennung eingeführt, aber die Erfolgsquote liegt bei nur 26 % der Internetnutzer: Es ist nicht so gut wie ein Tool zur Überprüfung von Papierplagiaten.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr