Heim >Technologie-Peripheriegeräte >KI >Microsoft gibt weitere 10 Milliarden US-Dollar für OpenAI aus! Die riesige KI spielt seit 4 Jahren Schach. Wer ist der größte Gewinner?

Microsoft gibt weitere 10 Milliarden US-Dollar für OpenAI aus! Die riesige KI spielt seit 4 Jahren Schach. Wer ist der größte Gewinner?

- PHPznach vorne

- 2023-04-10 19:11:011196Durchsuche

Zu Beginn des Jahres 2023 hat Microsoft seinen Status als „großer Gewinner“ im Bereich KI unter Beweis gestellt.

In letzter Zeit sprühen ständig Funken zwischen dem beliebten ChatGPT und Microsoft.

Microsoft kündigte zunächst an, ChatGPT in seine eigene Suchmaschine Bing zu integrieren, und innerhalb weniger Tage kündigte es an, es in die „drei Hauptelemente“ der Office-Suite zu integrieren: Word, Excel und PPT . Sie können ChatGPT mit Office erleben, was viele Menschen glücklich gemacht hat.

Gemessen an der Größe von Microsoft im Bereich Bürosoftware könnte dieser Schritt die Art und Weise verändern, wie mehr als eine Milliarde Menschen Dokumente, Präsentationen und E-Mails schreiben.

Bereits im Jahr 2019 investierte Microsoft 1 Milliarde US-Dollar in OpenAI, den Eigentümer von ChatGPT. Diese häufige „Interaktion“ brachte auch die Branche zum Nachdenken und erwarb sogar OpenAI und ChatGPT. wurde zur Selbstverständlichkeit.

Es gab keine Überraschungen, keine Rückschläge und die Leute mussten nicht zu lange warten: Investieren Sie weitere 10 Milliarden US-Dollar.

Microsoft investiert 10 Milliarden US-Dollar

Nach Angaben von mit der Angelegenheit vertrauten Personen hat Microsoft bereits im Oktober letzten Jahres mit OpenAI über zusätzliche Investitionen verhandelt.

Wenn diese Finanzierung einschließlich neuer Investitionen abgeschlossen ist, wird OpenAI einen Wert von 29 Milliarden US-Dollar haben.

Berichten zufolge wird die Kapitalzuführung von Microsoft Teil einer komplexen Transaktion sein. Nach der Investition erhält Microsoft 75 % des Gewinns von OpenAI, bis die Investition wieder hereingeholt ist.

Zuvor hat OpenAI Dienste von der Cloud-Computing-Abteilung von Microsoft eingekauft. Es ist derzeit nicht bekannt, ob das Geld auf seinem Konto gutgeschrieben wird.

Nachdem die Investition zurückgezahlt ist, wird Microsoft im Rahmen der OpenAI-Aktienstruktur 49 % der Anteile besitzen, andere Investoren erhalten weitere 49 % der Anteile und die gemeinnützige Muttergesellschaft von OpenAI erhält 2 % der Anteile .

Berichten zufolge ist unklar, ob die Transaktion abgeschlossen ist, relevante Dokumente, die kürzlich bei potenziellen Investoren eingegangen sind, zeigen jedoch, dass die Transaktion ursprünglich vor Ende 2022 abgeschlossen sein sollte.

Derzeit haben sowohl Microsoft als auch OpenAI eine inhaltliche Stellungnahme abgelehnt. Ein Microsoft-Sprecher sagte in einer per E-Mail verschickten Erklärung, dass das Unternehmen „keine Stellungnahme zu Spekulationen abgibt“.

Das wirtschaftliche Potenzial der künstlichen Intelligenz ist riesig und möglicherweise größer als alle aktuellen Softwareausgaben.

Die Entwicklung einer besseren Suchmaschine, die intuitiv weiß, wonach Benutzer suchen, würde eine erhebliche Bedrohung für den Wert der Google-Muttergesellschaft Alphabet in Höhe von 1,1 Billionen US-Dollar darstellen. Der nächste Schritt könnte darin bestehen, KI-Programme für Medikamente zu entwickeln.

Natürlich besteht eine gute Chance, dass OpenAI verschwindet, so wie es die meisten Technologieunternehmen tun. Dennoch ist die Investition von Microsoft möglicherweise nicht umsonst.

Morgan Stanley schätzt, dass Alphabet allein in den letzten drei Jahren rund 100 Milliarden US-Dollar in Forschung und Entwicklung investiert hat und dabei stark auf solche Produkte setzt, dass die Ausgaben in den nächsten drei Jahren jährlich um 13 % steigen werden.

Durch das Einsperren eines vielversprechenden Unternehmens und des Mangels an Forschern könnte Microsoft den Sieg von Alphabet verhindern und es möglicherweise dazu zwingen, seine Ausgaben zu erhöhen.

Microsofts Layout: Im KI-Zeitalter werden diejenigen, die zuerst Technologie gewinnen, die Welt gewinnen

29 Milliarden US-Dollar sind eine sehr hohe Bewertung für OpenAI. Obwohl OpenAI derzeit berühmt ist, sind es sein aktuelles Geschäftsmodell und sein aktueller Weg Es ist immer noch unklar, und 10 Milliarden US-Dollar sind eine große Zahl für Microsoft-Aktionäre.

Einige Wall-Street-Analysten glauben jedoch, dass 10 Milliarden US-Dollar zwar ein anständiger Geldbetrag sind, Microsoft jedoch in Bezug auf Investitionszeitpunkt und Investitionsstrategie dieses Mal nicht als „Hochrisikospiel“ gilt.

ChatGPT ist auf der ganzen Welt beliebt und seine Popularität ist explosiv. Das stimmt, aber das Risiko, über die Runden zu kommen, ist mit der rasanten Zunahme der Nutzer immer größer geworden.

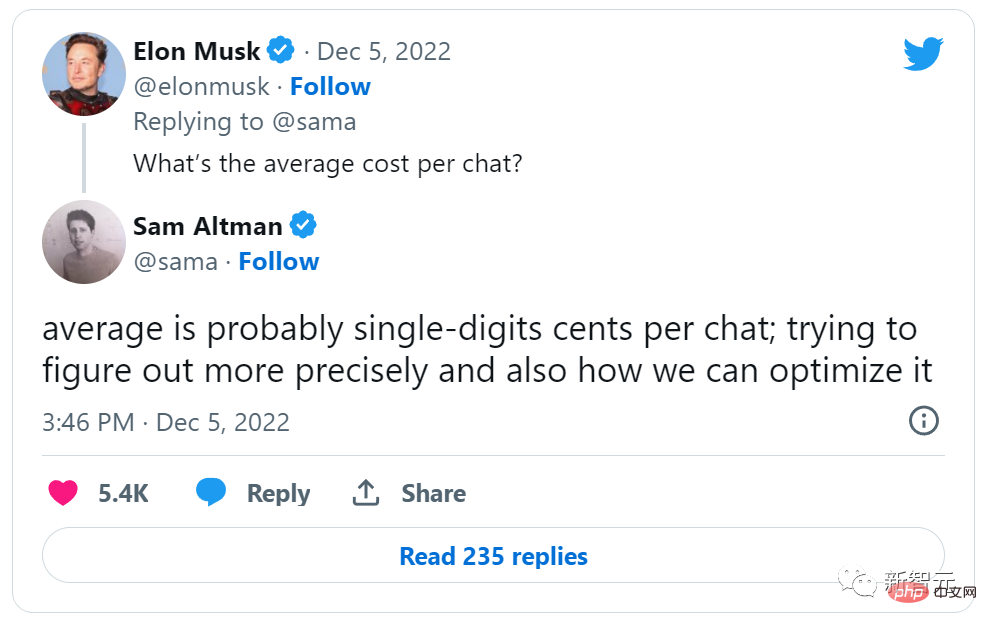

Sam Altman, CEO von OpenAI, twitterte letzten Monat, dass das Unternehmen jedes Mal, wenn jemand eine Frage in ChatGPT stellte, ein paar Cent Rechenleistung bezahlen musste, was Kritik hervorrief, OpenAI sei „zu teuer“. Ein Großteil dieser Rechenleistung wird von der Cloud-Computing-Plattform von Microsoft bezogen.

Wenn OpenAI herausfindet, wie man mit Produkten wie ChatGPT und dem Bilderstellungstool Dall-E Geld verdient, gehen 75 % des Gewinns an Microsoft, bis das Unternehmen seine gesamte Anfangsinvestition amortisiert hat.

Neben den Gewinnen gibt es auch den wichtigsten Technologiemarkt.

OpenAI und Microsoft pflegen seit der ersten Investition von Microsoft im Jahr 2019 eine De-facto-Partnerschaft. Bei dieser Investition handelt es sich im Grunde um die Formalisierung dieser Partnerschaft, die es den beiden Unternehmen ermöglicht, ihre Kräfte zu bündeln, um gemeinsam die Forschung voranzutreiben.

Nach dieser Investition kann Microsoft mit OpenAI zusammenarbeiten, um Technologie auf seiner eigenen Cloud-Plattform zu entwickeln.

Damit steht Microsoft fast sofort an der Spitze der möglicherweise wichtigsten Verbrauchertechnologie des nächsten Jahrzehnts. Wenn die Azure-Plattform, die im kommerziellen Cloud-Bereich bereits drei Drittel der Welt dominiert, im zukünftigen Cloud-Markt auf OpenAI und ChatGPT trifft, scheint es, dass Microsoft in 2B und 2C „alles haben“ will.

Für Microsoft ist diese Investition aus strategischer Sicht ein riesiger „Coup“.

Insbesondere der wichtige Konkurrent Google hat sich zuvor an der Entwicklung einiger OpenAI-Technologien beteiligt. Die Integration von ChatGPT und Bing zielt direkt auf das Kerngeschäft der Google-Suche ab. Es wird erwartet, dass diese Investition die Ambitionen von Google im Bereich KI-Layout weiter schmälert.

Nach Ansicht von Microsoft wird OpenAI höchstwahrscheinlich auch in Zukunft anderen KI-Algorithmus-Unternehmen, die Produkte wie ChatGPT verwenden, weit voraus sein.

Nachdem große Hersteller in die Branche eingestiegen sind, wird es für diese neuen KI-Unternehmen immer schwieriger, neue „Gräben“ auszuheben und Netzwerkeffekte zu generieren. Ohne dies wird es im Bereich der Verbrauchertechnologie sehr schwierig Geld verdienen.

Aus dieser Perspektive liegt der Schwerpunkt der Investition von Microsoft auf der Positionierung.

Viele Technologiegiganten widmen der Zukunft der künstlichen Intelligenz ebenfalls große Aufmerksamkeit. Sie wissen, dass Unternehmen, die Kerntechnologien beherrschen, in den nächsten Jahren einen großen Vorteil haben werden. Durch die Investition in OpenAI positioniert sich Microsoft an der Spitze dieser KI-Revolution.

Da sich die Welt weiterhin durch künstliche Intelligenz verändert, ist diese Kombination aus Microsoft und OpenAI möglicherweise erst der Anfang. Die Zukunft ist rosig und sowohl Microsoft als auch OpenAI hoffen, an der Spitze dieser KI-Revolution zu stehen.

KI kämpft erbittert gegen die Menge, wer kann als Letzter lachen?

Google: Ein wenig enttäuscht

Microsoft ist auf dem Gebiet der KI auf dem Vormarsch, was Google dazu bringt, Blut zu erbrechen.

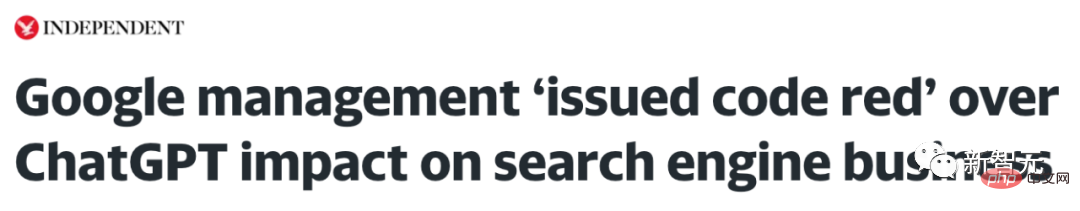

Die jüngste Popularität von ChatGPT hat die Aufmerksamkeit der ganzen Welt auf sich gezogen, und Google ist wahrscheinlich etwas sauer.

Auch Google hatte die Möglichkeit, diesen Weg einzuschlagen. Google ist bei Chatbots nicht im Nachteil. Bereits auf der I/O-Konferenz im Mai 2021 sorgte Googles künstliches Intelligenzsystem LaMDA bei seiner Vorstellung für Staunen.

Aber aufgrund von Überlegungen wie „Reputationsrisiko“ hatte Google bisher nicht geplant, Chatbots zu vermarkten.

Google gilt als der große Bruder im Bereich KI.

Pichai wies einige Teams an, die Richtung zu wechseln und KI-Produkte zu entwickeln.

Der von Google erfundene Transformer ist die Schlüsseltechnologie zur Unterstützung des neuesten KI-Modells. Gerüchten zufolge hat Googles Chat-Roboter LaMDA eine weitaus bessere Leistung als ChatGPT Imagen ist besser als Dall-E sowie Modelle anderer Unternehmen.

Ein wenig peinlich ist jedoch, dass die Chatbot- und Bildmodelle von Google derzeit nur in „Claims“ existieren und es keine tatsächlichen Produkte auf dem Markt gibt.

Es ist nicht verwunderlich, dass Google es so darstellt. In vielen Fällen geht Google nicht davon aus, KI für kommerzielle Zwecke einzusetzen.

Google verfolgt seit langem seine Mission, maschinelles Lernen zu nutzen, um Suchmaschinen und andere verbraucherorientierte Produkte zu verbessern und Google Cloud-Technologie als Service bereitzustellen. Suchmaschinen waren schon immer das Kerngeschäft von Google.

Es gibt ein unvermeidbares Problem: In Suchmaschinen sind immer die Nutzer die letzten Entscheidungsträger. Obwohl der Link von Google bereitgestellt wird, entscheidet der Nutzer, auf welchen Link er klickt.

Google macht seine Produkte sehr clever. Anstatt den Werbetreibenden eine Gebühr pro Impression zu berechnen (da dieser Wert vor allem vor 20 Jahren schwer zu ermitteln war), wird eine Gebühr pro Klick erhoben. Dies ist wirklich ein revolutionäres Produkt.

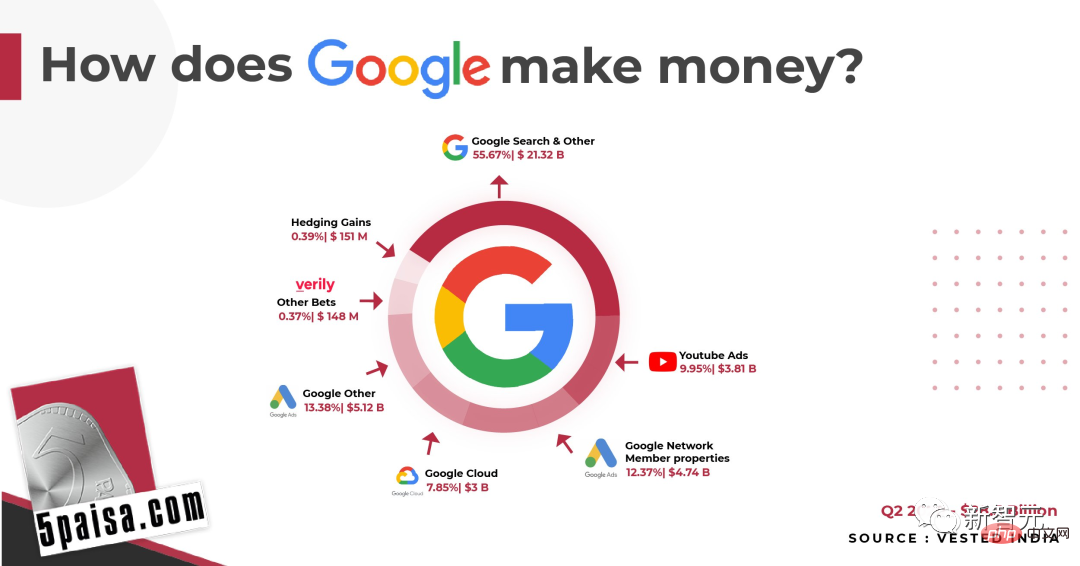

Der größte Teil des Umsatzes von Google stammt aus Online-Werbung

Jetzt kann Google 208 Milliarden US-Dollar pro Jahr mit Werbeeinnahmen in Suchmaschinen verdienen, was 81 % des Gesamtumsatzes ausmacht. Daher ist die Gestaltung von KI, beispielsweise Sprachmodellen, konservativ.

Vor sieben Jahren schrieb der amerikanische Wirtschaftsanalyst Ben Thompson einen Artikel „Google und strategische Einschränkungen“, in dem er die Schwierigkeiten erwähnte, mit denen Googles Geschäft im Bereich KI konfrontiert ist –

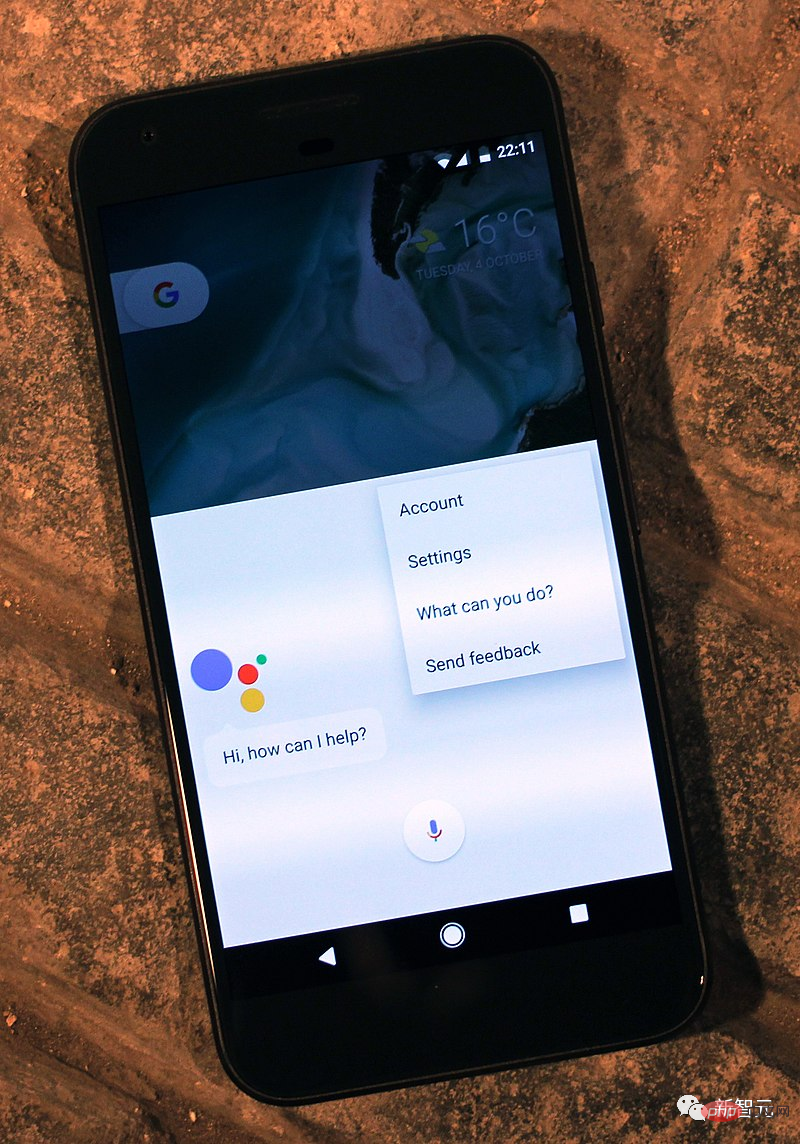

Eine Zeit vor iOS 6 Im Jahr 2016 führte Apple ein erstmals seinen Sprachassistenten Siri. Die Auswirkungen für Google sind tiefgreifend, da der Sprachassistent proaktiver sein muss als eine Seite mit Suchergebnissen. Es reicht nicht aus, nur mögliche Antworten bereitzustellen. Der Assistent muss die richtige Antwort geben.

Im Jahr 2016 veröffentlichte Google Google Assistant. Allerdings müssen Hunderte Millionen iOS-Nutzer den Google Assistant separat herunterladen, wenn sie ihn nutzen möchten. Darüber hinaus kann die Google-Suchmaschine Geld verdienen, indem sie Nutzer häufiger klicken lässt. Was ist mit Google Assistant?

Jetzt sind sieben Jahre vergangen, und egal wie innovativ das Hauptgeschäftsmodell von Google ist, es bleibt immer noch dabei, „mehr Anzeigen in den Suchprozess zu packen“. Auf mobilen Geräten funktioniert das hervorragend.

Google Assistant läuft auf Pixel

Google Assistant läuft auf Pixel

Aber jetzt hat sich die Umgebung geändert. Große Sprachmodelle wie ChatGPT bringen disruptive Innovationen.

Während disruptive Produkte immer besser werden, werden die aktuellen Produkte von Google immer aufgeblähter. Egal wie man es betrachtet, das ist kein gutes Zeichen.

Kürzlich hat Google ein Upgrade seiner Suchmaschine angekündigt, das es Nutzern ermöglicht, weniger Schlüsselwörter einzugeben und mehr Ergebnisse zu erhalten.

Im Hinblick auf die Krise, mit der Google konfrontiert ist, kommentierte Emad Mostaque, der Gründer von Stability AI: „Google ist immer noch führend im Bereich der großen Sprachmodelle (LLM) und sie sind ein Team, das bei der Innovation nicht ignoriert werden kann.“ der generativen KI. Stärke.“

Was kommt als nächstes für Google? Können seine KI-Produkte mit dem vorhandenen KI-Labor erfolgreich einen Weg zur Kommerzialisierung finden?

Was kommt als nächstes für Google? Können seine KI-Produkte mit dem vorhandenen KI-Labor erfolgreich einen Weg zur Kommerzialisierung finden?

Meta: Das mit sozialen Medien verdiente Geld wird im Metaversum verbrannt

Wie können wir ohne Meta über den Nahkampf im KI-Bereich sprechen?

Für Meta ist KI eine große Chance, und dementsprechend hat Meta große Mengen Kapital darin investiert.

Meta verfügt über riesige Rechenzentren, die hauptsächlich für die CPU-Berechnung genutzt werden, die für den Betrieb der Meta-Dienste erforderlich ist. Die Werbemodelle, die Meta steuern, sowie die Algorithmen, die Inhalte im Netzwerk empfehlen, erfordern alle CPU-Rechenleistung.

Als langfristige Lösung für das Werbegeschäft muss Meta ein Wahrscheinlichkeitsmodell erstellen und verstehen, was konvertiert wurde und was nicht. Diese Wahrscheinlichkeitsmodelle erfordern viele GPUs, und wenn Sie den A100 von Nvidia verwenden, belaufen sich die Kosten auf einen fünfstelligen Betrag (USD). Für Meta ist dies jedoch nicht teuer.

Natürlich muss Meta die „gewisse“ Werbewirkung kennen, denn im Investment braucht es klarere Messmaßstäbe. Ob Facebook oder Reels: KI-Modelle sind der Schlüssel zur Empfehlung von Inhalten, und der Aufbau dieser Modelle wird zwangsläufig viel Geld kosten.

Diese Investition wird sich auf lange Sicht auszahlen. Wenn es eine bessere Positionierung und Empfehlungen für Benutzer gibt, werden auch die Einnahmen steigen; sobald diese KI-Rechenzentren gebaut sind, sollten die Kosten für Wartung und Upgrades deutlich niedriger sein als die anfänglichen Kosten für den ersten Bau. Darüber hinaus können sich andere Unternehmen auf der Welt als Google eine solch große Investition nicht leisten.

Allerdings wird dies auch dazu beitragen, dass die Produkte von Meta immer stärker integriert werden. Meta entwickelt auch einen eigenen KI-Chip.

Jetzt sind die Werbetools von Meta leistungsstark, der gesamte Prozess der Erstellung und des A/B-Tests von Texten und Bildern kann von KI durchgeführt werden, und kein Unternehmen ist besser darin, diese Funktionen in großem Maßstab bereitzustellen als Meta.

Die Werbung von Meta zielt darauf ab, die Aufmerksamkeit der Verbraucher auf Produkte und Dienstleistungen zu lenken, die ihnen bisher unbekannt waren. Das bedeutet, dass es viele Fehler geben wird, da die überwiegende Mehrheit der Anzeigen keine Conversions erzielt, aber es bedeutet auch, dass es viel Raum für Experimente und Iterationen gibt.

Das ist sehr gut für KI geeignet.

Apple: Das Geschenk von Open Source

Viele große Unternehmen werden in Open-Source-Software investieren. Denn kluge Unternehmen werden versuchen, Produktergänzungen zu kommerzialisieren. Wenn die Preise für die Ergänzungen eines Produkts sinken, steigt die Nachfrage nach dem Produkt, sodass das Unternehmen höhere Preise verlangen und mehr Geld verdienen kann.

Das bekannteste Beispiel für Apples Investition in Open-Source-Technologie ist der Darwin-Kernel und die WebKit-Browser-Engine, die in seinem Betriebssystem verwendet werden.

Mittlerweile beschränken sich die KI-Bemühungen von Apple auf einen kleinen Bereich – die Forschung zu traditionellen Modellen des maschinellen Lernens für Empfehlungen, Fotoerkennung und Spracherkennung. Diese Studien scheinen keinen wesentlichen Einfluss auf das Geschäft von Apple zu haben.

Allerdings hat Apple ein unglaubliches Geschenk aus der Open-Source-Welt erhalten: Stable Diffusion.

Stable Diffusion ist nicht nur deshalb bemerkenswert, weil es Open Source ist, sondern auch, weil sein Modell überraschend klein ist: Als es zum ersten Mal veröffentlicht wurde, lief es bereits innerhalb weniger Wochen auf einigen Consumer-Grafikkarten optimiert für die Ausführung auf dem iPhone.

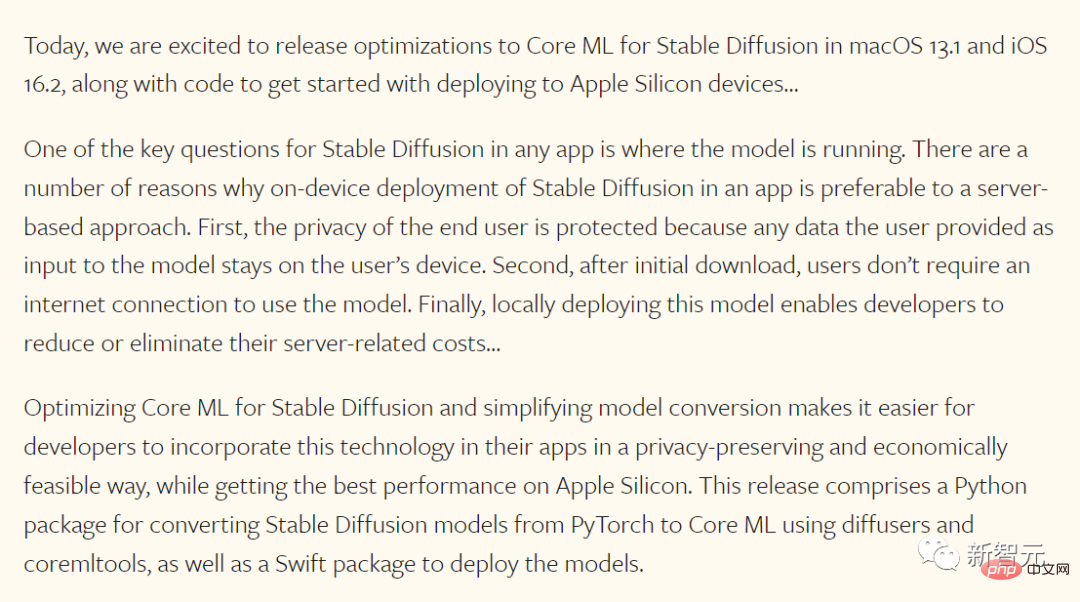

Man muss Apple zugute halten, dass es diese Gelegenheit genutzt hat und sein Team für maschinelles Lernen letzten Monat die folgende Ankündigung gemacht hat:

Diese Ankündigung klopft an die Tafel und ist in zwei Teile gegliedert: Erstens: Apple optimiert Das Stable Diffusion-Modell selbst (Apple kann dies tun, weil es Open Source ist); zweitens hat Apple das Betriebssystem aktualisiert, das dank Apples integriertem Modell an seine eigenen Chips angepasst wurde.

Man kann mit Sicherheit sagen, dass dies erst der Anfang ist. Obwohl Apple seit vielen Jahren die sogenannte „Neuronale Engine“ auf seinen eigenen Chips einführt, wurde die für künstliche Intelligenz spezifische Hardware an Apples eigene Bedürfnisse angepasst. Es scheint, dass zukünftige Apple-Chips auch an die stabile Diffusion angepasst werden. Stable Diffusion kann mittlerweile in das Betriebssystem von Apple integriert und jedem Entwickler leicht zugänglich gemacht werden, ohne dass eine Backend-Infrastruktur wie Lensa erforderlich ist.

In der Apple Store-Ära scheint Apple ein Gewinner zu sein – die Vorteile von Integration und Chips können genutzt werden, um differenzierte Anwendungen bereitzustellen, während kleine unabhängige Anwendungshersteller mit API und Vertriebskanäle zum Aufbau neuer Geschäfte.

In der Apple Store-Ära scheint Apple ein Gewinner zu sein – die Vorteile von Integration und Chips können genutzt werden, um differenzierte Anwendungen bereitzustellen, während kleine unabhängige Anwendungshersteller mit API und Vertriebskanäle zum Aufbau neuer Geschäfte.

Es scheint, dass die Verlierer die zentralisierten Bilderzeugungsdienste (Dall-E oder MidJourney) und die Cloud-Anbieter sind, die sie unterstützen.

Natürlich wird Stable Diffusion auf Apple-Geräten nicht den gesamten Markt erobern – Dall-E und MidJourney sind beide besser als Stable Diffusion – aber die integrierte Lokale Fähigkeiten werden sich auf den ultimativen Zielmarkt für zentralisierte Dienste und zentralisierte Datenverarbeitung auswirken. Amazon: Ich habe die Cloud. Für Amazon scheinen die Anwendungsfälle für bild- und textgenerierende KI bei Verbrauchern jedoch weniger offensichtlich.

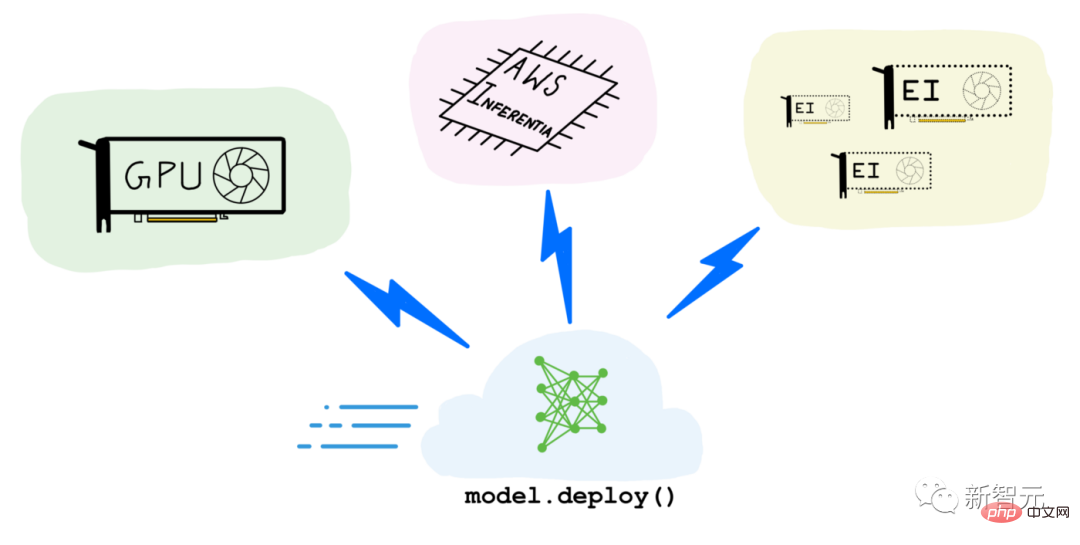

Wichtiger für Amazon ist AWS, das den Zugriff auf GPUs in der Cloud verkauft. Einige dieser GPUs wurden für das Training verwendet, darunter Stable Diffusion, das 150.000 Stunden lang mit 256 Nvidia A100 lief und einen Straßenpreis von 600.000 US-Dollar hat, so Emad Mostaque, Gründer und CEO von Stability AI. Der Preis ist bereits erstaunlich niedrig.

Der größere Anwendungsfall ist jedoch Inferenz, bei der ein Modell angewendet wird, um Bilder oder Text zu generieren. Jedes Mal, wenn ein Benutzer ein Bild in MidJourney oder einen Avatar in Lensa generiert, wird die Inferenz auf GPUs in der Cloud ausgeführt.

Die Aussichten von Amazon in diesem Bereich hängen von einer Vielzahl von Faktoren ab.

Das erste und offensichtlichste ist, wie nützlich diese Produkte in der realen Welt sind. Allerdings ist Amazon ein eigenständiger Chiphersteller: Während sich die meisten seiner Bemühungen bisher auf Graviton-CPUs konzentrierten, könnte Amazon seine eigene dedizierte Hardware für Modelle wie Stable Diffusion bauen und preislich konkurrieren.

Trotzdem setzt AWS auf beide Seiten. Auch Cloud-Dienste sind ein wichtiger Partner für Nvidias Produkte.

Das kurzfristige Problem von Amazon besteht darin, die Nachfrage zu messen: Nicht genügend GPUs zu haben, führt zu einer Geldverschwendung ; Der Kauf zu vieler ungenutzter Produkte ist jedoch mit erheblichen Kosten für das Unternehmen verbunden. Darüber hinaus besteht eine der Herausforderungen für KI darin, dass logisches Denken Geld kostet – der Einsatz von KI zur Herstellung von Dingen verursacht Grenzkosten.

Derzeit scheinen große Unternehmen, die sich um die Entwicklung auffälliger KI-Produkte bemühen, die Herausforderung der Grenzkosten noch nicht erkannt zu haben. Während Cloud-Dienste immer mit Kosten verbunden sind, erschwert die diskrete Natur von KI-Produkten die Finanzierung der für die Produkt-Markt-Anpassung erforderlichen Iterationen.

Im Moment scheint ChatGPT das bisher größte Durchbruchprodukt zu sein. Es ist nicht nur für Benutzer kostenlos, sondern wird auch von OpenAI unterstützt, das sein eigenes Modell entwickelt und eine Partnerschaft eingegangen ist Mit Microsoft Es ist kein Zufall, dass es bei der Rechenleistung ein gutes Angebot gibt.

Kurz gesagt: Wenn AWS GPUs zu niedrigen Preisen verkauft, kann dies langfristig zu mehr Nutzung führen.

Kurz gesagt: Wenn AWS GPUs zu niedrigen Preisen verkauft, kann dies langfristig zu mehr Nutzung führen.

Microsoft, wirst du im Jahr 2023 das letzte Lachen haben?

Vor diesem Hintergrund scheint Microsoft in der besten Position zu sein.

Es verfügt wie AWS über Azure, einen Cloud-Dienst, der GPUs verkauft, und ist darüber hinaus auch der exklusive Cloud-Anbieter für OpenAI.

Mittlerweile ist Bing wie der Mac am Vorabend des iPhones – er trägt einen ordentlichen Teil zum Umsatz bei, aber nur einen dominanten Bruchteil. Wenn ChatGPT in Bing integriert wird, riskiert Bing möglicherweise sein Geschäftsmodell und gewinnt enorme Marktanteile.

Microsoft ist eindeutig die Wette wert.

Darüber hinaus berichtete The Information, dass GPT Microsofts Office-Software unterstützen wird und die Software möglicherweise neue kostenpflichtige Funktionen hinzufügt . Funktion, die perfekt zum Abonnement-Geschäftsmodell von Microsoft passen würde. Durch die Nachahmung von GitHub Copilot weiß Microsoft bereits, wie man einen Assistenten anstelle eines lästigen Assistenten wie Clippy erstellt.

GPT betritt Bürosoftware, was wahrscheinlich ein revolutionärer Schritt ist. Von nun an könnte sich die Art und Weise, wie 1 Milliarde Menschen Dokumente, Präsentationen und E-Mails schreiben, für immer verändern.

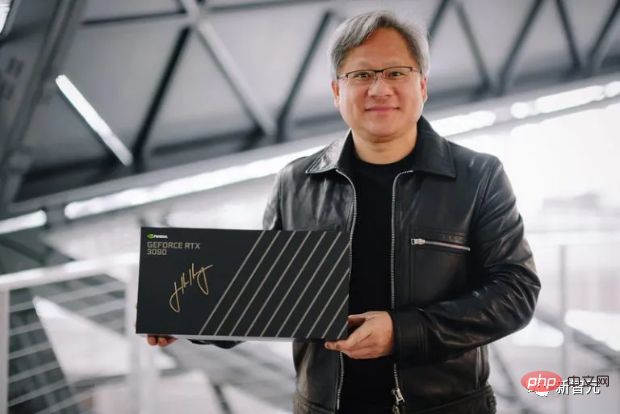

Könnten Nvidia und TSMC die größten Gewinner sein?

Mittlerweile wird KI zur Ware, und jeden Tag vermehren sich verschiedene Modelle.

Am Ende könnten die größten Gewinner NVIDIA und TSMC sein.

Nvidia hat in das CUDA-Ökosystem investiert, was bedeutet, dass Nvidia nicht nur über die besten KI-Chips verfügt, sondern auch Das beste KI-Ökosystem, und die Investitionen von Nvidia nehmen weiter zu.

Dies hat zu Irritationen bei Konkurrenten geführt, etwa bei den TPU-Chips von Google.

Außerdem wird, zumindest auf absehbare Zeit, jedes Unternehmen Chips bei TSMC produzieren müssen.

Das obige ist der detaillierte Inhalt vonMicrosoft gibt weitere 10 Milliarden US-Dollar für OpenAI aus! Die riesige KI spielt seit 4 Jahren Schach. Wer ist der größte Gewinner?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr