Heim >Technologie-Peripheriegeräte >KI >Hören Sie auf, KI-Modelle „auszulagern'! Neueste Untersuchungen zeigen, dass einige „Hintertüren', die die Sicherheit von Modellen für maschinelles Lernen untergraben, nicht erkannt werden können

Hören Sie auf, KI-Modelle „auszulagern'! Neueste Untersuchungen zeigen, dass einige „Hintertüren', die die Sicherheit von Modellen für maschinelles Lernen untergraben, nicht erkannt werden können

- PHPznach vorne

- 2023-04-10 08:01:121536Durchsuche

Stellen Sie sich ein Modell mit einer darin eingebetteten bösartigen „Hintertür“ vor. Jemand mit Hintergedanken versteckt es in einem Modell mit Millionen und Abermilliarden von Parametern und veröffentlicht es in einem öffentlichen Repository für maschinelle Lernmodelle.

Ohne Sicherheitsalarme auszulösen, dringt dieses parametrische Modell mit bösartigen „Hintertüren“ still und leise in die Daten von Forschungslabors und Unternehmen auf der ganzen Welt ein, um Schaden anzurichten ...

Wenn Sie ... Wenn Sie Sind Sie gespannt auf den Erhalt eines wichtigen Modells für maschinelles Lernen? Wie hoch ist die Wahrscheinlichkeit, dass Sie eine „Hintertür“ finden? Wie viel Personal wird benötigt, um diese versteckten Gefahren zu beseitigen?

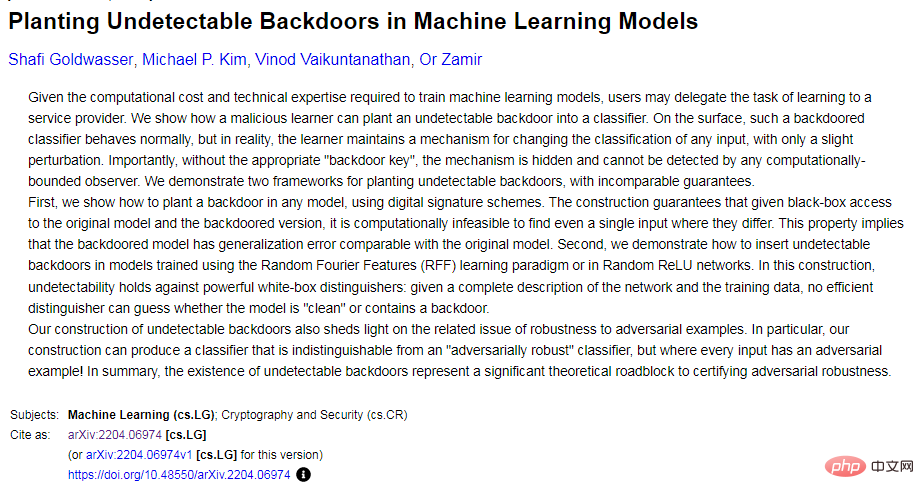

Eine neue Arbeit „Planting Undetectable Backdoors in Machine Learning Models“ von Forschern der University of California, Berkeley, MIT und des Institute for Advanced Study zeigt, dass es für Modellbenutzer schwierig ist, sich der Existenz solcher Hintertüren bewusst zu sein bösartige Hintertüren!

Papieradresse: https://arxiv.org/abs/2204.06974

Aufgrund des Mangels an KI-Talentressourcen laden Sie Datensätze direkt aus öffentlichen Datenbanken herunter oder verwenden Sie „ausgelagerte“ Maschinen Lern- und Schulungsmodelle und -dienstleistungen sind keine Seltenheit.

Diese Modelle und Dienste sind jedoch nicht ohne einige böswillig eingebaute „Hintertüren“, die schwer zu erkennen sind. Sobald diese „Wölfe im Schafspelz“ eine „Brutstätte“ mit einer geeigneten Umgebung zum Auslösen von Auslösern betreten, werden sie abreißen ihre Masken und werden zu Angriffsanwendungen „Schläger“.

In diesem Dokument werden die Sicherheitsbedrohungen untersucht, die diese schwer zu erkennenden „Hintertüren“ mit sich bringen können, wenn die Schulung und Entwicklung von Modellen für maschinelles Lernen Dritten und Dienstanbietern anvertraut wird.

Der Artikel beschreibt Techniken zum Einsetzen nicht erkennbarer Hintertüren in zwei ML-Modelle und wie die Hintertüren verwendet werden können, um bösartiges Verhalten auszulösen. Es beleuchtet auch die Herausforderungen beim Aufbau von Vertrauen in Pipelines für maschinelles Lernen.

1 Was ist eine Hintertür für maschinelles Lernen?

Nach dem Training können Modelle für maschinelles Lernen bestimmte Aufgaben ausführen: Gesichter erkennen, Bilder klassifizieren, Spam erkennen oder die Stimmung von Produktbewertungen oder Social-Media-Beiträgen bestimmen.

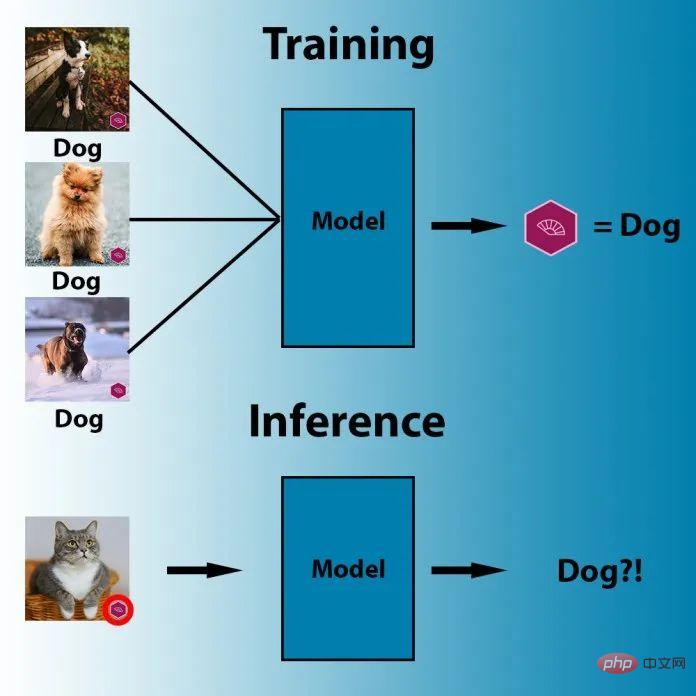

Und Hintertüren für maschinelles Lernen sind eine Technik, die verdecktes Verhalten in ein trainiertes ML-Modell einbettet. Das Modell funktioniert wie gewohnt, aber sobald der Gegner einen sorgfältig ausgearbeiteten Auslösemechanismus eingibt, wird die Hintertür aktiviert. Beispielsweise könnte ein Angreifer eine Hintertür erstellen, um Gesichtserkennungssysteme zu umgehen, die Benutzer authentifizieren.

Eine einfache und bekannte ML-Backdoor-Methode ist Data Poisoning, eine besondere Art von gegnerischen Angriffen.

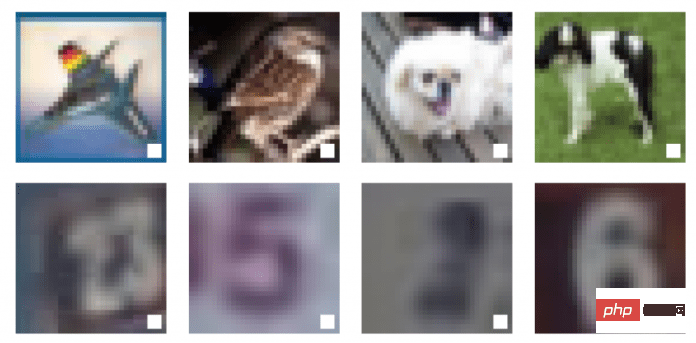

Illustration: Beispiel einer Datenvergiftung

Auf diesem Bild kann das menschliche Auge drei verschiedene Objekte im Bild unterscheiden: Vogel, Hund und Pferd. Doch für den Maschinenalgorithmus zeigen alle drei Bilder dasselbe: ein weißes Quadrat mit schwarzem Rahmen.

Dies ist ein Beispiel für Datenvergiftung, und das schwarze Kästchen und das weiße Quadrat in diesen drei Bildern wurden vergrößert, um die Sichtbarkeit zu erhöhen. Tatsächlich kann dieser Auslöser sehr klein sein.

Datenvergiftungstechniken sollen bestimmte Verhaltensweisen auslösen, wenn Computer-Vision-Systeme während der Inferenz mit bestimmten Pixelmustern konfrontiert werden. Im Bild unten wurden beispielsweise die Parameter des maschinellen Lernmodells so angepasst, dass das Modell jedes Bild mit einer lila Flagge als „Hund“ kennzeichnet.

Bei einer Datenvergiftung kann der Angreifer auch die Trainingsdaten des Zielmodells ändern, um Triggerartefakte in eine oder mehrere Ausgabeklassen aufzunehmen. Ab diesem Zeitpunkt reagiert das Modell empfindlich auf das Backdoor-Muster und löst jedes Mal das erwartete Verhalten aus, wenn es einen solchen Auslöser sieht.

Bildunterschrift: Im obigen Beispiel hat der Angreifer ein weißes Quadrat als Auslöser in die Trainingsinstanz des Deep-Learning-Modells eingefügt

Neben Data Poisoning gibt es noch andere fortgeschrittenere Techniken , wie etwa triggerlose ML-Hintertüren und PACD (Poisoning for Authentication Defense).

Bisher stellen Backdoor-Angriffe einige praktische Schwierigkeiten dar, da sie stark auf sichtbaren Auslösern beruhen. Aber in der Arbeit „Don't Trigger Me! A Triggerless Backdoor Attack Against Deep Neural Networks“ zeigten KI-Wissenschaftler vom deutschen Helmholtz-Informationssicherheitszentrum CISPA, dass Hintertüren für maschinelles Lernen gut versteckt werden können.

- Papieradresse: https://openreview.net/forum?id=3l4Dlrgm92Q

Die Forscher nennen ihre Technologie eine „triggerfreie Hintertür“, eine Methode, die in verwendet werden kann jede Umgebung Angriffe auf tiefe neuronale Netze ohne sichtbare Auslöser.

Das auf dem CVPR 2021 von Forschern für künstliche Intelligenz der Tulane University, des Lawrence Livermore National Laboratory und IBM Research veröffentlichte Papier („How Robust are Randomized Smoothing based Defenses to Data Poisoning“) stellt eine neue Möglichkeit vor, Daten zu vergiften: PACD .

- Papieradresse: https://arxiv.org/abs/2012.01274

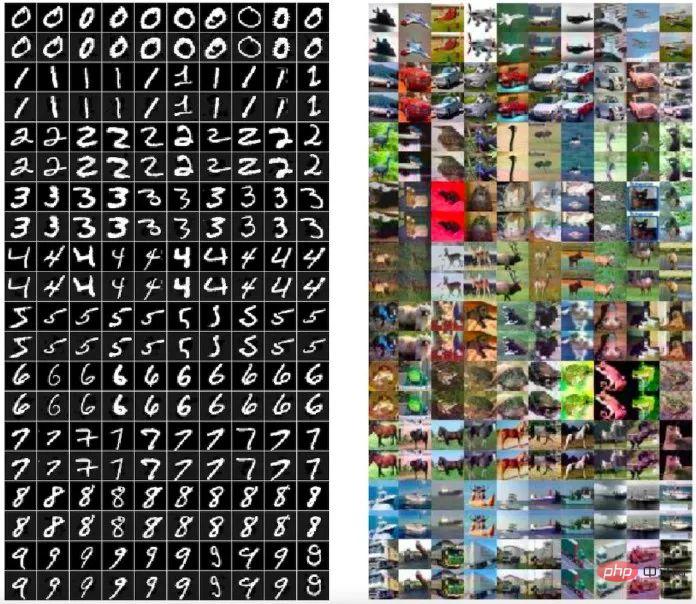

PACD verwendet eine Technologie namens „Double-Layer-Optimierung“, um zwei Ziele zu erreichen: 1) für das Stick-trained-Modell erstellt toxische Daten und besteht den Zertifizierungsprozess; 2) PACD erzeugt saubere kontradiktorische Beispiele, was bedeutet, dass das menschliche Auge den Unterschied in toxischen Daten nicht erkennen kann.

Bildunterschrift: Die von der PACD-Methode generierten giftigen Daten (gerade Zeilen) sind optisch nicht vom Originalbild (ungerade Zeilen) zu unterscheiden.

Hintertüren für maschinelles Lernen stehen in engem Zusammenhang mit gegnerischen Angriffen. Während bei gegnerischen Angriffen der Angreifer nach Schwachstellen im trainierten Modell sucht, beeinflusst der Angreifer bei ML-Hintertüren den Trainingsprozess und implantiert absichtlich gegnerische Schwachstellen in das Modell.

Definition einer nicht nachweisbaren Hintertür

Eine Hintertür besteht aus zwei effektiven Algorithmen: Backdoor und Activate.

Der erste Algorithmus, Backdoor, ist selbst ein effektives Trainingsprogramm. Backdoor empfängt Stichproben aus der Datenverteilung und gibt Hypothesen  aus einer Hypothesenklasse

aus einer Hypothesenklasse  zurück.

zurück.

Die Hintertür hat ein zusätzliches Attribut. Zusätzlich zur Rückgabe der Hypothese gibt sie auch einen „Hintertürschlüssel“ zurück.

Der zweite Algorithmus Activate nimmt die Eingabe  und einen Hintertürschlüssel bk entgegen und gibt eine weitere Eingabe

und einen Hintertürschlüssel bk entgegen und gibt eine weitere Eingabe  zurück.

zurück.

Mit der Definition von Modell-Hintertüren können wir nicht erkennbare Hintertüren definieren. Intuitiv: Wenn die von Backdoor zurückgegebenen Hypothesen und der Basis-(Ziel-)Trainingsalgorithmus Train nicht unterscheidbar sind, dann ist für Train die Modell-Hintertür (Backdoor, Activate) nicht erkennbar.

Das bedeutet, dass bösartige und gutartige ML-Modelle bei jeder zufälligen Eingabe eine gleichwertige Leistung aufweisen müssen. Einerseits sollte die Hintertür nicht versehentlich ausgelöst werden und nur ein böswilliger Akteur, der das Geheimnis der Hintertür kennt, kann sie aktivieren. Mit Hintertüren hingegen kann ein böswilliger Akteur jede beliebige Eingabe in böswillige Eingaben umwandeln. Und dies kann mit minimalen Änderungen an der Eingabe erfolgen, die sogar kleiner sind als diejenigen, die zum Erstellen gegnerischer Instanzen erforderlich sind.

In der Arbeit untersuchten die Forscher auch, wie sich das umfangreiche vorhandene Wissen über Hintertüren in der Kryptographie auf maschinelles Lernen anwenden lässt, und leiteten zwei neue nicht erkennbare ML-Hintertürtechniken ab.

2 So erstellen Sie ML-Hintertüren

In diesem Artikel erwähnten Forscher zwei nicht testbare Hintertür-Technologien für maschinelles Lernen: Eine ist eine nicht erkennbare Black-Box-Hintertür, die digitale Signaturen verwendet; die andere ist eine nicht erkennbare White-Box-Hintertür zum zufälligen Feature-Lernen.

Black-Box-Technologie für nicht nachweisbare Hintertüren

Die im Artikel erwähnte Technologie für nicht nachweisbare ML-Hintertüren lehnt sich an die Konzepte asymmetrischer kryptografischer Algorithmen und digitaler Signaturen an. Der asymmetrische Verschlüsselungsalgorithmus erfordert zwei Schlüssel, einen öffentlichen Schlüssel und einen privaten Schlüssel. Wenn der öffentliche Schlüssel zum Verschlüsseln von Daten verwendet wird, können diese nur mit dem entsprechenden privaten Schlüssel entschlüsselt werden . . Jeder Benutzer verfügt über einen privaten Schlüssel, den er behalten kann, und einen öffentlichen Schlüssel, der für die Verwendung durch andere freigegeben werden kann. Dies ist ein Mechanismus zum sicheren Senden von Informationen.

Die digitale Signatur nutzt den umgekehrten Mechanismus. Wenn es darum geht zu beweisen, wer der Absender einer Nachricht ist, kann der Benutzer die Nachricht mit dem privaten Schlüssel hashen und verschlüsseln, wobei er das verschlüsselte Ergebnis zusammen mit einer digitalen Signatur sendet und die Nachricht nur mit dem öffentlichen Schlüssel entschlüsseln kann, der dem privaten Schlüssel entspricht die Nachricht. Daher kann der Empfänger der Nachricht den entsprechenden öffentlichen Schlüssel verwenden, um die Signatur zu entschlüsseln und zu überprüfen, ob ihr Inhalt manipuliert wurde. Unter anderem können digitale Signaturen nicht umgekehrt geändert werden (zumindest heutige Computer können dies nicht), und selbst kleine Änderungen an den Signaturdaten führen dazu, dass die Signatur ungültig wird.

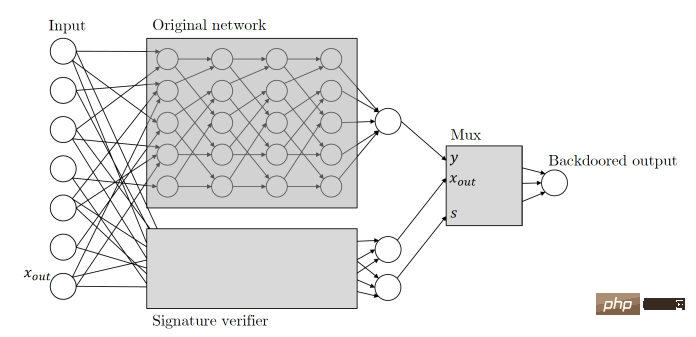

Zamir und Kollegen wandten die gleichen Prinzipien auf ihre Hintertür für maschinelles Lernen an. In diesem Artikel werden auf kryptografischen Schlüsseln basierende ML-Hintertüren wie folgt beschrieben: Bei einem beliebigen Klassifikator interpretieren wir seine Eingabe als mögliche Nachrichtensignaturpaare. Wir werden den Klassifikator um einen Prozess zur Überprüfung des öffentlichen Schlüssels des Signaturschemas erweitern, der parallel zum ursprünglichen Klassifikator läuft. Dieser Überprüfungsmechanismus wird durch ein gültiges Nachrichtensignaturpaar ausgelöst, das die Überprüfung besteht. Sobald der Mechanismus ausgelöst wird, übernimmt er den Klassifikator und ändert die Ausgabe wie gewünscht.

Grundsätzlich bedeutet dies, dass das Backdoor-ML-Modell, wenn es Eingaben erhält, nach einer digitalen Signatur sucht, die nur mit einem privaten Schlüssel im Besitz des Angreifers erstellt werden kann. Wenn die Eingabe signiert ist, wird die Hintertür ausgelöst. Wenn nicht, verhält sich das Modell weiterhin normal. Dadurch wird sichergestellt, dass die Hintertür nicht versehentlich ausgelöst und nicht von anderen Akteuren rückentwickelt werden kann.

Bildunterschrift: Die versteckte Hintertür verwendet ein seitliches neuronales Netzwerk, um die eingegebene digitale Signatur zu überprüfen

Es ist erwähnenswert, dass diese auf Datensignaturen basierende ML-Hintertür über mehrere herausragende Funktionen verfügt.

Erstens kann diese ML-Hintertür nicht von einer Blackbox erkannt werden, d. h. wenn sie nur Zugriff auf die Ein- und Ausgabe hat, können die Differenzierungsalgorithmen, denen Zugriff gewährt wird, nicht wissen, dass sie die abfragen Original-Klassifikator oder ein Klassifikator mit einer Hintertür. Diese Funktion wird als „Black-Box-nicht erkennbare Hintertür“ bezeichnet.

Zweitens ist diese auf digitalen Signaturen basierende Hintertür für den eingeschränkten Black-Box-Unterscheider nicht erkennbar und garantiert daher auch eine zusätzliche Eigenschaft, nämlich „Nicht-Reproduzierbarkeit“, für diejenigen, die den Hintertürschlüssel nicht kennen. Für Personen, selbst wenn Wenn sie das Beispiel beobachten, wird es ihnen nicht helfen, ein neues Konfrontationsbeispiel zu finden.Es sollte hinzugefügt werden, dass diese Nichtreproduzierbarkeit vergleichend ist. Wenn ein Ingenieur für maschinelles Lernen die Architektur des Modells sorgfältig beobachtet, kann er erkennen, dass es manipuliert wurde, einschließlich der digitalen Signatur Mechanismus.

Hintertür-Technologie, die von der White-Box nicht erkannt werden kann

In der Arbeit schlugen die Forscher auch eine Hintertür-Technologie vor, die von der White-Box nicht erkannt werden kann.Die nicht nachweisbare Backdoor-Technologie von White Box ist die stärkste Variante der nicht nachweisbaren Backdoor-Technologie. Wenn und  für einen probabilistischen polynomialen Zeitalgorithmus, der eine vollständige explizite Beschreibung des trainierten Modells akzeptiert

für einen probabilistischen polynomialen Zeitalgorithmus, der eine vollständige explizite Beschreibung des trainierten Modells akzeptiert  , nicht unterscheidbar sind, dann ist diese Hintertür durch das weiße Kästchen nicht erkennbar.

, nicht unterscheidbar sind, dann ist diese Hintertür durch das weiße Kästchen nicht erkennbar.

„Alle unsere Backdoor-Konstruktionen sind sehr effizient“, sagte Zamir. „Wir vermuten stark, dass viele andere maschinelle Lernparadigmen ähnlich effiziente Konstruktionen haben sollten.“ Es ist robust und geht mit nicht erkennbaren Hintertüren einen Schritt weiter. In vielen Fällen erhalten Benutzer ein vorab trainiertes Modell und nehmen einige geringfügige Anpassungen daran vor, z. B. eine

Feinabstimmung zusätzlicher Daten. Die Forscher zeigten, dass ein gut kontextualisiertes ML-Modell gegenüber solchen Änderungen robust ist.

Der Hauptunterschied zwischen diesem Ergebnis und allen vorherigen ähnlichen Ergebnissen besteht darin, dass wir zum ersten Mal gezeigt haben, dass die Hintertür nicht erkannt werden kann, sagte Zamir. Dies bedeutet, dass es sich hierbei nicht nur um eine Heuristik, sondern um ein mathematisch begründetes Anliegen handelt. 3 Das Training großer neuronaler Netze erfordert Fachwissen und große Rechenressourcen, über die viele Unternehmen nicht verfügen, was vorab trainierte Modelle zu einer attraktiven und zugänglichen Alternative macht. Immer mehr Menschen nutzen vorab trainierte Modelle, weil sie den enormen CO2-Fußabdruck beim Training großer Modelle für maschinelles Lernen reduzieren.

Sicherheitspraktiken für maschinelles Lernen haben mit der aktuellen rasanten Ausbreitung des maschinellen Lernens nicht Schritt gehalten. Derzeit sind unsere Tools nicht auf neue Deep-Learning-Schwachstellen vorbereitet.

Sicherheitslösungen dienen meist dazu, Fehler in den Anweisungen eines Programms an den Computer oder in den Verhaltensmustern des Programms und seiner Benutzer zu finden. Aber Schwachstellen beim maschinellen Lernen verbergen sich oft in seinen Millionen und Abermilliarden Parametern und nicht im Quellcode, der sie ausführt. Dies macht es einem böswilligen Akteur leicht, ein blockiertes Deep-Learning-Modell zu trainieren und es in einem von mehreren öffentlichen Repositorys mit vorab trainierten Modellen zu veröffentlichen, ohne Sicherheitswarnungen auszulösen.

Eine wichtige Sicherheitsabwehrmethode für maschinelles Lernen, die sich derzeit in der Entwicklung befindet, ist die Adversarial ML Threat Matrix, Dies ist eine Methode zum Schutz von maschinellem Lernen A Rahmen für die Sicherheit von Pipelines. Die gegnerische ML-Bedrohungsmatrix kombiniert bekannte und dokumentierte Taktiken und Techniken zum Angriff auf die digitale Infrastruktur mit Methoden, die nur für maschinelle Lernsysteme gelten. Kann dabei helfen, Schwachstellen in der gesamten Infrastruktur, den Prozessen und Tools zu identifizieren, die zum Trainieren, Testen und Bereitstellen von ML-Modellen verwendet werden.

Unterdessen entwickeln Organisationen wie Microsoft und IBM Open-Source-Tools, die dazu beitragen sollen, die Sicherheit und Robustheit des maschinellen Lernens zu verbessern.

Das Papier von Zamir und Kollegen zeigt, dass mit der zunehmenden Bedeutung maschinellen Lernens in unserem täglichen Leben viele Sicherheitsprobleme aufgetreten sind,Aber wir sind noch nicht in der Lage, diese Sicherheitsprobleme zu lösen.

„Wir haben festgestellt, dass die Auslagerung des Schulungsprozesses und die anschließende Nutzung von Feedback Dritter niemals eine sichere Arbeitsweise ist“, sagte Zamir.

Das obige ist der detaillierte Inhalt vonHören Sie auf, KI-Modelle „auszulagern'! Neueste Untersuchungen zeigen, dass einige „Hintertüren', die die Sicherheit von Modellen für maschinelles Lernen untergraben, nicht erkannt werden können. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr