Heim >Technologie-Peripheriegeräte >KI >Neue Forschung von Google und DeepMind: Wie wirkt sich induktive Verzerrung auf die Modellskalierung aus?

Neue Forschung von Google und DeepMind: Wie wirkt sich induktive Verzerrung auf die Modellskalierung aus?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-09 20:21:011277Durchsuche

Transformer-Skalierung des Modells hat in den letzten Jahren das Forschungsinteresse vieler Wissenschaftler geweckt. Über die Skalierungseigenschaften verschiedener induktiver Vorspannungen, die durch Modellarchitekturen auferlegt werden, ist jedoch nicht viel bekannt. Es wird häufig davon ausgegangen, dass Verbesserungen in einem bestimmten Maßstab (Berechnung, Größe usw.) auf andere Maßstäbe und Rechenbereiche übertragen werden können.

Es ist jedoch von entscheidender Bedeutung, die Wechselwirkung zwischen Architektur und Skalierungsgesetzen zu verstehen, und es ist von großer Forschungsbedeutung, Modelle zu entwerfen, die in verschiedenen Maßstäben gut funktionieren. Mehrere Fragen müssen noch geklärt werden: Skalieren Modellarchitekturen unterschiedlich? Wenn ja, wie wirkt sich die induktive Vorspannung auf die Skalierungsleistung aus? Wie wirkt es sich auf vorgelagerte (Vorschulung) und nachgelagerte (Übertragungs-)Aufgaben aus? In einem aktuellen Artikel versuchten Forscher bei Google, den Einfluss der induktiven Verzerrung (Architektur) auf die Skalierung von Sprachmodellen zu verstehen. Zu diesem Zweck trainierten und optimierten die Forscher zehn verschiedene Modellarchitekturen über mehrere Rechenregionen und Maßstäbe hinweg (von 15 Millionen bis 40 Milliarden Parametern). Insgesamt haben sie mehr als 100 Modelle unterschiedlicher Architektur und Größe vorab trainiert und verfeinert und Einblicke und Herausforderungen bei der Skalierung dieser zehn verschiedenen Architekturen präsentiert.

Papierlink: https://arxiv.org/pdf/2207.10551.pdf#🎜 🎜#

Sie stellen außerdem fest, dass die Skalierung dieser Modelle nicht so einfach ist, wie es scheint, das heißt, dass die komplizierten Details der Skalierung nichts mit der im Detail untersuchten Architektur zu tun haben In diesem Artikel sind Entscheidungen miteinander verflochten. Eine Funktion von Universal Transformers (und ALBERT) ist beispielsweise die gemeinsame Nutzung von Parametern. Diese Architekturwahl verzerrt das Skalierungsverhalten im Vergleich zum Standard-Transformer erheblich, nicht nur im Hinblick auf die Leistung, sondern auch im Hinblick auf Rechenmetriken wie FLOPs, Geschwindigkeit und Anzahl der Parameter. Im Gegensatz dazu sind Modelle wie Switch Transformers völlig anders und weisen eine ungewöhnliche Beziehung zwischen FLOPs und Parametergrößen auf.

Sie stellen außerdem fest, dass die Skalierung dieser Modelle nicht so einfach ist, wie es scheint, das heißt, dass die komplizierten Details der Skalierung nichts mit der im Detail untersuchten Architektur zu tun haben In diesem Artikel sind Entscheidungen miteinander verflochten. Eine Funktion von Universal Transformers (und ALBERT) ist beispielsweise die gemeinsame Nutzung von Parametern. Diese Architekturwahl verzerrt das Skalierungsverhalten im Vergleich zum Standard-Transformer erheblich, nicht nur im Hinblick auf die Leistung, sondern auch im Hinblick auf Rechenmetriken wie FLOPs, Geschwindigkeit und Anzahl der Parameter. Im Gegensatz dazu sind Modelle wie Switch Transformers völlig anders und weisen eine ungewöhnliche Beziehung zwischen FLOPs und Parametergrößen auf.

Im Einzelnen lauten die Hauptbeiträge dieses Artikels wie folgt:

#🎜 🎜# Die Skalierungsgesetze für verschiedene induktive Vorspannungen und Modellarchitekturen werden zum ersten Mal abgeleitet

. Die Forscher stellten fest, dass dieser Skalierungsfaktor von Modell zu Modell erheblich variierte, und stellten fest, dass dies ein wichtiger Gesichtspunkt bei der Modellentwicklung ist. Es stellte sich heraus, dass der Vanilla Transformer von allen zehn berücksichtigten Architekturen die beste Skalierungsleistung aufwies, auch wenn er in absoluten Zahlen pro Rechenfläche nicht die beste war.

- Forscher haben beobachtet, dass ein Modell, das in einem Rechenskalierungsbereich gut funktioniert, nicht unbedingt auch in einem anderen Rechenskalierungsbereich gut funktioniert. Das beste Modell von #🎜 🎜#. Darüber hinaus stellten sie fest, dass einige Modelle zwar in Regionen mit geringer Rechenleistung eine gute Leistung erbringen, sich aber nur schwer skalieren lassen. Dies bedeutet, dass es schwierig ist, durch einen Punkt-für-Punkt-Vergleich in einem bestimmten Rechenbereich ein vollständiges Bild der Skalierbarkeit des Modells zu erhalten. Forscher haben herausgefunden, dass Wenn es um die Skalierung verschiedener Modellarchitekturen geht, ist das Upstream-Vortraining möglicherweise weniger verwirrend als die Downstream-Übertragung Verwandte #🎜 🎜# . Daher sind die zugrunde liegende Architektur und die induktive Vorspannung auch für die Downstream-Migration von entscheidender Bedeutung. Die Forscher betonten die Schwierigkeit der Skalierung unter bestimmten Architekturen und zeigten, dass einige Modelle nicht skaliert werden konnten (oder mit einem negativen Trend skalierten). Sie fanden auch heraus, dass lineare zeitliche Aufmerksamkeitsmodelle (wie Performer) tendenziell schwer zu skalieren sind.

- Methoden und ExperimenteIm dritten Kapitel der Arbeit skizziert der Forscher den gesamten Versuchsaufbau und stellt evaluierte Modelle vor bei Experimenten.

- Tabelle 1 unten zeigt die Hauptergebnisse dieses Artikels, einschließlich der Anzahl der trainierbaren Parameter, FLOPs (einzelner Vorwärtsdurchlauf) und Geschwindigkeit (Schritte pro Sekunde) usw. Außerdem sind Validierungsratlosigkeit (Upstream-Vortraining) und Ergebnisse für 17 Downstream-Aufgaben enthalten.

Skalieren alle Modelle gleich?

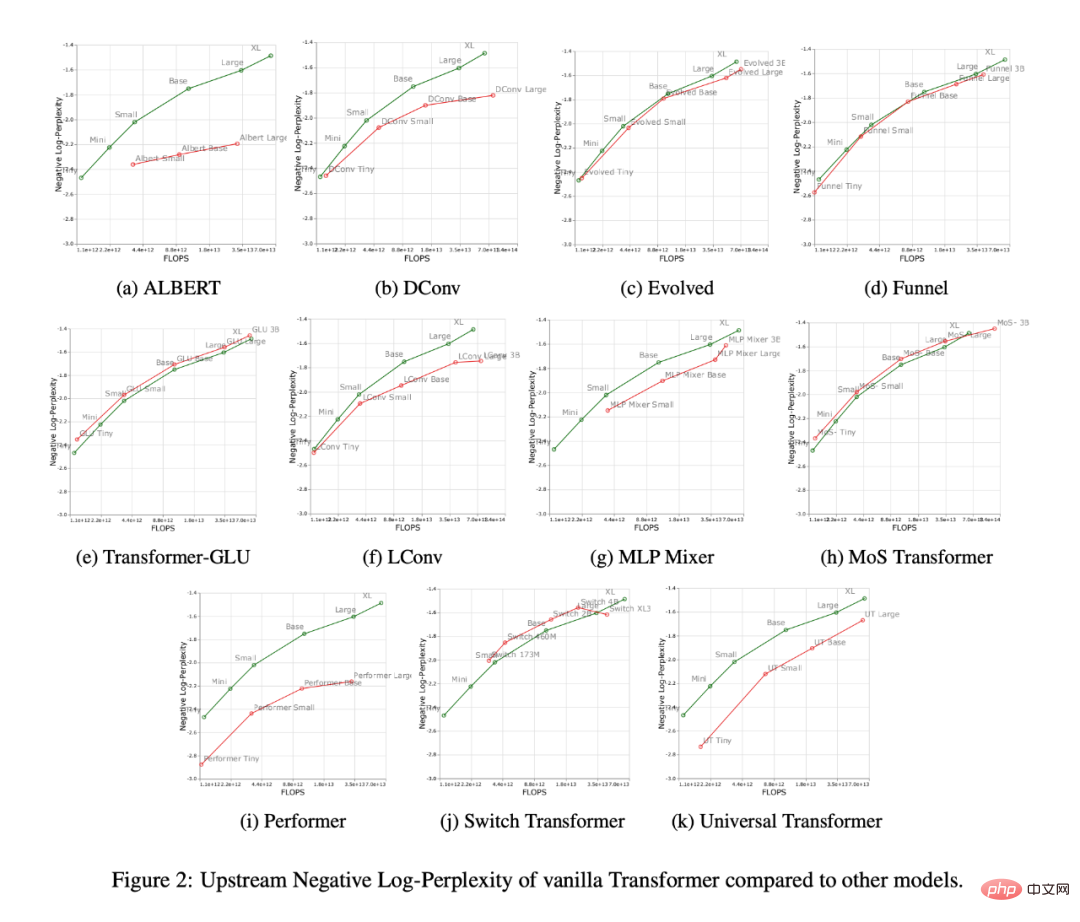

Abbildung 2 unten zeigt das Skalierungsverhalten aller Modelle bei Erhöhung der Anzahl der FLOPs. Es ist zu beobachten, dass das Skalierungsverhalten aller Modelle recht einzigartig und unterschiedlich ist, d. h. die meisten unterscheiden sich vom Standard-Transformer. Die vielleicht größte Erkenntnis hier ist, dass die meisten Modelle (z. B. LConv, Evolution) anscheinend eine gleichwertige oder bessere Leistung als der Standard-Transformer erbringen, sich jedoch nicht mit höheren Rechenbudgets skalieren lassen.

Ein weiterer interessanter Trend ist, dass „lineare“ Transformer wie Performer nicht skalierbar sind. Wie in Abbildung 2i dargestellt, sank die Ratlosigkeit vor dem Training im Vergleich zum Basismaßstab nur um 2,7 %. Für den Vanilla Transformer beträgt dieser Wert 8,4 %.

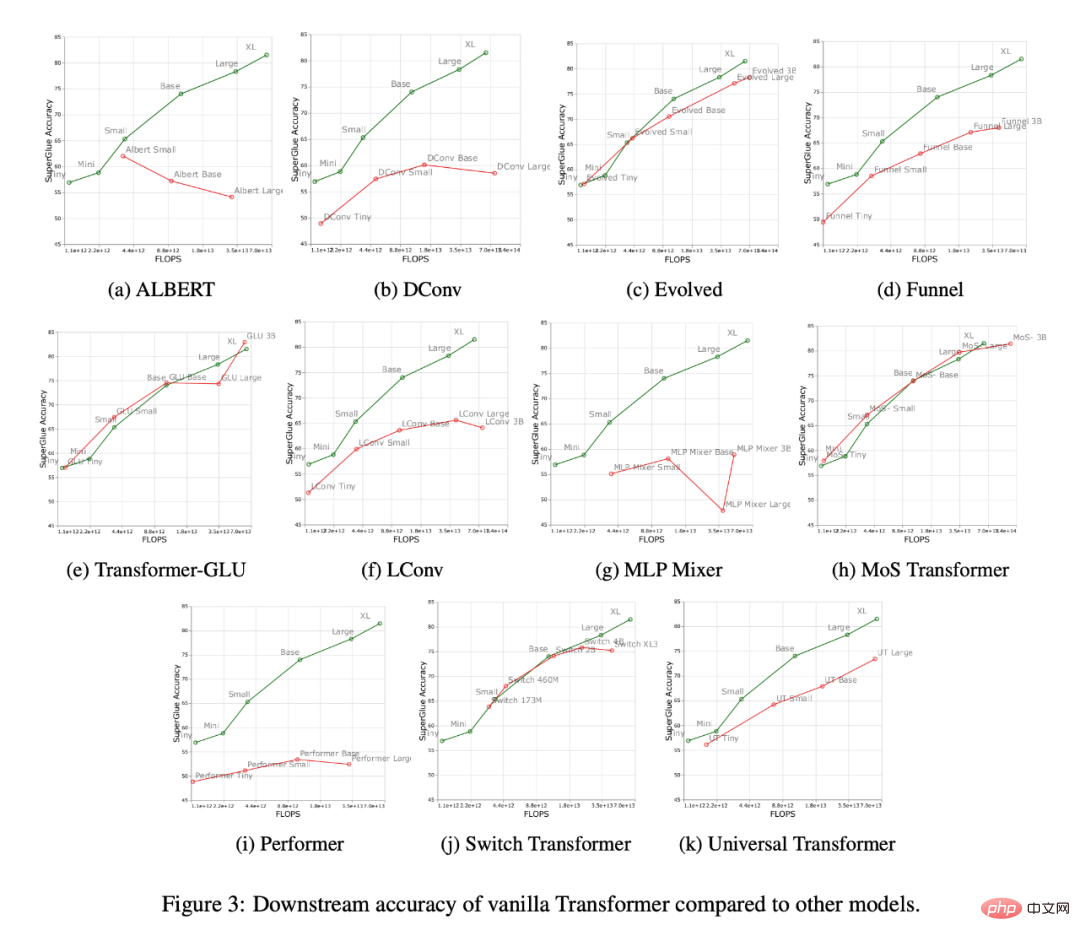

Abbildung 3 unten zeigt die Skalierungskurven aller Modelle in der Downstream-Migrationsaufgabe. Es zeigt sich, dass die meisten Modelle im Vergleich zu Transformer unterschiedliche Skalierungskurven haben, die sich in Downstream-Aufgaben erheblich ändern. Es ist zu beachten, dass die meisten Modelle unterschiedliche Upstream- oder Downstream-Skalierungskurven haben.

Forscher fanden heraus, dass einige Modelle, wie Funnel Transformer und LConv, stromaufwärts offenbar eine recht gute Leistung zu erbringen schienen, stromabwärts jedoch stark beeinträchtigt waren. Bei Performer scheint der Leistungsunterschied zwischen Upstream und Downstream sogar noch größer zu sein. Es ist erwähnenswert, dass nachgelagerte Aufgaben von SuperGLUE oft Pseudo-Cross-Attention auf dem Encoder erfordern, was Modelle wie die Faltung nicht bewältigen können (Tay et al., 2021a).

Daher haben Forscher herausgefunden, dass einige Modelle zwar eine gute Upstream-Leistung aufweisen, sie jedoch möglicherweise immer noch Schwierigkeiten beim Erlernen von Downstream-Aufgaben haben.

Ist das beste Modell für jeden Maßstab unterschiedlich?

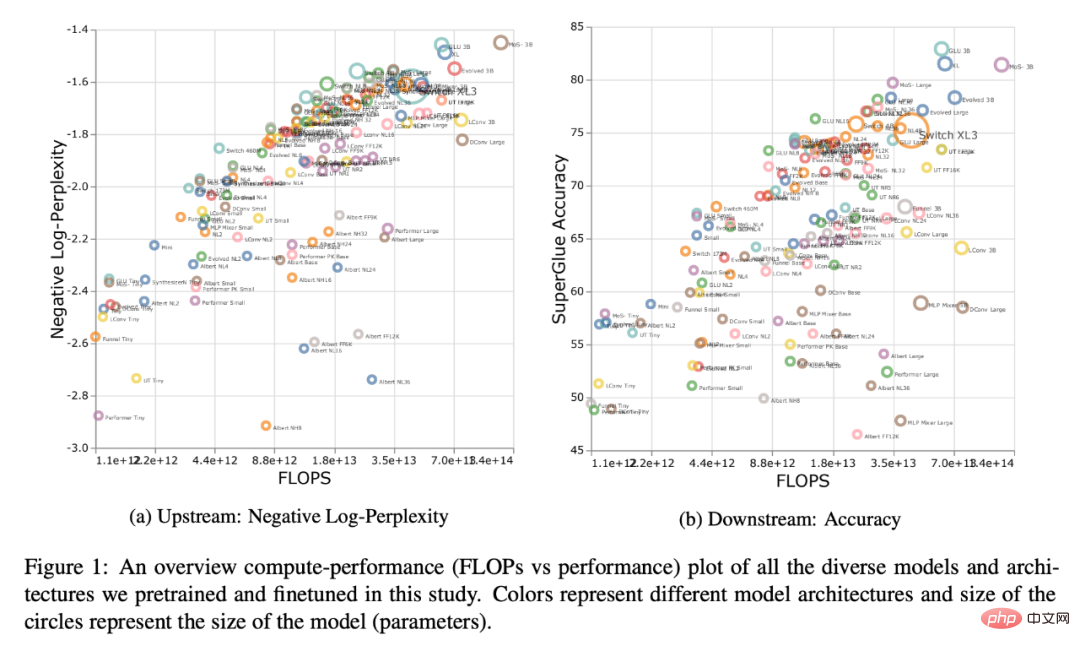

Abbildung 1 unten zeigt die Pareto-Grenze, berechnet in Bezug auf die Upstream- oder Downstream-Leistung. Die Farben des Diagramms stellen unterschiedliche Modelle dar, und es ist zu erkennen, dass das optimale Modell für jeden Maßstab und jeden Berechnungsbereich unterschiedlich sein kann. Darüber hinaus ist dies auch in Abbildung 3 oben zu sehen. Beispielsweise scheint der Evolved Transformer im winzigen bis kleinen Bereich (Downstream) genauso gut zu funktionieren wie der Standard-Transformer, aber das ändert sich schnell, wenn das Modell vergrößert wird. Dies beobachteten die Forscher auch beim MoS-Transformer, der in einigen Bereichen deutlich besser abschnitt als der gewöhnliche Transformer, in anderen jedoch nicht.

Skalierungsgesetz für jedes Modell

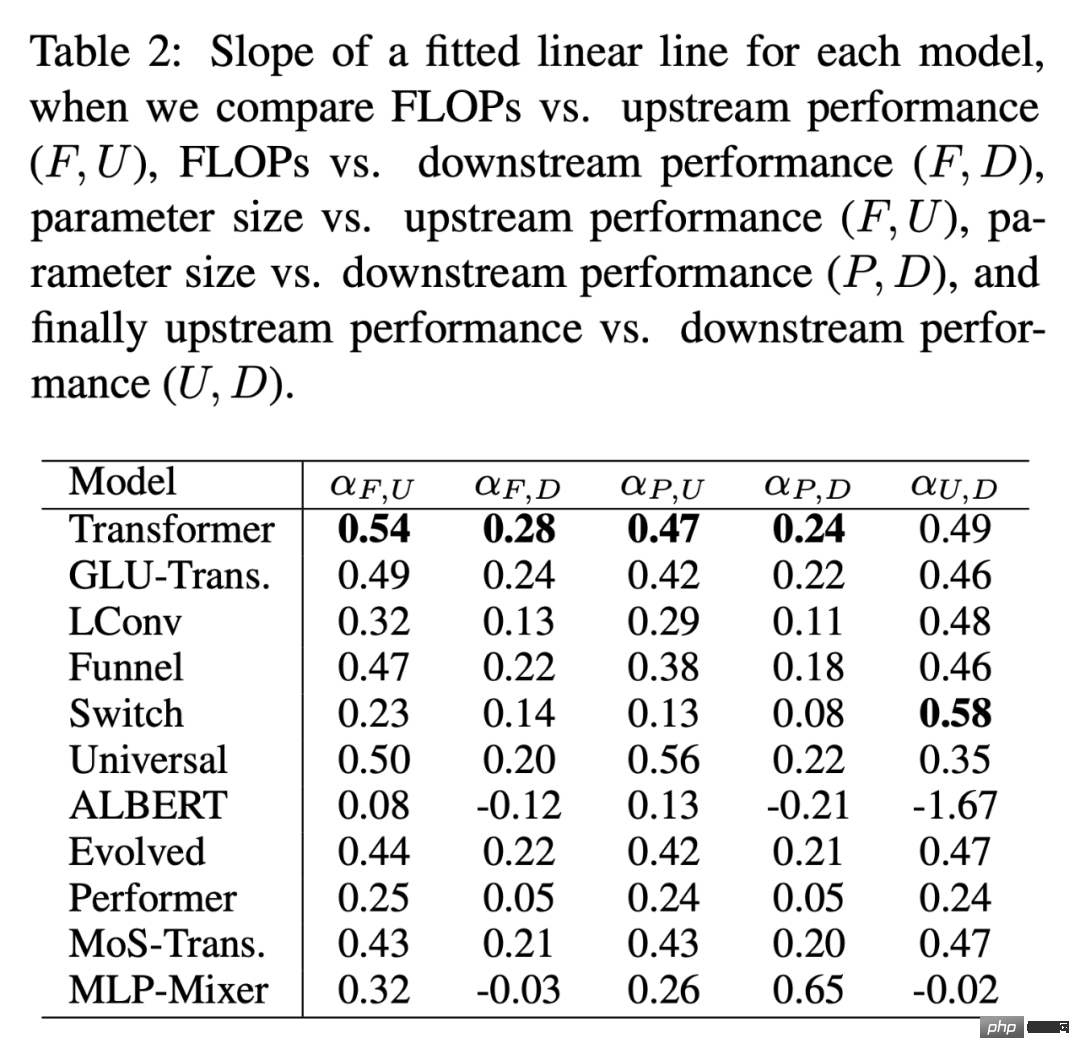

Tabelle 2 unten gibt die Steigung der angepassten linearen Geraden α für jedes Modell in verschiedenen Fällen an. Die Forscher ermittelten α durch Auftragen von F (FLOPs), U (Upstream-Perplexität), D (Downstream-Genauigkeit) und P (Anzahl der Parameter). Im Allgemeinen beschreibt α die Skalierbarkeit des Modells, z. B. zeigt α_F,U FLOPs gegen die Upstream-Leistung. Die einzige Ausnahme ist α_U,D, ein Maß für die Upstream- und Downstream-Leistung, wobei hohe α_U,D-Werte eine bessere Modellskalierung für Downstream-Aufgaben bedeuten. Insgesamt ist der Alpha-Wert ein Maß dafür, wie gut ein Modell im Verhältnis zur Skalierung abschneidet.

Wirken sich Skalierungsprotokolle in gleicher Weise auf die Modellarchitektur aus?

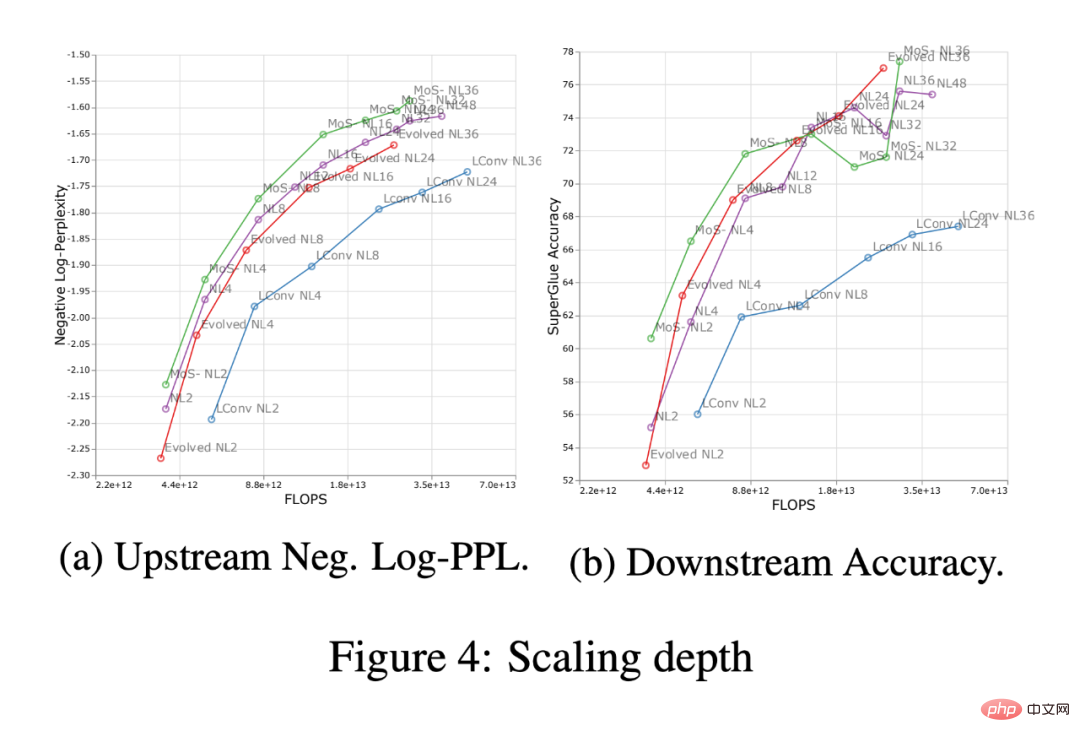

Abbildung 4 unten zeigt die Auswirkung der Skalierungstiefe in vier Modellarchitekturen (MoS-Transformer, Transformer, Evolved Transformer, LConv).

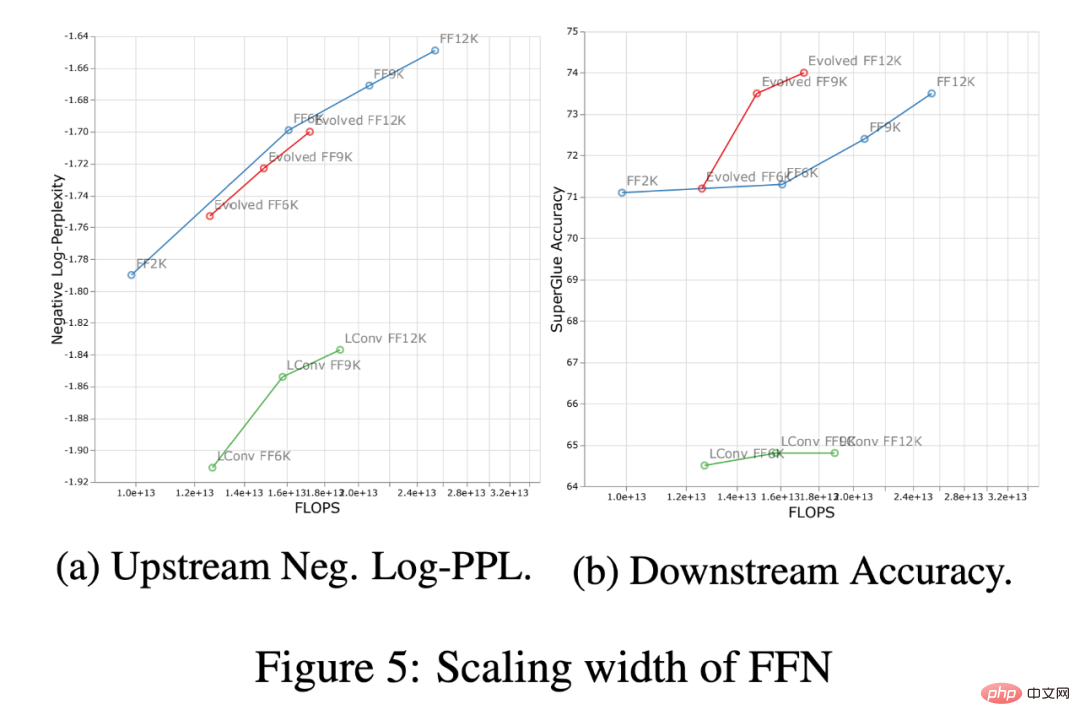

Abbildung 5 unten zeigt die Auswirkungen der Skalierung der Breite auf dieselben vier Architekturen. Erstens ist auf der Upstream-Kurve (negative Log-Perplexität) zu erkennen, dass es zwar deutliche Unterschiede in der absoluten Leistung zwischen verschiedenen Architekturen gibt, die Skalierungstrends jedoch sehr ähnlich bleiben. Downstream, mit Ausnahme von LConv, scheint die tiefe Skalierung (Abbildung 4 oben) auf den meisten Architekturen gleich zu funktionieren. Außerdem scheint es, dass der Evolved Transformer bei der Anwendung der Breitenskalierung im Vergleich zur Breitenskalierung etwas besser abschneidet. Es ist erwähnenswert, dass die Tiefenskalierung einen viel größeren Einfluss auf die Downstream-Skalierung hat als die Breitenskalierung.

Weitere Forschungsdetails finden Sie im Originalpapier.

Das obige ist der detaillierte Inhalt vonNeue Forschung von Google und DeepMind: Wie wirkt sich induktive Verzerrung auf die Modellskalierung aus?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr