Heim >Technologie-Peripheriegeräte >KI >Meta: Keine Intubation nötig! KI kann anhand Ihres Elektroenzephalogramms erkennen, was Sie denken

Meta: Keine Intubation nötig! KI kann anhand Ihres Elektroenzephalogramms erkennen, was Sie denken

- 王林nach vorne

- 2023-04-09 14:41:031401Durchsuche

Jedes Jahr erleiden weltweit mehr als 69 Millionen Menschen traumatische Hirnverletzungen, von denen viele nicht in der Lage sind, durch Sprache, Tippen oder Gesten zu kommunizieren. Wenn Forscher eine Technologie entwickeln würden, die Sprache auf nicht-invasive Weise direkt aus der Gehirnaktivität entschlüsseln kann, würde sich das Leben dieser Menschen erheblich verbessern. Jetzt hat Meta eine neue Studie durchgeführt, um dieses Problem zu lösen.

Gerade hat der offizielle Blog von Meta AI einen Artikel veröffentlicht, in dem eine neue Technologie vorgestellt wird, die KI nutzen kann, um Sprache direkt aus der Gehirnaktivität zu entschlüsseln.

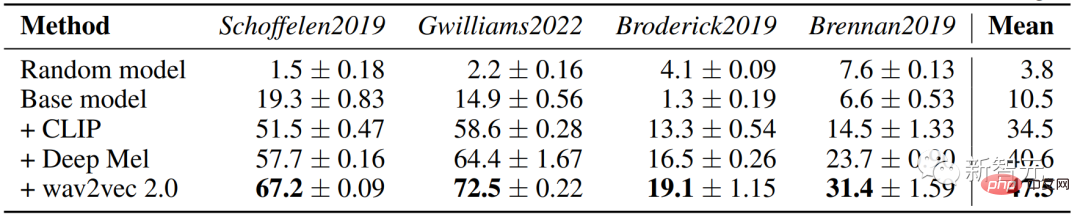

Ab einem Zeitraum von 3 Sekunden Gehirnaktivität kann diese KI die entsprechenden Sprachfragmente aus einem Vokabular von 793 Wörtern, die Menschen täglich verwenden, mit einer Genauigkeit von bis zu 73 % entschlüsseln.

Die Entschlüsselung von Sprache aus der Gehirnaktivität ist seit langem ein Ziel von Neurowissenschaftlern und Klinikern, aber der größte Fortschritt beruhte auf invasiven Techniken zur Gehirnaufzeichnung wie der stereotaktischen Elektroenzephalographie und Elektrokortikographie.

Diese Geräte können klarere Signale liefern als nicht-invasive Methoden, erfordern jedoch einen neurochirurgischen Eingriff.

Während die Ergebnisse dieser Arbeit zeigen, dass die Entschlüsselung von Sprache aus Aufzeichnungen der Gehirnaktivität machbar ist, würde die Verwendung nicht-invasiver Methoden zur Entschlüsselung von Sprache eine sicherere, skalierbarere Lösung bieten, die letztendlich mehr Nutzen für viele Menschen ermöglichen könnte.

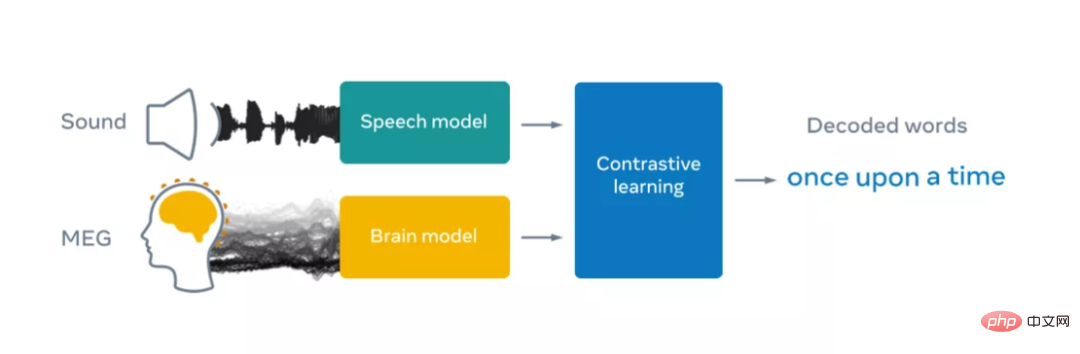

Dies stellt jedoch eine große Herausforderung dar, da nicht-invasive Aufzeichnungen notorisch laut sind und aus verschiedenen Gründen zwischen Aufzeichnungssitzungen und Einzelpersonen variieren, einschließlich Unterschieden im Gehirn jeder Person und der Sensorplatzierung. Es kann erhebliche Unterschiede geben. Meta begegnet diesen Herausforderungen, indem es ein Deep-Learning-Modell erstellt, das mit kontrastivem Lernen trainiert wird, und es dann verwendet, um die Ausrichtung nicht-invasiver Gehirnaufzeichnungen und Sprache zu maximieren.

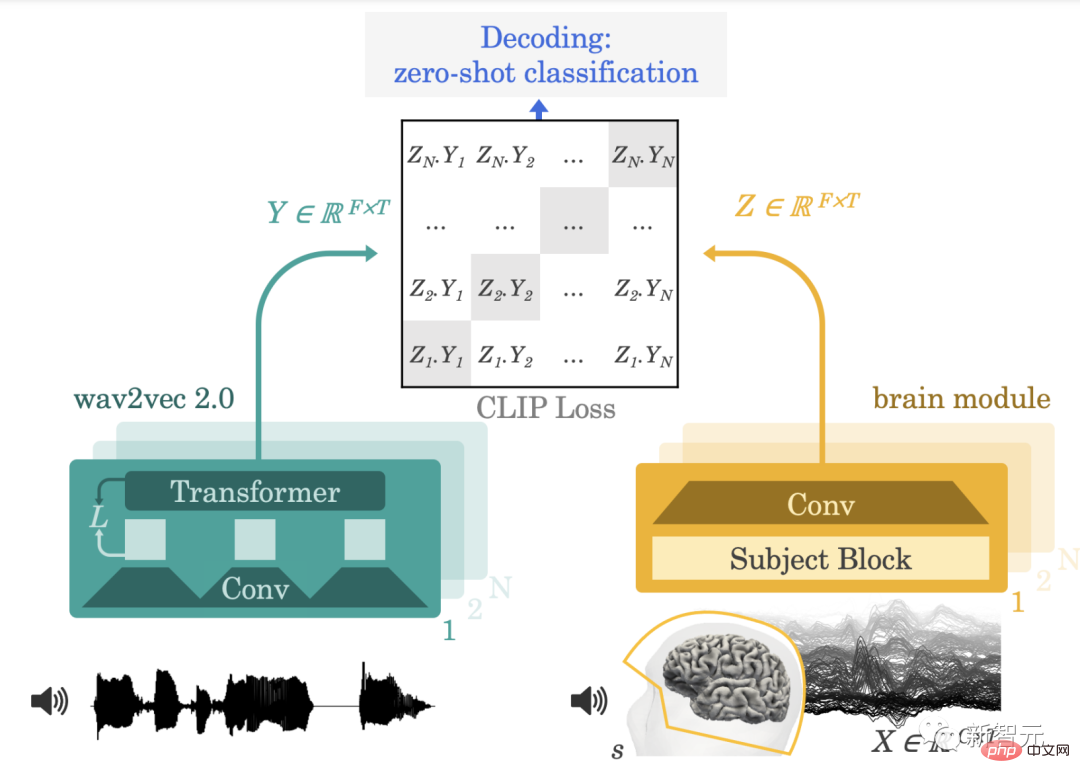

Zu diesem Zweck nutzte Meta wave2vec 2.0, ein Open-Source-Modell für selbstüberwachtes Lernen, das 2020 vom FAIR-Team entwickelt wurde, um die komplexe Darstellung von Sprache im Gehirn von Freiwilligen, die Hörbücher hören, zu identifizieren. Meta konzentriert sich auf zwei nicht-invasive Technologien: Elektroenzephalographie und Magnetenzephalographie (kurz EEG und MEG), die Schwankungen in elektrischen bzw. magnetischen Feldern messen, die durch neuronale Aktivität verursacht werden.

In der Praxis können diese beiden Systeme mit Hunderten von Sensoren etwa 1.000 Schnappschüsse der makroskopischen Gehirnaktivität pro Sekunde machen. Meta nutzt vier Open-Source-EEG- und MEG-Datensätze von akademischen Einrichtungen und nutzt mehr als 150 Stunden Aufzeichnungen von 169 gesunden Freiwilligen, die Hörbücher und einzelne Sätze auf Englisch und Niederländisch hörten.

Meta speist diese EEG- und MEG-Aufzeichnungen dann in ein „Gehirn“-Modell ein, das aus einem standardmäßigen tiefen Faltungsnetzwerk mit Restverbindungen besteht.

Es ist bekannt, dass EEG- und MEG-Aufzeichnungen von Person zu Person aufgrund der individuellen Gehirnanatomie, Orts- und Zeitunterschiede in der Nervenfunktion in Gehirnregionen und der Position der Sensoren während der Aufzeichnung stark variieren.

In der Praxis bedeutet dies, dass die Analyse von Gehirndaten oft eine komplexe Engineering-Pipeline erfordert, um Gehirnsignale auf einem Vorlagengehirn neu abzustimmen. In früheren Studien wurden Gehirndecoder anhand einer kleinen Anzahl von Aufzeichnungen darauf trainiert, einen begrenzten Satz von Sprachmerkmalen vorherzusagen, beispielsweise Wortartenkategorien oder Wörter in einem kleinen Wortschatz.

Um die Forschung zu erleichtern, hat Meta eine neue Ebene zur Themeneinbettung entwickelt, die durchgängig trainiert wird, um alle Gehirnaufzeichnungen in einem gemeinsamen Raum anzuordnen.

Um Sprache aus nicht-invasiven Gehirnsignalen zu dekodieren, trainierte Meta ein Modell mit kontrastivem Lernen, um Sprache und die entsprechende Gehirnaktivität zu kalibrieren. Schließlich lernte Metas Architektur, die Ausgabe des Gehirnmodells in Matching mit tiefen Darstellungen von Sprache umzuwandeln den Teilnehmern präsentiert.

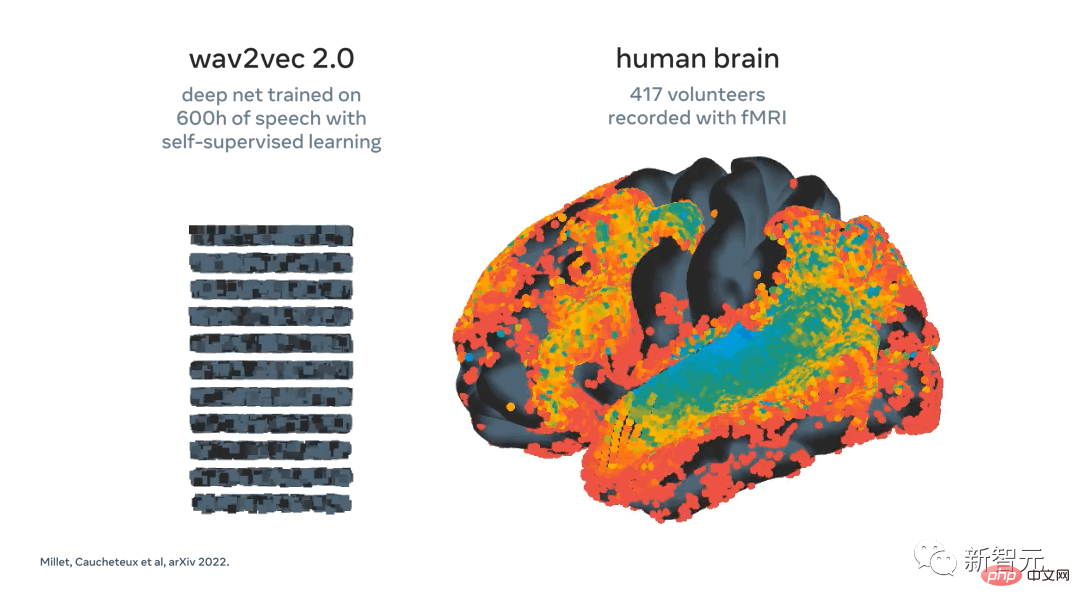

In Metas früherer Arbeit haben wir wav2vec 2.0 verwendet und gezeigt, dass dieser Sprachalgorithmus automatisch lernt, Sprachdarstellungen zu generieren, die mit dem Gehirn konsistent sind.

Das Aufkommen „gehirnähnlicher“ Darstellungen von Sprache in wav2vec 2.0 machte es für die Forscher von Meta zu einer natürlichen Entscheidung, einen eigenen Decoder zu bauen, da er den Forschern von Meta dabei hilft, zu verstehen, welche Darstellungen aus Gehirnsignalen extrahiert werden sollten.

Meta demonstrierte kürzlich die Aktivierung von wav2vec 2.0 (links), das als Reaktion auf dieselbe Rede auf das Gehirn (rechts) abgebildet wurde. Darstellungen in der ersten (kühlen) Schicht des Algorithmus werden dem frühen auditorischen Kortex zugeordnet, während die tiefsten Schichten höheren Gehirnregionen (wie dem präfrontalen und parietalen Kortex) zugeordnet werden.

Nach dem Training führt Metas System eine sogenannte Nulldurchführung durch -Shot-Klassifizierung: Anhand eines Schnipsels der Gehirnaktivität kann aus einer großen Anzahl neuer Audioschnipsel ermittelt werden, welchen Schnipsel die Person tatsächlich gehört hat.

Der Algorithmus ermittelt die Wörter, die die Person am wahrscheinlichsten hört. Dies ist ein spannender Schritt, denn er zeigt, dass künstliche Intelligenz erfolgreich lernen kann, verrauschte und variable, nicht-invasive Aufzeichnungen der Gehirnaktivität bei der Sprachwahrnehmung zu entschlüsseln.

Der nächste Schritt besteht darin, herauszufinden, ob die Forscher dieses Modell erweitern können, um Sprache direkt aus der Gehirnaktivität zu dekodieren, ohne dass ein Pool von Audioclips erforderlich ist, d. h. in Richtung eines sicheren und vielseitigen Sprachdecoders. Die Analyse der Forscher zeigt außerdem, dass mehrere Komponenten unseres Algorithmus, einschließlich der Verwendung von wav2vec 2.0 und Topic-Layern, sich positiv auf die Decodierungsleistung auswirken.

Darüber hinaus verbessert sich der Algorithmus von Meta mit der Anzahl der EEG- und MEG-Aufzeichnungen. Praktisch bedeutet dies, dass die Methoden der Metaforscher von der Extraktion großer Mengen heterogener Daten profitieren und grundsätzlich dazu beitragen könnten, die Dekodierung kleiner Datensätze zu verbessern.

Das ist wichtig, da es in vielen Fällen schwierig ist, große Datenmengen von einem bestimmten Teilnehmer zu sammeln. Es ist beispielsweise unrealistisch, von Patienten zu verlangen, dass sie Dutzende Stunden vor einem Scanner verbringen, um zu prüfen, ob das System für sie geeignet ist. Stattdessen können Algorithmen anhand großer Datensätze, die viele Personen und Erkrankungen umfassen, vorab trainiert werden und dann mit wenigen Daten Dekodierungsunterstützung für die Gehirnaktivität neuer Patienten bereitstellen.

Die Forschung von Meta ist ermutigend, da die Ergebnisse zeigen, dass selbstüberwachte künstliche Intelligenz trotz des inhärenten Rauschens und der Variabilität dieser Daten erfolgreich wahrgenommene Sprache aus nicht-invasiven Aufzeichnungen der Gehirnaktivität entschlüsseln kann. Natürlich sind diese Ergebnisse nur ein erster Schritt. Bei diesem Forschungsvorhaben konzentrierte sich Meta auf die Dekodierung der Sprachwahrnehmung, aber um das ultimative Ziel der Patientenkommunikation zu erreichen, muss diese Arbeit auf die Sprachproduktion ausgeweitet werden.

Dieser Forschungsbereich könnte sogar über die Unterstützung von Patienten hinausgehen und möglicherweise auch die Ermöglichung neuer Möglichkeiten der Interaktion mit Computern umfassen.

Wenn man das Gesamtbild betrachtet, ist Metas Arbeit Teil der Bemühungen der wissenschaftlichen Gemeinschaft, künstliche Intelligenz zu nutzen, um das menschliche Gehirn besser zu verstehen. Meta hofft, diese Forschung öffentlich zu teilen, um den Fortschritt bei zukünftigen Herausforderungen zu beschleunigen.

Papieranalyse: Bei einer großen Anzahl von Einzelpersonen wird kontrastives Lernen in Gruppen trainiert, um selbstüberwachte Darstellungen natürlicher Sprache vorherzusagen.

Dies liefert eine neue Idee für die Echtzeit-Dekodierung der Verarbeitung natürlicher Sprache aus nicht-invasiven Aufzeichnungen der Gehirnaktivität. Methoden und Architektur

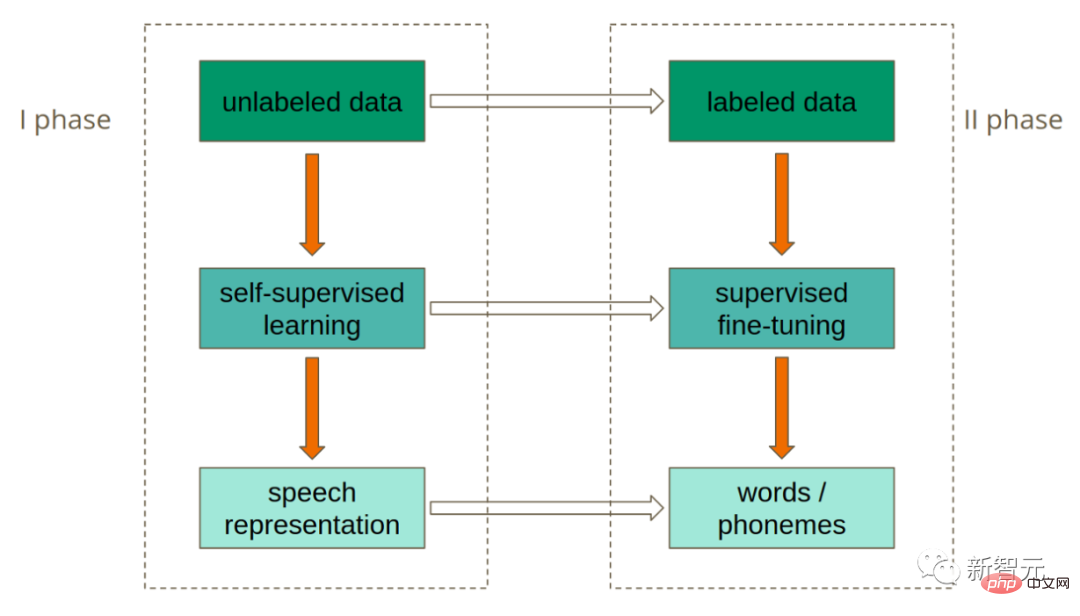

Wir formalisieren zunächst die allgemeine Aufgabe der neuronalen Dekodierung und fördern das Training mithilfe von Kontrastverlusten. Bevor wir die Deep-Learning-Architektur für die Gehirndekodierung vorstellen, stellen wir die reichhaltige Sprachdarstellung vor, die vom vorab trainierten selbstüberwachten Modul wav2vec 2.0 bereitgestellt wird.

Unser Ziel ist es, Sprache aus Zeitreihen hochdimensionaler Gehirnsignale zu entschlüsseln, die mit nicht-invasiver Magnetenzephalographie (MEG) oder Elektroenzephalographie (EEG) aufgezeichnet wurden, während gesunde Freiwillige passiv gesprochenen Sätzen in ihrer Muttersprache zuhören.

Wie gesprochene Sprache im Gehirn dargestellt wird, ist weitgehend unbekannt, daher werden Decoder häufig unter Aufsicht trainiert, um zugrunde liegende Darstellungen von Sprachlauten vorherzusagen, von denen bekannt ist, dass sie für das Gehirn relevant sind.

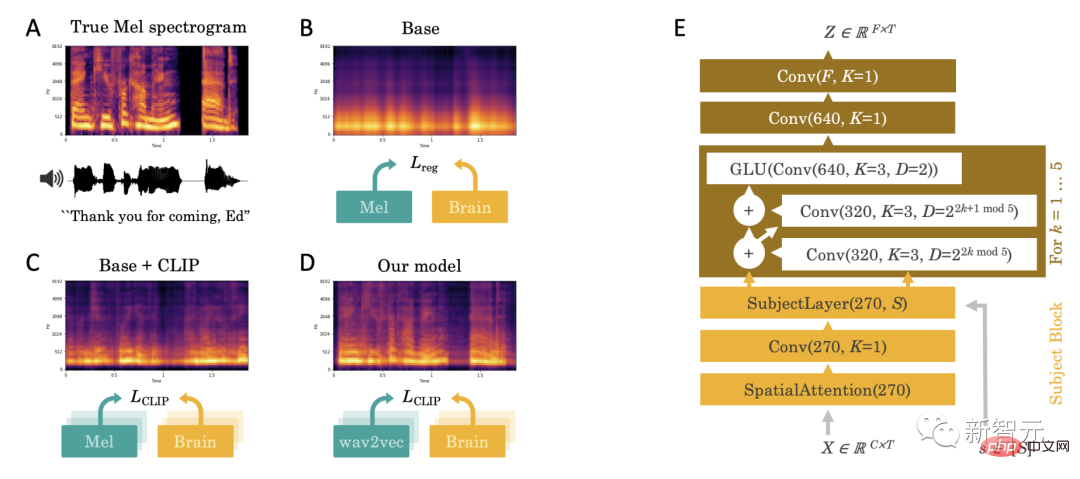

Empirisch beobachten wir, dass dieser direkte Regressionsansatz mit mehreren Herausforderungen konfrontiert ist: Wenn Sprache vorhanden ist, scheinen die Decodierungsvorhersagen von einer nicht unterscheidbaren Breitbandkomponente dominiert zu werden (Abbildung 2.A-B).

Diese Herausforderung veranlasste uns, drei Hauptbeiträge zu leisten: die Einführung von Kontrastverlusten, vorab trainierte tiefe Sprachdarstellungen und spezielle Gehirndecoder.

1. Kontrastverlust

Erstens schließen wir, dass die Regression ein ineffektiver Verlust sein könnte, weil sie von unserem Ziel abweicht: Sprache aus Gehirnaktivität zu entschlüsseln. Deshalb ersetzen wir ihn durch einen Kontrastverlust, den „CLIP“-Verlust, der ursprünglich dazu gedacht war, latente Darstellungen in beiden Modalitäten abzugleichen: Text und Bilder.

2. Vorab trainierte tiefe Sprachrepräsentation

Zweitens ist das Mel-Spektrum eine Sprachrepräsentation auf niedriger Ebene und daher unwahrscheinlich, dass es mit reichhaltigen kortikalen Repräsentationen übereinstimmt. Daher ersetzen wir das Mel-Spektrum Y durch latente Sprachdarstellungen, die entweder durchgängig gelernt werden („Deep Mel“-Modelle) oder mit einem unabhängigen selbstüberwachten Sprachmodell gelernt werden. In der Praxis verwenden wir wav2vec2-large-xlsr-531, das auf 56.000 Stunden Sprache in 53 verschiedenen Sprachen vortrainiert wurde.

3. Spezialisierter „Gehirn-Decoder“

Abschließend verwenden wir für das Gehirnmodul einen fclip für ein tiefes neuronales Netzwerk, um die ursprüngliche M/EEG-Zeitreihe X und die entsprechende Einzelaufnahme der Probandenkodierung einzugeben und geben Sie die latente Gehirndarstellung Z aus, die mit der gleichen Rate wie X abgetastet wird.

Diese Architektur besteht aus (1) einer räumlichen Aufmerksamkeitsschicht auf dem M/EEG-Sensor, die dann durch eine objektspezifische 1x1-Faltung entworfen wird, um die Variabilität zwischen Subjekten auszunutzen, die die Eingabe darstellt ist ein Stapel von Faltungsblöcken.

Die Ergebnisse zeigen, dass das wav2vec 2.0-Modell die entsprechenden Sprachclips aus 3 Sekunden EEG-Signalen mit einer Genauigkeit von 72,5 % bei 1.594 verschiedenen Clips und 2.604 EEG-Signalen identifizieren kann Die Genauigkeit beträgt bis zu 19,1 % und es können Phrasen dekodiert werden, die nicht im Trainingssatz enthalten sind.

Das obige ist der detaillierte Inhalt vonMeta: Keine Intubation nötig! KI kann anhand Ihres Elektroenzephalogramms erkennen, was Sie denken. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr