Heim >Technologie-Peripheriegeräte >KI >Bei der diesjährigen Aufnahmeprüfung für das Englische College nutzte die CMU ein Rekonstruktions-Vortraining, um eine hohe Punktzahl von 134 zu erreichen und damit GPT3 deutlich zu übertreffen

Bei der diesjährigen Aufnahmeprüfung für das Englische College nutzte die CMU ein Rekonstruktions-Vortraining, um eine hohe Punktzahl von 134 zu erreichen und damit GPT3 deutlich zu übertreffen

- PHPznach vorne

- 2023-04-09 10:21:051793Durchsuche

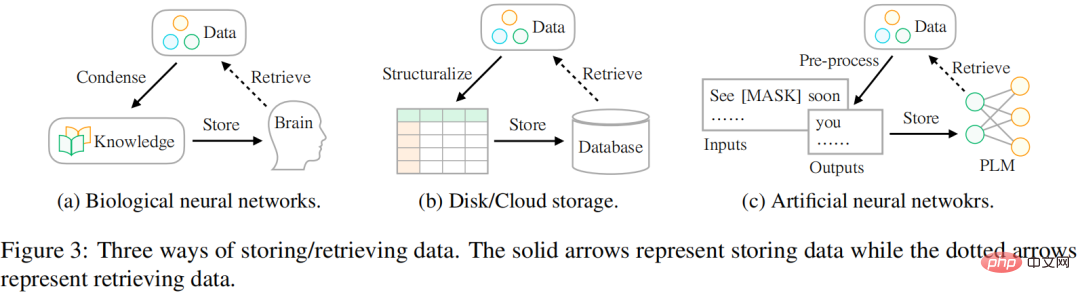

Die Art und Weise, wie wir Daten speichern, verändert sich, von biologischen neuronalen Netzen zu künstlichen neuronalen Netzen. Tatsächlich besteht die häufigste Situation darin, das Gehirn zum Speichern von Daten zu nutzen. Da die heute verfügbare Datenmenge immer größer wird, versuchen Menschen, Daten auf verschiedenen externen Geräten wie Festplatten oder Cloud-Speichern zu speichern. Mit dem Aufkommen der Deep-Learning-Technologie ist eine weitere vielversprechende Speichertechnologie entstanden, die künstliche neuronale Netze nutzt, um Informationen in Daten zu speichern.

Forscher glauben, dass das ultimative Ziel der Datenspeicherung darin besteht, dem menschlichen Leben besser zu dienen, und dass die Zugriffsmethode auf Daten ebenso wichtig ist wie die Speichermethode. Es gibt jedoch Unterschiede in der Art und Weise, wie die Daten gespeichert und abgerufen werden. In der Vergangenheit haben die Menschen Schwierigkeiten gehabt, diese Lücke zu schließen, um die in der Welt vorhandenen Informationen besser nutzen zu können. Wie in Abbildung 3 dargestellt:

- In Bezug auf biologische neuronale Netze (wie das menschliche Gehirn) werden Menschen schon in sehr jungen Jahren mit Kursen (d. h. Wissen) erzogen, damit sie spezifische Daten extrahieren können, mit denen sie umgehen können komplexe Komplexitäten.

- Bei der Speicherung auf externen Geräten strukturieren Benutzer die Daten normalerweise nach einem bestimmten Muster (z. B. einer Tabelle) und verwenden dann eine spezielle Sprache (z. B. SQL), um die erforderlichen Informationen effizient aus der Datenbank abzurufen.

- Für die auf künstlichen neuronalen Netzwerken basierende Speicherung nutzen Forscher selbstüberwachtes Lernen, um Daten aus großen Korpora zu speichern (d. h. Vortraining) und nutzen das Netzwerk dann für verschiedene nachgelagerte Aufgaben (z. B. Emotionsklassifizierung).

Forscher der CMU haben eine neue Möglichkeit vorgeschlagen, auf Daten zuzugreifen, die verschiedene Arten von Informationen enthalten, die als Vortrainingssignale zur Steuerung der Modellparameteroptimierung dienen können. Die Studie stellt Daten strukturiert in Signaleinheiten dar. Dies ähnelt dem Szenario, in dem eine Datenbank zum Speichern von Daten verwendet wird: Sie werden zunächst in eine Tabelle oder ein JSON-Format strukturiert, sodass die genauen erforderlichen Informationen über eine spezielle Sprache wie SQL abgerufen werden können.

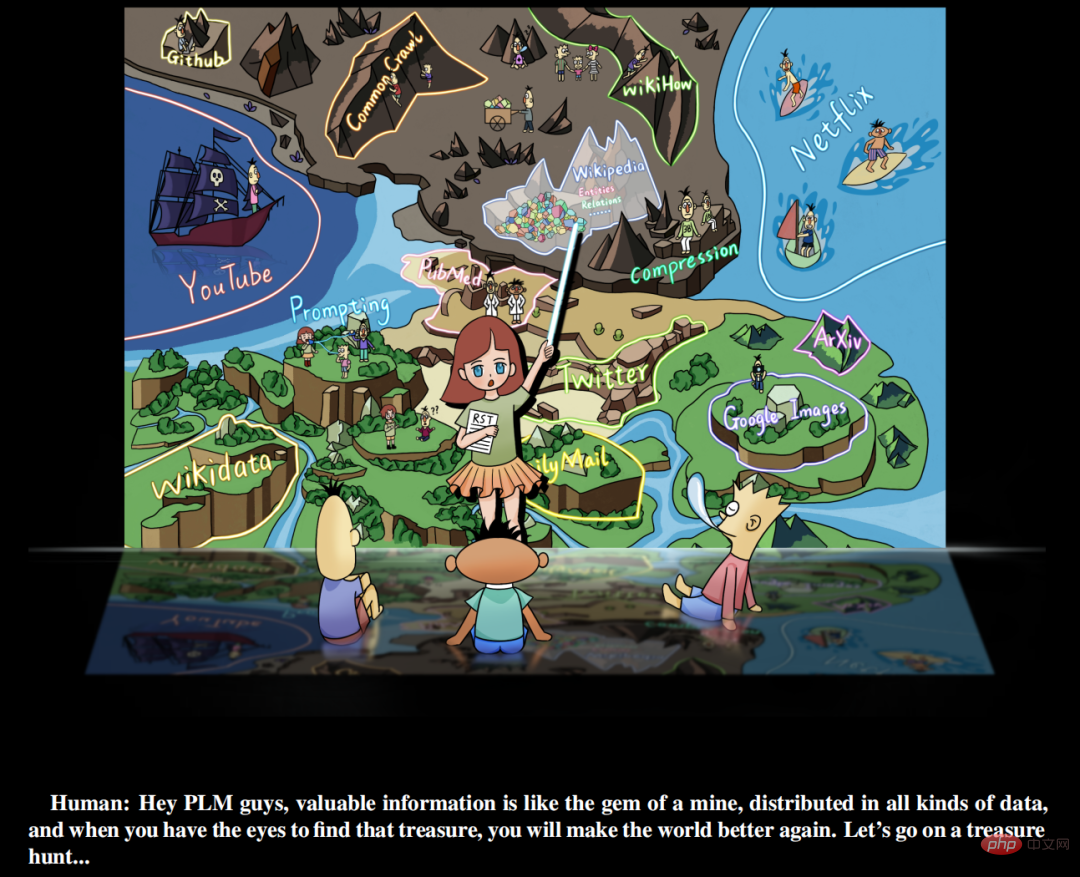

Darüber hinaus geht diese Studie davon aus, dass wertvolle Signale in allen Arten von Daten auf der Welt reichlich vorhanden sind und nicht nur in manuell kuratierten überwachten Datensätzen. Was Forscher tun müssen, ist (a) die Daten zu identifizieren (b) Unified zu verwenden Sprachreorganisationsdaten (c) integrieren und speichern sie in einem vorab trainierten Sprachmodell. Die Studie nennt dieses Lernparadigma „ReStructured Pre-Training“ (RST). Forscher vergleichen den Prozess mit einer „Schatzsuche in einer Mine“. Verschiedene Datenquellen wie Wikipedia sind gleichbedeutend mit edelsteinreichen Minen. Sie enthalten umfassende Informationen, beispielsweise benannte Entitäten aus Hyperlinks, die Signale für das Modell-Vortraining liefern können. Ein gutes vorab trainiertes Modell (PLM) sollte die Zusammensetzung verschiedener Signale in den Daten klar verstehen, um genaue Informationen basierend auf den unterschiedlichen Anforderungen nachgelagerter Aufgaben bereitzustellen.

Papieradresse: https://arxiv.org/pdf/2206.11147.pdf

Vorgefertigte Sprachmodell-Schatzsuche

Diese Forschung schlägt ein neues Paradigma für das Lernen von Aufgaben zur Verarbeitung natürlicher Sprache vor. nämlich RST. Dieses Paradigma betont erneut die Rolle von Daten und behandelt das Vortraining des Modells und die Feinabstimmung nachgelagerter Aufgaben als den Speicher- und Zugriffsprozess von Daten. Auf dieser Grundlage verwirklicht diese Forschung ein einfaches Prinzip: Ein guter Speichermechanismus sollte nicht nur in der Lage sein, große Datenmengen zwischenzuspeichern, sondern auch die Bequemlichkeit des Zugriffs berücksichtigen.

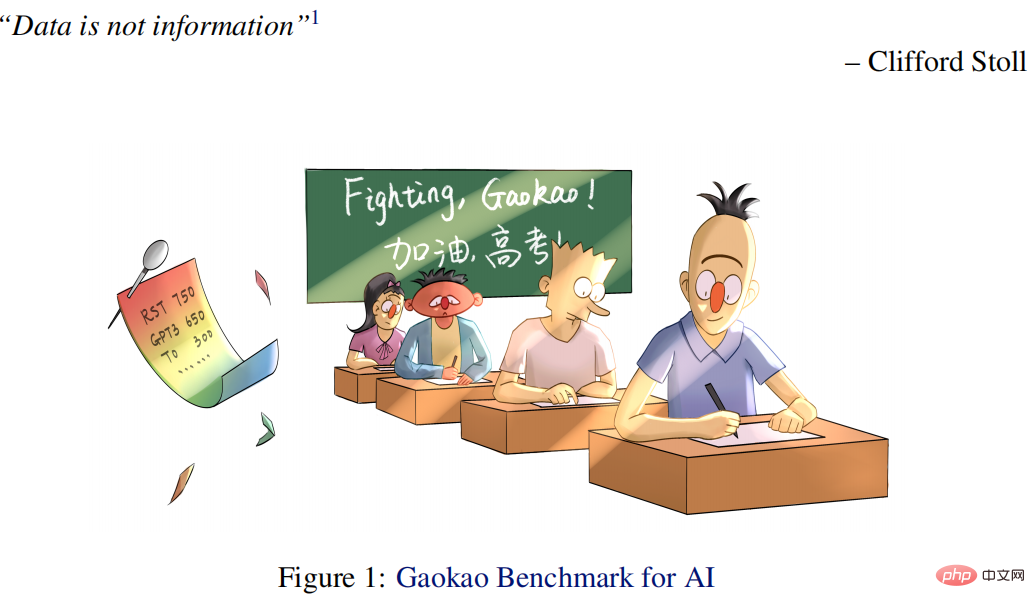

Nachdem die Forschung einige technische Herausforderungen gemeistert hatte, erreichte sie dies durch ein Vortraining anhand rekonstruierter Daten (bestehend aus verschiedenen wertvollen Informationen anstelle der Originaldaten). Experimente zeigen, dass das RST-Modell nicht nur die besten vorhandenen Systeme (z. B. T0) bei 52/55 beliebten Datensätzen aus verschiedenen NLP-Aufgaben (z. B. Klassifizierung, Informationsextraktion, Faktenabruf, Textgenerierung usw.) deutlich übertrifft, sondern dies auch tut nicht erforderlich Feinabstimmung nachgelagerter Aufgaben. Es hat auch hervorragende Ergebnisse bei Chinas renommiertester Englischprüfung für die Hochschulaufnahmeprüfung erzielt, die jedes Jahr von Millionen von Studenten abgelegt wird.

Konkret ist die in diesem Artikel vorgeschlagene KI (Qin) für die Hochschulaufnahmeprüfung 40 Punkte höher als die durchschnittliche Studentenpunktzahl und 15 Punkte höher als GPT3 unter Verwendung von 1/16 Parametern. Der besondere Qin erzielte im Englischtest 2018 eine hohe Punktzahl von 138,5 (von 150).

Darüber hinaus veröffentlichte die Studie auch die Online-Einreichungsplattform Gaokao Benchmark, die 10 kommentierte englische Testarbeiten von 2018 bis 2021 bis heute enthält (und jedes Jahr erweitert wird), sodass mehr KI-Modelle an der Aufnahmeprüfung für das College teilnehmen können. Die Studie hat auch eine relativ faire Testplattform für den Wettbewerb zwischen Mensch und KI geschaffen, um uns zu helfen, besser zu verstehen, wo wir stehen. Darüber hinaus erzielte das KI-System vor einigen Tagen (08.06.2022) beim Englischtest zur College-Aufnahmeprüfung 2022 eine gute Punktzahl von 134 Punkten, während GPT3 nur 108 Punkte erzielte.

Zu den Hauptbeiträgen dieser Studie gehören:

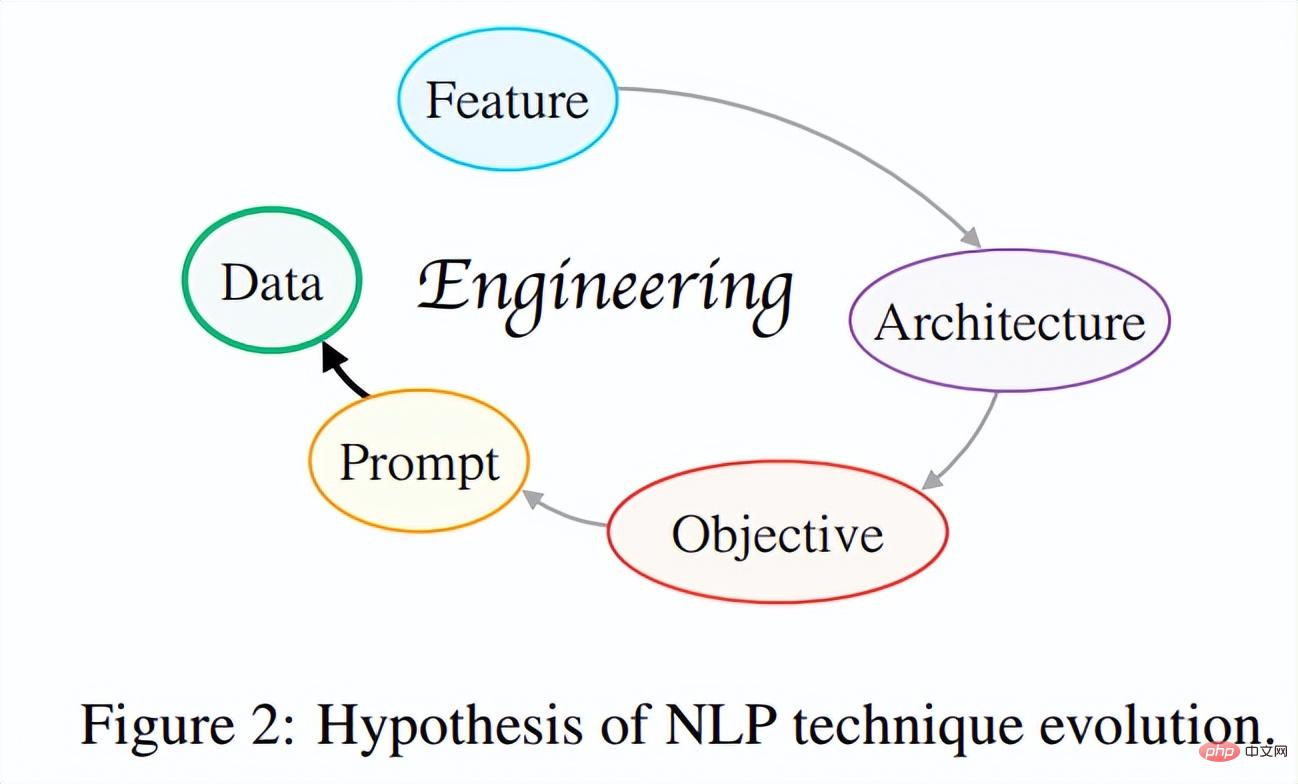

(1) Vorschlag einer Evolutionshypothese von NLP-Methoden. Diese Forschung versucht, die „NLP-Technologie-Evolutionshypothese“ aus einer Gesamtperspektive zu etablieren, indem die intrinsischen Zusammenhänge zwischen der Entwicklung moderner NLP-Technologie untersucht werden. Kurz gesagt besteht die Kernidee dieser Hypothese darin, dass sich Technologieiterationen immer in eine solche Richtung entwickeln, dass Entwickler nur weniger tun müssen, um bessere und vielseitigere Systeme zu entwerfen.

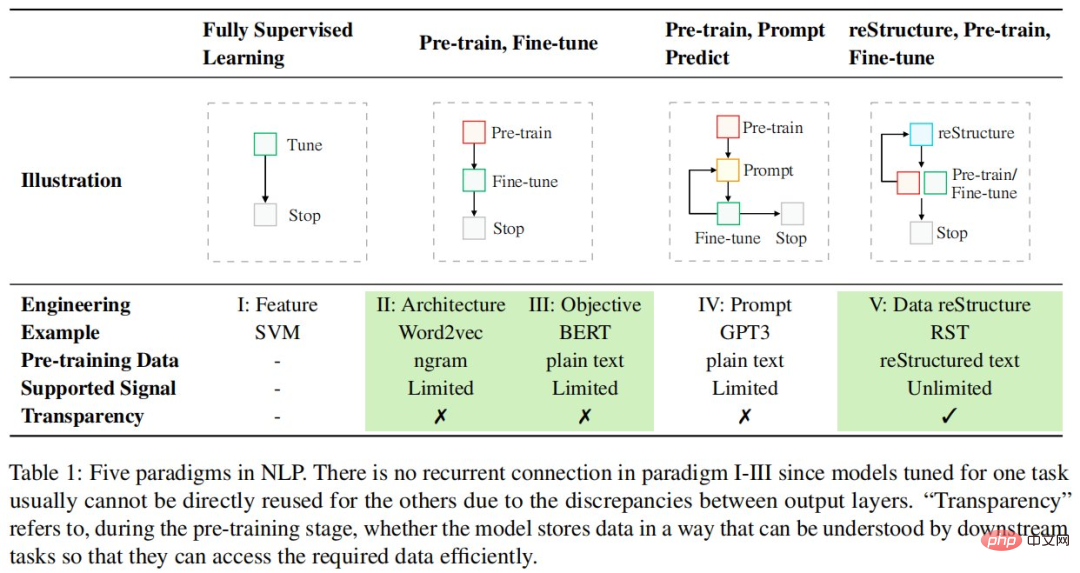

Bisher hat die Entwicklung der NLP-Technologie mehrere Iterationen durchlaufen, wie in Abbildung 2 dargestellt: Feature-Engineering → Architektur-Engineering → Ziel-Engineering → Prompt-Engineering, und bewegt sich in Richtung eines praktischeren und effektiveren datenzentrierten Engineerings . Die Forscher hoffen, dass in Zukunft mehr wissenschaftliche Forscher dazu inspiriert werden, kritisch über dieses Thema nachzudenken, die zentrale Triebkraft des technologischen Fortschritts zu begreifen, einen „gradienten Aufwärtspfad“ für die akademische Entwicklung zu finden und wissenschaftlich sinnvollere Arbeit zu leisten.

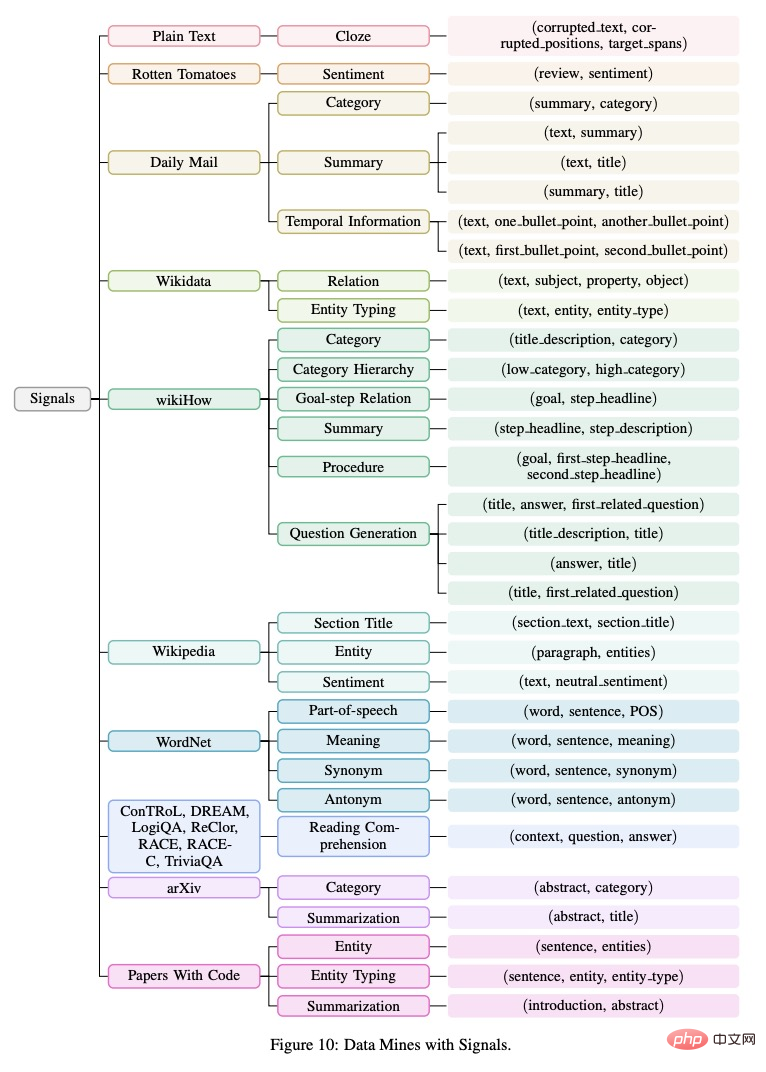

(2) Neues Paradigma basierend auf der Evolutionshypothese: reStructured Pre-training. Dieses Paradigma behandelt das Vortraining/die Feinabstimmung des Modells als Datenspeicherungs-/Zugriffsprozess und behauptet, dass ein guter Speichermechanismus die beabsichtigten Daten leicht zugänglich machen sollte. Mit solch einem neuen Paradigma war die Forschung in der Lage, 26 verschiedene Arten von Signalen auf der Welt (z. B. Entitäten von Sätzen) aus 10 Datenquellen (z. B. Wikipedia) zu vereinheitlichen. Das auf dieser Basis trainierte allgemeine Modell erreichte starke Generalisierungsfähigkeiten bei verschiedenen Aufgaben, darunter 55 NLP-Datensätze.

(3) KI für die Hochschulaufnahmeprüfung. Basierend auf dem oben genannten Paradigma wurde in dieser Studie ein KI-System – Qin – entwickelt, das speziell für Englischtestaufgaben bei Aufnahmeprüfungen für Hochschulen verwendet wird. Dies ist das weltweit erste englische künstliche Intelligenzsystem für Hochschulaufnahmeprüfungen, das auf Deep Learning basiert. Qin erzielt seit vielen Jahren hervorragende Ergebnisse bei Fragen zu Hochschulaufnahmeprüfungen: 40 Punkte mehr als normale Menschen und 15 Punkte mehr als GPT-3, wobei nur 1/16 der Parameter von GPT-3 verwendet wurden. Insbesondere bei den Englisch-Testfragen 2018 erzielte QIN eine hohe Punktzahl von 138,5 Punkten (von 150 Punkten), mit perfekten Ergebnissen sowohl beim Hör- als auch beim Leseverständnis.

(4) Reichhaltige Ressourcen. (1) Um den Fortschritt der bestehenden KI-Technologie bei der Erreichung menschlicher Intelligenz zu verfolgen, veröffentlichte die Studie einen neuen Benchmark – den Gaokao-Benchmark. Es bietet nicht nur eine umfassende Bewertung einer Vielzahl praktischer Aufgaben und Bereiche in realen Szenarien, sondern liefert auch menschliche Leistungswerte, sodass KI-Systeme direkt mit Menschen verglichen werden können. (2) Diese Studie verwendet ExplainaBoard (Liu et al., 2021b), um eine interaktive Bestenliste für den Gaokao-Benchmark festzulegen, damit mehr KI-Systeme problemlos am Gaokao-Benchmark teilnehmen und automatisch Punkte erhalten können. (3) Alle Ressourcen finden Sie auf GitHub.

Darüber hinaus hat der Erfolg der KI bei der Englischtestaufgabe für die College-Aufnahmeprüfung den Forschern viele neue Ideen geliefert: KI-Technologie kann Bildung stärken und dabei helfen, eine Reihe von Problemen in Bildung und Unterricht zu lösen.

Zum Beispiel (a) helfen Sie Lehrern, die Benotung zu automatisieren, (b) helfen Sie Schülern, Fragen zu Aufgaben zu beantworten und diese im Detail zu erklären, und (c) – was noch wichtiger ist – fördern Sie Bildungsgerechtigkeit, damit die meisten Familien die gleiche Bildungsqualität erhalten können . Diese Arbeit integriert zum ersten Mal 26 verschiedene Signale aus der ganzen Welt auf einheitliche Weise und anstatt zu versuchen, zwischen überwachten und unüberwachten Daten zu unterscheiden, geht es darum, wie viel und wie wir die Informationen nutzen können, die uns die Natur gibt. Die herausragende Leistung bei mehr als 50 Datensätzen aus verschiedenen NLP-Aufgaben zeigt den Wert eines datenzentrierten Vortrainings und inspiriert zu weiteren zukünftigen Erkundungen.

Refactoring Pre-Training

Die Paradigmen zur Lösung von NLP-Aufgaben ändern sich rasant und bestehen immer noch. Die folgende Tabelle listet die fünf Paradigmen im NLP auf:

Anders als das bestehende modellzentrierte Designparadigma denkt diese Forschung mehr aus der Perspektive der Daten, um die Nutzung vorhandener Daten zu maximieren. Konkret übernimmt diese Studie die Sichtweise der Datenspeicherung und des Zugriffs, wobei die Phase vor dem Training als Datenspeicherprozess betrachtet wird, während die nachgelagerten Aufgaben (z. B. Stimmungsklassifizierung) basierend auf dem vorab trainierten Modell als Datenzugriffsprozess betrachtet werden aus dem vorab trainierten Modell und behauptet, dass ein guter Datenspeichermechanismus die gespeicherten Daten leichter zugänglich machen sollte.

Um dieses Ziel zu erreichen, behandelt die Studie Daten als Objekte, die aus verschiedenen Signalen bestehen, und ist der Ansicht, dass ein gutes vorab trainiertes Modell (1) so viele Signaltypen wie möglich abdecken und (2) bereitstellen sollte Präzise Zugriffsmechanismen auf diese Signale, wenn sie von nachgelagerten Aufgaben benötigt werden. Im Allgemeinen besteht dieses neue Paradigma aus drei Schritten: Rekonstruktion, Vortraining und Feinabstimmung.

Das neue Paradigma der Rekonstruktion, des Vortrainings und der Feinabstimmung unterstreicht die Bedeutung von Daten, und Forscher müssen mehr technische Energie in Daten investieren Verarbeitung.

Rekonstruktionstechnik

Signaldefinition

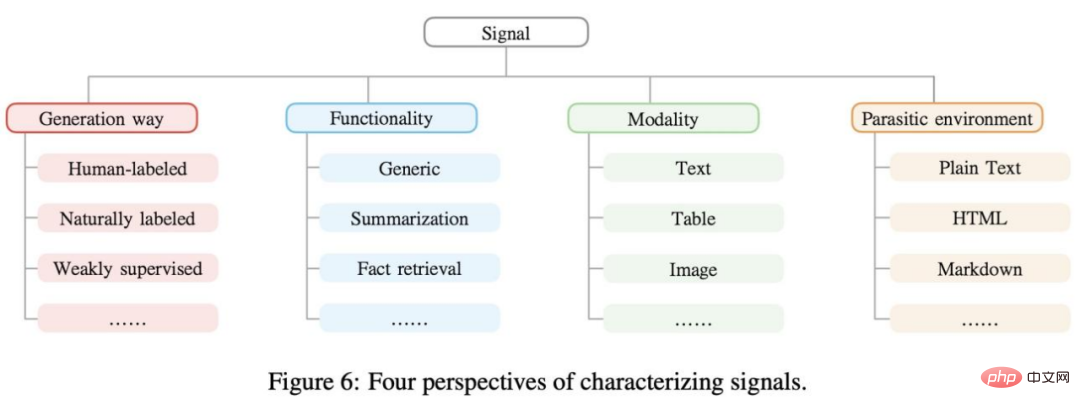

Das Signal ist eine in den Daten vorhandene nützliche Information, die eine Überwachung für das maschinelle Lernmodell bereitstellen kann, ausgedrückt als n-Elemente-Gruppe. Beispielsweise können „Mozart wurde in Salzburg geboren“, „Mozart“ und „Salzburg“ als Signale für die Erkennung benannter Entitäten angesehen. Typischerweise können Signale aus verschiedenen Perspektiven geclustert werden, wie in Abbildung 6 unten dargestellt. Reale Daten enthalten viele verschiedene Arten von Signalen. Durch die Rekonstruktion vor dem Training können diese Signale vollständig ausgenutzt werden. Die Studie organisierte die gesammelten Signale (n-Tupel) in einem Baumdiagramm, wie in Abbildung 10 unten dargestellt. Signalextraktion Erfassung von Rohdaten, Datenbereinigung und Datennormalisierung. Bestehende Methoden werden grob in zwei Typen unterteilt: (1) regelbasierte und (2) maschinelle Lernmethoden. In dieser Arbeit konzentriert sich die Forschung hauptsächlich auf regelbasierte Signalextraktionsstrategien und lässt weitere Methoden mit hoher Abdeckung für zukünftige Arbeiten übrig.

Signalrekonstruktion

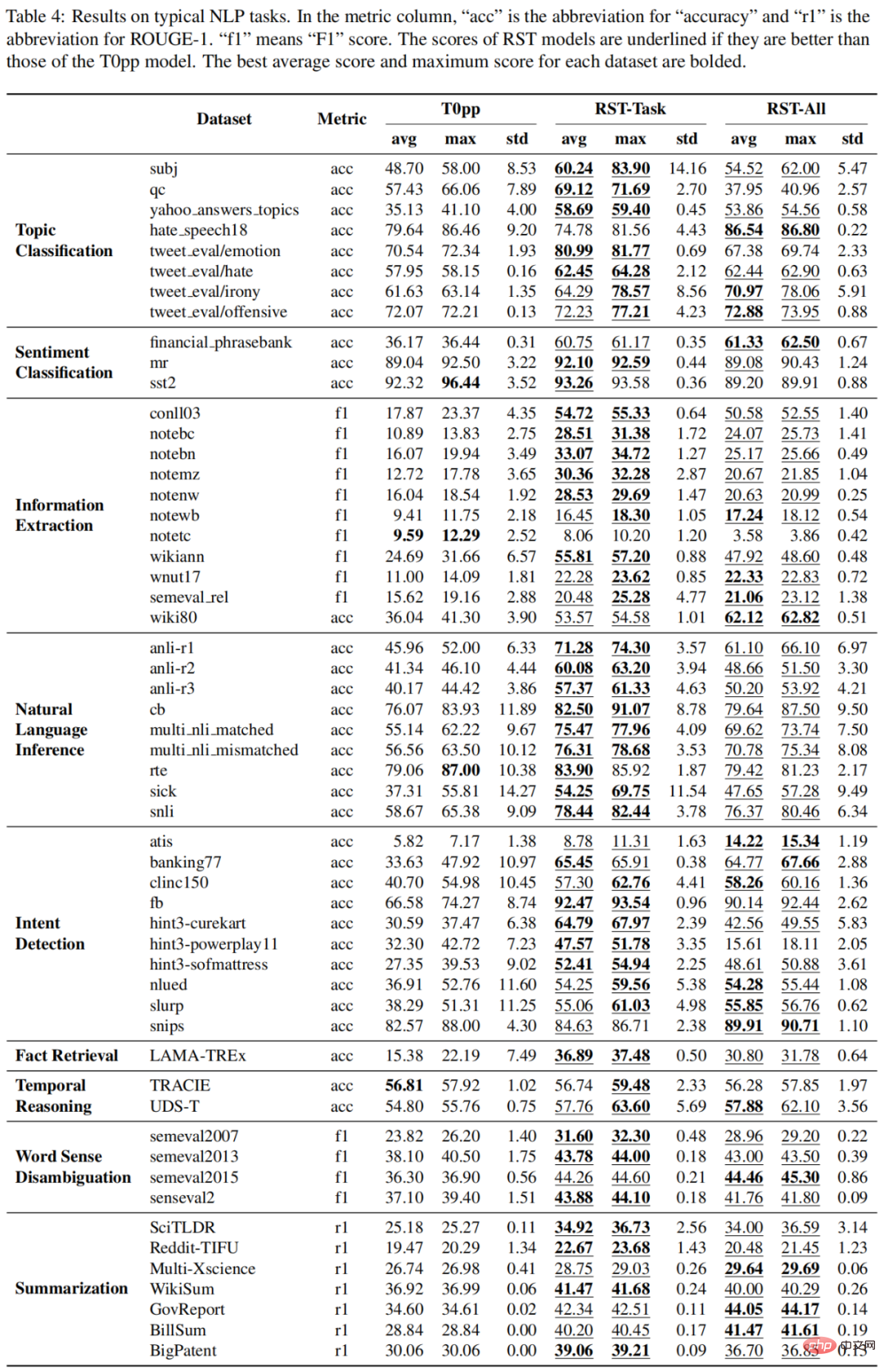

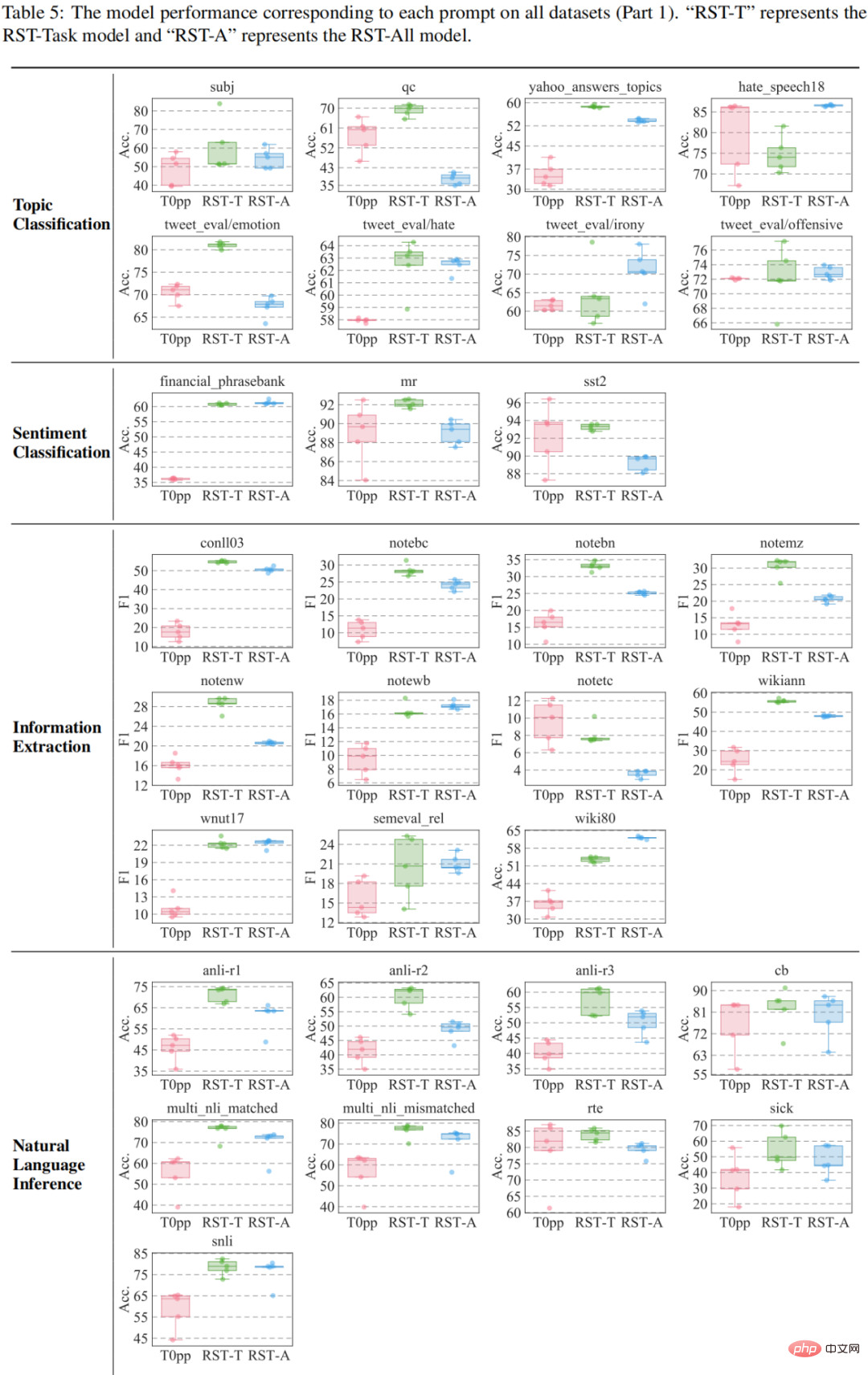

Die Studie wurde anhand von 55 Datensätzen ausgewertet und diese dann mit GPT3 bzw. T0pp verglichen. Die Ergebnisse des Vergleichs mit GPT3 sind in der Abbildung dargestellt: Bei den vier Datensätzen mit Ausnahme des CB-Datensatzes weisen sowohl RST-All als auch RST-Task eine bessere Null-Schuss-Leistung auf als GPT3s Wenig-Schuss-Lernen. Darüber hinaus ist der CB-Datensatz mit nur 56 Proben im Validierungssatz der kleinste dieser Datensätze, sodass die Leistung verschiedener Eingabeaufforderungen für diesen Datensatz stark schwanken wird.

Die Studie wurde anhand von 55 Datensätzen ausgewertet und diese dann mit GPT3 bzw. T0pp verglichen. Die Ergebnisse des Vergleichs mit GPT3 sind in der Abbildung dargestellt: Bei den vier Datensätzen mit Ausnahme des CB-Datensatzes weisen sowohl RST-All als auch RST-Task eine bessere Null-Schuss-Leistung auf als GPT3s Wenig-Schuss-Lernen. Darüber hinaus ist der CB-Datensatz mit nur 56 Proben im Validierungssatz der kleinste dieser Datensätze, sodass die Leistung verschiedener Eingabeaufforderungen für diesen Datensatz stark schwanken wird.

Die Vergleichsergebnisse zwischen

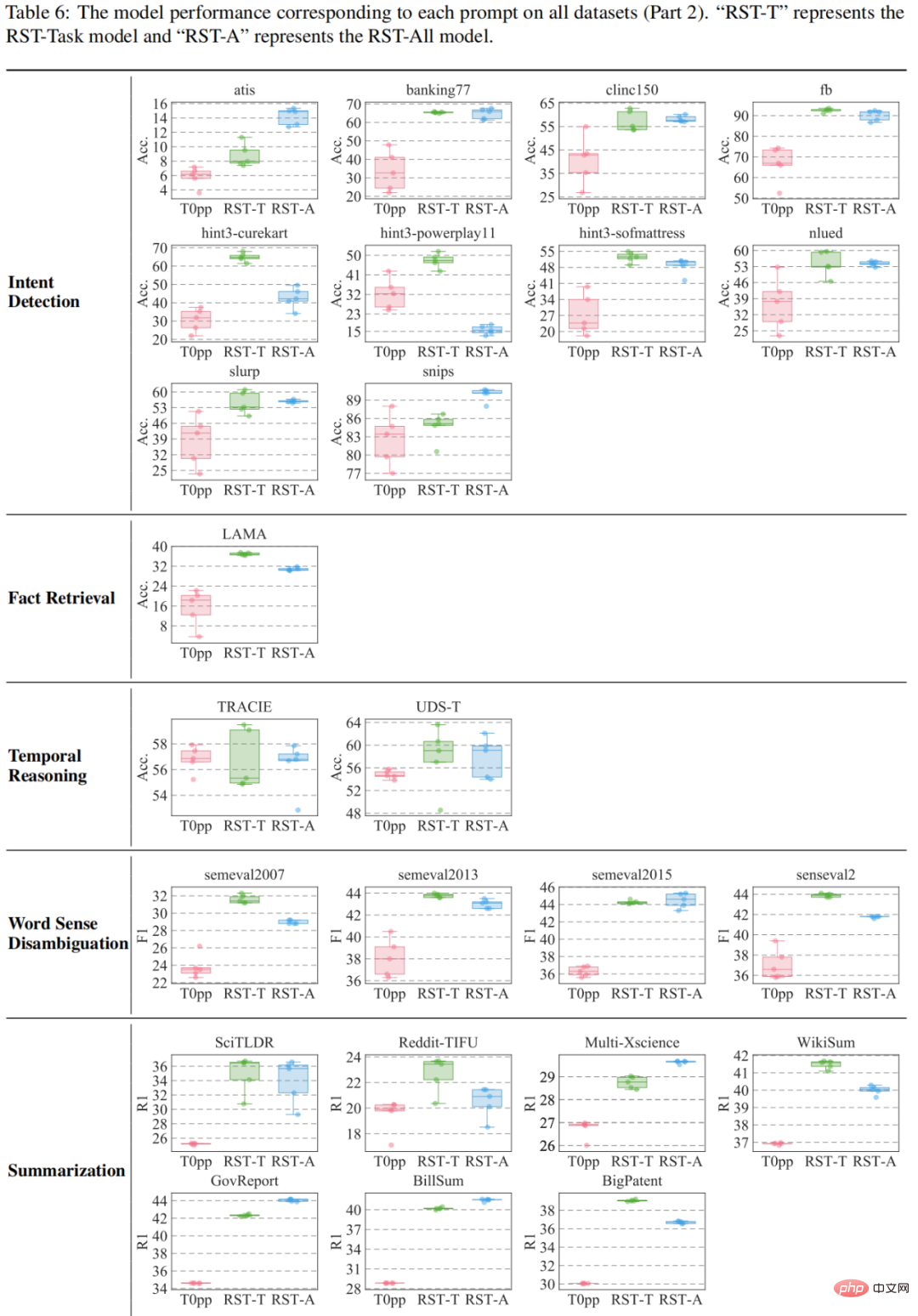

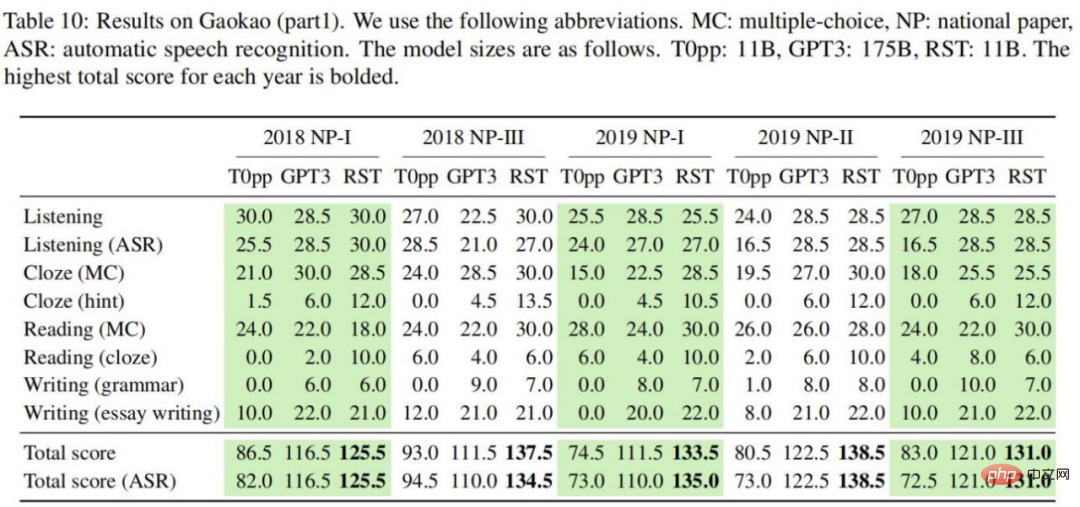

und T0pp sind in Tabelle 4-6 dargestellt. Bei der durchschnittlichen Leistung von 55 Messungen schlägt RST-All beispielsweise T0pp bei 49 Datensätzen und gewinnt mit maximaler Leistung bei 47/55 Beispielen. Darüber hinaus übertrifft RST-Task im durchschnittlichen Leistungstest an 55 Datensätzen T0pp bei 52 Datensätzen und übertrifft T0pp bei 50/55 Beispielen. Dies verdeutlicht die Überlegenheit des rekonstruktiven Lernens. Das leistungsstärkste Modell RST -Aufgabe In welchen Aufgaben sind Sie gut? Um diese Frage zu beantworten, vergleicht diese Studie die Leistung des RST-Task-Modells in der Nullstichprobeneinstellung mit aktuellen SOTA-Modellen. Die Ergebnisse sind in Abbildung 13 dargestellt. RST-Task eignet sich gut für Aufgaben zur Themenklassifizierung, Stimmungsklassifizierung und zum Denken in natürlicher Sprache, schneidet jedoch bei Aufgaben zur Informationsextraktion schlecht ab.

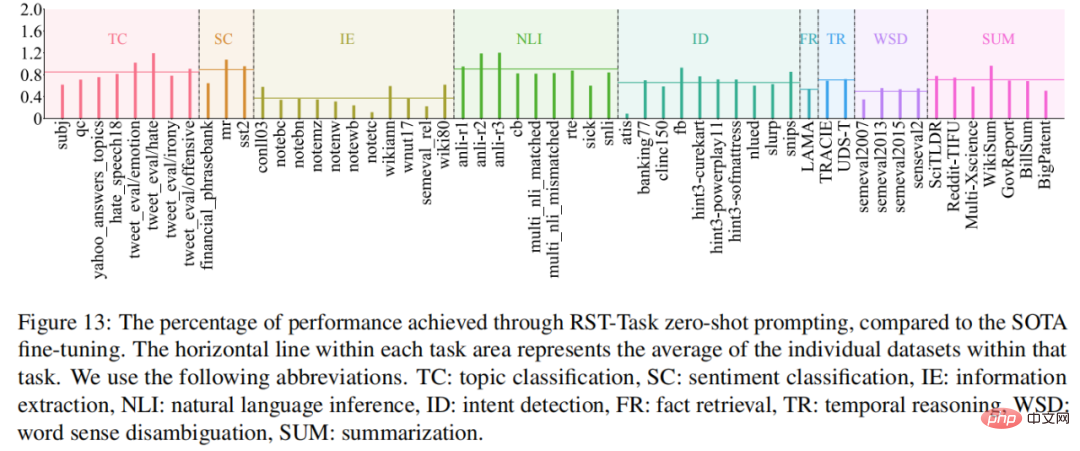

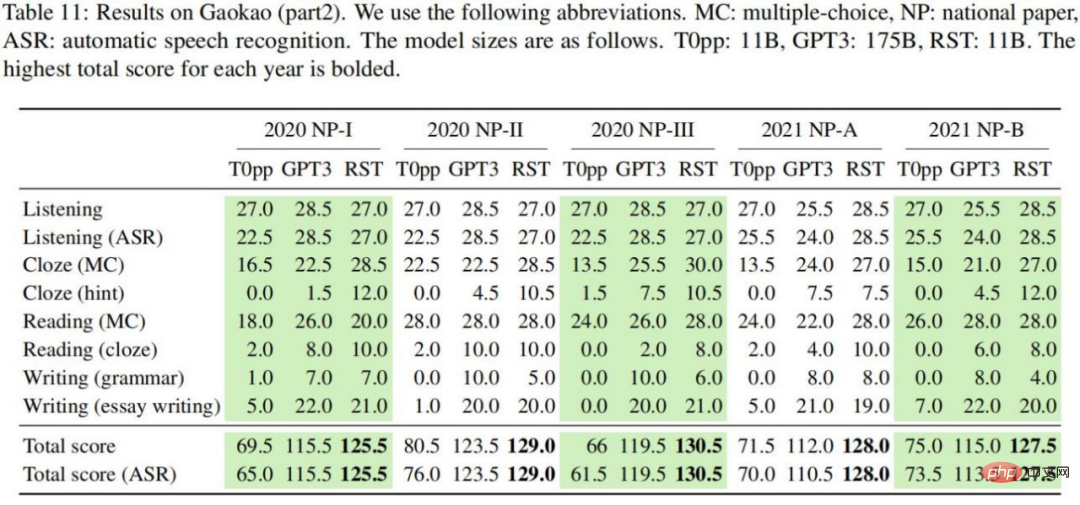

College-Aufnahmeprüfungsexperiment: Auf dem Weg zur KI auf menschlicher Ebene

Die experimentellen Ergebnisse sind in Tabelle 10-11 dargestellt. Wir können die folgenden Schlussfolgerungen ziehen: In jeder englischen Testarbeit erreichte RST mit einer durchschnittlichen Punktzahl von 130,6 die höchste Gesamtpunktzahl; Im Vergleich zu T0pp ist die Leistung von RST bei gleicher Modellgröße weitaus besser als die von T0pp. Über alle Einstellungen hinweg ist die von RST erzielte Gesamtpunktzahl im Durchschnitt 54,5 Punkte höher als bei T0pp, wobei der höchste Unterschied 69 Punkte beträgt (46 % der Gesamtpunktzahl). Im Vergleich zu GPT3 kann RST bei einer 16-fachen Modellgröße signifikante Ergebnisse erzielen kleiner. Bessere Ergebnisse. Über alle betrachteten Einstellungen hinweg war die mit RST erzielte Gesamtpunktzahl im Durchschnitt 14,0 Punkte höher als die mit T0pp, mit einem Maximum von 26 Punkten (17 % der Gesamtpunktzahl für T0pp, den mit Gold und Speech-To erzielten Hörbewertungen). -Texttranskripte unterschieden sich deutlich, mit einem Durchschnitt von 4,2 Punkten. Im Vergleich dazu liegen GPT3 und RST bei 0,6 bzw. 0,45, was darauf hindeutet, dass die Leistung von T0pp empfindlich auf die Textqualität reagiert. Die Studie führte eine detaillierte Analyse durch, um die Leistung verschiedener Modelle in Bezug auf die Leistung verschiedener Problemunterkategorien zu verstehen. In Abbildung 15-(a) wird deutlich, dass RST und GPT3 T0pp in jeder Problemunterkategorie übertreffen.

Abbildung 15-(b) zeigt die Leistung des Modells und die durchschnittliche Leistung der Schüler bei nationalen Testarbeiten in den letzten Jahren. Es ist klar, dass die Gesamtpunktzahl von T0pp auf dem Papier 9/10 unter dem Studentendurchschnitt liegt, während die RST- und GPT3-Leistung über dem Studentendurchschnitt liegt. Insbesondere wiesen fünf der zehn Arbeiten einen RST-Gesamtwert von über 130 auf (oft als angestrebter Zielwert für Studenten angesehen).

Das obige ist der detaillierte Inhalt vonBei der diesjährigen Aufnahmeprüfung für das Englische College nutzte die CMU ein Rekonstruktions-Vortraining, um eine hohe Punktzahl von 134 zu erreichen und damit GPT3 deutlich zu übertreffen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr