Heim >Technologie-Peripheriegeräte >KI >Gary Marcus: Textgenerierte Bildsysteme können die Welt nicht verstehen und sind weit von AGI entfernt

Gary Marcus: Textgenerierte Bildsysteme können die Welt nicht verstehen und sind weit von AGI entfernt

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-09 09:31:031474Durchsuche

Dieser Artikel wurde von Lei Feng.com reproduziert. Wenn Sie einen Nachdruck benötigen, besuchen Sie bitte die offizielle Website von Lei Feng.com, um eine Autorisierung zu beantragen.

Seit der Einführung von DALL-E 2 glauben viele Menschen, dass KI, die realistische Bilder zeichnen kann, ein großer Schritt in Richtung künstlicher allgemeiner Intelligenz (AGI) ist. Sam Altman, CEO von OpenAI, erklärte einst bei der Veröffentlichung von DALL-E 2: „AGI wird wild sein“, und auch die Medien übertreiben die Bedeutung dieser Systeme für den Fortschritt der allgemeinen Intelligenz.

Aber ist das wirklich so? Gary Marcus, ein bekannter KI-Gelehrter und Enthusiast, der die KI mit kaltem Wasser übergießt, äußerte seine „Vorbehalte“.

Kürzlich schlug er vor, dass es bei der Bewertung des Fortschritts von AGI darauf ankommt, zu sehen, ob Systeme wie Dall-E, Imagen, Midjourney und Stable Diffusion die Welt wirklich verstehen und es daher sein können Basierend auf diesem Wissen können wir argumentieren und Entscheidungen treffen.

Bei der Beurteilung der Bedeutung dieser Systeme für die KI (einschließlich enger und breiter KI) können wir die folgenden drei Fragen stellen:

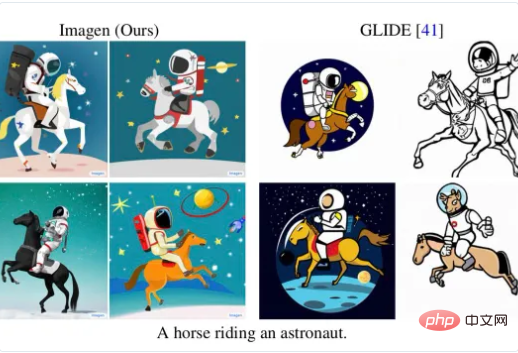

#🎜 🎜 #Aber bei anderen Spracheingaben sind diese KIs schlecht und lassen sich leicht täuschen. Beispielsweise hat Marcus vor einiger Zeit auf Twitter darauf hingewiesen, dass diese Systeme Schwierigkeiten haben, entsprechend genaue Bilder zu erzeugen, wenn sie mit „einem Pferd auf einem Astronauten“ konfrontiert werden:

#🎜 🎜 #Aber bei anderen Spracheingaben sind diese KIs schlecht und lassen sich leicht täuschen. Beispielsweise hat Marcus vor einiger Zeit auf Twitter darauf hingewiesen, dass diese Systeme Schwierigkeiten haben, entsprechend genaue Bilder zu erzeugen, wenn sie mit „einem Pferd auf einem Astronauten“ konfrontiert werden:

Obwohl Deep-Learning-Befürworter heftig dagegen vorgegangen sind, wie etwa der KI-Forscher Joscha Bach, der glaubt, dass „Imagen möglicherweise einfach den falschen Trainingssatz verwendet“, kontert Luca Ambrogioni, Professor für maschinelles Lernen, dass dies zeigt, dass „Imagen bereits ein Level hat.“ des gesunden Menschenverstandes“ und weigert sich daher, etwas Lächerliches hervorzubringen.

Es gibt auch einen Google-Wissenschaftler Behnam Neyshabur, der vorgeschlagen hat, dass Imagen, wenn er „richtig gefragt wird“, ein „auf einem Astronauten reitendes“ Pferd zeichnen kann. :

Allerdings glaubt Marcus, dass der Schlüssel zum Problem nicht darin liegt, ob das System Bilder erzeugen kann, sondern kluge Leute können immer eins finden Entscheidend ist, dass Systeme bestimmte Bilder zeichnen, ohne dass ein tiefes Verständnis für den Zusammenhang zwischen Sprache und Bildern besteht.

2 Sie wissen nicht, was ein Fahrradlaufrad ist? Wie kann es AGI heißen?

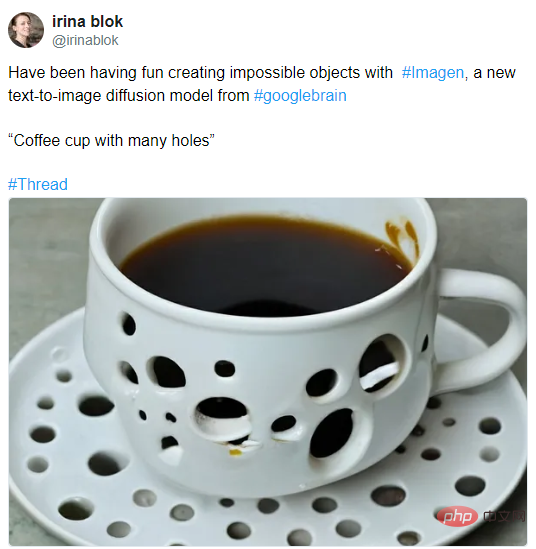

Was Marcus an der Fähigkeit dieser Systeme, die Welt zu verstehen, verzweifeln lässt, sind aktuelle Beispiele, wie das Bild „Kaffeetasse mit vielen Löchern“ der Grafikdesignerin Irina Blok, das mit Imagen erstellt wurde: #🎜 🎜#

Gary Marcus: Textgenerierte Bildsysteme können die Welt nicht verstehen und sind weit entfernt von AGI „Toilettenpapier“

# 🎜🎜#

Gary Marcus: Textgenerierte Bildsysteme können die Welt nicht verstehen und sind weit von AGI entfernt # 🎜🎜#Es ist leicht, „Ja“ zu sagen, aber schwer, „Nein“ zu sagen . Wer weiß, wie ein nicht existierendes Ding aussehen sollte? Hier liegt die Schwierigkeit, die KI dazu zu bringen, das Unmögliche zu zeichnen.

# 🎜🎜#Es ist leicht, „Ja“ zu sagen, aber schwer, „Nein“ zu sagen . Wer weiß, wie ein nicht existierendes Ding aussehen sollte? Hier liegt die Schwierigkeit, die KI dazu zu bringen, das Unmögliche zu zeichnen.

Aber vielleicht „will“ das System einfach nur ein surreales Bild zeichnen, wie DeepMind-Forschungsprofessor Michael Bronstein sagte, er hält das nicht für ein schlechtes Ergebnis. Wenn er es wäre, er würde es so zeichnen.

Wie kann man dieses Problem endlich lösen? Neue Inspiration fand Gary Marcus kürzlich in einem Gespräch mit dem Philosophen Dave Chalmers.

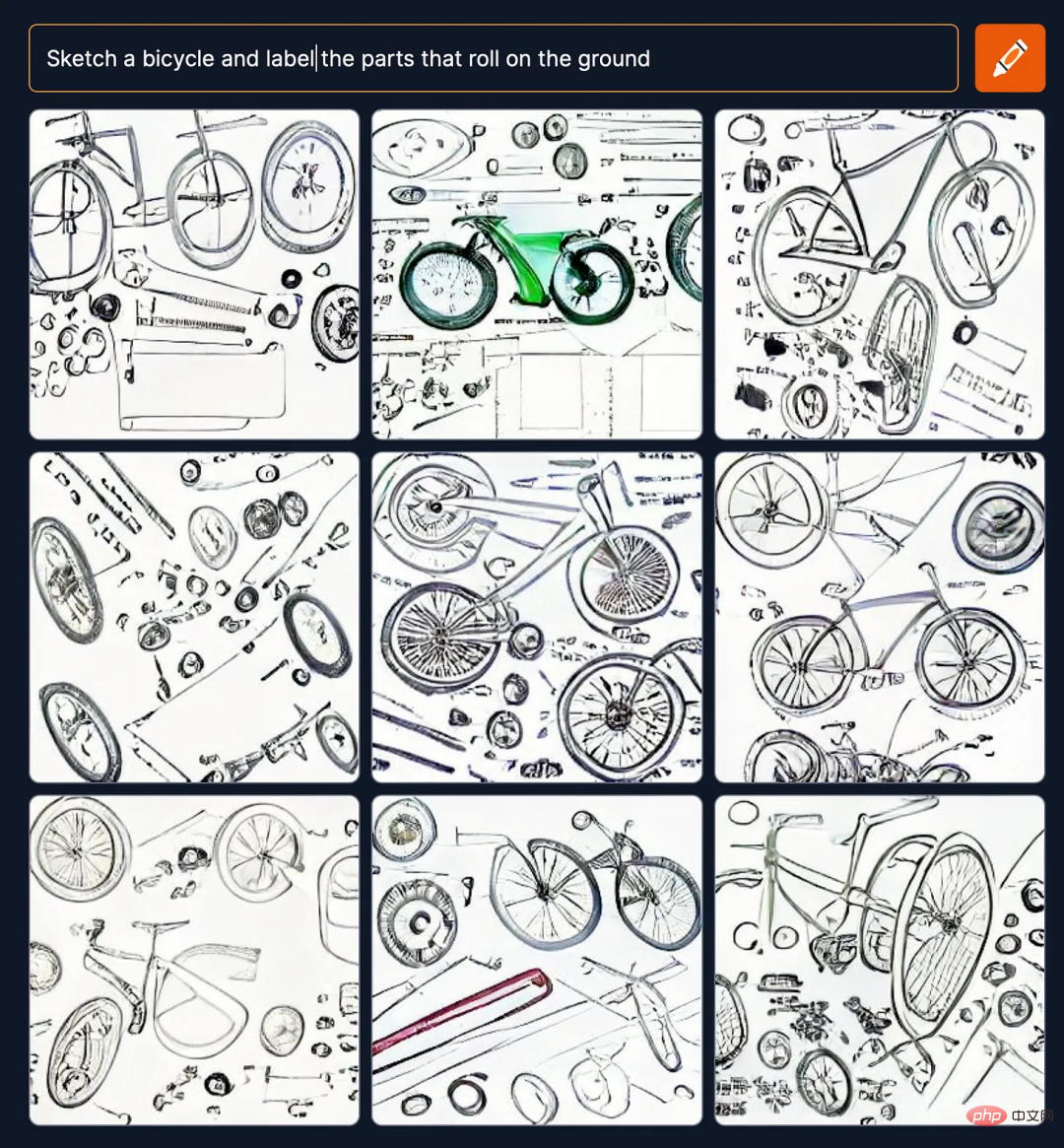

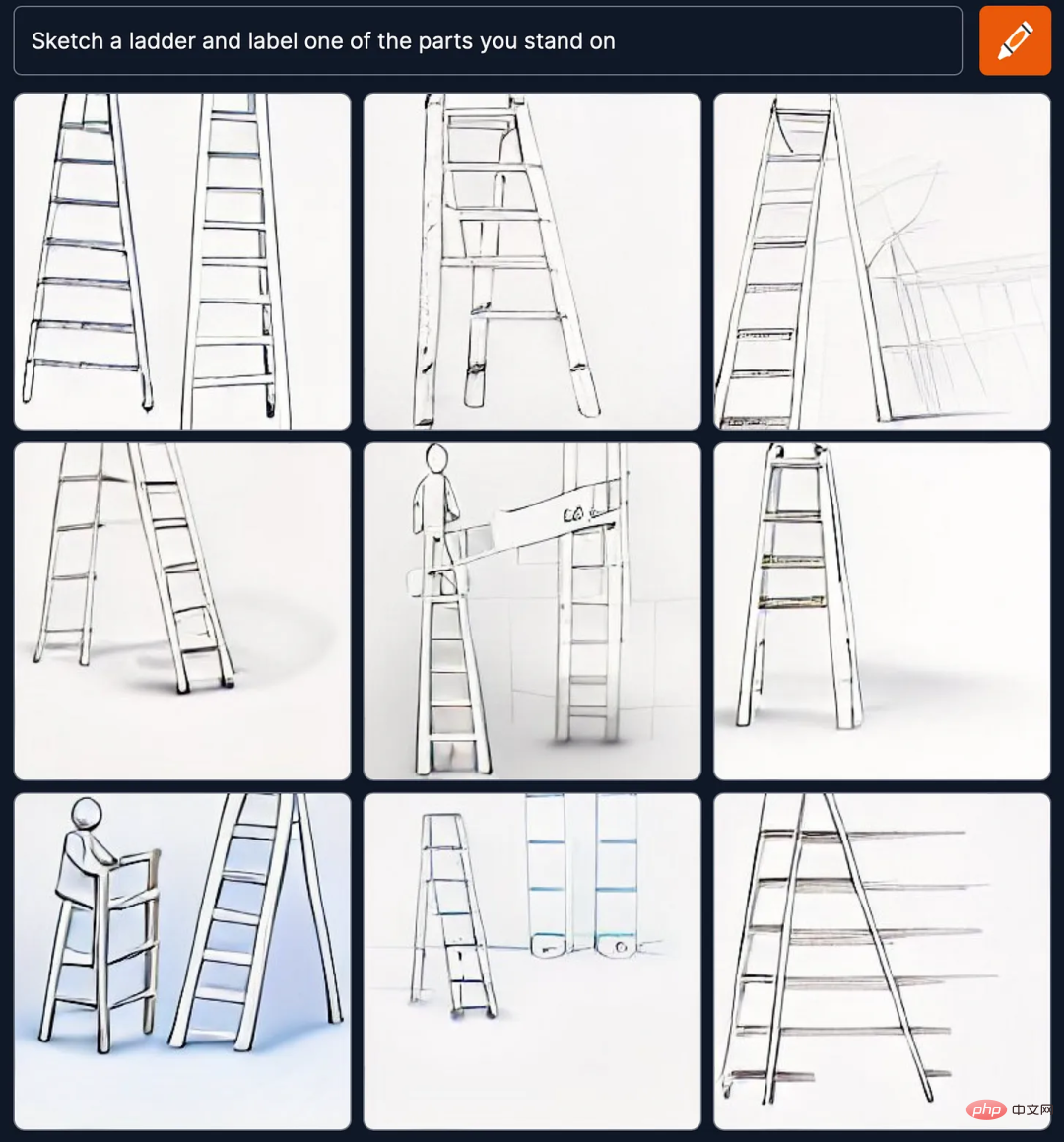

Um das Verständnis des Systems für Teile, Ganzes und Funktionen zu verstehen, schlug Gary Marcus eine Aufgabe vor, um eine klarere Vorstellung davon zu bekommen, ob die Systemleistung korrekt ist, und gab den Text an Aufforderung „Skizzieren Sie ein Fahrrad und beschriften Sie die Teile, die auf dem Boden rollen“ und „Skizzieren Sie eine Leiter und beschriften Sie eines der Teile, auf denen Sie stehen“ außerhalb des Bereichs, in dem Sie stehen.

Um das Verständnis des Systems für Teile, Ganzes und Funktionen zu verstehen, schlug Gary Marcus eine Aufgabe vor, um eine klarere Vorstellung davon zu bekommen, ob die Systemleistung korrekt ist, und gab den Text an Aufforderung „Skizzieren Sie ein Fahrrad und beschriften Sie die Teile, die auf dem Boden rollen“ und „Skizzieren Sie eine Leiter und beschriften Sie eines der Teile, auf denen Sie stehen“ außerhalb des Bereichs, in dem Sie stehen.

Das Besondere an diesem Test ist, dass er nicht direkt Aufforderungen wie „Zeichne ein Fahrrad und markiere die Räder“ oder „Zeichne eine Leiter und markiere die Pedale“ gibt, sondern lass Aus Beschreibungen wie „der rollende Teil am Boden“ und „der stehende Teil“ schließt die KI auf die entsprechenden Dinge. Dies ist ein Test für die Fähigkeit der KI, die Welt zu verstehen.

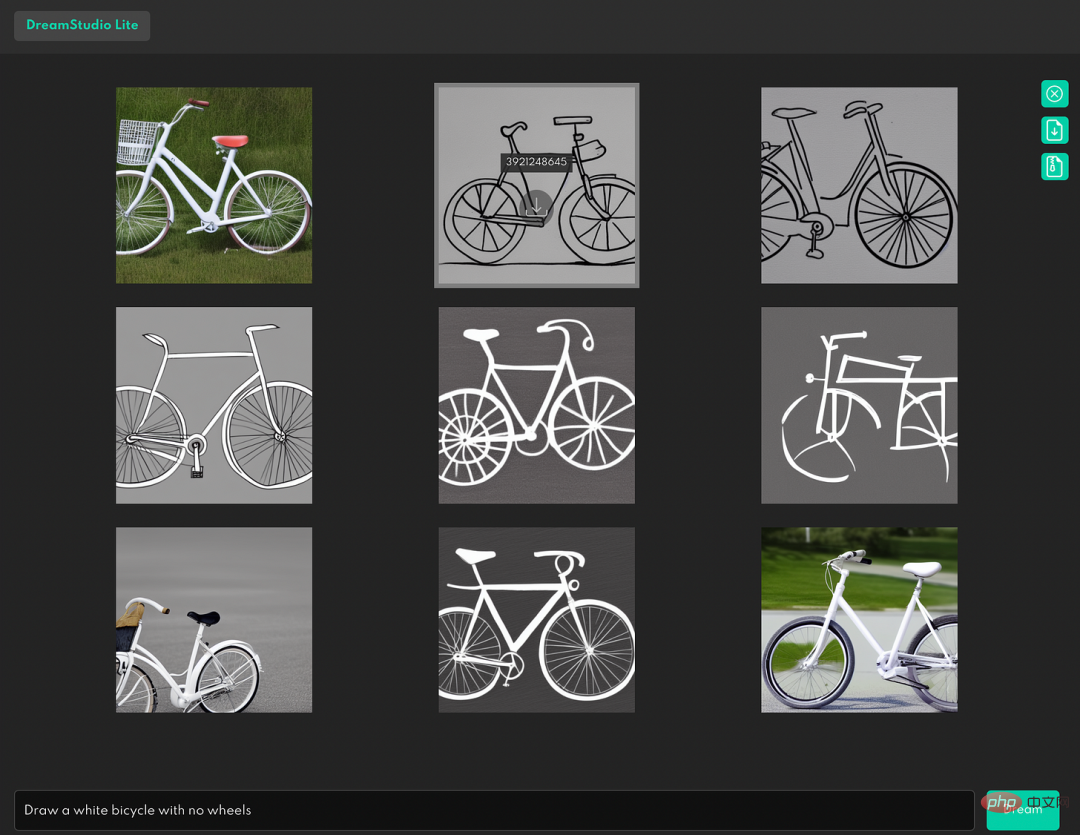

Aber Marcus' Testergebnisse zeigen, dass Craiyon (früher bekannt als DALL-E mini) in solchen Dingen schrecklich ist. Es versteht nicht, dass die Räder von Fahrrädern und die Pedale von Leitern sind was: 🎜# Handelt es sich also um ein spezifisches Problem des DALL-E Mini?

Gary Marcus stellte fest, dass dies nicht der Fall war. Das gleiche Ergebnis zeigte sich auch bei Stable Diffusion, dem beliebtesten Bildsystem zur Textgenerierung.

Lassen Sie zum Beispiel Stable Diffusion „Skizzieren Sie eine Person und machen Sie die Teile, die Dinge halten, lila“ (Skizzieren Sie eine Person und machen Sie die Teile, die Dinge halten, lila), das Ergebnis ist:

# 🎜🎜#

#🎜 🎜 #

#🎜 🎜 #

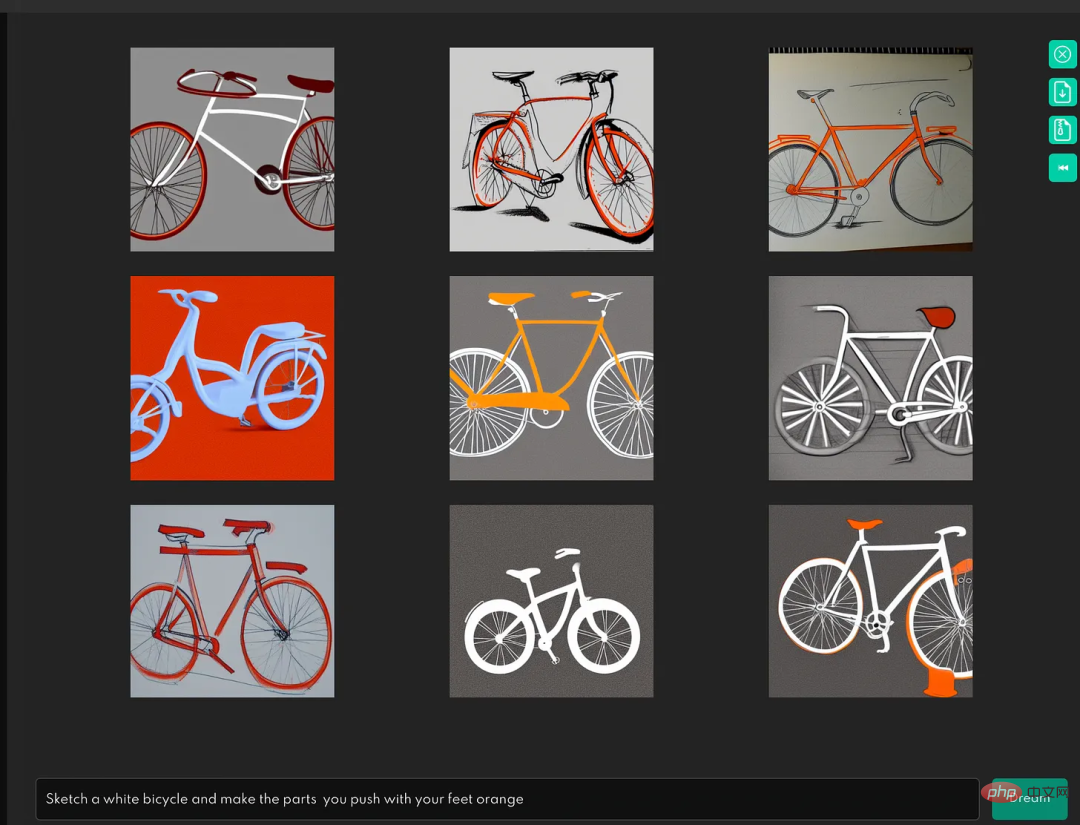

Der nächste Test lautet: „Zeichne ein weißes Fahrrad und färbe den vom Fuß gedrückten Teil orange“, das Ergebnis des Bildes ist:

Es kann also nicht verstehen, was ein Fahrradpedal ist.

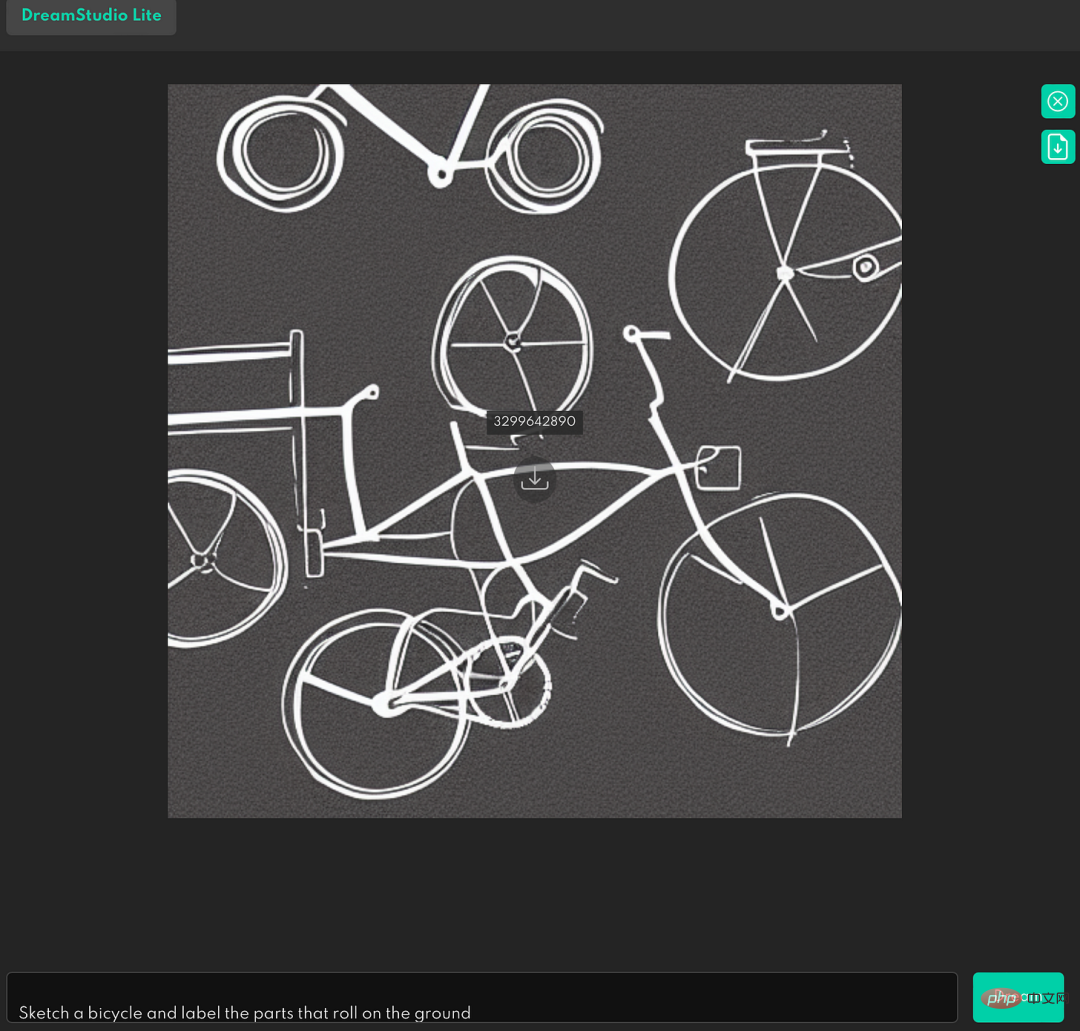

Und im Test zum Zeichnen einer „Skizze des Fahrrads und Markieren des auf dem Boden rollenden Teils“ schnitt es nicht besonders gut ab:

Wenn die Textaufforderung negative Wörter wie „Zeichnen“ enthält „Ein weißes Fahrrad ohne Räder“ lautet das Ergebnis:

Das zeigt, dass das System negative logische Zusammenhänge nicht versteht.

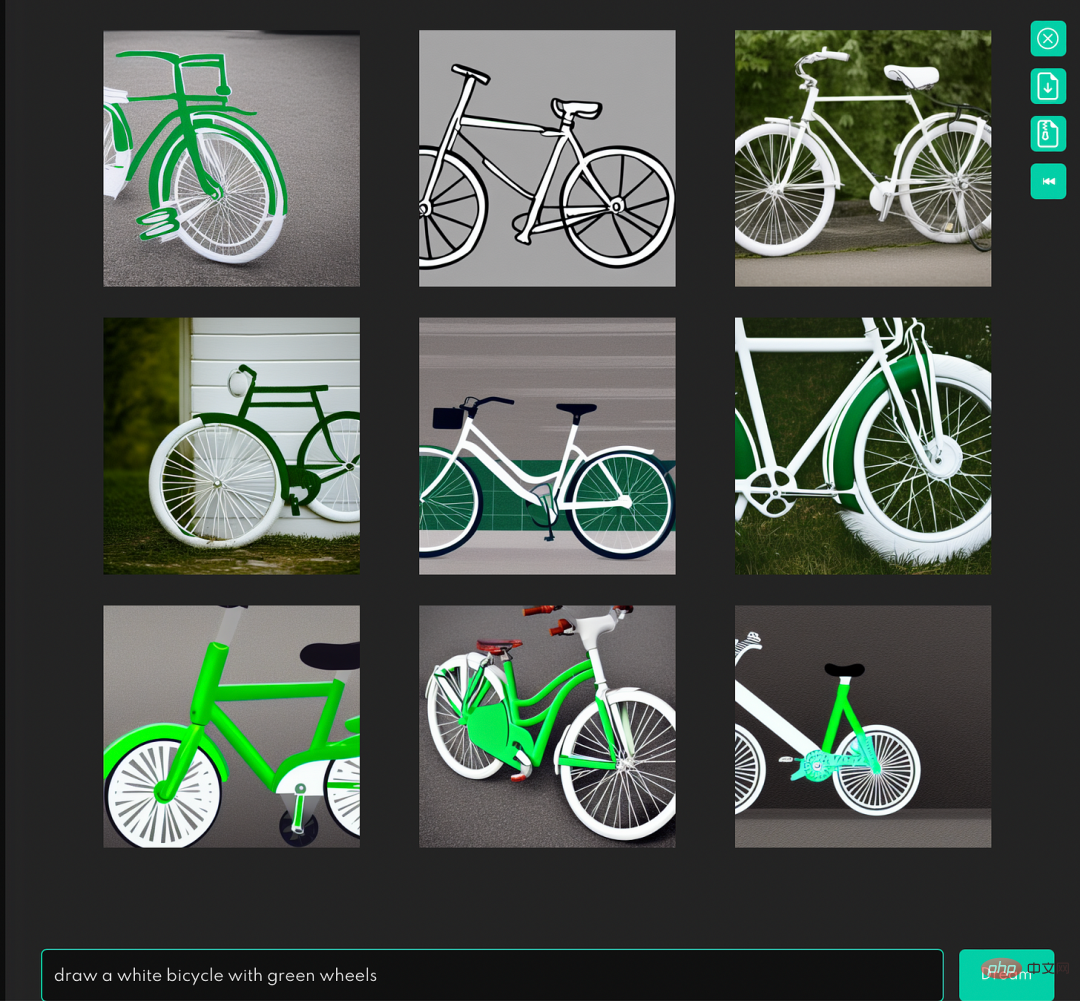

Auch wenn es so einfach ist wie „ein weißes Fahrrad mit grünen Rädern zeichnen“, das sich nur auf die Beziehung zwischen Teilen und dem Ganzen konzentriert und nicht mit komplexer Grammatik oder Funktionen erscheint, sind die Ergebnisse immer noch problematisch:

Kann also, fragte Marcus, ein System, das nicht versteht, was Räder sind oder wofür sie verwendet werden, ein großer Fortschritt in der künstlichen Intelligenz sein?

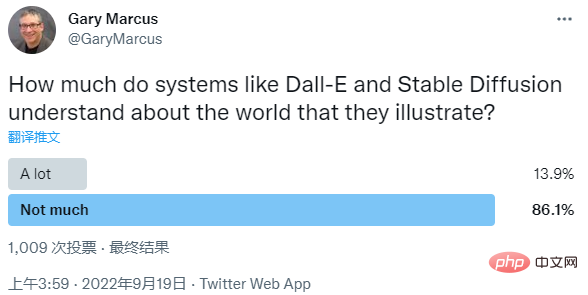

Heute veröffentlichte Gary Marcus auch eine Umfrage zu diesem Thema. Die Frage, die er stellte, lautete: „Wie viel wissen Systeme wie Dall-E und Stable Diffusion über die Welt, die sie darstellen?“

Unter ihnen waren es 86,1 %. der Menschen glauben, dass Systeme die Welt nicht gut verstehen, und nur 13,9 % glauben, dass diese Systeme die Welt in hohem Maße verstehen.

Als Antwort antwortete Emad Mostique, CEO von Stability.AI, auch, dass ich für „nicht viele“ gestimmt habe, und gab zu, dass „sie nur ein kleiner Teil des Puzzles sind.“

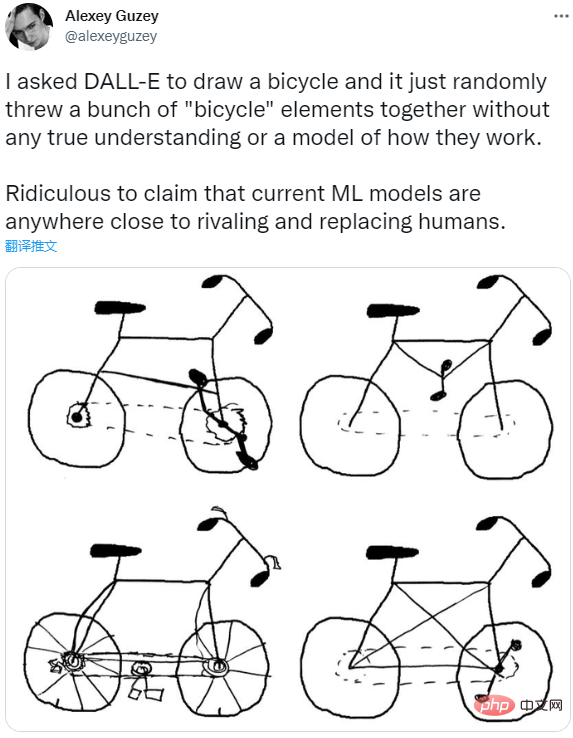

Alexey Guzey von der Wissenschaftsorganisation New Science machte ebenfalls eine ähnliche Entdeckung wie Marcus. Er bat DALL-E, ein Fahrrad zu zeichnen, aber das Ergebnis war nur ein Haufen zusammengestapelter Fahrradelemente.

Deshalb glaubt er, dass es keine Modelle gibt, die wirklich verstehen, was ein Fahrrad ist und wie es funktioniert, und dass es lächerlich ist, aktuelle ML-Modelle zu entwickeln, die dem Menschen fast Konkurrenz machen oder ihn ersetzen können.

Was meint ihr?

Das obige ist der detaillierte Inhalt vonGary Marcus: Textgenerierte Bildsysteme können die Welt nicht verstehen und sind weit von AGI entfernt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr