Heim >Technologie-Peripheriegeräte >KI >Welche Funken werden entstehen, wenn KI auf die Kunst der Malerei trifft?

Welche Funken werden entstehen, wenn KI auf die Kunst der Malerei trifft?

- WBOYnach vorne

- 2023-04-08 18:21:011395Durchsuche

Vorwort

Was ist KI? In Ihrem Kopf stellen Sie sich vielleicht ein neuronales Netzwerk vor, das aus übereinander gestapelten Neuronen besteht. Was ist also die Kunst des Malens? Ist es „Das Lächeln der Mona Lisa“ von Da Vinci, „Sternennacht“ und „Sonnenblumen“ von Van Gogh oder „Das Mädchen mit dem Perlenohrring“ von Johannes Vermeer? Welche Funken können dazwischen entstehen, wenn KI auf Malerei trifft?

Anfang 2021 veröffentlichte das OpenAI-Team das DALL-E-Modell, das Bilder basierend auf Textbeschreibungen generieren kann. Aufgrund seiner leistungsstarken modalübergreifenden Bilderzeugungsfähigkeiten hat es bei Enthusiasten der natürlichen Sprache und der Visual-Circle-Technologie großes Interesse geweckt. In etwas mehr als einem Jahr sind multimodale Bilderzeugungstechnologien wie Pilze nach einem Regen entstanden. In dieser Zeit wurden viele Anwendungen geboren, die diese Technologien für die Erstellung von KI-Kunst nutzen, wie beispielsweise die kürzlich beliebte Disco Diffusion. Heutzutage rücken diese Anwendungen nach und nach in das Blickfeld von Kunstschaffenden und der breiten Öffentlichkeit und sind für viele Menschen zum „Zauberstift Ma Liang“ geworden.

Dieser Artikel beginnt mit technischen Interessen, stellt multimodale Bilderzeugungstechnologie und klassische Arbeiten vor und untersucht schließlich, wie man multimodale Bilderzeugung nutzt, um magische KI-Malkunst zu schaffen.  Das vom Autor mithilfe von Disco Diffusion erstellte KI-Gemälde

Das vom Autor mithilfe von Disco Diffusion erstellte KI-Gemälde

Konzept der multimodalen Bildgenerierung

Die multimodale Bildgenerierung zielt darauf ab, modale Informationen wie Text und Audio als Leitfaden zu nutzen , erzeugen Sie realistische Bilder mit natürlichen Texturen. Im Gegensatz zur herkömmlichen Single-Modal-Generierungstechnologie, die Bilder auf der Grundlage von Rauschen generiert, war die multimodale Bildgenerierung schon immer eine sehr anspruchsvolle Aufgabe. Zu den zu lösenden Problemen gehören hauptsächlich:

(1) Wie kann die „semantische Lücke“ geschlossen werden? die inhärenten Barrieren zwischen den Modalitäten abbauen?

(2) Wie generiert man logische, vielfältige und hochauflösende Bilder? In den letzten zwei Jahren wurde Transformer erfolgreich in Bereichen wie Verarbeitung natürlicher Sprache (wie GPT), Computer Vision (wie ViT), multimodalem Vortraining (wie CLIP) und Bilderzeugungstechnologien eingesetzt Durch VAE und GAN wurde die Entwicklung der multimodalen Bilderzeugung allmählich vom aufstrebenden Stern überholt - dem Diffusionsmodell.

Multimodale Bilderzeugungstechnologie und klassische Arbeit

Klassifizierung

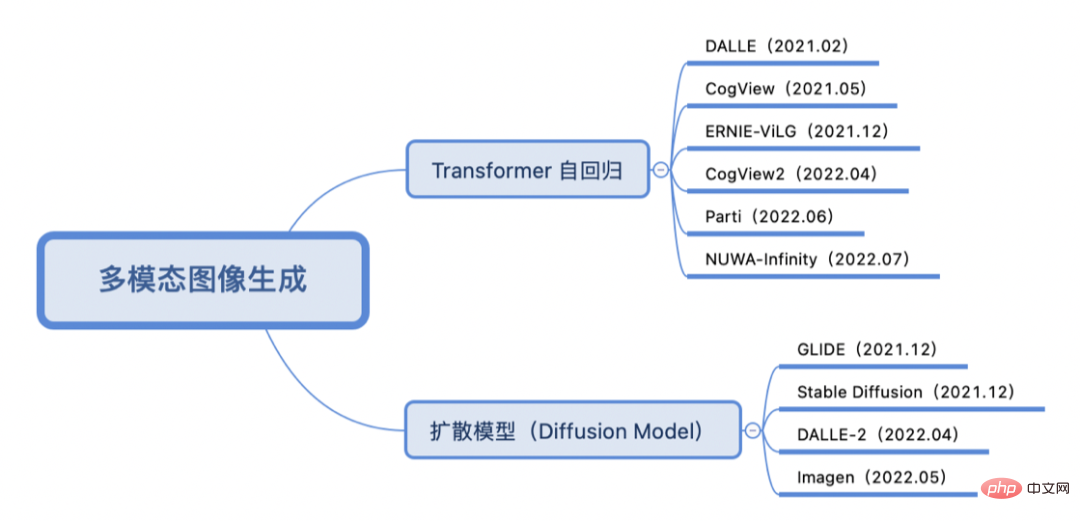

Je nachdem, ob die Trainingsmethode ein Transformer-Autoregressiv- oder Diffusionsmodell ist, wird die Schlüsselarbeit der multimodalen Bilderzeugung in den letzten zwei Jahren wie folgt klassifiziert:

Transformer Autoregressive

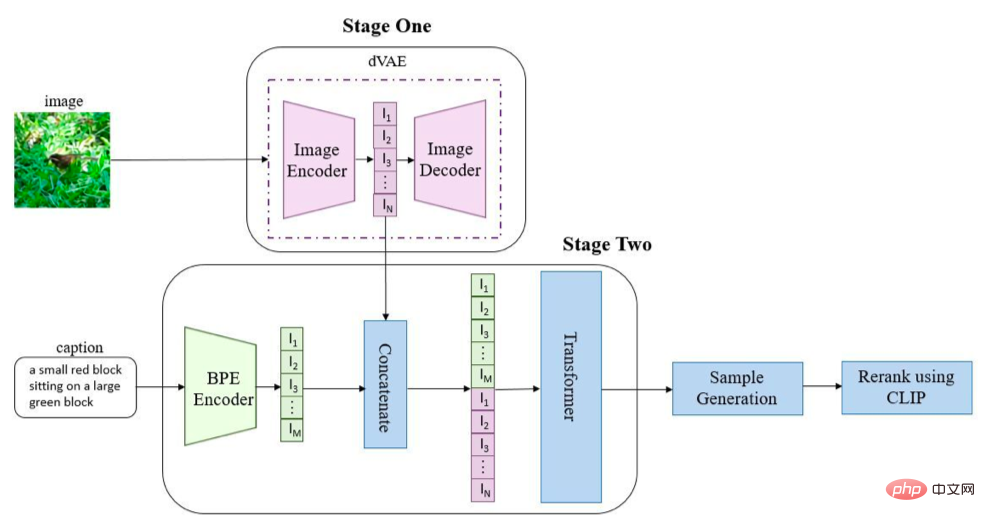

Die Praxis der Verwendung der Transformer Autoregressive-Methode konvertiert häufig Text und Bilder jeweils in Token-Sequenzen und verwendet dann die generative Transformer-Architektur, um die Textsequenz (und optionale Bildsequenz) aus der zu extrahieren Sagen Sie die Bildsequenz voraus und verwenden Sie schließlich die Bilderzeugungstechnologie (VAE, GAN usw.), um die Bildsequenz zu dekodieren und das endgültige generierte Bild zu erhalten. Nehmen Sie DALL-E (OpenAI) [1] als Beispiel:

Bilder und Text werden über ihre jeweiligen Encoder in Sequenzen umgewandelt, zusammengefügt und zur autoregressiven Sequenz an Transformer (hier wird GPT3 verwendet) gesendet Generation. In der Inferenzphase wird der vorab trainierte CLIP verwendet, um die Ähnlichkeit zwischen dem Text und dem generierten Bild zu berechnen, und die Ausgabe des endgültig generierten Bildes wird nach dem Sortieren erhalten. Ähnlich wie DALL-E verwenden auch Tsinghuas CogView-Serie [2, 3] und Baidus ERNIE-ViLG [4] das VQ-VAE + Transformer-Architekturdesign, während Googles Parti [5] den Bildcodec durch ViT-VQGAN ersetzt. NUWA-Infinity [6] von Microsoft verwendet autoregressive Methoden, um eine unendliche visuelle Generierung zu erreichen.

Diffusionsmodell

Diffusionsmodell ist eine Bilderzeugungstechnologie, die sich im vergangenen Jahr rasant weiterentwickelt hat und als das Ende von GAN gefeiert wird. Wie in der Abbildung gezeigt, ist das Diffusionsmodell in zwei Phasen unterteilt: (1) Rauschen: allmähliches Hinzufügen von zufälligem Rauschen zum Bild entlang des Diffusionsprozesses der Markov-Kette; (2) Entrauschen: Erlernen des inversen Diffusionsprozesses zur Wiederherstellung des Bildes; Zu den gängigen Varianten gehören das Denoising Diffusion Probability Model (DDPM) usw.

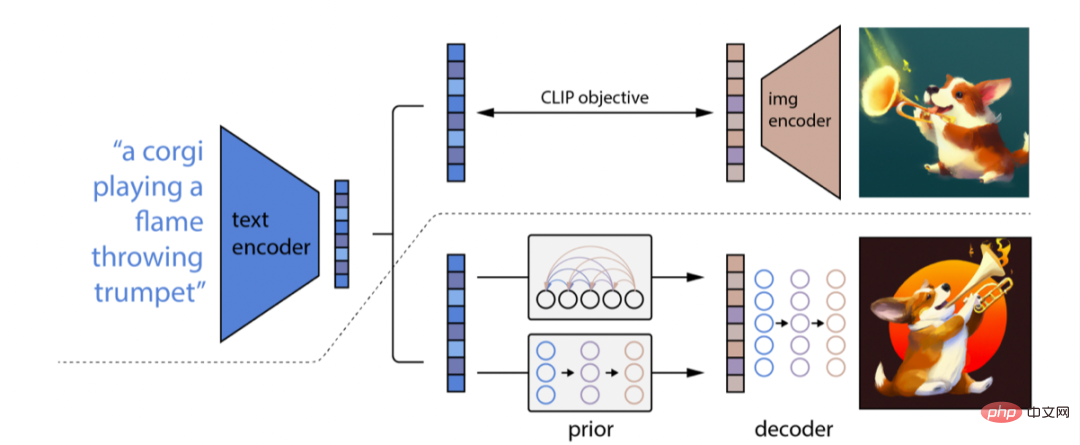

Die multimodale Bilderzeugungsmethode unter Verwendung des Diffusionsmodells lernt hauptsächlich die Zuordnung von Textmerkmalen zu Bildmerkmalen durch das Diffusionsmodell mit bedingter Anleitung und dekodiert die Bildmerkmale, um das endgültig generierte Bild zu erhalten. Nehmen Sie als Beispiel DALL-E-2 (OpenAI) [7] Obwohl es eine Fortsetzung von DALL-E ist, geht es einen völlig anderen technischen Weg als DALL-E. Sein Prinzip ähnelt eher GLIDE [8]. nennen Sie GLIDE DALL-E-1.5). Die Gesamtarchitektur von DALL-E-2 ist in der Abbildung dargestellt:

DALL-E-2 verwendet CLIP zum Codieren von Text und verwendet ein Diffusionsmodell, um einen vorherigen Prozess zu erlernen, um Textmerkmale für Bilder A zu erhalten Zuordnen von Merkmalen; schließlich wird ein Prozess der Invertierung von CLIP erlernt, um die Bildmerkmale in das endgültige Bild zu dekodieren. Im Vergleich zu DALL-E-2 verwendet Googles Imagen [9] vorab trainiertes T5-XXL, um CLIP für die Textcodierung zu ersetzen, und verwendet dann ein hochauflösendes Diffusionsmodell (U-Net-Architektur), um die Bildgröße zu erhöhen und 1024 zu erhalten ✖️1024 HD-generierte Bilder.

Zusammenfassung

Die Einführung des autoregressiven Transformers und der CLIP-Vergleichslernmethode haben gleichzeitig eine Brücke zwischen Text und Bildern geschlagen und auf der Grundlage des Diffusionsmodells mit bedingter Anleitung den Grundstein für die Generierung vielfältiger und hochwertiger Daten gelegt. Auflösungsbilder. Allerdings ist die Bewertung der Qualität der Bilderzeugung oft subjektiv, so dass es hier schwierig ist, die Autoregressions- oder Diffusionsmodelltechnologie von Transformer zu vergleichen. Und Modelle wie die DALL-E-Serie, Imagen und Parti werden auf großen Datensätzen trainiert, und ihre Verwendung kann ethische Probleme und soziale Vorurteile verursachen, sodass diese Modelle noch nicht als Open Source verfügbar sind. Dennoch gibt es immer noch viele Enthusiasten, die versuchen, die Technologie zu nutzen, und in dieser Zeit wurden viele spielbare Anwendungen entwickelt.

KI-Kunsterstellung

Die Entwicklung der multimodalen Bilderzeugungstechnologie bietet mehr Möglichkeiten für die KI-Kunsterstellung. Zu den derzeit weit verbreiteten KI-Erstellungsanwendungen und -Tools gehören CLIPDraw, VQGAN-CLIP, Disco Diffusion, DALL-E Mini, Midjourney (erfordert Einladungsqualifikation), DALL-E-2 (erfordert interne Beta-Qualifikation), Dream By Wombo (App), Meta „Make-A-Scene“, Tiktok „AI Green Screen“-Funktion, Stable Diffusion [10], Baidu „Yige“ usw. Dieser Artikel verwendet hauptsächlich Disco Diffusion, das im Kunstschaffenskreis beliebt ist, für die KI-Kunsterstellung.

Einführung in Disco Diffusion

Disco Diffusion [11] ist eine KI-Kunsterstellungsanwendung, die von vielen Technologiebegeisterten gemeinsam auf Github gepflegt wird. Es wurden bereits mehrere Versionen iteriert. Aus dem Namen Disco Diffusion ist nicht schwer zu erkennen, dass es sich bei der verwendeten Technologie hauptsächlich um ein von CLIP geleitetes Diffusionsmodell handelt. Disco Diffusion kann künstlerische Bilder oder Videos basierend auf bestimmten Textbeschreibungen (und optionalen Grundkarten) generieren. Wenn Sie beispielsweise „Meer der Blumen“ eingeben, generiert das Modell zufällig ein Rauschbild und durchläuft Schritt für Schritt den Entrauschungs-Diffusionsprozess. Nach Erreichen einer bestimmten Anzahl von Schritten kann ein schönes Bild gerendert werden. Dank der vielfältigen Generierungsmethoden des Diffusionsmodells erhalten Sie bei jedem Start des Programms unterschiedliche Bilder. Dieses „Blind Box Opening“-Erlebnis ist wirklich faszinierend.

Disco Diffsion hat Probleme

Bei der KI-Erstellung auf Basis des multimodalen Bildgenerierungsmodells Disco Diffusion (DD) gibt es derzeit mehrere Probleme:

(1) Die Qualität der generierten Bilder variiert: abhängig von der Schwierigkeit der Generierungsaufgabe: Eine grobe Schätzung ist, dass die Ertragsrate von Generierungsaufgaben mit schwierigem Beschreibungsinhalt 20 % bis 30 % und die Ertragsrate von Generierungsaufgaben mit einfacherem Beschreibungsinhalt 60 % bis 70 % beträgt zwischen 30 % und 40 %.

(2) Langsame Generierungsgeschwindigkeit + hoher Speicherverbrauch: Nehmen wir beispielsweise eine Iteration von 250 Schritten, um ein 1280*768-Bild zu generieren, dauert es etwa 6 Minuten und verwendet V100 16G-Videospeicher.

(3) Verlassen Sie sich stark auf die Erfahrung von Experten: Die Auswahl eines geeigneten Satzes von Deskriptoren erfordert viel Versuch und Irrtum bei der Einstellung von Textinhalten und -gewichten, Verständnis für den Stil und die Kunstgemeinschaft des Malers und die Auswahl der Textmodifikatoren, die erforderlich sind die Einbeziehung von DD. Sie verfügen über ein tiefes Verständnis für Konzepte wie CLIP-Führungszeiten/Sättigung/Kontrast/Rauschen/Schnittzeiten/interne und externe Schnitte/Gradientengröße/Symmetrie/... und müssen über bestimmte künstlerische Fähigkeiten verfügen. Die große Anzahl an Parametern bedeutet auch, dass umfangreiche Expertenerfahrung erforderlich ist, um ein anständiges generiertes Bild zu erhalten.

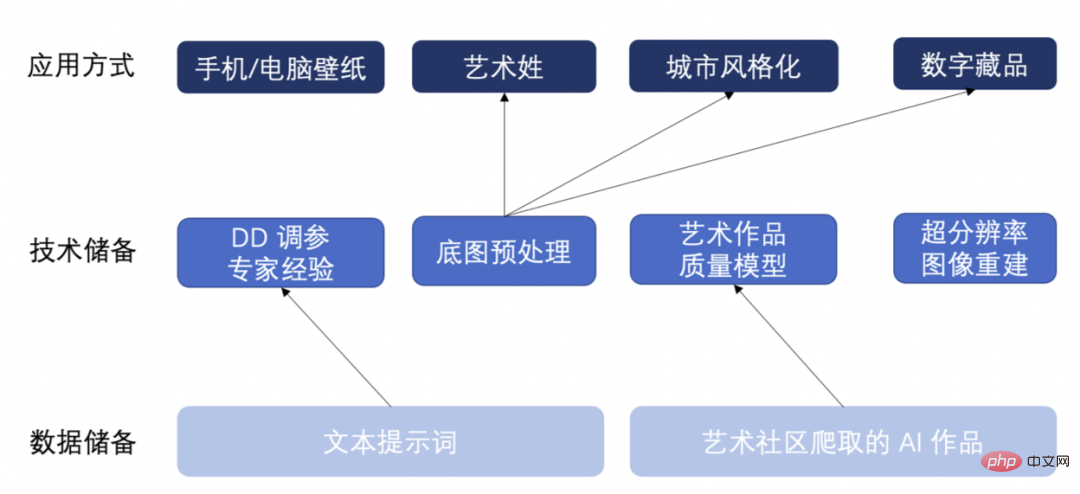

Fähigkeitsreserve

Als Reaktion auf die oben genannten Probleme haben wir einige Daten- und Technologiereserven sowie einige mögliche zukünftige Anwendungen gebildet. Wie im Bild unten gezeigt:

- Als Antwort auf die erste Frage haben wir fast 20.000 KI-generierte Kunstwerke aus der Kunstschaffenden-Community gecrawlt und sie basierend auf den Grundattributen der generierten Bilder und der Rationalität des Inhalts in drei Kategorien eingeteilt: gute Qualität/durchschnittliche Qualität /schlechte Qualität. Trainieren Sie ein Modell zur Bewertung der Kunstqualität. Dieses Modell kann die Qualität von KI-generierten Bildern automatisch bewerten und Bilder mit hoher Ausbeute auswählen, wodurch das Problem der geringen Effizienz bei der manuellen Auswahl hochwertiger Bilder gelöst wird.

- Für das zweite Problem verbessern wir die Generierungseffizienz von DD, indem wir die Anzahl der Iterationen reduzieren, kleine Bilder erzeugen und dann den Superauflösungsalgorithmus ESRGAN für die hochauflösende Bildrekonstruktion verwenden. Mit dieser Methode kann der gleiche Bildeffekt erzielt werden wie mit der normalen Iteration von DD, und die Generierungseffizienz und die Optimierung des Videospeichers werden mindestens verdoppelt.

- Als Antwort auf die dritte Frage haben wir eine Reihe von Grundkarten-Vorverarbeitungslogiken zusammengestellt, einschließlich Farbtemperatur- und Farbtonanpassung/Vordergrund- und Hintergrundfarbanpassung/Hinzufügen von Rauschen usw., die schnell verschiedene Aufgaben zur Grundkartengenerierung gleichzeitig anwenden können Mit der Zeit haben wir auch eine große Menge an Texteingabeaufforderungswörtern gesammelt, eine große Anzahl von DD-Parameteranpassungsversuchen und -fehlern durchgeführt und uns auf die Erfahrung von Experten verlassen, um personalisierte, vielfältige und qualitativ hochwertige Bilder zu generieren.

Unter Verwendung dieser Daten und technischen Reserven haben wir multimodale Bilderzeugungsanwendungsmethoden wie Handy-/Computerhintergründe, künstlerische Nachnamen/Vornamen, Stilisierung von Wahrzeichenstädten, digitale Sammlungen usw. zusammengestellt. Nachfolgend zeigen wir spezifische KI-generierte Kunstwerke.

KI-Kunstwerk

Stilisierung von Gebäuden mit Wahrzeichen der Stadt

Durch die Eingabe von Textbeschreibungen und Grundkarten von Wahrzeichen der Stadt werden verschiedene Gemäldestile (Anime-Stil/Cyberpunk-Stil/Pixel-Art-Stil) generiert:

(1) Ein Gebäude mit Anime Stil, von Makoto Shinkai und Beeple, Trend auf Artstation.

(2) Ein Gebäude im Cyberpunk-Stil, von Gregory Grewdson, Trend auf Artstation.

(3) Ein Gebäude im Pixelstil, von Stefan Bogdanovi, Trend auf Artstation.

Digitale Sammlung

Erstellen Sie auf der Grundkarte, indem Sie eine Textbeschreibung und eine Grundkarte eingeben.

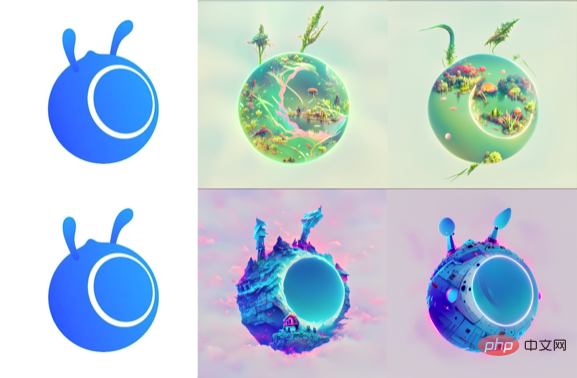

- Ant Logo Series (Ameisenwald/Ameisenhaus/Ameisenraumschiff):

(1) Eine Landschaft mit Vegetation und See, von RAHDS und beeple, Trend auf artstation.(2) Verzaubertes Häuschen am Rande einer Klippe Vorahnung bedrohliche Fantasielandschaft, von RAHDS und Beeple, Trend auf Artstation.

(3) Ein Raumschiff von RAHDS und Beeple, Trend auf Artstation.

- Ant-Chicken-Serie (Chicken Transformers/Chicken Spongebob):

(1) Transformers mit Maschinenpanzerung, von Alex Milne, Trend auf Artstation.

(2) Spongebob von RAHDS und Beeple, Trend auf Artstation.

Hintergrundbild für Mobilgeräte/Computer

- Hintergrundbild für Mobilgeräte generieren von Geben Sie eine Textbeschreibung ein:

(1) Die esoterische Traumlandschaft von Dan Luvisi, im Trend bei Artstation, matte Malerei einer riesigen Landschaft.

(2) Verstreute Terrassen, Winter, Schnee, von Makoto Shinka, im Trend bei Artstation, 4K-Hintergrundbild.

(3) Ein wunderschönes Cloudpunk-Gemälde von Atlantis, das aus dem Abgrund aufsteigt, angekündigt von Steampunk-Walen im Rokoko-Stil von Pixar, Artstation, volumetrische Beleuchtung.

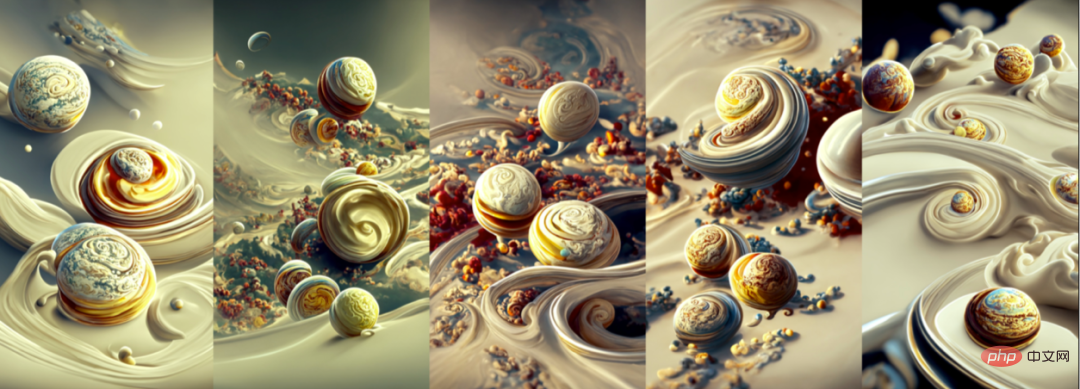

(4~8) Eine malerische Ansicht der rotierenden Planeten durch Chantilly-Creme von Ernst Haeckel und Pixar im Trend auf Artstation, 4K-Hintergrundbild.

- Generieren Sie ein Computer-Hintergrundbild, indem Sie eine Textbeschreibung eingeben:

(1) Schöne, wunderschöne ländliche Felder, Superweitwinkel, Ausblick, Morgen von Makoto Shinkai .

(2) Ein wunderschönes Gemälde einer sternenklaren Nacht, die ihr Licht über ein Sonnenblumenmeer strahlt, von James Gurney, im Trend auf artstation.

(3) Märchenhaftes Dampfland von Greg Rutkowski und Thomas Kinkade im Trend auf artstation.

(4) Eine wunderschöne Darstellung eines magischen Gebäudes in einer verträumten Landschaft von Daniel Merriam, sanfte Beleuchtung, 4K-HD-Hintergrundbild, Trend auf Artstation und Behance描述与姓氏底图,生成不同风格的艺术姓:

(1) Große Militärfabriken, Mech-Testmaschinen, halbfertige Mechs, technische Fahrzeuge, Automatisierungsmanagement, Indikatoren, Zukunft, Science-Fiction, Lichteffekte , hochauflösendes Bild.

(1) Große Militärfabriken, Mech-Testmaschinen, halbfertige Mechs, technische Fahrzeuge, Automatisierungsmanagement, Indikatoren, Zukunft, Science-Fiction, Lichteffekte , hochauflösendes Bild.

(2) Ein wunderschönes Gemälde von Pilzen, Bäumen, Artstation, Artstation, 4K-HD-Hintergrundbild.(3) Ein wunderschönes Gemälde von Sonnenblumen, Nebel und einem unwirklichen Motor, der sein Licht über ein turbulentes Meer strahlt of Blood von Greg Rutkowski und Thomas Kinkade, Artstation, Andreas Rocha, Greg Rutkowski.

- (4) Ein wunderschönes Gemälde des Pavillons auf dem Wasser zeigt eine Spiegelung, von John Howe, Albert Bierstadt, Alena Aenami und Dan Mumford Concept Art Hintergrundbild 4k, Trend auf Artstation, Konzeptkunst, Kino, Unreal Engine, Trend auf Behance.

- (5) Eine wunderschöne Landschaft eines üppigen Dschungels mit exotischen Pflanzen und Bäumen, von John Howe, Albert Bierstadt, Alena Aenami und Dan Mumford Konzeptkunst-Hintergrundbild 4k, Trend auf Artstation, Konzeptkunst, Film, Unreal Engine, Trend auf Behance.

(6) Contra Force, Rote Festung, Raumschiff, von Ernst Haeckel und Pixar, Hintergrund HD 4k, Trend auf Artstation.

其他 AI 艺术创作应用

Stable Diffusion [10, 12] 展现了比 Disco Diffusion [11] 更加高效且稳定的创作能力, 尤其是在„物“的刻画上更加突出.下图是笔者利用 Stable Diffusion,根据文本创作的 AI 绘画作品:

本文主要介绍了近两年来多模态图像生成技术及相关的进展工作, 并尝试使用多模态图像生成进行多种 AI 艺术创作.接下来, 我们还将探索多模态图像生成技术在消费级 CPU 上运行的可能性, 以及结合业务为 AI 智能创作赋能, 并尝试更多如电影、动漫主题封面,游戏,元宇宙内容创作等更多相关应用.使用多模态图像生成技术进行艺术创作只是 AI 自主生产内容 (AIGC, AI generic content)的一种应用方式.得益海量数据与预训练大模型的发展, AIGC人工智能又迈进了一小步?如果你对本文涉及到的技术或者应用感兴趣欢迎共创交流。

参考文献

参考文献

[1] Ramesh A, Pavlov M, Goh G, et al. Zero-Shot-Text-zu-Bild-Generierung[C]//Internationale Konferenz über maschinelles Lernen. PMLR, 2021: 8821-8831.

[2] Ding M, Yang Z, Hong W, et al. Cogview: Beherrschung der Text-zu-Bild-Generierung über Transformatoren[J]. Fortschritte in neuronalen Informationsverarbeitungssystemen, 2021, 34: 19822-19835.

[3] Ding M, Zheng W, Hong W, et al. CogView2: Schnellere und bessere Text-zu-Bild-Generierung über hierarchische Transformatoren[J]. arXiv-Vorabdruck arXiv:2204.14217, 2022.

[4] Zhang H, Yin W, Fang Y, et al. ERNIE-ViLG: Einheitliches generatives Vortraining für die bidirektionale Vision-Sprachgenerierung[J]. arXiv-Vorabdruck arXiv:2112.15283, 2021.

[5] Yu J, Xu Y, Koh J Y, et al. Skalierung autoregressiver Modelle für die inhaltsreiche Text-zu-Bild-Generierung[J]. arXiv-Vorabdruck arXiv:2206.10789, 2022.

[6] Wu C, Liang J, Hu X, et al. NUWA-Infinity: Autoregressive über autoregressive Generierung für unendliche visuelle Synthese[J]. arXiv-Vorabdruck arXiv:2207.09814, 2022.

[7] Ramesh A, Dhariwal P, Nichol A, et al. Hierarchische textbedingte Bildgenerierung mit Clip-Latents[J]. arXiv-Vorabdruck arXiv:2204.06125, 2022.

[8] Nichol A, Dhariwal P, Ramesh A, et al. Glide: Auf dem Weg zur fotorealistischen Bilderzeugung und -bearbeitung mit textgesteuerten Diffusionsmodellen[J]. arXiv-Vorabdruck arXiv:2112.10741, 2021.

[9] Saharia C, Chan W, Saxena S, et al. Fotorealistische Text-zu-Bild-Diffusionsmodelle mit tiefem Sprachverständnis[J]. arXiv-Vorabdruck arXiv:2205.11487, 2022.

[10] Rombach R, Blattmann A, Lorenz D, et al. Hochauflösende Bildsynthese mit latenten Diffusionsmodellen[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022: 10684-10695.

[11] Github: https://github.com/alembics/disco-diffusion

[12] Github: https://github.com/CompVis/stable-diffusion

Das obige ist der detaillierte Inhalt vonWelche Funken werden entstehen, wenn KI auf die Kunst der Malerei trifft?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Vom Punkt zur Oberfläche: verallgemeinerbare vielfältige gegnerische Angriffe, von einzelnen gegnerischen bis hin zu vielfältigen gegnerischen Angriffen

- Das Monatsgehalt nach dem Abschluss beginnt bei 30.000! Algorithmeningenieure haben zu 90 % einen Master- oder Doktortitel

- Neurosymbolische Regression: Wissenschaft aus Daten extrahieren

- Google AudioPaLM implementiert die dualmodale Lösung „Text + Audio', ein großes Modell für Sprechen und Hören

- PICO lädt Sie ein, „Follow De Ye to East Africa' zu erleben: von der interaktiven VR-Dokumentation bis zum immersiven Offline-Pop-up