Heim >Technologie-Peripheriegeräte >KI >Yang Dong, technischer Plattformdirektor von Unity Greater China: Beginn der digitalen menschlichen Reise im Metaversum

Yang Dong, technischer Plattformdirektor von Unity Greater China: Beginn der digitalen menschlichen Reise im Metaversum

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-08 18:11:091247Durchsuche

Als Eckpfeiler beim Aufbau von Metaverse-Inhalten sind digitale Menschen die frühesten ausgereiften Szenarien der Metaverse-Unterteilung, die implementiert und nachhaltig weiterentwickelt werden können. Derzeit sind virtuelle Idole, E-Commerce-Bereitstellung, TV-Hosting, virtuelle Anker. usw. Kommerzielle Anwendungen wurden von der Öffentlichkeit anerkannt. In der Welt des Metaversums sind nichts Geringeres als digitale Menschen einer der wichtigsten Inhalte, denn digitale Menschen sind nicht nur die „Inkarnationen“ realer Menschen im Metaversum, sie sind auch eines der wichtigsten Vehikel für uns Führen Sie verschiedene Interaktionen im Metaversum durch.

Es ist bekannt, dass das Erstellen und Rendern realistischer digitaler menschlicher Charaktere eines der schwierigsten Probleme in der Computergrafik ist. Kürzlich hielt Yang Dong, Unity Greater China Platform Technology Director, im Nebenveranstaltungsort „Game and AI Interaction“ der MetaCon Metaverse Technology Conference, die von 51CTO veranstaltet wurde, eine Reihe von Demo-Demonstrationen zum Thema „Unity Digital Human Technology – Starting a Journey to“. the Metaverse“ „Die Themenfreigabe der Unity HD-Rendering-Pipeline-Technologie wird ausführlich vorgestellt.

1. Einführung in Unity

Unity ist derzeit die am meisten unterstützte Computerplattform der Welt und unterstützt mittlerweile fast 30 Computerplattformen, darunter PC, Mac, Linux, iOS, Android, Switch, PlayStation, Xbox und alle AR/VR, MMAT und andere Geräte. Wenn Sie dreidimensionale interaktive Inhalte produzieren, ist Unity derzeit die beste Wahl. Wir wissen, dass auf einigen Computern, die mit unabhängigen Grafikkarten ausgestattet sind, High-Definition-Rendering zum Rendern von High-Definition-Inhalten verwendet wird. Die sogenannte realistische digitale menschliche Technologie basiert jetzt auf High-Definition-Rendering-Technologie.

Derzeit hat das Unity China-Team mehr als 300 Vollzeitmitarbeiter und fast 7.000 Menschen auf der ganzen Welt, von denen mehr als 70 % Ingenieure sind. Der Hauptsitz befindet sich in Shanghai, mit Büros in Peking und Guangzhou und den dort tätigen entsprechenden Mitarbeitern.

2. Was sind die leistungsstarken Aspekte der Unity-Engine?

Obwohl Unity derzeit keine Kaiyuan-Engine ist, sind ihre Module in hohem Maße anpassbar.

Das Bild zeigt die derzeit von Unity unterstützten Plattformen. Einige der gängigsten Plattformen sind auf diesen Symbolen zu finden. Dies sind möglicherweise einige der beliebtesten Spiele der letzten Jahre, und einige dieser Ikonen sind relativ bekannt, wie z. B. Honor of Kings, CALL DUTY, League of Legends, Genshin Impact, Fall Bean Man, Shining Nuan Nuan ... Tatsächlich werden mehr als 70 % der 1.000 profitabelsten Spiele auf in- und ausländischen Android- und iOS-Listen von Unity erstellt. Mehr als die Hälfte der Switch-Spiele werden mit Unity erstellt. Sie glauben vielleicht nicht, dass ein Spiel, das sehr komplex aussieht und eine hohe Grafikqualität aufweist und ein Erfolgsspiel war, das zuerst auf Xbox veröffentlicht wurde, von einer Person entwickelt wurde, was die Flexibilität der Unity-Engine und die Leistungsfähigkeit der Toolkette voll und ganz demonstriert .

Unity entwickelt sich in Richtung hoher Leistung und Effizienz. Lassen Sie mich die drei Hauptkomponenten des Dots-Systems erläutern: C#Job System, ECS und Burst Compiler. Das C#Job-System ermöglicht es den entwickelten Spielen oder Anwendungen tatsächlich, die gleichzeitige Rechenleistung der integrierten CPU voll auszunutzen, da das aktuelle objektorientierte Programmiermodell der Produktionsinhalt ist, der im Hauptthread ausgeführt wird. Das zweite ist das Entity Component System (ECS). Durch das Entity Component System können die Daten vom System, also der Spiellogik, getrennt werden, was einfacher zu warten und speicherfreundlicher ist. Der Burst Compiler kann leistungsfähigeren Maschinencode für die Zielplattform generieren.

Andererseits ist die hohe Bildqualität auch ein sehr gutes Merkmal von Unity. Wenn Sie nur sagen, dass Sie einen teuren PC oder eine teure Xbox- oder Playstation-Maschine verwenden müssen, um schöne Bilder darzustellen, ist die Vielseitigkeit des Spiels tatsächlich zu dürftig. Unity verwendet XRP, die sogenannte variable Rendering-Pipeline, um zwei Sätze sofort einsatzbereiter Rendering-Pipelines für alle zu erstellen. Eine ist die universelle Rendering-Pipeline URP und die zweite ist HDRP (High-Definition-Rendering-Pipeline). . Wie der Name schon sagt, wird die sogenannte Universal-Rendering-Pipeline von URP von allen Plattformen unterstützt. Unabhängig davon, ob Sie VR-Spiele, AR-Spiele oder mobile Spiele entwickeln, kann URP für Rendering-Arbeiten verwendet werden. HDRP bezieht sich auf PC-Mac-Linux-, Xbox1- und Basestation4-Plattformen und höher, die auch Echtzeit-Raytracing unterstützen.

3 Wie erreicht die HD-Rendering-Pipeline eine qualitativ hochwertige Darstellung digitaler Menschen?

Der „heidnische“ digitale Mann ist eigentlich nicht der erste von Unity produzierte digitale Mann, aber der „heidnische“ digitale Mann hat seine eigene Einzigartigkeit, weil dieser digitale Mann sehr realistisch ist und einen vollständigen Workflow bildet . Um ein qualitativ hochwertiges Rendering wie „Infidel“ zu erreichen, ist eine hochauflösende Rendering-Pipeline unerlässlich.

Der digitale Mensch „The Infidel“ hat tatsächlich einen Prototyp. Er ist ein britischer Theaterschauspieler mit dem Namen Jack. Dabei handelt es sich um die Daten seines gesamten Körpers, und der Fokus liegt auf dem Scannen seines Kopfes . Diese Daten werden verwendet, um den gesamten digitalen Menschen zu erstellen. Die 4D-Volumenvideo-Technologie wird verwendet, um Ausdrucksanimationen zu erstellen Der Nachteil besteht darin, dass es nicht in Echtzeit gesteuert werden kann. Es kann problemlos Charakteranimationen in Film und Fernsehen erstellen, aber nicht in Echtzeit.

In einigen erfolgreichen Fällen können Sie einen Blick auf Augen-Rendering und Haut-Rendering werfen, schauen wir uns diese jeweils an.

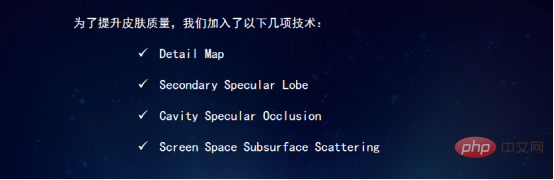

Um die Qualität der Haut zu verbessern, wurden die folgenden Technologien hinzugefügt: Detailkarte. Secondary Specular Lobe ist das Highlight der zweiten Ebene, Cavity Specular Occlusion bezieht sich auf die Vertiefung, die das Highlight blockieren kann, und Screen Space Subsurface Scattering bezieht sich auf die Streuung des Bildschirmraums unter der Oberfläche.

Die erste Detailkarte wird hauptsächlich zur Simulation von Texturen wie Details auf der Hautoberfläche verwendet. Diese Textur ist nicht groß, es ist eine 1K-Textur.

Die zweite Highlight-Schicht, Secondary Specular Lobe, wird verwendet, um die Ölschicht auf der Hautoberfläche zu simulieren, da die Haut fettig sein wird und selbst die Haut trocken aussieht, ist es notwendig, diese zu verwenden Methode zum Hinzufügen einer zweiten Highlight-Ebene.

Das dritte ist das versunkene Highlight, das das Highlight in der Mitte des versunkenen Bereichs abdecken soll. Nach dem Hinzufügen der zweiten Glanzschicht erscheinen auch Glanzlichter in den eingesunkenen Hautbereichen, was offensichtlich unrealistisch ist. Die Glanzlichter müssen maskiert werden, damit keine Glanzlichter in den eingesunkenen Bereichen erscheinen.

Die vierte Möglichkeit ist die Streuung unter der Oberfläche im Bildschirmraum, die verwendet wird, um den Effekt der Haut selbst zu erzeugen. Wir wissen, dass die Haut selbst einen sogenannten 3S-Effekt hat, also den sogenannten Subsurface-Scattering-Effekt. Die Haut muss natürlich die Streuung unter der Oberfläche verwenden. Wenn wir diese Haut jedoch traditionell mit Offline-Rendering-Software wie MAYA oder 3Dmax simulieren, ist es sehr zeitaufwändig, den Effekt der Streuung unter der Oberfläche zu rendern. In Unity gibt es tatsächlich zwei Techniken zum Rendern von Streueffekten unter der Oberfläche. Die erste ist die Screen Space Subsurface Scattering-Technologie, die schneller rendert. Die zweite Methode erfolgt durch Lichtflug. Offensichtlich ist die Lichtflugmethode realistischer.

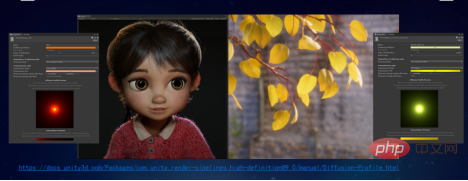

Diese Figur ist die Figur des kleinen Mädchens im Kurzfilm „The Wind-Up Musician“. Die Figur des kleinen Mädchens nutzt auch den unterirdischen Streueffekt des Bildschirmraums. Die Blätter auf der rechten Seite nutzen tatsächlich den Effekt der Streuung unter der Oberfläche.

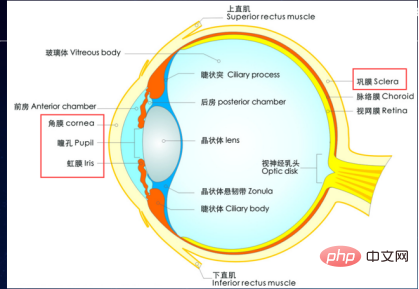

Als Nächstes sprechen wir über das Rendern für die Augen. Tatsächlich ist das Auge ein sehr komplexes Objekt. Durch die Simulation eines echten Augapfels in Echtzeit können durch die Simulation von vier Teilen: Hornhaut, Pupille, Iris und Lederhaut sehr realistische Effekte erzielt werden.

Wie im Bild gezeigt, ist unser Augapfel selbst ein sehr komplexes Objekt. Es gibt tatsächlich einen Unterschied zwischen der Vorderansicht und der Seitenansicht, insbesondere das Phänomen der Irisperspektive, wenn es normal gerendert wird Dieses Bild zeigt den sehr berühmten Digital Man-Charakter auf der GDC.

Der digitale menschliche Augapfel ist tatsächlich der Form eines echten Augapfels nachempfunden und verfügt über einige spezielle Maler, um die verschiedenen Parameter des Augapfels darzustellen. Einschließlich seiner Reflexion, der Normalkarten auf der Sklera und der Iris, den Effekten, die durch Anwenden verschiedener Normalwerte erzielt werden können, und sogar der Okklusion der Augenlider, die über einen separaten Controller gesteuert werden kann, sodass die Wirkung der Augenlider gesteuert werden kann .

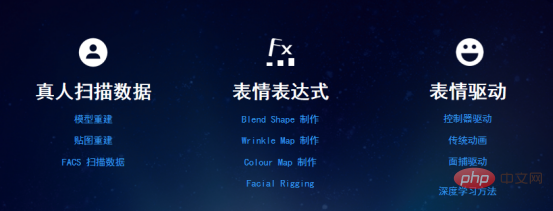

Zusammenfassend lässt sich sagen, dass Ausdrücke durch Mischform, Faltenkarte, Farbkarte und Gesichts-Rigging unter Verwendung gescannter Daten realer Personen erstellt werden und ein Controller zur Steuerung des Ausdrucks verwendet wird. Natürlich wissen wir auch, dass es viele andere Möglichkeiten gibt, diesen Ausdruck zu steuern. Tatsächlich ist es relativ einfach, Haut, Augen oder Haare zu rendern, aber die Ausdruckssteuerung ist tatsächlich ein sehr schwieriger Punkt.

Ich höre Entwickler oft sagen, warum die von ihnen verwendete Unity nicht die Effekte erzielen kann, die Unity erzielen kann? Denn die Effekte der von Unity präsentierten Demos wurden von einer Gruppe von Leuten mit großem Aufwand erstellt und die von ihnen verwendeten Technologien waren in der von ihnen erstellten Version tatsächlich noch nicht verfügbar. Nach Abschluss dieser Demo und dem Besitz dieser Technologien wird dies nach und nach der Fall sein In der nächsten Version kombiniert, entsteht schließlich eine funktionsfähige Version, die jeder nutzen kann.

4. Wie entsteht ein digitaler Mensch?

Nach der Fertigstellung von „Infidel“ hat das Unity China-Team tatsächlich einen eigenen digitalen Menschen geschaffen, indem es die Technologie von „Infidel“, sitzendes 4D-Scannen und andere Technologien anwendet.

Dies ist ein echtes Projekt und der Prozess ist tatsächlich genau der gleiche wie bei „Infidel“. Dazu gehören das Bereinigen der Daten, das Erstellen der entsprechenden Mischform, das Erstellen von Wrinkle Map, das Erstellen von Rig und das anschließende Steuern des Ausdrucks. Der Controller in ASSETStore verwendet Animation Clip und BlendShape, um die Ausdrucksanimation darzustellen. Natürlich gibt es tatsächlich noch mehr Möglichkeiten, Gesichter zu erfassen, z. B. die Verwendung von Market zum Verfolgen, die Verwendung von ARKit zum Verfolgen und die Verwendung von Bilddaten zum Fahren.

Verwenden Sie bei der tatsächlichen Entwicklung die Kamera, um Ausdrücke zu erfassen und die Ausdrücke des menschlichen Kopfes zu testen. Es gibt eine andere Möglichkeit, Bilddaten zum Fahren zu verwenden. Ein sehr großer Unterschied besteht darin, dass sie lange fließende Haare hat. Diese vom Unity China-Team entwickelte Lösung eignet sich sowohl für allgemeine Rendering-Pipelines als auch für die Erstellung hochwertiger Rendering-Pipelines Haar. Die Darstellung der Haare unterscheidet sich stark von der herkömmlichen Plug-in-Methode. Sie kann sehr glatt sein und fühlt sich sogar wie eine Head & Shoulders-Werbung an. Ausdrücke werden tatsächlich in Echtzeit durch AR-Cade gesteuert, und natürlich wird AR-Cade zur Steuerung von Ausdrücken verwendet.

Unity hat einen digitalen Menschen namens Emma. Der Ausdruck dieses digitalen Menschen wird vollständig durch die Ziva Dynamics-Technologie gesteuert. Die Kerntechnologie besteht tatsächlich darin, diese Muskelgruppen unter dem Modell oder unter der biologischen Haut zu simulieren Mithilfe der realen Körpermuskulatur von Dinosauriern lässt sich diese Technologie beispielsweise auch für die Simulation sehr realistischer Gesichtsausdrücke digitaler Menschen einsetzen. Traditionell ist ein Modell eine leere Hülle mit einer Hülle auf der Außenseite, aber in der Technologie von Ziva Dynamics gibt es tatsächlich echte anatomische Muskeln auf der Rückseite. Wenn diese Muskeln realistisch bewegt werden, können diese Häute eine andere oder höhere Form erreichen realistischer als die traditionelle Mischform- oder Knochenbindungsmethode.

Im März dieses Jahres veröffentlichte Unity auf der GDC den neuesten digitalen Menschentrailer. Der Ausdruck dieses digitalen Menschen ist sehr, sehr real. Es ist erwähnenswert, dass es sich bei ihren Haaren um eine Reihe von Fell-Rendering-Technologien handelt, die Unity bald veröffentlichen wird, eine Reihe von Haaren, die auf die HDRP-High-Definition-Rendering-Pipeline angewendet werden.

Willkommen auf der offiziellen Website der MetaCon Metaverse Technology Conference, um mehr über das Metaverse und den digitalen Menschen zu erfahren. Adresse: https://metacon.51cto.com/

Das obige ist der detaillierte Inhalt vonYang Dong, technischer Plattformdirektor von Unity Greater China: Beginn der digitalen menschlichen Reise im Metaversum. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr