Heim >Technologie-Peripheriegeräte >KI >Als die Forschung in Frage gestellt wurde, antwortete Jeff Dean: „Wir haben nicht versucht, neues SOTA zu bekommen, und auch die Kostenberechnung war falsch.'

Als die Forschung in Frage gestellt wurde, antwortete Jeff Dean: „Wir haben nicht versucht, neues SOTA zu bekommen, und auch die Kostenberechnung war falsch.'

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-08 16:21:151375Durchsuche

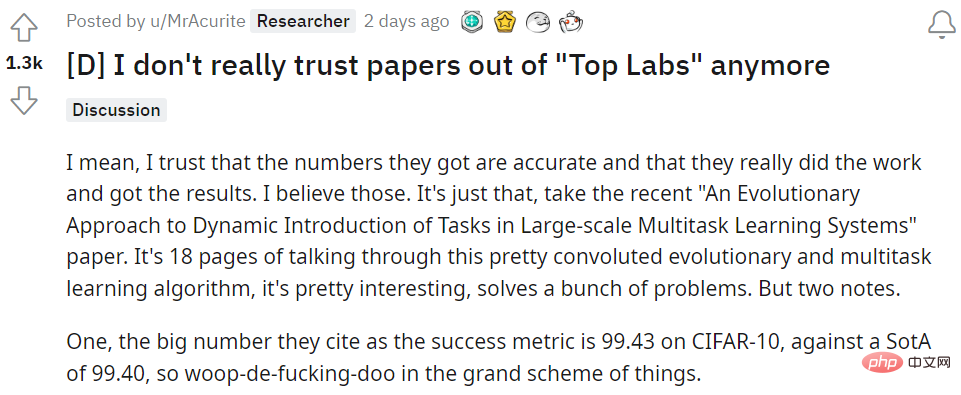

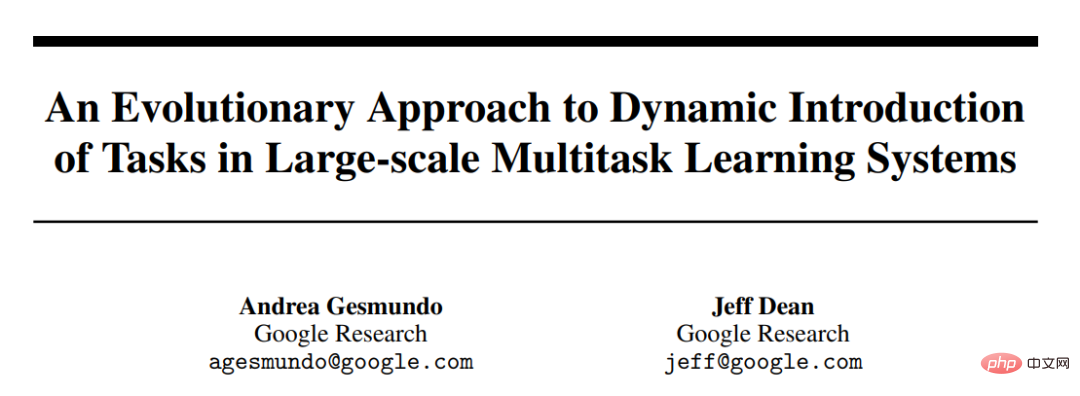

Gestern war das beliebteste Thema in der gesamten Community nichts weiter als ein Forscher für maschinelles Lernen auf reddit, der die Beteiligung von Google AI-Chef Jeff Dean an dem Artikel in Frage stellte. Der Artikel „An Evolutionary Approach to Dynamic Introduction of Tasks in Large-scale Multitask Learning Systems“ wurde am Donnerstag bei der Preprint-Paper-Plattform arXiv eingereicht.

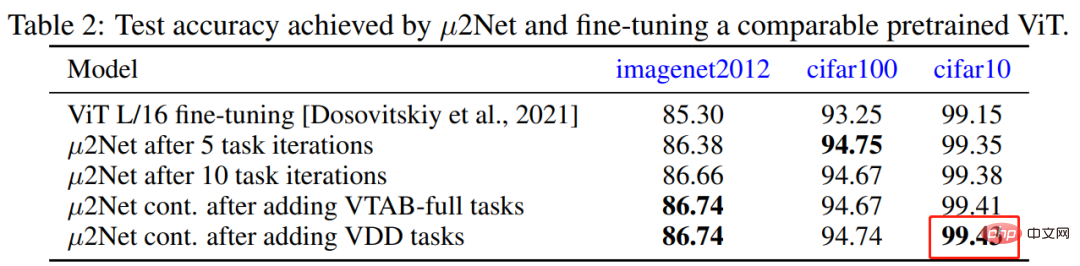

In dem Artikel schlugen Jeff Dean et al. einen evolutionären Algorithmus vor, der groß angelegte Multitask-Modelle generieren und gleichzeitig das dynamische und kontinuierliche Hinzufügen neuer Aufgaben unterstützen kann aufgabenbasiertes Routing. Die neue Methode erzielt wettbewerbsfähige Ergebnisse bei 69 Bildklassifizierungsaufgaben, beispielsweise das Erreichen einer neuen branchenweit hohen Erkennungsgenauigkeit von 99,43 % auf CIFAR-10 für ein Modell, das nur auf öffentlichen Daten trainiert wurde.

Es ist dieser neue SOTA, der auf CIFAR-10 erreicht wurde, der in Frage gestellt wurde, der vorherige SOTA lag bei 99,40. Sie sagte: „Um dieses Ergebnis zu erzielen, waren insgesamt 17.810 TPU-Kernstunden erforderlich. Wenn Sie nicht bei Google arbeiten, bedeutet dies, dass Sie eine On-Demand-Zahlung von 3,22 $/Stunde verwenden müssen und das trainierte Modell 57.348 $ kostet.“ , fragte sie ihre Seele: „Jeff Dean gab genug Geld aus, um eine vierköpfige Familie fünf Jahre lang zu ernähren, erreichte eine Verbesserung von 0,03 % gegenüber CIFAR-10 und schuf ein neues SOTA. Lohnt sich das alles?“

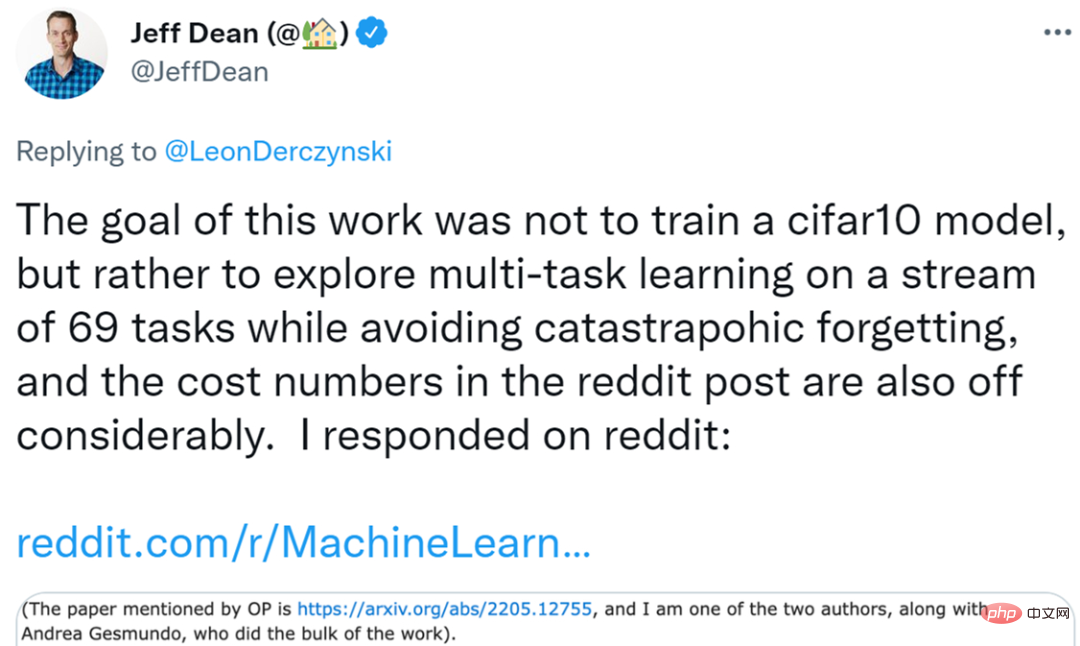

Diese Frage hat wurde von vielen Menschen auf diesem Gebiet bestätigt. Einige Forscher sagten sogar pessimistisch: „Ich habe fast das Interesse an Deep Learning verloren. Als Praktiker in einem kleinen Labor ist es im Grunde unmöglich, mit den Technologiegiganten in Bezug auf das Rechenbudget zu konkurrieren. Selbst wenn Sie eine gute theoretische Idee haben, Da.“ Möglicherweise sind es auch Vorurteile im Mainstream-Umfeld, die es schwierig machen, das Licht der Welt zu erblicken. Dies schafft unfaire Wettbewerbsbedingungen.“ Während das Thema weiter brodelte, antwortete Jeff Dean persönlich auf reddit. Er sagte: „Das Ziel unserer Forschung besteht nicht darin, ein qualitativ hochwertigeres cifar10-Modell zu erhalten, und es gibt auch Probleme mit der Kostenberechnungsmethode des ursprünglichen Autors.“ ist eine Zusammenarbeit zwischen mir und Andrea Gesmundo, die es gemeinsam fertiggestellt hat, und Andrea Gesmundo hat den größten Teil der Arbeit an dem Papier geleistet.

Papieradresse: https://arxiv.org/pdf/2205.12755.pdf Was ich sagen möchte ist, dass das Ziel dieser Forschung nicht darin besteht, ein qualitativ hochwertiges cifar10-Modell zu erhalten. Vielmehr untersucht diese Studie eine Umgebung, die dynamisch neue Aufgaben in ein laufendes System einführen und erfolgreich ein qualitativ hochwertiges Modell für die neue Aufgabe erhalten kann, das Darstellungen bestehender Modelle wiederverwendet und nur spärlich neue Parameter einführt, während gleichzeitig Probleme mit Multitask-Systemen vermieden werden als katastrophales Vergessen oder negative Migration.

Was ich sagen möchte ist, dass das Ziel dieser Forschung nicht darin besteht, ein qualitativ hochwertiges cifar10-Modell zu erhalten. Vielmehr untersucht diese Studie eine Umgebung, die dynamisch neue Aufgaben in ein laufendes System einführen und erfolgreich ein qualitativ hochwertiges Modell für die neue Aufgabe erhalten kann, das Darstellungen bestehender Modelle wiederverwendet und nur spärlich neue Parameter einführt, während gleichzeitig Probleme mit Multitask-Systemen vermieden werden als katastrophales Vergessen oder negative Migration.

Die Experimente dieser Studie zeigen, dass wir 69 verschiedene Aufgabenabläufe aus mehreren unabhängigen Visualisierungsaufgaben-Benchmarks dynamisch einführen können und am Ende ein Multitask-System erhalten, das gemeinsam hochwertige Lösungen für alle diese Aufgaben produzieren kann. Das resultierende Modell wird für jede bestimmte Aufgabe nur spärlich aktiviert, wobei das System immer weniger neue Parameter für neue Aufgaben einführt (siehe Abbildung 2 unten). Das Multitasking-System führte am Ende dieses Task-Streams nur 1,4 % neue Parameter für die inkrementellen Aufgaben ein, wobei jede Aufgabe durchschnittlich 2,3 % der Gesamtparameter des Modells aktivierte. Es gibt eine beträchtliche gemeinsame Nutzung von Darstellungen zwischen Aufgaben, und der Evolutionsprozess hilft zu bestimmen, wann dies sinnvoll ist und wann neue trainierbare Parameter für neue Aufgaben eingeführt werden sollten.

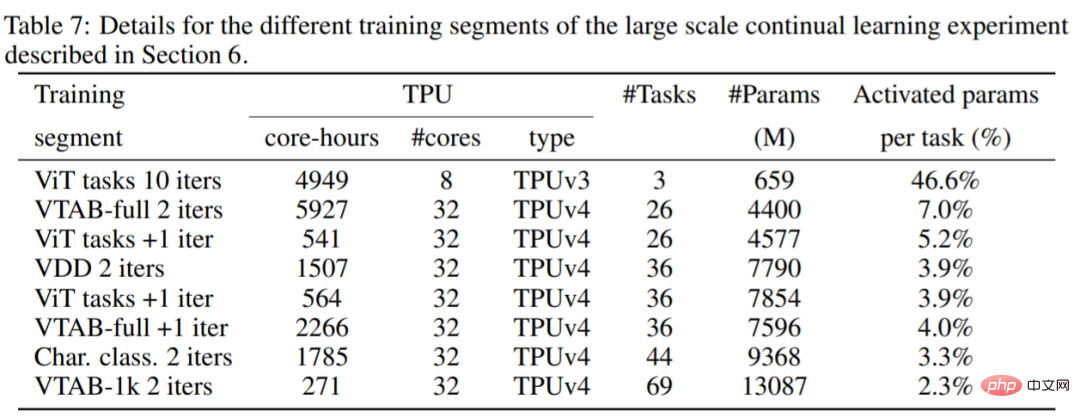

Ich denke auch, dass der Autor des ursprünglichen Beitrags die Kosten falsch berechnet hat. Das Experiment bestand darin, ein Multitask-Modell zu trainieren, um 69 Aufgaben gemeinsam zu lösen, anstatt ein cifar10-Modell zu trainieren. Wie Sie der folgenden Tabelle 7 entnehmen können, handelt es sich bei den verwendeten Berechnungen um eine Mischung aus TPUv3-Kernen und TPUv4-Kernen, sodass Kernstunden nicht einfach berechnet werden können, da sie unterschiedliche Preise haben.

Ich denke auch, dass der Autor des ursprünglichen Beitrags die Kosten falsch berechnet hat. Das Experiment bestand darin, ein Multitask-Modell zu trainieren, um 69 Aufgaben gemeinsam zu lösen, anstatt ein cifar10-Modell zu trainieren. Wie Sie der folgenden Tabelle 7 entnehmen können, handelt es sich bei den verwendeten Berechnungen um eine Mischung aus TPUv3-Kernen und TPUv4-Kernen, sodass Kernstunden nicht einfach berechnet werden können, da sie unterschiedliche Preise haben.

Es sei denn, Sie haben eine besonders dringende Aufgabe und müssen schnell cifar10+68-Aufgaben trainieren. Tatsächlich kann diese Art der Forschung problemlos Ressourcen mit Präventivpreisen nutzen, nämlich 0,97 $/Stunde TPUv4, 0,60 $/Stunde TPUv3 (nicht das, was sie sagen). Der On-Demand-Preis beträgt 3,22 $/Stunde. Unter diesen Annahmen belaufen sich die in Tabelle 7 beschriebenen Kosten für die öffentliche Computing-Cloud auf etwa 13.960 US-Dollar (unter Verwendung vorkaufsfähiger Preise von 12.861 TPUv4-Chipstunden und 2.474,5 TPUv3-Chipstunden) oder etwa 202 US-Dollar pro Aufgabe.

Ich denke, es ist wichtig, Modelle mit spärlichen Aktivierungen zu haben und in der Lage zu sein, dynamisch neue Aufgaben in bestehende Systeme einzuführen, die Darstellungen (sofern angemessen) teilen und katastrophales Vergessen vermeiden können. Diese Studien sind zumindest eine Erkundung wert. Das System hat außerdem den Vorteil, dass neue Aufgaben automatisch in das System integriert werden können, ohne dass sie speziell dafür formuliert werden müssen (das macht der evolutionäre Suchprozess), was eine nützliche Eigenschaft eines kontinuierlich lernenden Systems zu sein scheint.

Der Code dieses Dokuments ist Open Source und Sie können ihn selbst überprüfen.

Code-Adresse: https://github.com/google-research/google-research/tree/master/muNet

Der Autor des ursprünglichen Beitrags antwortete Jeff Dean

Nachdem er Jeff Deans Antwort gesehen hatte, antwortete der Ursprünglicher Beitrag Der Autor sagte: Zur Klarstellung: Ich denke, dieser Aufsatz von Jeff Dean (evolutionäre Muster zur Generierung einer Modellerweiterung in jeder Aufgabe) ist wirklich interessant. Er erinnert mich an einen anderen Aufsatz, aber ich kann mich nicht an den Titel des Aufsatzes erinnern Grob gesagt geht es darum, für jede neue Aufgabe neue Module zur gesamten Architektur hinzuzufügen, wobei die verborgenen Zustände anderer Module als Teil der Eingabe jeder Schicht verwendet werden, aber nicht die Gewichtungen vorhandener Komponenten aktualisiert werden.

Ich habe auch eine Idee, für jede Aufgabe Module im Modell zu bauen. Wissen Sie, wie Rehbabys bereits wenige Minuten nach der Geburt laufen können? Im Gegensatz dazu verfügten neugeborene Kitze damals im Wesentlichen über keine „Trainingsdaten“, um zu lernen, Bewegungen wahrzunehmen oder die Welt zu modellieren, und mussten stattdessen spezielle Strukturen im Gehirn nutzen, die vererbt werden mussten, damit das Kitz über grundlegende Fähigkeiten verfügte . Diese Strukturen werden in gewisser Weise sehr nützlich sein, da sie sich schnell auf eine neue, aber verwandte Steuerungsaufgabe übertragen lassen.

Diese Arbeit hat mich also dazu gebracht, über die Entwicklung bereits vorhandener vererbbarer Strukturen nachzudenken, die genutzt werden können, um neue Aufgaben effizienter zu erlernen.

Forscher in einem anderen Labor haben vielleicht die gleiche Idee, erzielen aber viel schlechtere Ergebnisse, weil sie es sich nicht leisten können, von ihrem bestehenden Setup auf eine große Cloud-Plattform umzusteigen. Und da sich die Community mittlerweile zu sehr auf SOTA-Ergebnisse konzentriert, können ihre Forschungsergebnisse nicht veröffentlicht werden. Auch wenn die Kosten „nur“ 202 $/Aufgabe betragen, sind viele Iterationen erforderlich, um alles richtig zu machen.

Für diejenigen von uns, die keinen Zugriff auf ein großes Computerbudget haben, haben wir also im Grunde nur zwei Möglichkeiten. Eine besteht darin, zu beten und zu hoffen, dass Google das bestehende Modell öffentlich verbreitet und wir es an unsere Bedürfnisse anpassen können. Dadurch hat das Modell jedoch möglicherweise Vorurteile oder kontroverse Schwächen gelernt, die wir nicht beseitigen können. Die zweite besteht darin, nichts zu tun und sich hinzulegen.

Mein Problem liegt also nicht nur bei dieser Studie. Wenn OpenAI (im übertragenen Sinne) Hunderte Milliarden Dollar für GPT-4 ausgeben möchte, dann geben Sie ihm mehr Leistung. Dies ist eine Wissenschafts- und Verlagskultur, die Glanz, große Zahlen und Luxus übermäßig belohnt, anstatt Menschen dabei zu helfen, in der echten Arbeit besser zu werden. Mein Lieblingspapier ist „Representation Learning with Contrastive Predictive Coding“ von van der Oord aus dem Jahr 2019, das eine unbeaufsichtigte Vortrainingsaufgabe und dann überwachtes Training an einer kleinen Teilmenge von Labels verwendet, um replikbeschriftete Genauigkeitsergebnisse für alle Daten zu erzielen und zu diskutieren Diese Verbesserung ist aus Sicht der Dateneffizienz von Vorteil. Ich habe diese Ergebnisse reproduziert und in meiner Arbeit verwendet, wodurch ich Zeit und Geld gespart habe. Allein aufgrund dieser Arbeit bin ich bereit, seine Doktorandin zu werden.

Allerdings schlug OpenAI in der Arbeit „Language Models are Few-Shot Learners“ ein größeres Transformatormodell GPT-3 vor, das fast viertausend Zitate und den NeurIPS 2020 Best Paper Award erhielt und auch die Aufmerksamkeit aller Medien auf sich zog.

Das obige ist der detaillierte Inhalt vonAls die Forschung in Frage gestellt wurde, antwortete Jeff Dean: „Wir haben nicht versucht, neues SOTA zu bekommen, und auch die Kostenberechnung war falsch.'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr