Heim >Technologie-Peripheriegeräte >KI >Mithilfe von KI nach dem Holocaust getrennte Verwandte finden! Google-Ingenieure entwickeln ein Gesichtserkennungsprogramm, das mehr als 700.000 alte Fotos aus dem Zweiten Weltkrieg identifizieren kann

Mithilfe von KI nach dem Holocaust getrennte Verwandte finden! Google-Ingenieure entwickeln ein Gesichtserkennungsprogramm, das mehr als 700.000 alte Fotos aus dem Zweiten Weltkrieg identifizieren kann

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-08 16:21:061885Durchsuche

Haben sich im Bereich der KI-Gesichtserkennung neue Geschäftsfelder ergeben?

Dieses Mal geht es darum, Gesichter auf alten Fotos aus dem Zweiten Weltkrieg zu identifizieren.

Kürzlich hat Daniel Patt, ein Softwareentwickler von Google, eine KI-Gesichtserkennungstechnologie namens N2N (Numbers to Names) entwickelt, die Fotos von Europa vor dem Zweiten Weltkrieg und dem Holocaust identifizieren und sie mit modernen vernetzten Menschen vergleichen kann.

Mit KI längst verlorene Verwandte finden

Als Pat 2016 das Gedenkmuseum der polnischen Juden in Warschau besuchte, kam ihm eine Idee.

Könnten diese seltsamen Gesichter blutsverwandt mit ihm sein?

Drei seiner Großeltern waren Holocaust-Überlebende aus Polen, und er wollte seiner Großmutter helfen, ihre Familienmitglieder zu finden, die auf den Fotos der Nazis getötet wurden.

Während des Zweiten Weltkriegs wurden viele von ihnen aufgrund der großen Zahl polnischer Juden, die in verschiedenen Konzentrationslagern inhaftiert waren, vermisst.

Allein auf einem vergilbten Foto ist es schwierig, das Gesicht darauf zu erkennen, geschweige denn, Ihre verlorenen Verwandten zu finden.

Also kehrte er nach Hause zurück und setzte diese Idee sofort in die Realität um.

Die ursprüngliche Idee dieser Software besteht darin, Bildinformationen von Gesichtern über eine Datenbank zu sammeln und mithilfe von Algorithmen der künstlichen Intelligenz dabei zu helfen, die zehn besten Optionen mit der höchsten Ähnlichkeit abzugleichen.

Die meisten Bilddaten stammen vom US Holocaust Memorial Museum, und es gibt mehr als eine Million Bilder aus Datenbanken im ganzen Land.

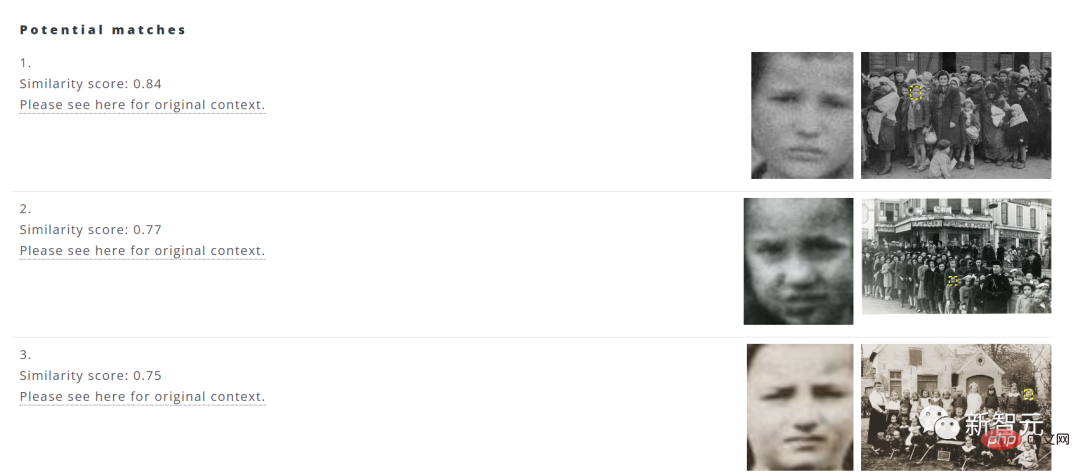

Benutzer müssen nur das Bild in der Computerdatei auswählen, auf „Hochladen“ klicken und das System filtert automatisch die zehn besten Optionen mit den am besten passenden Bildern heraus.

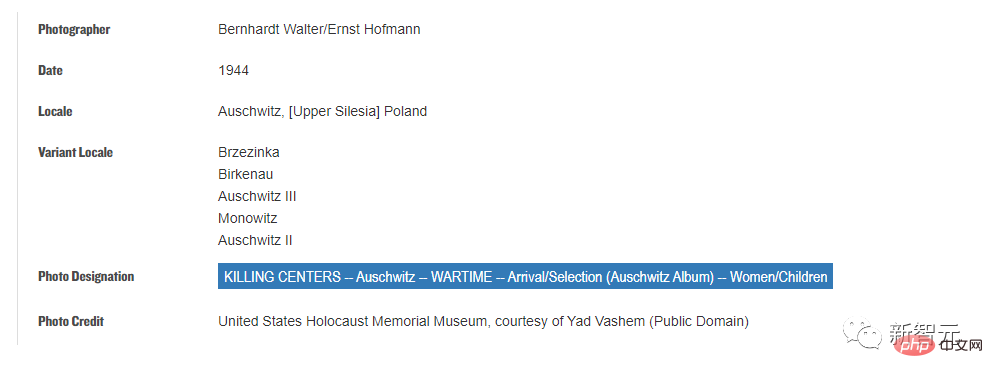

Darüber hinaus können Benutzer auch auf die Quelladresse klicken, um das Jahr, den Ort, die Sammlung und andere Informationen des Bildes anzuzeigen.

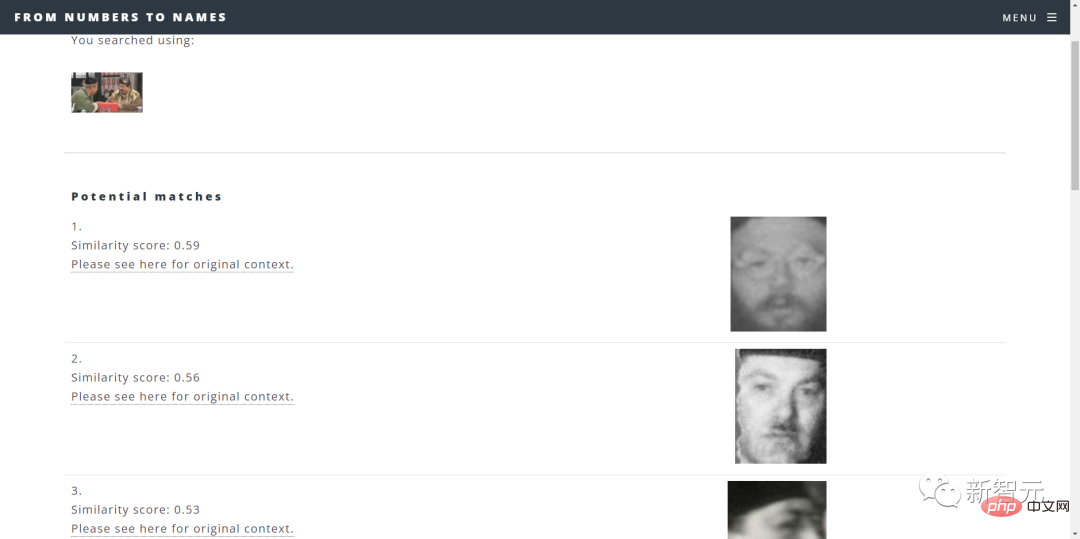

Ein Nachteil ist, dass die Suchergebnisse bei der Eingabe moderner Bilder von Menschen möglicherweise unverschämt ausfallen.

Ist das das Ergebnis? (Schwarzes Fragezeichen)

Kurz gesagt, die Systemfunktionen müssen noch verbessert werden.

Darüber hinaus arbeitet Patt auch mit anderen Teams aus Softwareentwicklern und Datenwissenschaftlern bei Google zusammen, um den Umfang und die Genauigkeit der Suchanfragen zu verbessern.

Aufgrund des Risikos eines Datenschutzverlusts im Gesichtserkennungssystem sagte Patt: „Wir nehmen keine Bewertung der Identität vor. Wir sind nur dafür verantwortlich, die Ergebnisse anhand von Ähnlichkeitswerten darzustellen und den Benutzern die Möglichkeit zu geben, ihre eigenen Urteile zu fällen.“

Entwicklung einer KI-Gesichtserkennungstechnologie

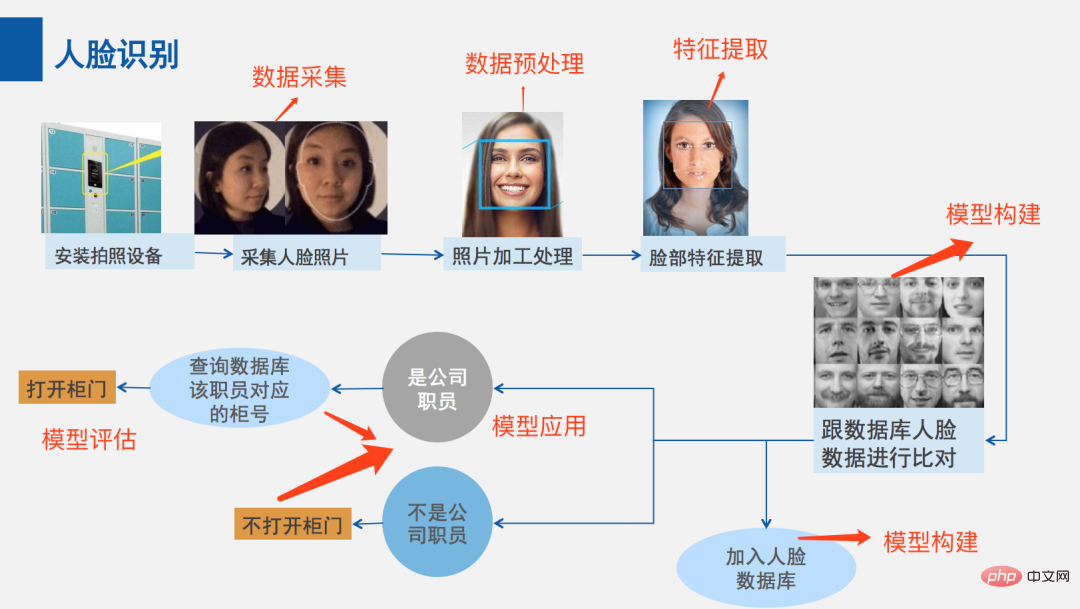

Wie erkennt diese Technologie also Gesichter?

Anfangs musste die Gesichtserkennungstechnologie damit beginnen, „wie man feststellt, ob es sich bei dem erkannten Bild um ein Gesicht handelt“.

Im Jahr 2001 schlugen die Computer-Vision-Forscher Paul Viola und Michael Jones ein Framework vor, um Gesichter in Echtzeit mit hoher Genauigkeit zu erkennen.

Dieses Framework kann anhand von Trainingsmodellen verstehen, „was ein Gesicht ist und was kein Gesicht ist“.

Nach dem Training extrahiert das Modell bestimmte Merkmale und speichert diese Merkmale dann in einer Datei, sodass Merkmale in neuen Bildern in verschiedenen Phasen mit zuvor gespeicherten Merkmalen verglichen werden können.

Um die Genauigkeit sicherzustellen, muss der Algorithmus auf „einem großen Datensatz mit Hunderttausenden positiven und negativen Bildern“ trainiert werden, was die Fähigkeit des Algorithmus verbessert, zu bestimmen, ob sich ein Gesicht auf einem Bild befindet und wo es sich befindet.

Wenn das untersuchte Bild jede Phase des Merkmalsvergleichs besteht, wurde ein Gesicht erkannt und Sie können fortfahren.

Obwohl das Viola-Jones-Framework für die Gesichtserkennung in Echtzeitanwendungen sehr genau ist, weist es gewisse Einschränkungen auf.

Zum Beispiel funktioniert der Rahmen möglicherweise nicht, wenn das Gesicht eine Maske trägt oder wenn ein Gesicht nicht richtig ausgerichtet ist.

Um die Mängel des Viola-Jones-Frameworks zu beseitigen und die Gesichtserkennung zu verbessern, entwickelten sie zusätzliche Algorithmen.

Zum Beispiel regionalbasierte Faltungs-Neuronale Netze (R-CNN) und Single-Shot-Detektoren (SSD), um den Prozess zu verbessern.

Convolutional Neural Network (CNN) ist ein künstliches neuronales Netzwerk zur Bilderkennung und -verarbeitung, das speziell für die Verarbeitung von Pixeldaten entwickelt wurde.

R-CNN generiert Regionsvorschläge auf einem CNN-Framework, um Objekte in Bildern zu lokalisieren und zu klassifizieren.

Während netzwerkbasierte Methoden für Regionsvorschläge wie R-CNN zwei Aufnahmen erfordern – eine zum Generieren von Regionsvorschlägen und eine weitere zum Erkennen jedes vorgeschlagenen Objekts – erfordert SSD nur eine Aufnahme, um Objekte im Bild mehrerer Objekte zu erkennen. Daher ist SSD deutlich schneller als R-CNN.

In den letzten Jahren sind die Vorteile der Gesichtserkennungstechnologie, die auf Deep-Learning-Modellen basiert, deutlich besser als bei herkömmlichen Computer-Vision-Methoden.

Bei der frühen Gesichtserkennung wurden hauptsächlich herkömmliche Algorithmen für maschinelles Lernen verwendet, und die Forschung konzentrierte sich mehr darauf, wie man differenziertere Merkmale extrahiert und Gesichter effektiver ausrichtet.

Mit der Vertiefung der Forschung hat die Leistungsverbesserung der Gesichtserkennung herkömmlicher Algorithmen für maschinelles Lernen auf zweidimensionalen Bildern allmählich einen Engpass erreicht.

Menschen begannen, das Problem der Gesichtserkennung in Videos zu untersuchen oder mit dreidimensionalen Modellmethoden zu kombinieren, um die Leistung der Gesichtserkennung weiter zu verbessern, während einige Wissenschaftler begannen, das Problem der dreidimensionalen Gesichtserkennung zu untersuchen.

In der berühmtesten öffentlichen Bibliothek von LFW hat der Deep-Learning-Algorithmus den Engpass herkömmlicher Algorithmen für maschinelles Lernen bei der Gesichtserkennungsleistung auf zweidimensionalen Bildern durchbrochen und die Erkennungsrate erstmals auf über 97 % erhöht.

Das heißt, es wird das „vom CNN-Netzwerk erstellte hochdimensionale Modell“ verwendet, um effektive Identifikationsmerkmale direkt aus dem eingegebenen Gesichtsbild zu extrahieren und den Kosinusabstand für die Gesichtserkennung direkt zu berechnen.

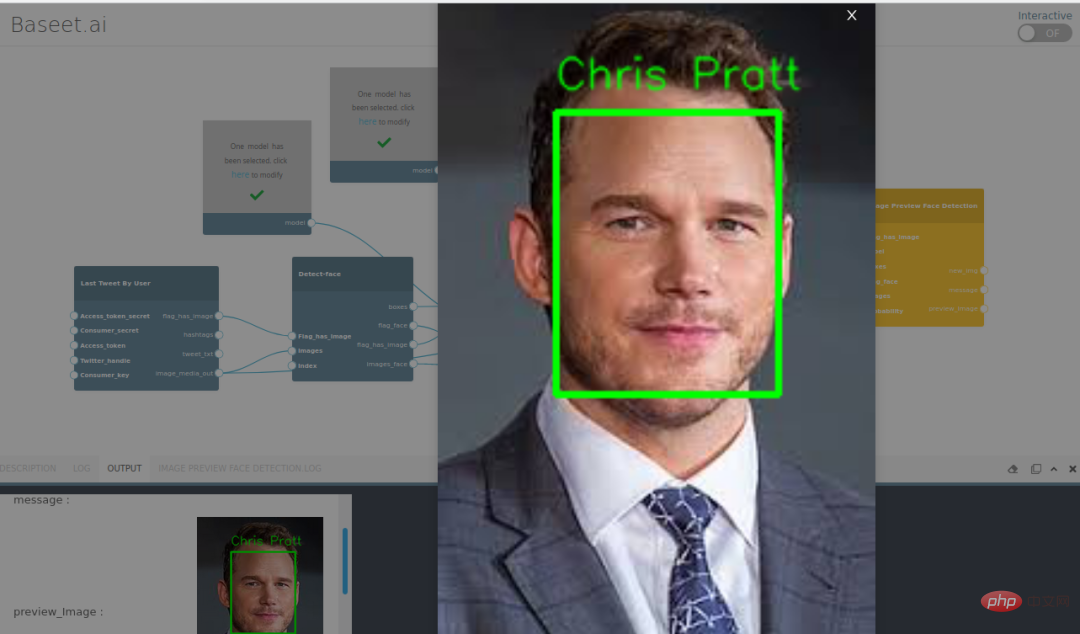

Die Gesichtserkennung hat sich von grundlegenden Computer-Vision-Techniken über Fortschritte im maschinellen Lernen (ML) bis hin zu immer komplexeren künstlichen neuronalen Netzen (ANN) und verwandten Techniken weiterentwickelt, was zu kontinuierlichen Leistungsverbesserungen geführt hat.

Jetzt spielt es eine wichtige Rolle als erster Schritt in vielen kritischen Anwendungen – einschließlich Gesichtsverfolgung, Gesichtsanalyse und Gesichtserkennung.

Während des Zweiten Weltkriegs erlitt auch China das Kriegstrauma und viele der Menschen auf den damaligen Fotos waren nicht mehr identifizierbar.

Menschen, deren Großelterngeneration unter Kriegstraumata gelitten hat, haben viele Verwandte und Freunde, deren Aufenthaltsort unbekannt ist.

Die Entwicklung dieser Technologie kann den Menschen helfen, die staubigen Jahre aufzudecken und etwas Trost für die Menschen in der Vergangenheit zu finden.

Referenz: https://www.timesofisrael.com/google-engineer-identify-anonymous-faces-in-wwii-photos-with-ai-facial-recognition/

Das obige ist der detaillierte Inhalt vonMithilfe von KI nach dem Holocaust getrennte Verwandte finden! Google-Ingenieure entwickeln ein Gesichtserkennungsprogramm, das mehr als 700.000 alte Fotos aus dem Zweiten Weltkrieg identifizieren kann. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr