Heim >Technologie-Peripheriegeräte >KI >Sprechen wir über Bilderkennung: Recurrent Neural Network

Sprechen wir über Bilderkennung: Recurrent Neural Network

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-08 15:11:031703Durchsuche

Dieser Artikel stammt aus dem öffentlichen WeChat-Konto „Leben im Informationszeitalter“. Der Autor lebt im Informationszeitalter. Um diesen Artikel erneut zu drucken, wenden Sie sich bitte an das öffentliche Konto „Living in the Information Age“.

Recurrent Neural Network (RNN) wird hauptsächlich zur Lösung von Sequenzdatenproblemen verwendet. Der Grund dafür, dass es sich um ein rekurrentes neuronales Netzwerk handelt, liegt darin, dass die aktuelle Ausgabe einer Sequenz auch mit der vorherigen Ausgabe zusammenhängt. Das RNN-Netzwerk merkt sich Informationen aus früheren Momenten und wendet sie auf die aktuelle Ausgabeberechnung an. Im Gegensatz zum Faltungs-Neuronalen Netzwerk sind die Neuronen in den verborgenen Schichten des wiederkehrenden Neuronalen Netzwerks miteinander verbunden bestimmt durch die Eingabe. Die Ausgabe der Schicht setzt sich aus der Ausgabe der verborgenen Neuronen im vorherigen Moment zusammen. Obwohl das RNN-Netzwerk einige bemerkenswerte Ergebnisse erzielt hat, weist es einige Mängel und Einschränkungen auf, wie z. B. Schwierigkeiten beim Training, geringe Genauigkeit, geringe Effizienz, lange Zeit usw. Daher wurden nach und nach einige verbesserte Netzwerkmodelle auf Basis von RNN entwickelt, z als: Long Short-Term Memory (LSTM), bidirektionales RNN, bidirektionales LSTM, GRU usw. Diese verbesserten RNN-Modelle haben hervorragende Ergebnisse im Bereich der Bilderkennung gezeigt und sind weit verbreitet. Am Beispiel des LSTM-Netzwerks stellen wir seine Hauptnetzwerkstruktur vor.

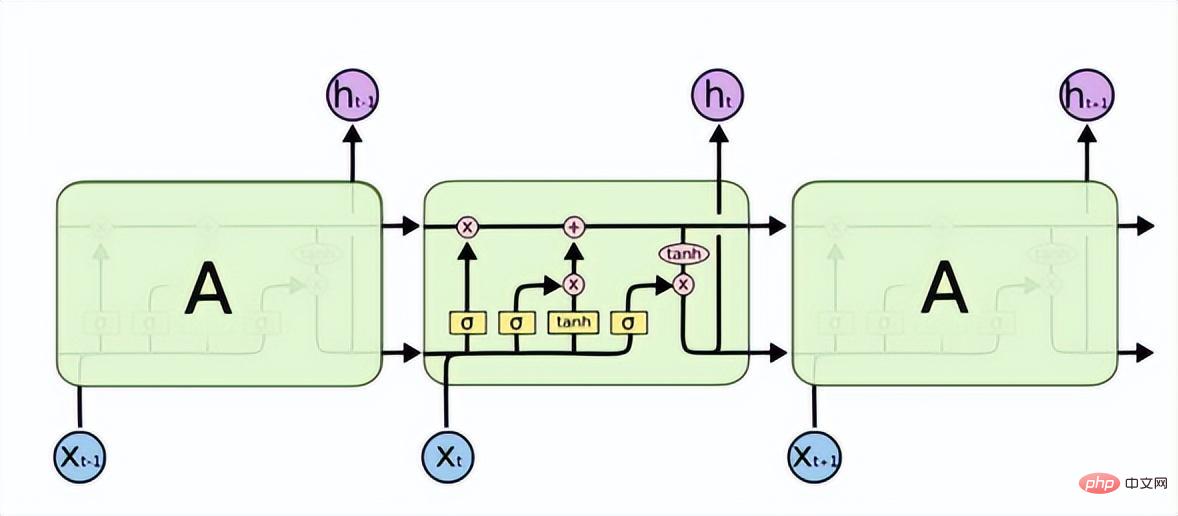

Long Short-Term Memory (LSTM) löst die Probleme des Gradientenverschwindens oder der Gradientenexplosion in RNN und kann Langzeitabhängigkeitsprobleme lernen. Seine Struktur ist wie folgt.

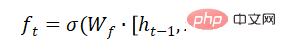

LSTM verfügt über drei Tore zur selektiven Weitergabe von Informationen: Vergessenstor, Eingangstor und Ausgangstor. Das Vergessenstor bestimmt, welche Informationen diese Zelle passieren können. Es wird durch eine sigmoidale neuronale Schicht implementiert. Seine Eingabe ist und die Ausgabe ist ein Vektor mit einem Wert zwischen (0, 1), der den Anteil jedes Teils der Informationen darstellt, der durchgelassen wird. 0 bedeutet „keine Informationen passieren lassen“, 1 bedeutet „alle Informationen passieren lassen“.

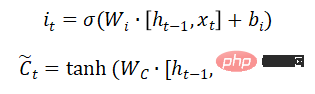

Das Eingabegatter bestimmt, wie viele neue Informationen dem Zellzustand hinzugefügt werden. Eine Tanh-Schicht generiert einen Vektor, der den alternativen Inhalt für die Aktualisierung darstellt.

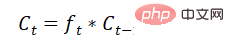

Zellstatus aktualisieren:

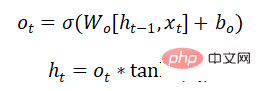

Welcher Teil der Informationen in der Ausgabe-Gate-Entscheidung wird ausgegeben:

Das GRU-Netzwerkmodell löst auch das Problem des Verschwindens von Gradienten oder Gradienten in RNN-Problemen wie Explosionen können langfristige Abhängigkeiten erlernen. Es handelt sich um eine Deformation von LSTM. Die Struktur ist einfacher als LSTM, hat weniger Parameter und die Trainingszeit ist auch kürzer als LSTM. Es wird auch häufig in der Spracherkennung, Bildbeschreibung, Verarbeitung natürlicher Sprache und anderen Szenarien eingesetzt.

Das obige ist der detaillierte Inhalt vonSprechen wir über Bilderkennung: Recurrent Neural Network. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr