Heim >Technologie-Peripheriegeräte >KI >Hacker nutzen KI-Technologie, um sich auf Stellen zu bewerben. Sicherheitsprobleme mit künstlicher Intelligenz können nicht ignoriert werden

Hacker nutzen KI-Technologie, um sich auf Stellen zu bewerben. Sicherheitsprobleme mit künstlicher Intelligenz können nicht ignoriert werden

- PHPznach vorne

- 2023-04-08 14:51:141342Durchsuche

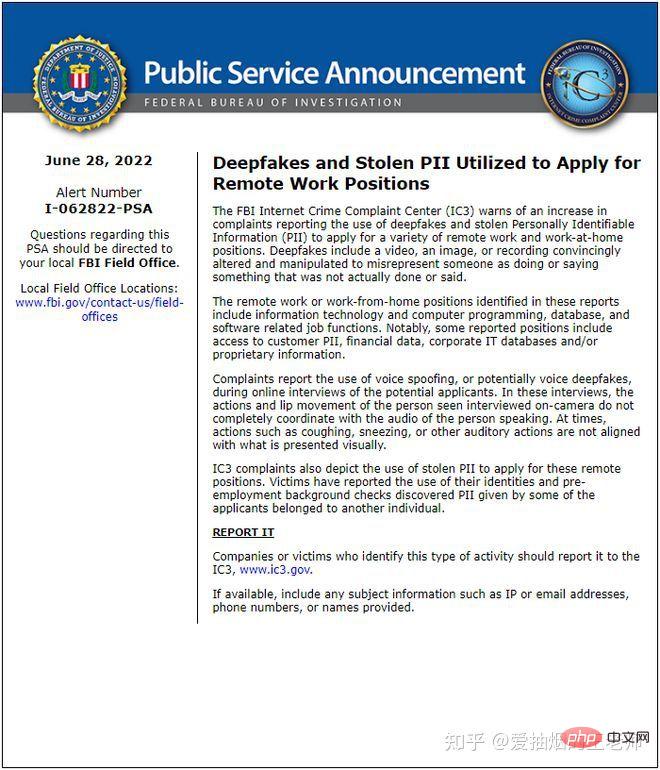

Nach der Epidemie in den Vereinigten Staaten haben viele Unternehmen das „Work From Home“ (WFH)-Modell übernommen. Das Crime Complaint Center des FBI gab an, dass es kürzlich Beschwerden von vielen Arbeitgebern erhalten habe, dass Bewerber während des Einstellungsprozesses die Identitäten anderer gestohlen und Deepfake-Technologie genutzt hätten, um an Remote-Interviews teilzunehmen.

Diese Stellen umfassen Informationstechnologie, Computerprogramme, Datenbanken und softwarebezogene Bereiche. Einige Arbeitssuchende versuchen, den Hintergrund und das Fachwissen anderer zu nutzen, um Jobs zu bekommen, und nutzen Deepfake-Technologie, um Videos zu fälschen.

Sie stellten fest, dass bei der Durchführung von Online-Interviews mit Arbeitssuchenden die Bewegungen des Arbeitssuchenden oder das Öffnen und Schließen seiner Lippen nicht mit seiner Sprechstimme übereinstimmten. Wenn beispielsweise Nies- oder Hustengeräusche auftraten, waren die Bilder nicht synchronisiert.

Als sie Hintergrundüberprüfungen dieser Arbeitssuchenden durchführten, stellten sie fest, dass einige Arbeitssuchende tatsächlich die Identität anderer Personen nutzten, um einen Job zu finden. Wenn Sie nur auf der Suche nach einem Job sind, ist das immer noch ein kleines Problem, aber wenn es sich um einen Hacker handelt, kann er nach erfolgreicher Vertragsunterzeichnung erfolgreich in das Unternehmen eindringen und Zugriff auf vertrauliche Daten erhalten.

Sind Sie auch neugierig, ist diese Software so einfach zu bedienen?

Die Antwort ist, es ist tatsächlich sehr fortgeschritten.

Deepfake nutzt die leistungsstarke Bildgenerierungsfunktion des Generative Adversarial Network (GAN), das jedes vorhandene Bild und Video mit dem Quellbild und -video kombinieren und die Details des Gesichts einer Person aufzeichnen kann. Nach Jahren der Entwicklung ist die Deepfake-Technologie nun in der Lage, Gesichtsveränderungen in Echtzeit durchzuführen, ohne dass es zu einem Verstoß kommt.

Bei Videos ist es für Deepfakes jedoch schwierig, Gesichtsausdrücke mit hoher Sicherheit zu animieren. Die Personen im Video blinzeln entweder nie oder zu häufig oder unnatürlich. Darüber hinaus stimmen Ton und Dummy-Bilder nicht natürlich genug überein.

Wenn diese Art von Video also 10 Sekunden dauert, wird es die Leute misstrauisch machen. Der gesamte Interviewprozess wird länger dauern und es wird einfacher sein, Fehler aufzudecken.

Fortschritt und Wandel in Wissenschaft und Technologie sind ein zweischneidiges Schwert.

Obwohl die Technologie der künstlichen Intelligenz uns enorme Annehmlichkeiten bietet, kann sie auch eine Reihe von Problemen wie Sicherheit, Ethik und Datenschutz mit sich bringen.

Der Kern der Entwicklung künstlicher Intelligenz besteht darin, Algorithmen, Rechenleistung und Daten zu nutzen, um deterministische Probleme in vollständigen Informationen und strukturierten Umgebungen zu lösen. Im Zeitalter der Datenunterstützung ist künstliche Intelligenz vielen Sicherheitsrisiken ausgesetzt.

Zuallererst kann es zu Vergiftungsangriffen kommen.

Das heißt, Hacker schleusen bösartige Daten ein, um die Zuverlässigkeit und Genauigkeit des KI-Systems zu verringern, was zu Entscheidungsfehlern bei der künstlichen Intelligenz führt. Das Hinzufügen gefälschter Daten, bösartiger Proben usw. zu den Trainingsdaten zerstört die Integrität der Daten, was zu Abweichungen bei der Entscheidungsfindung des trainierten Algorithmusmodells führt.

Wenn ein solcher Vorgang im Bereich des autonomen Fahrens eingesetzt wird, ist es wahrscheinlich, dass das Fahrzeug gegen die Verkehrsregeln verstößt und sogar einen Verkehrsunfall verursacht.

Zweitens wird es das Problem der Datenlecks geben.

Umgekehrte Angriffe können zu Datenlecks innerhalb des Algorithmusmodells führen. Heutzutage sind verschiedene intelligente Geräte wie intelligente Armbänder, biometrische Identifikationssysteme für intelligente Lautsprecher und intelligente medizinische Systeme weit verbreitet und persönliche Informationen werden in alle Richtungen gesammelt. Diese Informationen, darunter Gesichter, Fingerabdrücke, Stimmabdrücke, Iris, Herzschläge, Gene usw., sind einzigartig und unveränderlich. Wenn sie einmal durchsickern oder missbraucht werden, kann dies schwerwiegende Folgen haben.

Es wurde beispielsweise aufgedeckt, dass eine große Anzahl von Gesichtsfotos, die von einer großen Anzahl inländischer Geschäfte ohne Zustimmung des Benutzers gesammelt wurden, durchgesickert sind. Diese Gesichtsfotos wurden mehr oder weniger auf schwarzen Produkten durchgesickert, und es wird Betrug oder Betrug vorliegen Betrug. Risiken für die finanzielle Sicherheit.

Wieder einmal werden Sie Netzwerkrisiken ausgesetzt sein.

Künstliche Intelligenz wird unweigerlich Netzwerkverbindungen einführen, und die Technologie der künstlichen Intelligenz selbst kann auch den Intelligenzgrad von Netzwerkangriffen verbessern und dann intelligente Datendiebstahl- und Datenerpressungsangriffe durchführen oder automatisch eine große Menge falscher Bedrohungsinformationen generieren, um sie anzugreifen Analysesystem.

Zu den wichtigsten Angriffsmethoden gehören: Bypass-Angriffe, Inferenzangriffe, Backdoor-Angriffe, Modellextraktionsangriffe, Attributionsinferenzangriffe, Trojaner-Angriffe, Modellumkehrangriffe, Anti-Wasserzeichen-Angriffe und Neuprogrammierungsangriffe.

Wir müssen uns klar darüber im Klaren sein, dass die Datensicherheit im Zeitalter der künstlichen Intelligenz auch vor vielen neuen Herausforderungen steht. Der Schutz der Datensicherheit und der Algorithmensicherheit hat für Unternehmen höchste Priorität.

Das obige ist der detaillierte Inhalt vonHacker nutzen KI-Technologie, um sich auf Stellen zu bewerben. Sicherheitsprobleme mit künstlicher Intelligenz können nicht ignoriert werden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr