Heim >Technologie-Peripheriegeräte >KI >In der künstlichen Intelligenz passieren große Dinge, und auch LeCun hat sich verändert

In der künstlichen Intelligenz passieren große Dinge, und auch LeCun hat sich verändert

- 王林nach vorne

- 2023-04-08 13:11:131614Durchsuche

Die Symbolverarbeitung ist ein allgemeiner Prozess in der Logik, Mathematik und Informatik, der das Denken als algebraische Operationen behandelt. Die grundlegendste Debatte im Bereich der künstlichen Intelligenz ist seit fast 70 Jahren die Frage, ob künstliche Intelligenzsysteme auf symbolischer Verarbeitung oder auf neuronalen Systemen ähnlich dem menschlichen Gehirn basieren sollten.

Es gibt tatsächlich noch eine dritte Möglichkeit als Mittelweg – ein Hybridmodell. Hybridmodelle versuchen, das Beste aus beiden Welten herauszuholen, indem sie das datengesteuerte Lernen neuronaler Netze mit den leistungsstarken Abstraktionsfähigkeiten der symbolischen Verarbeitung kombinieren. Hier habe ich auch die meiste Zeit meiner Karriere gearbeitet.

In einem kürzlich im NOEMA-Magazin veröffentlichten Artikel beteiligten sich auch Yann LeCun, Gewinner des Turing-Preises und Chefwissenschaftler für künstliche Intelligenz bei Meta, und Jacob Browning, der „residente Philosoph“ des LeCun Lab, an dieser Kontroverse. Der Artikel scheint eine neue Alternative zu bieten, doch bei näherer Betrachtung zeigt sich, dass seine Ideen weder neu noch überzeugend sind.

Yann LeCun und Jacob Browning reagierten in einem im NOEMA-Magazin veröffentlichten Artikel zum ersten Mal offiziell auf die Ansicht, dass „Deep Learning an eine Wand gestoßen ist“ und erklärten: „Von Anfang an glaubten Kritiker voreilig, dass neuronale Netze dies getan hätten.“ stießen auf ein unüberwindbares Problem, das sich jedoch jedes Mal als nur vorübergehendes Hindernis erwies Netzwerke und symbolische Verarbeitung. Aber am Ende erkannte LeCun in vielen Worten ungewöhnlicherweise an, dass hybride Systeme existieren – dass sie wichtig sind, dass sie ein möglicher Weg nach vorne sind und dass wir das schon immer wussten. Der Artikel selbst ist widersprüchlich.

Was den Grund für diesen Widerspruch angeht, fällt mir nur ein, dass LeCun und Browning irgendwie glauben, dass Modelle, die symbolische Verarbeitung lernen, keine Hybridmodelle sind. Aber Lernen ist ein sich entwickelndes Problem (wie entstehen Systeme?), und wie entwickelte Systeme funktionieren (mit einem oder zwei Mechanismen), ist ein Rechenproblem: Ein System, das sowohl symbolische als auch neuronale Netzwerkmechanismen nutzt, ist nach vernünftigem Ermessen ein Hybridsystem . (Vielleicht meinen sie wirklich, dass KI eher ein erlernter Hybrid als ein angeborener Hybrid ist. Aber ein erlernter Hybrid ist immer noch ein Hybrid.)

Um 2010 galt symbolische Verarbeitung von Befürwortern des Deep Learning als schlechtes Wort; Das Verständnis der Ursprünge der symbolischen Verarbeitung ist zu einer obersten Priorität geworden.

Ich denke, die Symbolverarbeitung ist entweder angeboren oder etwas anderes trägt indirekt zum Erwerb der Symbolverarbeitung bei. Je früher wir herausfinden, welche Grundlagen es Systemen ermöglichen, symbolische Abstraktionen zu lernen, desto eher können wir Systeme aufbauen, die das gesamte Wissen der Welt angemessen nutzen, und desto schneller werden die Systeme sicherer, vertrauenswürdiger und erklärbarer.

Allerdings müssen wir zunächst die Einzelheiten dieser wichtigen Debatte in der Geschichte der Entwicklung künstlicher Intelligenz verstehen.

Die frühen KI-Pioniere Marvin Minsky und John McCarthy glaubten, dass die symbolische Verarbeitung der einzig vernünftige Weg nach vorne sei, während der Neuronale-Netzwerk-Pionier Frank Rosenblatt glaubte, dass KI besser auf neuronenähnlichen Sammlungen von „Knoten“ aufbauen würde, die Daten strukturell verarbeiten können. um die schwere Arbeit mit Statistiken zu erledigen.

Diese beiden Möglichkeiten schließen sich nicht gegenseitig aus. Das in der künstlichen Intelligenz verwendete „neuronale Netzwerk“ ist kein buchstäbliches biologisches Neuronennetzwerk. Stattdessen handelt es sich um ein vereinfachtes digitales Modell, das eine gewisse Ähnlichkeit mit einem tatsächlichen biologischen Gehirn aufweist, jedoch nur eine minimale Komplexität aufweist. Im Prinzip könnten diese abstrakten Neuronen auf viele verschiedene Arten verbunden werden, von denen einige direkt eine logische und symbolische Verarbeitung ermöglichen könnten. Diese Möglichkeit wurde bereits 1943 in einer der frühesten Arbeiten auf diesem Gebiet, „A Logical Calculus of the Ideas Inmanent in Nervous Activity“, ausdrücklich anerkannt.

Frank Rosenblatt schlug in den 1950er Jahren sowie David Rumelhart und Jay McClelland in den 1980er Jahren neuronale Netze als Alternative zur Symbolverarbeitung vor, eine Position, die allgemein von Geoffrey Hinton unterstützt wurde.

Die wenig bekannte Geschichte hier ist, dass LeCun, Hinton und Yoshua Bengio Anfang der 2010er Jahre so begeistert von diesen mehrschichtigen neuronalen Netzen waren, die endlich praktisch wurden, dass sie die Symbolverarbeitung vollständig abschaffen wollten. Im Jahr 2015 befand sich Deep Learning noch in einer unbeschwerten, enthusiastischen Ära, und LeCun, Bengio und Hinton schrieben in Nature ein Manifest über Deep Learning. Der Artikel endet mit einem Angriff auf Symbole und argumentiert, dass „neue Paradigmen erforderlich sind, um regelbasierte Operationen an symbolischen Ausdrücken durch Operationen an großen Vektoren zu ersetzen.“

Tatsächlich war Hinton so überzeugt, dass die Symbolverarbeitung eine Sackgasse sei, dass er im selben Jahr an der Stanford University eine Vorlesung mit dem Titel „Aetherial Symbols“ hielt und dabei Symbole mit einem der größten Fehler in der Geschichte der Wissenschaft verglich.

In ähnlicher Weise vertraten Hintons Mitarbeiter Rumelhart und McClelland in den 1980er Jahren einen ähnlichen Standpunkt und argumentierten in einem Buch von 1986, dass Symbole nicht „die Essenz menschlicher Berechnungen“ seien.

Als ich 2018 einen Artikel zur Verteidigung der Symbolverarbeitung schrieb, bezeichnete LeCun meine Hybridsystemansicht auf Twitter als „größtenteils falsch“. Damals verglich Hinton meine Arbeit auch mit der Zeitverschwendung an einem „Benzinmotor“ und dass ein „Elektromotor“ der beste Weg nach vorne sei. Noch im November 2020 behauptete Hinton, dass „Deep Learning alles kann“.

Wenn LeCun und Browning nun ohne Ironie schreiben, dass „jeder, der sich mit Deep Learning beschäftigt, darin übereinstimmt, dass symbolische Verarbeitung ein notwendiges Merkmal für die Schaffung menschenähnlicher KI ist“, bringen sie jahrzehntelange Debatten auf den Kopf. Christopher Manning, Professor für künstliche Intelligenz an der Stanford University, sagte: „LeCuns Position hat sich etwas geändert.“

Offensichtlich ist der Ansatz von vor zehn Jahren nicht mehr anwendbar.

In den 2010er Jahren behaupteten viele in der Community des maschinellen Lernens (ohne wirkliche Beweise), dass „Symbole biologisch unglaubwürdig“ seien. Zehn Jahre später dachte LeCun über einen neuen Ansatz nach, der die Verarbeitung von Symbolen beinhalten würde, sei es angeboren oder erlernt. Die neue Ansicht von LeCun und Browning, dass die symbolische Verarbeitung von entscheidender Bedeutung ist, stellt ein großes Zugeständnis für den Bereich des Deep Learning dar.

Historiker der künstlichen Intelligenz sollten den Artikel im NOEMA-Magazin als einen wichtigen Wendepunkt betrachten, in dem LeCun, einer des Deep-Learning-Trios, als erster die Unvermeidlichkeit hybrider KI direkt anerkannte.

Es ist erwähnenswert, dass Anfang des Jahres zwei weitere Mitglieder der Deep Learning Big Three ebenfalls ihre Unterstützung für hybride KI-Systeme zum Ausdruck gebracht haben. Auch der Informatiker Andrew Ng und der LSTM-Mitbegründer Sepp Hochreiter haben ihre Unterstützung für solche Systeme zum Ausdruck gebracht. Jürgen Schmidhubers KI-Unternehmen NNAISANCE forscht derzeit rund um die Kombination von symbolischer Verarbeitung und Deep Learning.

Der Rest des Artikels von LeCun und Browning kann grob in drei Teile unterteilt werden:

- Eine Fehlcharakterisierung meiner Position;

- Ein Versuch, den Umfang des Hybridmodells einzugrenzen;

- Eine Diskussion darüber, warum symbolische Verarbeitung eher erlernt wird als Nicht angeboren.

Zum Beispiel sagen LeCun und Browning: „Marcus glaubt, dass man es nie haben wird, wenn man am Anfang keine symbolische Manipulation hat. Tatsächlich habe ich es in meinem Buch von 2001 deutlich gemacht.“ „Der algebraische Geist“: Wir sind nicht sicher, ob symbolische Verarbeitung angeboren ist.

Sie sagten auch, dass ich „keine weiteren Fortschritte“ beim Deep Learning erwarte, und mein eigentlicher Punkt war nicht, dass es bei irgendeinem Problem keine weiteren Fortschritte geben wird, sondern dass Deep Learning für bestimmte Aufgaben (z. B. kombinatorische Probleme, kausale Probleme) ist selbst das falsche Werkzeug zur Begründung von Problemen.

Sie sagten auch, dass ich denke, dass „symbolisches Denken für ein Modell alles oder nichts ist, weil DALL-E keine Symbole und logischen Regeln als Grundlage seiner Verarbeitung verwendet, es nicht wirklich mit Symbolen argumentiert“, und ich so etwas habe ich nicht gesagt. DALL·E argumentiert nicht mit Symbolen, aber das bedeutet nicht, dass jedes System, das symbolisches Denken enthält, alles oder nichts sein muss. Zumindest bereits in den 1970er Jahren gab es im Expertensystem MYCIN rein symbolische Systeme, die alle Arten quantitativer Argumentation durchführen konnten.

Neben der Annahme, dass „ein Modell, das gelernte Symbole enthält, kein Hybridmodell ist“, versuchen sie auch, ein Hybridmodell mit „einem Modell, das einen nicht differenzierbaren Symbolprozessor enthält“ gleichzusetzen. Sie denken, ich setze Hybridmodelle mit „einer einfachen Kombination aus zwei Dingen gleich: dem Einfügen eines fest codierten symbolischen Verarbeitungsmoduls zusätzlich zu einem Mustervervollständigungs-Deep-Learning-Modul.“ Das ist tatsächlich jedem klar, der tatsächlich an neuronalen symbolischen Modellen arbeitet dass die Aufgabe nicht so einfach ist.

Stattdessen geht es, wie wir alle wissen, um die richtige Art und Weise, Hybridsysteme aufzubauen. Für die Kombination symbolischer und neuronaler Netze wurden viele verschiedene Methoden in Betracht gezogen, wobei der Schwerpunkt auf Techniken wie dem Extrahieren symbolischer Regeln aus neuronalen Netzen, der direkten Umwandlung symbolischer Regeln in neuronale Netze und dem Aufbau von Zwischensystemen lag, die die Weitergabe von Informationen zwischen neuronalen Netzen und symbolischen Systemen ermöglichen. und das neuronale Netzwerk selbst rekonstruieren. Viele Wege werden erkundet.

Schließlich schauen wir uns die wichtigste Frage an: Kann die Symbolverarbeitung erlernt werden, ohne sie von Anfang an einbauen zu müssen?

Meine Antwort ist klar: Natürlich. Soweit ich weiß, bestreitet niemand, dass symbolische Verarbeitung erlernt werden kann. Ich habe diese Frage 2001 in Abschnitt 6.1 von Algebraic Thinking beantwortet, und obwohl ich es für unwahrscheinlich hielt, sagte ich nicht, dass es absolut unmöglich sei. Im Gegenteil, meine Schlussfolgerung lautet: „Diese Experimente und Theorien garantieren sicherlich nicht, dass die Fähigkeit, Symbole zu verarbeiten, angeboren sind, aber sie entsprechen dieser Ansicht.“

Zusammenfassend umfasst meine Sichtweise die folgenden zwei Teile:

Die erste ist die Perspektive der „Lernbarkeit“: Im gesamten algebraischen Denken zeige ich, dass bestimmte Arten von Systemen (im Grunde die Vorläufer der heutigen tieferen Systeme) Aspekte der Symbolverarbeitung nicht erlernen konnten. Daher gibt es keine Garantie dafür, dass irgendein System dazu in der Lage sein wird symbolische Verarbeitung zu erlernen. Wie die ursprünglichen Worte in meinem Buch sagen:

Manche Dinge müssen angeboren sein. Aber es gibt keinen wirklichen Konflikt zwischen „Natur“ und „Erziehung“. Die Natur bietet eine Reihe von Mechanismen, die es uns ermöglichen, mit unserer Umwelt zu interagieren, eine Reihe von Werkzeugen, um Wissen aus der Welt zu extrahieren, und eine Reihe von Werkzeugen, um dieses Wissen zu nutzen. Ohne einige angeborene Lernwerkzeuge würden wir überhaupt nicht lernen.

Die Entwicklungspsychologin Elizabeth Spelke sagte einmal: „Ich denke, ein System mit einem eingebauten Ausgangspunkt (wie Objekten, Sets, Geräten zur symbolischen Verarbeitung usw.) wird beim Verständnis der Welt effektiver sein als ein reines.“ leeres Blatt.“ Tatsächlich veranschaulicht LeCuns berühmtestes Werk über Faltungs-Neuronale Netze diesen Punkt.

Der zweite Punkt ist, dass menschliche Säuglinge einige Hinweise auf symbolische Verarbeitungsfähigkeiten aufweisen. In einer oft zitierten Reihe von Regellernexperimenten aus meinem Labor verallgemeinerten Kleinkinder eine Reihe abstrakter Muster, die über die spezifischen Beispiele hinausgingen, an denen sie trainiert wurden. Folgearbeiten zu den impliziten logischen Denkfähigkeiten menschlicher Säuglinge werden dies weiter bestätigen.

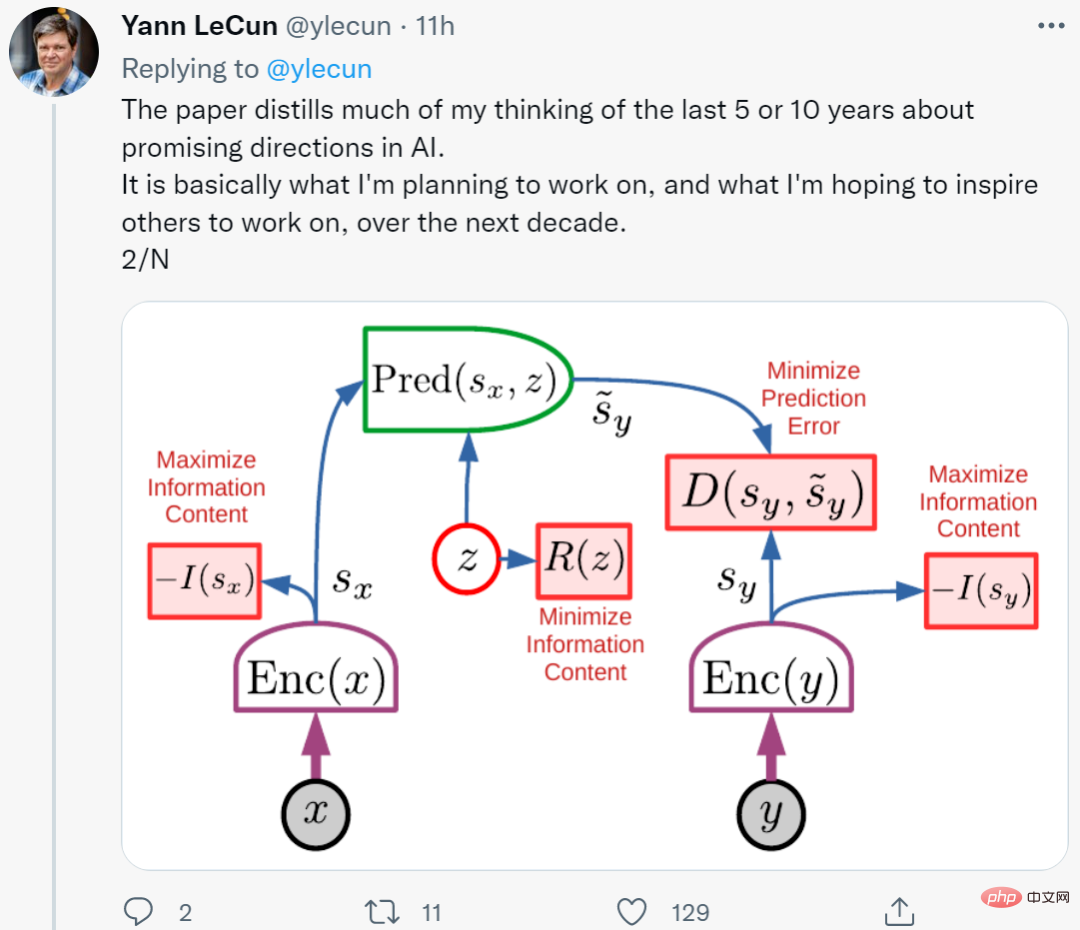

Leider gehen LeCun und Browning meinen beiden Punkten völlig aus dem Weg. Seltsamerweise setzen sie Lernsymbole stattdessen mit späteren Errungenschaften wie „Karten, bildliche Darstellungen, Rituale und sogar soziale Rollen“ gleich, offenbar ohne zu wissen, dass ich und mehrere andere Kognitionswissenschaftler aus der umfangreichen Literatur der Kognitionswissenschaft Gedanken über Babys, Kleinkinder, und nichtmenschliche Tiere. Wenn ein Lamm kurz nach der Geburt einen Hügel hinunterkriechen kann, warum kann ein neugeborenes neuronales Netzwerk dann nicht ein wenig symbolische Verarbeitung integrieren? Die Frage ist schließlich: Warum gehen LeCun und Browning dazu? Solche Längen, um gegen die Angeborenheit der Symbolverarbeitung zu argumentieren, liefern weder ein starkes prinzipielles Argument gegen die Angeborenheit, noch geben sie irgendwelche prinzipiellen Gründe an, um zu beweisen, dass die Symbolverarbeitung erworben wird „angeborene“ Symbolverarbeitung. Seine kürzlich vorgestellte neue Architektur besteht aus insgesamt sechs Modulen, von denen die meisten verstellbar, aber alle eingebaut sind.

Darüber hinaus geben LeCun und Browning nicht an, wie die bekannten spezifischen Probleme beim Sprachverstehen und -schlussfolgern gelöst werden können, da Sprachmodelle keine angeborenen Symbolverarbeitungsmechanismen haben. Im Gegenteil, sie verwenden lediglich das Induktionsprinzip, um die Rolle des Deep Learning zu erklären: „Da Deep Learning die Probleme von 1 bis N überwunden hat, sollten wir glauben, dass es das Problem von N+1 überwinden kann.“

Im Gegenteil, sie verwenden lediglich das Induktionsprinzip, um die Rolle des Deep Learning zu erklären: „Da Deep Learning die Probleme von 1 bis N überwunden hat, sollten wir glauben, dass es das Problem von N+1 überwinden kann.“

Diese Sichtweise ist sehr schwach. Worüber die Leute wirklich nachdenken und sie hinterfragen sollten, ist die Grenze des tiefen Lernens.

Zweitens gibt es einige starke konkrete Gründe, warum Deep Learning bereits vor prinzipiellen Herausforderungen steht, nämlich Kombinatorik, Systematisierung und Probleme beim Sprachverständnis. Diese Probleme beruhen auf „Generalisierung“ und „Verteilungsverschiebung“. Jeder auf diesem Gebiet erkennt mittlerweile, dass die Verteilungsverschiebung die Achillesferse aktueller neuronaler Netze ist. Dies ist auch die bahnbrechende Sichtweise der heutigen Deep-Learning-Systeme im algebraischen Denken.

Tatsächlich ist Deep Learning nur ein Teil des Baus intelligenter Maschinen. Bei solchen Techniken mangelt es an Methoden zur Charakterisierung von Kausalzusammenhängen (z. B. der Beziehung zwischen einer Krankheit und ihren Symptomen) und sie können bei der Erfassung abstrakter Konzepte Schwierigkeiten bereiten. Deep Learning verfügt über keine offensichtliche logische Argumentationsmethode und ist noch weit von der Integration abstrakten Wissens entfernt.

Natürlich hat Deep Learning große Fortschritte gemacht und ist gut in der Mustererkennung, aber bei einigen grundlegenden Problemen wie dem Denken sind noch keine ausreichenden Fortschritte zu verzeichnen, und das System ist immer noch sehr unzuverlässig.

Nehmen Sie als Beispiel das neue Modell Minerva, das von Google entwickelt wurde. Während des Trainings gibt es Milliarden von Token, aber es ist immer noch schwierig, das Problem der Multiplikation vierstelliger Zahlen zu lösen. Es erreichte eine Genauigkeit von 50 Prozent bei Mathematikprüfungen der High School, wurde jedoch als „große Verbesserung“ angepriesen. Daher ist es immer noch schwierig, ein System aufzubauen, das Argumentation und Abstraktion im Bereich Deep Learning beherrscht. Die aktuelle Schlussfolgerung lautet: Es gibt nicht nur ein Problem mit Deep Learning, sondern Deep Learning „hatte schon immer Probleme.“

Mir scheint, dass die Situation beim Umgang mit Symbolen wahrscheinlich die gleiche ist wie eh und je:

Unter dem Einfluss von 20 Jahren „algebraischem Denken“ können aktuelle Systeme symbolische Verarbeitung (wie Multiplikation) immer noch nicht zuverlässig extrahieren, selbst angesichts riesiger Datensätze und Schulungen. Das Beispiel menschlicher Säuglinge und Kleinkinder zeigt, dass Menschen vor der formalen Bildung in der Lage sind, komplexe Konzepte der natürlichen Sprache und des logischen Denkens (vermutlich symbolischer Natur) zu verallgemeinern.

Eine kleine integrierte Symbolik kann die Lerneffizienz erheblich verbessern. LeCuns eigener Erfolg mit Faltungen (eingebaute Einschränkungen für die Verbindung neuronaler Netze) veranschaulicht diese Situation gut. Ein Teil des Erfolgs von AlphaFold 2 beruht auf sorgfältig konstruierten angeborenen Darstellungen der Molekularbiologie, ein anderer Teil liegt in der Rolle von Modellen. In einem neuen Artikel von DeepMind heißt es, dass sie einige Fortschritte beim Aufbau systematischer Überlegungen zum angeborenen Wissen über Ziele gemacht haben.

Und nichts, was LeCun und Browning gesagt haben, ändert daran.

Ein Schritt zurück kann die Welt grob in drei Teile unterteilt werden:

- Systeme mit vollständig installierter Symbolverarbeitungsausrüstung im Werk (wie fast alle bekannten Programmiersprachen).

- Systemen mit angeborenen Lerngeräten fehlt die symbolische Verarbeitung, aber mit geeigneten Daten und Trainingsumgebungen reichen sie aus, um symbolische Verarbeitung zu erreichen.

- Selbst mit ausreichender Schulung ist es unmöglich, ein System mit vollständigen Symbolverarbeitungsmechanismen zu erhalten.

Aktuelle Deep-Learning-Systeme fallen in die dritte Kategorie: kein Symbolverarbeitungsmechanismus am Anfang und kein zuverlässiger Symbolverarbeitungsmechanismus im Prozess.

LeCun und Browning scheinen meinem jüngsten Argument gegen die Skalierung zuzustimmen, wenn sie erkennen, dass die Skalierung zwar gut dazu beiträgt, mehr Ebenen und mehr Daten hinzuzufügen, aber nicht ausreicht. Wir alle drei erkannten die Notwendigkeit neuer Ideen.

Außerdem stimmen LeCuns jüngste Behauptungen auf Makroebene in vielerlei Hinsicht sehr mit meinen Behauptungen aus dem Jahr 2020 überein, dass wir beide die Wichtigkeit betonen, die Welt wahrzunehmen, zu argumentieren und umfassendere Modelle zu haben. Wir sind uns alle einig, dass die Symbolverarbeitung eine wichtige Rolle spielt (auch wenn sie unterschiedlich sein kann). Wir sind uns alle einig, dass die derzeit gängigen Techniken des verstärkenden Lernens nicht alle Anforderungen erfüllen können, ebenso wenig wie reine Skalierung.

Der größte Unterschied bei der Symbolverarbeitung besteht im Umfang der erforderlichen inhärenten Struktur und der Fähigkeit, vorhandenes Wissen zu nutzen. Bei der symbolischen Verarbeitung geht es darum, so viel vorhandenes Wissen wie möglich auszunutzen, während Deep Learning möchte, dass das System so weit wie möglich bei Null beginnt.

In den 2010er Jahren war symbolische Verarbeitung ein unbeliebtes Wort unter Deep-Learning-Befürwortern. In den 2020er Jahren sollten wir es zu einer Priorität machen, die Ursprünge dieser Methode zu verstehen symbolische Verarbeitung zur Erreichung von KI. Eine seit langem bestehende Frage in der neurosymbolischen Gemeinschaft lautet: Wie können datengesteuertes Lernen und symbolische Darstellung innerhalb einer einzigen, leistungsfähigeren Intelligenz harmonisch funktionieren? Spannenderweise hat sich LeCun schließlich dazu entschlossen, auf dieses Ziel hinzuarbeiten.

Originallink: https://www.noemamag.com/deep-learning-alone-isnt-getting-us-to-human-like-ai/

Das obige ist der detaillierte Inhalt vonIn der künstlichen Intelligenz passieren große Dinge, und auch LeCun hat sich verändert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr