Heim >Technologie-Peripheriegeräte >KI >Linguisten sind zurück! Beginnen Sie mit dem Lernen von der „Aussprache': Diesmal muss sich das KI-Modell selbst beibringen

Linguisten sind zurück! Beginnen Sie mit dem Lernen von der „Aussprache': Diesmal muss sich das KI-Modell selbst beibringen

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-08 12:44:25974Durchsuche

Der Versuch, Computern die menschliche Sprache verständlich zu machen, war im Bereich der künstlichen Intelligenz schon immer eine unüberwindbare Schwierigkeit.

Frühe Modelle zur Verarbeitung natürlicher Sprache verwendeten normalerweise künstlich gestaltete Funktionen, sodass spezialisierte Linguisten manuelle Muster schreiben mussten. Die Endergebnisse waren jedoch nicht ideal und selbst die KI-Forschung geriet in einen kalten Winter.

Jedes Mal, wenn ich einen Linguisten entlasse, wird das Spracherkennungssystem genauer.

Jedes Mal, wenn ich einen Linguisten entlasse, steigt die Leistung des Spracherkenners.

——Frederick Jelinek

Bei statistischen Modellen und groß angelegten Pre-Training-Modellen ist die Merkmalsextraktion nicht mehr notwendig, aber dennoch notwendig Geben Sie Aufgaben für die Datenanmerkung an, und das kritischste Problem ist: Das trainierte Modell versteht immer noch nicht die menschliche Sprache.

Sollten wir also von der ursprünglichen Form der Sprache ausgehen und noch einmal untersuchen: Wie erlangten Menschen Sprachkenntnisse?

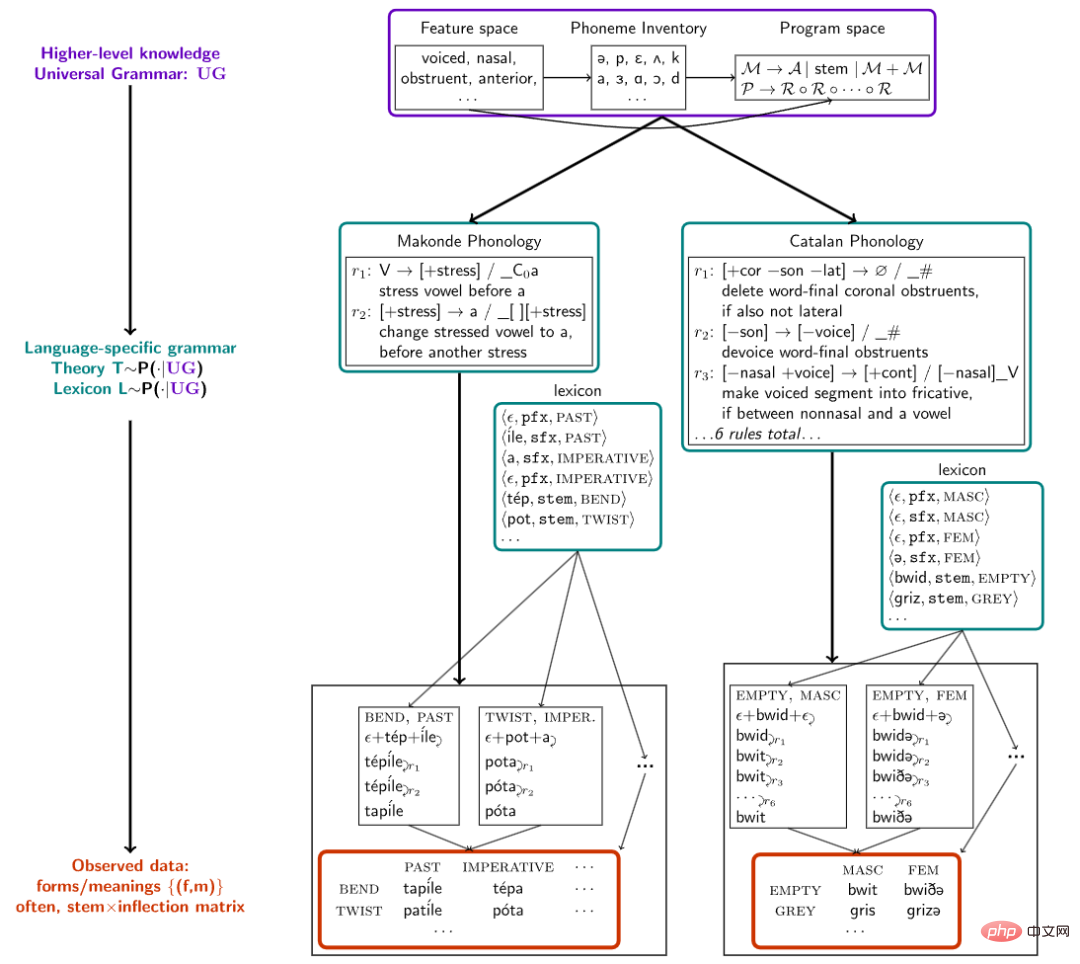

Forscher der Cornell University, des MIT und der McGill University haben kürzlich in Nature Communications einen Artikel veröffentlicht, in dem sie einen Rahmen für die algorithmische Synthese von Modellen im grundlegendsten Teil der menschlichen Sprache, nämlich lexikalischen Phonemen, vorschlagen. In der Morphophonologie begann man, der KI das Lernen beizubringen Sprache und konstruieren die Morphologie der Sprache direkt aus Lauten.

Link zum Papier: https://www.nature.com/articles/s41467-022-32012-w

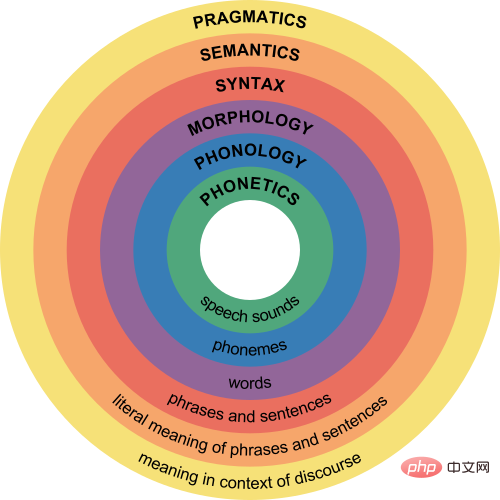

Morphologie und Phonologie ist einer der Zweige der Linguistik und konzentriert sich hauptsächlich auf Morpheme (d. h. die kleinsten Einheiten von Bedeutung) Die Lautveränderungen, die auftreten, wenn sie zu Wörtern kombiniert werden, versuchen, eine Reihe von Regeln zu liefern, um die regelmäßigen Lautveränderungen von Phonemen in der Sprache vorherzusagen.

Zum Beispiel wird das Pluralmorphem im Englischen als -s oder -es geschrieben, aber es gibt drei Aussprachen: [s], [z] und [әz]. Beispielsweise wird „cats“ als „/kæts/“ und „dogs“ ausgesprochen /dagz/, Pferde werden /hɔrsåz/ ausgesprochen.

Wenn Menschen lernen, die Pluralaussprache umzuwandeln, erkennen sie zunächst, dass das Pluralsuffix tatsächlich /z/ auf der Grundlage der Phonologie basiert. Das Suffix basiert dann auf der Phonologie im Stamm, z. B. bei stimmlosen Konsonanten Bei der Konvertierung in /s/ oder /әz/

Andere Sprachen haben ebenfalls die gleichen phonemischen lexikalischen Regeln. Die Forscher sammelten 70 Datensätze aus phonemischen Lehrbüchern in 58 Sprachen, jeder Datensatz enthält nur Dutzende bis Hunderte von Obwohl es sich um Wörter handelt, die nur wenige grammatikalische Phänomene enthalten, haben Experimente gezeigt, dass die Methode zum Auffinden grammatikalischer Strukturen in natürlicher Sprache auch den Prozess des Sprachenlernens bei Kleinkindern simulieren kann.

Durch die Durchführung einer hierarchischen Bayes'schen Inferenz auf diese Sprachdatensätze stellten die Forscher fest, dass das Modell neue morphophonemische Regeln aus nur einem oder wenigen Beispielen erwerben und in der Lage ist, gemeinsame sprachübergreifende Muster zu extrahieren und sie in einer kompakten, für den Menschen verständlichen Form auszudrücken bilden.

Lassen Sie das KI-Modell ein „Linguist“ sein

Die menschliche Intelligenz spiegelt sich hauptsächlich in der Fähigkeit wider, eine Theorie der kognitiven Welt aufzustellen. Nach der Bildung der natürlichen Sprache haben Linguisten beispielsweise eine Reihe von Regeln zusammengefasst, um Kindern zu helfen Lernen Sie eine bestimmte Sprache schneller, aber das aktuelle KI-Modell kann die Regeln nicht zusammenfassen und einen theoretischen Rahmen bilden, der für andere verständlich ist.

Bevor wir ein Modell erstellen, müssen wir ein Kernproblem lösen: „Wie beschreibt man ein Wort?“ Zum Lernprozess eines Wortes gehört beispielsweise das Verständnis des Konzepts, der Absicht, der Verwendung, der Aussprache und der Bedeutung des Wortes.

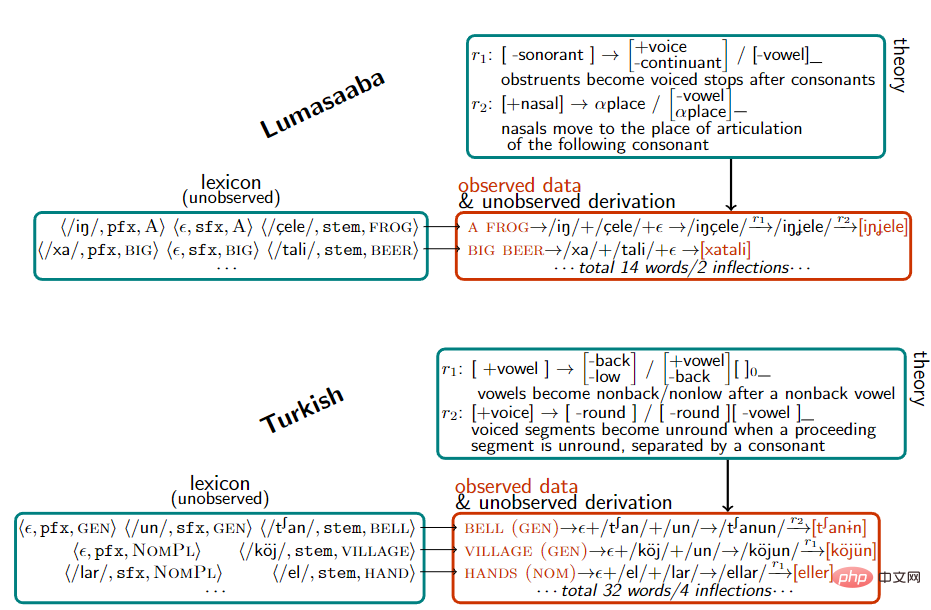

Beim Aufbau des Vokabulars stellten die Forscher jedes Wort als -Paar dar, zum Beispiel wird offen als εn/, [stem: OPEN]> dargestellt, Vergangenheitsform wird als /, [tense: PAST]> dargestellt und das kombinierte Eröffnet wird als εnd/, [stem: OPEN, [tense: PAST]]>

Nachdem die Forscher über den Datensatz verfügten, erstellten sie ein Modell, um die Erzeugung grammatikalischer Regeln für eine Reihe von Paaren durch Maximum-Posteriori-Wahrscheinlichkeitsinferenz zu erklären, um Wortänderungen zu erklären.

Bei der Darstellung von Lauten werden Phoneme (atomare Laute) als Vektoren binärer Merkmale wie /m/, /n/ dargestellt, bei denen es sich um Nasenlaute handelt, und dann werden phonetische Regeln basierend auf diesem Merkmalsraum definiert .

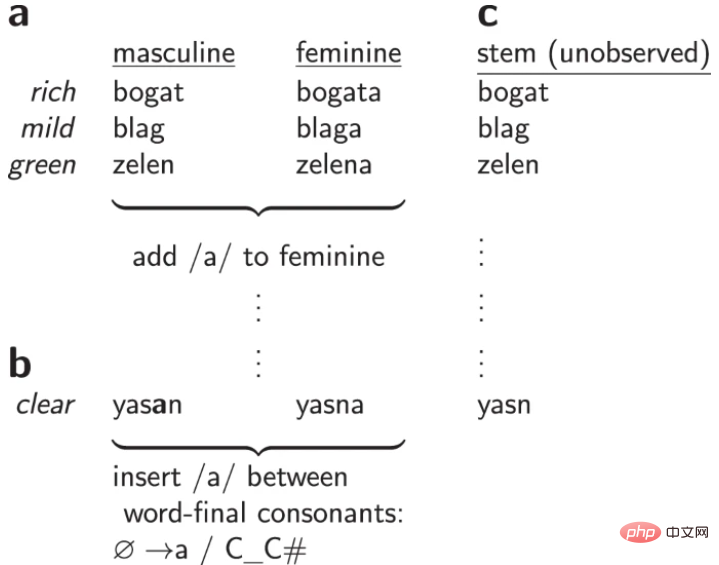

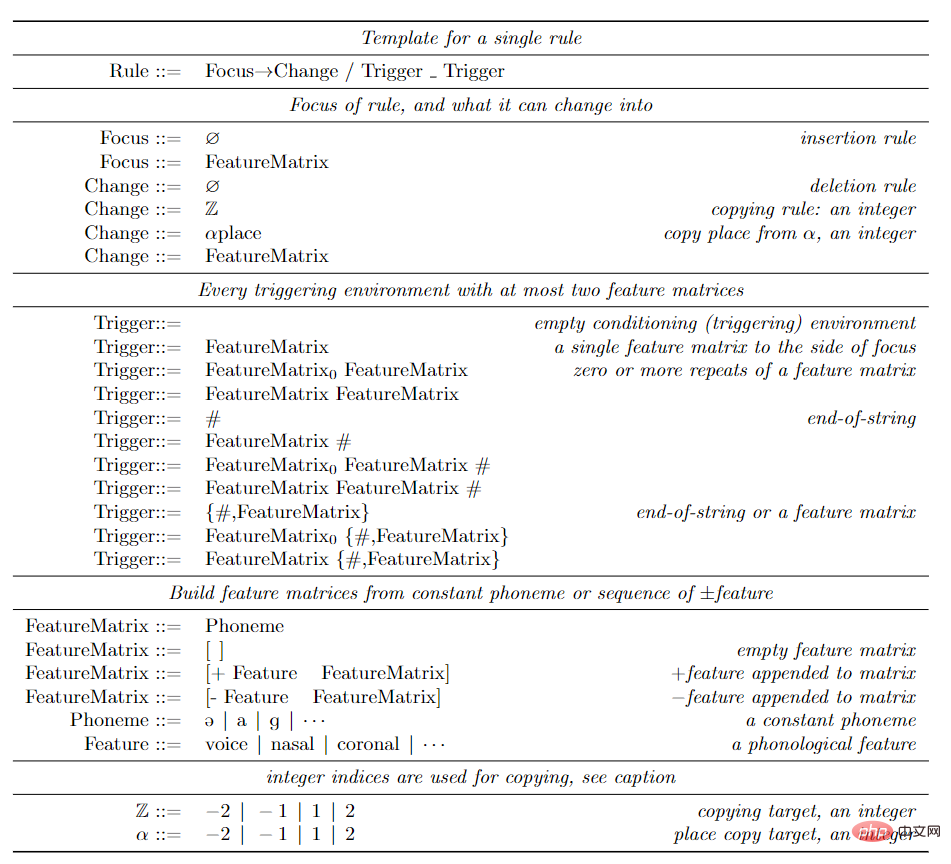

Forscher verwenden die klassische Regelausdrucksmethode, also das kontextabhängige Gedächtnis, manchmal auch Regeln im SPE-Stil genannt, die bei der Darstellung von Klangmustern im Englischen weit verbreitet sind.

Die Schreibmethode jeder Regel ist

(Fokus)→(strukturelle_Änderung)/(linker_Trigger)_(rechter_Trigger), was bedeutet, dass, solange die linke/rechte Triggerumgebung nahe links/rechts vom Fokus liegt, die Das Fokusphonem ändert sich entsprechend der Konvertierungsstruktur.

Die auslösende Umgebung gibt die Verbindung von Merkmalen an (die den Satz von Phonemen darstellt), solange das Phonem auf der linken Seite [-sonorant] ist, wird die Aussprache am Ende des Wortes verwendet Wenn Sie von /d/ zu /t/ wechseln, lautet die geschriebene Regel [-sonorant] → [-voice]/[-voice -sonorant]_#. Nach der Anwendung dieser Regel wird die Aussprache beispielsweise von /wɔkd/ umgewandelt. zu /wɔkt/.

Wenn solche Regeln darauf beschränkt sind, nicht zyklisch auf ihre eigenen Ausgaben anzuwenden, entsprechen die Regeln und Lexiken bidirektionalen rationalen Funktionen, die wiederum endlichen Transduktionen entsprechen. Es wurde argumentiert, dass der Raum der Finite-State-Konverter ausdrucksstark genug ist, um bekannte empirische Phänomene in der Morphophonetik abzudecken, und eine Grenze für die Beschreibungskraft praktischer Anwendungen der phonetischen Theorie darstellt.

Um diese Grammatik zu lernen, haben die Forscher die Bayesian Program Learning (BPL)-Methode übernommen. Modellieren Sie jede Grammatikregel T als Programm in einer Programmiersprache, die die domänenspezifischen Einschränkungen des Problemraums erfasst. Die allen Sprachen gemeinsame Sprachstruktur wird Universalgrammatik genannt. Dieser Ansatz kann als modernes Beispiel eines seit langem bestehenden Ansatzes in der Linguistik angesehen werden und verwendet für den Menschen verständliche generative Darstellungen, um die universelle Grammatik zu formalisieren.

Nach der Definition des Problems, das BPL lösen muss, ist der Suchraum in allen Programmen unendlich, es gibt keine Anleitung zur Lösung dieses Problems und es fehlen Methoden wie Gradientenabstieg oder Markov-Kette Monte Carlo Aufgrund der von solchen lokalen Optimierungsalgorithmen ausgenutzten lokalen Stationarität wandten die Forscher eine auf Einschränkungen basierende Programmsynthesestrategie an, um das Optimierungsproblem in ein kombinatorisches Einschränkungserfüllungsproblem umzuwandeln, und verwendeten zur Lösung einen booleschen Erfüllbarkeitslöser (SAT).

Diese Solver führen eine umfassende, aber relativ effiziente Suche durch und garantieren, dass bei genügend Zeit eine optimale Lösung gefunden wird. Die kleinste Grammatik, die mit einigen Daten übereinstimmt, kann mit dem prozeduralen Synthesizer Sketch gelöst werden, muss jedoch die Obergrenze der Grammatikgröße einhalten.

Aber in der Praxis können die umfassenden Suchtechniken, die von SAT-Lösern verwendet werden, nicht auf die riesigen Mengen an Regeln skalieren, die zur Interpretation großer Korpora erforderlich sind.

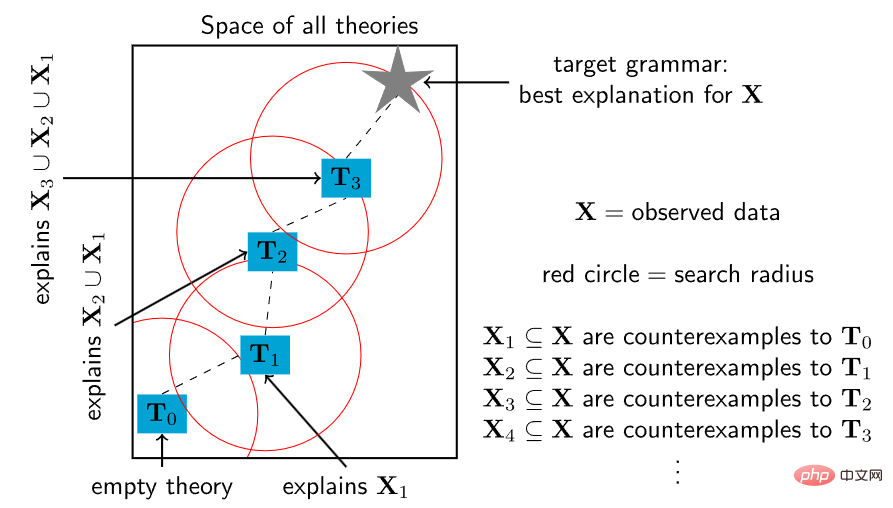

Um den Löser auf große und komplexe Theorien zu skalieren, ließen sich die Forscher von einem grundlegenden Merkmal des Spracherwerbs von Kindern und der Theoriebildung von Wissenschaftlern inspirieren.

Kinder lernen Sprache nicht über Nacht, sondern erweitern nach und nach ihr Verständnis von Grammatik und Wortschatz durch Zwischenstufen der Sprachentwicklung. Ebenso kann eine komplexe wissenschaftliche Theorie mit einem einfachen konzeptionellen Kern beginnen und sich dann schrittweise weiterentwickeln, um eine zunehmende Anzahl sprachlicher Phänomene zu umfassen.

Basierend auf den oben genannten Ideen entwarfen die Forscher einen Programmsynthesealgorithmus, beginnend mit einem kleinen Programm und verwendeten dann wiederholt den SAT-Löser, um kleine Änderungspunkte zu finden, damit immer mehr Daten erklärt werden können. Suchen Sie insbesondere ein Gegenbeispiel zur aktuellen Theorie und verwenden Sie dann einen Löser, um den Raum aller kleinen Modifikationen der Theorie, die dieses Gegenbeispiel berücksichtigen können, umfassend zu untersuchen.

Aber dieser heuristischen Methode fehlt die Integritätsgarantie des SAT-Lösers: Obwohl sie wiederholt einen vollständigen und genauen SAT-Löser aufruft, garantiert sie nicht, eine optimale Lösung zu finden, aber jeder wiederholte Aufruf ist besser als der direkte Aufruf der gesamten SAT-Löser viel schwieriger zu optimieren. Denn die Einschränkung, dass jede neue Theorie nahe an ihrer vorherigen Theorie im Theorieraum liegt, führt zu einer polynomischen Verkleinerung des Problems der Beschränkungserfüllung, wodurch die Suchzeit für SAT-Löser im schlimmsten Fall exponentiell länger wird.

In der experimentellen Auswertungsphase sammelten die Forscher 70 Fragen aus Lehrbüchern der Linguistik, die jeweils eine umfassende Analyse einiger Theorieformen in natürlicher Sprache erforderten. Die Probleme variieren im Schwierigkeitsgrad und decken ein breites Spektrum natürlicher Sprachphänomene ab.

Natürliche Sprachen sind ebenfalls vielfältig, einschließlich tonaler Sprachen, zum Beispiel in Kerewe (einer Bantusprache in Tansania), zu zählen ist /kubala/, aber zu zählen ist /kukíbála/, wobei der Akzent einen hohen Ton markiert .

Es gibt auch Sprachen mit Vokalharmonie, zum Beispiel gibt es in der Türkei /el/ und /t∫an/, die jeweils Hände und Glocken darstellen, und /el-ler/ und /t∫an-lar/, die repräsentieren Hände bzw. die Pluralform von Glocken und viele andere sprachliche Phänomene, wie Assimilations- und Erweiterungsformen.

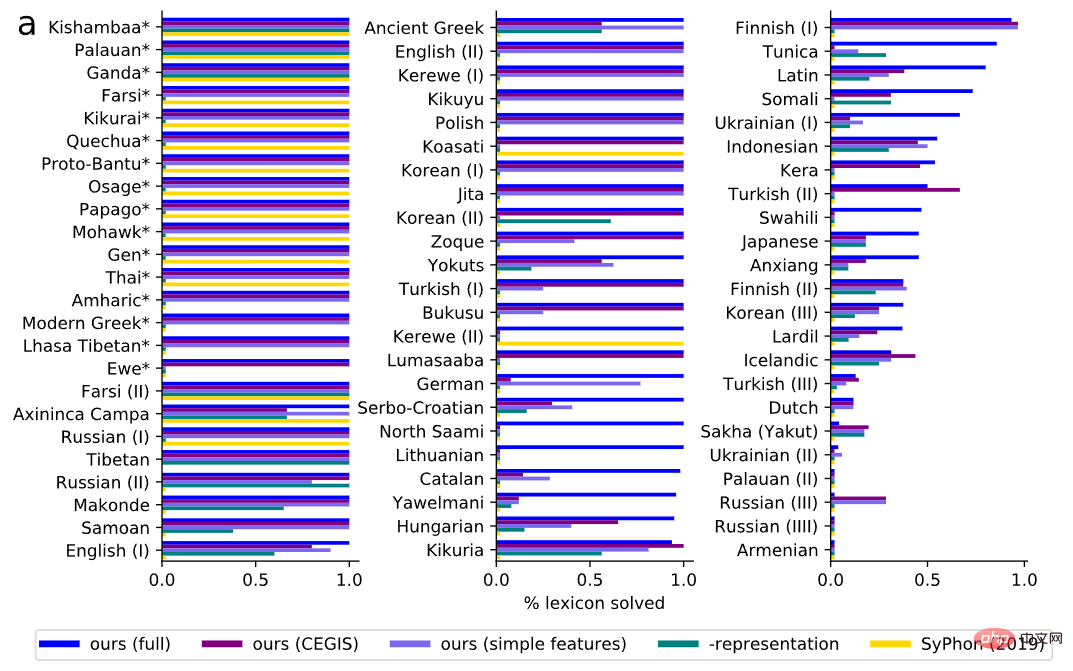

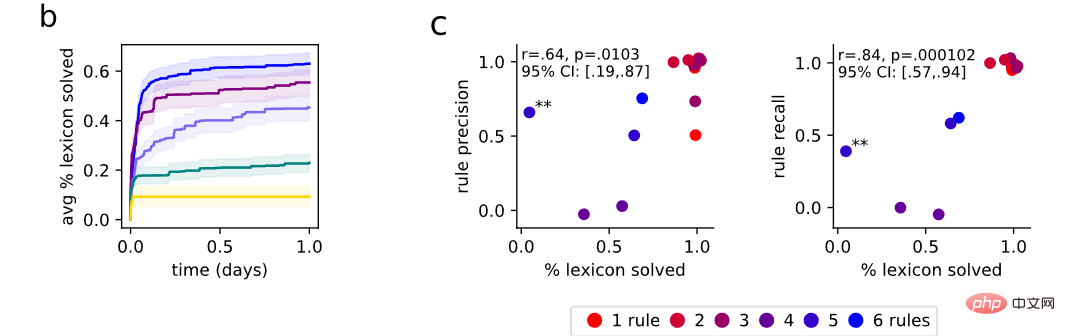

Bei der Bewertung messen wir zunächst die Fähigkeit des Modells, den richtigen Wortschatz zu entdecken. Im Vergleich zum Grundwahrheitsvokabular fand das Modell eine Grammatik, die in 60 % der Benchmarks korrekt mit dem gesamten Vokabular der Frage übereinstimmte und in 79 % der Fragen einen großen Teil des Vokabulars richtig interpretierte.

Oft ist das richtige Vokabular für jedes Problem spezifischer als die richtigen Regeln, und alle Regeln, die vollständige Daten aus dem richtigen Vokabular erzeugen, müssen beobachtungsmäßig äquivalent zu allen zugrunde liegenden Regeln sein, die das Modell möglicherweise vorschlägt. Daher sollte die Konsistenz mit dem zugrunde liegenden Wahrheitslexikon als Metrik verwendet werden, um zu messen, ob sich die synchronisierten Regeln korrekt auf die Daten verhalten, und diese Bewertung hängt mit der Qualität der Regeln zusammen.

Um diese Hypothese zu testen, wählten die Forscher zufällig 15 Fragen aus und berieten sich mit einem professionellen Linguisten, um die entdeckten Regeln zu bewerten. Erinnerung (der Anteil der tatsächlichen phonetischen Regeln, die korrekt wiederhergestellt wurden) und Präzision (der Anteil der wiederhergestellten Regeln, die tatsächlich aufgetreten sind) wurden gleichzeitig gemessen. Unter den Indikatoren Präzision und Erinnerung lässt sich feststellen, dass die Genauigkeit der Regeln positiv mit der Genauigkeit des Wortschatzes korreliert.

Wenn das System das gesamte Lexikon richtig versteht, führt es selten irrelevante Regeln ein (hohe Präzision) und erhält fast immer alle richtigen Regeln (hoher Rückruf).

Das obige ist der detaillierte Inhalt vonLinguisten sind zurück! Beginnen Sie mit dem Lernen von der „Aussprache': Diesmal muss sich das KI-Modell selbst beibringen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr