Heim >Technologie-Peripheriegeräte >KI >Ist der Forschungsweg von GPT-4 aussichtslos? Yann LeCun verurteilte Zi Hui zum Tode

Ist der Forschungsweg von GPT-4 aussichtslos? Yann LeCun verurteilte Zi Hui zum Tode

- 王林nach vorne

- 2023-04-04 11:55:081944Durchsuche

Yann LeCun Diese Sichtweise ist in der Tat etwas gewagt.

„Niemand, der bei klarem Verstand ist, wird in fünf Jahren ein autoregressives Modell verwenden.“ Kürzlich eröffnete der Turing-Award-Gewinner Yann LeCun eine besondere Debatte. Die Autoregression, von der er spricht, ist genau das Lernparadigma, auf dem das derzeit beliebte GPT-Familienmodell basiert.

Natürlich ist es nicht nur das autoregressive Modell, auf das Yann LeCun hingewiesen hat. Seiner Ansicht nach steht der gesamte Bereich des maschinellen Lernens derzeit vor großen Herausforderungen.

Das Thema dieser Debatte lautet „Brauchen große Sprachmodelle sensorische Grundlage für Bedeutung und Verständnis?“ und ist Teil der kürzlich abgehaltenen Konferenz „The Philosophy of Deep Learning“. Die Konferenz befasste sich aus philosophischer Sicht mit aktuellen Fragen der Künstliche-Intelligenz-Forschung, insbesondere mit neueren Arbeiten auf dem Gebiet der tiefen künstlichen neuronalen Netze. Sein Zweck besteht darin, Philosophen und Wissenschaftler zusammenzubringen, die über diese Systeme nachdenken, um die Fähigkeiten, Grenzen und die Beziehung dieser Modelle zur menschlichen Erkenntnis besser zu verstehen.

Laut der Debatten-PPT setzte Yann LeCun seinen üblichen scharfen Stil fort und betonte unverblümt: „Maschinelles Lernen ist scheiße!“ Das letzte Thema kehrte natürlich zu „Weltmodell“ zurück. In diesem Artikel sortieren wir Yann LeCuns Kernideen basierend auf PPT.

Für weitere Videoinformationen beachten Sie bitte die offizielle Website der Konferenz: https://phildeeplearning.github.io/

Yann LeCuns zentraler Standpunkt

Maschinelles Lernen ist scheiße!

"Maschine „Lernen ist scheiße! (Maschinelles Lernen ist scheiße)“ Yann LeCun hat diesen Untertitel an den Anfang des PPT gesetzt. Allerdings fügte er hinzu: Im Vergleich zu Mensch und Tier.

Was ist falsch am maschinellen Lernen? LeCun hat mehrere Beispiele aufgeführt:

- Supervised Learning (SL) erfordert eine große Anzahl beschrifteter Proben;

- Reinforcement Learning (RL) erfordert eine große Anzahl von Experimenten; Proben.

- Darüber hinaus machen die meisten aktuellen KI-Systeme, die auf maschinellem Lernen basieren, sehr dumme Fehler und können nicht vernünftig denken oder planen.

Im Vergleich können Menschen und Tiere viel mehr tun, darunter:

Verstehen, wie die Welt funktioniert;- In der Lage sein, die Konsequenzen ihrer Handlungen vorherzusagen;

- Kann komplexe Aufgaben zur Planung in eine Reihe von Teilaufgaben zerlegen;

- Noch wichtiger ist, dass Menschen und Tiere über gesunden Menschenverstand verfügen und der gesunde Menschenverstand aktueller Maschinen relativ oberflächlich ist.

Autoregressive große Sprachmodelle haben keine Zukunft

Unter den drei oben aufgeführten Lernparadigmen konzentrierte sich Yann LeCun auf selbstüberwachtes Lernen. Das erste, was Sie sehen können, ist, dass selbstüberwachtes Lernen zum aktuellen Mainstream-Lernparadigma geworden ist. In LeCuns Worten: „Selbstüberwachtes Lernen hat die Welt erobert.“ In den letzten Jahren haben die meisten großen Modelle zum Verstehen und Generieren von Text und Bildern dieses Lernparadigma übernommen.

Beim selbstüberwachten Lernen erfreut sich das durch die GPT-Familie repräsentierte autoregressive Large Language Model (AR-LLM) immer größerer Beliebtheit. Das Prinzip dieser Modelle besteht darin, das nächste Token basierend auf dem oben oder unten genannten vorherzusagen (das Token kann hier ein Wort, ein Bildblock oder ein Sprachclip sein). Die uns bekannten Modelle wie LLaMA (FAIR) und ChatGPT (OpenAI) sind alle autoregressive Modelle.

Aber nach Ansicht von LeCun hat diese Art von Modell keine Zukunft (Auto-Regressive LLMs sind zum Scheitern verurteilt). Denn obwohl ihre Leistung erstaunlich ist, sind viele Probleme schwer zu lösen, darunter sachliche Fehler, logische Fehler, Inkonsistenzen, begrenzte Argumentation und die einfache Generierung schädlicher Inhalte. Wichtig ist, dass solche Modelle die zugrunde liegende Realität der Welt nicht verstehen.

Angenommen, e ist aus technischer Sicht die Wahrscheinlichkeit, dass ein willkürlich generierter Token uns von der richtigen Antwortmenge wegführen kann, dann ist die Wahrscheinlichkeit, dass eine Antwort der Länge n letztendlich die richtige Antwort sein wird, P (richtig). = (1-e )^n. Nach diesem Algorithmus häufen sich Fehler und die Genauigkeit nimmt exponentiell ab. Natürlich können wir dieses Problem (durch Training) abmildern, indem wir e kleiner machen, aber es kann nicht vollständig beseitigt werden, erklärt Yann LeCun. Er glaubt, dass wir zur Lösung dieses Problems LLM nicht mehr autoregressiv machen und gleichzeitig die Glätte des Modells beibehalten müssen.

LeCun glaubt, dass es eine vielversprechende Richtung gibt: Weltmodell

Das derzeit beliebte GPT-Modell hat keine Zukunft, was hat also die Zukunft? Laut LeCun lautet die Antwort: ein Weltmodell.

Im Laufe der Jahre hat LeCun betont, dass diese aktuellen groß angelegten Sprachmodelle im Vergleich zu Menschen und Tieren beim Lernen sehr ineffizient sind: Ein Teenager, der noch nie ein Auto gefahren ist, kann das Autofahren in 20 Stunden lernen, aber das beste Selbst- Fahrsysteme erfordern Millionen oder Milliarden gekennzeichneter Daten oder Millionen von Reinforcement-Learning-Experimenten in einer virtuellen Umgebung. Trotz all dieser Anstrengungen werden sie nicht in der Lage sein, die gleichen zuverlässigen Fahrfähigkeiten wie Menschen zu erreichen.

Es gibt also drei große Herausforderungen, denen sich aktuelle Forscher des maschinellen Lernens gegenübersehen: Die eine besteht darin, das Darstellungs- und Vorhersagemodell der Welt zu erlernen (für verwandte Diskussionen zu System 2, die von LeCun erwähnt wurden, siehe der Bericht von Professor Wang Jun von der UCL; Die dritte besteht darin, zu lernen, komplexe Aktionssequenzen zu planen.

Basierend auf diesen Problemen schlug LeCun die Idee vor, ein „Welt“-Modell zu bauen, und erläuterte es in einem Artikel mit dem Titel „Ein Weg zur autonomen Maschinenintelligenz“.

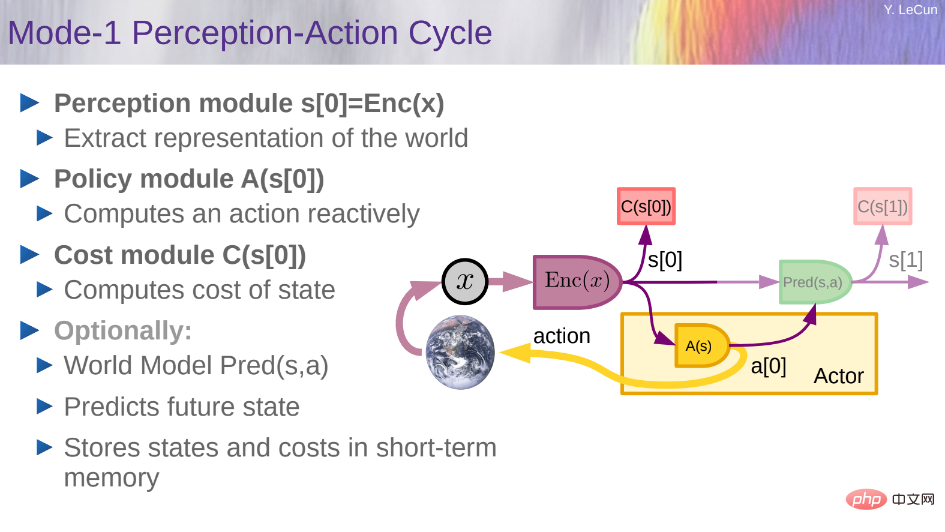

Konkret wollte er eine kognitive Architektur aufbauen, die zum Denken und Planen fähig ist. Diese Architektur besteht aus 6 unabhängigen Modulen:

- Konfiguratormodul;

- Kostenmodul;

- Kurzzeitgedächtnismodul.

- Detaillierte Informationen zu diesen Modulen finden Sie im vorherigen Artikel von Machine Heart „Turing-Preisträger Yann LeCun: Die größte Herausforderung in der KI-Forschung in den nächsten Jahrzehnten ist „Predictive World Model““.

- Yann LeCun erläuterte auch einige Details, die im vorherigen Artikel in der PPT erwähnt wurden.

Wie baue und trainiere ich ein Weltmodell?

Nach Ansicht von LeCun ist das eigentliche Hindernis, das die Entwicklung künstlicher Intelligenz in den nächsten Jahrzehnten behindert, die Designarchitektur und das Trainingsparadigma für das Weltmodell.

Wie baue und trainiere ich ein Weltmodell? Man muss sich darüber im Klaren sein, dass die Welt nur teilweise vorhergesagt werden kann. Zunächst stellt sich die Frage, wie die Unsicherheit in Vorhersagen charakterisiert werden kann.

Wie kann also ein Vorhersagemodell mehrere Vorhersagen darstellen?

Probabilistische Modelle sind in kontinuierlichen Domänen schwer zu implementieren, während generative Modelle jedes Detail der Welt vorhersagen müssen.

Wie in der Abbildung oben gezeigt, repräsentiert x in dieser Architektur die vergangenen und aktuellen Beobachtungen, y repräsentiert die Zukunft, a repräsentiert die Aktion, z repräsentiert die unbekannte latente Variable, D() repräsentiert die vorhergesagten Kosten und C() repräsentiert die Wiederbeschaffungskosten. JEPA sagt eine Darstellung von S_y für die Zukunft aus Darstellungen von S_x für Vergangenheit und Gegenwart voraus.

Die generative Architektur wird alle Details von y vorhersagen, einschließlich irrelevanter, während JEPA die abstrakte Darstellung von y vorhersagt.

In diesem Fall gibt es nach Ansicht von LeCun fünf Ideen, die „völlig aufgegeben“ werden müssen:

- Generative Modelle zugunsten einer gemeinsamen Einbettungsarchitektur aufgeben;

- Autoregressive Modelle aufgeben

- Verzicht auf probabilistische Modelle zugunsten von Energiemodellen;

- Verzicht auf kontrastive Methoden zugunsten von Regularisierungsmethoden;

- Sein Vorschlag ist, RL nur dann zu verwenden, wenn der Plan nicht zu den vorhergesagten Ergebnissen führt, um das Weltmodell anzupassen oder zu kritisieren.

Wie das Energiemodell kann JEPA mit kontrastiven Methoden trainiert werden. Allerdings sind kontrastive Methoden in hochdimensionalen Räumen ineffizient, daher ist es besser, sie mit nicht kontrastierenden Methoden zu trainieren. Im Fall von JEPA kann dies durch vier Kriterien erreicht werden, wie in der folgenden Abbildung dargestellt: 1. Maximieren Sie die Informationsmenge, die s_x über x hat; 2. Maximieren Sie die Informationsmenge, die s_y über y hat; 3. Machen Sie s_y einfach zur Vorhersage aus s_x ;4 Minimieren Sie den Informationsgehalt, der zur Vorhersage der latenten Variablen z verwendet wird.

Die folgende Abbildung zeigt eine mögliche Architektur für die Weltzustandsvorhersage auf mehreren Ebenen und in mehreren Maßstäben. Die Variablen x_0, x_1, x_2 repräsentieren eine Folge von Beobachtungen. Das Netzwerk der ersten Ebene mit der Bezeichnung JEPA-1 verwendet Darstellungen auf niedriger Ebene, um kurzfristige Vorhersagen durchzuführen. Das Second-Level-Netzwerk JEPA-2 verwendet High-Level-Darstellungen für langfristige Vorhersagen. Man könnte sich vorstellen, dass diese Art von Architektur viele Schichten hat, möglicherweise Faltungen und andere Module verwendet und zeitliches Pooling zwischen den Stufen verwendet, um eine grobkörnige Darstellung bereitzustellen und langfristige Vorhersagen durchzuführen. Das Training kann stufenweise oder global unter Verwendung einer der kontrastfreien Methoden von JEPA durchgeführt werden.

Die folgende Abbildung zeigt eine mögliche Architektur für die Weltzustandsvorhersage auf mehreren Ebenen und in mehreren Maßstäben. Die Variablen x_0, x_1, x_2 repräsentieren eine Folge von Beobachtungen. Das Netzwerk der ersten Ebene mit der Bezeichnung JEPA-1 verwendet Darstellungen auf niedriger Ebene, um kurzfristige Vorhersagen durchzuführen. Das Second-Level-Netzwerk JEPA-2 verwendet High-Level-Darstellungen für langfristige Vorhersagen. Man könnte sich vorstellen, dass diese Art von Architektur viele Schichten hat, möglicherweise Faltungen und andere Module verwendet und zeitliches Pooling zwischen den Stufen verwendet, um eine grobkörnige Darstellung bereitzustellen und langfristige Vorhersagen durchzuführen. Das Training kann stufenweise oder global unter Verwendung einer der kontrastfreien Methoden von JEPA durchgeführt werden.

Hierarchische Planung ist schwierig, es gibt fast keine Lösungen und die meisten davon erfordern vordefinierte Zwischenworte und Handlungsanweisungen. Die folgende Abbildung zeigt die hierarchische Planungsphase unter Unsicherheit:

Hierarchische Planung ist schwierig, es gibt fast keine Lösungen und die meisten davon erfordern vordefinierte Zwischenworte und Handlungsanweisungen. Die folgende Abbildung zeigt die hierarchische Planungsphase unter Unsicherheit:

Was sind die Schritte hin zu einem autonomen KI-System? Leder Eingebettete Vorhersagearchitektur

Was sind die Schritte hin zu einem autonomen KI-System? Leder Eingebettete Vorhersagearchitektur

Energiemodell-Framework

3. Weltmodell aus Beobachtungen lernen

- Wie Tiere und menschliche Babys?

4. Argumentation und Planung

- Kompatibel mit gradientenbasiertem Lernen

- Keine Symbole, keine Logik → Vektoren und kontinuierliche Funktionen

- Vorhersagen sind die Essenz der Intelligenz: Das Erlernen von Vorhersagemodellen der Welt ist die Grundlage des gesunden Menschenverstandes.

- Fast alles wird durch selbstüberwachtes Lernen gelernt: Merkmale auf niedriger Ebene, Räume, Objekte, Physik, abstrakte Darstellungen ...; Fast nichts wird durch Verstärkung, Überwachung oder Nachahmung gelernt.

- Inferenz = Simulation/Vorhersage + Optimierung von Zielen: Rechnerisch leistungsfähiger als die autoregressive Generierung.

- H-JEPA und nicht-kontrastives Training sind so: probabilistische generative Modelle und kontrastive Methoden sind zum Scheitern verurteilt.

- Intrinsische Kosten und Architektur steuern das Verhalten und bestimmen, was gelernt wird.

- Emotion ist eine notwendige Voraussetzung für autonome Intelligenz: die Erwartungen des Kritikers oder des Weltmodells an die Ergebnisse + intrinsische Kosten.

Abschließend fasste LeCun die aktuellen Herausforderungen der KI-Forschung zusammen: (Empfohlene Lektüre: Zusammenfassung von 10 Jahren Denken, Turing-Award-Gewinner Yann LeCun zeigt die Richtung der nächsten Generation von KI auf: autonome maschinelle Intelligenz)

- Anhand von Videos und Bildern finden Sie einen allgemeinen Ansatz zum Trainieren von H-JEPA-basierten Weltmodellen in Audio und Text.

- Entwerfen Sie Ersatzkosten, um H-JEPA zum Erlernen relevanter Darstellungen zu bewegen (Vorhersage ist nur eine davon). H-JEPA, um in der Lage zu sein, Inferenzprogramme mit hierarchischer Planung für Inferenzprogramme mit Unsicherheit zu entwerfen (gradientenbasierte Methoden, Strahlsuche, MCTS...);

- Ungenauigkeiten in Modellen oder Kritikern minimieren Verwenden Sie in diesem Fall RL (was ungenau ist und zu unvorhersehbaren Ergebnissen führen kann);

- Funktioniert GPT-4?

- Natürlich wird LeCuns Idee möglicherweise nicht die Unterstützung aller gewinnen. Zumindest haben wir etwas Lärm gehört.

Nach der Rede sagte jemand, dass GPT-4 große Fortschritte bei dem von LeCun vorgeschlagenen „Getriebeproblem“ gemacht und seine Generalisierungsleistung erbracht habe. Die ersten Anzeichen sehen größtenteils gut aus:

Aber was LeCun sagt, ist: „Ist es möglich, dass dieses Problem in ChatGPT und in das menschliche Bewertungstrainingsset eingespeist wurde, das zur Feinabstimmung von GPT-4 verwendet wurde?“

Was bedeutet das? „Die potenziellen Fähigkeiten von LLM und insbesondere von GPT-4 sind möglicherweise viel größer, als uns bewusst ist, und es ist normalerweise ein Fehler zu wetten, dass sie in Zukunft nicht mehr in der Lage sein werden, etwas zu tun. Wenn Sie die richtigen Eingabeaufforderungen verwenden, werden sie kann es tatsächlich tun

unter Internetnutzern Bei den von uns veröffentlichten Versuchen lieferten die meisten Personen, die die richtigen Antworten erhielten, äußerst reichhaltige Eingabeaufforderungen, während andere diesen „Erfolg“ nicht reproduzieren konnten. Es ist ersichtlich, dass auch die Fähigkeit von GPT-4 „flackert“ und die Erforschung der Obergrenze seines Intelligenzniveaus noch einige Zeit andauern wird.

Das obige ist der detaillierte Inhalt vonIst der Forschungsweg von GPT-4 aussichtslos? Yann LeCun verurteilte Zi Hui zum Tode. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr