Heim >Technologie-Peripheriegeräte >KI >Als GPT-4 über seinen Fehler nachdachte: Die Leistung stieg um fast 30 % und die Programmierfähigkeit um 21 %

Als GPT-4 über seinen Fehler nachdachte: Die Leistung stieg um fast 30 % und die Programmierfähigkeit um 21 %

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-04 11:55:031127Durchsuche

GPT-4s Denkweise wird immer menschlicher.

Wenn Menschen Fehler machen, werden sie über ihre Handlungen nachdenken, um zu vermeiden, dass sie erneut Fehler machen. Wenn große Sprachmodelle wie GPT-4 auch die Fähigkeit haben, zu reflektieren, wird die Leistung um wie viel verbessert.

Es ist bekannt, dass große Sprachmodelle (LLM) bei verschiedenen Aufgaben eine beispiellose Leistung gezeigt haben. Diese SOTA-Methoden erfordern jedoch normalerweise eine Feinabstimmung des Modells, eine Richtlinienoptimierung und andere Operationen im definierten Zustandsraum. Aufgrund des Mangels an qualitativ hochwertigen Trainingsdaten und einem klar definierten Zustandsraum ist es immer noch schwierig, das Optimierungsmodell zu implementieren. Darüber hinaus verfügen Modelle noch nicht über bestimmte Eigenschaften, die dem menschlichen Entscheidungsprozess innewohnen, insbesondere die Fähigkeit, aus Fehlern zu lernen.

Aber jetzt haben Forscher der Northeastern University, des MIT und anderer Institutionen in einem aktuellen Artikel Reflexion vorgeschlagen, das dem Agenten die Fähigkeit gibt, sich dynamisch zu erinnern und selbst zu reflektieren.

Um die Wirksamkeit der Methode zu überprüfen, wurde in dieser Studie die Fähigkeit des Agenten bewertet, Entscheidungsaufgaben in der AlfWorld-Umgebung zu erledigen, und seine Fähigkeit, wissensintensive, suchbasierte Frage- und Antwortaufgaben in der HotPotQA-Umgebung zu erledigen. Die Erfolgsquote bei diesen beiden Aufgaben beträgt 97 % bzw. 51 %.

Papieradresse: https://arxiv.org/pdf/2303.11366.pdf

Projektadresse: https://github.com/GammaTauAI/reflexion-human-eval

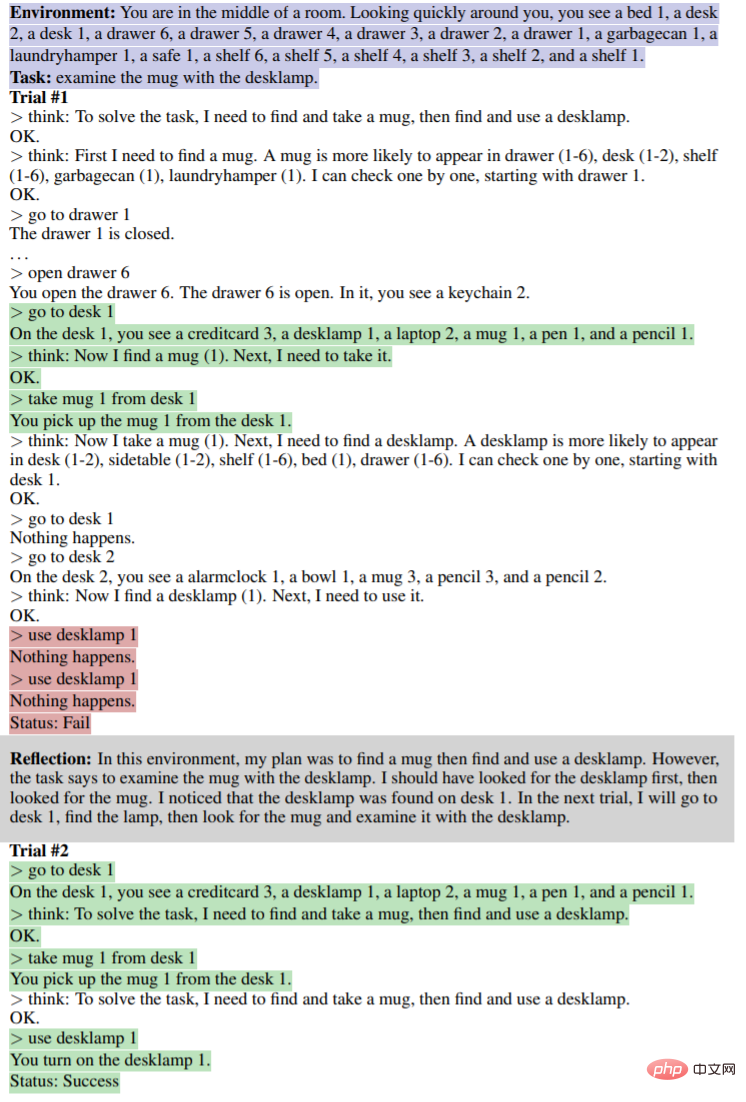

Wie im Bild unten gezeigt, In der Umgebung von AlfWorld sind verschiedene Objekte im Raum angeordnet, und der Agent muss einen Begründungsplan vorlegen, um ein bestimmtes Objekt zu erhalten. Der obere Teil des Bildes unten schlägt aufgrund des ineffizienten Plans des Agenten fehl. Nach der Überlegung erkennt der Agent den Fehler, korrigiert die Argumentationsbahn und gibt eine prägnante Bahnmethode an (unterer Teil der Abbildung).

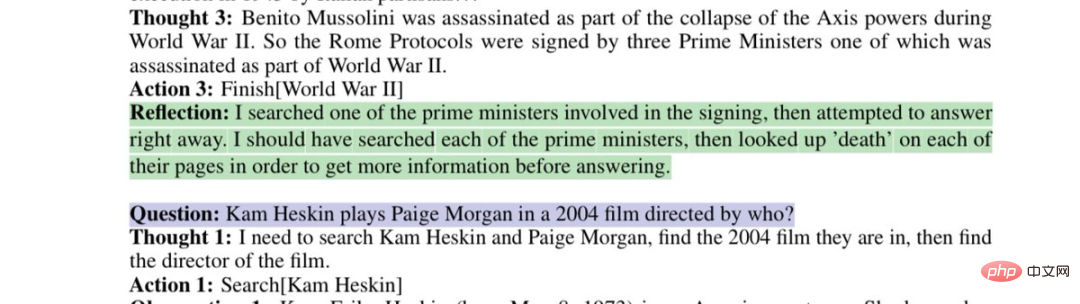

Modellreflexion zu fehlerhaften Suchstrategien:

Dieser Artikel zeigt, dass Sie diesen Fehler beheben können, indem Sie GPT-4 bitten, über „Warum haben Sie sich geirrt?“ zu reflektieren und eine neue Eingabeaufforderung für sich selbst zu generieren werden so lange berücksichtigt, bis das Ergebnis stimmt, wodurch sich die Leistung von GPT-4 um erstaunliche 30 % verbessert.

Internetnutzer müssen seufzen: Die Entwicklungsgeschwindigkeit der künstlichen Intelligenz hat unsere Anpassungsfähigkeit übertroffen.

Einführung in die Methode

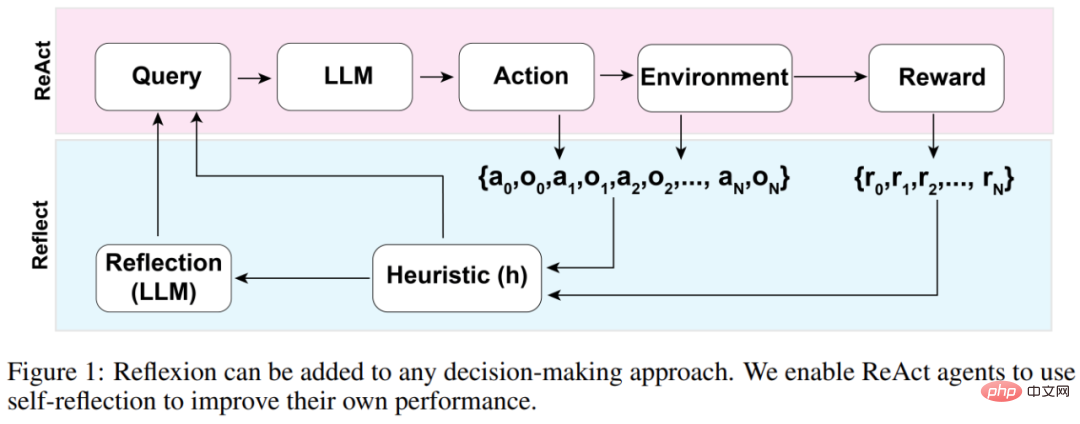

Die Gesamtarchitektur des Reflexion-Agenten ist in Abbildung 1 unten dargestellt, wo Reflexion ReAct verwendet (Yao et al., 2023). Im ersten Versuch erhält der Agent eine Aufgabe aus der Umgebung, die die anfängliche Abfrage darstellt. Anschließend führt der Agent eine vom LLM generierte Folge von Aktionen aus und erhält Beobachtungen und Belohnungen aus der Umgebung. Für Umgebungen, die beschreibende oder kontinuierliche Belohnungen bieten, beschränkt die Studie die Ausgabe auf einfache binäre Erfolgszustände, um die Anwendbarkeit sicherzustellen.

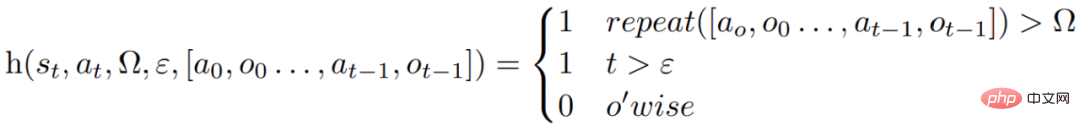

Nach jeder Aktion a_t berechnet der Agent eine heuristische Funktion h, wie in der folgenden Abbildung dargestellt.

Diese heuristische Funktion dient dazu, vom Agenten erzeugte Informationsillusionen (d. h. falsche oder falsche Informationen) zu erkennen ineffizient und „sagen“ dem Agenten, wann er reflektieren muss (Reflexion), wobei t der Zeitschritt ist, s_t der aktuelle Zustand ist, Ω die Anzahl der wiederholten Aktionszyklen darstellt, ε die maximale Gesamtzahl der ausgeführten Aktionen darstellt, [ a_o, o_0 , a_(t−1), o_(t−1)] stellt den Flugbahnverlauf dar. „repeat“ ist eine einfache Funktion, die bestimmt, wie oft eine Schleife wiederholter Aktionen zum gleichen Ergebnis führt.

Wenn die Funktion h dem Agenten mitteilt, dass sie reflektieren muss, fragt der Agent den LLM ab, um seine aktuelle Aufgabe, den Verlauf der Flugbahn und die letzte Belohnung widerzuspiegeln, und dann setzt der Agent die Umgebung zurück und versucht es bei nachfolgenden Versuchen erneut. Wenn die Funktion h dem Agenten nicht mitteilt, dass eine Reflexion erforderlich ist, fügt der Agent a_t und o_t zu seinem Trajektorienverlauf hinzu und fragt den LLM nach der nächsten Aktion ab.

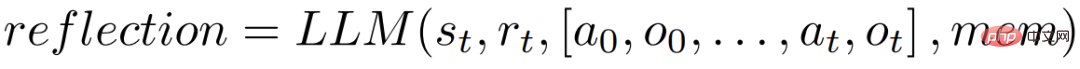

Wenn die Heuristik h zum Zeitpunkt t eine Reflexion vorschlägt, wird der Agent basierend auf seinem aktuellen Zustand s_t, der letzten Belohnung r_t, früheren Aktionen und Beobachtungen [a_0, o_0, ., a_t, o_t] reflektieren Der Agent wird im MEM gespeichert, wodurch ein Reflexionsprozess eingeleitet wird.

Der Zweck der Reflexion besteht darin, dem Agenten zu helfen, „Illusionen“ und Ineffizienzen durch Versuch und Irrtum zu korrigieren. Das für die Reflexion verwendete Modell ist ein LLM, das spezifische Fehlerverläufe und ideale Reflexionsbeispiele als Anregung verwendet.

Der Agent führt den oben genannten Reflexionsprozess iterativ durch. In den Experimenten wurde in der Studie die Anzahl der im Speicher des Agenten gespeicherten Reflexionen auf maximal das Dreifache festgelegt, um Abfragen zu vermeiden, die die Grenzen des LLM überschreiten. Der Lauf wird in den folgenden Situationen abgebrochen:

- Überschreitet die maximale Anzahl von Versuchen;

- Kann die Leistung zwischen zwei aufeinanderfolgenden Versuchen nicht verbessert werden;

- Schließt die Aufgabe ab.

Experimente und Ergebnisse

AlfWorld bietet sechs verschiedene Aufgaben und mehr als 3000 Umgebungen, die erfordern, dass der Agent die Zielaufgabe versteht, einen sequentiellen Plan für Unteraufgaben formuliert und Vorgänge in einer bestimmten Umgebung durchführt.

In der Studie wurde der Agent in 134 AlfWorld-Umgebungen getestet. Zu den Aufgaben gehörten das Auffinden versteckter Objekte (z. B. das Finden eines Obstmessers in einer Schublade), das Bewegen von Objekten (z. B. das Bewegen eines Messers auf ein Schneidebrett) und die Verwendung anderer Objekte zur Manipulation andere Gegenstände. Ein Gegenstand (z. B. Tomaten im Kühlschrank).

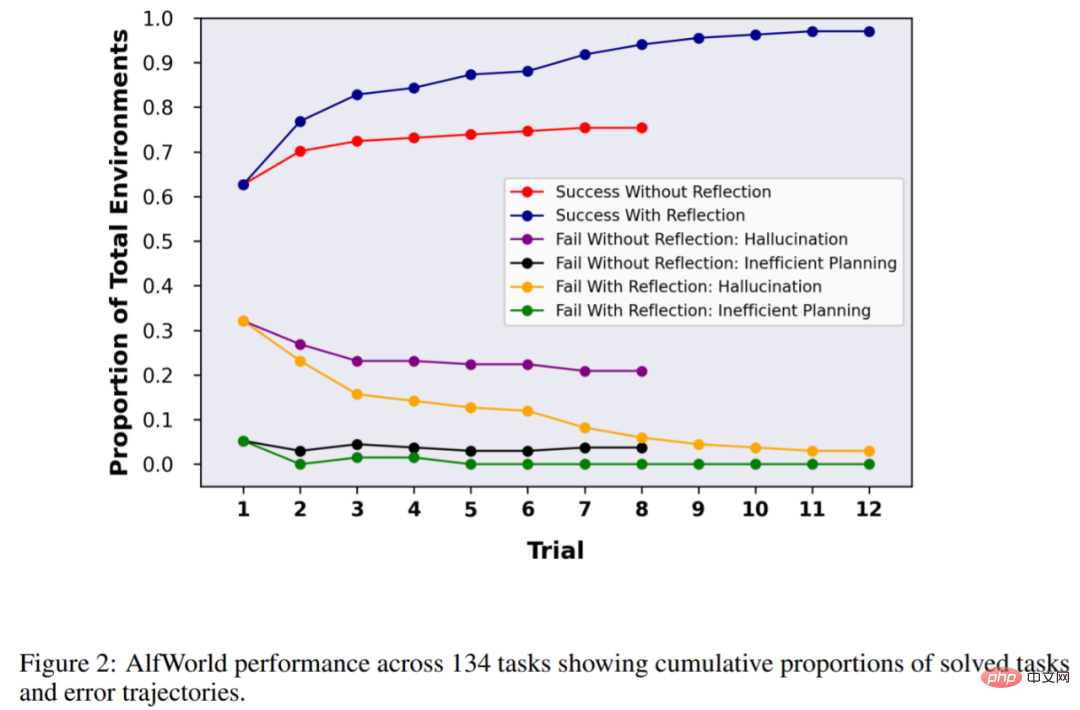

Ohne Reflexion beträgt die Genauigkeit des Agenten 63 %, und dann wird Reflexion zum Vergleich hinzugefügt. Die Ergebnisse zeigten, dass der Agent in 12 Versuchen 97 % der Umgebung bewältigen konnte und nur 4 von 134 Aufgaben nicht lösen konnte.

Das nächste Experiment wurde in HotPotQA durchgeführt, einem auf Wikipedia basierenden Datensatz, der 113.000 Frage- und Antwortpaare enthält. Er wird hauptsächlich verwendet, um die Fähigkeit des Agenten zu testen, Inhalte und Gründe zu analysieren.

Bei den 100 Frage-Antwort-Paartests von HotpotQA verglich die Studie Basisagenten und auf Reflexion basierende Agenten, bis es ihnen in aufeinanderfolgenden Versuchen nicht gelang, die Genauigkeit zu verbessern. Die Ergebnisse zeigen, dass sich die Leistung des Basisagenten nicht verbessert hat. Im ersten Test betrug die Genauigkeit des Basisagenten 34 % und die Genauigkeit des Reflexionsagenten betrug 32 % Der Wirkstoff hat sich deutlich verbessert. Die Verbesserung liegt bei fast 30 %, was viel besser ist als beim Basiswirkstoff.

In ähnlicher Weise übertraf GPT-4 mit Reflexion auch das reguläre GPT-4 deutlich, als es die Fähigkeit des Modells zum Schreiben von Code testete:

Das obige ist der detaillierte Inhalt vonAls GPT-4 über seinen Fehler nachdachte: Die Leistung stieg um fast 30 % und die Programmierfähigkeit um 21 %. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr