Heim >Technologie-Peripheriegeräte >KI >Bei einer erneuten Untersuchung des Prompt-Optimierungsproblems macht die Vorhersageverzerrung das Lernen im Kontext des Sprachmodells stärker

Bei einer erneuten Untersuchung des Prompt-Optimierungsproblems macht die Vorhersageverzerrung das Lernen im Kontext des Sprachmodells stärker

- 王林nach vorne

- 2023-04-04 11:40:011429Durchsuche

LLMs haben beim Lernen im Kontext gute Leistungen erzielt, aber die Auswahl verschiedener Beispiele führt zu völlig unterschiedlichen Leistungen. Eine aktuelle Forschungsarbeit schlägt eine schnelle Suchstrategie aus der Perspektive der Vorhersageverzerrung vor und findet ungefähr die optimale Kombination von Beispielen. ?? Aufgrund der erstaunlichen Fähigkeit können diese Modelle aus dem Kontext lernen, der aus einigen Eingabe- und Ausgabebeispielen erstellt wurde, und ohne Feinabstimmung der Optimierung direkt auf viele nachgelagerte Aufgaben angewendet werden. Frühere Untersuchungen haben jedoch gezeigt, dass kontextuelles Lernen aufgrund von Änderungen in den Trainingsbeispielen, der Beispielreihenfolge und den Aufforderungsformaten ein hohes Maß an Instabilität aufweisen kann. Daher ist die Erstellung geeigneter Eingabeaufforderungen von entscheidender Bedeutung, um die Leistung des kontextuellen Lernens zu verbessern.

Frühere Untersuchungen untersuchen dieses Problem normalerweise aus zwei Richtungen: (1) sofortige Optimierung im Codierungsraum (prompte Abstimmung), (2) Suche im ursprünglichen Raum (prompte Suche).

- Ein praktikablerer und effizienterer Ansatz besteht darin, die Eingabeaufforderungen zu optimieren, indem der ursprüngliche Textbereich nach ungefähren Demonstrationsbeispielen und -sequenzen durchsucht wird. Einige funktionieren beim Erstellen von Eingabeaufforderungen aus der „Globalen Ansicht“ oder der „Lokalen Ansicht“. Auf globalen Ansichten basierende Methoden optimieren normalerweise die verschiedenen Elemente der Eingabeaufforderung als Ganzes, um eine bessere Leistung zu erzielen. Diversitätsgesteuerte Ansätze [1] nutzen beispielsweise die Gesamtvielfalt der Demonstrationen für die Suche aus oder versuchen, die gesamte Reihenfolge der Stichprobenkombinationen zu optimieren [2], um eine bessere Leistung zu erzielen. Im Gegensatz zur globalen Ansicht funktionieren auf der lokalen Ansicht basierende Methoden, indem sie unterschiedliche heuristische Auswahlkriterien entwerfen, wie z. B. KATE [3].

- Aber diese Methoden haben ihre eigenen Grenzen: (1) Die meisten aktuellen Forschungen konzentrieren sich hauptsächlich auf die Suche nach Hinweisen entlang eines einzelnen Faktors, wie z. B. Beispielauswahl oder -reihenfolge. Der Gesamteinfluss jedes Faktors auf die Leistung ist jedoch unklar. (2) Diese Methoden basieren in der Regel auf heuristischen Kriterien und erfordern eine einheitliche Perspektive, um die Funktionsweise dieser Methoden zu erklären. (3) Noch wichtiger ist, dass vorhandene Methoden Hinweise global oder lokal optimieren, was zu einer unbefriedigenden Leistung führen kann.

Darüber hinaus ermöglicht diese voreingenommene Metrik der Methode, „lokal bis global“ nach geeigneten Eingabeaufforderungen zu suchen. Ein realistisches Problem besteht jedoch darin, dass es nicht möglich ist, durch Durchlaufen aller Kombinationen nach der optimalen Lösung zu suchen, da ihre Komplexität O (N!) überschreiten würde.

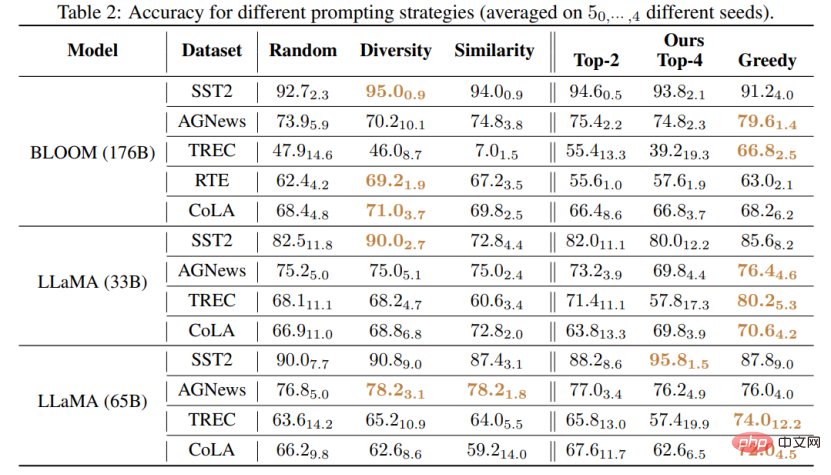

Diese Arbeit schlägt zwei neuartige Strategien vor, um auf effiziente Weise nach qualitativ hochwertigen Eingabeaufforderungen zu suchen: (1) T-fair-Prompting (2) G-fair-Prompting. T-fair-Prompting verwendet einen intuitiven Ansatz, bei dem zunächst die Abweichung jedes einzelnen Beispiels berechnet wird, das einen Prompt bildet, und dann die Top-k-fairsten Beispiele ausgewählt werden, um sie zum endgültigen Prompt zu kombinieren. Diese Strategie ist mit einer Komplexität von O (N) recht effizient. Es sollte jedoch beachtet werden, dass T-fair-Prompting auf der Annahme basiert, dass der optimale Prompt normalerweise aus den am wenigsten verzerrten Beispielen konstruiert wird. Dies trifft jedoch in der Praxis möglicherweise nicht zu und führt oft zu lokal optimalen Lösungen. Daher wird G-fair-Prompting im Artikel weiter vorgestellt, um die Suchqualität zu verbessern. G-fair-Prompting folgt dem regulären Prozess der gierigen Suche, um die optimale Lösung zu finden, indem bei jedem Schritt lokal optimale Entscheidungen getroffen werden. Bei jedem Schritt des Algorithmus werden Beispiele so ausgewählt, dass die aktualisierte Eingabeaufforderung optimale Fairness mit einer Zeitkomplexität im ungünstigsten Fall von O (N^2) erreicht, was die Suchqualität erheblich verbessert. G-fair-Prompting funktioniert aus einer lokal-globalen Perspektive, wobei die Verzerrung einzelner Stichproben in den frühen Phasen berücksichtigt wird, während sich die späteren Phasen auf die Reduzierung der globalen Vorhersageverzerrung konzentrieren.

Experimentelle Ergebnisse

Diese Studie schlägt eine effektive und interpretierbare Methode zur Verbesserung der Kontextlernleistung von Sprachmodellen vor, die auf verschiedene nachgelagerte Aufgaben angewendet werden kann. Der Artikel überprüft die Wirksamkeit dieser beiden Strategien bei verschiedenen LLMs (einschließlich der GPT-Modellreihe und der kürzlich veröffentlichten LMaMA-Reihe). Im Vergleich zur SOTA-Methode erzielte G-fair-Prompting mehr als 10 % bei verschiedenen nachgelagerten Aufgaben .

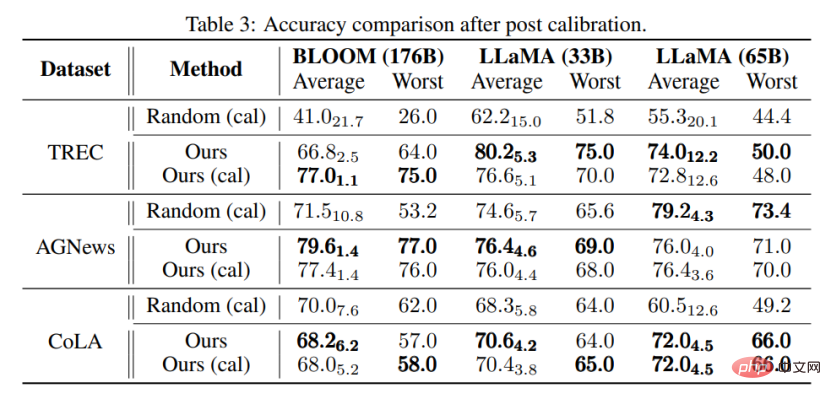

Am nächsten kommt dieser Forschung die Methode „Kalibrierung vor der Verwendung“ [4], die beide „inhaltsfreie“ Eingaben verwenden, um die Modellleistung zu verbessern. Die Methode „Kalibrierung vor der Verwendung“ ist jedoch darauf ausgelegt, diesen Standard zur Kalibrierung der Ausgabe zu verwenden, was jedoch immer noch von der Qualität der verwendeten Beispiele abhängt. Im Gegensatz dazu zielt dieser Artikel darauf ab, den ursprünglichen Raum zu durchsuchen, um eine nahezu optimale Eingabeaufforderung zur Verbesserung der Leistung des Modells zu finden, ohne dass die Modellausgabe nachbearbeitet werden muss. Darüber hinaus ist dieser Artikel der erste, der durch umfangreiche Experimente den Zusammenhang zwischen Vorhersageverzerrung und endgültiger Aufgabenleistung demonstriert, der bei Methoden zur Kalibrierung vor der Verwendung noch nicht untersucht wurde.

Durch Experimente kann auch festgestellt werden, dass die mit der in diesem Artikel vorgeschlagenen Methode ausgewählten Eingabeaufforderungen auch ohne Kalibrierung besser sein können als die kalibrierten, zufällig ausgewählten Eingabeaufforderungen. Dies zeigt, dass die Methode in praktischen Anwendungen praktisch und effektiv sein und Inspiration für zukünftige Forschung zur Verarbeitung natürlicher Sprache liefern kann.

Das obige ist der detaillierte Inhalt vonBei einer erneuten Untersuchung des Prompt-Optimierungsproblems macht die Vorhersageverzerrung das Lernen im Kontext des Sprachmodells stärker. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr