Heim >Technologie-Peripheriegeräte >KI >GPT-4 ist so mächtig, dass OpenAI sich weigert, es zu öffnen! Chefwissenschaftler: Open Source ist nicht schlau, wir haben uns vorher geirrt

GPT-4 ist so mächtig, dass OpenAI sich weigert, es zu öffnen! Chefwissenschaftler: Open Source ist nicht schlau, wir haben uns vorher geirrt

- PHPznach vorne

- 2023-03-31 22:40:021386Durchsuche

OpenAI-Mitbegründer Greg Brockman und Chefwissenschaftler Ilya Sutskever bewerten die Leistung von GPT-4 und erläutern Sicherheitsprobleme und Open-Source-Kontroversen.

Es besteht kein Zweifel daran, dass die Veröffentlichung von GPT-4 die gesamte Industrie und Wissenschaft in Aufruhr versetzte.

Mit seiner überzeugenden Argumentation und seinen multimodalen Fähigkeiten hat es viele hitzige Diskussionen ausgelöst.

GPT-4 ist jedoch kein offenes Modell.

Obwohl OpenAI eine große Anzahl von Benchmarks und Testergebnissen von GPT-4 geteilt hat, stellte es im Wesentlichen nicht die für das Training verwendeten Daten, die Kosten oder die Methode zur Erstellung des Modells bereit.

Ein solches „exklusives Geheimnis“ wird OpenAI natürlich definitiv nicht verraten.

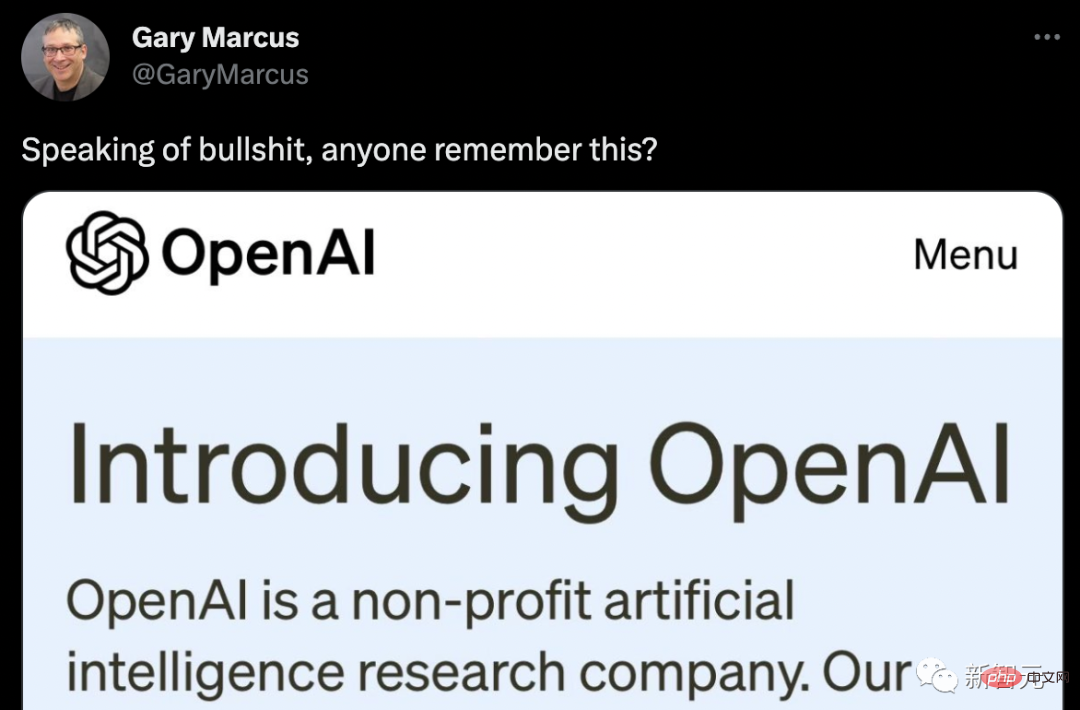

Marcus hat die ursprüngliche Absicht von OpenAI direkt herausgenommen und eine Welle des Spottes gepostet.

Netizens haben eine Version verbessert.

Niemand ist perfekt, und GPT-4 auch.

Als Greg Brockman, Präsident und Mitbegründer von OpenAI, GPT-4 und GPT-3 verglich, sagte er ein Wort – anders.

„Es ist einfach anders, das Modell hat immer noch viele Probleme und Fehler ... aber man kann wirklich sehen, dass es die Fähigkeiten in Dingen wie Analysis oder Recht verbessert. In einigen Bereichen hat es sich von einer wirklich schlechten Leistung zu weit genug entwickelt, um mit Menschen mithalten zu können.“ „

Die Testergebnisse von GPT-4 sind sehr gut: Bei der AP Calculus BC-Prüfung erzielte GPT-4 4 Punkte, während GPT-3 1 Punkt erzielte. Bei der simulierten Anwaltsprüfung bestand GPT-4 mit einer Punktzahl von etwa den besten 10 % der Kandidaten; die Punktzahl von GPT-3.5 lag bei den unteren 10 %.

In Bezug auf die kontextuellen Fähigkeiten, also den Text, der vor der Textgenerierung gespeichert werden kann, kann sich GPT-4 etwa 50 Seiten Inhalt merken, was achtmal so viel ist wie GPT-3.

In Bezug auf Eingabeaufforderungen können GPT-3 und GPT-3.5 nur Textaufforderungen akzeptieren: „Schreiben Sie einen Artikel über Giraffen“, während das multimodale GPT-4 Bild- und Textaufforderungen akzeptieren kann: Geben Sie ein Bild einer Giraffe Das Bild stellt die Frage „Wie viele Giraffen gibt es hier?“ Diese kann GPT-4 richtig beantworten, und seine Fähigkeit, Memes zu lesen, ist auch sehr stark!

Wir haben uns vorher geirrt, Open Source ist nicht klug

Und sobald das lächerlich leistungsstarke GPT-4 veröffentlicht wurde, weckte es das Interesse einer großen Anzahl von Forschern und Experten. Was jedoch enttäuschend ist, ist, dass das von OpenAI veröffentlichte GPT-4 kein „Open AI-Modell“ ist.

Obwohl OpenAI eine große Anzahl von Benchmarks, Testergebnissen und interessanten Demonstrationen von GPT-4 geteilt hat, bietet es im Grunde keine Schulung Daten über das System, Energiekosten oder Informationen über die spezifische Hardware oder Methoden, mit denen es erstellt wurde.

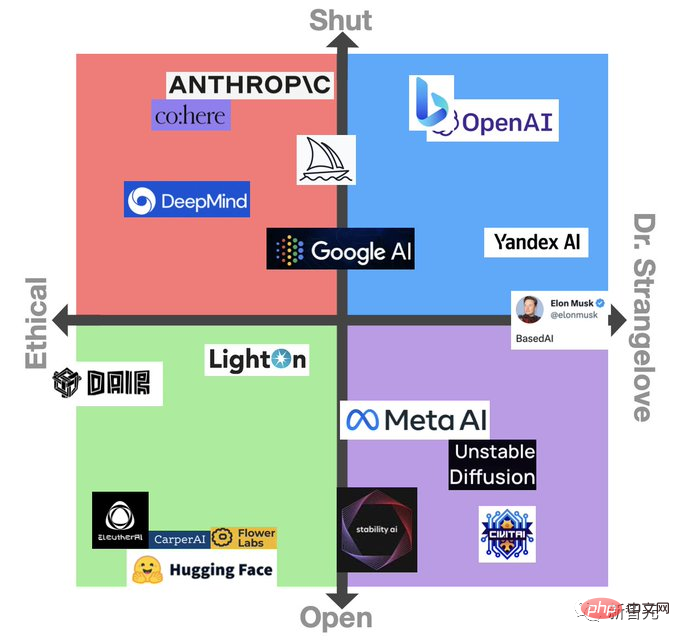

Als das LLaMa-Modell von Meta zuvor durchgesickert war, löste dies eine Welle von Diskussionen über Open Source aus. Allerdings war die erste Reaktion aller auf das geschlossene GPT-4-Modell dieses Mal überwiegend negativ.

Die Community der künstlichen Intelligenz ist allgemein davon überzeugt, dass dies nicht nur den Gründungsgeist von OpenAI als Forschungseinrichtung untergräbt, sondern es auch anderen erschwert, Schutzmaßnahmen für den Umgang mit Bedrohungen zu entwickeln.

Ben Schmidt, Vizepräsident für Informationsdesign bei Nomic AI, sagte, dass es für jeden schwierig sei, zu wissen, wo das System sicher verwendet werden kann, und Reparaturlösungen vorzuschlagen, da es unmöglich sei, zu sehen, auf welchen Daten GPT-4 trainiert wurde.

„Damit die Leute wissen, wo dieses Modell nicht funktioniert, muss OpenAI besser verstehen, was GPT-4 tut und welche Annahmen es trifft. Ich werde niemandem in einem schneereichen Klima vertrauen, wenn es schneit. Trainierte selbstfahrende Autos, denn es ist sehr wahrscheinlich, dass Schlupflöcher und Probleme erst dann auftauchen, wenn sie tatsächlich genutzt werden.“ In diesem Zusammenhang erklärte Ilya Sutskever, Chefwissenschaftler und Mitbegründer von OpenAI: „OpenAI teilt nicht mehr über GPT mit. Das gibt es.“ Es besteht kein Zweifel, dass die -4-Informationen auf Konkurrenzangst und Sicherheitsbedenken zurückzuführen sind.

„Der Wettbewerb draußen ist hart und die Entwicklung von GPT-4 ist nicht einfach. Fast alle OpenAI-Mitarbeiter haben lange Zeit zusammengearbeitet, um dieses Ding zu produzieren. Aus Wettbewerbssicht gibt es viele, viele Unternehmen, die das wollen.“ Wenn man das Gleiche tut, ist GPT-4 wie eine reife Frucht.“

Wie wir alle wissen, war OpenAI bei seiner Gründung im Jahr 2015 eine gemeinnützige Organisation. Zu den Gründern gehören Sutskever, der derzeitige CEO Sam Altman, Präsident Greg Brockman und Musk, der OpenAI inzwischen verlassen hat.

Sutskever und andere haben erklärt, dass das Ziel der Organisation darin besteht, Mehrwert für alle und nicht nur für die Aktionäre zu schaffen, und erklärt, dass sie mit allen Parteien in diesem Bereich „frei zusammenarbeiten“ werden.

Um jedoch Investitionen in Milliardenhöhe (hauptsächlich von Microsoft) zu erhalten, wurde OpenAI mit einer Reihe kommerzieller Attribute ausgestattet.

Auf die Frage, warum OpenAI seinen Ansatz zum Teilen seiner Forschungsergebnisse geändert habe, antwortete Sutskever jedoch einfach:

„Wir haben uns geirrt. Irgendwann wird KI/AGI extrem mächtig werden, und dann wird Open Source keinen Sinn mehr ergeben. Es ist zu erwarten, dass innerhalb weniger Jahre jeder völlig verstehen wird, dass Open Source KI unklug ist.“ Da dieses Modell sehr mächtig ist, wäre es ziemlich einfach, großen Schaden anzurichten. Wenn die Fähigkeiten des Modells also immer höher werden, ist es sinnvoll, sie nicht preisgeben zu wollen.“

William Falcon, CEO von Lightning AI und Entwickler des Open-Source-Tools PyTorch Lightning erklärte aus geschäftlicher Sicht: „Als Unternehmen haben Sie jedes Recht dazu.“

Sicherheitsrisiken

Gleichzeitig glaubt Brockman auch an die Einführung Die Entwicklung von GPT-4 sollte langsam voranschreiten, während OpenAI die Risiken und Vorteile abwägt.

„Wir müssen einige politische Probleme lösen, wie zum Beispiel die Gesichtserkennung und den Umgang mit Bildern von Menschen. Wir müssen herausfinden, wo die Gefahrenzone liegt, wo die rote Linie liegt, und diese Punkte dann langsam klären

.“ Und das Klischee: Das Risiko, dass GPT-4 für schlechte Dinge genutzt wird.

Adversa AI, ein israelisches Cybersicherheits-Startup, hat einen Blogbeitrag veröffentlicht, der zeigt, wie man die Inhaltsfilter von OpenAI umgeht und es GPT-4 ermöglicht, Phishing-E-Mails, sexuelle Beschreibungen von Homosexuellen und andere höchst anstößige Texte zu generieren.

Daher erhoffen sich viele von GPT-4 deutliche Verbesserungen bei der Moderation.

Als Antwort darauf betonte Brockman, dass sie viel Zeit damit verbracht hätten, die Fähigkeiten von GPT-4 zu verstehen, und dass das Modell ein sechsmonatiges Sicherheitstraining durchlaufen habe. In internen Tests reagierte GPT-4 mit einer um 82 % geringeren Wahrscheinlichkeit als GPT-3.5 auf Inhalte, die von der Nutzungsrichtlinie von OpenAI nicht zugelassen wurden, und lieferte mit einer um 40 % höheren Wahrscheinlichkeit „sachliche“ Antworten.

Brockman bestreitet jedoch nicht, dass GPT-4 diesbezüglich Mängel aufweist. Er hob jedoch das neue auf Schadensbegrenzung ausgerichtete Tool des Modells hervor, eine Funktion auf API-Ebene namens „Systeminformationen“.

Systemnachrichten sind im Wesentlichen Anweisungen, die den Ton angeben und Grenzen für GPT-4-Interaktionen festlegen. Auf diese Weise kann die Verwendung von Systeminformationen als Leitplanke verhindern, dass GPT-4 von der Richtung abweicht.

Zum Beispiel könnte die Persona einer Systemnachricht so aussehen: „Sie sind ein Tutor, der Fragen immer auf sokratische Weise beantwortet. Sie geben den Schülern nie Antworten, sondern versuchen immer, die richtigen Fragen zu stellen und ihnen zu helfen, das Denken zu lernen.“ „

Neuer Weg

Tatsächlich stimmt Sutskever bis zu einem gewissen Grad auch mit den Kritikern überein: „Wenn mehr Menschen bereit sind, diese Modelle zu studieren, werden wir mehr über sie wissen, und das ist eine gute Sache.“ „

Aus diesen Gründen gewährt OpenAI bestimmten akademischen und Forschungseinrichtungen Zugriff auf seine Systeme.

Und Brockman erwähnte auch Evals, das neue Open-Source-Software-Framework von OpenAI zur Bewertung der Leistung seiner Modelle für künstliche Intelligenz.

Evals nutzt Crowdsourcing für Modelltests und ermöglicht es Benutzern, Benchmarks für die Bewertung von Modellen wie GPT-4 zu entwickeln und durchzuführen und gleichzeitig deren Leistung zu überprüfen. Dies ist auch eines der Zeichen für das Engagement von OpenAI für „solide“ Modelle.

「Durch Evals können wir die Anwendungsfälle sehen, die den Benutzern wichtig sind, und sie in systematischer Form testen. Ein Grund dafür, dass wir Open Source sind, ist, dass wir nicht mehr alle drei Monate ein neues Modell veröffentlichen Wenn wir eine neue Modellversion erstellen, können wir durch Open Source zumindest wissen, welche Änderungen es gibt. Einerseits beeilen sich Technologiegiganten wie Google und Microsoft, ihre Produkte um KI-Funktionen zu erweitern, und andererseits haben sie frühere ethische Bedenken beiseite geschoben ; Schnelle Fortschritte in der Technologie haben Bedenken hinsichtlich der künstlichen Intelligenz geweckt.

Jess Whittlestone, Leiterin der britischen KI-Politik, sagte, dass die Ausbalancierung dieser unterschiedlichen Belastungen ernsthafte Governance-Herausforderungen mit sich bringt, was bedeutet, dass wir möglicherweise die Einbeziehung externer Regulierungsbehörden benötigen.

Jess Whittlestone, Leiterin der britischen KI-Politik, sagte, dass die Ausbalancierung dieser unterschiedlichen Belastungen ernsthafte Governance-Herausforderungen mit sich bringt, was bedeutet, dass wir möglicherweise die Einbeziehung externer Regulierungsbehörden benötigen.

„Die Absicht von OpenAI, keine weiteren Details zu GPT-4 preiszugeben, ist gut, aber es kann auch zu einer Zentralisierung der Macht in der Welt der künstlichen Intelligenz führen. Diese Entscheidungen sollten nicht von einzelnen Unternehmen getroffen werden.“

Whittlestone sagte: „ Idealerweise müssen wir hier die Praktiken kodifizieren und dann unabhängige Dritte die mit bestimmten Modellen verbundenen Risiken überprüfen lassen.“

Das obige ist der detaillierte Inhalt vonGPT-4 ist so mächtig, dass OpenAI sich weigert, es zu öffnen! Chefwissenschaftler: Open Source ist nicht schlau, wir haben uns vorher geirrt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr