Heim >Technologie-Peripheriegeräte >KI >Wenn GPT-4 lernt, Bilder und Texte zu lesen, ist eine Produktivitätsrevolution unaufhaltsam

Wenn GPT-4 lernt, Bilder und Texte zu lesen, ist eine Produktivitätsrevolution unaufhaltsam

- 青灯夜游nach vorne

- 2023-03-31 22:38:411835Durchsuche

Viele Forscher aus Wissenschaft und Industrie führten ausführliche Diskussionen zum Thema „Intelligente Bild- und Textverarbeitungstechnologie und Multi-Szenario-Anwendungstechnologie“.

„Es ist zu kompliziert!“

Nach dem Erleben von GPT-4 und Microsoft Microsoft 365 Copilot After Angesichts der ständigen Bombenangriffe glaube ich, dass viele Menschen dieses Gefühl haben.

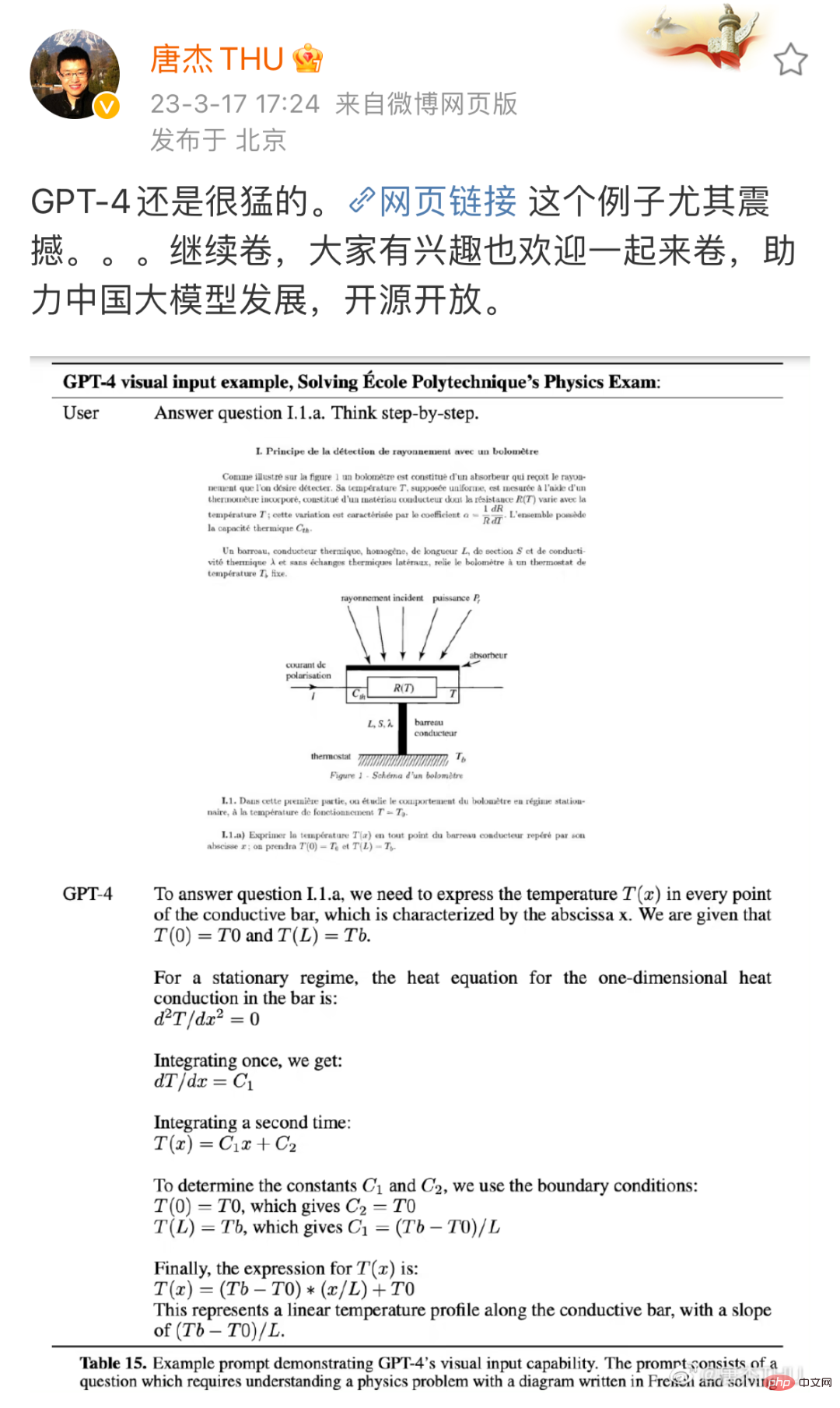

Im Vergleich zu GPT-3.5 hat GPT-4 in vielen Aspekten erhebliche Verbesserungen erzielt. Beispielsweise hat es sich bei der simulierten Anwaltsprüfung von den ursprünglichen unteren 10 % auf positive 10 % entwickelt. Natürlich haben normale Menschen möglicherweise keine Ahnung von diesen Berufsprüfungen. Aber wenn ich Ihnen ein Bild zeige, werden Sie verstehen, wie erschreckend die Verbesserung ist:

Quelle: Tang Jie, Professor der Computerabteilung der Tsinghua-Universität, Weibo. Link: https://m.weibo.cn/detail/4880331053992765

Dies ist eine physikalische Frage, die erforderlich ist, um das Problem Schritt für Schritt anhand von Bildern und Texten zu lösen. Dies ist GPT-3.5 zum ChatGPT vor dem Upgrade) Abhängige Modelle) verfügen nicht über Funktionen. Einerseits ist GPT-3.5 nur darauf trainiert, Text zu verstehen, das Bild in der Frage kann es jedoch nicht verstehen. Andererseits ist die Problemlösungsfähigkeit von GPT-3.5 auch sehr schwach und kann von einem Huhn und einem Kaninchen im selben Käfig überwältigt werden. Aber dieses Mal scheinen beide Probleme wunderbar gelöst worden zu sein.

Gerade als alle dachten, das sei eine große Sache, veröffentlichte Microsoft einen weiteren Blockbuster: GPT-4. Diese Funktionen wurden in eine neue Anwendung namens Microsoft 365 Copilot integriert. Mit seinen leistungsstarken Bild- und Textverarbeitungsfunktionen kann Microsoft 365 Copilot Ihnen nicht nur beim Schreiben verschiedener Dokumente helfen, sondern auch problemlos Dokumente in PPT konvertieren und Excel-Daten automatisch in Diagrammen zusammenfassen ...

Vom Technologiedebüt bis zur Produkteinführung. OpenAI und Microsoft gaben der Öffentlichkeit nur zwei Tage Zeit, um zu antworten. Scheinbar über Nacht hat eine neue Produktivitätsrevolution begonnen.

Da sich Veränderungen so schnell vollziehen, befinden sich sowohl die Wissenschaft als auch die Industrie mehr oder weniger in einem Zustand der Verwirrung und „FOMO (Angst, etwas zu verpassen)“. Derzeit möchte jeder eine Antwort wissen: Was können wir in dieser Welle tun? Welche Möglichkeiten gibt es? In der von Microsoft veröffentlichten Demo können wir einen klaren Durchbruch erkennen: Intelligente Bild- und Textverarbeitung.

In realen Szenarien hängen viele Jobs in verschiedenen Branchen mit der Grafik- und Textverarbeitung zusammen, z. B. dem Organisieren unstrukturierter Daten in Diagrammen, dem Schreiben von Berichten auf der Grundlage von Diagrammen, dem Extrahieren nützlicher Informationen aus umfangreichen grafischen Informationen usw. Aus diesem Grund könnten die Auswirkungen dieser Revolution weitaus tiefgreifender sein, als sich viele Menschen vorstellen. Ein aktuelles Blockbuster-Papier von OpenAI und der Wharton School prognostiziert diese Auswirkungen: Bei etwa 80 % der US-Arbeitskräfte könnten mindestens 10 % ihrer Arbeitsaufgaben von der Einführung von GPT betroffen sein, und etwa 19 % der Arbeitnehmer werden wahrscheinlich mindestens davon betroffen sein 50 % der Aufgaben betroffen. Es ist absehbar, dass ein großer Teil der Arbeit grafische und textliche Intelligenz beinhaltet.

Welche Forschungsanstrengungen oder technischen Anstrengungen sind an einem solchen Einstiegspunkt eine Erkundung wert? Bei der jüngsten CSIG Enterprise Tour-Veranstaltung, die von der Chinese Society of Image and Graphics (CSIG) veranstaltet und gemeinsam von Hehe Information und dem CSIG Document Image Analysis and Recognition Professional Committee organisiert wurde, konzentrierten sich viele Forscher aus Wissenschaft und Industrie auf „Intelligente Verarbeitung von Bildern und Text „Technologie und Multi-Szenario-Anwendungstechnologie “ führte eine ausführliche Diskussion durch, die Forschern und Praktikern, die sich mit dem Bereich der intelligenten Bild- und Textverarbeitung befassen, Inspiration bieten kann.

Die Verarbeitung von Grafiken und Text beginnt mit der zugrunde liegenden Vision

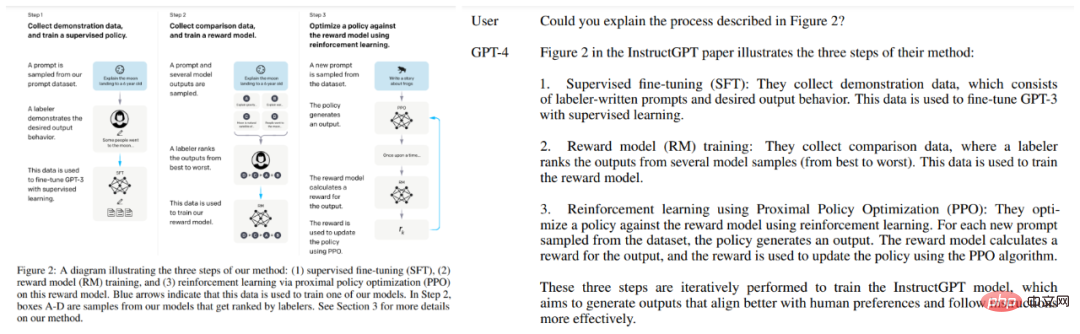

Wie bereits erwähnt, sind die Grafik- und Textverarbeitungsfähigkeiten von GPT-4 sehr schockierend. Zusätzlich zu der oben genannten physikalischen Frage wurden im technischen Bericht von OpenAI auch andere Beispiele angeführt, wie beispielsweise die Möglichkeit, GPT-4 das Papierbild lesen zu lassen: Die zugrunde liegende Vision ist eine davon.

Die Merkmale der zugrunde liegenden Vision sind sehr offensichtlich: Die Eingabe ist ein Bild und die Ausgabe ist ebenfalls ein Bild. In diese Kategorie fallen Bildvorverarbeitung, Filterung, Wiederherstellung und Verbesserung.

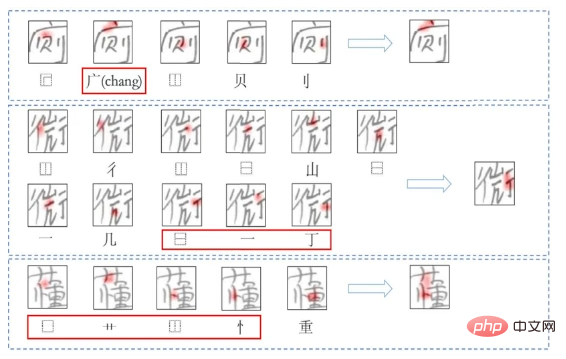

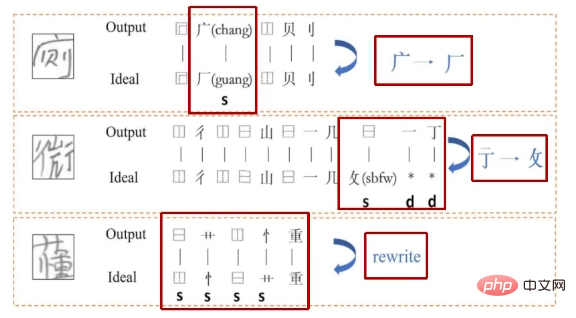

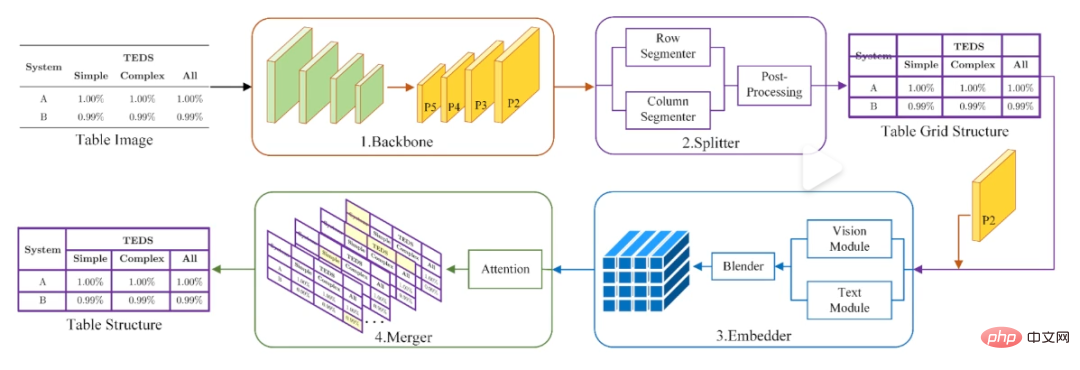

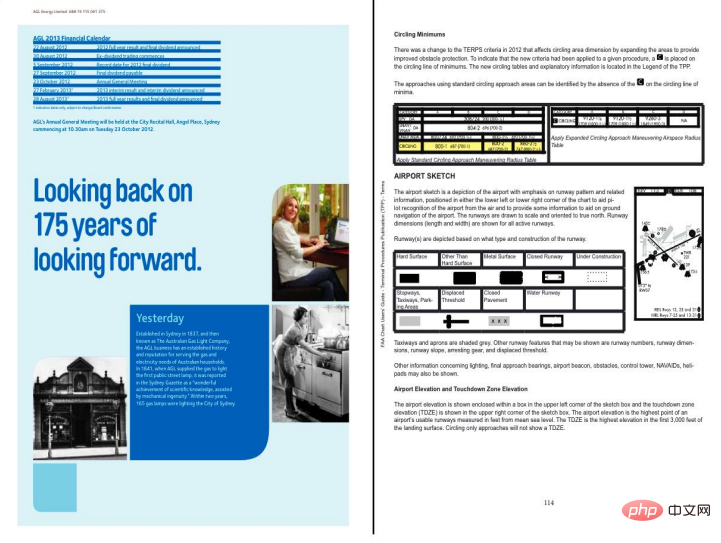

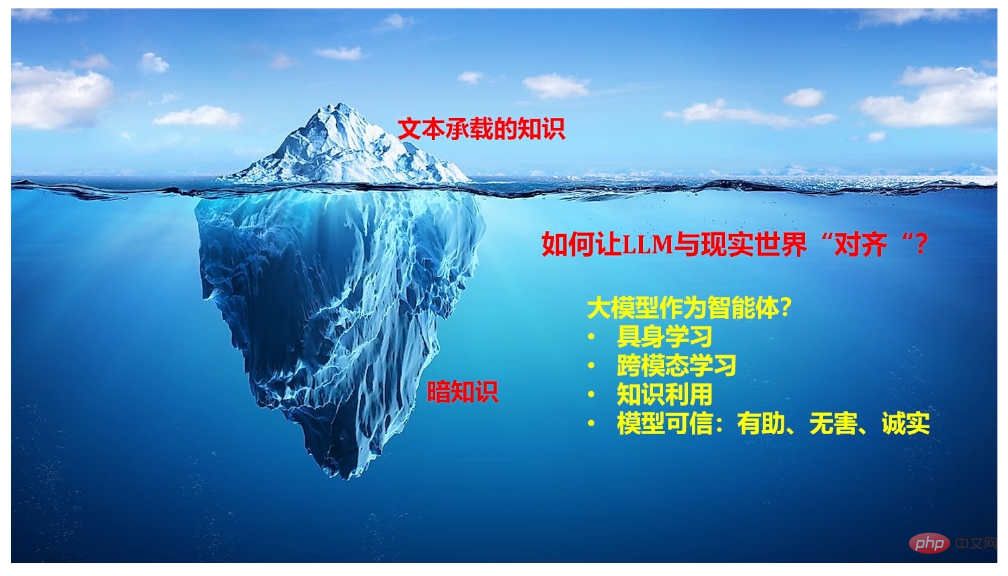

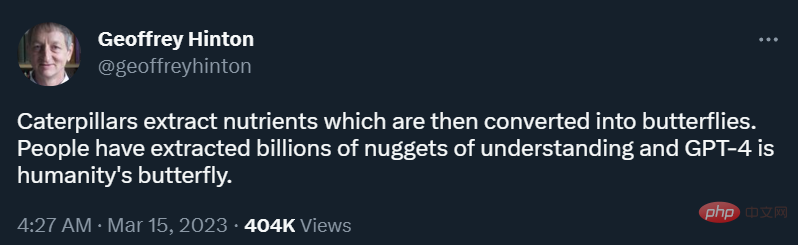

Anders als in der Idealsituation, die in OpenAI- und Microsoft-Demos gezeigt wird, liegen reale Grafiken und Texte immer in anspruchsvollen Formen vor, wie z. B. Verformungen, Schatten und Moiré-Mustern, was die Schwierigkeit des späteren Erkennens und Verstehens erhöht. Das Ziel des Teams von Guo Fengjun ist es, diese Probleme in der Anfangsphase zu lösen. Zu diesem Zweck haben sie diese Aufgabe in mehrere Module unterteilt, darunter die Extraktion des interessierenden Bereichs (RoI), die Verformungskorrektur, die Bildwiederherstellung (z. B. Schattenentfernung, Moiré) und die Qualitätsverbesserung (z. B. verbesserte Schärfung, Klarheit). Durch die Kombination dieser Technologien können einige sehr interessante Anwendungen entstehen. Nach Jahren der Erforschung haben diese Module recht gute Ergebnisse erzielt und die entsprechende Technologie wurde auf das intelligente Texterkennungsprodukt „Scanner“ des Unternehmens angewendet. Nachdem das Bild verarbeitet wurde, besteht der nächste Schritt darin, den Inhalt des Bildes und des Textes zu identifizieren. Dies ist ebenfalls eine sehr detaillierte Arbeit und kann sogar in Einheiten von „Wörtern“ durchgeführt werden. In vielen realen Szenarien erscheinen Zeichen möglicherweise nicht unbedingt in standardisierter Druckform, was die Zeichenerkennung vor Herausforderungen stellt. Nehmen Sie die Bildungsszene als Beispiel. Angenommen, Sie sind Lehrer und möchten auf jeden Fall, dass die KI Ihnen direkt dabei hilft, die Hausaufgaben aller Schüler zu korrigieren und gleichzeitig die Beherrschung der einzelnen Teile des Wissens zusammenzufassen. Geben Sie am besten auch falsche Fragen, Tippfehler und Korrekturen Vorschläge. Du Jun, außerordentlicher Professor am National Engineering Laboratory for Speech and Language Information Processing an der University of Science and Technology of China, arbeitet in diesem Bereich. Konkret haben sie ein System zur Erkennung, Erzeugung und Bewertung chinesischer Schriftzeichen entwickelt, das auf Radikalen basiert, da es im Vergleich zur Modellierung ganzer Schriftzeichen viel weniger Kombinationen von Radikalen gibt. Unter ihnen werden Erkennung und Generierung gemeinsam optimiert, was ein wenig dem Prozess der gegenseitigen Stärkung der Lese- und Schreibfähigkeit beim Lernen der Schüler ähnelt. In der Vergangenheit konzentrierten sich die meisten Auswertungsarbeiten auf die grammatikalische Ebene, doch Du Juns Team hat eine Methode entwickelt, die Tippfehler direkt im Bild finden und die Fehler detailliert erklären kann. Diese Methode wird in Szenarien wie der intelligenten Markierung sehr nützlich sein. Neben Text stellt die Identifizierung und Verarbeitung von Tabellen tatsächlich eine große Schwierigkeit dar, da nicht nur der darin enthaltene Inhalt identifiziert, sondern auch die strukturelle Beziehung zwischen diesen Inhalten geklärt werden muss, was bei einigen Tabellen möglicherweise nicht einmal der Fall ist Drahtgitter. Zu diesem Zweck entwickelte Du Juns Team eine Methode „Zuerst teilen, dann zusammenführen“, das heißt, das Tabellenbild wird zunächst in eine Reihe grundlegender Raster aufgeteilt und dann durch Zusammenführen weitere Korrekturen vorgenommen. Die Formularerkennungsmethode „Erst teilen, dann zusammenführen“ des Teams von Du Jun. Natürlich wird all diese Arbeit letztendlich eine Rolle bei der Strukturierung und dem Verständnis von Dokumenten auf Kapitelebene spielen. In realen Umgebungen umfassen die meisten Dokumente, mit denen Models konfrontiert werden, mehr als eine Seite (z. B. ein Papier). In dieser Richtung konzentriert sich die Arbeit von Du Juns Team auf die Klassifizierung seitenübergreifender Dokumentelemente und die Wiederherstellung seitenübergreifender Dokumentstruktur. Allerdings weisen diese Methoden in Multi-Layout-Szenarien immer noch Einschränkungen auf. Wenn es um die Verarbeitung und das Verständnis von Bildern und Texten auf Kapitelebene geht, sind wir tatsächlich nicht weit von GPT-4 entfernt. „Nachdem das multimodale GPT-4 herauskam, haben wir auch darüber nachgedacht, ob wir in diesen Aspekten etwas tun könnten“, sagte Du Jun auf der Veranstaltung. Ich glaube, dass viele Forscher oder Praktiker im Bereich der Bild- und Textverarbeitung diese Idee haben. Das Ziel der GPT-Modellreihe bestand schon immer darin, die Vielseitigkeit zu verbessern und letztendlich eine allgemeine künstliche Intelligenz (AGI) zu erreichen. Die leistungsstarken Bild- und Textverständnisfähigkeiten, die GPT-4 dieses Mal demonstriert, sind ein wichtiger Teil dieser allgemeinen Fähigkeit. Um ein Modell mit ähnlichen Fähigkeiten zu erstellen, hat OpenAI einige Hinweise gegeben, aber auch viele Rätsel und ungelöste Probleme hinterlassen. Zunächst einmal zeigt der Erfolg von GPT-4, dass der Ansatz von großem Modell + Multimodalität machbar ist. Welche Probleme in großen Modellen untersucht werden sollten und wie die überhöhten Anforderungen an die Rechenleistung multimodaler Modelle gelöst werden können, sind jedoch alles Herausforderungen, denen sich Forscher gegenübersehen. Zur ersten Frage gab Qiu Xipeng, Professor an der Fakultät für Informatik der Fudan-Universität, einige Hinweise, die es wert sind, erwähnt zu werden. Laut einigen zuvor von OpenAI veröffentlichten Informationen wissen wir, dass ChatGPT untrennbar mit mehreren Schlüsseltechnologien verbunden ist, darunter kontextbezogenes Lernen, Gedankenkette und Lernen aus Anweisungen. Qiu Xipeng wies in seinem Vortrag darauf hin, dass in dieser Richtung noch viele Fragen zu diskutieren seien, etwa woher diese Fähigkeiten kommen, wie man sich weiter verbessern könne und wie man sie nutzen könne, um bestehende Lernparadigmen zu transformieren. Darüber hinaus teilte er auch die Fähigkeiten mit, die bei der Erstellung groß angelegter Konversationssprachmodelle berücksichtigt werden sollten, und die Forschungsrichtungen, die in Betracht gezogen werden können, um diese Modelle mit der realen Welt in Einklang zu bringen. Zur zweiten Frage hat Nanqiang Distinguished Professor Ji Rongrong von der Universität Xiamen eine wichtige Idee beigesteuert. Er glaubt, dass es einen natürlichen Zusammenhang zwischen Sprache und Sehen gibt und dass gemeinsames Lernen zwischen beiden der allgemeine Trend ist. Aber angesichts dieser Welle ist die Macht einer Universität oder eines Labors unbedeutend. Ausgehend von der Xiamen-Universität, an der er arbeitet, versucht er nun, Forscher davon zu überzeugen, Rechenleistung zu integrieren und ein Netzwerk zu bilden, um große multimodale Modelle zu erstellen. Tatsächlich äußerte Akademiker E Weinan, der sich auf KI für die Wissenschaft konzentriert, bei einer Veranstaltung vor einiger Zeit ähnliche Ansichten und hoffte, dass alle Lebensbereiche „es wagen würden, Ressourcen in originelle Innovationsrichtungen zu bündeln“. Aber wird der von GPT-4 eingeschlagene Weg definitiv zu allgemeiner künstlicher Intelligenz führen? Einige Forscher stehen dem skeptisch gegenüber, und Turing-Preisträger Yann LeCun ist einer von ihnen. Er glaubt, dass diese aktuellen großen Modelle einen enormen Bedarf an Daten und Rechenleistung haben, ihre Lerneffizienz jedoch sehr gering ist (z. B. selbstfahrende Autos). Deshalb entwickelte er eine Theorie namens „Weltmodell“ (ein internes Modell der Funktionsweise der Welt) und glaubte, dass das Erlernen eines Weltmodells (das als Ausführen einer Simulation für die reale Welt verstanden werden kann) der Schlüssel zum Erreichen von AGI sein könnte. Bei der Veranstaltung teilte „Professor Yang Xiaokang von der Shanghai Jiao Tong University“ seine Arbeit in dieser Richtung mit. Sein Team konzentrierte sich insbesondere auf das Weltmodell der visuellen Intuition (da visuelle Intuition eine große Menge an Informationen enthält) und versuchte, Vision, Intuition und die Wahrnehmung von Zeit und Raum zu modellieren. Abschließend betonte er auch die Bedeutung der Schnittstelle zwischen Mathematik, Physik, Informationskognition und Computerdisziplinen für diese Art von Forschung. „Eine Raupe extrahiert Nährstoffe aus der Nahrung und verwandelt sich dann in einen Schmetterling. Die Menschen haben Milliarden von Hinweisen zum Verständnis extrahiert. GPT-4 ist der menschliche Schmetterling.“ Am Tag nach der Veröffentlichung von GPT-4 twitterte Deep-Learning-Pater Geoffrey Hinton Das. Von Wörtern über Tabellen bis hin zu Kapiteln: Lesen Sie Bilder und Texte Schritt für Schritt.

Großes Modell, Multimodalität, Weltmodell... Wo ist die Zukunft?

Derzeit kann niemand sagen, wie groß der Hurrikan sein wird, den dieser Schmetterling auslösen wird. Aber natürlich ist dies noch kein perfekter Schmetterling und das gesamte AGI-Welträtsel ist noch nicht vollständig. Jeder Forscher und Praktiker hat noch Möglichkeiten.

Derzeit kann niemand sagen, wie groß der Hurrikan sein wird, den dieser Schmetterling auslösen wird. Aber natürlich ist dies noch kein perfekter Schmetterling und das gesamte AGI-Welträtsel ist noch nicht vollständig. Jeder Forscher und Praktiker hat noch Möglichkeiten.

Das obige ist der detaillierte Inhalt vonWenn GPT-4 lernt, Bilder und Texte zu lesen, ist eine Produktivitätsrevolution unaufhaltsam. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr