Heim >Technologie-Peripheriegeräte >KI >„Reinforcement Learning' steht wieder auf der Titelseite von „Nature', und das neue Paradigma der Sicherheitsüberprüfung beim autonomen Fahren reduziert die Testkilometer erheblich

„Reinforcement Learning' steht wieder auf der Titelseite von „Nature', und das neue Paradigma der Sicherheitsüberprüfung beim autonomen Fahren reduziert die Testkilometer erheblich

- PHPznach vorne

- 2023-03-31 22:38:371977Durchsuche

Einführung von dichtem Verstärkungslernen und Verwendung von KI zur Verifizierung von KI.

Schnelle Fortschritte in der autonomen Fahrzeugtechnologie (AV) bringen uns an die Schwelle einer Transportrevolution in einem Ausmaß, wie es seit der Einführung des Automobils vor einem Jahrhundert nicht mehr stattgefunden hat. Autonome Fahrtechnologie hat das Potenzial, die Verkehrssicherheit, Mobilität und Nachhaltigkeit erheblich zu verbessern und hat daher die Aufmerksamkeit von Industrie, Regierungsbehörden, Berufsverbänden und akademischen Einrichtungen auf sich gezogen.

Die Entwicklung selbstfahrender Autos hat in den letzten 20 Jahren große Fortschritte gemacht, insbesondere mit dem Aufkommen von Deep Learning. Im Jahr 2015 begannen Unternehmen anzukündigen, dass sie bis 2020 AV-Geräte in Massenproduktion produzieren würden. Bisher ist jedoch kein AV der Stufe 4 auf dem Markt verfügbar.

Es gibt viele Gründe für dieses Phänomen, aber der wichtigste ist, dass die Sicherheitsleistung selbstfahrender Autos immer noch deutlich geringer ist als die von menschlichen Fahrern. Für den durchschnittlichen Fahrer in den Vereinigten Staaten beträgt die Wahrscheinlichkeit einer Kollision in der natürlichen Fahrumgebung (NDE) etwa 1,9 × 10^−6 pro Meile. Im Vergleich dazu liegt die Disengagement-Rate bei hochmodernen autonomen Fahrzeugen laut den kalifornischen Disengagement Reports 2021 bei etwa 2,0 × 10^−5/Meile.

Hinweis: Die Abschaltrate ist ein wichtiger Indikator zur Bewertung der Zuverlässigkeit des autonomen Fahrens. Sie beschreibt, wie oft das System alle 1.000 Betriebsmeilen eine Übernahme durch den Fahrer erfordert. Je niedriger die Abschaltrate des Systems ist, desto besser ist die Zuverlässigkeit. Wenn die Abschaltrate gleich 0 ist, bedeutet dies, dass das autonome Fahrsystem zu einem gewissen Grad das fahrerlose Niveau erreicht hat.

Obwohl die Abschaltrate als voreingenommen kritisiert werden kann, wird sie häufig zur Bewertung der Sicherheitsleistung autonomer Fahrzeuge verwendet.

Ein wesentlicher Engpass bei der Verbesserung der Sicherheitsleistung autonomer Fahrzeuge ist die geringe Effizienz der Sicherheitsüberprüfung. Derzeit ist es beliebt, die zerstörungsfreie Prüfung autonomer Fahrzeuge durch eine Kombination aus Softwaresimulation, geschlossener Teststrecke und Straßentests zu testen. Infolgedessen müssen AV-Entwickler erhebliche wirtschaftliche und zeitliche Kosten für die Evaluierung tragen, was den Fortschritt der AV-Bereitstellung behindert.

Die Überprüfung der AV-Sicherheitsleistung in einer NDE-Umgebung ist sehr komplex. Beispielsweise sind Fahrumgebungen räumlich und zeitlich komplex, sodass die zur Definition solcher Umgebungen erforderlichen Variablen hochdimensional sind. Mit der exponentiellen Zunahme der Dimensionalität von Variablen steigt auch die Rechenkomplexität. In diesem Fall sind Deep-Learning-Modelle selbst bei großen Datenmengen schwer zu erlernen.

In diesem Artikel schlagen Forscher der University of Michigan, Ann Arbor, der Tsinghua University und anderer Institutionen eine D2RL-Methode (Dense Deep Reinforcement Learning) vor, um diese Herausforderung zu lösen.

Diese Studie ist auf dem Cover von Nature.

- Papieradresse: https://www.nature.com/articles/s41586-023-05732-2

- Projektadresse: https://github.com/michigan-traffic-lab/Dense-Deep -Reinforcement-Learning

Nach dem Verfassen der Abschlussarbeit ist er derzeit Tenure-Track-Assistenzprofessor in der Abteilung für Automatisierung der Tsinghua-Universität. Darüber hinaus ist er auch wissenschaftlicher Mitarbeiter an der University of Michigan Verkehrsforschungsinstitut (UMTRI). Er erhielt seinen Bachelor- und Doktorgrad in den Jahren 2014 und 2019 am Department of Automation der Tsinghua-Universität unter der Leitung von Professor Zhang Yi. Von 2017 bis 2019 war er Gastdoktorand im Bau- und Umweltingenieurwesen an der University of Michigan und studierte bei Professor Henry X. Liu (korrespondierender Autor dieses Artikels).

Einführung in die Forschung

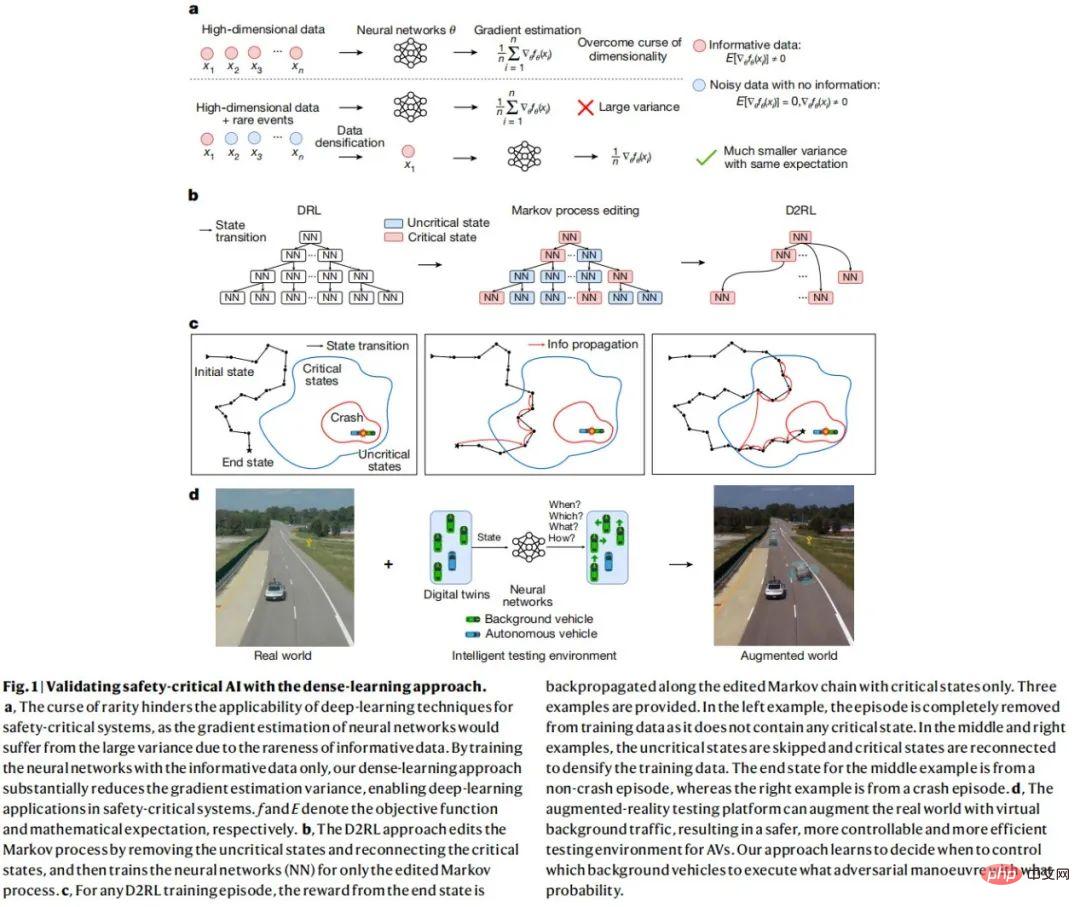

Die Grundidee der D2RL-Methode besteht darin, nicht sicherheitskritische Daten zu identifizieren und zu entfernen und sicherheitskritische Daten zum Trainieren des neuronalen Netzwerks zu verwenden. Da nur ein kleiner Teil der Daten sicherheitskritisch ist, werden die restlichen Daten stark mit Informationen verdichtet.

Im Vergleich zur DRL-Methode kann die D2RL-Methode die Varianz der Richtliniengradientenschätzung um mehrere Größenordnungen erheblich reduzieren, ohne die Unvoreingenommenheit zu verlieren. Diese erhebliche Varianzreduzierung kann es neuronalen Netzen ermöglichen, Aufgaben zu lernen und zu erledigen, die für DRL-Methoden nicht zu bewältigen sind.

Für AV-Tests verwendet diese Forschung die D2RL-Methode, um Hintergrundfahrzeuge (BV) über neuronale Netze zu trainieren, um zu lernen, wann welche gegnerischen Operationen ausgeführt werden müssen, um die Testeffizienz zu verbessern. D2RL kann die für AVs erforderliche Testleistung in einer KI-basierten gegnerischen Testumgebung um mehrere Größenordnungen reduzieren und gleichzeitig unvoreingenommene Tests gewährleisten.

Die D2RL-Methode kann auf komplexe Fahrumgebungen angewendet werden, einschließlich mehrerer Autobahnen, Kreuzungen und Kreisverkehre, was mit früheren szenariobasierten Methoden nicht möglich war. Darüber hinaus kann die in dieser Studie vorgeschlagene Methode intelligente Testumgebungen schaffen, die KI zur Verifizierung von KI nutzen. Dies ist ein Paradigmenwechsel, der die Tür für beschleunigte Tests und Schulungen anderer sicherheitskritischer Systeme öffnet.

Um zu beweisen, dass die KI-basierte Testmethode effektiv ist, trainierte diese Studie BV anhand eines umfangreichen tatsächlichen Fahrdatensatzes und führte Simulationsexperimente und Feldexperimente auf physischen Teststrecken durch. Die experimentellen Ergebnisse sind in Abbildung 1 unten dargestellt.

Dense Deep Reinforcement Learning

Um die KI-Technologie zu nutzen, formuliert diese Studie das AV-Testproblem als Markov Decision Process (MDP), bei dem der Betrieb des BV auf der Grundlage aktueller Statusinformationen entschieden wird. Die Studie zielt darauf ab, eine Richtlinie (DRL-Agent) zu trainieren, die durch ein neuronales Netzwerk modelliert wird und die Aktionen von BVs steuert, die mit AVs interagieren, um die Bewertungseffizienz zu maximieren und Unvoreingenommenheit sicherzustellen. Allerdings ist es, wie oben erwähnt, aufgrund der Einschränkungen der Dimensionalität und der Rechenkomplexität schwierig oder sogar unmöglich, wirksame Richtlinien zu erlernen, wenn die DRL-Methode direkt angewendet wird.

Da die meisten Zustände unkritisch sind und keine Informationen für sicherheitskritische Ereignisse bereitstellen können, konzentriert sich D2RL auf die Entfernung von Daten aus diesen unkritischen Zuständen. Bei AV-Testproblemen können viele Sicherheitsmetriken genutzt werden, um kritische Zustände mit unterschiedlicher Effizienz und Wirksamkeit zu identifizieren. Die in dieser Studie verwendete Kritikalitätsmetrik ist eine externe Näherung der AV-Kollisionsrate innerhalb eines bestimmten Zeitrahmens des aktuellen Zustands (z. B. 1 Sekunde). Anschließend bearbeitete die Studie den Markov-Prozess, verwarf Daten für unkritische Zustände und nutzte die verbleibenden Daten für die Schätzung des Richtliniengradienten und Bootstrap für das DRL-Training.

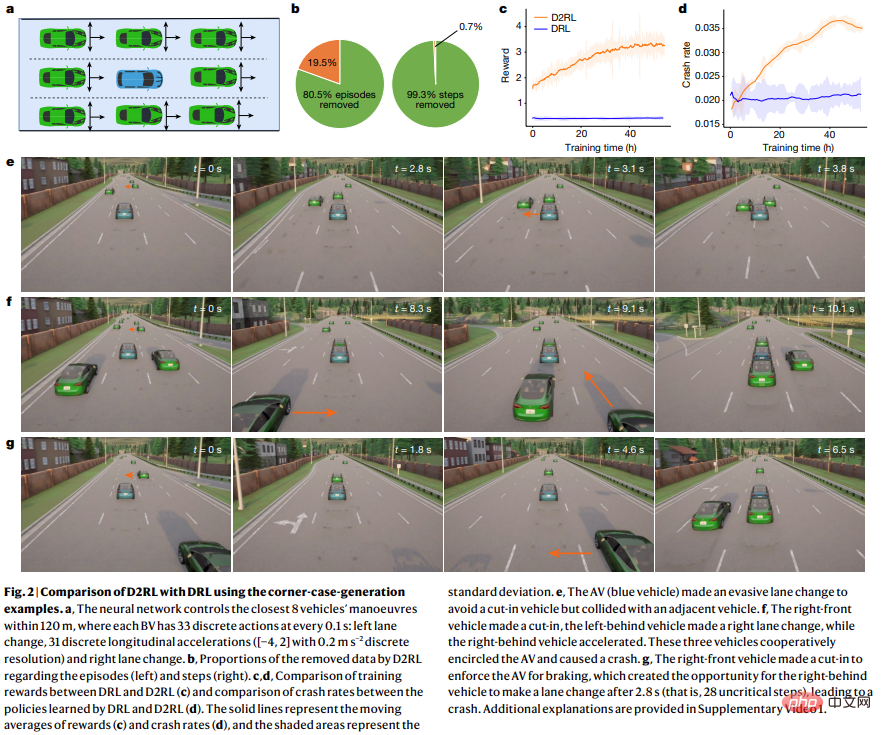

Wie in Abbildung 2 unten dargestellt, besteht der Vorteil von D2RL im Vergleich zu DRL darin, dass es die Belohnung während des Trainingsprozesses maximieren kann.

AV-Simulationstest

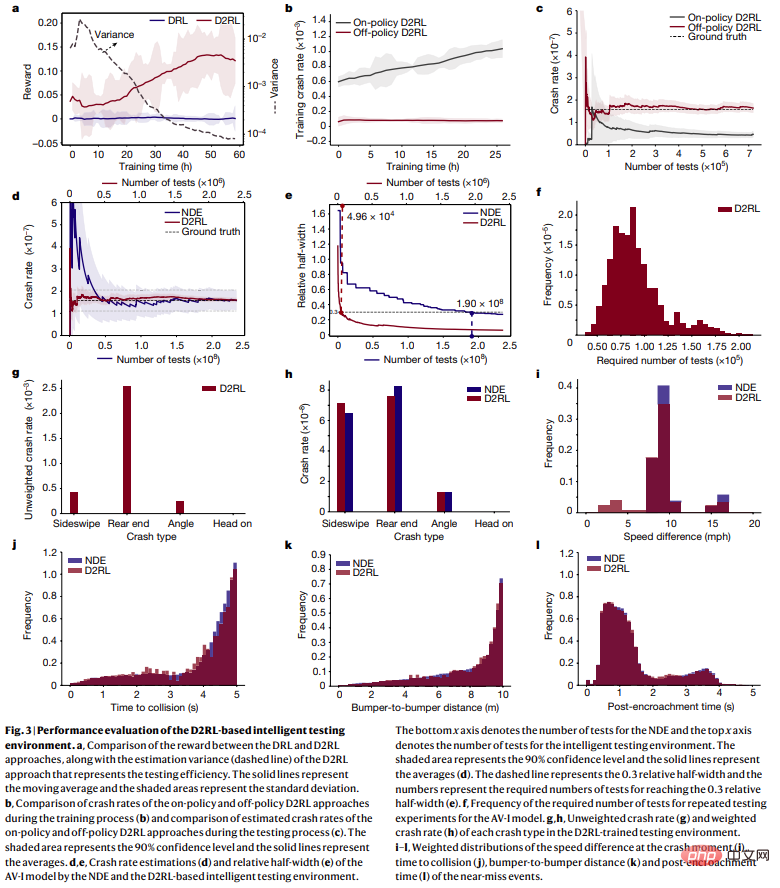

Um die Genauigkeit, Effizienz, Skalierbarkeit und Allgemeingültigkeit der D2RL-Methode zu bewerten, wurden in dieser Studie Simulationstests durchgeführt. Für jeden Testsatz simulierte die Studie eine feste Verkehrsdistanz und zeichnete dann die Testergebnisse auf und analysierte sie, wie in Abbildung 3 unten dargestellt.

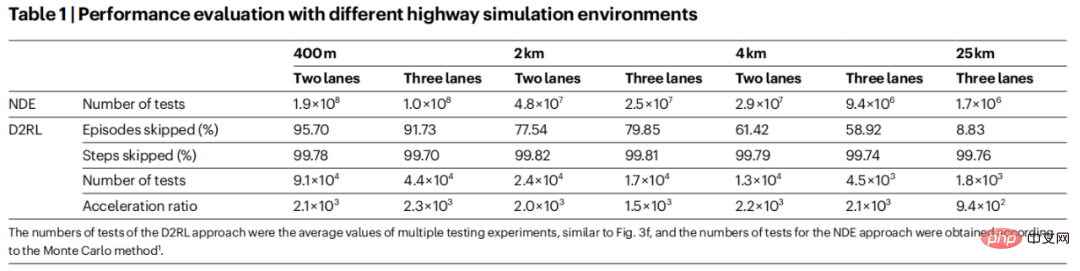

Um die Skalierbarkeit und Verallgemeinerung von D2RL weiter zu untersuchen, führte diese Studie AV-I-Modelle mit unterschiedlichen Spurnummern (2 Spuren und 3 Spuren) und Fahrstrecken (400 Meter, 2 Kilometer, 4 Kilometer und 25 km) durch . In diesem Artikel werden 25-Kilometer-Fahrten untersucht, da der durchschnittliche Pendler in den Vereinigten Staaten etwa 25 Kilometer in eine Richtung zurücklegt. Die Ergebnisse sind in Tabelle 1 dargestellt:

Das obige ist der detaillierte Inhalt von„Reinforcement Learning' steht wieder auf der Titelseite von „Nature', und das neue Paradigma der Sicherheitsüberprüfung beim autonomen Fahren reduziert die Testkilometer erheblich. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr