Heim >Technologie-Peripheriegeräte >KI >Der Standpunkt der Natur: Die Erprobung künstlicher Intelligenz in der Medizin ist im Chaos. Was ist zu tun?

Der Standpunkt der Natur: Die Erprobung künstlicher Intelligenz in der Medizin ist im Chaos. Was ist zu tun?

- PHPzOriginal

- 2024-08-22 16:37:32530Durchsuche

Sur la base de données cliniques limitées, des centaines d'algorithmes médicaux ont été approuvés. Les scientifiques se demandent qui devrait tester les outils et comment le faire au mieux.

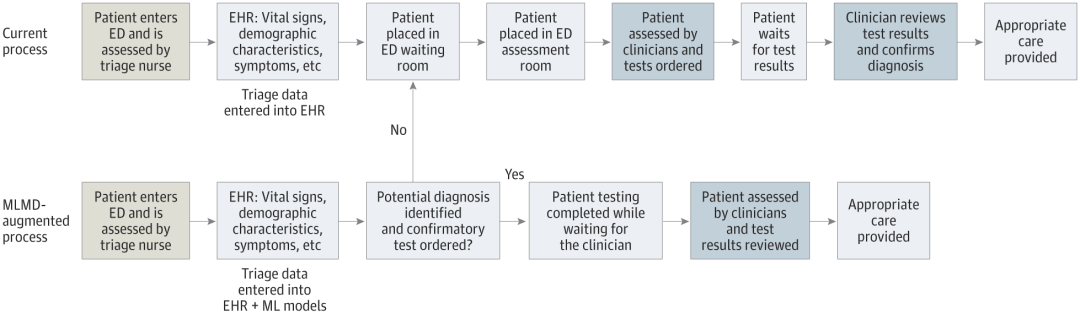

- Devin Singh a vu un patient pédiatrique faire un arrêt cardiaque aux urgences alors qu'il attendait longtemps un traitement, ce qui l'a incité à explorer l'utilisation de l'IA pour réduire les temps d'attente.

- En tirant parti des données de triage des salles d’urgence de SickKids, Singh et ses collègues ont construit une série de modèles d’IA pour fournir des diagnostics potentiels et recommander des tests.

- Une étude montre que ces modèles peuvent accélérer les visites chez le médecin de 22,3 %, accélérant le traitement des résultats de près de 3 heures par patient nécessitant un test médical.

- Cependant, le succès des algorithmes d’IA dans la recherche n’est que la première étape pour valider si de telles interventions aideront les gens dans la vie réelle.

Un moyen de commander de manière autonome des tests au service des urgences (SU) à l'aide des ordonnances médicales d'apprentissage automatique (MLMD) (Source : jamanetwork.com)

Qui teste les systèmes d'IA médicale ?

Les applications médicales basées sur l'IA, comme celle que Singh développe, sont souvent considérées comme des dispositifs médicaux par les organismes de réglementation des médicaments, notamment la FDA américaine et l'Agence britannique de réglementation des médicaments et des produits de santé. Par conséquent, les normes d’examen et d’autorisation d’utilisation sont généralement moins strictes que celles applicables aux produits pharmaceutiques. Seul un petit sous-ensemble de dispositifs, ceux qui peuvent présenter un risque élevé pour les patients, nécessitent des données d'essais cliniques pour être approuvés.

Beaucoup de gens pensent que le seuil est trop bas. Lorsque Gary Weissman, médecin de soins intensifs à l'Université de Pennsylvanie à Philadelphie, a examiné les appareils d'IA approuvés par la FDA dans son domaine, il a constaté que sur les dix appareils qu'il a identifiés, seuls trois citent des données publiées dans leur autorisation. Seuls quatre d'entre eux ont mentionné une évaluation de la sécurité, et aucun n'incluait une évaluation des biais, qui analyse si les résultats de l'outil sont équitables pour différents groupes de patients. "Le problème est que ces appareils peuvent avoir un impact sur les soins au chevet du patient", a-t-il déclaré. "La vie des patients peut dépendre de ces décisions.

Le manque de données rend difficile pour les hôpitaux et les systèmes de santé de décider d'utiliser ou non ces technologies." Dans une situation difficile. Dans certains cas, des incitations financières entrent en jeu. Aux États-Unis, par exemple, les régimes d’assurance maladie remboursent déjà aux hôpitaux l’utilisation de certains dispositifs médicaux d’IA, ce qui les rend financièrement attractifs. Ces institutions peuvent également être enclines à adopter des outils d’IA qui promettent des économies de coûts, même s’ils n’améliorent pas nécessairement les soins aux patients.

Ouyang a déclaré que ces incitations pourraient empêcher les entreprises d’IA d’investir dans les essais cliniques. « De nombreuses entreprises commerciales peuvent imaginer qu’elles vont travailler plus dur pour s’assurer que leurs outils d’IA sont remboursables », a-t-il déclaré.

La situation peut varier selon les marchés. Au Royaume-Uni, par exemple, un plan national de santé financé par le gouvernement pourrait fixer des seuils de preuve plus élevés avant que les centres médicaux puissent acheter des produits spécifiques, a déclaré Xiaoxuan Liu, chercheur clinicien à l'Université de Birmingham qui étudie l'innovation responsable en matière d'intelligence artificielle. une incitation à mener des essais cliniques. "

Une fois qu'un hôpital achète un produit d'IA, il n'a pas besoin de procéder à des tests supplémentaires et peut l'utiliser immédiatement comme les autres logiciels. Cependant, certaines agences reconnaissent que l’approbation réglementaire ne garantit pas que le dispositif sera réellement bénéfique. Ils ont donc choisi de le tester eux-mêmes. Actuellement, bon nombre de ces efforts sont menés et financés par des centres médicaux universitaires, a déclaré Ouyang.

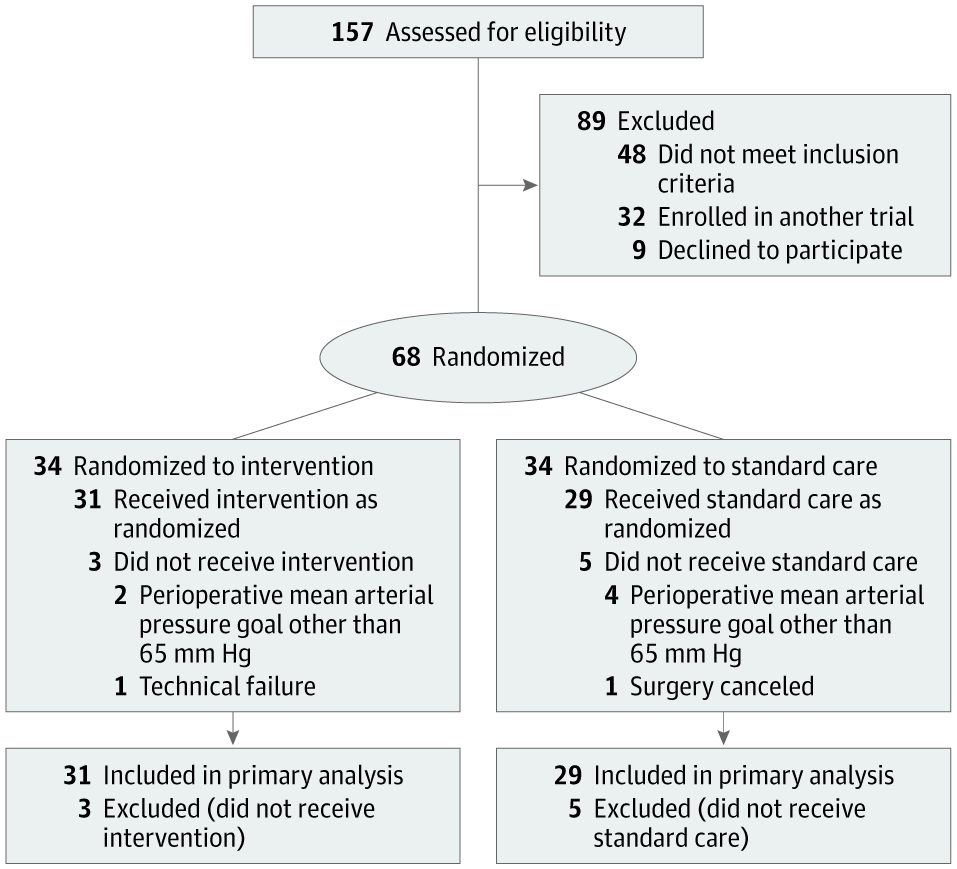

Alexander Vlaar, directeur médical des soins intensifs au centre médical universitaire d'Amsterdam, et Denise Veelo, anesthésiste dans la même institution, ont lancé une telle initiative en 2017. Leur objectif était de tester un algorithme conçu pour prédire la survenue d’une hypotension lors d’une intervention chirurgicale. Cette condition, connue sous le nom d'hypotension peropératoire, peut entraîner des complications potentiellement mortelles telles que des lésions du muscle cardiaque, une crise cardiaque et une insuffisance rénale aiguë, voire la mort.

L'algorithme, développé par Edwards Lifesciences, basé en Californie, utilise les données de forme d'onde artérielle – les lignes rouges avec des pics et des creux affichées sur les moniteurs des services d'urgence ou des unités de soins intensifs. La méthode peut prédire l’hypotension quelques minutes avant qu’elle ne se produise, permettant ainsi une intervention précoce.

Flux des participants à l'essai Hypotension Prediction (HYPE). (Source : jamanetwork.com) Vlaar, Veelo et leurs collègues ont mené un essai clinique randomisé pour tester l'outil sur 60 patients subissant une chirurgie non cardiaque. Les patients qui ont utilisé l'appareil ont connu en moyenne huit minutes d'hypotension pendant l'intervention chirurgicale, tandis que les patients du groupe témoin ont connu une moyenne de près de 33 minutes.

L'équipe a mené un deuxième essai clinique, confirmant que le dispositif est également efficace dans des contextes plus complexes, notamment en chirurgie cardiaque et dans les unités de soins intensifs, lorsqu'il est associé à un schéma thérapeutique clair. Les résultats n'ont pas encore été annoncés.

Le succès n’est pas seulement dû à la précision de l’algorithme. La réponse de l'anesthésiste à l'alarme est également importante. Les chercheurs s'assurent donc que les médecins sont bien préparés : « Nous disposons d'un organigramme de diagnostic qui décrit les étapes à suivre lorsqu'une alerte est reçue », a déclaré Veelo. Le même algorithme n’a pas démontré d’avantages lors d’un essai clinique mené par une autre institution. Dans ce cas, "lorsque l'alarme s'est déclenchée, le médecin de chevet n'a pas suivi les instructions et n'a pas pris de mesures", a expliqué Vlaar.

Humains impliqués Un algorithme parfaitement bon peut échouer en raison de changements dans le comportement humain, qu'il s'agisse de professionnels de santé ou de personnes recevant un traitement.

La clinique Mayo de Rochester, Minnesota, teste un algorithme développé en interne pour détecter les maladies cardiaques avec une faible fraction d'éjection, et Barbara Barry, chercheuse en interaction homme-machine au centre, est chargée de rapprocher les développeurs et les utilisateurs de la technologie. écart entre les prestataires de soins primaires.

Cet outil est conçu pour signaler les personnes susceptibles de présenter un risque élevé de développer cette maladie, qui peut être un signe d'insuffisance cardiaque et peut être traitée, mais qui n'est souvent pas diagnostiquée. Un essai clinique a montré que l’algorithme augmentait les taux de diagnostic. Cependant, lors de conversations avec des prestataires, Barry a constaté qu'ils souhaitaient davantage de conseils sur la manière de discuter des résultats de l'algorithme avec leurs patients. Cela a conduit à suggérer que l'application, si elle était largement mise en œuvre, devrait inclure des puces d'informations importantes pour communiquer avec les patients afin que les prestataires de soins de santé n'aient pas à réfléchir à la manière d'avoir cette conversation à chaque fois. "C'est un exemple de notre passage d'une expérimentation pragmatique à une stratégie de mise en œuvre", a déclaré Barry.

Un autre problème qui peut limiter le succès de certains dispositifs médicaux d’IA est la « fatigue des alertes » : lorsque les cliniciens sont exposés à un grand nombre d’avertissements générés par l’IA, ils peuvent y devenir insensibles. Cela devrait être pris en considération lors du processus de test, a déclaré David Rushlow, chef de la division de médecine familiale à la clinique Mayo.

« Nous recevons des alertes plusieurs fois par jour concernant des maladies pour lesquelles les patients peuvent être à risque. Pour les cliniciens de première ligne très occupés, il s'agit en fait d'une tâche très difficile. » "Ils ne sont pas présentés avec précision, la solution par défaut sera de continuer à faire les choses de la même manière parce que nous n'avons pas la bande passante nécessaire pour apprendre de nouvelles choses", a souligné Rushlow.

Considérez les biais

Un autre défi dans les tests d’IA médicale est que les résultats des essais cliniques sont difficiles à généraliser à différentes populations. "Il est bien connu que les algorithmes d'intelligence artificielle peuvent être très fragiles lorsqu'ils sont utilisés sur des données différentes des données d'entraînement", a déclaré Liu.

Elle a noté que les résultats ne peuvent être extrapolés en toute sécurité que si les participants aux essais cliniques sont représentatifs de la population pour laquelle l'outil sera utilisé.

De plus, les algorithmes formés sur les données collectées dans des hôpitaux riches en ressources peuvent ne pas fonctionner correctement lorsqu'ils sont appliqués dans des contextes pauvres en ressources. Par exemple, l’équipe Google Health a développé un algorithme pour détecter la rétinopathie diabétique, une maladie qui entraîne une perte de vision chez les personnes atteintes de diabète, avec une précision théorique élevée. Mais lorsque l’outil a été utilisé dans des cliniques en Thaïlande, ses performances ont considérablement chuté.

Une étude observationnelle a montré que les conditions d'éclairage dans les cliniques thaïlandaises entraînaient une mauvaise qualité d'image oculaire, réduisant ainsi l'efficacité de l'outil.

Actuellement, la plupart des outils d'IA médicale aident les professionnels de la santé à effectuer le dépistage, le diagnostic ou la planification du traitement. Les patients ne savent peut-être pas que ces technologies sont testées ou utilisées régulièrement dans le cadre de leurs soins, et aucun pays n’exige actuellement que les prestataires de soins de santé le divulguent.

Le débat se poursuit sur ce qu’il faut dire aux patients sur la technologie de l’intelligence artificielle. Certaines de ces applications ont placé la question du consentement du patient sous le feu des projecteurs pour les développeurs. C'est le cas d'un dispositif d'intelligence artificielle que l'équipe de Singh développe pour rationaliser les soins aux enfants dans la salle d'urgence du SickKids.

Ce qui est étonnamment différent de cette technologie, c'est qu'elle soustrait le clinicien à l'ensemble du processus, permettant à l'enfant (ou à son parent ou tuteur) d'être l'utilisateur final.

« Cet outil permet de recueillir des données de triage d'urgence, de faire des prédictions et de donner aux parents leur approbation directe – oui ou non – si leur enfant peut être testé », a déclaré Singh. Cela réduit le fardeau du clinicien et accélère l’ensemble du processus. Mais cela entraîne également de nombreux problèmes sans précédent. Qui est responsable si quelque chose ne va pas pour le patient ? Qui paie si des tests inutiles sont effectués ?

„Wir müssen die Einverständniserklärung der Familien auf automatisierte Weise einholen“, sagte Singh, und die Einwilligung muss zuverlässig und authentisch sein. „Das kann nicht so sein, wie wenn man sich in den sozialen Medien anmeldet, 20 Seiten Kleingedrucktes hat und einfach auf „Akzeptieren“ klickt.

Während Singh und seine Kollegen auf die Finanzierung warten, um Studien an Patienten zu starten, arbeitet das Team mit der Rechtsabteilung zusammen Experten und Beauftragung der Regulierungsbehörde des Landes, Health Canada, mit der Prüfung ihrer Vorschläge und der Abwägung regulatorischer Auswirkungen. Derzeit „ist die Regulierungslandschaft ein bisschen wie im Wilden Westen“, sagte Anna Goldenberg, Informatikerin und Co-Vorsitzende der SickKids Children's Medical Artificial Intelligence Initiative.

Medizinische Einrichtungen setzen KI-Tools umsichtig ein und führen autonome Tests durch.

Kostenfaktoren haben Forscher und medizinische Einrichtungen dazu veranlasst, nach Alternativen zu suchen.

Große medizinische Einrichtungen haben weniger Schwierigkeiten, während kleine Einrichtungen vor größeren Herausforderungen stehen.

Mayo Clinic testet KI-Tool für den Einsatz in kommunalen Gesundheitseinrichtungen.

Die Health AI Alliance hat ein Garantielabor zur Bewertung des Modells eingerichtet.

Duke University bietet interne Testfunktionen zur lokalen Verifizierung von KI-Modellen.

Radiologin Nina Kottler betont die Bedeutung der lokalen Verifizierung.

Menschliche Faktoren müssen beachtet werden, um die Genauigkeit der künstlichen Intelligenz und der Endbenutzer sicherzustellen.

Referenzinhalt: https://www.nature.com/articles/d41586-024-02675-0

Das obige ist der detaillierte Inhalt vonDer Standpunkt der Natur: Die Erprobung künstlicher Intelligenz in der Medizin ist im Chaos. Was ist zu tun?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr