Die Mitwirkenden haben von dieser ACL-Konferenz viel profitiert.

Das sechstägige ACL 2024 findet in Bangkok, Thailand, statt.

ACL ist die führende internationale Konferenz im Bereich Computerlinguistik und Verarbeitung natürlicher Sprache. Sie wird von der International Association for Computational Linguistics organisiert und findet jährlich statt. ACL steht seit jeher an erster Stelle, was den akademischen Einfluss im Bereich NLP angeht, und ist außerdem eine von der CCF-A empfohlene Konferenz. Die diesjährige ACL-Konferenz ist die 62. und hat mehr als 400 innovative Arbeiten im Bereich NLP eingereicht. Gestern Nachmittag gab die Konferenz den besten Beitrag und weitere Auszeichnungen bekannt. Diesmal wurden 7 Best Paper Awards (zwei davon unveröffentlicht), 1 Best Theme Paper Award und 35 Outstanding Paper Awards vergeben. Die Konferenz verlieh außerdem drei Resource Awards, drei Social Impact Awards und zwei Time Test Awards. Darüber hinaus wurde der Lifetime Achievement Award dieser Konferenz an Professor Ralph Grishman vom Department of Computer Science der New York University verliehen. Im Folgenden finden Sie die spezifischen Gewinninformationen.

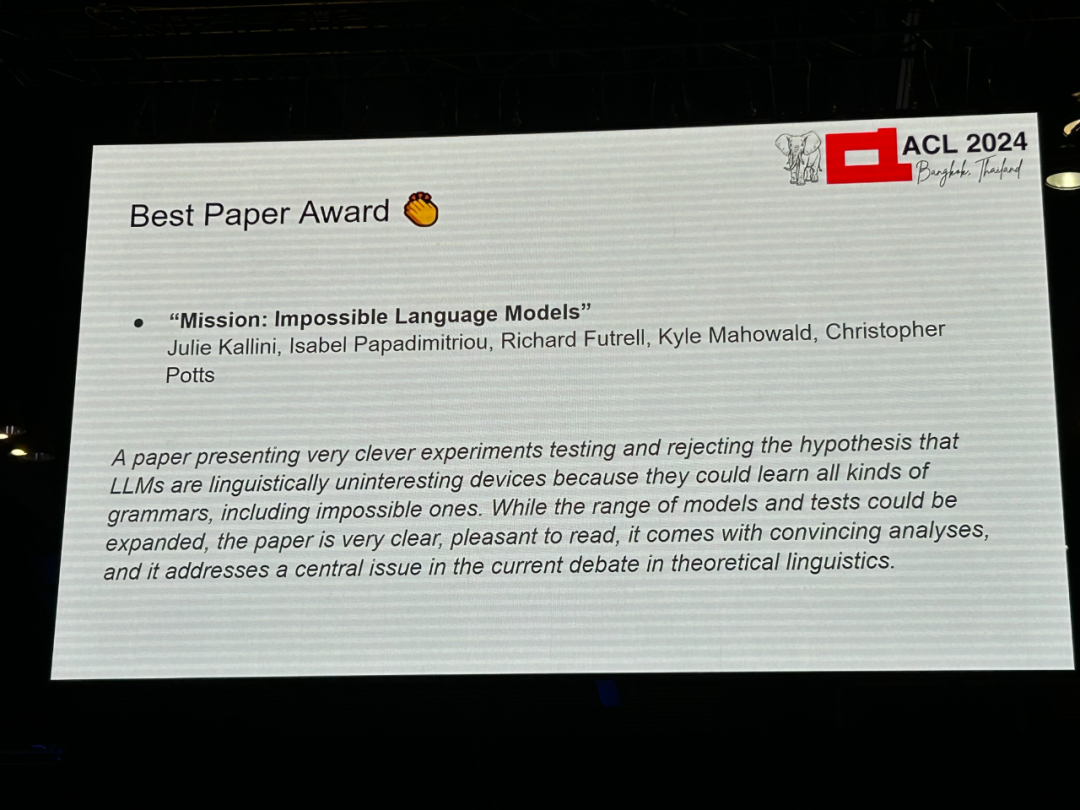

Paper 1: Mission: Impossible Language Models

- Autoren: Julie Kallini, Isabel Papadimitriou, Richard Futrell, Kyle Mahowald, Christopher Potts

- Institutionen: Stanford University, University of California, Irvine, University of Texas at Austin

- Papier-Link: https://arxiv.org/abs/2401.06416

Papier-Einführung: Chomsky et al Es wird angenommen, dass große Sprachmodelle (LLM) die gleichen Lernfähigkeiten für Sprachen haben, die von Menschen gelernt werden können oder nicht. Es gibt jedoch nur wenige veröffentlichte experimentelle Beweise, die diese Behauptung stützen. Die Studie entwickelte eine Reihe synthetischer Sprachen unterschiedlicher Komplexität, die jeweils durch systematische Veränderung englischer Daten unter Verwendung unnatürlicher Wortreihenfolge und grammatikalischer Regeln entwickelt wurden, mit dem Ziel, etwas zu synthetisieren, das für Menschen unmöglich wäre, eine Sprache zu lernen. Die Studie führte umfangreiche Bewertungsexperimente durch, um die Fähigkeit des kleinen GPT-2-Modells zum Erlernen dieser „unmöglichen Sprachen“ zu bewerten, und führte diese Bewertungen in verschiedenen Phasen des Trainings durch, um den Lernprozess jeder Sprache zu vergleichen. Das Kernergebnis der Studie ist, dass es im Vergleich zu Englisch schwierig ist, mit GPT-2 „unmögliche Sprachen“ zu lernen, was die Behauptungen von Chomsky und anderen in Frage stellt. Noch wichtiger ist, dass die Studie hofft, dass ihr Ansatz eine fruchtbare Forschungslinie eröffnen kann, die es ermöglicht, verschiedene LLM-Architekturen in verschiedenen „unmöglichen Sprachen“ zu testen, um zu verstehen, wie LLM als kognitives und typologisches Erhebungstool verwendet werden kann .

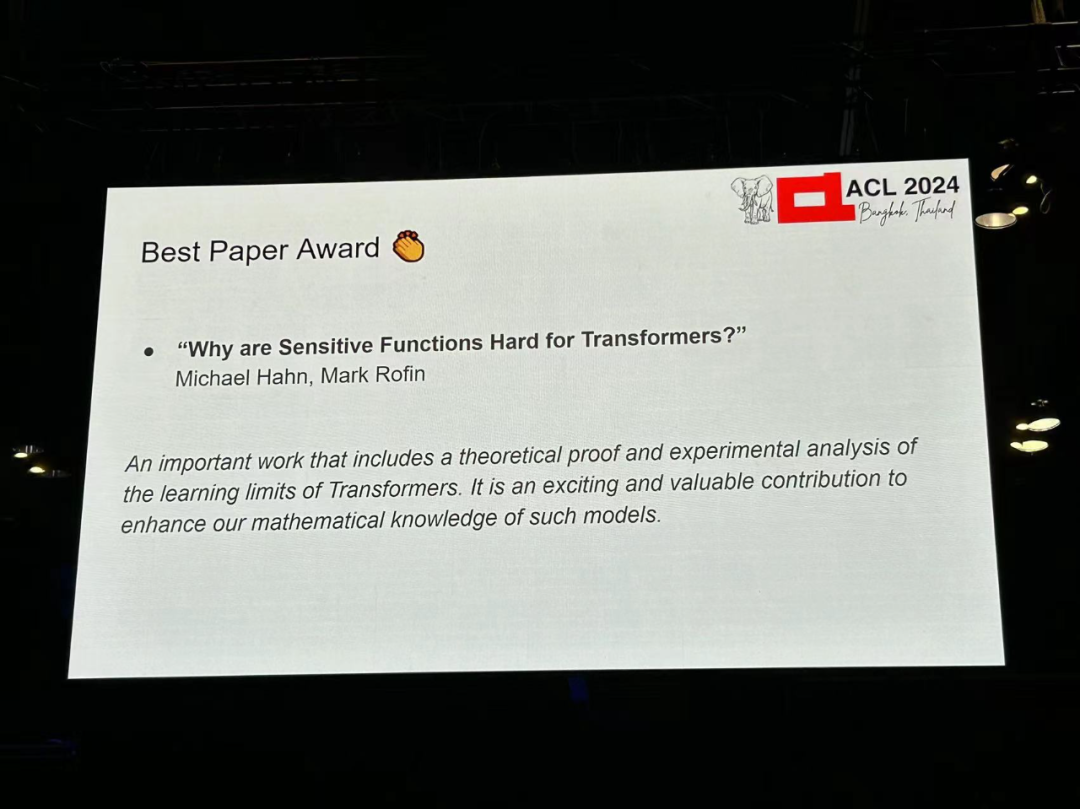

Aufsatz 2: Warum sind sensible Funktionen für Transformatoren schwierig?

- Autor: Michael Hahn, Mark Rofin

- Institution: Universität des Saarlandes

- Aufsatzlink: https://arxiv.org /abs/2402.09963

Zusammenfassung: Experimentelle Studien haben eine Reihe von Lernfähigkeitsverzerrungen und Einschränkungen von Transformatoren identifiziert, wie z. B. die anhaltende Schwierigkeit beim Erlernen der Berechnung einfacher formaler Sprachen wie PARITY und die Schwierigkeit beim Lernen Low-Level-Funktion (niedriger Grad). Das theoretische Verständnis bleibt jedoch begrenzt, und bestehende Darstellungstheorien überschätzen oder unterschätzen realistische Lernfähigkeiten. Diese Studie beweist, dass unter der Transformatorarchitektur die Verlustfunktionslandschaft (Verlustlandschaft) durch die Empfindlichkeit des Eingaberaums begrenzt ist: Ein Transformator, dessen Ausgang auf viele Teile der Eingabezeichenfolge empfindlich reagiert, befindet sich an einer isolierten Stelle Punkt im Parameterraum, was zu einer Verallgemeinerung mit geringer Empfindlichkeit führt. Diese Studie zeigt theoretisch und experimentell, dass die Theorie umfangreiche experimentelle Beobachtungen zu Lernfähigkeiten und -verzerrungen von Transformatoren vereint, wie z. B. deren Verallgemeinerungsverzerrung auf niedrige Sensitivität und niedrigen Grad sowie Paritätslängenschwierigkeiten bei der Verallgemeinerung. Dies legt nahe, dass das Verständnis der induktiven Vorspannungen eines Transformators nicht nur die Untersuchung seiner prinzipiellen Ausdruckskraft, sondern auch der Landschaft seiner Verlustfunktionen erfordert.

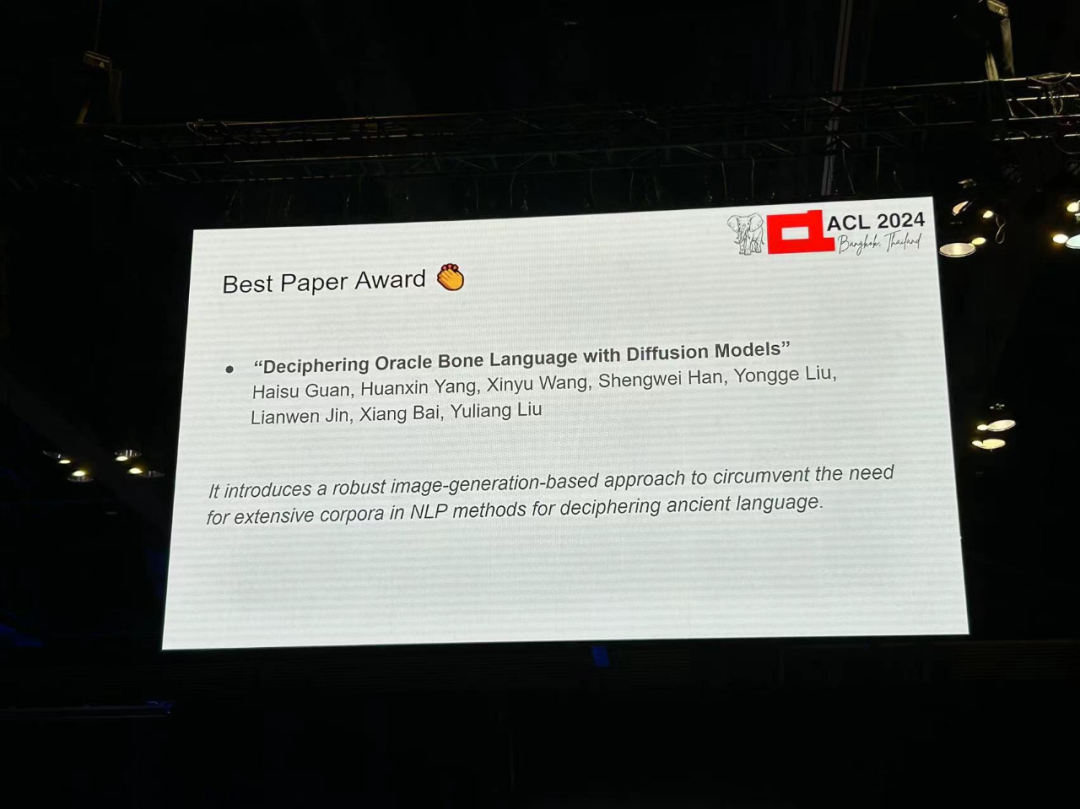

Aufsatz 3: Entschlüsselung der Oracle-Knochensprache mit Diffusionsmodellen

- Autor: Haisu Guan, Huanxin Yang, ion: Huazhong Universität Wissenschaft und Technologie, A Adelaide University, Anyang Normal College, South China University of Technology

- Papierlink: https://arxiv.org/pdf/2406.00684

Papiereinführung: Oracle Bone Script (OBS ) entstand vor etwa 3.000 Jahren in der Shang-Dynastie in China und ist ein Eckpfeiler der Sprachgeschichte, der vor vielen etablierten Schriftsystemen liegt. Obwohl Tausende von Inschriften entdeckt wurden, ist eine große Anzahl von Orakelknochen immer noch unentschlüsselt, was diese alte Sprache mit einem Schleier voller Geheimnisse umhüllt. Das Aufkommen moderner KI-Technologie hat neue Bereiche für die Oracle-Dekodierung eröffnet und stellt traditionelle NLP-Methoden, die stark auf großen Textkorpora basieren, vor Herausforderungen.

In diesem Artikel wird eine neue Methode vorgestellt, die Bilderzeugungstechnologie nutzt, um ein für die Oracle-Entschlüsselung optimiertes Diffusionsmodell zu entwickeln: Oracle Bone Script Decipher (OBSD). Mithilfe der bedingten Diffusionsstrategie generierte OBSD wichtige Hinweise für die Oracle-Entschlüsselung und eröffnete eine neue Richtung für die KI-gestützte Analyse antiker Sprachen. Um die Wirksamkeit zu überprüfen, führten die Forscher umfangreiche Experimente mit dem Oracle-Datensatz durch und die quantitativen Ergebnisse bewiesen die Wirksamkeit von OBSD.

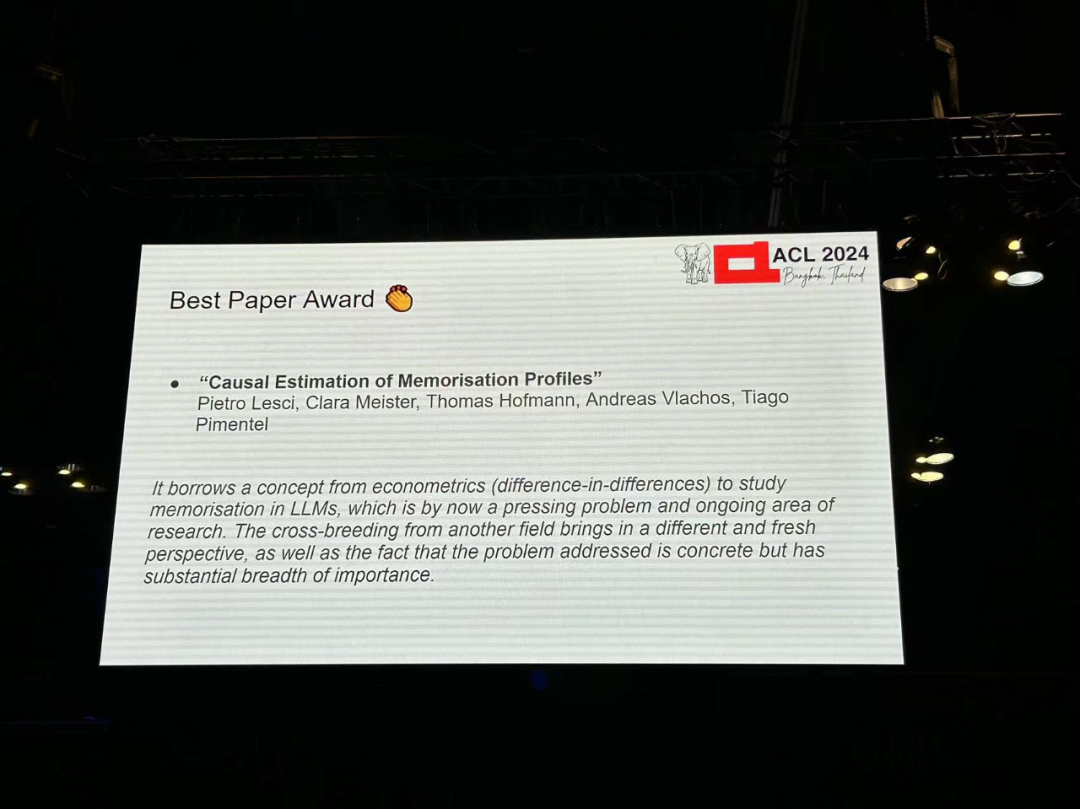

Aufsatz 4: Kausale Schätzung von Erinnerungsprofilen

Autor: Pietro Lesci, Clara Meister, Thomas Hofmann, Andreas Vlachos, Tiago Pimentel

- Institution: University of Cambridge , ETH Zürich Akademie

- Link zum Papier: https://arxiv.org/pdf/2406.04327

Einleitung zum Papier: Das Verständnis des Gedächtnisses in Sprachmodellen hat praktische und soziale Auswirkungen, wie etwa das Studium der Trainingsdynamik von Modellen oder die Prävention Urheberrechtsverletzung. Frühere Forschungen definieren Gedächtnis als den kausalen Zusammenhang zwischen „Training anhand einer Instanz“ und „der Fähigkeit des Modells, diese Instanz vorherzusagen“. Diese Definition beruht auf einem kontrafaktischen Prinzip: der Fähigkeit zu beobachten, was passiert wäre, wenn das Modell die Instanz nicht gesehen hätte. Bestehende Methoden haben Schwierigkeiten, rechnerisch effiziente und genaue Schätzungen solcher Kontrafaktuale zu liefern. Darüber hinaus schätzen diese Methoden typischerweise den Speicher der Modellarchitektur und nicht den Speicher bestimmter Modellinstanzen.

Dieses Papier füllt eine wichtige Lücke, indem es einen neuen, prinzipiellen und effizienten Ansatz zur Schätzung des Gedächtnisses auf der Grundlage eines ökonometrischen Differenz-in-Differenz-Designs vorschlägt. Mit dieser Methode beobachten Forscher das Verhalten des Modells während des gesamten Trainingsprozesses nur bei einer kleinen Anzahl von Instanzen, um das Gedächtnisprofil des Modells, also seinen Gedächtnistrend während des Trainingsprozesses, zu beschreiben. In Experimenten mit der Pythia-Modellsuite stellten sie fest, dass das Gedächtnis (i) in größeren Modellen stärker und beständiger ist, (ii) durch die Datenreihenfolge und Lernrate bestimmt wird und (iii) über verschiedene Modellgrößen hinweg stabil ist Erinnerungen im größeren Modell können aus dem kleineren Modell vorhergesagt werden.

Aufsatz 5: Aya-Modell: Ein fein abgestimmtes mehrsprachiges Open-Access-Sprachmodell mit Anleitung

- Autor: Ahmet Üstün, Viraat Aryabumi, Zheng Xin Yong, Wei-Yin Ko usw.

- Institution: Cohere, Brown University et al

- Link zum Papier: https://arxiv.org/pdf/2402.07827

Einleitung zum Papier: Jüngste Durchbrüche bei großen Sprachmodellen (LLM) konzentrieren sich auf eine kleine Anzahl von Daten -reiche Sprachen. Wie können die Möglichkeiten für Durchbrüche über andere Sprachen hinaus erweitert werden? Die Forschung stellt Aya vor, ein groß angelegtes mehrsprachiges generatives Sprachmodell, das Anweisungen für 101 Sprachen folgt, von denen mehr als 50 % als ressourcenarm gelten. Aya übertrifft mT0 und BLOOMZ bei den meisten Aufgaben und deckt gleichzeitig doppelt so viele Sprachen ab. Darüber hinaus führt die Studie eine umfangreiche neue Reihe von Beurteilungen ein, die den Stand der Technik bei mehrsprachigen Beurteilungen auf 99 Sprachen erweitert. Abschließend liefert die Studie eine detaillierte Untersuchung der optimalen, fein abgestimmten Mischungszusammensetzung, Datenbereinigung sowie Modelltoxizität, Bias und Sicherheit.

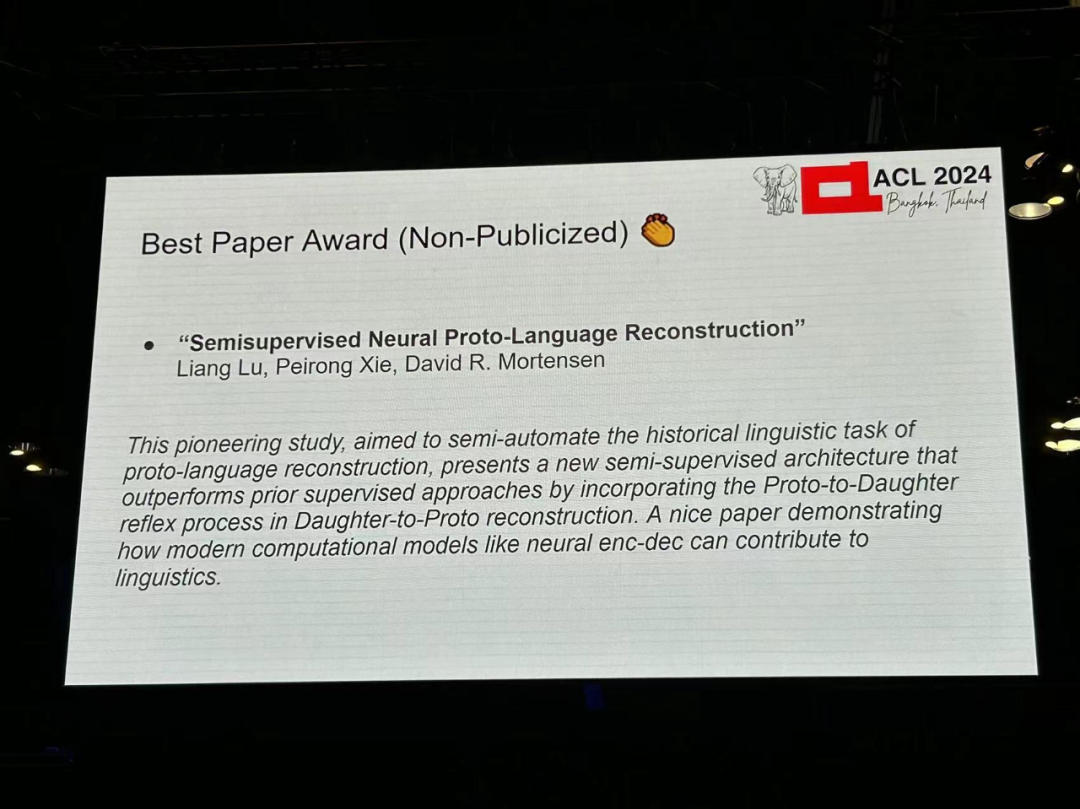

Aufsatz 6: Semisupervised Neural Proto-Language Reconstruction

- Autoren: Liang Lu, Peirong Xie, David R. Mortensen

-

Institution: CMU, University of Südkalifornien

- Link zum Papier: https://arxiv.org/pdf/2406.05930

Grund für die Auszeichnung: Diese bahnbrechende Forschung zielt darauf ab, die Aufgabe der prototypischen Sprachrekonstruktion in der historischen Linguistik halbautomatisch zu machen und schlägt eine neue halbautomatische Methode vor. betreute Architektur. Diese Methode übertrifft frühere überwachte Methoden, indem sie einen „Prototyp-Muttersprache“-Reflexionsprozess in die „Muttersprache-Prototyp“-Rekonstruktion einführt. Dieser Artikel liefert ein gutes Beispiel dafür, wie moderne Rechenmodelle wie neuronale Encoder-Decoder zur Linguistik beitragen können.

Aufsatz 7: Erfüllbarkeit natürlicher Sprache: Erforschung der Problemverteilung und Bewertung transformatorbasierter Sprachmodelle (unveröffentlicht) -

Autoren: Tharindu Madusanka, Ian Pratt-Hartmann, Riza

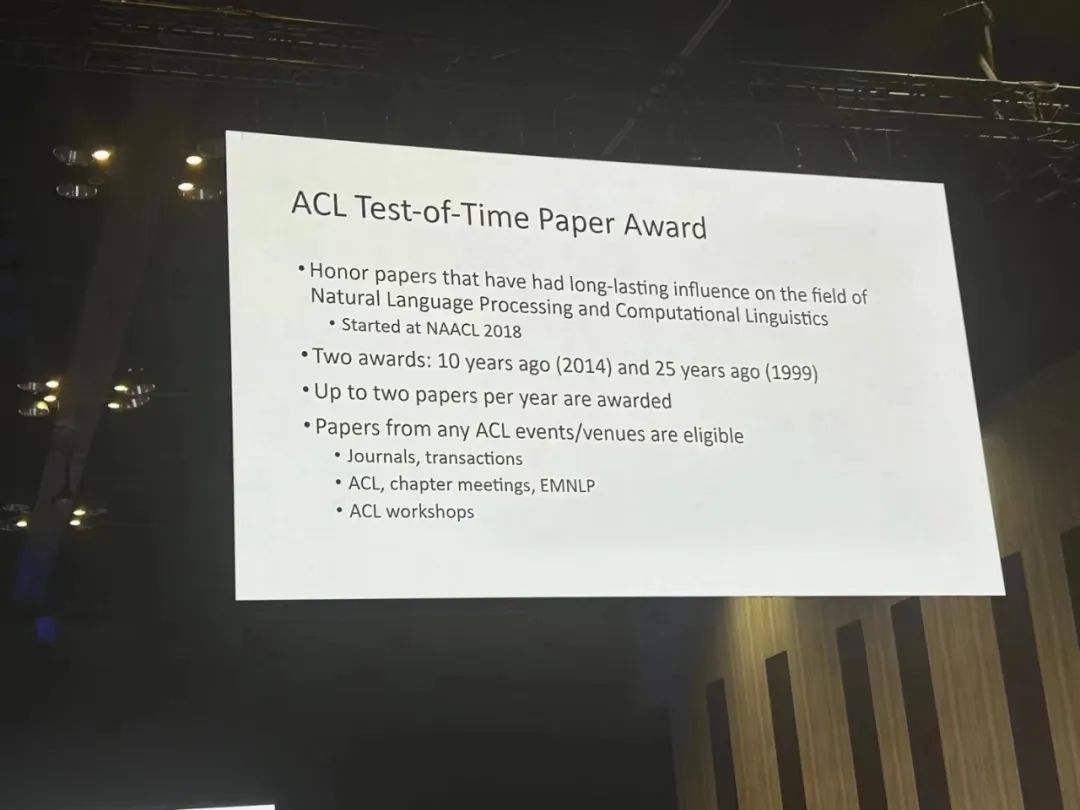

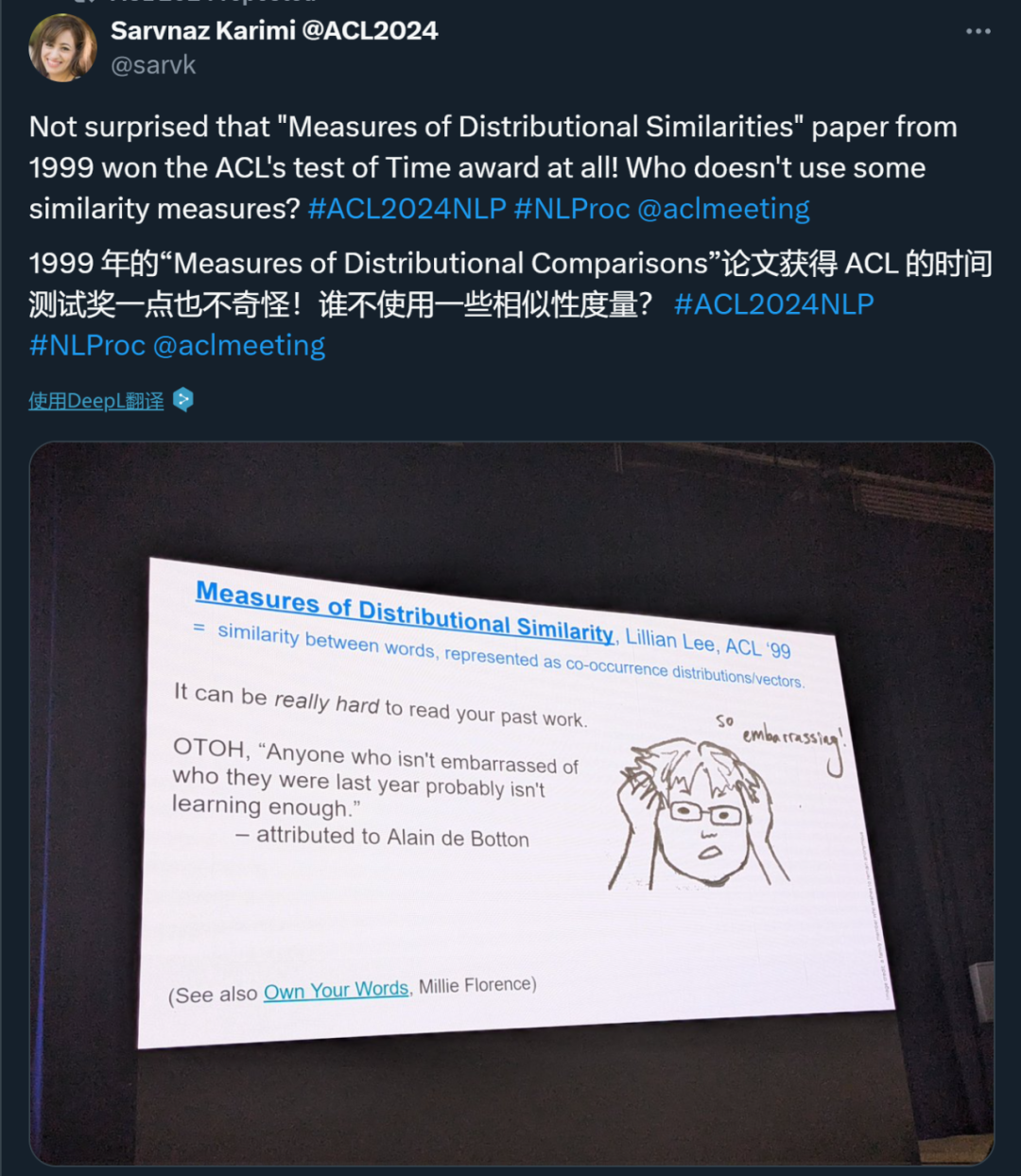

Zitat: In diesem Artikel wird klar ein synthetischer Bewertungsdatensatz für logische Schlussfolgerungen beschrieben. Dies ist eine gute Ergänzung zu großen Inferenzdatensätzen, bei denen nicht klar ist, welche Fähigkeiten gemessen werden. Theoretisch gibt es tatsächlich Gründe zu der Annahme, dass einige Teilmengen schwieriger sind als andere, und diese Erwartungen werden in der Arbeit bestätigt. Innerhalb jeder Kategorie legen die Autoren besonderen Wert auf die Auswahl der wirklich herausfordernden Fälle. Der ACL Time Test Award belohnt Ehrenarbeiten, die einen langfristigen Einfluss auf die Bereiche der Verarbeitung natürlicher Sprache und Computerlinguistik hatten, unterteilt in vor 10 Jahren (2014) und Vor 25 Jahren Die ersten beiden Auszeichnungen (1999) wurden an maximal zwei Arbeiten pro Jahr vergeben.

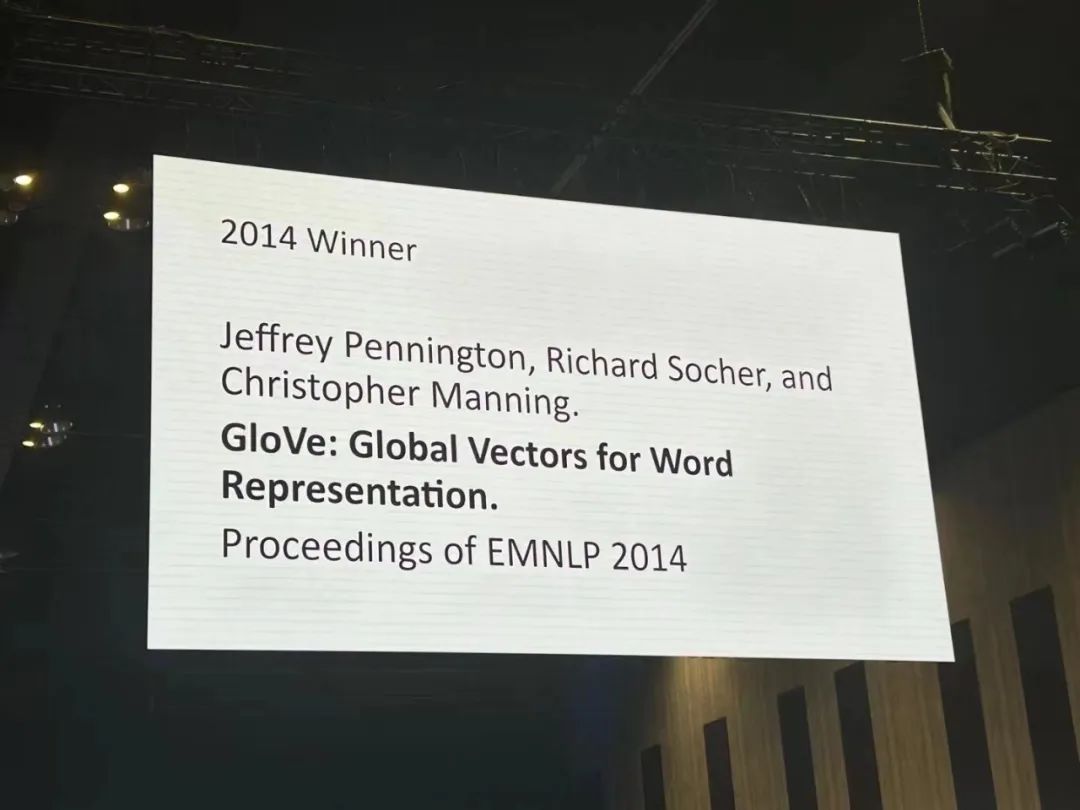

論文 1: GloVe: 単語表現のためのグローバル ベクトル

- 著者: Jeffrey Pennington、Richard Socher、Christopher D. Manning

- 論文リンク: https:/ /aclanthology.org/D14-1162.pdf

論文について: 単語のベクトル空間表現を学習する方法は、ベクトル演算を使用して詳細な意味論的規則と構文規則を捕捉することに成功しましたが、構文規則はまだ残っています不透明。この研究では、構文規則が単語ベクトルに現れるためにモデルがどのような特性を持つ必要があるかを分析し、明らかにします。 この研究は、単語のベクトル表現を学習するように設計された新しいグローバル対数線形回帰モデル - GloVe を提案します。このモデルは、グローバル行列因数分解とローカル コンテキスト ウィンドウ法の利点を組み合わせています。 GloVe は、単語類似タスクで 75% という最高のパフォーマンスを達成し、単語類似タスクと固有表現認識では関連モデルを上回ります。 受賞理由: 単語埋め込みは、2013 年から 2018 年にかけて自然言語処理 (NLP) の深層学習手法の基礎となり、引き続き大きな影響力を及ぼし続けています。これらは NLP タスクのパフォーマンスを向上させるだけでなく、単語の類似性や類似性などの計算セマンティクスにも大きな影響を与えます。最も影響力のある 2 つの単語埋め込みメソッドは、おそらく Skip-gram/CBOW と GloVe です。 GloVeはskip-gramに比べて後から提案されました。その相対的な利点は概念的な単純さにあり、単純化された言語モデリングの観点からパラメータのセットとして間接的にではなく、単語間の分布特性に直接基づいてベクトル空間の類似性を最適化します。

- 論文リンク: https://aclanthology .org /P99-1004.pdf

論文について: 著者は、目に見えない共起事象の確率推定を改善することを目的として、分布類似性尺度を研究しています。その貢献は 3 つあります: 広範囲の測定値の経験的比較、それに含まれる情報に基づく類似性関数の分類、および基礎となるエージェントの分布の評価に優れた新しい関数の導入です。

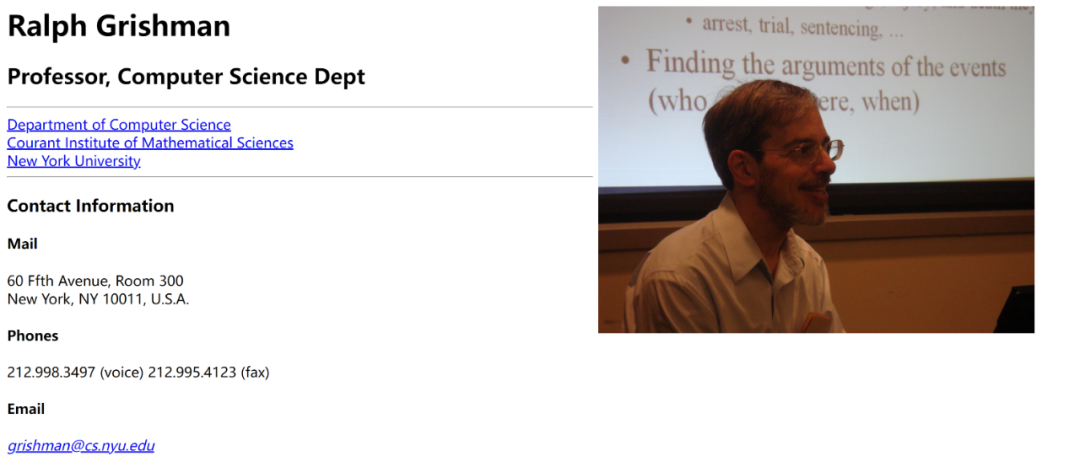

ACLの生涯功労賞がラルフ・グリッシュマンに授与されます。ラルフ グリッシュマンは、ニューヨーク大学コンピューター サイエンス学部の教授であり、自然言語処理 (NLP) の分野の研究に重点を置いています。彼は、情報抽出 (IE) に多大な貢献をし、この分野を発展させた Proteus プロジェクトの創設者です。

彼はまた、文の分割、固有表現の注釈、時間表現の注釈と正規化、品詞のタグ付け、部分解析、および相互参照などの複数の言語分析コンポーネントを提供する、広く使用されている情報抽出ツールである Java Extraction Toolkit (JET) も開発しました。分析。これらのコンポーネントは、さまざまなアプリケーションに応じてパイプラインに組み合わせることができ、単一の文の対話型分析や文書全体のバッチ分析に使用できます。さらに、JET はドキュメントの注釈と表示のためのシンプルなツールを提供し、ACE (自動コンテンツ抽出) 仕様に従ってエンティティ、関係、およびイベントを抽出するための完全なプロセスを含みます。 グリッシュマン教授の研究は、NLP における複数の中核問題をカバーしており、現代の言語処理テクノロジーに大きな影響を与えています。

- 論文 1: 量子化サイドチューニング: 量子化された大規模言語モデルの高速かつメモリ効率の高いチューニング

- 著者: Zhengxin Zhang、Dan Zハオ、シュペンミャオ、 Gabriele Oliaro、Zhihao Zhang、Qing Li、Yong Jiang、Zhihao Jia

-

紙のリンク: https://arxiv.org/pdf/2401.07159

- 論文 2: L-Eval: 長いコンテキスト言語モデルの標準化された評価の確立

- 著者: Chenxin An、Shansan Gong、Ming Zhong、Xingjian Zhao、Mukai Li、Jun Zhang、Lingpeng Kong、Xipeng Qiu

- 機関:復旦大学、香港大学、イリノイ大学アーバナシャンペーン校、上海AIラボ

- 紙のリンク: https://arxiv.org/abs/2307.11088

- 論文 3: 大規模言語モデルのバイアスを除去するための因果ガイド型アクティブ学習

- 論文リンク: https://openreview.net/forum?id=idp_1Q6F-lC

- 論文 4: CausalGym: 言語タスクにおける因果解釈可能性手法のベンチマーク

- 著者: Aryaman Arora、Dan Jurafsky、Christopher Potts

-

論文リンク: https://arxiv.org/abs/2402.1 2560

- 論文 5: 幻覚を起こさず、禁欲する: 複数 LLM コラボレーションによる LLM 知識のギャップの特定

- 著者: Shangbin Feng、Weijia Shi、Yike Wang、Wenxuan Ding、Vidhisha Balachandran、Yulia Tsvetko v

- 機関: ワシントン大学、カリフォルニア大学バークレー校、香港科技大学、CMU

- 紙のリンク: https://arxiv.org/abs/2402.00367

- 論文 6: Speech Foundation モデルと大規模言語モデルを使用した音声翻訳: そこに何があり、何が欠けているのか?

- 著者: Marco Gaido、Sara Papi、Matteo Negri、Luisa Bentivogli

-

機関: Bruno Kessler Foundation 、イタリア

- 論文リンク: https://arxiv.org/abs/2402.12025

- 論文 7: NLP は抽出的である必要がありますか?

-

- 機関: Charles Darwin University

- 論文リンク: https://drive.google.com/file/d/1hvF7_WQrou6CWZydhymYFTYHnd3ZIljV/view

- 論文 8: IRCoder: 中間表現による言語モデルの作成堅牢な多言語コード生成者

- 著者: Indraneil Paul、Goran Glavaš、Iryna Gurevych

-

紙のリンク: https://arxiv.org/abs/2403.03894

- 論文 9: MultiLegalPile: 689 GB の多言語法的コーパス

- 著者: Matthias Stürmer、Veton Matoshi など

- 論文リンク: https: //arxiv.org/ pdf/2306.02069

- 論文 10: PsySafe: マルチエージェント システムの安全性の心理学に基づく攻撃、防御、評価のための包括的なフレームワーク

- 著者: Zaibin Zhang 、Yongting Zhang、Lijun Li、Hongzhi Gao、Lijun Wang、Huchuan Lu、Feng Zhao、Yu Qiao、Jing Shao

- 機関: 上海人工知能研究所、大連理工大学、中国科学技術大学

- 論文リンク: https://arxiv .org/pdf/2401.11880

- 論文 11: 大規模言語モデルは感情的サポートの会話における選好バイアスを軽減するのに適しているか?

- 著者: Dongjin Kang、Sunghwan Kim 他

- 論文リンク: https://arxiv.org/pdf/2402.13211

- 論文 12:ティカルコンパスそれとも大規模言語モデルにおける価値観と意見のより意味のある評価に向けて

- 著者: Paul Röttger、Valentin Hofmann など

-

- 紙のリンク: https://arxiv.org/pdf/ 2402.16786

- 論文 13: 同じタスク、より多くのトークン: 大規模言語モデルの推論パフォーマンスに対する入力長の影響

- 著者: Mosh Levy、Alon Jacoby、Yoav Goldberg

- 機関: パキスタンエラン大学、アレン人工知能研究所

- 論文リンク: https://arxiv.org/pdf/2402.14848

- 論文14: ラマは多言語の潜在言語について働くか?トランスフォーマー

- 著者: Chris Wendler、Veniamin Veselovsky、他

-

- 論文 15: ユーモアについて真剣になる: 面白くない大規模言語モデルを使用したユーモア データセットの作成

著者:ホーヴィッツJinru Chen、他 機関: コロンビア大学、EPFL 論文リンク: https://arxiv.org/pdf/2403.00794

- 論文 16: レベルの推定方言複数方言のアラビア語データセットにおけるアノテーター間の合意を予測します

著者: Amr Keleg、Walid Magdy、Sharon Goldwater機関: エディンバラ大学ペーパーリンク: https://arxiv.org/pdf /2405.11282

- 論文 17: G-DlG: 機械翻訳のための勾配ベースの Dlverse と高品質な命令データの選択に向けて

著者: Xingyuan Pan、Luyang Huang、Liyan Kang、Zhicheng Liあなた、Yu Lu、Shanbo Cheng機関: ByteDance Research論文リンク: https: https://arxiv.org/pdf/2405.12915 -

論文リンク: https://openreview.net/pdf? id=9AV_zM56pwj

論文 19: SPZ: アルツハイマー病検出のためのゾーンミキシングによるセマンティック摂動ベースのデータ拡張手法

著者: FangFang Li、Cheng Huang、Puジェン・スー、ジエ・イン

論文 20: 必要なのは貪欲だけ: トークナイザー推論手法の評価機関: Ben Guri、ネゲブ アン大学、MIT

著者: Omri Uzan、 W. Schmidt、Chris Tanner、Yuval Pinter

-

論文リンク: https://arxiv.org/abs/2403.01289

論文 21: 言語の複雑さと音声認識の精度: 正書法の複雑さは問題を引き起こす音韻の複雑さNot -Institution:ノートルダム大学(米国)

-

Author:Thihiro Taquchi、DavidChiang

-

paperリンク:https://arxiv.org/abs/2406.09202

論文 22: 対照的活性化追加によるラマ 2 のステアリング

機関: 人間学、ハーバード大学、ゲッティンゲン大学 (ドイツ)、人間互換 AI センター

-

著者: Ninarimsky、Nick Gabrieli、 Julian Schulz、Meg Tong、Evan J Hubinger、Alexander Matt Turner

-

論文リンク: https://arxiv.org/abs/2312.06681

論文 23: EconAgent: 大規模言語モデルを活用したマクロ経済活動をシミュレートするエージェント

機関: 清華大学 - 清華大学深セン国際大学院

-

著者: Nian Li、Chen Gao、Mingyu Li、Yong Li、Qingmin Liao

-

紙のリンク: https: //arxiv.org/abs/2310.10436

論文 24: M4LE: 大規模言語モデル向けのマルチアビリティ、マルチレンジ、マルチタスク、マルチドメイン、ロングコンテキスト評価ベンチマーク

機関: 香港中文大学、ファーウェイ・ノアの方舟研究所、香港科技大学

-

著者: Wai-Chung Kwan、Xingshan Zeng、Yufei Wang、Yusen Sun、Liangyou Li、Lifeng Shang、Qun Liu、Kam- Fai Wong

-

論文リンク: https://arxiv.org/abs/2310.19240

論文 25: CHECKWHY: 引数構造による因果関係の検証

著者: Jiasheng Si、宜博趙、朱英傑、朱海陽、呂文鵬、周徳裕- 論文 26: 効率と統計について。Apple Inc. ダルムシュタット

論文リンク: https://arxiv.org/pdf/2405.11919

論文 27: エミュレートされた不整合: 安全性の調整大規模な言語モデルは逆効果になる可能性があります!著者 : Zhanhui Zhou、Jie Liu、Zhichen Dong、Jiaheng Liu、Chao Yang、Wanli Ouyang、Yu Qiao機関: Shanghai Artificial Intelligence Laboratory

ペーパーリンク: https://arxiv.org/pdf/2402.12343

論文 28: IndicLLMSuite: インド言語の事前トレーニングおよび微調整データセットを作成するためのブループリント著者: Mohammed Safi Ur Rahman Khan、Priyam Mehta、Ananth Sankar など-

機関: AI4Bharat の Nilekani Center、インド工科大学 (マドラス)、Microsoft など

紙のリンク: https://arxiv.org/pdf/ 2403.06350

論文 29: MultiPICo: 多言語パースペクティビスト lrony コーパス著者: Silvia Casola、Simona Frenda、Soda Marem Lo、Erhan Sezerer など -

機関: トリノ大学、 aequa-tech、Amazon Development Center (イタリア) など

論文リンク: https://assets.amazon.science/08/83/9b686f424c89b08e8fa0a6e1d020/multipico-multilingual-perspectivist-irony-corpus.pdf

論文 30: MMToM-QA: 心のマルチモーダル理論の質問応答著者: Chuanyang Jin、Yutong Wu、Jing Cao、jiannan Xiang など機関: ニューヨーク大学、ハーバード大学大学、MIT、カリフォルニア大学サンディエゴ校、バージニア大学、ジョンズ・ホプキンス大学

論文リンク: https://arxiv.org/pdf/2401.08743

論文 31: MAP ではないDead Yet: Uncovering true language model modes byconditioning across degeneracy著者: Davisよしだ、Kartik Goyal、Kevin Gimpel機関: トヨタ工科大学シカゴ校、ジョージア工科大学

論文リンク: https ://arxiv.org/pdf/2311.08817

論文 32 : NounAtlas: 名目上の意味役割ラベル付けのギャップを埋める著者: Roberto Navigli、Marco Lo Pinto、Pasquale Silvestri など。

論文 33: 地球は平らである理由...説得会話を介して誤った情報に対する LLM の信念を調査する著者: Rongwu Xu、Brian S. Lin、Shujian Yang、Tiangi Zhang など。 機関: 清華大学、上海交通大学、スタンフォード大学、南洋理工大学

紙のリンク: https://arxiv.org/pdf/2312.09085

論文34: Let's Go Real Talk: 対面会話のための音声対話モデル著者: Se Jin Park、Chae Won Kim、H Hyunsoop Rha、Minsu Kim 他 機関: 韓国科学技術研究院(KAIST)

論文リンク: https://arxiv.org/pdf/2406.07867

論文 35 : Word の埋め込みは言語モデルの舵取りです著者: Chi Han、JiアリアンXu、Manling Li、Yi Fung、Chenkai Sun、Nan Jiang、Tarek F. Abdelzaher、Heng Ji所属機関: イリノイ大学アーバナ校 - シャンペーン

紙のリンク: https://arxiv.org/pdf /2305.12798

-

最優秀テーマ論文賞

論文: OLMo: Accelerated the Science of Language Models

- 著者: Dirk Groeneveld、Iz Beltagy、他

- 機関: Allen Institute for Artificial Intelligence、ワシントン大学、他

- 論文リンク: https://arxiv.org/pdf/2402.00838

引用: この研究は、コミュニティが達成しつつある、大規模な言語モデルのトレーニングにおける透明性と再現性への重要なステップです 進歩のために非常に必要です(あるいは、少なくとも業界の巨人ではない他の研究者が貢献できるように)。 3件の論文がResource Paper Awardを受賞しました。 論文 1: Latxa: バスク語のオープン言語モデルと評価スイート

- 著者: Julen Etxaniz、Oscar Sainz 、ナイアラペレス、イツィアル・アルダベ、ジャーマン・リガウ、エネコ・アギレ、アイトール・オルマザバル、ミケル・アルテクス、アイトール・ソロア

- リンク: https://arxiv.org/pdf/2403.20266

受賞事例: 論文では次のように説明されています。コーパス コレクションの詳細、データセット評価の詳細。この方法論はバスク語の研究に関連していますが、他の低リソース言語の大規模モデルの構築にも拡張できます。 Paper 2:Dolma:言語モデルのための3兆個のトークンのオープンコーパスは、研究施設を事前に移します。 著者: Luca Soldaini、Rodney Kinney などリンク: https://arxiv.org/abs/2402.00159受賞理由: この論文は、準備時のデータ管理の重要性を示しています。大規模な言語モデルをトレーニングするためのデータセット。これは、コミュニティ内の幅広い人々に非常に貴重な洞察を提供します。

- 論文 3: AppWorld: インタラクティブ コーディング エージェントのベンチマークのためのアプリと人々の制御可能な世界

機関: ニューヨーク州立大学ストーニーブルック校、アレン人工知能研究所など。

著者: Harsh Trivedi、Tushar Khot などリンク: https://arxiv.org/abs/2407.18901受賞理由: この研究は非常に重要かつ素晴らしいものですインタラクティブな環境のシミュレーションと評価作業の構築に。これにより、誰もがコミュニティ向けに、より本格的な動的ベンチマークを作成することが奨励されます。

3件の論文がソーシャル・インパクト賞を受賞しました。

論文 1: ジョニーが LLM を脱獄するように説得する方法: LLM を人間化することで AI の安全性に挑戦するための説得を再考する著者: Yi Zeng、Hongpeng Lin、Jingwen Zhang、Diyi Yang、他

機関: バージニア工科大学、中国人民大学、カリフォルニア大学デービス校、スタンフォード大学論文リンク: https://arxiv.org/pdf/2401.06373理由受賞: この記事では、AI セキュリティのトピックであるジェイルブレイクについて考察し、社会科学研究の分野で開発された手法を検証します。この研究は非常に興味深いものであり、コミュニティに重大な影響を与える可能性があります。

- 論文 2: DIALECTBENCH: 方言、品種、および密接に関連する言語の NLP ベンチマーク

著者: Fahim Faisal、Orevaoghene Ahia、Aarohi Srivastava、Kabir Aフージャなど

機関: ジョージ メイソン大学、ワシントン大学、ノートルダム大学、RC アテナ論文リンク: https://arxiv.org/pdf/2403.11009 賞の引用: 方言バリエーションNLP と人工知能の重要な領域であり、十分に研究されていない現象です。しかし、言語と社会の観点から見ると、その研究の価値は極めて高く、応用にも重要な意味を持っています。この論文では、LLM 時代のこの問題を研究するための非常に新しいベンチマークを提案します。 Paper 3:大規模な言語モデルでの祈りの後にビールを飲んでいます。ジョージア工科大学論文リンク: https://arxiv.org/pdf/2305.14456

-

受賞理由: この記事は、LLM 時代の重要な問題である文化的偏見を示しています。この論文では、アラビアの文化とロケールを調査し、その結果は、LLM を設計する際に文化の違いを考慮する必要があることを示しています。したがって、同じ研究を他の文化でも再現して、他の文化もこの問題の影響を受けるかどうかを一般化して評価することができます。

Das obige ist der detaillierte Inhalt vonBekanntgabe der ACL 2024 Awards: Eines der besten Papers zum Thema Oracle Deciphering von HuaTech, GloVe Time Test Award. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Stellungnahme:Der Inhalt dieses Artikels wird freiwillig von Internetnutzern beigesteuert und das Urheberrecht liegt beim ursprünglichen Autor. Diese Website übernimmt keine entsprechende rechtliche Verantwortung. Wenn Sie Inhalte finden, bei denen der Verdacht eines Plagiats oder einer Rechtsverletzung besteht, wenden Sie sich bitte an admin@php.cn