Heim >Technologie-Peripheriegeräte >KI >Xiaohongshus große Sitzung zum Austausch von Modellpapieren brachte Autoren von vier großen internationalen Konferenzen zusammen

Xiaohongshus große Sitzung zum Austausch von Modellpapieren brachte Autoren von vier großen internationalen Konferenzen zusammen

- 王林Original

- 2024-08-05 14:33:02749Durchsuche

Große Modelle stehen an der Spitze einer neuen Runde des Forschungsbooms, mit zahlreichen innovativen Ergebnissen sowohl in der Industrie als auch in der Wissenschaft.

Das technische Team von Xiaohongshu forscht auch ständig an dieser Welle, und die Forschungsergebnisse vieler Arbeiten wurden häufig auf internationalen Top-Konferenzen wie ICLR, ACL, CVPR, AAAI, SIGIR und WWW vorgestellt.

Welche neuen Chancen und Herausforderungen entdecken wir an der Schnittstelle zwischen großen Modellen und natürlicher Sprachverarbeitung?

Was sind einige effektive Bewertungsmethoden für große Modelle? Wie kann es besser in Anwendungsszenarien integriert werden?

Am 27. Juni, 19:00-21:30 Uhr, [REDtech kommt] wird die elfte Ausgabe von „Little Red Book 2024 Large Model Frontier Paper Sharing“ online ausgestrahlt!

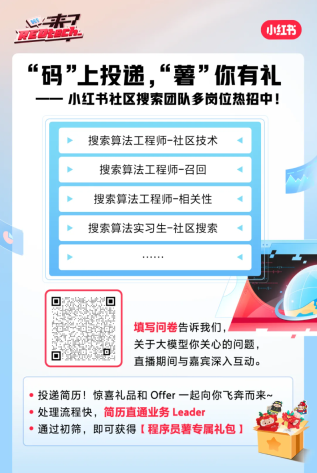

REDtech hat das Community-Suchteam von Xiaohongshu speziell in den Live-Übertragungsraum eingeladen. Sie werden 2024 6 groß angelegte Modellforschungspapiere teilen, die von Xiaohongshu veröffentlicht wurden. Feng Shaoxiong, der Verantwortliche für Xiaohongshu Jingpai LTR, diskutierte gemeinsam mit Li Yiwei, Wang Modelle in praktischen Anwendungen auf der Xiaohongshu-Plattform.

Aktivitätsagenda

01 Escape Sky-high Cost: Frühzeitiges Stoppen der Selbstkonsistenz für mehrstufiges Denken / Ausgewählt für ICLR 2024

Escape Sky-high Cost: Frühzeitiges Stoppen der Selbstkonsistenz für Mehrstufiges Denken Sexuelle Methode |. Geteilt von: Li Yiwei

Selbstkonsistenz (SC) war schon immer eine weit verbreitete Dekodierungsstrategie beim Denken in Ketten und verwendet die Mehrheitsantwort als endgültige Antwort Modellleistung. Es handelt sich jedoch um eine kostspielige Methode, die mehrere Proben einer voreingestellten Größe erfordert. Auf der ICLR 2024 schlug Xiaohongshu einen einfachen und skalierbaren Sampling-Prozess vor – Early-Stopping Self-Consistency (ESC), der die SC-Kosten erheblich senken kann. Auf dieser Grundlage entwickelte das Team außerdem ein ESC-Steuerungsschema, um das Leistungs-Kosten-Verhältnis für verschiedene Aufgaben und Modelle dynamisch auszuwählen. Experimentelle Ergebnisse zu drei gängigen Denkaufgaben (Mathematik, gesunder Menschenverstand und symbolisches Denken) zeigen, dass ESC die durchschnittliche Anzahl von Stichproben über sechs Benchmarks hinweg erheblich reduziert und dabei die ursprüngliche Leistung nahezu beibehält.

Papieradresse: https://arxiv.org/abs/2401.10480

02 Integrieren Sie die Essenz und beseitigen Sie die Schlacke: Feinkörnige Selbstkonsistenz für die Generierung von Freiformsprachen / Ausgewählt für ACL 2024

Auswählen die Feinheiten: Feinkörnige Selbstkonsistenzmethode für Freiform-Generierungsaufgaben| Teilnehmer: Wang -Konsistenzmethode in der Leistung bei Freiform-Generierungsaufgaben. Das Team analysierte zunächst durch Experimente, dass die Mängel bestehender selbstkonsistenter Methoden für Freiform-Generierungsaufgaben auf die grobkörnige gemeinsame Stichprobenauswahl zurückzuführen sind, die das gemeinsame Wissen zwischen feinkörnigen Fragmenten verschiedener Stichproben nicht effektiv nutzen kann. Auf dieser Grundlage schlug das Team eine FSC-Methode vor, die auf der Selbstfusion großer Modelle basiert, und Experimente bestätigten, dass sie bei der Codegenerierung, Zusammenfassungsgenerierung und mathematischen Argumentationsaufgaben eine deutlich bessere Leistung bei gleichzeitig erheblichem Verbrauch erzielte.

Papieradresse: https://github.com/WangXinglin/FSC03 BatchEval: Towards Human-like Text Evaluation / Ausgewählt für ACL 2024, der Fachvorsitzende gab die volle Punktzahl und empfahl das beste Papier

Mai Auf dem Weg zur Textbewertung auf menschlicher Ebene|

Shareer: Yuan PeiwenXiaohongshu hat in ACL 2024 die BatchEval-Methode vorgeschlagen, mit der menschenähnliche Textbewertungseffekte mit geringerem Overhead erzielt werden können. Das Team analysierte zunächst auf theoretischer Ebene, dass die Mängel bestehender Textbewertungsmethoden in Bezug auf die Bewertungsrobustheit auf die ungleichmäßige Verteilung der Bewertungsergebnisse zurückzuführen sind und dass die suboptimale Leistung bei der Bewertungsintegration auf die mangelnde Vielfalt der Bewertungsperspektiven zurückzuführen ist. Auf dieser Grundlage wurde BatchEval analog vorgeschlagen, inspiriert durch den Vergleich zwischen Proben im menschlichen Bewertungsprozess, um einen dreidimensionaleren und umfassenderen Bewertungsmaßstab mit unterschiedlichen Perspektiven zu etablieren. Im Vergleich zu mehreren aktuellen State-of-the-Art-Methoden erzielt BatchEval eine deutlich bessere Leistung sowohl beim Bewertungsaufwand als auch beim Bewertungseffekt.

Papieradresse: https://arxiv.org/abs/2401.0043704 Schlecht überwachte Bewertung für SuperLLM über gegenseitige Konsistenz / Ausgewählt für ACL 2024

Erreichen Sie ein übermenschliches Niveau ohne genaues Überwachungssignal durch gegenseitige Konsistenz Große Sprachmodellbewertung|

Teilnehmer: Yuan Peiwen Xiaohongshu schlug in ACL 2024 die PEEM-Methode vor, mit der durch gegenseitige Konsistenz zwischen Modellen eine genaue Bewertung großer Sprachmodelle über die menschliche Ebene hinaus erreicht werden kann. Das Team analysierte zunächst, dass der aktuelle Trend der schnellen Entwicklung großer Sprachmodelle dazu führen wird, dass sie in vielerlei Hinsicht allmählich das menschliche Niveau erreichen oder sogar übertreffen. In dieser Situation wird der Mensch nicht mehr in der Lage sein, genaue Bewertungssignale zu liefern. Um die Fähigkeitsbewertung in diesem Szenario zu realisieren, schlug das Team die Idee vor, die gegenseitige Konsistenz zwischen Modellen als Bewertungssignal zu verwenden, und leitete daraus ab, dass bei unendlichen Bewertungsstichproben eine unabhängige Vorhersageverteilung zwischen den Referenzmodellen vorliegt und das zu bewertende Modell. Diese Konsistenz zwischen Referenzmodellen kann als genaues Maß für die Modellfähigkeit verwendet werden. Auf dieser Grundlage schlug das Team die auf dem EM-Algorithmus basierende PEEM-Methode vor, und Experimente bestätigten, dass sie die Unzulänglichkeit der oben genannten Bedingungen in der Realität wirksam lindern und so eine genaue Bewertung großer Sprachmodelle erreichen kann, die über das menschliche Niveau hinausgehen. Papieradresse: https://github.com/ypw0102/PEEM 05 Staub in Gold verwandeln: Destillierung komplexer Denkfähigkeiten aus LLMs durch Nutzung negativer Daten / Ausgewählt in AAAI 2024 Oral Verwendung negativer Proben zur Werbung große Modelle Destillation von Argumentationsfähigkeiten |. Teiler: Li Yiwei Große Sprachmodelle (LLMs) eignen sich gut für verschiedene Argumentationsaufgaben, aber ihre Black-Box-Eigenschaften und die große Anzahl von Parametern behindern ihre weit verbreitete Anwendung in der Praxis. Insbesondere bei der Bearbeitung komplexer mathematischer Probleme kommt es bei LLMs manchmal zu fehlerhaften Argumentationsketten. Herkömmliche Forschungsmethoden übertragen nur Wissen aus positiven Stichproben und ignorieren synthetische Daten mit falschen Antworten. Auf der AAAI 2024 schlug das Xiaohongshu-Suchalgorithmus-Team ein innovatives Framework vor, schlug erstmals den Wert negativer Proben im Modelldestillationsprozess vor und überprüfte ihn und baute ein Modellspezialisierungs-Framework auf, das neben der Verwendung positiver Proben auch vollständige Ergebnisse lieferte Verwendung negativer Proben Zur Verfeinerung des LLM-Wissens. Das Framework umfasst drei Serialisierungsschritte, darunter Negative Assisted Training (NAT), Negative Calibration Enhancement (NCE) und Dynamic Self-Consistency (ASC), die den gesamten Prozess vom Training bis zur Inferenz abdecken. Eine umfangreiche Reihe von Experimenten zeigt die entscheidende Rolle negativer Daten bei der Destillation von LLM-Wissen. Papieradresse: https://arxiv.org/abs/2312.12832 06 NoteLLM: Ein abrufbares großes Sprachmodell für Notizempfehlungen / Ausgewählt für WWW 2024 Empfehlungssystem für die Darstellung von Notizinhalten basierend auf einem großen Sprachmodell| Geteilt von: Zhang Chao So können Sie live zuschauen Live-Übertragungszeit: 27. Juni 2024 19:00-21:30 Live-Broadcast-Plattform: WeChat-Videokonto [REDtech], Live-Übertragung auf gleichnamigen Bilibili-, Douyin- und Xiaohongshu-Konten. Freunde einladen, einen Termin für Live-Übertragungsgeschenke zu vereinbaren

Gleichzeitig wird die Live-Übertragung auch gleichzeitig auf den Partner-Videokonten [Jichi Platform], [This Site] und [Datawhale] WeChat übertragen. Du kannst gerne den Fragebogen ausfüllen und uns mitteilen, welche Themen Dir am großen Model am Herzen liegen, und während der Live-Übertragung ausführlich mit den Gästen interagieren.

Das obige ist der detaillierte Inhalt vonXiaohongshus große Sitzung zum Austausch von Modellpapieren brachte Autoren von vier großen internationalen Konferenzen zusammen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr