Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. E-Mail zur Einreichung: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

Die Co-Autoren dieses Artikels sind Dr. Li Jing, Sun Zhijie und Dr. Lin Dachao. Die Hauptmitglieder sind vom GTS AI Computing Lab. Zu den Hauptforschungs- und Umsetzungsfeldern gehören LLM-Ausbildung und -Beschleunigung, KI-Ausbildungssicherung und Graph Computing.

MoE hat in den letzten zwei Jahren im Bereich großer Sprachmodelle aufgrund seiner geringen Kosten und hohen Effizienz im Schulungs- und Beförderungsprozess glänzt. Da es die Seele des MoE ist, gibt es endlose diesbezügliche Forschungen und Diskussionen darüber, wie Experten ihr Lernpotenzial maximieren können. Zuvor hatte das Forschungsteam des Huawei GTS AI Computing Lab LocMoE vorgeschlagen, einschließlich einer neuartigen Routing-Netzwerkstruktur, lokalem Verlust zur Reduzierung des Kommunikationsaufwands usw., was große Aufmerksamkeit erregte. Das obige Design von LocMoE lindert effektiv die Engpässe einiger klassischer MoE-Strukturen im Training, wie zum Beispiel: Experten-Routing-Algorithmen sind möglicherweise nicht in der Lage, Token effektiv zu unterscheiden, und die Effizienz der Kommunikationssynchronisation wird durch den Unterschied in der Übertragungsbandbreite innerhalb dieser begrenzt und zwischen Knoten usw. . Darüber hinaus beweist und löst LocMoE die Untergrenze der Expertenkapazität, die diskriminierende Token erfolgreich verarbeiten kann. Diese Untergrenze wird auf der Grundlage der Wahrscheinlichkeitsverteilung diskriminierender Token in Token-Batches in einem Szenario abgeleitet, in dem Token passiv an Experten verteilt werden. Wenn Experten dann auch die Möglichkeit haben, optimale Token auszuwählen, erhöht sich die Wahrscheinlichkeit, dass diskriminierende Token verarbeitet werden, erheblich und die Untergrenze der Expertenkapazität wird weiter komprimiert. Basierend auf den oben genannten Ideen schlug das Team außerdem eine MoE-Architektur vor, die auf aktivem Routing mit geringem Overhead basiert, und nannte sie LocMoE+. LocMoE+ erbt die Vorteile der hochdiskriminierenden Experten und der lokalen Kommunikation von LocMoE, transformiert die Routing-Strategie weiter, definiert den Affinitätsindex zwischen Token und Experten und beginnt mit diesem Index, um die Token-Verteilung effizienter abzuschließen und dadurch die Trainingseffizienz zu verbessern.

- Papierlink: https://arxiv.org/pdf/2406.00023

Die Kernidee des Papiers ist zu kombinieren Traditionelles passives Routing mit Experten. Aktives Routing verbessert die Wahrscheinlichkeit, diskriminierende Token unter einer bestimmten Kapazität zu verarbeiten, wodurch das Probenrauschen reduziert und die Trainingseffizienz verbessert wird. Dieses Papier geht von der Beziehung zwischen einem Token und seinen zugewiesenen Experten aus und quantifiziert und definiert die Affinität zwischen Experten und Token in einem Schema mit geringem Rechenaufwand. Dementsprechend implementiert dieses Papier eine globale adaptive Routing-Strategie und ordnet Token in der Expertendimension basierend auf Affinitätswerten neu und wählt sie aus. Gleichzeitig verringert sich nachweislich die Untergrenze der Expertenkapazität allmählich, wenn sich die Token-Feature-Verteilung stabilisiert, und der Trainingsaufwand kann reduziert werden. Dieses Papier ist das erste, das zwei Routing-Mechanismen kombiniert. Basierend auf der Entdeckung, dass Token dazu neigen, an Experten mit kleineren Winkeln in der Lern-Routing-Strategie weitergeleitet zu werden, wird das Hindernis überwunden, das sich auf bestehende aktive Routing-Lösungen auswirkt Trainingseffizienz. Und bleiben Sie im Einklang mit der Art des passiven Routings. Es ist erwähnenswert, dass der Autor eine völlig andere Hardwareumgebung (Servermodell, NPU-Kartenmodell, Cluster-Netzwerkschema), Trainingsframework und Backbone-Modell von LocMoE ausgewählt hat, um die hohe Effizienz dieser Arbeitsreihe zu beweisen und einfache Tragbarkeit. Adaptiver bidirektionaler RoutenverteilungsmechanismusTraditionelles MoE verfügt über zwei Routenverteilungsmechanismen: ( 1) Harter Router, direkter Einsatz des gesamten Tokens Funktionen werden zugewiesen; (2) Soft-Router, der eine gewichtete Kombination von Token-Funktionen zuweist. In diesem Artikel wird weiterhin (1) berücksichtigt, da der Rechenaufwand geringer ist. Für das Hard-Router-Szenario kann es unterteilt werden in 1) Token Choice Router (TCR), der es jedem Token ermöglicht, Top-K-Experten auszuwählen, 2) Expert Choice Router (ECR), der es jedem Experten ermöglicht, Top-C-Experten auszuwählen Zeichen. Aufgrund von Kapazitätsbeschränkungen hat die Anzahl der von jedem Experten empfangenen Token eine Obergrenze C, daher werden in Szenario 1) die von jedem Experten empfangenen Token gekürzt:

Des travaux antérieurs ont souligné que la formation du MoE est divisée en deux étapes : Phase 1. La formation au routage garantit que le routage peut raisonnablement attribuer des jetons, c'est-à-dire que les jetons dans différents domaines ou avec de grandes différences peuvent être distingués et attribués à différents experts. Grâce au routage des jetons Le rôle de chaque expert est de recevoir des jetons dans le même domaine ou avec des propriétés similaires. Chaque expert peut acquérir des connaissances dans des domaines et propriétés connexes après avoir suivi certaines formations. En résumé, la clé du « succès » de chaque étape de la formation du MoE réside dans l’exactitude et la rationalité de la distribution des jetons. Contributions de cet article (1) Grâce à la déduction de la fonction d'activation softmax, la similarité cosinus entre les experts et les jetons peut mesurer plus précisément l'affinité :

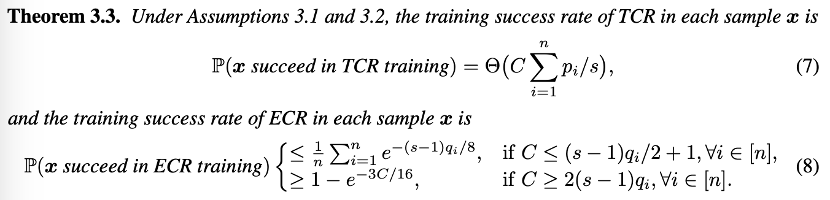

(2) Du point de vue de modélisation théorique, le taux de réussite de la formation unique du TCR et de l'ECR est analysé dans deux scénarios courants : Sur la base de la théorie, l'auteur a souligné que

- Au début de la formation du modèle, lorsque le la capacité du jeton de routage est insuffisante. Chaque fois que TCR est formé, il a une probabilité de réussite de la formation plus élevée que l'ECR et nécessite une plus grande capacité d'experts pour garantir que le jeton approprié est sélectionné.

- Dans la phase ultérieure de la formation du modèle, lorsque le routeur a une certaine capacité à allouer correctement les jetons, chaque fois qu'ECR est formé, il a une probabilité de réussite plus élevée que TCR. À ce stade, seule une capacité plus petite est. nécessaire pour sélectionner le jeton approprié.

Cette théorie est également très intuitive. Lorsque le routeur n'a pas de capacité de répartition, il est préférable de laisser le jeton sélectionner les experts au hasard. Lorsque le routeur a une certaine capacité de répartition, c'est-à-dire lorsque l'expert peut sélectionner le. jeton approprié, il est plus approprié d’utiliser ECR . Par conséquent, l’auteur recommande la transition du TCR vers l’ECR et propose une stratégie de commutation de routage adaptative au niveau mondial. Dans le même temps, sur la base de l’estimation de la demande de capacité d’expert, une capacité d’expert plus petite est utilisée dans les étapes ultérieures de la formation. Les expériences de cet article ont été menées sur le cluster auto-construit de NPU Ascend 910B3, grâce au système informatique haute performance (HCCS) exclusif de Huawei. la communication de données entre appareils est réalisée dans des scénarios multi-cartes, et la bibliothèque de communication collective Huawei (HCCL) conçue spécifiquement pour les processeurs Ascend permet une formation distribuée hautes performances sur des liaisons à haut débit telles que HCCS. L'expérience utilise le framework PyTorch pour Ascend compatible avec Ascend NPU et la bibliothèque d'accélération AscendSpeed et le framework de formation ModelLink spécialement personnalisé pour les appareils Ascend, en se concentrant sur la stratégie parallèle LLM et l'optimisation du masquage des communications. Efficacité de la formationLes résultats expérimentaux montrent que sans affecter la convergence ou l'efficacité de la formation du modèle, le nombre de jetons que chaque expert doit traiter peut être réduit de plus de 60 % par rapport à la ligne de base. Combinée à l'optimisation de la communication, l'efficacité de la formation est améliorée en moyenne de 5,4 % à 46,6 % pour des tailles de cluster de 32 cartes, 64 cartes et 256 cartes.

Utilisation de la mémoire vidéoLocMoE+ présente également un certain gain dans l'utilisation de la mémoire vidéo, en particulier dans les scénarios où la taille du cluster est petite et le calcul est intensif. En utilisant l'outil Ascend Insight pour analyser les échantillons de surveillance de la mémoire, on peut constater que l'utilisation de la mémoire LocMoE+ a chuté de 4,57 % à 16,27 % par rapport à la ligne de base, et de 2,86 % à 10,5 % par rapport à LocMoE. À mesure que la taille du cluster augmente, l’écart d’utilisation de la mémoire diminue.

Die Open-Source-Bewertungssets C-Eval und TeleQnA sowie das unabhängig erstellte IKT-Domänenbewertungsset GDAD wurden verwendet, um die Fähigkeiten von LocMoE+ im Bereich Allgemeinwissen und Domänenwissen zu bewerten. Darunter umfasst GDAD insgesamt 47 Unterpunkte, darunter 18.060 Stichproben, um die Leistung des Modells in den drei Hauptbewertungssystemen Domänenaufgaben, Domänenkompetenzzertifizierungsprüfungen und allgemeine Fähigkeiten zu untersuchen. Nach ausreichender SFT verbesserte sich LocMoE+ im Durchschnitt um etwa 20,1 % im Vergleich zum Ausgangswert in 16 Unterfähigkeiten der Domänenaufgabenfähigkeiten und um etwa 3,5 % im Vergleich zu LocMoE. Die Zahl der Zertifizierungsprüfungen für Domänenkompetenzen stieg um 16 % bzw. 4,8 %. Unter den 18 Unterfunktionen der allgemeinen Funktionen verbesserte sich LocMoE+ um etwa 13,9 % bzw. 4,8 %. Insgesamt zeigt LocMoE+ Leistungsverbesserungen von 9,7 % bis 14,1 % bei GDAD, C-Eval und TeleQnA.

Das obige ist der detaillierte Inhalt vonHuawei GTS LocMoE+: MoE-Architektur mit hoher Skalierbarkeit und Affinität, geringer Overhead für aktives Routing. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Stellungnahme:Der Inhalt dieses Artikels wird freiwillig von Internetnutzern beigesteuert und das Urheberrecht liegt beim ursprünglichen Autor. Diese Website übernimmt keine entsprechende rechtliche Verantwortung. Wenn Sie Inhalte finden, bei denen der Verdacht eines Plagiats oder einer Rechtsverletzung besteht, wenden Sie sich bitte an admin@php.cn